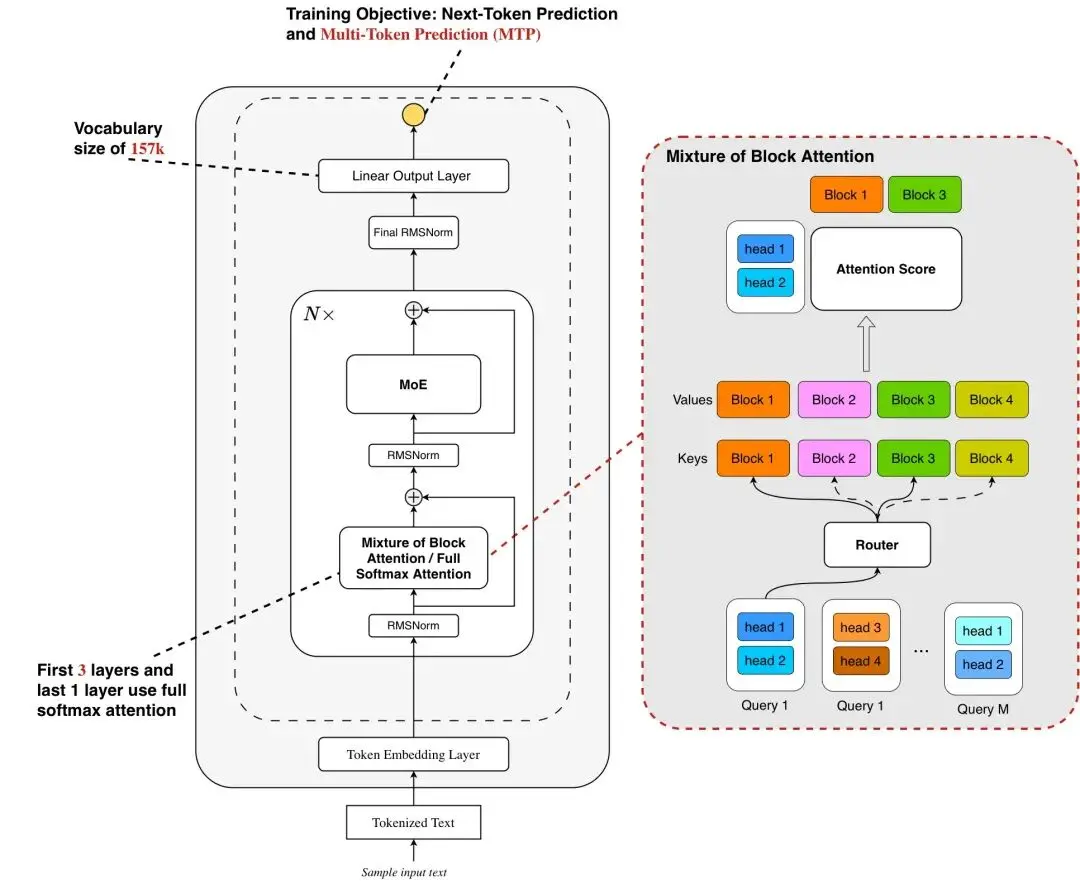

螞蟻百靈大模型團隊正式開源高效推理模型 Ring-mini-sparse-2.0-exp,該模型採用的 Ling 2.0 架構是專為長序列解碼優化的稀疏注意力架構,創新性地融合了高稀疏比 Mixture of Expert(MoE)結構與稀疏注意力機制。

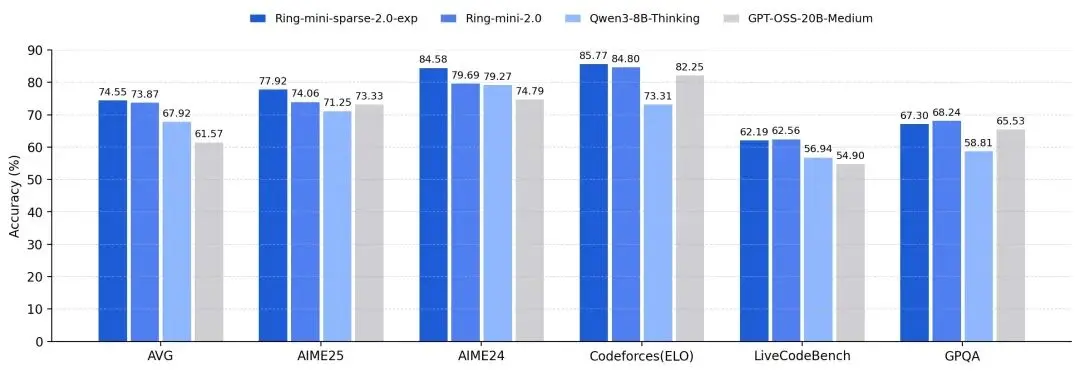

團隊表示,得益於架構與推理框架的深度協同優化,該模型在複雜長序列推理場景下的吞吐量較原版 Ring-mini-2.0 實現 近 3 倍提升,同時在多項高難度推理基準測試中持續保持 SOTA 性能。這一成果為開源社區提供了兼具高效推理與強上下文處理能力的輕量化解決方案。

Ling 2.0 Sparse 是專為應對大語言模型未來兩大核心趨勢 —— 上下文長度擴展(Context Length Scaling) 與測試時擴展(Test Time Scaling)而設計的高效稀疏注意力機制。

團隊借鑑了 Mixture of Block Attention (MoBA),採用塊級稀疏注意力(block-wise sparse attention),將輸入的 Key 和 Value 按塊(block)劃分,每個 query 在 head 維度上進行 top-k 塊選擇,僅對選中的塊執行 softmax 注意力計算,從而顯著降低計算開銷。同時將 MoBA 設計和 Grouped Query Attention (GQA) 結合,使同一組內的 query heads 共享 top-k 塊選擇結果,讓一次塊讀取可服務於多個 query head 的注意力計算,進一步減少 I/O 開銷。

Ring-mini-sparse-2.0-exp開源地址

Hugging Face:https://huggingface.co/inclusionAI/Ring-mini-sparse-2.0-exp

ModelScope:https://modelscope.cn/models/inclusionAI/Ring-mini-sparse-2.0-exp

GitHub:https://github.com/inclusionAI/Ring-V2/tree/main/moba