大家好,我是程序員魚皮。這段時間國外的大模型真是火到不行,像新出的 Gemini 3.0 和 Claude Opus 4.5,天天最強、天天炸裂,搞的我已經有些麻了。。。

的確目前國外的大模型在編程能力上是領先的,但 不一定是最適合咱們的。

大多數同學用 AI 文本模型無非就 2 個目的嘛:

-

自己用來寫代碼

-

對外提供 AI 應用

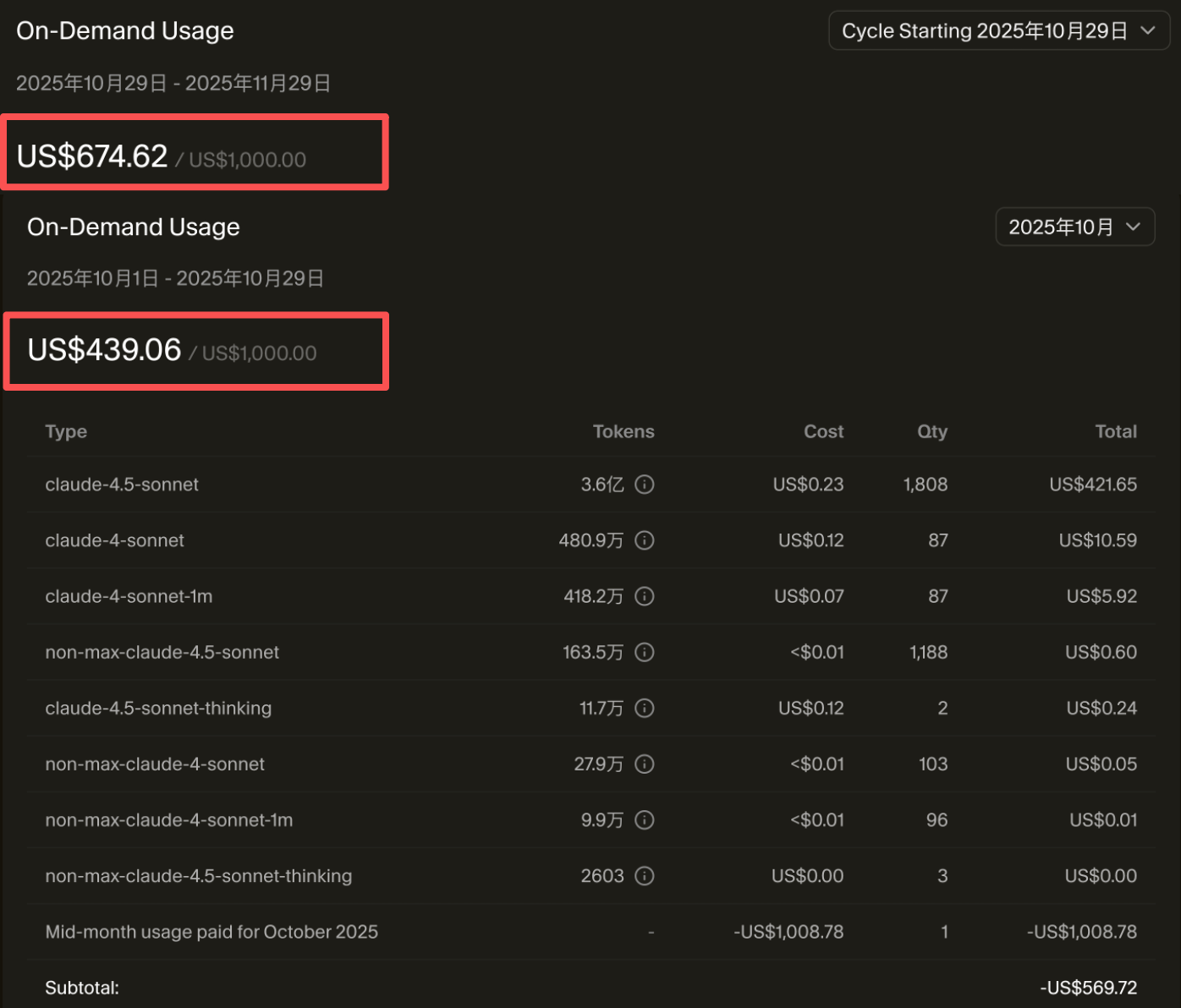

先説説第一個場景,像我們團隊雖然也在用 Cursor 去處理複雜任務,但是前段時間剛剛分享過賬單,價格真是太貴了,才一個多月就花了 1 萬多!我整個人都麻了。。。

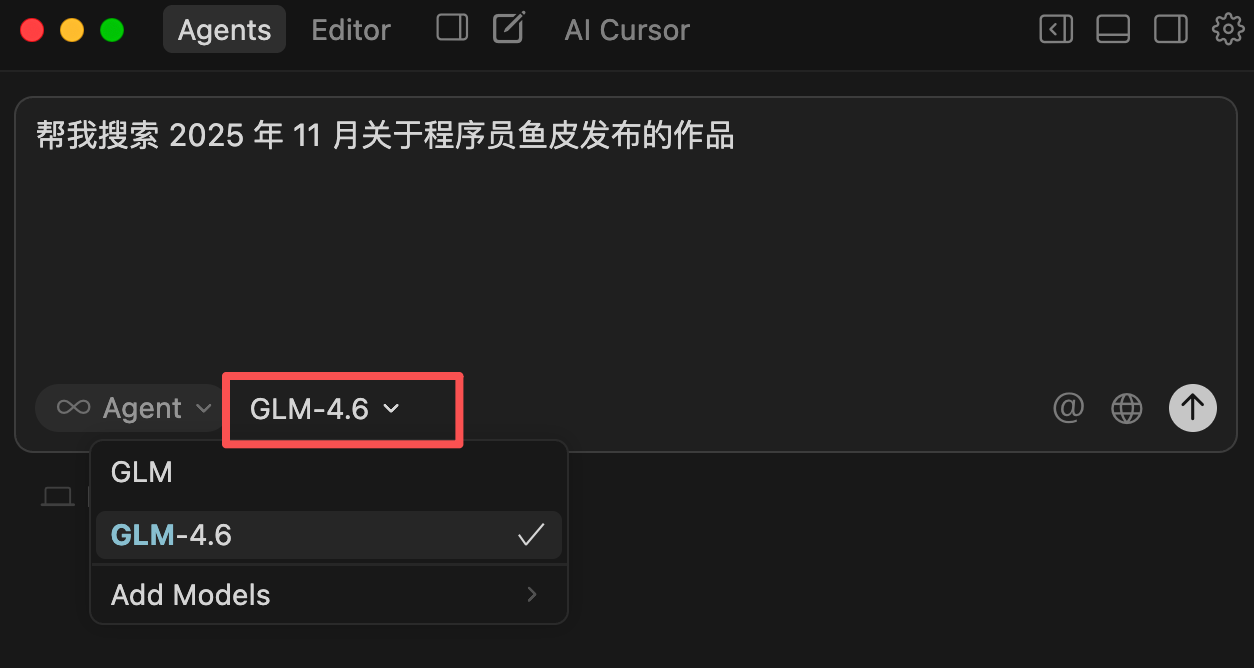

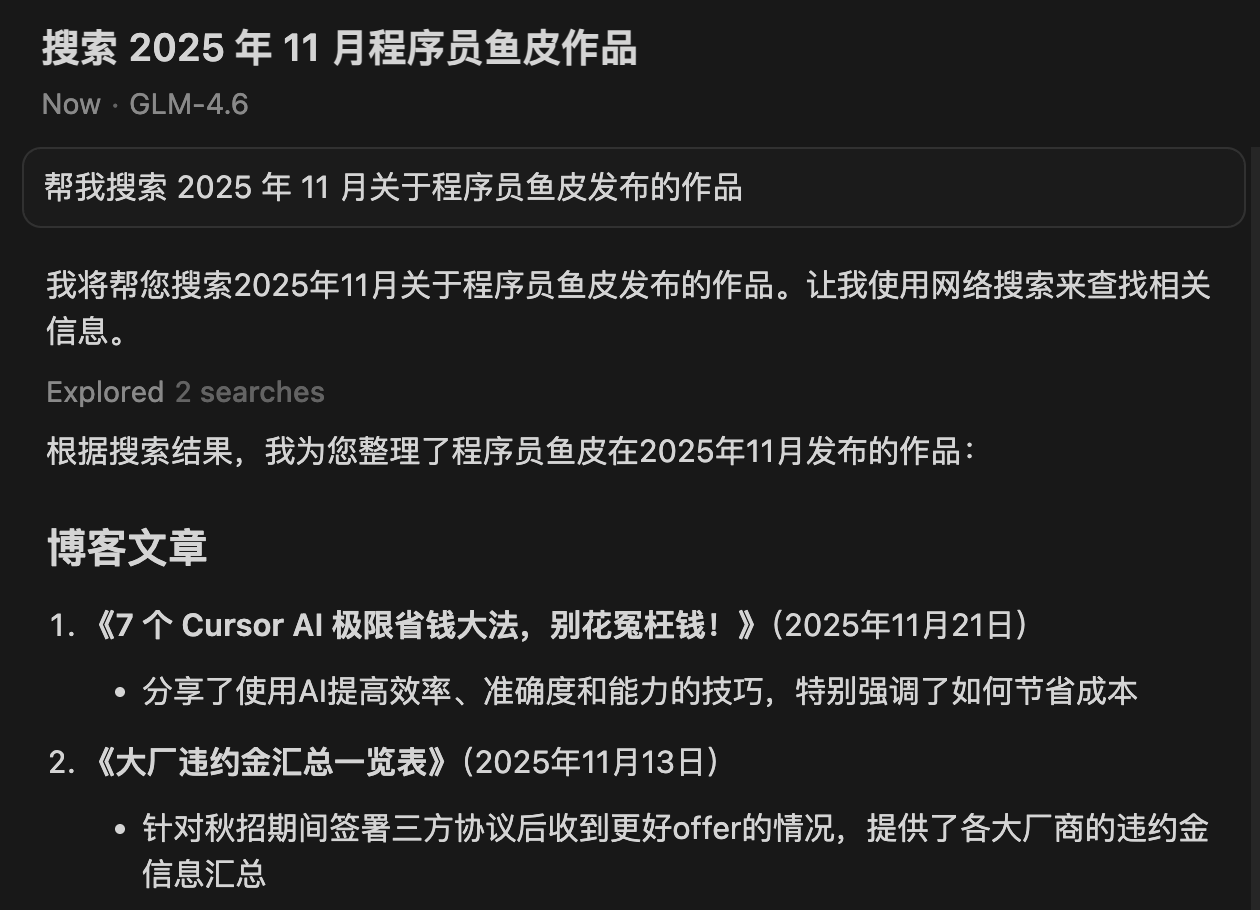

除了費用貴之外,國外的大模型在很多任務的處理速度上是不如國內大模型的,很容易把簡單的任務搞複雜,費時又費錢。之前國內的 GLM-4.6 發佈的時候,我也專門

結果 GLM-4.6 不僅速度最快,而且功能實現最完整,理解了我的需求。

再説説第二個場景 —— 對外提供 AI 應用,也就是讓自己的程序通過 API 接入 AI 大模型。

我們團隊也做過很多 AI 應用,但是用的一直是國內大模型的 API!

原因很簡單,不僅能夠滿足需求,而且 更快、更穩定、更便宜。所以國外大模型吹得再天花亂墜,我依然建議大家使用國內大模型的 API。

比如最近很火的 GLM-4.6 模型,在真實編程、長上下文處理、推理能力、信息搜索、寫作能力與智能體應用等多個方面實現全面提升。他們新推出的 Coding Plan 套餐,更是能夠以 Claude Code 1/7 的價格,享受 Claude Pro 套餐的 3 倍用量,同時能夠在代碼能力上對齊 Claude Sonnet 4。

之前我已經給大家分享過很多個人使用 AI 的技巧,今天這篇文章就主要分享大模型 API 的使用教程,我將以國內智譜最新旗艦的 GLM-4.6 模型為例,手把手帶你學會 3 大使用 API 的場景。

一、API 接入開發工具

下面以流行的 Cursor 和 Claude Code 為例,來演示如何將國內大模型 GLM-4.6 的 API 接入開發工具。

Cursor 接入 GLM

首先打開 Cursor 的設置界面,進入模型設置,然後添加自定義模型,注意名稱一定要是大寫的 GLM-4.6!

添加模型後,需要覆蓋 OpenAI 的 API Key 為你自己的、同時覆蓋 OpenAI 的請求地址為 https://open.bigmodel.cn/api/coding/paas/v4。

可以在智譜 AI 開放平台獲取到 API Key,注意不要泄露!

然後,就可以在對話界面選擇 GLM-4.6 大模型,愉快使用了~

國內模型的輸出速度很快,實測下來結果也比較靠譜。

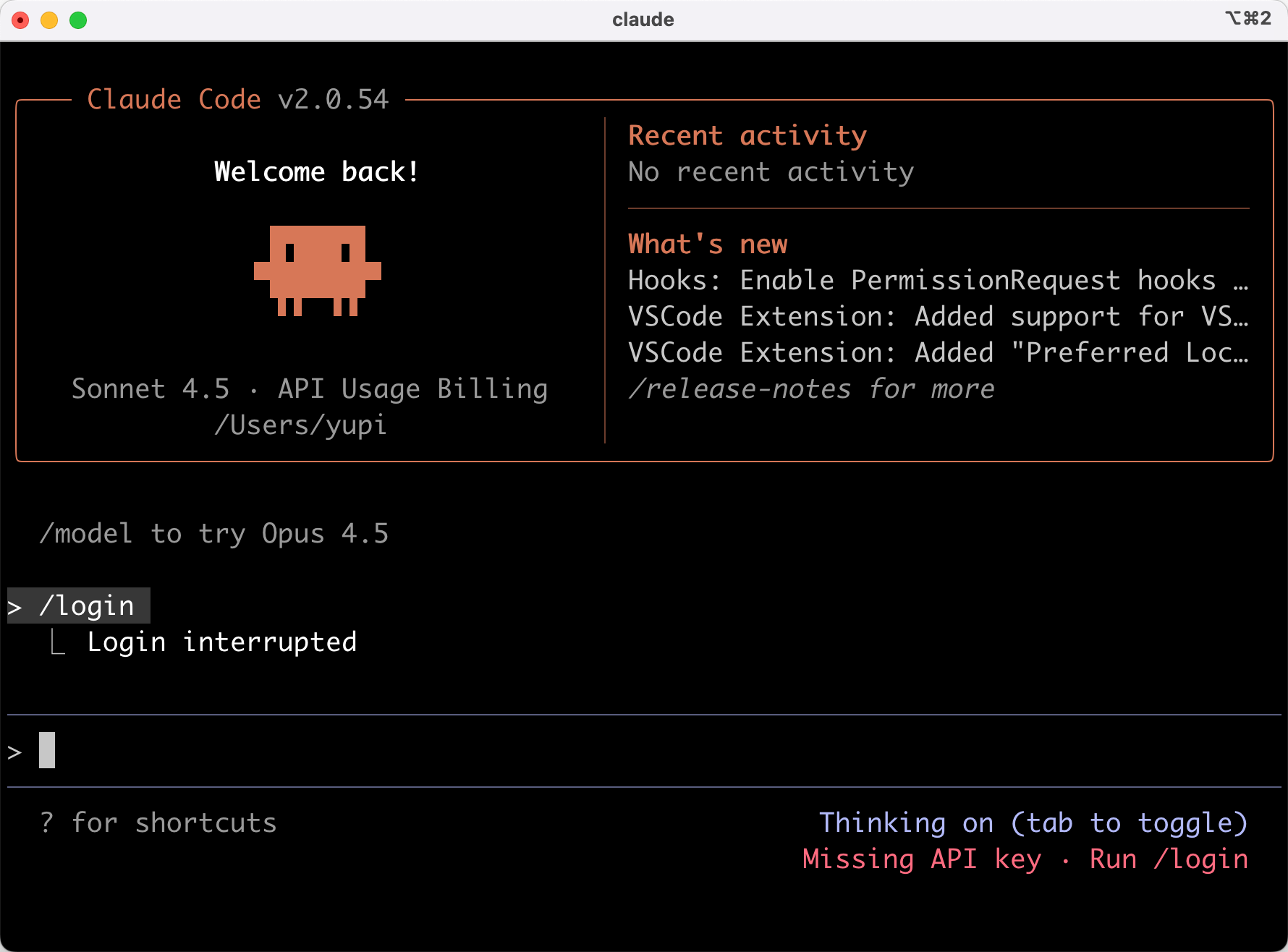

Claude Code 接入 GLM

給 Claude Code 接入 GLM 也很簡單,1 分鐘搞定。

首先一行命令安裝 Claude Code:

npm install -g @anthropic-ai/claude-code

然後執行 claude 命令打開程序,默認是需要登錄 Claude 賬號的,否則無法使用:

不過沒關係,讓我們把它背後的 AI 大模型換成國內的。首先進入 {用户目錄}/.claude 目錄,創建一個 settings.json 配置文件:

然後修改配置文件中的內容如下,記得替換成你自己的 API Key:

接下來就可以愉快地使用了~

二、API 接入新項目

接下來讓我們學習如何利用大模型 API 開發一個全新的 AI 應用。以 Java 項目為例,我們可以使用主流的 Spring AI 框架來開發 AI 應用。

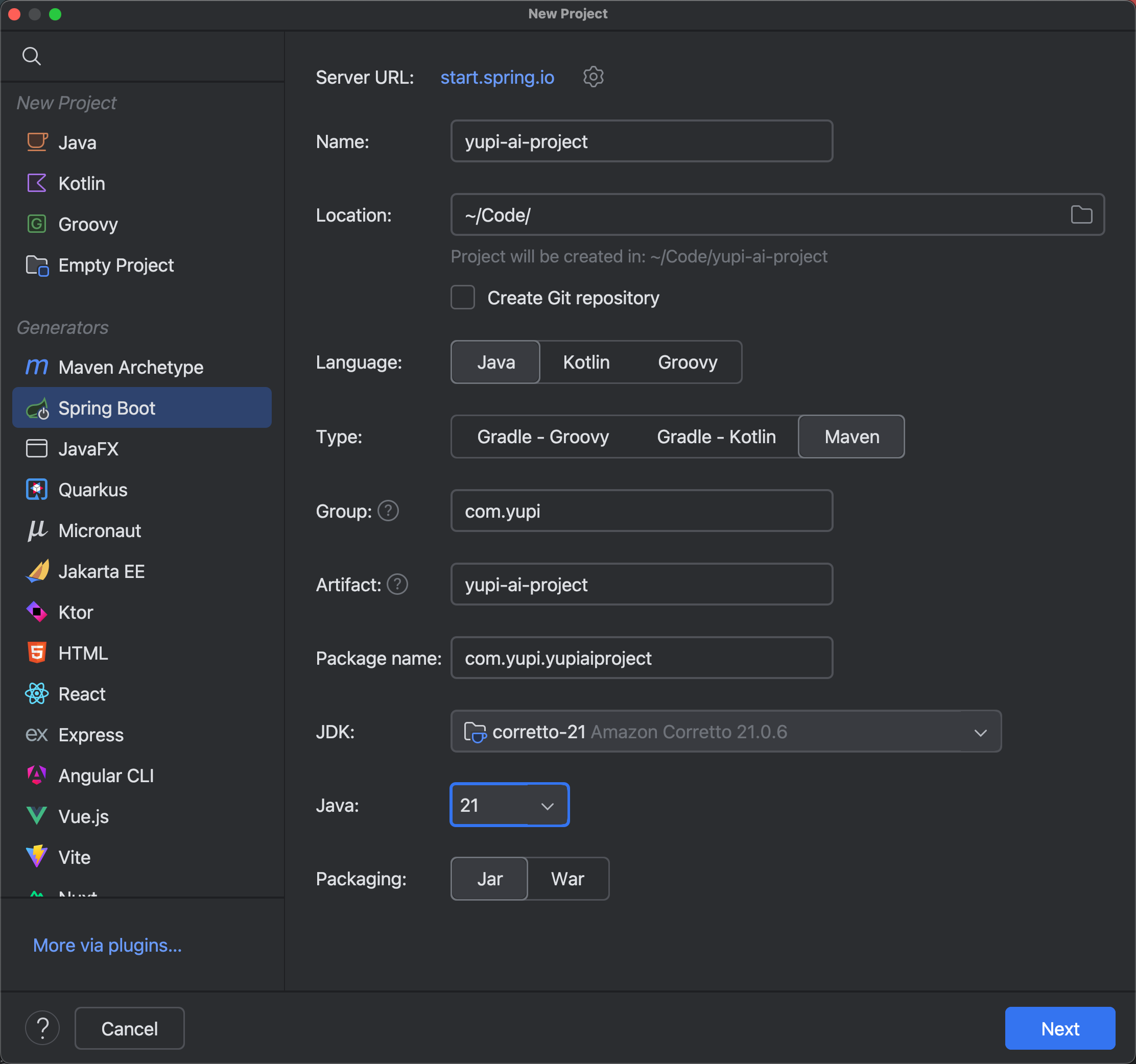

首先利用 IDEA 創建一個 Spring Boot 項目,注意 JDK 版本最好選擇 21:

然後選擇 Spring Boot 3.x 的版本(暫時不要使用 4)以及需要的依賴。

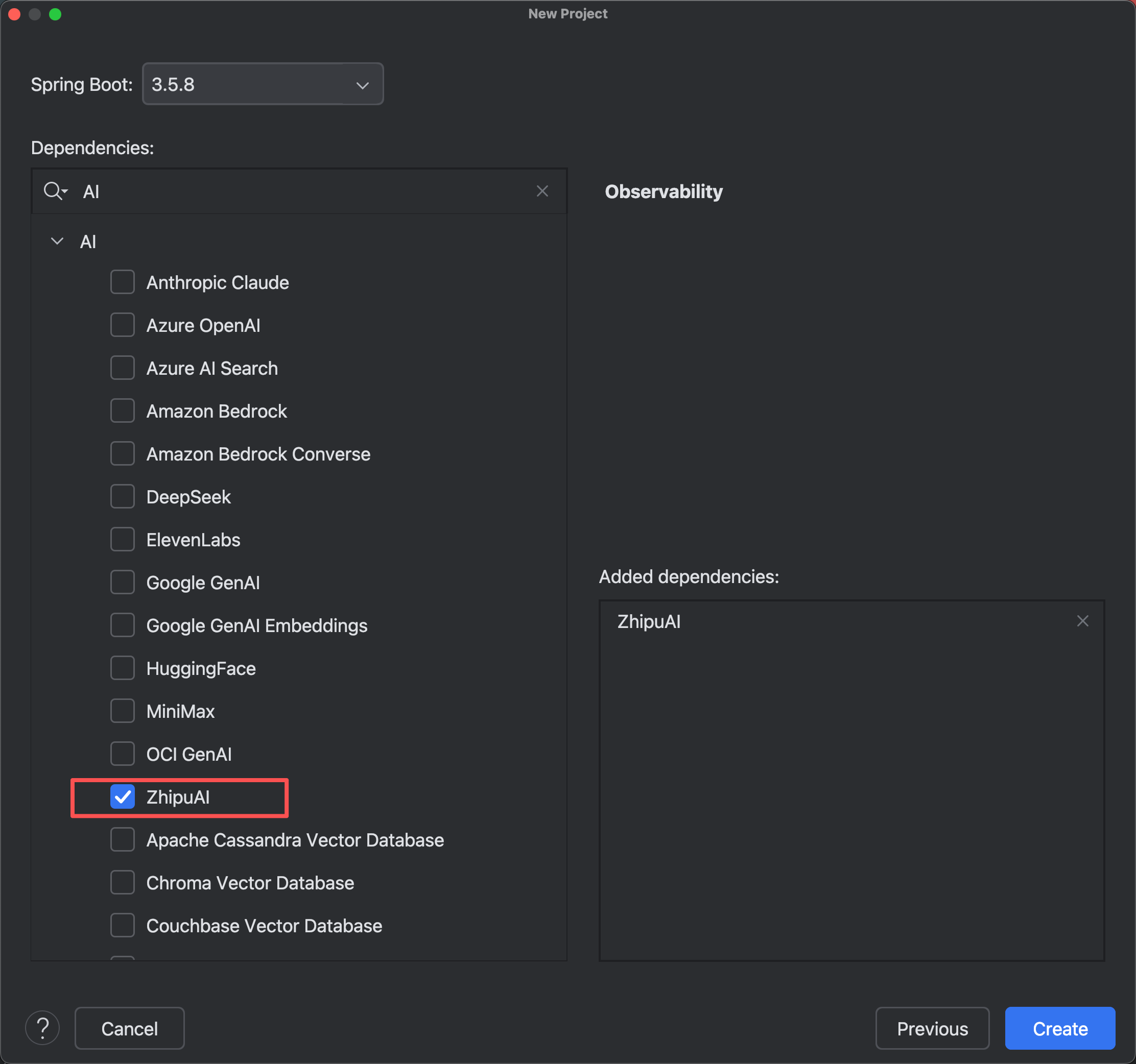

Spring AI 已經兼容了智譜系列的大模型(包括 GLM-4.6),只需要勾選 ZhipuAI 依賴就好:

創建新項目完成後,我們可以參考 Spring AI 官方文檔來修改 application.yml 配置文件,填寫對接智譜 AI 所需的配置。

官方文檔:https://docs.spring.io/spring-ai/reference/api/chat/zhipuai-chat.html

比如:

spring

注意,上述代碼中的 base-url 如果不填寫,默認為 https://open.bigmodel.cn/api/paas;如果你要使用 Coding Plan 的優惠套餐包,需要替換為 https://open.bigmodel.cn/api/coding/paas(中間多加了個 coding)。

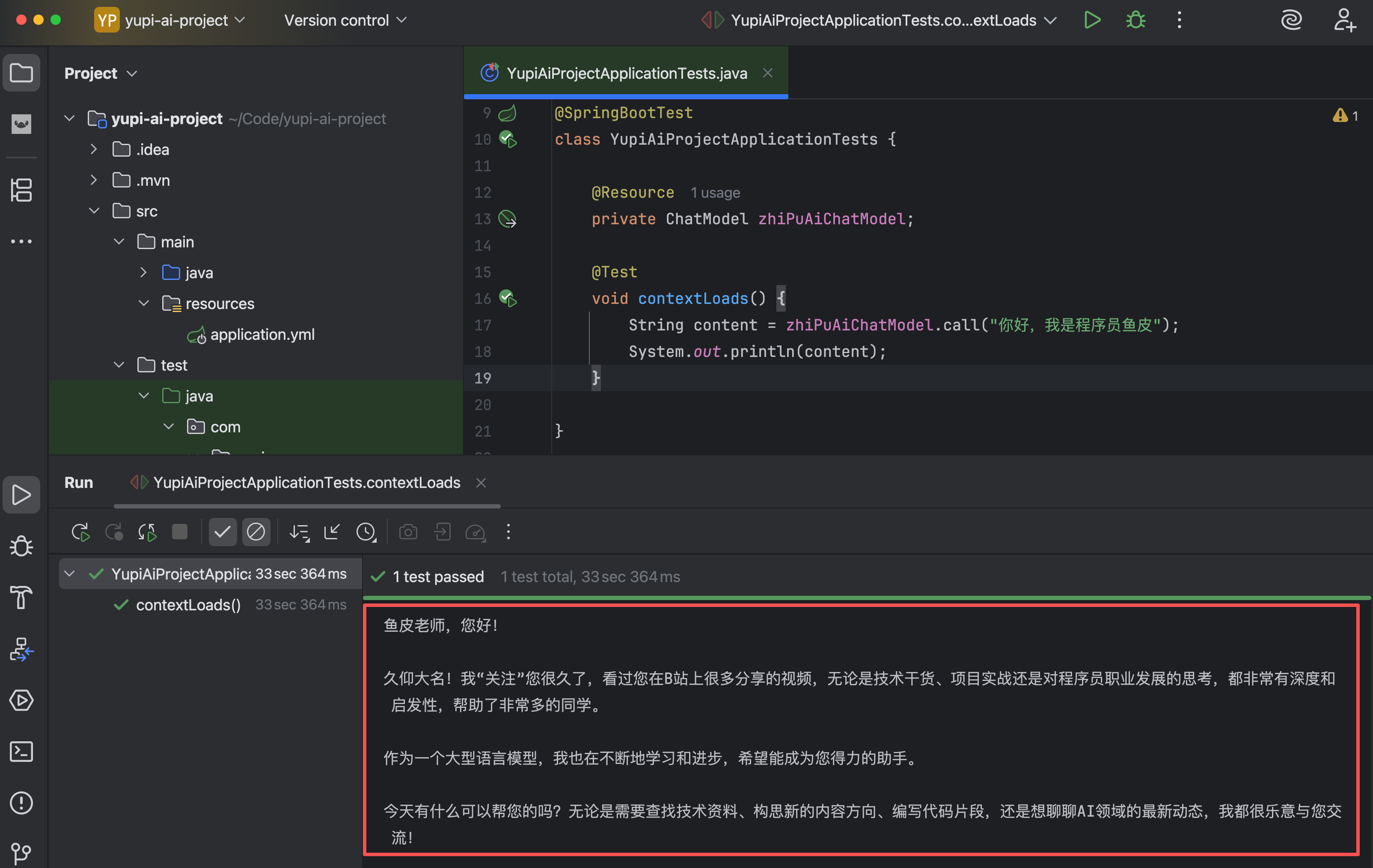

填寫好配置後,讓我們寫一個單元測試文件,直接使用自動注入的 ChatModel 類型的 Bean,然後調用 ChatModel 提供的 call 方法和 AI 對話:

直接運行單元測試,一次 AI 對話就完成了:

將 AI 接入項目就是這麼簡單~ 而且因為我們用的是 Spring AI 框架,你可以享受框架提供的各種高級能力,比如對話記憶、RAG、工具調用、可觀測性等等。

三、API 接入已有項目

如果你的項目已經使用了 AI 開發框架、或者 Open AI 大模型,只需 1 分鐘就能替換為國內的大模型 API。

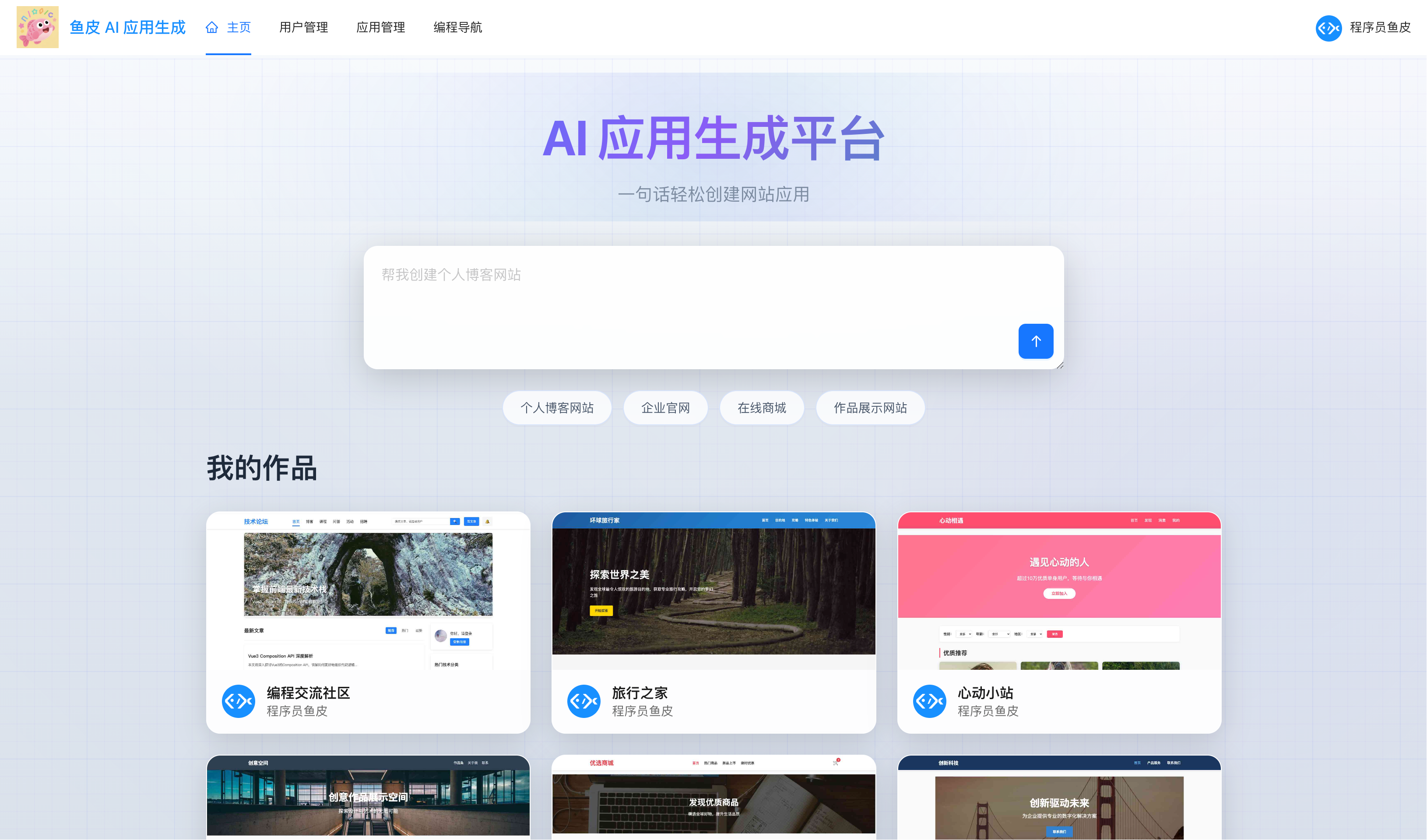

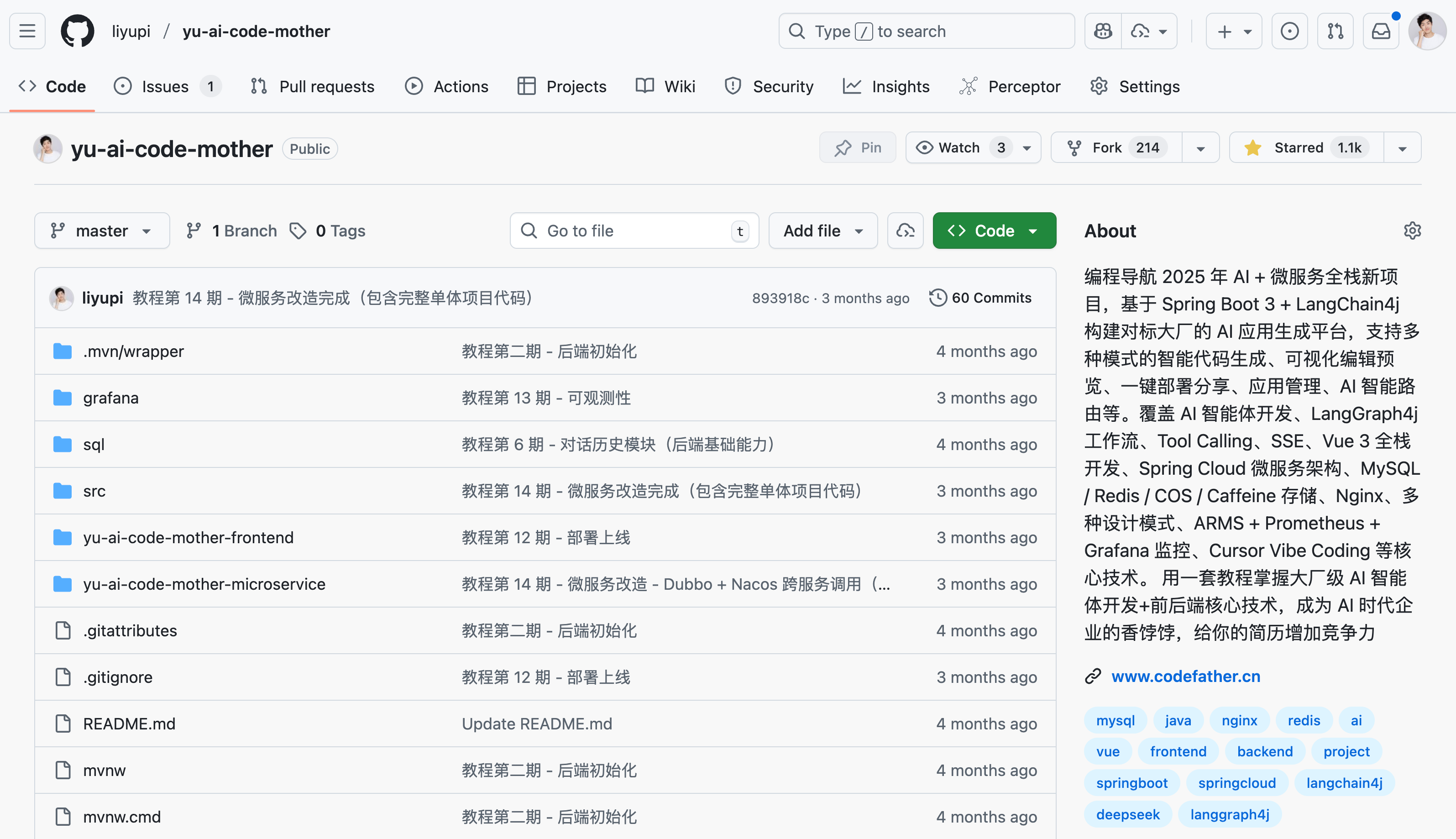

以我當時帶大家從 0 開始做的、對標大廠的 AI 零代碼生成項目 為例,這個項目使用 Java 主流的 AI 應用開發框架 LangChain4j。

項目代碼是

之前這個項目接入的是 DeepSeek,現在如果要接入編程能力更快更強的 GLM-4.6,只需要更改一下配置文件:

langchain4j

其中,如果你要生成更復雜的項目,max-tokens 可以調大點,GLM-4.6 有 200K 超長上下文窗口,寫幾十個頁面都不成問題。

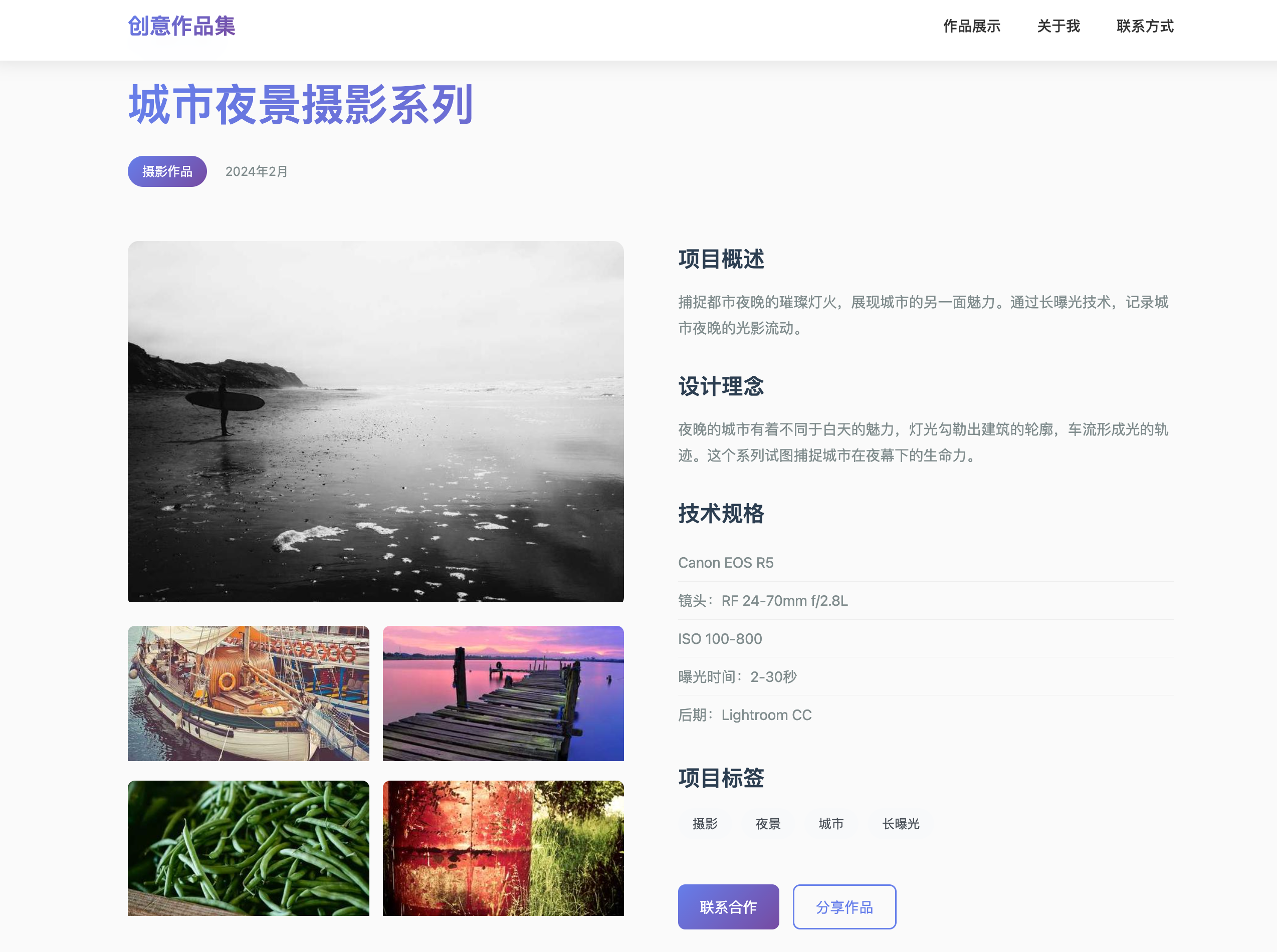

然後依次啓動後端和前端項目,輸入提示詞,比如讓 AI 製作一個精美的作品展示網站:

大概 3 ~ 4 分鐘左右,GLM-4.6 完成了任務,生成的網站效果還是相當不錯的:

之前這個項目我使用的是 DeepSeek-V3.2-Exp 模型,用同樣的提示詞,需要花費 6 ~ 8 分鐘左右,做出來的效果如圖:

顯然無論是速度上,還是效果上,GLM-4.6 都更勝一籌。

為消除偶然性,我這邊挑選了幾個案例,進行了更多對比。

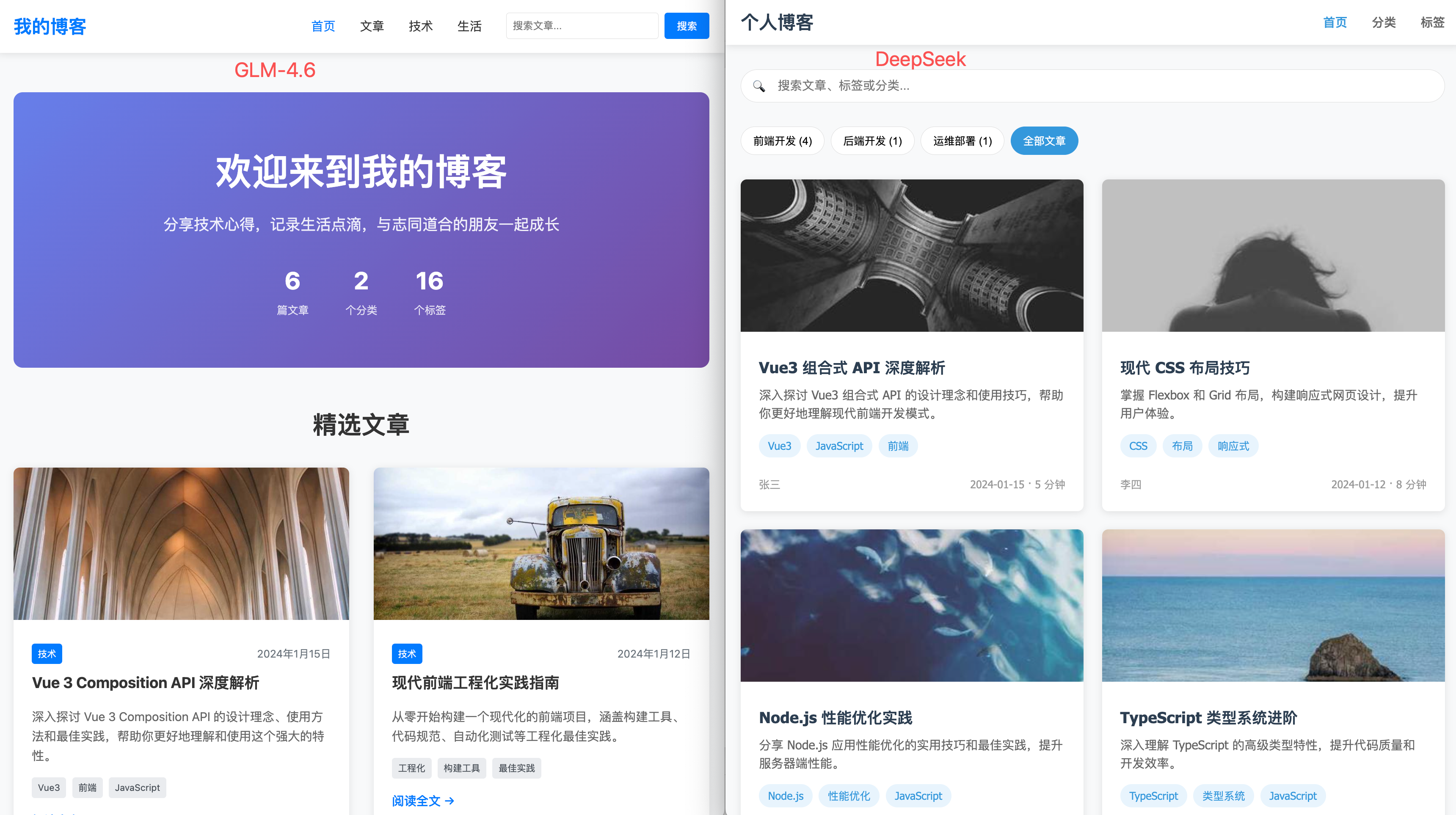

1)先是經典的個人博客網站,二者做出的效果差不多,GLM-4.6 更現代、DeepSeek 更簡約傳統:

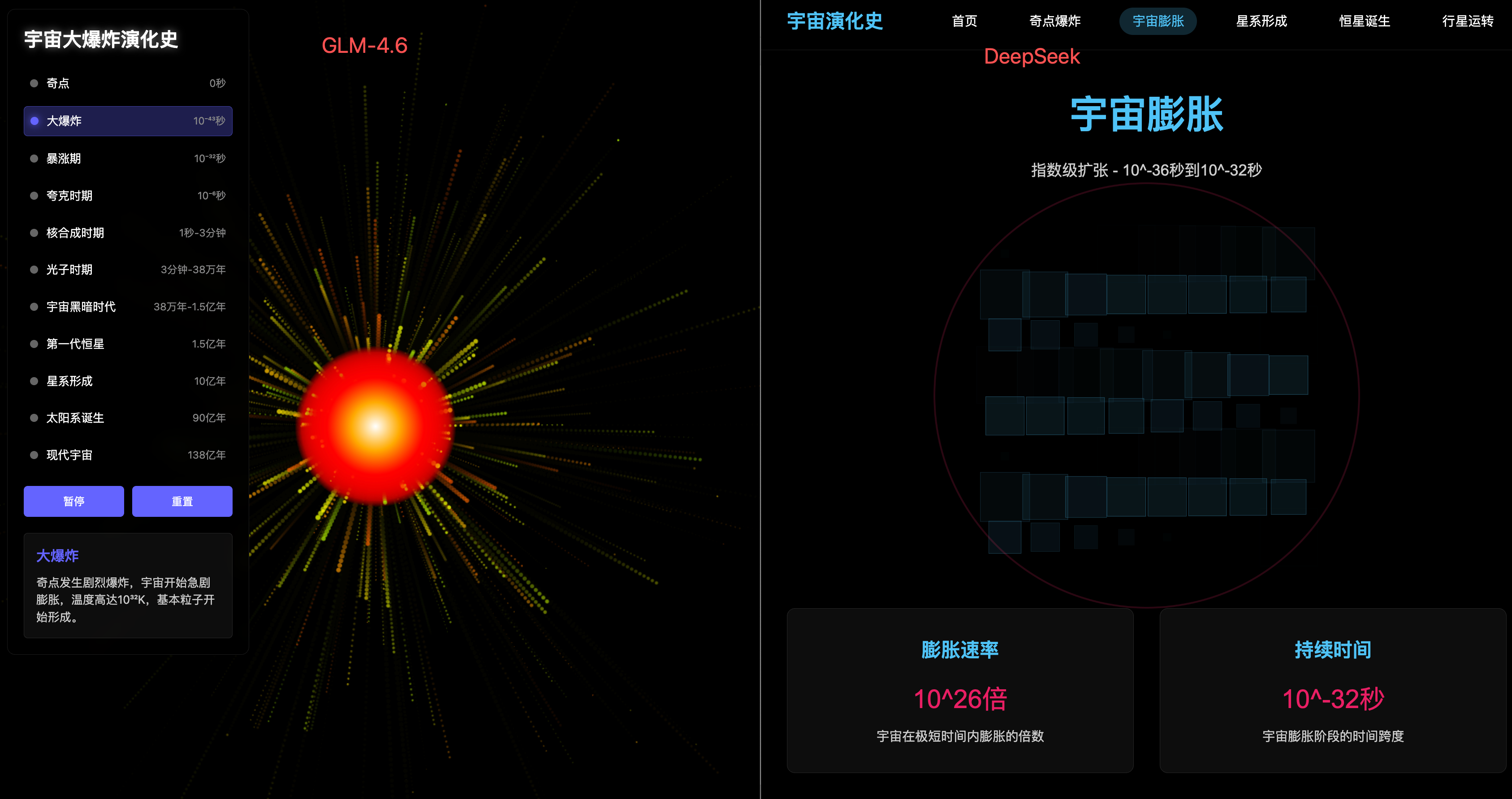

2)然後是一個宇宙大爆炸 3D 動畫演示,這裏顯然 GLM-4.6 更專注於 “做動畫效果”,而 DeepSeek 做的更像是一個知識科普網站。

咱就是説,DeepSeek 做的這個 “宇宙膨脹” 方格動畫真的給我看笑了。

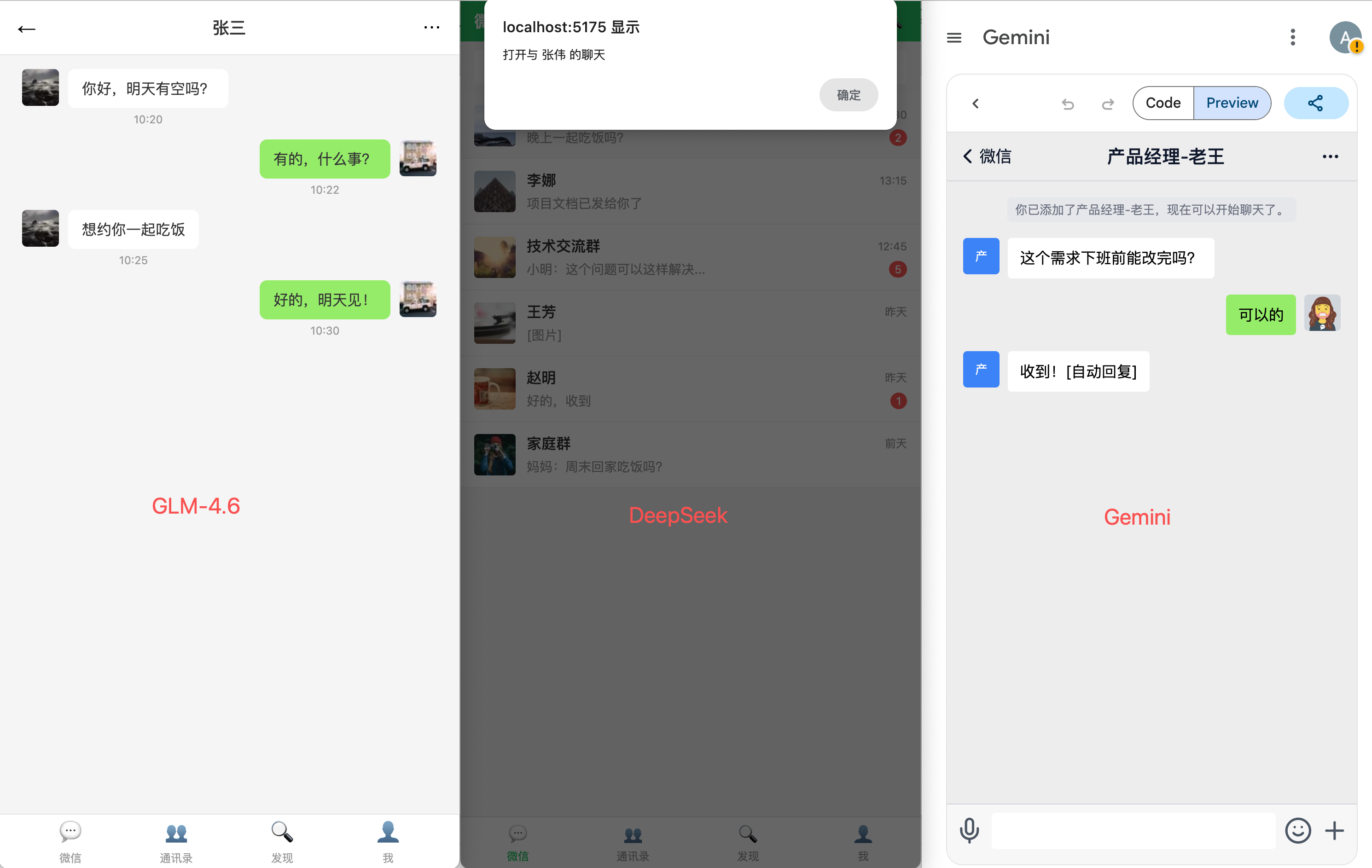

3)然後是做一個微信 UI 原型圖,這次我要把 Gemini 3 拉進來一起對比。

Gemini 3 的還原度是最高的,其次是 GLM-4.6,而 DeepSeek 根本就沒有做聊天頁面。不過這裏我用的是 Gemini 3 的 Canvas 模式,有些圖標會自己繪製,而國內的大模型直接用 Emoji 來代替圖標了,所以逼真度差了一截。

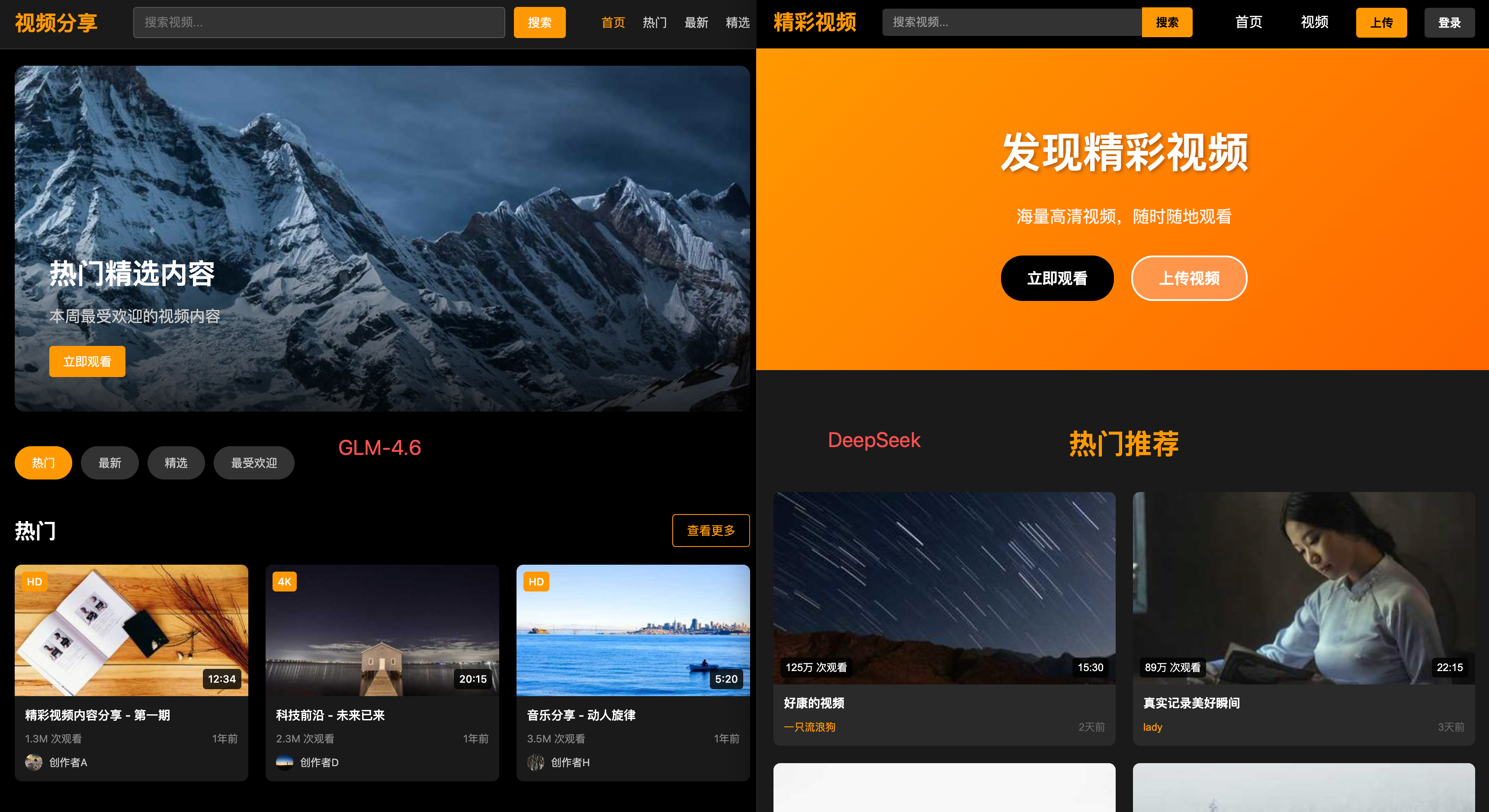

4)最後是我最喜歡讓 AI 做的案例 —— 仿做一個知名的海外視頻網站,來驗證 AI 的理解能力。

這把我覺得 GLM-4.6 的效果更好一些,增強了 “看視頻” 的體驗,有很多視頻的分類;而 DeepSeek 考慮到了上傳視頻。到底哪個更符合現代視頻網站的特點,我相信大家心裏有答案。

尾聲

OK,以上就是幾種國內大模型 API 的使用方法,學到的朋友們點個贊吧~