本文介紹瞭如何利用多維度 Linux 工具進行 Docker 容器性能問題診斷分析及調優,從而充分利用硬件資源,最大化系統資源使用。原文:Docker Performance Tuning: Resource Bottleneck Identification and CPU/Memory/I/O Optimization

在現代 Docker 運維框架中,性能調優已成為提升系統效率、降低成本並確保服務水平協議(SLA)合規的關鍵實踐。雖然 Docker 容器化帶來了資源隔離和彈性,但也帶來了潛在瓶頸,如 CPU 競爭、內存碎片和 I/O 延遲。如果不優化,這些問題可能導致應用響應緩慢、資源浪費和穩定性問題。在生產環境中,性能問題通常源於多因素耦合,需要系統化的瓶頸識別和調優策略。

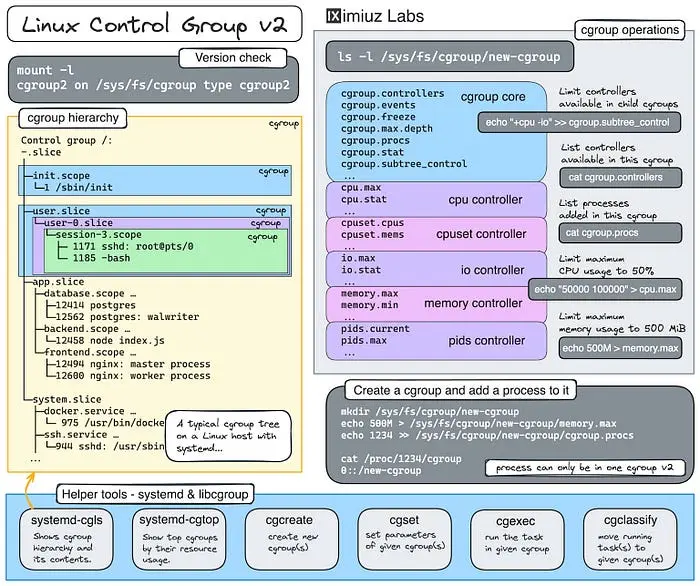

Docker 性能高度依賴於 Linux 內核的 cgroup v2、調度器和 I/O 子系統。在運維實踐中,工程師必須掌握基線測試、指標監控和參數微調,才能從被動響應轉向主動優化。本文深入探討了生產級策略,用於識別和解決 CPU、內存和 I/O 維度的 Docker 性能瓶頸。

Docker 性能核心概念與瓶頸模型

性能調優始於建立概念模型和定量框架,理解這些基礎知識使得基於數據的優化決策而非憑猜測成為可能。

- 性能指標框架:行業依賴四個關鍵指標:延遲(完成作時間)、吞吐量(單位時間內的操作)、利用率(資源容量百分比)和飽和度(工作排隊程度)。Docker 特定的考慮因素包括容器開銷(通常低於 5%)以及分層文件系統架構的影響。

- 瓶頸分類:性能下降表現在多個維度上。CPU 問題包括容器間爭用、多核處理器利用率不足以及非一致內存訪問(NUMA,Non-Uniform Memory Access)錯位。內存瓶頸源於碎片化、交換抖動和膨脹效應。I/O 約束源於低效的存儲驅動、隊列深度不足以及緩存命中率較差。網絡問題包括最大傳輸單元(MTU)配置錯誤、校驗和卸載問題以及 RX/TX 環緩衝區大小不當。系統範圍的擔憂包括調度器的公平性和遷移熱點影響。

- 診斷方法:USE(利用率、飽和率、誤差,Utilization Saturation Errors)方法為瓶頸定位提供了結構化方法。RED(速率、錯誤、持續時間,Rate Errors Duration)方法補充了服務級監控的 USE。企業運維強調通過受控空載測試與滿載測試建立基線,以建立性能基準。

- 必備工具鏈:現代 Docker 環境需要全面的監控棧,包括用於實時指標的

docker stats、用於詳細容器分析的 cAdvisor、用於深度系統內省的 sysdig、用於底層分析的 perf 以及用於歷史趨勢分析的 sar。

資源瓶頸識別方法

有效識別先於優化,多維診斷揭示了性能瓶頸的真實本質,而非症狀。

綜合指標收集

實時監控從 docker stats 開始,這些數據會暴露每個容器的 CPU 百分比、內存使用率、網絡 I/O 和塊 I/O。用腳本幫助數據收集:docker stats --format "table {{.Name}}\t{{.CPUPerc}}\t{{.MemUsage}}\t{{.NetIO}}\t{{.BlockIO}}",將輸出結構化,以供分析流程使用。

在生產級可觀測性方面,cAdvisor 與 Prometheus 無縫集成,暴露了 container_cpu_load_average_10s、container_memory_usage_bytes 和 container_fs_io_current 等指標,從而幫助我們可以通過 Grafana 儀表盤實現趨勢分析和異常檢測。

Sysdig 通過命令提供系統調用級別的可視化,比如 sysdig -p "%container.name %proc.cpu %proc.memory.rss" -M 60,每個容器平均採集 60 秒的資源消耗。這種細緻度揭示了高層工具看不見的模式。

主機級上下文來自經典的 Linux 工具包:sar -u 1 10,以 1s 採樣迭代 10 次收集 CPU 利用率,mpstat 分解每個核的統計數據,iostat 詳細描述磁盤 I/O 模式,vmstat 跟蹤內存和交換行為。

集羣級監控利用 Prometheus 聯邦技術,在分佈式環境中彙總節點級指標。Grafana 儀表盤可視化這些聚合,將容器行為與主機資源關聯起來,並實現全局優化決策。

系統性瓶頸定位

性能調查遵循結構化工作流程。從症狀觀察開始:當應用變慢時,檢查延遲直方圖和百分位分佈,以瞭解延遲的嚴重程度和分佈。

層級診斷從應用分析器(如 Go 的 pprof 或 Java 的 VisualVM)開始,經過 docker inspect HostConfig 檢查容器資源限制,到利用 top 或 htop 進行主機級分析,最終到使用 perf record 生成火焰圖的內核級調查。

基線測試建立性能預期。對於 I/O,fio 提供全面的基準測試:fio --name=test --rw=randread --bs=4k --numjobs=1 --iodepth=32 --size=1G --runtime=60 測量 4KB 內存塊在 32 級隊列深度下的隨機讀取性能。對於 CPU 和內存,sysbench 提供標準化工作負載:sysbench --threads=8 cpu run 測試 sysbench --test=memory --memory-block-size=1M --memory-total-size=10G run 評估內存吞吐量時對 8 核 CPU 造成的壓力。

熱力圖分析由 Brendan Gregg 開創,能夠可視化執行時間的集中點。perf report 生成火焰圖,顯示調用堆棧時間分佈,突出顯示消耗不成比例資源的熱路徑。

自動化通過基於閾值的告警閉合了循環。監控 CPU 使用率超過 80% 或內存飽和超過 90% 的腳本會觸發深入調查,將操作從被動補救轉向主動修復。

CPU 優化技術

CPU 優化平衡利用率與公平性,確保容器獲得適當的處理時間,同時避免鄰居無法被調度。

對照組與調度

現代 Docker 利用 cgroup v2 實現細粒度的 CPU 控制。--cpus=2.5 表示分配兩個半核心的 CPU 時間,而 --cpu-shares=2048 則在爭用發生時設定相對優先級。這種組合既保證了絕對限制,也保證了公平的調度。

/etc/docker/daemon.json 中的 "exec-opts": ["native.cgroupdriver=systemd"] 守護進程級配置將 Docker 的 cgroup 管理與大多數現代 Linux 發行版的初始化系統 systemd 集成,從而防止衝突並提升系統事件的可靠性。

CPU 親和性將容器綁定到特定核心:--cpuset-cpus=0-3 限制執行於核心 0 至 3,減少上下文切換並提升緩存區域性。對於 NUMA 系統,--cpuset-mems=0 與容器內的 numactl --cpunodebind=0 結合,確保 CPU 和內存存在於同一 NUMA 節點,顯著降低內存訪問延遲。

實時工作負載需要優先調度。參數 --cpu-rt-period=100000 --cpu-rt-runtime=50000 將每 100 毫秒時間的 50% 分配給實時任務。這種配置適用於對延遲敏感的應用,如音頻處理或工業控制系統。

監控可以防止過度投入。跟蹤 cpu.shares.used.percent(配額使用率)和 cpu.quota.used.percent(絕對配額消耗)以檢測接近限額的容器。高限速表示需要增加配額或優化工作負載。

多核利用與並行性

應用層級調優釋放了多核潛力。對於 Go 應用,在容器內設置 GOMAXPROCS=4 限制 goroutine 並行性為四個核心,防止線程在過載主機上激增。Java 應用受益於顯式垃圾回收線程配置:-XX:ParallelGCThreads=8 用於並行收集階段,-XX:ConcGCThreads=2 用於併發標記。

基線比較可驗證優化。在容器內而非裸機上運行 sysbench --threads=8 cpu,可量化容器化開銷,通常 CPU 負載受限時為 2-5%。如果偏差顯著則表示有配置錯誤。

生產案例研究:某高頻交易平台經歷了 CPU 使用率激增,觸發了 CFS(完全公平調度器)限速。根因分析顯示了激進的 cfs_quota 極限。修復方法包括在高峯時段通過 docker update --cpus 進行動態調整,並結合主機間的工作負載重新平衡。優化後,P99 延遲下降了 40%。

內存優化技術

內存調優防止泄漏,減少碎片化,並避免令人畏懼的 OOM(Out-of-Memory)殺手(即內存耗盡時終止進程)。

限制與監控

硬內存限制防止進程失控:--memory=4g 限制容器使用量為 4 GB。軟保留 --memory-reservation=3g 在主機內存壓力上升時觸發內核回收,允許突發容量同時保護系統。禁用 --memory-swap=-1 可以防止導致性能下降的交換,迫使 OOM 殺手在交換前介入。

OOM 評分調整會影響終止優先級:--oom-score-adj=500 使容器更有可能被終止,從而保護關鍵系統進程。監控 container_memory_failcnt 檢測容器達到內存限制且未造成 OOM,揭示容量規劃需求。

Docker 守護進程配置對共享內存進行調優:在 daemon.json 中設置 "default-shm-size":"128m",分配 128 MB 用於使用 System V 共享內存的應用中的 /dev/shm。應用調優如 JVM 堆大小加 -Xmx3g 確保 Java 進程遵守容器限制,防止主機內存爭用。

碎片化與內存壓力

內存碎片化會降低性能,因為內核難以分配連續的頁面。監控 /proc/buddyinfo 可以發現不同頁順序的碎片化程度。過度碎片化表現為儘管內存可用,仍導致分配失敗。

透明大頁(THP,Transparent Huge Pages)減少了 TLB(translation lookaside buffer)未命中,但可能增加碎片化。通過 --shm-size=1g 以及內核參數 vm.nr_hugepages 明確分配專用的 2MB hugepage,非常適合內存佔用較大的數據庫工作負載。

用 vmstat 1 監控交換,跟蹤換進(si)和換出(so)事件。非零值表示內存壓力會強制交換,性能比 RAM 訪問降低了數個量級。調整 vm.swappiness 控制內核偏好:echo 10 > /proc/sys/vm/swappiness,使內核不願交換,更傾向於重新獲取文件緩存。

生產案例研究:某電商平台在沒有 OOM 的情況下實現了高內存使用率,調查顯示存在嚴重碎片。解決方案是通過數據庫層實現內存壓縮 echo 1 > /proc/sys/vm/compact_memory 並啓用 hugepage。內存效率提升了 25%,減少了兩個節點數。

I/O 優化技術

I/O 常常成為無聲的瓶頸,儘管 CPU 和內存充足,卻限制了吞吐量。通過存儲驅動程序選擇和隊列調優解鎖性能。

存儲驅動程序的選擇與配置

Overlay2 因其高效性而主導現代 Docker 部署,但需要理解權衡關係從而指導最佳選擇。該驅動程序支持頁面緩存共享,即多個容器訪問同一文件時共享單一頁面緩存條目,在高密度環境中大幅減少內存消耗。

對於寫入密集型工作負載,可以考慮調優。在守護進程配置中啓用 "overlay2.metacopy=on" 可推遲寫入數據複製,初始僅複製元數據,僅在修改後複製數據。這種優化加快了鏡像構建和容器啓動,但複雜度略有增加。

Btrfs 提供了快照和子卷功能,對開發工作流有價值,但會帶來隨機寫入開銷。用 fio --direct=1(繞過緩存)進行基準測試,可以揭示在真實工作負載下驅動的特定性能特性。

存儲驅動比較:OverlayFS 在 Web 服務器工作負載(讀操作較重)中實現了 900 IOPS,平均延遲為 1.5ms,憑藉其輕量級設計優於 Btrfs(750 IOPS,2.5ms 延遲)。對於數據庫工作負載(寫操作較重),Btrfs 實現了 1,500 IOPS,而 OverlayFS 僅為 1,200 IOPS,這得益於其寫時複製優化。

隊列深度與緩存優化

塊 I/O 權重控制相對優先級:--blkio-weight=500,在多個容器爭奪磁盤時,按比例分配帶寬。IOPS 限制強制執行絕對約束:--device-read-iops=/dev/sda:1000,讀取次數限制在每秒 1000 次,防止噪點鄰居壟斷存儲。

主機級 I/O 調度器的選擇會影響性能。BFQ(預算公平隊列,Budget Fair Queueing)優先考慮延遲而非吞吐量,非常適合旋轉磁盤上的交互工作負載。MQ-deadline 在 SSD 和 NVMe 硬盤上平衡了公平性與性能,提供了確定性延遲,同時避免了 BFQ 的開銷。切換調度器:echo mq-deadline > /sys/block/nvme0n1/queue/scheduler。

隊列深度調優與工作負載特性相匹配。數據庫受益於 128–256 的深度,允許併發操作使現代 SSD 飽和。對於對延遲敏感的應用,將隊列深度減少到 32,可以以犧牲峯值吞吐量為代價,從而減少排隊延遲。

文件系統調優可以額外提升性能。對於 ext4,通過 tune2fs -O ^has_journal /dev/sdX 禁用非核心關鍵數據的日誌功能消除了日誌寫入開銷,寫吞吐量翻倍,但崩潰恢復保證會降低。帶有 iommu=pt 的 NVMe 直通可繞過 IOMMU 轉換,降低直連存儲的延遲。

容器級調優採用 posix_fadvise 來暗示緩存行為:POSIX_FADV_SEQUENTIAL,優化流讀取,而 POSIX_FADV_WILLNEED 則異步預取數據。監控 iostat -x 1 可追蹤利用率,持續值超過 90% 表示飽和度需要擴容或卸載。

網絡 I/O 優化使用主機模式網絡:--network host,繞過 Docker 的 NAT 層,消除對延遲關鍵服務的轉換開銷。權衡:犧牲網絡隔離,以換取適合可信環境的性能。或者,卸載校驗和:ethtool -K eth0 tx off,將校驗和計算移給硬件,從而降低 CPU 佔用。

整體性能調優框架

集成框架將孤立優化轉化為系統化實踐,實現整個技術棧的持續性能提升。

自動化與動態調優

像 Ansible 這樣的基礎設施即代碼工具可以大規模自動化性能調整。Playbook 監控 Prometheus 指標並動態調整容器 CPU 分配:當平均負載超過 70% 持續五分鐘時,將 --cpus 增加 0.5 個。這種反應式調校在用户察覺到問題之前就完成調整,避免出現瓶頸。

腳本化修復響應告警:Prometheus 告警規則觸發 webhook,調用腳本以水平擴展容器副本,當請求隊列超過閾值時。這種自動化將解決問題的平均時間從幾分鐘(人工干預)縮短到幾秒(自動響應)。

集羣級優化

Docker Swarm 的部署約束能夠智能分配工作負載。placement.preferences 字段通過 spread: node.cpu 在節點間分散副本,防止主機過載。通過 --reserve-cpu=1 保留資源,確保宿主守護進程即使在容器壓力下仍保持容量。

負載均衡策略會影響性能。DNS 輪詢模式(--endpoint-mode dnsrr)繞過了 Swarm 的虛擬 IP(VIP)層,消除了內部服務網格通信的代理開銷。這種優化適用於低延遲微服務架構。

全面測試基準與分析

合成壓力測試驗證優化主張。stress-ng --cpu 4 --io 2 --vm 1 --timeout 60s 同時對 CPU、I/O 和內存施加壓力 60 秒,揭示系統在聯合負載下的表現。這種多維方法能夠檢測單維測試看不到的跨資源爭用。

分析識別優化機會。perf top 顯示實時 CPU 熱點功能,顯示執行時間集中的位置。對於容器化工作負載,通過 PID 命名空間過濾,將容器活動與主機進程隔離開來。

生產驗證比較優化前後指標。Apache Bench 測試負載:ab -n 10000 -c 100 http://localhost/ 發送 10,000 個請求,同時有 100 個併發連接,測量吞吐量(每秒請求)和延遲分佈(P50、P95、P99)。

生產級案例研究:電商平台調優

某高併發電商平台在高峯期結賬表現下降,調查發現了 I/O 和 CPU 的複合瓶頸。

初步評估:cAdvisor 指標顯示塊 I/O 等待時間較長(P95 >20ms)和 CPU 限流(約 30% 調度期)。內存利用率保持良好,60%,排除 OOM 問題。

根因分析:深入剖析揭示了因內存碎片化而加劇的 overlay2 隨機寫入效率低下。容器日誌顯示頻繁的小寫入觸發了寫時複製操作,而 buddyinfo 顯示 3 階(32KB)頁面出現了 90% 的碎片化。

優化策略:多管齊下的修復解決了多層次問題。首先,存儲驅動調優支持 overlay2 元副本,將寫放大降低 40%。其次,每個容器的內存限制從 6GB 提高到 8GB,減少了碎片引發的分配失敗。第三,NUMA 感知調度將容器綁定到單個 NUMA 節點:--cpuset-cpus=0-15 --cpuset-mems=0,確保本地內存訪問。

驗證結果:優化後基準測試在 ab n -5000 -c 500 下顯著提升:吞吐量從 850 TPS 提升至 1,020 TPS(+20%),P95 延遲從 280ms 降至 175ms(-37%),CPU 限流降至 5% 以下。資源效率提升使節點從 12 個整合到 10 個,基礎設施成本降低 16%。

監控與可持續性:Grafana 儀表盤持續跟蹤優化指標。面板顯示塊 I/O 延遲、CPU 限速率和內存碎片化趨勢。當延遲超過 200 毫秒或限速超過 10%時,Prometheus 警報規則會觸發,從而在影響到用户前進行主動干預。

高級主題與未來方向

新興技術將性能優化能力擴展到傳統方法之外,實現更深層次的洞察和更復雜的自動化。

基於 eBPF 的性能追蹤

擴展伯克利分組過濾器(eBPF,Extended Berkeley Packet Filter)實現了內核級的可觀測性且無性能開銷。BPFtrace 腳本配置文件容器 CPU 時間分佈:bpftrace -e 'kprobe:finish_task_switch { @cpu_time[comm] = avg(nsecs); }' 跟蹤每個進程的平均 CPU 時間。這種細緻度揭示了用户空間工具看不到的調度低效問題。

容器感知追蹤將工作負載指標與主機噪聲隔離開來。Tracee 是一款基於 eBPF 的工具,能夠自動檢測容器 PID 命名空間,並僅追蹤容器化事件,從而消除了對宿主進程的雜亂分析。這種精度加快了共享多租户環境中的根因識別。

機器學習驅動預測

時間序列預測能在瓶頸發生前預見問題。Prometheus 的 predict_linear 函數推斷度量趨勢: predict_linear(container_memory_usage_bytes[1h], 3600) 根據過去一小時的趨勢預測一小時內存使用情況。這種前瞻性使得搶佔式擴展或優化成為可能。

異常檢測模型學習正常行為基線,提醒簡單閾值規則未察覺的偏差。Sysdig Secure 利用機器學習分析容器運行時行為,通過行為分析檢測惡意活動和性能異常。

標準化基準套件

可重複的基準測試確保了各環境性能的一致驗證。Phoronix 測試套件提供涵蓋 CPU、內存、存儲和網絡維度的全面 Docker 專用基準測試。標準化結果使硬件配置、存儲驅動和編排策略之間能夠客觀比較。

自動化腳本示例

實用腳本將性能調優付諸實踐,使團隊能夠快速驗證並部署優化方案。

性能基線腳本:該綜合基準同時強調多個維度,建立能力規劃和迴歸測試的性能基線。

#!/bin/bash

# Multi-dimensional container performance baseline

echo "=== Docker Performance Baseline Test ==="

echo "Starting: $(date)"

# CPU + Memory + I/O stress test

echo -e "\n[1/3] Running combined stress test (60s)..."

docker run --rm -it \

--cpus=2 \

--memory=4g \

--name stress-test \

stress-ng \

--cpu 4 \

--io 4 \

--vm 2 \

--vm-bytes 1G \

--metrics-brief \

--timeout 60s

# CPU benchmark

echo -e "\n[2/3] CPU benchmark (sysbench)..."

sysbench --threads=8 --time=60 cpu run > results_cpu.log

# I/O benchmark

echo -e "\n[3/3] I/O benchmark (fio)..."

fio --name=iotest \

--rw=randrw \

--bs=4k \

--iodepth=64 \

--size=4G \

--numjobs=4 \

--runtime=60 \

--group_reporting > results_io.log

echo "Completed: $(date)"

echo "Results saved to: results_*.log"該腳本運行三個互補測試:用於綜合資源壓力的 stress-ng,用於 CPU 基線的 sysbench,以及用於 I/O 性能特性的 fio。結果建立了優化後比較的定量基線。

結論

Docker 性能調優將容器化應用從可工作轉變為卓越,帶來可衡量的延遲、吞吐量和成本效益改進。利用現代可觀測性工具系統性識別瓶頸,揭示了 CPU 調度、內存管理和 I/O 子系統中的隱藏約束。

優化過程有條不紊進行:用基準工具建立基線,通過集成指標棧持續監控,系統使用分層診斷方法進行分析,針對內核和容器級參數進行有意識的調整,並通過生產測試進行嚴格驗證。

實際部署顯示了影響:電子商務平台吞吐量提升了 20%,金融科技應用延遲減少了 40%,基礎設施團隊通過資源整合降低了 16% 的成本。這些成果源於對 Docker 架構基礎的理解,利用 Linux 內核能力,並應用數據驅動的優化方法。

隨着容器化不斷髮展,eBPF 追蹤和機器學習驅動預測等新興技術拓展了優化的可能性。然而,基本原則始終不變:先測量再優化,一次只調整一個變量,客觀驗證結果,並實現自動化。掌握這些實踐的團隊能夠最大化 Docker 價值,提供卓越用户體驗,同時最大限度減少基礎設施開支。

達到卓越 Docker 性能的道路是迭代的,而非瞬間完成。從全面監控開始,識別影響最大的瓶頸,實施針對性優化,並基於生產數據持續優化。這種嚴謹的方法將性能從事後考慮變成競爭優勢,使應用能夠可靠擴展、響應迅速,並在生產環境中經濟運行。

你好,我是俞凡,在Motorola做過研發,現在在Mavenir做技術工作,對通信、網絡、後端架構、雲原生、DevOps、CICD、區塊鏈、AI等技術始終保持着濃厚的興趣,平時喜歡閲讀、思考,相信持續學習、終身成長,歡迎一起交流學習。為了方便大家以後能第一時間看到文章,請朋友們關注公眾號"DeepNoMind",並設個星標吧,如果能一鍵三連(轉發、點贊、在看),則能給我帶來更多的支持和動力,激勵我持續寫下去,和大家共同成長進步!

本文由mdnice多平台發佈