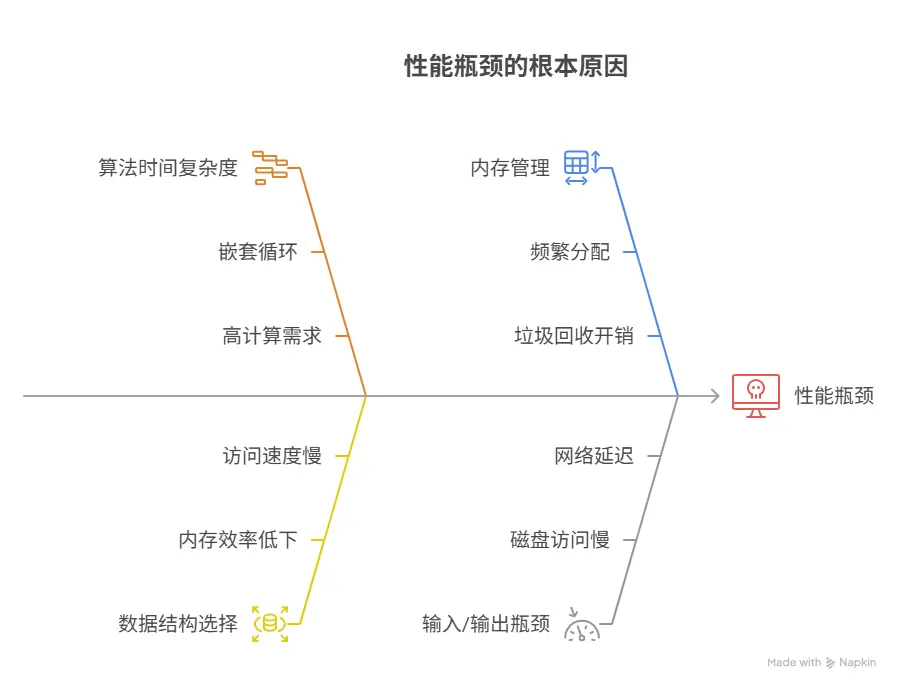

程序在處理少量數據時運行如飛,一旦數據量激增,性能便急劇下降甚至崩潰,這一現象的根源,在於程序內部的“處理成本”與“數據規模”之間,形成了一種“非線性”的增長關係。一個設計欠佳的程序,其處理成本的增長速度,可能遠超數據量的增長速度。導致這種性能瓶頸的五大核心“元兇”通常包括:算法的時間複雜度過高、不合適的數據結構選擇、內存的頻繁分配與垃圾回收、磁盤或網絡輸入輸出的瓶頸、以及數據庫查詢的低效。

其中,算法的時間複雜度過高,是最根本、也最具決定性的因素。例如,一個採用了“嵌套循環”來進行數據匹配的算法,其計算量,會隨着數據量N的增長,而成N的平方(N²)級別增長。當N從100增加到10000時(數據量增加100倍),其計算量,將從1萬次,暴增到1億次(計算量增加10000倍),性能的急劇下降,便不可避免。

一、問題的本質:從“線性增長”到“指數爆炸”

要理解性能為何會“急劇”下降,我們必須首先,在腦中,建立一個關於“成本增長”的數學模型。程序的性能,並非一個非黑即白的“快”或“慢”的狀態,而是一條描述“處理時間(或資源消耗)”隨“輸入數據規模”變化的“增長曲線”。

- 算法複雜度的“標尺”

在計算機科學中,我們使用“大O表示法”來描述這條曲線的“增長趨勢”,即算法的時間複雜度。

理想狀態 O(1) - 常數時間:無論處理10條數據,還是1000萬條數據,程序的執行時間,都基本保持不變。這是最理想的性能。

優秀狀態 O(log n) - 對數時間:執行時間,隨着數據規模的對數增長。即使數據量翻倍,執行時間的增長也微乎其微。例如,在有序數組中進行二分查找。

良好狀態 O(n) - 線性時間:執行時間,與數據規模,成正比增長。數據量增加10倍,耗時也大致增加10倍。這是大多數簡單操作的、可接受的性能表現。

危險狀態 O(n²) - 平方時間:這是導致性能“急劇下降”的、最常見的“罪魁禍首”。執行時間,與數據規模的平方,成正比。數據量增加10倍,耗時將暴增至100倍。

災難狀態 O(2ⁿ) - 指數時間:執行時間,隨着數據規模,呈指數級爆炸。這類算法,通常只適用於處理極小規模的數據。

- 性能“拐點”的出現

一個O(n²)的算法,在處理n=10這樣的小數據量時,其計算量可能只有100次,速度飛快,與O(n)算法的10次計算,在體感上,幾乎沒有差別。這使得,這類性能問題,在開發和單元測試階段,極易被“忽略”。 然而,當程序被部署到生產環境,開始處理n=100,000的真實數據時,O(n²)算法的計算量,將飆升至100億次,而O(n)算法,則只有10萬次。兩者之間的性能差異,將是天壤之別。這個從“感覺很快”到“慢到卡死”的突變點,就是性能的“拐點”。

正如計算機科學巨匠高德納(Donald Knuth)所言:“過早的優化是萬惡之源。” 但他後面還有半句話常被忽略:“然而,我們不應錯過那關鍵3%的機會。” 這提醒我們,雖然不應在所有代碼上都過度追求性能,但對於那些處於“核心路徑”的、需要處理大量數據的代碼,對其複雜度的預先分析和優化,是至關重要的、必不可少的“關鍵機會”。

二、元兇一:算法的“時間複雜度”

這是最根本的、也是決定性能上限的內在因素。

- “嵌套循環”的陷阱

一個嵌套了兩層的、且內外兩層循環的次數,都與數據規模N相關的循環,其時間複雜度,天然地,就是O(n²)。

場景示例:在一個包含N個用户的列表中,找出所有“同名”的用户對。Java// 一個時間複雜度為 O(n²) 的低效實現 for (int i = 0; i < userList.size(); i++) { for (int j = i + 1; j < userList.size(); j++) { if (userList.get(i).getName().equals(userList.get(j).getName())) { System.out.println("發現同名用户: " + userList.get(i).getName()); } } }

解決方案:改變算法思路,常常可以用“空間”換“時間”。我們可以使用一個“哈希表”(一種特殊的數據結構),來將這個問題的複雜度,從O(n²),優化到O(n)。Java// 一個時間複雜度為 O(n) 的高效實現 Map<String, Integer> nameCounts = new HashMap<>(); for (User user : userList) { String name = user.getName(); nameCounts.put(name, nameCounts.getOrDefault(name, 0) + 1); } // ... 再遍歷一次哈希表,找出計數大於1的名字

- 低效的“查找”與“排序”

在處理數據時,不恰當地,使用了一些“教科書”級別的、但性能低下的基礎算法。例如,在一個巨大的、未排序的列表中,反覆地進行“線性查找”(其複雜度為O(n))。

三、元兇二:數據結構的“錯配”

算法的性能,與其操作的“數據結構”,是緊密耦合、互為表裏的。選擇一個與操作場景“不匹配”的數據結構,同樣會引發性能災難。

場景:高頻的“成員資格”檢查

問題:你需要反覆地,檢查某個用户ID,是否存在於一個包含了100萬個“黑名單”ID的列表中。

低效的結構(列表):如果你將這100萬個ID,存儲在一個普通的“列表”或“數組”中,那麼,每一次檢查,程序,都需要從頭到尾,遍歷這個列表,其單次操作的複雜度是O(n)。

高效的結構(哈希集合):如果你將它們,存儲在一個“哈希集合”中,那麼,每一次檢查,程序,都只需要進行一次哈希計算,其單次操作的平均複雜度,是O(1),即與黑名單的規模大小,無關。

場景:頻繁的“中間插入”

問題:你需要在一個包含了大量元素的列表中,頻繁地,在其中間位置,插入新的元素。

低效的結構(數組):如果你使用“數組”來實現,那麼,每一次的中間插入,都將迫使數組,將其後續的所有元素,都向後“挪動”一個位置。這個操作的複雜度是O(n)。

高效的結構(鏈表):如果使用“鏈表”,則只需要修改前後兩個節點的“指針”即可,其操作複雜度是O(1)。

四、元兇三:內存的“瓶頸”與“顛簸”

當數據量,大到一定程度時,內存的“容量”和“管理效率”,就會成為新的、嚴峻的瓶頸。

- 一次性加載“巨型”數據 一個最常見的、導致程序因“內存溢出”而直接崩潰的錯誤,就是試圖,將一個遠超內存容量的“巨型”文件(例如,一個10GB的日誌文件),一次性地,全部讀取到內存中,來進行處理。

【解決方案】:必須採用“流式處理”或“分塊處理”的方式。即,每次只讀取文件的一小部分(例如,10MB)到內存中進行處理,處理完畢後,再讀取下一塊,直至文件末尾。

- 頻繁的“對象創建”與“垃圾回收” 在Java, C#, Go等具有“自動內存管理”的語言中,我們無需手動釋放不再使用的內存,這個工作,由一個名為“垃圾回收器”的後台進程來完成。

問題:如果我們的代碼,在一個處理大量數據的、緊湊的循環中,不必要地,創建了數以百萬計的、生命週期極短的“臨時對象”,那麼,這就會給“垃圾回收器”,帶來巨大的壓力。

後果:垃圾回收器,可能會被頻繁地觸發。而在許多垃圾回收算法的執行過程中,都需要或多或少地,暫停我們應用程序的正常運行(即所謂的“Stop-the-World”)。這種由垃圾回收,所引發的、週期性的“程序卡頓”,在高併發、大數據量的場景下,是性能急劇下降的一個重要元兇。

五、元兇四:輸入輸出的“等待”

在很多時候,我們的程序,之所以“慢”,並非因為中央處理器在“拼命計算”,而恰恰是因為,它在“無所事事地,等待”數據的到來。這種“等待”,就是“輸入輸出”瓶頸。

- 數據庫的“慢查詢” 這是在Web應用和後台服務中,最普遍、最致命的性能瓶頸。

未加“數據庫索引”的查詢:當你在一個擁有數千萬行記錄的“訂單”表上,試圖根據一個“用户ID”,去查詢其訂單時,如果沒有為“用户ID”這個列,建立“索引”,那麼,數據庫,就不得不,像翻閲一本沒有目錄的字典一樣,從第一行到最後一行,進行一次完整的“全表掃描”。這個操作的耗時,是災難性的。

N+1查詢問題:這是一個在使用對象關係映射框架時,極其常見、但又很隱蔽的性能殺手。

場景:你首先,查詢出了100個“部門”。然後,在一個循環中,去逐一地,獲取每一個部門下的“員工”。

後果:這個過程,最終,會向數據庫,發起了101次查詢(1次查詢部門,N=100次查詢每個部門的員工)。而一個高效的實現,本應通過一次“連接查詢”,只用1次查詢,就獲取到所有需要的數據。

- 低效的文件讀寫與網絡調用

在處理大文件時,一次只讀寫一個字節,遠比使用“緩衝”技術,一次讀寫一個數據塊,要慢得多。

在一個循環中,向另一個服務,發起了1000次獨立的網絡調用,其總耗時,必然遠高於,將這1000個請求,合併為一次“批量”調用。

六、如何“預防”與“定位”

- 預防策略:將性能“內建”於流程

性能測試:不能等到上線後,才第一次面對“大流量”的考驗。負載測試、壓力測試等性能測試活動,必須被前置到開發和測試周期中來。

代碼審查:在進行代碼審查時,必須將“性能”和“複雜度”,作為一個與“功能正確性”同等重要的審查維度。一個有經驗的架構師,能夠輕易地,從代碼中,嗅出“嵌套循環”、“N+1查詢”等潛在的性能“壞味道”。

架構設計:一個需要處理海量數據的系統,其可擴展性,必須在最初的架構設計階段,就被充分地、系統性地考慮。

- 定位策略:當性能下降時

性能分析工具:這是診斷性能瓶頸的、最專業、也最強大的“手術刀”。一個“性能分析器”,能夠直接地,告訴你,在你的程序運行時:

哪個函數,消耗了最多的中央處理器時間?

哪個對象,佔據了最多的內存空間?

哪個數據庫查詢,被執行的次數最多,且平均耗時最長? 這能夠幫助我們,極其精準地,定位到那個“最熱”的、最需要被優化的代碼點。

日誌分析:在關鍵的業務流程的“入口”和“出口”,都打印一行帶有“時間戳”的日誌。通過分析線上日誌,計算出各個環節的“平均耗時”,我們就可以快速地,定位到整個流程中最慢的那個“瓶頸”環節。

在實踐中,這些預防和定位活動,都需要工具的支撐。例如,團隊的編碼規範(其中應包含性能相關的最佳實踐),可以被沉澱在像 Worktile 這樣的平台的知識庫中。而性能測試的結果、性能分析報告、以及因此而產生的“性能優化”任務,則可以在像 PingCode 這樣的研發管理工具中,被作為專門的工作項,進行指派、跟蹤和管理,確保每一個性能問題,都能被閉環解決。

常見問答 (FAQ)

Q1: 算法的“時間複雜度”和“空間複雜度”有什麼區別?

A1: “時間複雜度”,衡量的是,一個算法的執行時間,隨數據規模增長的趨勢。而“空間複雜度”,衡量的是,一個算法在運行過程中,所需要額外佔用的內存空間,隨數據規模增長的趨勢。有時,我們可以通過“增加空間複雜度”(例如,使用一個哈希表),來換取“降低時間複雜度”。

Q2: 是不是應該在項目一開始,就對所有代碼進行性能優化?

A2: 不是。這恰恰是高德納所警示的“過早優化”。在項目初期,代碼的“清晰性”和“正確性”,遠比“性能”更重要。我們應該在完成了功能,並通過性能測試或線上監控,明確地,定位到了真正的“性能瓶頸”之後,再對那些“關鍵的少數”代碼,進行針對性的優化。

Q3: “數據庫索引”為什麼能極大地提升查詢性能?

A3: 一個“索引”,就如同書籍的“目錄”。如果沒有目錄,要找一個知識點,你需要從第一頁,翻到最後一頁。而有了目錄,你就可以通過幾次快速的查找,直接定位到它所在的頁碼。數據庫索引,正是通過一些高效的數據結構(如B+樹),為數據表的某個(或某些)列,創建了一個類似的“快速查詢目錄”。

Q4: 什麼是“N+1查詢”問題?

A4: “N+1查詢”問題,是指在查詢一個“主”對象列表(1次查詢)後,又在一個循環中,為每一個“主”對象,都單獨地,去查詢其關聯的“子”對象(N次查詢),最終,總共,執行了N+1次數據庫查詢。這是一種極其低效的數據訪問模式,應通過“連接查詢”或“批量預加載”等技術,將其,優化為1-2次查詢。