大家好,我是小悟。

騰訊混元團隊開源了翻譯模型1.5版本,一出手就是兩個“王炸”,Tencent-HY-MT1.5-1.8B和Tencent-HY-MT1.5-7B兩個尺寸的模型,把端側翻譯的門檻拉到了新低,效果還比很多商用API更猛。

端側部署,1GB內存就能跑,手機翻譯自由來了。1.8B模型居然能在手機端離線跑。根據騰訊官方數據,這個模型經過量化壓縮後,內存佔用不到1GB。

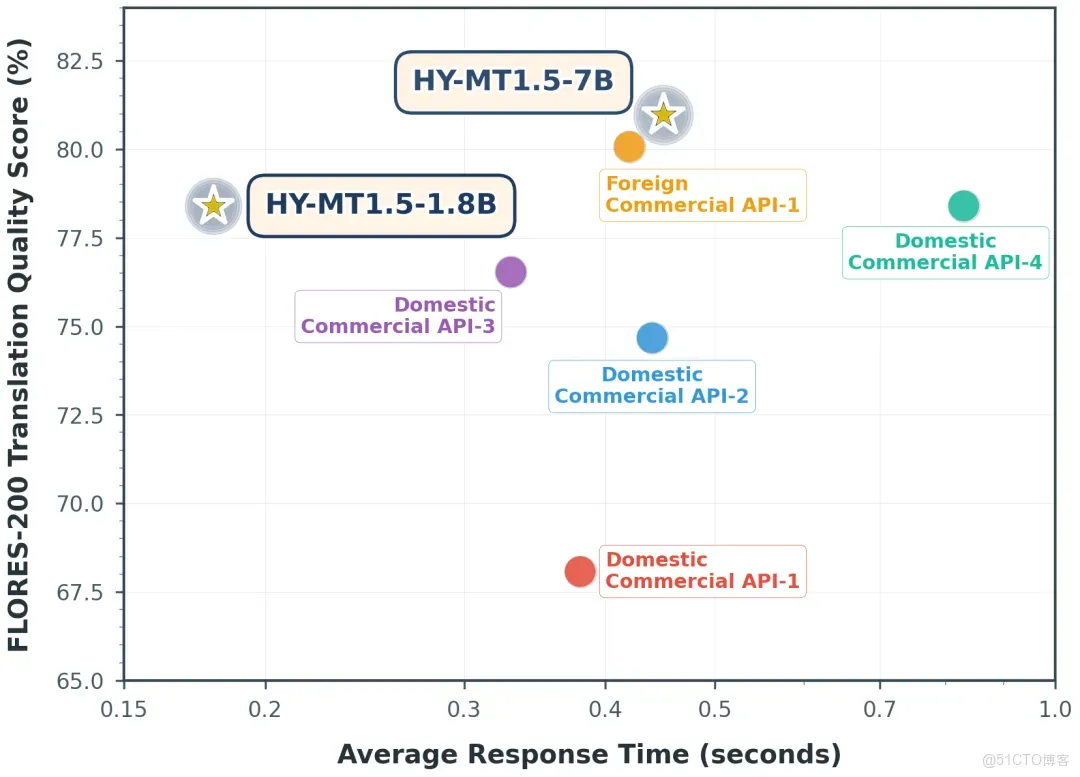

實測顯示,處理50個單詞的翻譯任務,平均耗時只要0.18秒,而主流商用API普遍需要0.4秒左右。

這意味着什麼?可以這樣想象一下,你在國外旅遊時用手機翻譯菜單,或者和外國客户視頻會議時實時生成字幕,不用擔心網絡卡頓了。

更絕的是,這個模型還支持33種語言互譯,連捷克語、冰島語這種小眾語種都覆蓋了。

你要是做跨境電商,之前為了翻譯小語種商品描述,不得不買多個付費API接口,現在直接用混元1.8B就能搞定。可以説是“小身材大能量”的設計。

當然,光快不夠,翻譯質量才是硬指標。

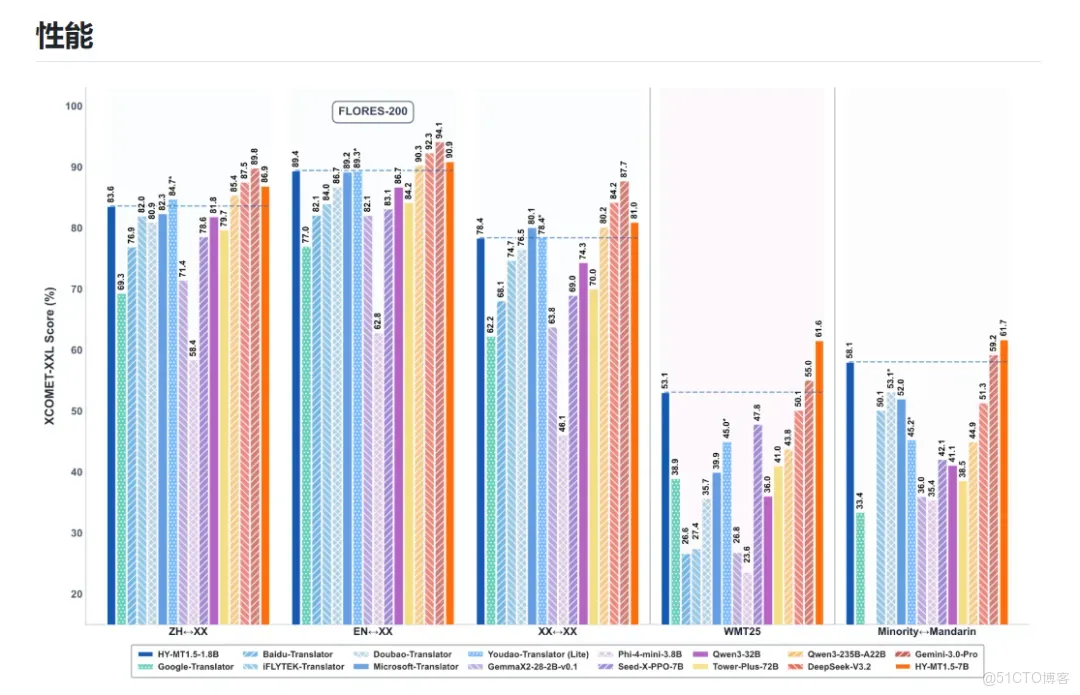

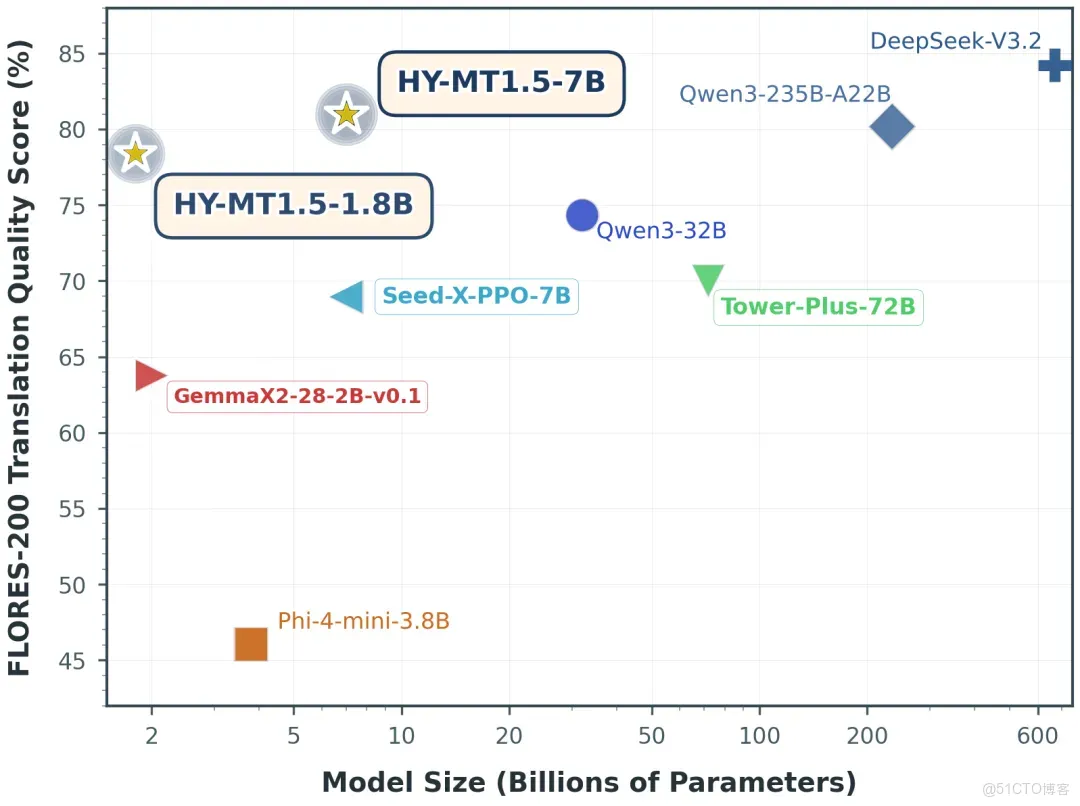

根據權威測試數據,在FLORES-200、WMT25等國際基準測試中,1.8B模型的成績達到了Gemini-3.0-Pro這種超大閉源模型的90分位水平。

要知道,後者可是參數規模幾十倍的“巨無霸”,而混元1.8B只用不到2GB的內存就實現了類似效果,這波操作堪稱“四兩撥千斤”。

它的專業場景適配能力也值得一提。比如法律合同翻譯,混元支持自定義術語庫,能確保“不可抗力”“違約責任”這些關鍵詞始終準確統一。

醫學文獻翻譯時,它能理解長段落中的上下文邏輯,避免“指代不清”的尷尬。甚至翻譯網頁時,還能保留原文的排版格式,直接複製就能用。

這些細節優化,解決了傳統翻譯工具“機械直譯”的痛點,讓AI真正成為生產力工具。

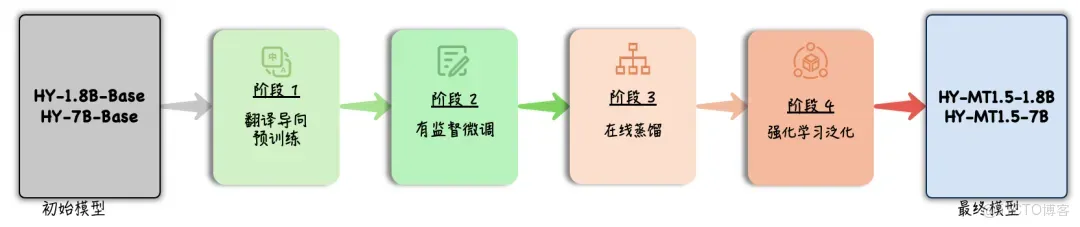

混元團隊這次用了一個很巧的技術,On-Policy Distillation(策略蒸餾)。簡單來説,就是讓7B的大模型當“老師”,實時指導1.8B的小模型學習。

但和傳統蒸餾方法不同,它不是讓小模型死記硬背答案,而是通過糾正預測序列的偏差,讓小模型自己“悟”出翻譯規律。

這種“啓發式”訓練方式,讓小模型在參數量少的情況下,依然能保持高準確率和泛化能力。

這種技術路線,或許成為“輕量化+專業化”的行業趨勢。大模型負責攻克通用任務,小模型通過蒸餾技術繼承核心能力,再針對特定場景優化。

這樣既能降低部署成本,又能滿足多樣化需求。騰訊這次開源,相當於給開發者提供了一套“端側翻譯解決方案”,模型開源降低了技術門檻。

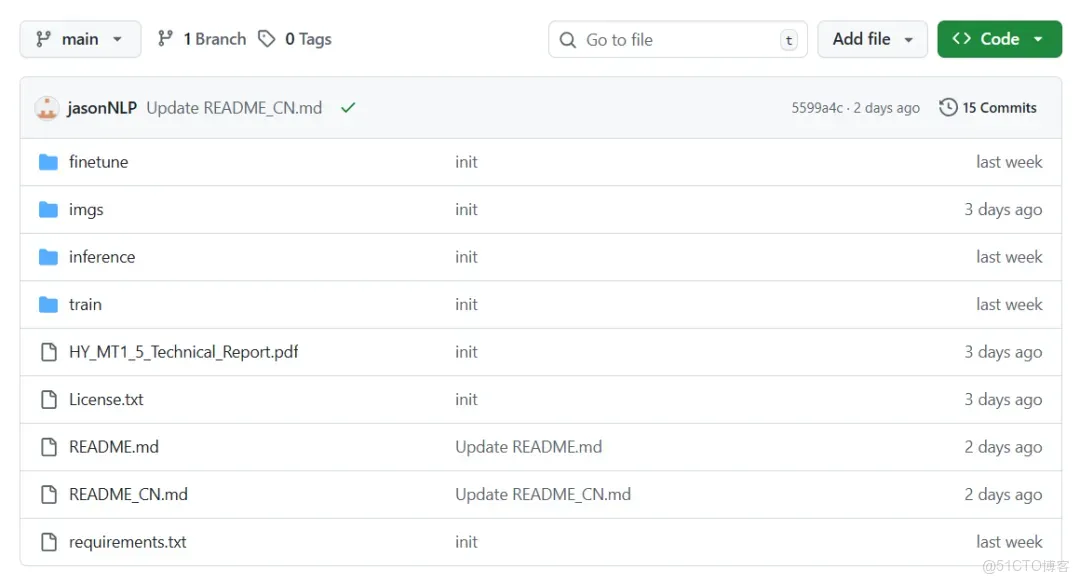

説到開源,模型不僅在GitHub和HuggingFace等平台上線,還支持Arm、高通、Intel等多平台部署。

這意味着開發者可以輕鬆把它集成到手機、IoT設備甚至車載系統中。目前混元翻譯已經在騰訊會議、企業微信等內部產品中落地。

開發者對這類“小而美”的模型需求應該很大。以後可能會出現針對醫療、教育、遊戲等垂直領域的定製版混元翻譯,甚至有人用它開發離線翻譯APP,直接挑戰傳統翻譯軟件的市場。

混元團隊這次開源,或許説明了AI落地不需要“堆參數、燒算力”。通過算法優化和場景深耕,小模型也能在特定領域實現超越大模型的效果。

對於普通用户來説,這意味着更低的使用成本、更快的響應速度和更可靠的隱私保護。對於開發者來説,則提供了一個可複用的技術框架,加速AI應用的創新。

本地安裝與使用,源代碼部署,更多詳細步驟和用法,詳見倉庫文檔:

與 transformers 一起使用

首先,請安裝 transformers,推薦版本 v4.56.0

pip install transformers==4.56.0

如果您想使用 transformers 加載 fp8 模型,您需要將 config.json 中的 "ignored_layers" 名稱更改為 "ignore",並將 compressed-tensors 升級到 compressed-tensors-0.11.0。

以下代碼片段展示瞭如何使用 transformers 庫來加載和應用模型。

我們以 tencent/HY-MT1.5-1.8B 為例。

from transformers import AutoModelForCausalLM, AutoTokenizer

import os

model_name_or_path = "tencent/HY-MT1.5-1.8B"

tokenizer = AutoTokenizer.from_pretrained(model_name_or_path)

model = AutoModelForCausalLM.from_pretrained(model_name_or_path, device_map="auto") # You may want to use bfloat16 and/or move to GPU here

messages = [

{"role": "user", "content": "Translate the following segment into Chinese, without additional explanation.\n\nIt’s on the house."},

]

tokenized_chat = tokenizer.apply_chat_template(

messages,

tokenize=True,

add_generation_prompt=False,

return_tensors="pt"

)

outputs = model.generate(tokenized_chat.to(model.device), max_new_tokens=2048)

output_text = tokenizer.decode(outputs[0])

開源社區:

混元官網:https://hunyuan.tencent.com/modelSquare/home/list

Github鏈接:https://github.com/Tencent-Hunyuan/HY-MT

HuggingFace鏈接:https://huggingface.co/collections/tencent/hy-mt15謝謝你看我的文章,既然看到這裏了,如果覺得不錯,隨手點個贊、轉發、在看三連吧,感謝感謝。那我們,下次再見。

您的一鍵三連,是我更新的最大動力,謝謝

山水有相逢,來日皆可期,謝謝閲讀,我們再會

我手中的金箍棒,上能通天,下能探海