AI手機之深入淺出ADAGRPO三大核心略

為何訓練“手機AI助手”如此困難?

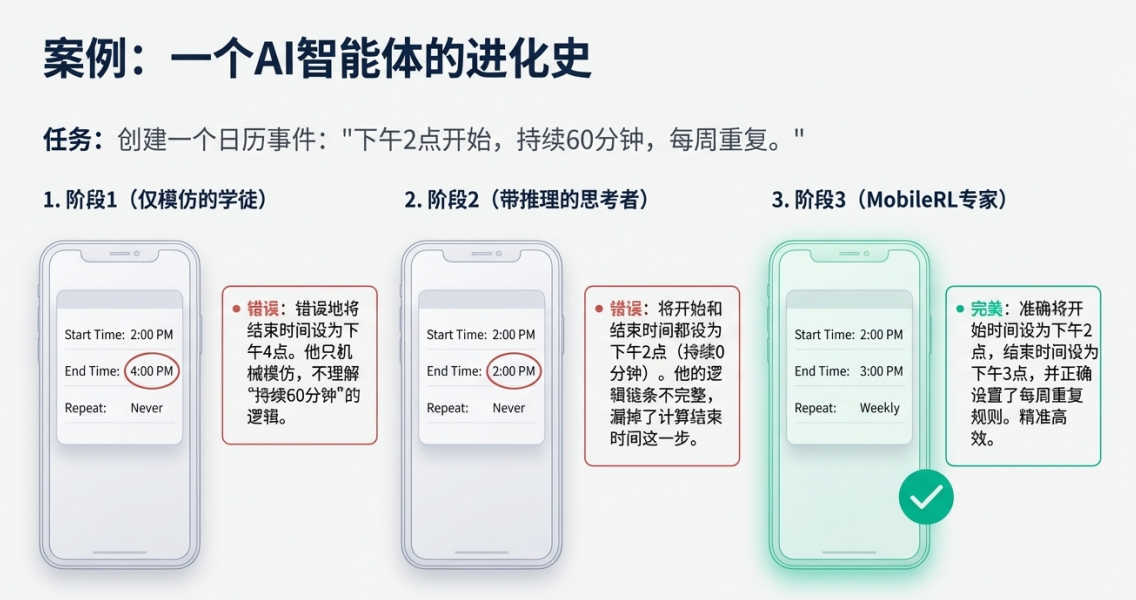

隨着視覺語言模型的飛速發展,能夠自主操作手機圖形用户界面(GUI)的通用智能體——也就是我們常説的“手機AI助手”——的前景變得日益廣闊。想象一下,未來你只需用一句話,AI就能幫你完成打開App、預訂酒店、設置日曆提醒等一系列複雜操作。然而,要將這個願景變為現實,研究人員在使用強化學習(RL)訓練這類智能體時,必須克服幾座技術大山。

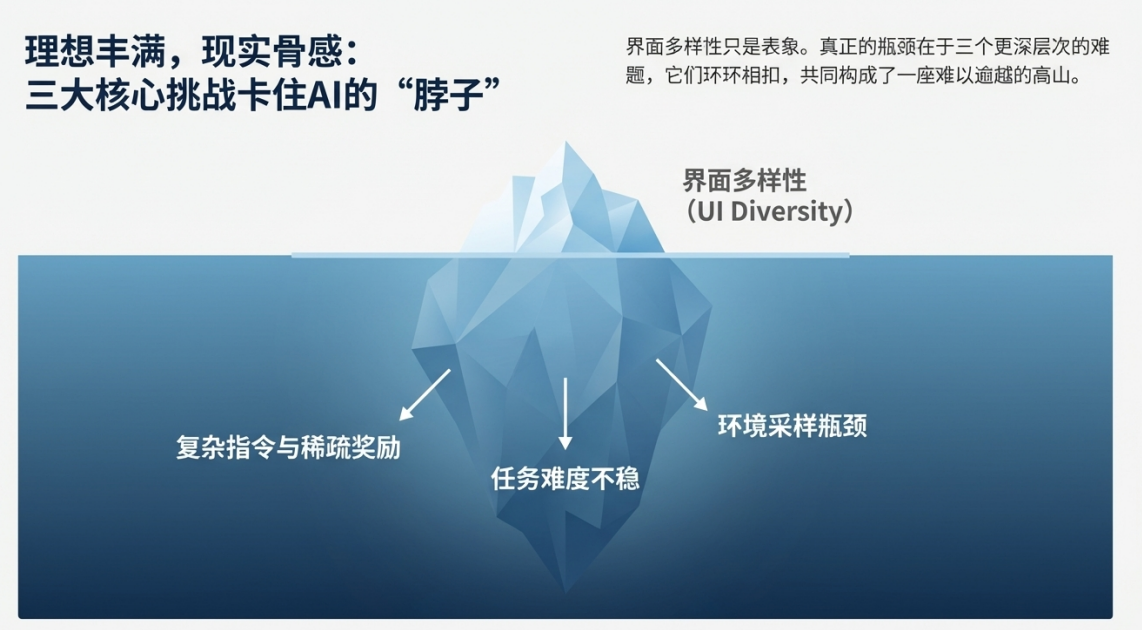

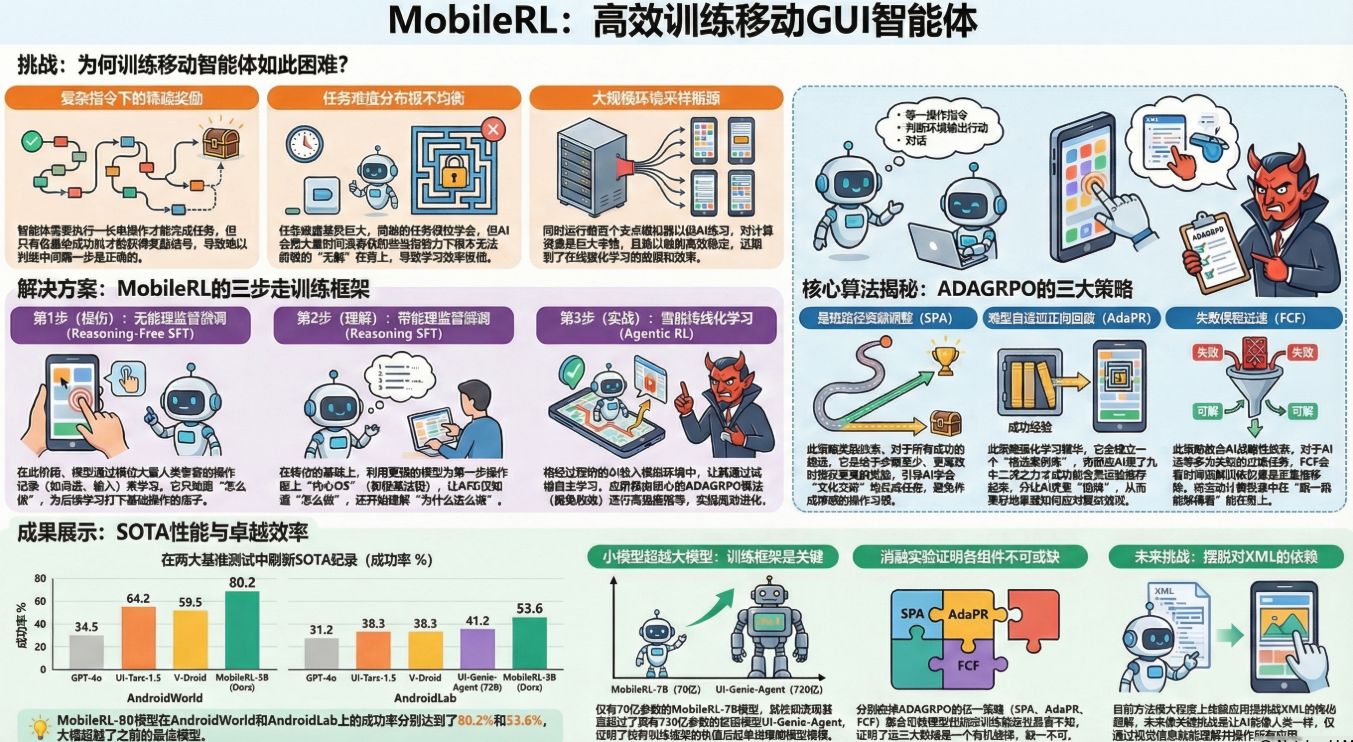

具體來説,訓練一個高效的手機AI助手面臨三大核心挑戰:

• 稀疏的積極信號 (Sparse positive signals): 在多步驟任務中,智能體往往只有在最終成功完成所有操作後才能獲得一個“成功”的獎勵。在漫長的探索過程中,它得不到任何即時的反饋或指導,這就像在一個沒有路標的巨大迷宮中尋找出口,極大地降低了學習效率。

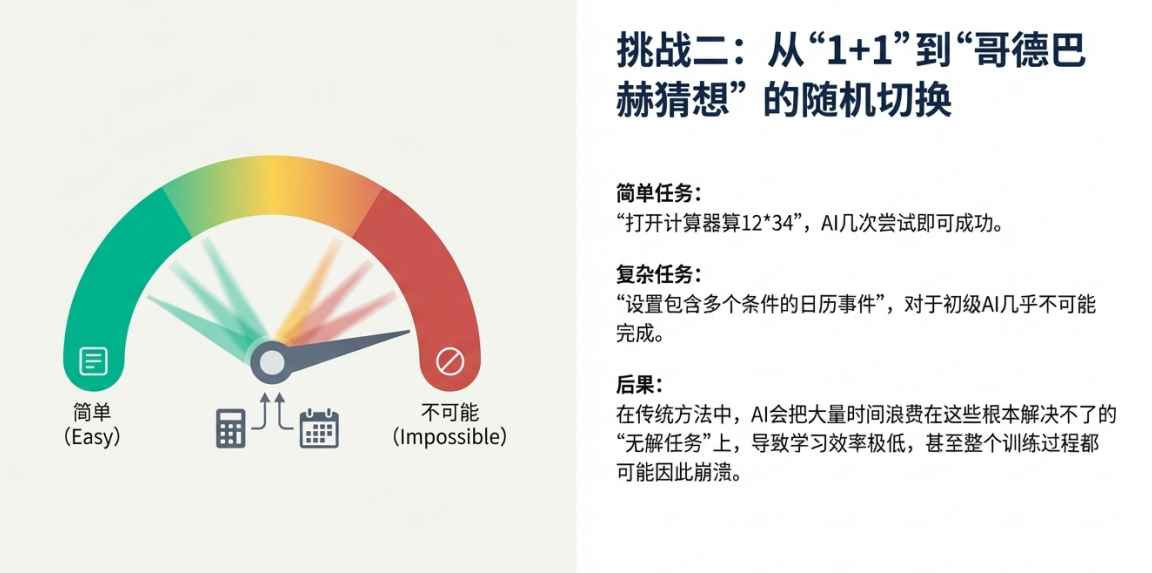

• 任務難度差異巨大 (Large and unstable task difficulty spectrum): 手機上的任務難度分佈極其不均。有些任務非常簡單,智能體嘗試幾次就能成功;而另一些任務則可能對當前的模型來説是“不可能完成的”。如果採用樸素的訓練方法,模型會在這些無法解決的“死衚衕”任務上反覆嘗試,白白浪費大量的計算資源。

• 高昂的採樣成本 (Inefficiency of large-scale environment sampling): 在手機模擬器中讓AI進行一次完整的嘗試(即一次“採樣”),是一個既耗時又消耗計算資源的過程。低下的採樣效率嚴重製約了在線強化學習的規模和速度。

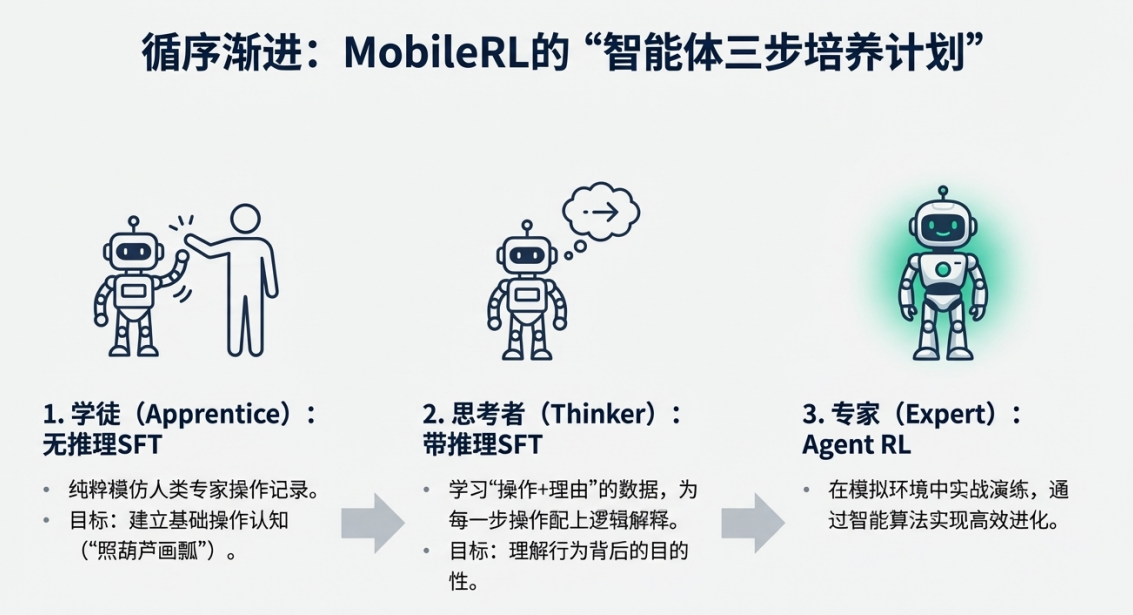

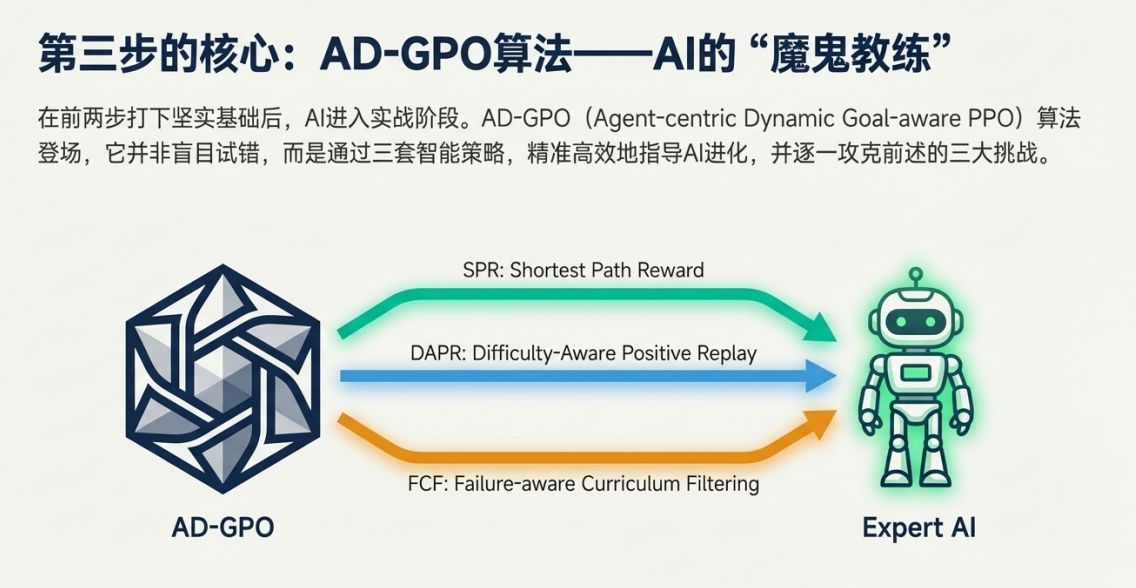

為了系統性地解決這些挑戰,研究人員設計了難度自適應羣組相對策略優化算法 (Difficulty-ADAptive GRPO, ADAGRPO)。它並非憑空創造,而是對一個名為羣組相對策略優化(GRPO)的現有方法進行了重要增強,通過引入三個新穎的、能夠自適應任務難度的策略,讓AI的訓練過程變得更加智能和高效。

本文檔的目的,就是逐一拆解ADAGRPO算法的三個關鍵策略——SPA、AdaPR和FCF,通過圖文並茂的方式,幫助你清晰地理解它們各自的原理,以及它們如何協同工作,最終煉成一個更強大的手機AI助手。

那麼,ADAGRPO是如何巧妙應對這些挑戰的呢?讓我們首先來看它如何定義“成功”的價值——最短路徑獎勵調整(SPA)策略。

一. 最短路徑獎勵調整 (SPA) —— 教會AI“走捷徑”,追求高效

要解決的問題

在強化學習中,一個常見的做法是給所有成功的嘗試打上相同的分數(例如,獎勵=1)。但這會帶來一個隱蔽的問題,即“獎勵偏見”。如果完成同一個任務有兩條路徑,一條需要5步,另一條需要15步,它們都成功了,也都獲得了相同的獎勵。模型在學習時,會更傾向於那條15步的路徑,因為它貢獻了更多的梯度更新項。這種傾向不僅效率低下,更不符合用户對簡潔、高效操作的期望。

工作原理

最短路徑獎勵調整 (Short-Path Reward Adjustment, SPA) 的核心思想非常直觀:它不僅僅獎勵“成功”,更獎勵“高效的成功”。

SPA通過一種動態的獎勵調整機制,以當前訓練批次中最短的成功路徑為基準,對其他較長的成功路徑進行適度的“懲罰”。這樣一來,更短、更直接的成功路徑就能獲得相對更高的獎勵值,從而引導模型學習最高效的解決方案。

該策略的獎勵計算公式如下: RSPA(st, at) = r(τi) * (1 - α * (Ti - Tmin) / Ti)

• r(τi): 軌跡 i 的原始獎勵,成功為1,失敗為0。

• Ti: 軌跡 i 的總步數(路徑長度)。

• Tmin: 在當前批次的所有成功軌跡中,最短的那條路徑的長度。

• α: 一個控制懲罰強度的超參數(0到1之間)。

這個公式意味着,只有最短的成功路徑能獲得滿分獎勵。其他成功路徑的獎勵會根據其超出最短路徑的長度比例進行折扣,路徑越長,折扣越大。

核心價值 (The "So What?")

• 消除偏見: 有效地抵消了模型在訓練中偏愛冗長、繁瑣操作路徑的傾向。

• 提升效率: 引導模型學習更短、更符合用户直覺的解決方案,顯著提升了任務完成的步驟效率 (step efficiency)。

通過SPA,我們讓智能體懂得了“好”的成功是高效的。但對於那些來之不易的成功經驗,我們又該如何讓智能體牢牢記住並反覆學習呢?這就是難度自適應正向回放(AdaPR)策略要解決的問題。

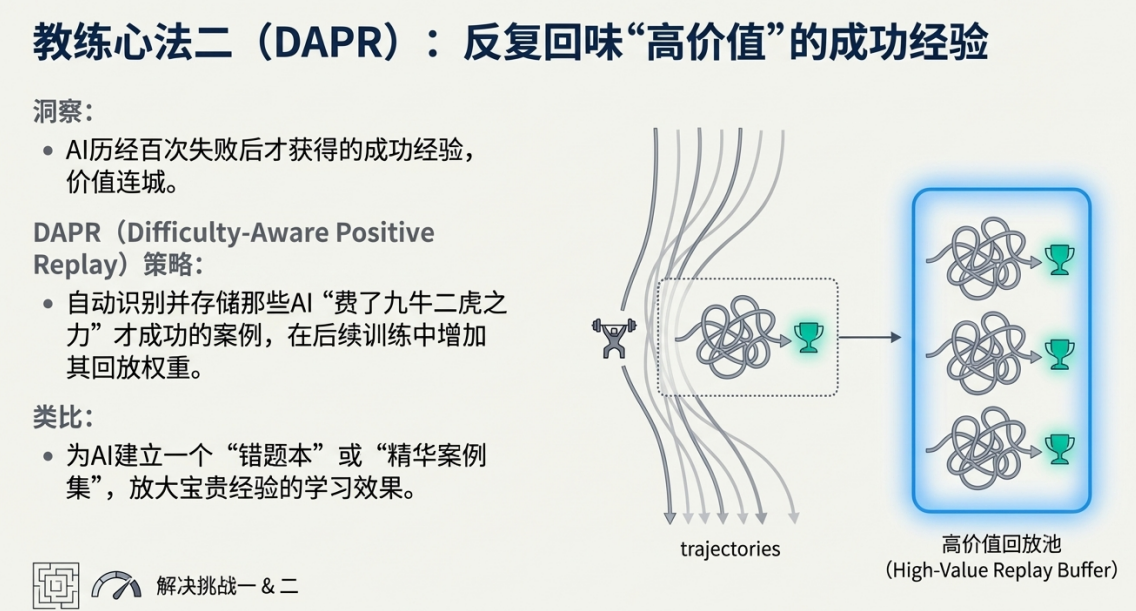

二. 難度自適應正向回放 (AdaPR) —— 打造AI的“好題本”,鞏固稀有成功經驗

要解決的問題

在獎勵稀疏的環境下,那些困難任務的成功經驗就像金子一樣寶貴——它們既稀有,又包含着極其豐富和有價值的學習信號。傳統的訓練方法通常對所有新產生的經驗一視同仁地進行學習(均勻採樣),這會導致那些寶貴的成功案例被海量的普通或失敗案例所淹沒,其學習信號無法被有效利用。這就像學生做練習,不對難題、錯題進行歸納複習,學習效果自然大打折扣。

工作原理

難度自適應正向回放 (Difficulty-Adaptive Positive Replay, AdaPR) 的核心思想,就是為AI打造一個專屬的“好題本”,策略性地存儲和重放那些有價值的、困難的成功軌跡。它借鑑了強化學習中經典的經驗回放 (experience replay) 範式,並將其應用得更具策略性。

它的工作流程分為兩步:

1. 構建高質量經驗池 (Buffer Construction): 系統會維護一個“經驗回放緩衝區”(Replay Buffer)。當智能體在探索中完成一個任務並取得成功時,系統會通過其軌跡級優勢值 (trajectory-level advantage) 來評估這次成功經驗的價值。那些被判定為困難且高價值的成功軌跡會被篩選出來,存入這個專屬的經驗池中。

2. 混合採樣與學習 (Mixture Sampling): 在每次進行模型更新時,訓練過程不再僅僅依賴於新探索產生的“在策略”(on-policy)樣本。它會從經驗池這個“好題本”中,抽取一部分高質量的成功經驗,並與新樣本混合在一起,共同用於模型的學習。這確保了模型既能“温故知新”,鞏固已經掌握的困難技能,又能不斷探索新的可能性。

核心價值 (The "So What?")

• 放大關鍵信號: 極大地放大了稀有但信息量豐富的成功案例的學習效果,讓模型對如何解決困難問題學得更紮實、更深刻。

• 穩定訓練過程: 通過反覆“複習”高價值的成功經驗,幫助穩定策略的更新過程,有效防止模型在探索新策略時遺忘已經學會的關鍵技能。

AdaPR確保了每一次寶貴的成功都不會被浪費。然而,面對那些AI屢戰屢敗、似乎無法逾越的難題,我們是應該讓它繼續死磕,還是選擇策略性放棄呢?這引出了我們的第三個策略——失敗課程過濾(FCF)。

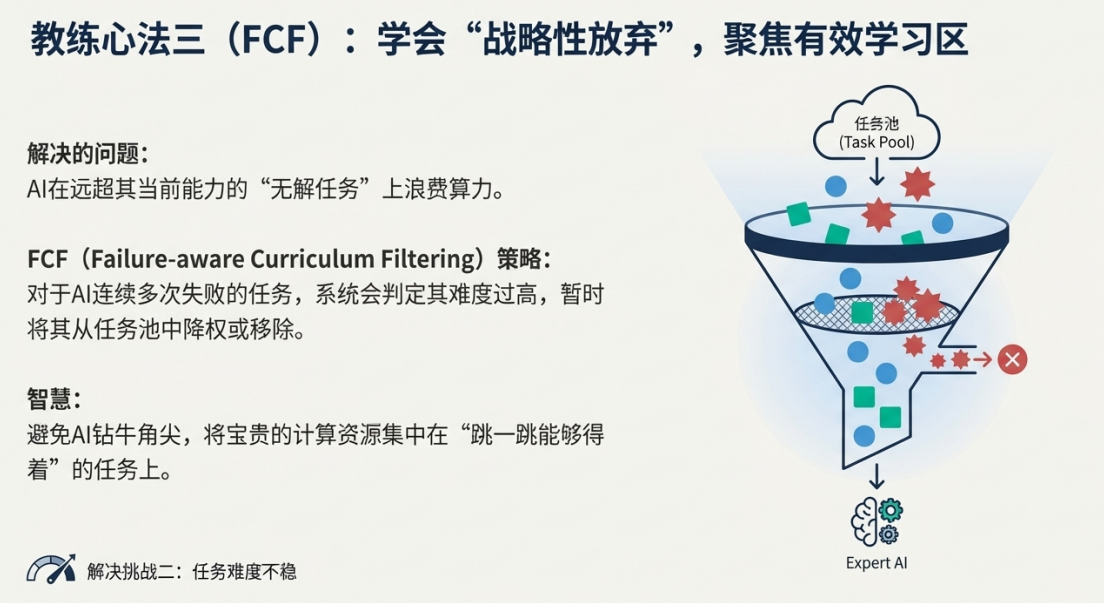

三.失敗課程過濾 (FCF) —— 學會“策略性放棄”,聚焦可學範圍

要解決的問題

移動智能體面臨的任務存在“難度重尾分佈”現象(通俗地説,就是絕大多數任務難度適中,但有少數幾個任務極其困難,佔用了不成比例的失敗嘗試次數)。對於當前階段的模型來説,這些極難的任務就像是持續無法解決的“死衚衕”。如果讓模型在這些任務上反覆嘗試,不僅無法獲得任何有價值的積極信號,還會嚴重浪費寶貴的計算資源和時間,拖慢整體的學習進度。

工作原理

失敗課程過濾 (Failure Curriculum Filtering, FCF) 的核心思想,是一種簡化的課程學習(Curriculum Learning)。它通過動態調整任務的採樣權重,智能地減少在那些“似乎無解”的任務上的資源投入。

FCF的機制如下: 系統會追蹤每個任務的失敗歷史。如果一個任務連續數個週期都完全失敗(例如,連續2個週期),系統就會大幅降低其被採樣的概率(進入“冷卻期”),若持續失敗則可能將其從訓練池中永久移除。

核心價值 (The "So What?")

• 優化計算預算: 將寶貴的計算資源從那些當前無法解決的任務上,重新分配到模型有潛力學習和改進的可行任務上,實現了計算資源的智能調度。

• 提高樣本效率: 通過聚焦於“可解”和“待解”的問題範圍,確保了模型每次探索生成的訓練數據(軌跡)更有可能包含有價值的學習信號,從而從整體上提高了訓練的樣本效率。

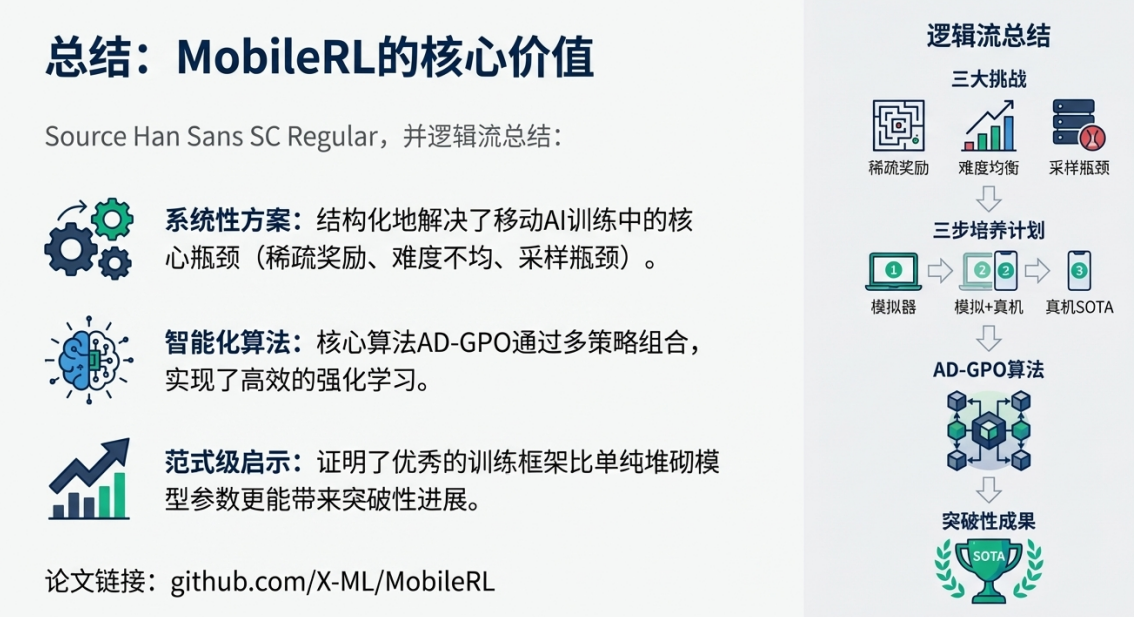

至此,我們已經分別瞭解了ADAGRPO的三個“錦囊妙計”。但它們的威力並不僅僅是簡單的相加,而是三位一體、協同作戰的結果。

四. 協同作用:三位一體,打造高效穩定的學習框架

ADAGRPO的三個策略並非孤立工作,而是相輔相成,共同構成一個高效、穩定的學習框架,系統性地解決了移動智能體訓練中的核心難題。

下圖以流程圖的形式,直觀地展示了三者在訓練循環中的協同工作方式:

[開始] --> 1. 智能體與手機環境交互,生成經驗軌跡

|

V

2. FCF (失敗課程過濾) 動態調整任務採樣權重,

優先選擇“可學習”的任務進行下一輪交互。

|

V

3. SPA (最短路徑獎勵調整) 對成功完成的軌跡進行評分,

為更高效的(路徑更短的)成功軌跡賦予更高的獎勵。

|

V

4. AdaPR (難度自適應正向回放) 將高價值的成功軌跡

(如攻克難題的經驗)存入專屬的“經驗池”。

|

V

5. 模型更新:將來自“經驗池”的寶貴舊經驗與新產生的經驗混合,

共同用於更新模型策略。

|

V

[返回步驟 1,開始新的循環]

我們可以這樣理解它們的協同流程: 首先,FCF 扮演“課程設計師”的角色,它預先篩選出當前值得學習的“題目範圍”,避免AI在無法解決的問題上浪費時間。接着,智能體在這些被篩選過的任務上進行探索和嘗試。對於探索中攻克的“難題”(高質量的成功軌跡),AdaPR 就像一個“智能好題本”,將其收錄並讓智能體反覆“複習”,以加深理解。最後,在每一次成功的“解題”後,SPA 充當“評分老師”,為那些解法“簡潔優美”(即路徑最短)的成功案例打上更高的分數,激勵AI追求更高效的解決方案。

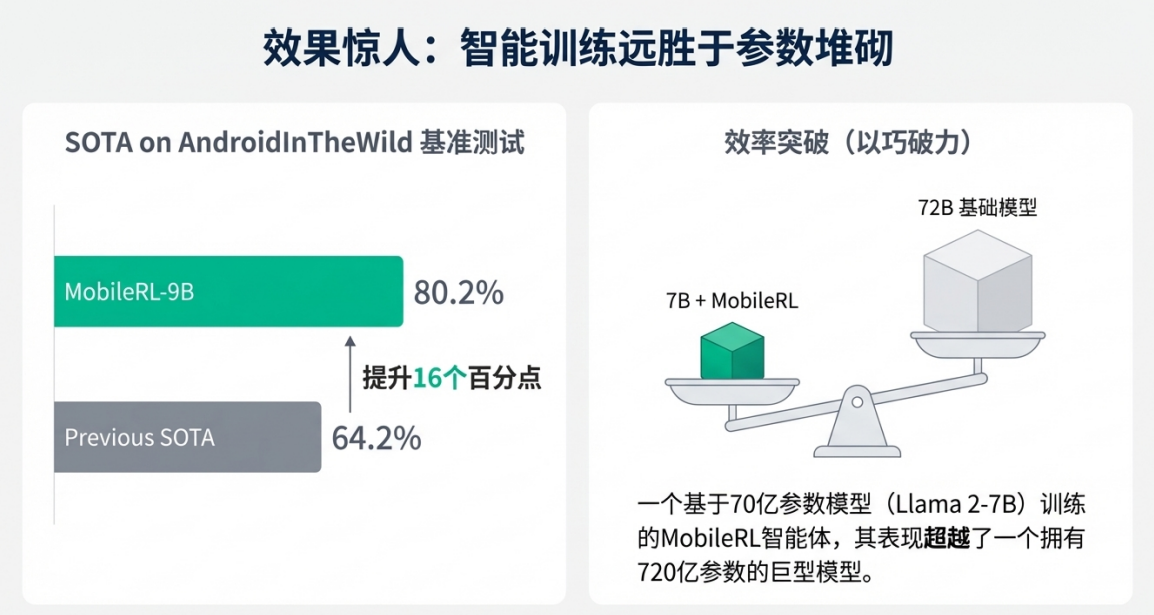

從強化學習的角度看,這個框架通過課程學習(FCF)優化了探索空間,通過獎勵重塑(SPA)優化了信用分配,並通過優先經驗回放(AdaPR)優化了樣本利用率,從而系統性地提升了在線學習的穩定性和效率。

總結

ADAGRPO算法通過三個設計精巧且互補的核心策略,為訓練手機AI助手這一複雜挑戰提供了系統性的解決方案:

• 最短路徑獎勵調整 (SPA): 重新定義了“成功”,讓效率成為衡量標準。

• 難度自適應正向回放 (AdaPR): 珍視並放大了每一個來之不易的成功經驗。

• 失敗課程過濾 (FCF): 學會了“策略性放棄”,讓學習資源聚焦於最有價值的地方。

這三個策略的共同目標,都是通過智能地適應任務難度、放大有效信號並提升求解效率,來克服移動GUI智能體在線強化學習中的種種障礙。ADAGRPO的成功實踐,最終助力模型在AndroidWorld等關鍵基準測試中取得了超過80%的成功率,為我們未來構建更強大、更通用的GUI交互智能體,展示了一條清晰而有效的路徑。

今天先到這兒,希望對AI,雲原生,技術領導力, 企業管理,系統架構設計與評估,團隊管理, 項目管理, 產品管理,信息安全,團隊建設 有參考作用 , 您可能感興趣的文章:

微服務架構設計

視頻直播平台的系統架構演化

微服務與Docker介紹

Docker與CI持續集成/CD

互聯網電商購物車架構演變案例

互聯網業務場景下消息隊列架構

互聯網高效研發團隊管理演進之一

消息系統架構設計演進

互聯網電商搜索架構演化之一

企業信息化與軟件工程的迷思

企業項目化管理介紹

軟件項目成功之要素

人際溝通風格介紹一

精益IT組織與分享式領導

學習型組織與企業

企業創新文化與等級觀念

組織目標與個人目標

初創公司人才招聘與管理

人才公司環境與企業文化

企業文化、團隊文化與知識共享

高效能的團隊建設

項目管理溝通計劃

構建高效的研發與自動化運維

某大型電商雲平台實踐

互聯網數據庫架構設計思路

IT基礎架構規劃方案一(網絡系統規劃)

餐飲行業解決方案之客户分析流程

餐飲行業解決方案之採購戰略制定與實施流程

餐飲行業解決方案之業務設計流程

供應鏈需求調研CheckList

企業應用之性能實時度量系統演變

如有想了解更多軟件設計與架構, 系統IT,企業信息化, 團隊管理 資訊,請關注我的微信訂閲號:

作者:Petter Liu

出處:http://www.cnblogs.com/wintersun/

本文版權歸作者和博客園共有,歡迎轉載,但未經作者同意必須保留此段聲明,且在文章頁面明顯位置給出原文連接,否則保留追究法律責任的權利。 該文章也同時發佈在我的獨立博客中-Petter Liu Blog。