背景

大語言模型(LLM)在代碼生成方面無疑取得了驚人的進步,早已成為許多開發者不可或缺的日常工具。從自動補全到生成完整函數,AI正在重塑軟件開發的生態。但當這些先進的AI模型生成錯誤代碼時,背後的真正原因是什麼?真的是因為任務太複雜、代碼太難寫了嗎?一篇針對GPT-4o、Claude Sonnet-4、Llama-3.3-70B等六大主流模型和四大基準測試的深入研究揭示了幾個出人意料的發現。結果表明,我們可能一直都搞錯了重點。AI編碼的失敗,根源並非代碼的複雜性,而是一些更深層次的“思維”陷阱。

意外發現一:代碼越複雜,AI越容易失敗?這是一個誤解

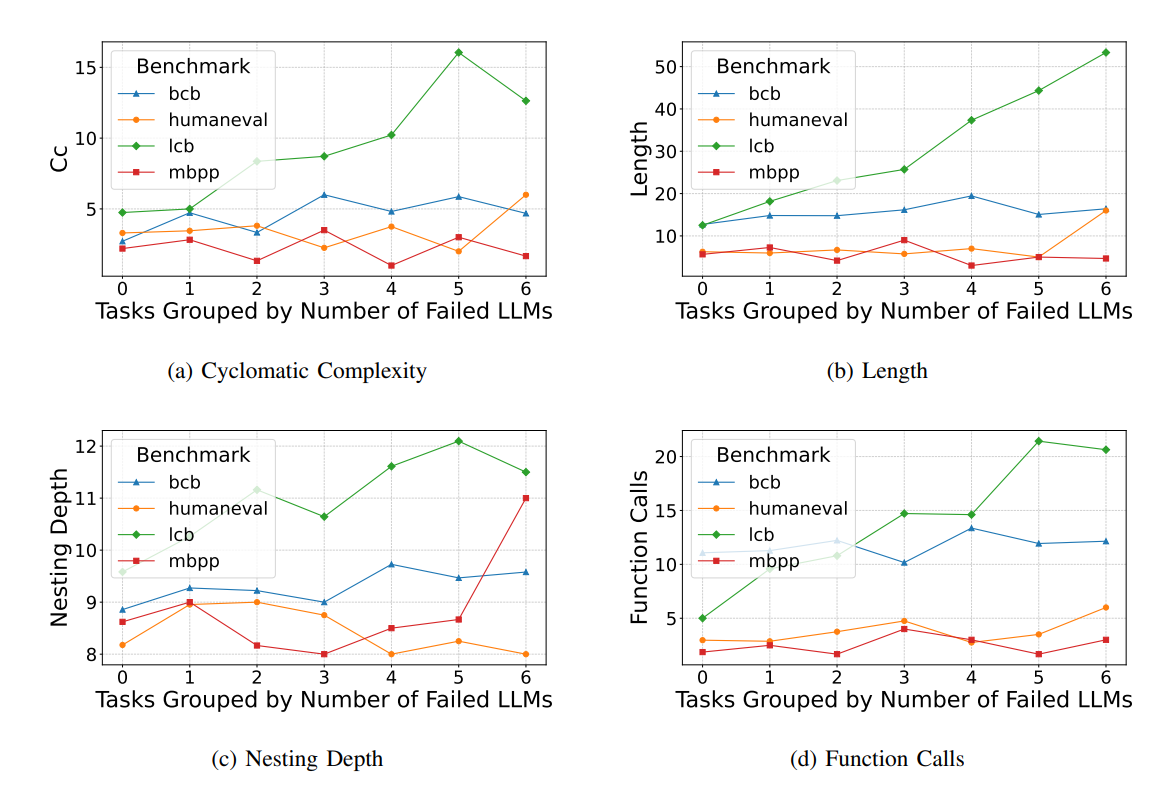

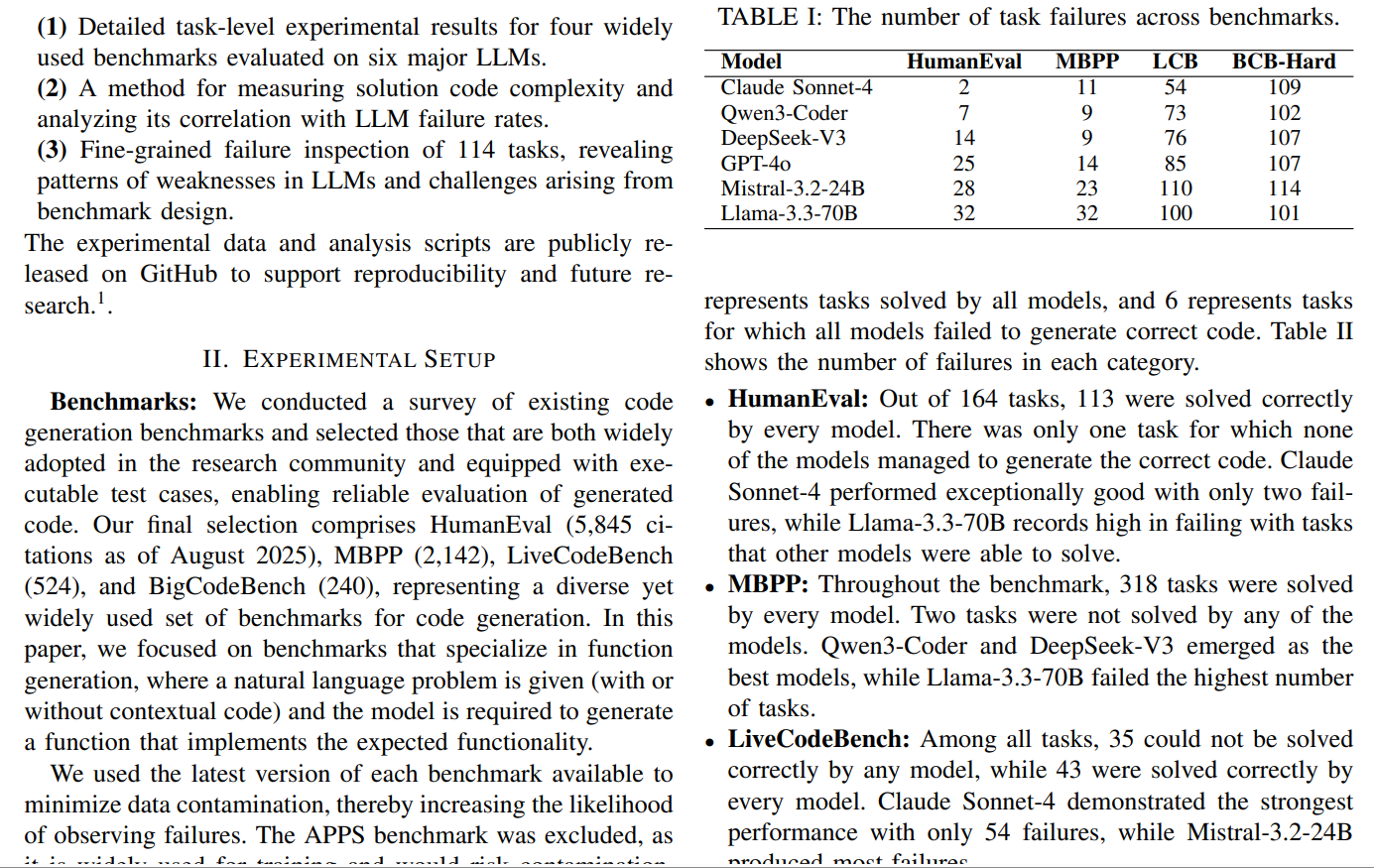

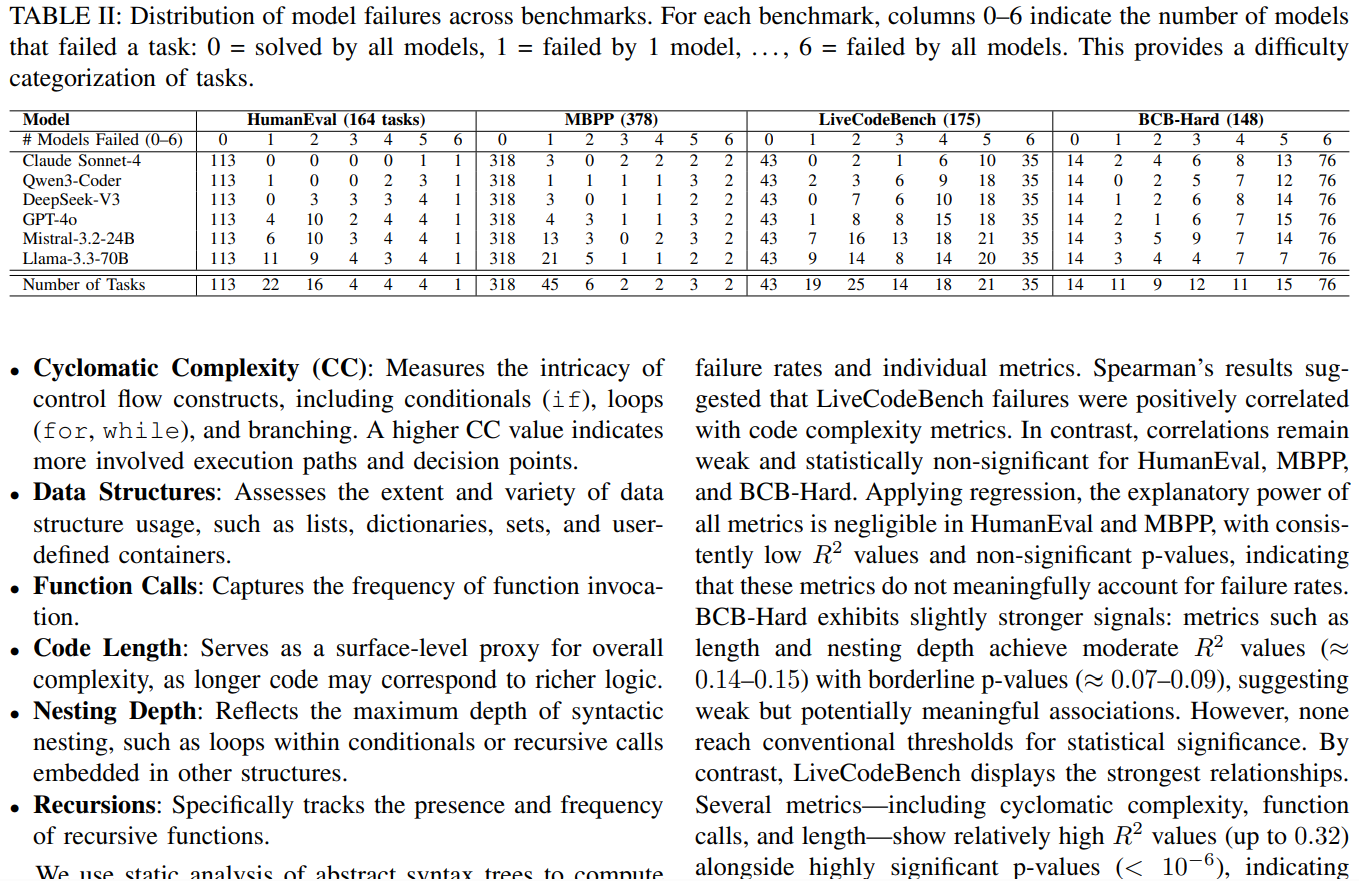

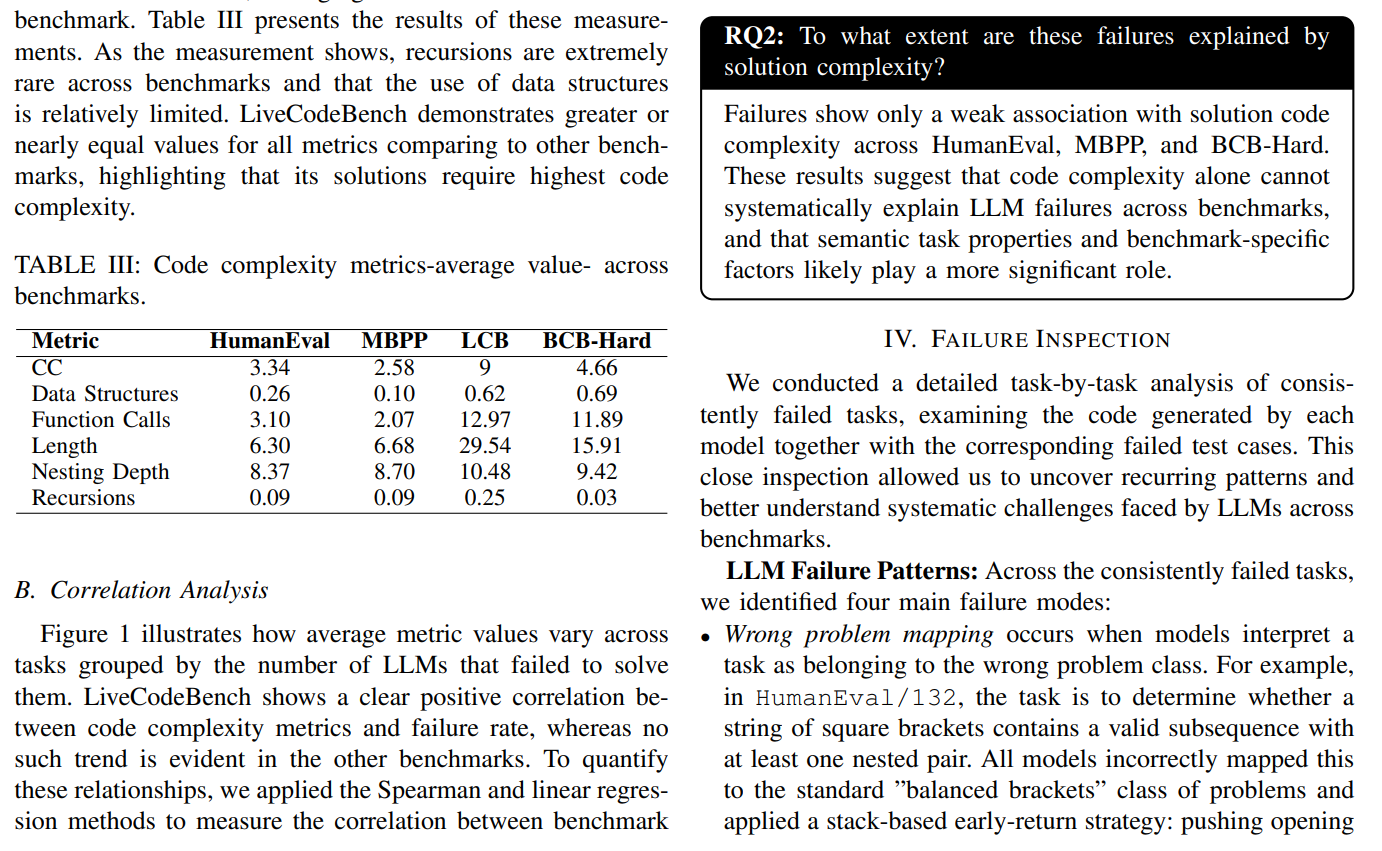

我們通常認為,代碼越複雜,AI越容易出錯。但這項研究的第一個發現就給這個普遍認知潑了一盆冷水。研究中的一個核心發現顛覆了我們的直覺:在HumanEval、MBPP和BCB-Hard這三個廣受歡迎的基準測試中,解決方案代碼的複雜性(如圈複雜度、代碼長度、嵌套深度)與模型的失敗率之間並沒有表現出明顯的正相關關係。

唯一的例外是LiveCodeBench,在這個基準測試中,任務失敗率確實與代碼複雜性存在較強關聯。深入數據我們發現,LiveCodeBench的任務(多源於LeetCode等競賽平台)在算法複雜度和代碼長度上遠超其他基準。這或許意味着,當任務的純粹算法挑戰達到一定閾值時,代碼的靜態複雜性才開始成為AI的“硬傷”,而在大多數常規編碼任務中,問題出在別處。

研究表明,代碼本身的複雜性並不能系統地解釋大語言模型的失敗。真正的挑戰可能在於任務的語義特性和基準測試的設計本身。

解剖失敗:LLM的四大“思維定式”陷阱

既然複雜性不是主因,那麼真正的“罪魁禍首”是什麼?研究人員像偵探一樣,通過剖析114個所有模型都普遍失敗的“懸案”,發現了模型在邏輯推理層面反覆陷入的四種思維陷阱。

在這些模式中,“有缺陷的算法設計”和“錯誤的問題映射”是導致失敗最主要的原因,尤其是在難度更高的BCB-Hard和LiveCodeBench基準測試中。

1. 錯誤的問題映射 (Wrong Problem Mapping) 這指的是模型將一個特定的、新穎的任務誤解為另一個更常見、更熟悉的問題。例如,在HumanEval/132任務中,要求是判斷一個括號字符串是否“包含至少一個嵌套對的有效子序列”。然而,所有模型都錯誤地將其當成了常規的“判斷括號是否完全平衡”問題來解決,導致了失敗。這暴露了模型傾向於套用“舊知識”,而忽略了問題的關鍵細節。

2. 有缺陷或不完整的算法設計 (Flawed/Incomplete Algorithm Design) 在這種情況下,模型理解了問題的大方向,但在具體實現的算法步驟上存在邏輯漏洞或考慮不周。例如,在BCB-Hard/945任務中,模型需要基於歷史數據進行迴歸預測。它們正確地進行了數據處理和迴歸,但未能處理數據中可能存在的“非單調”趨勢,導致算法在特定情況下失效。

3. 邊界條件處理不當 (Edge Case Mishandling) 這是最常見的失敗模式之一。模型生成的代碼能夠處理常規、普遍的輸入,卻在面對不常見或極端的邊界情況時崩潰。例如,在BCB-Hard/964任務中,要求轉換一個目錄及其子目錄下的所有文件。所有模型生成的代碼都只迭代了頂層目錄的文件,而未能按要求遞歸遍歷子文件夾,導致測試失敗。

4. 格式錯誤 (Formatting Mistakes) 有時,AI的算法邏輯是完全正確的,但僅僅因為輸出結果的格式不符合基準測試的嚴格要求而被判為失敗。一個典型的例子是LiveCodeBench/3736,它要求模型返回一個字符串形式的數字,如"23",但模型卻返回了數字23。這種“差之毫釐”的錯誤凸顯了當前模型在精確遵循指令方面的脆弱性。

意外發現三:“更強”的模型有時反而會輸給“更實在”的模型

研究中一個非常有趣的反直覺現象發生在BCB-Hard基準測試中。在這個測試裏,Llama-3.3-70B的表現竟然優於在其他測試中公認更強的Claude Sonnet-4。

原因令人深思:Llama-3.3-70B之所以成功,恰恰是因為它對任務提示進行了更“字面化”、更“實在”的解讀。以BCB-Hard/147任務為例,任務要求遍歷一個IP地址範圍。Claude Sonnet-4遵循了更普遍、更專業的編程慣例,自動跳過了範圍中的網絡和廣播地址——這在真實世界的開發中是合理的做法。然而,Llama-3.3-70B則嚴格按照提示,遍歷了所有IP地址,一個不漏。結果,後者的“實在”行為恰好通過了刻板的測試用例,而前者的“專業”行為反而導致了失敗。

這揭示了一個評估AI模型時的核心悖論:隨着模型越來越“智能”,越來越能模仿人類開發者的專業直覺和慣例,它們反而可能在那些獎勵絕對字面服從的刻板測試中“自作聰明”地失敗。這迫使我們反思:我們到底希望AI成為一個遵循指令的工具,還是一個具備專業判斷力的“同事”?

結論:我們該如何更好地“考驗”AI?

這項研究清晰地告訴我們,當前頂級LLM生成代碼的失敗,更多是源於對問題語義的誤解、邏輯推理的缺陷、對邊界條件的忽視以及對刻板規則的適應性不足,而非代碼本身的靜態複雜性。此外,研究還發現,一些基準測試本身存在的“提示模糊”和“測試過嚴”等問題,也是導致模型失敗的重要外部因素。

1. 對模型開發:精準指明優化方向

不再盲目追求 “提升整體性能”,而是針對性解決四大失敗問題 —— 比如優化模型對題目細節的理解(避免任務映射錯誤)、強化算法完整性設計、補充邊緣情況訓練、適配多樣化輸出格式,讓模型優化更有針對性。

2. 對基準測試設計:完善評價體系

揭示了現有測試的缺陷(如描述模糊、要求過嚴),後續可設計更清晰、合理的測試題,同時可基於共性失敗任務打造 “故障診斷型基準”,更精準區分模型真實能力,而非只看表面得分。

3. 對實際應用:降低開發風險

幫助開發者瞭解 AI 生成代碼的 “雷區”—— 比如複雜場景下的邊緣情況、嚴格格式要求的任務,使用時需重點核查這些環節,避免直接套用模型輸出導致 bug。

4. 對研究方向:開闢新視角

打破 “只看排名不看失敗” 的研究慣性,提供了 “任務級失敗分析 + 複雜度測量 + 失敗模式歸類” 的完整方法,為後續 LLM 能力短板研究提供了可複用的框架。

今天先到這兒,希望對AI,雲原生,技術領導力, 企業管理,系統架構設計與評估,團隊管理, 項目管理, 產品管理,信息安全,團隊建設 有參考作用 , 您可能感興趣的文章:

微服務架構設計

視頻直播平台的系統架構演化

微服務與Docker介紹

Docker與CI持續集成/CD

互聯網電商購物車架構演變案例

互聯網業務場景下消息隊列架構

互聯網高效研發團隊管理演進之一

消息系統架構設計演進

互聯網電商搜索架構演化之一

企業信息化與軟件工程的迷思

企業項目化管理介紹

軟件項目成功之要素

人際溝通風格介紹一

精益IT組織與分享式領導

學習型組織與企業

企業創新文化與等級觀念

組織目標與個人目標

初創公司人才招聘與管理

人才公司環境與企業文化

企業文化、團隊文化與知識共享

高效能的團隊建設

項目管理溝通計劃

構建高效的研發與自動化運維

某大型電商雲平台實踐

互聯網數據庫架構設計思路

IT基礎架構規劃方案一(網絡系統規劃)

餐飲行業解決方案之客户分析流程

餐飲行業解決方案之採購戰略制定與實施流程

餐飲行業解決方案之業務設計流程

供應鏈需求調研CheckList

企業應用之性能實時度量系統演變

如有想了解更多軟件設計與架構, 系統IT,企業信息化, 團隊管理 資訊,請關注我的微信訂閲號:

作者:Petter Liu

出處:http://www.cnblogs.com/wintersun/

本文版權歸作者和博客園共有,歡迎轉載,但未經作者同意必須保留此段聲明,且在文章頁面明顯位置給出原文連接,否則保留追究法律責任的權利。 該文章也同時發佈在我的獨立博客中-Petter Liu Blog。