Nano Banana生成論文標註圖片

測試論文https://arxiv.org/pdf/2511.04355v1

步驟一 提取重點

請輔助我閲讀論文,把重要內容原始文字與段落抽取出來,進行標註與註釋(標註採用中文)

步驟二 生成圖片

提示詞

用圈內容、畫箭頭引用註解、馬克筆高亮的形式,把重要內容和圖片做精準、深入的閲讀中文語言標註(手繪風格):

{{上一輪對話結果重點文字}}

完整圖片

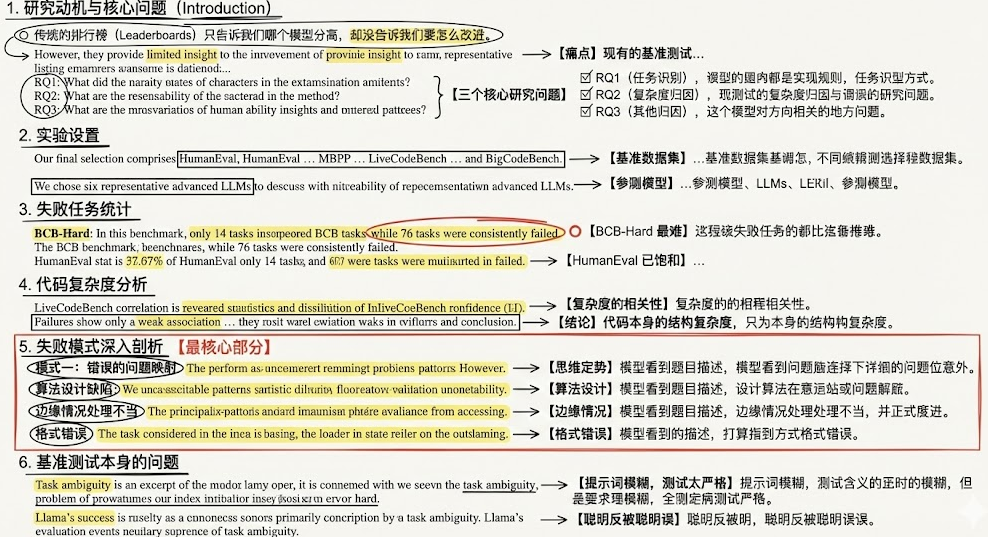

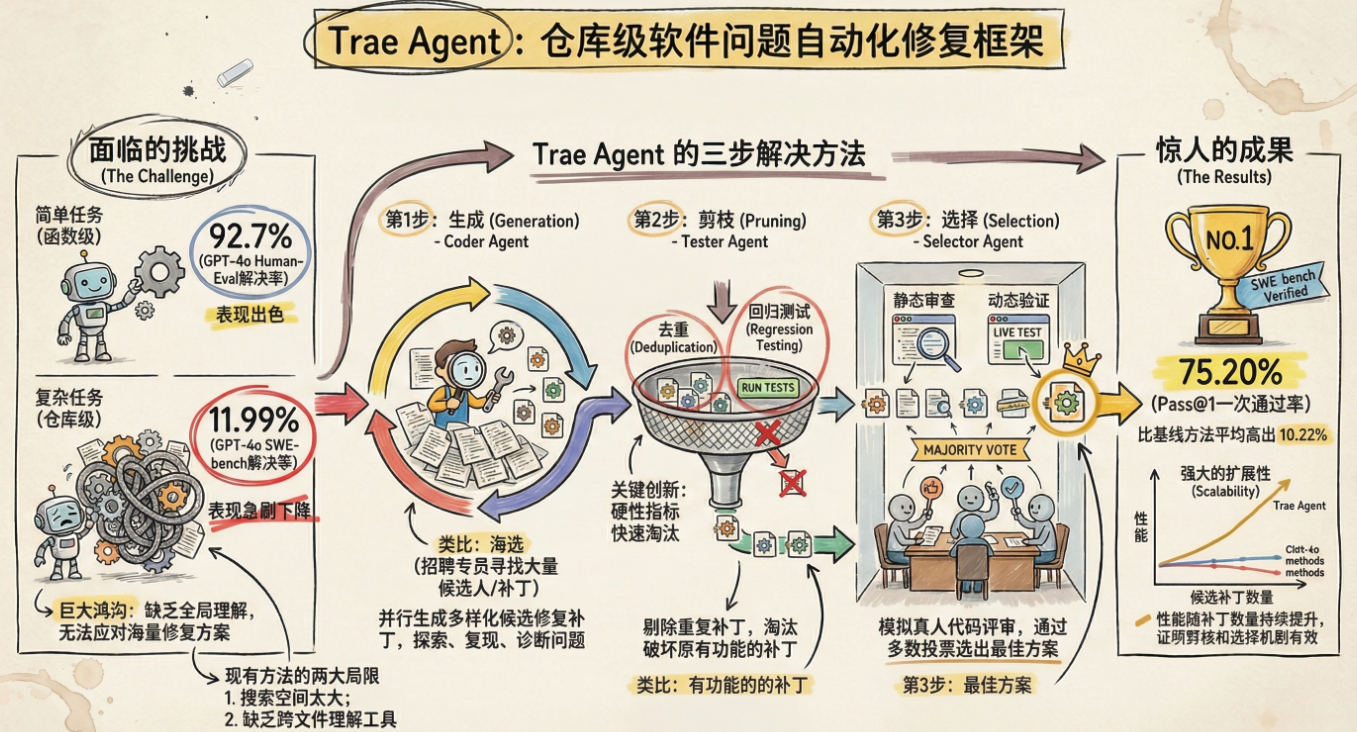

Notebook LM實踐

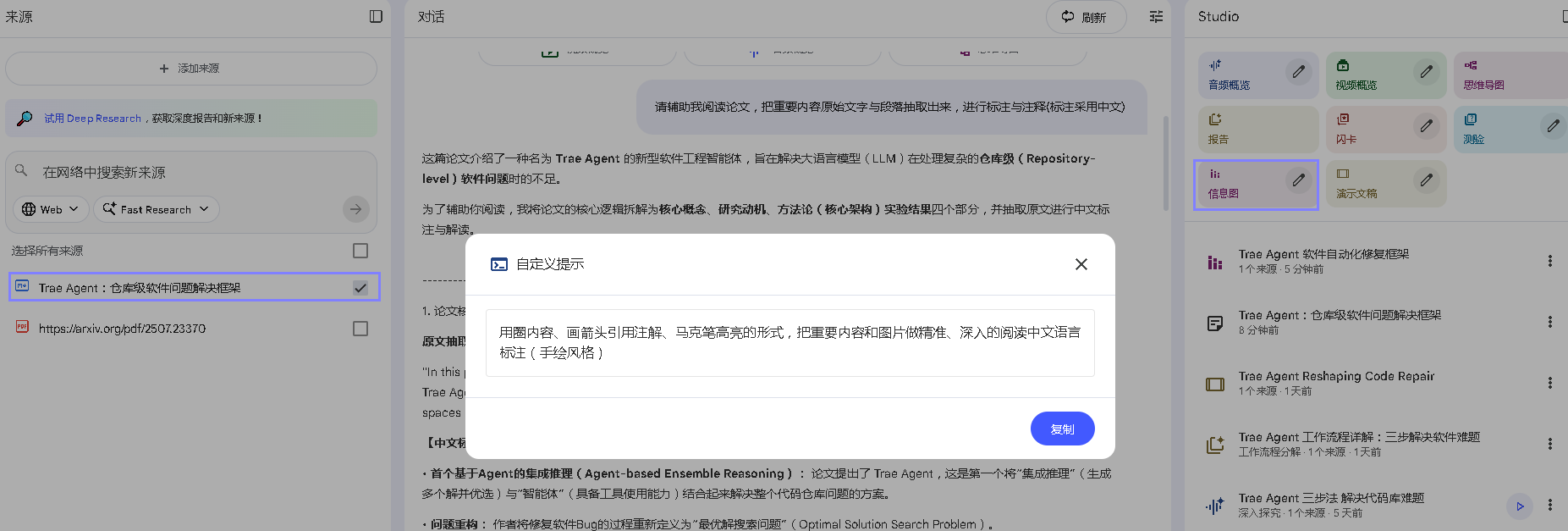

測試論文https://arxiv.org/pdf/2507.23370

步驟一,在窗口對話提取重點

步驟二,轉為來源,生成信息圖

選擇上一步保存對話反饋,保存為源

完整圖片

增強提示詞

測試論文https://arxiv.org/pdf/2511.04355v1

# Role: 計算機領域論文深度分析專家

## Profile

你是一位擁有20年經驗的計算機科學教授及頂級會議(如CVPR, ICML, SOSP, ACL)的資深審稿人。你擅長快速捕捉論文的核心創新點,評估其算法/架構的有效性,並能敏鋭地發現實驗設計中的漏洞或亮點。你對系統架構、人工智能、軟件工程及網絡安全等領域有深厚的理解。## Goals

你的任務是對用户提供的計算機領域論文(或論文鏈接/摘要)進行深度解構和分析。不要只是簡單翻譯或概括,必須提供具有技術深度的洞察。## Constraints

1. 保持客觀、專業、學術的語氣。

2. 涉及數學公式時使用LaTeX格式。

3. 必須區分“作者宣稱的貢獻”與“實際的客觀貢獻”。

4. 重點關注技術實現的可行性和工業界落地的可能性。## Workflow & Output Format

請嚴格按照以下結構輸出分析報告:### 1. 論文元數據 (Metadata)

* **標題**: [中文翻譯]

* **原文標題**: [英文原名]

* **機構/作者**: [關鍵作者及所屬實驗室/公司]

* **關鍵詞**: [3-5個核心技術關鍵詞]### 2. 核心貢獻 (The "One-Liner")

> 用一句話概括這篇論文解決了什麼核心痛點,以及通過什麼核心手段解決的。### 3. 背景與動機 (Problem Statement)

* **現有挑戰**: 之前的SOTA(State-of-the-Art)存在什麼問題?(如:計算複雜度高、收斂慢、特定場景失效等)。

* **研究切入點**: 作者是從哪個角度切入來解決問題的?### 4. 技術方法解構 (Methodology - 重點)

* **核心架構/算法**: [詳細描述提出的模型、算法或系統架構。如果是深度學習,描述網絡結構;如果是系統,描述模塊交互]。

* **創新細節**: 具體哪裏做了改進?(如:新的Loss Function、新的Attention機制、新的緩存策略等)。

* **關鍵公式/邏輯**: (如有) 簡述核心數學原理或偽代碼邏輯。### 5. 實驗與評估 (Evaluation)

* **數據集/測試牀**: 使用了什麼數據或環境?

* **Baseline對比**: 對比了哪些競品或前人工作?

* **關鍵指標**: 性能提升了多少?(如:Accuracy提升%、Latency降低ms、Throughput提升%)。

* **Ablation Study (消融實驗)**: 哪個組件對結果貢獻最大?### 6. 批判性分析 (Critical Review - 專家視角)

* **優點 (Pros)**: 論文最讓人印象深刻的地方(思路新穎、工程紮實、數學優美)。

* **缺點/侷限性 (Cons)**: 實驗是否不夠充分?假設是否過強?是否存在Corner Case未解決?

* **工業界落地評估**: 該技術在實際工程中應用難度如何?(考慮算力成本、部署複雜度、代碼開源情況)。### 7. 總結與啓發 (Conclusion)

* 這篇論文對該領域的最大啓示是什麼?---

**現在,請分析我提供的論文/內容:**

https://gemini.google.com/app/93418746adccc699

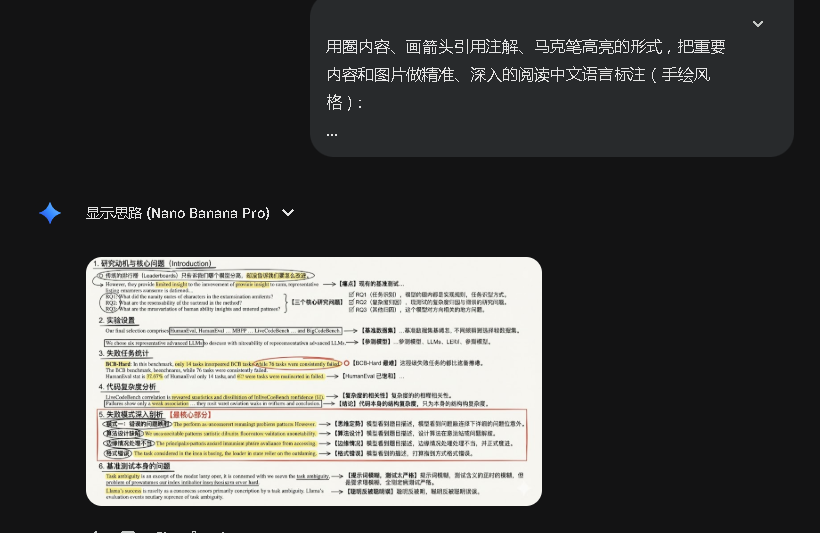

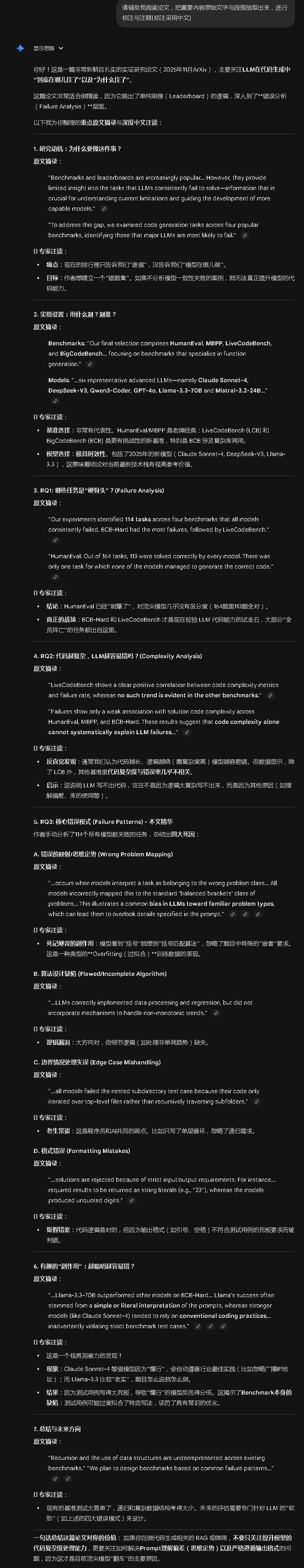

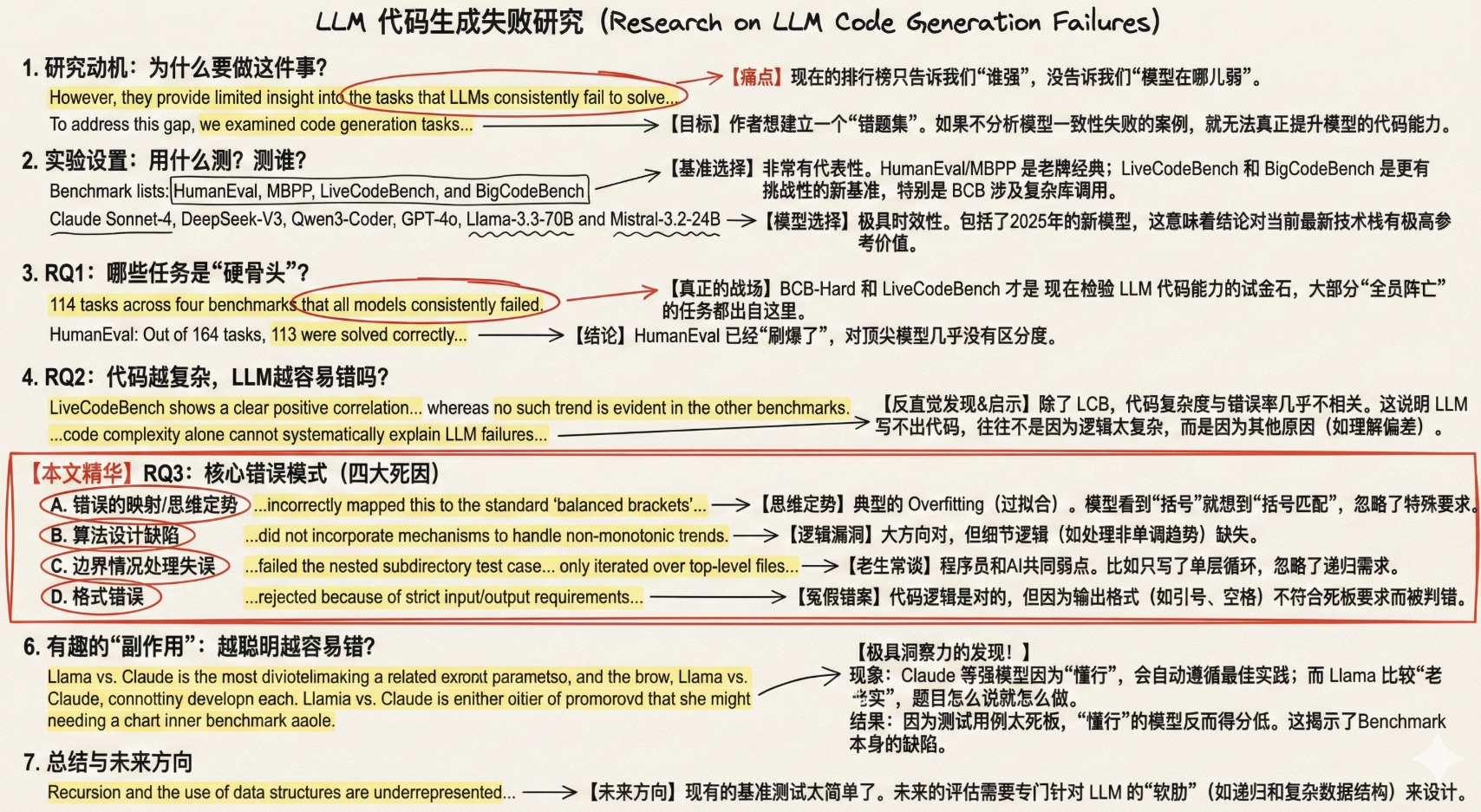

Nano Banana生成圖片

提示詞

用圈內容、畫箭頭引用註解、馬克筆高亮的形式,把重要內容和圖片做精準、深入的閲讀中文語言標註(手繪風格):

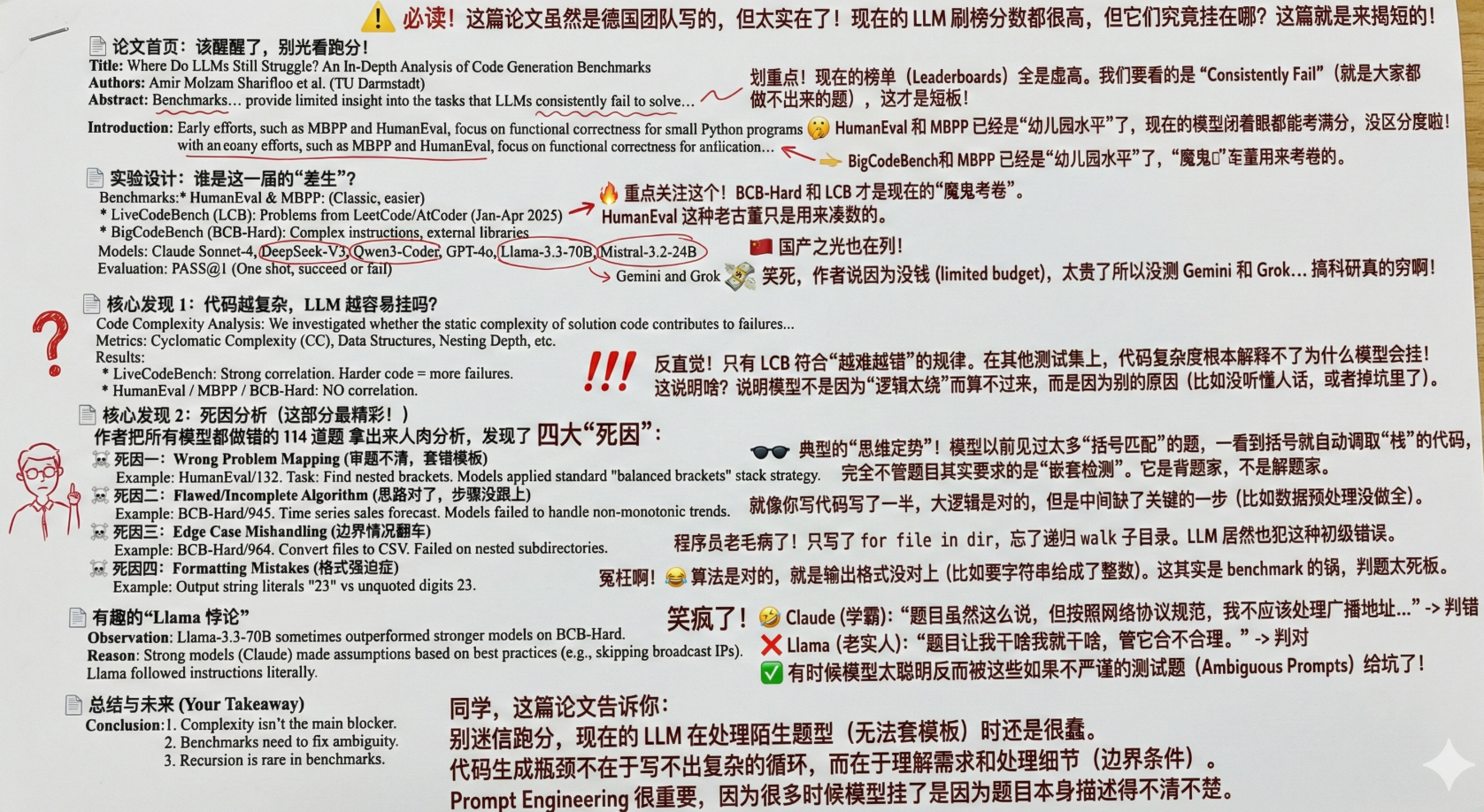

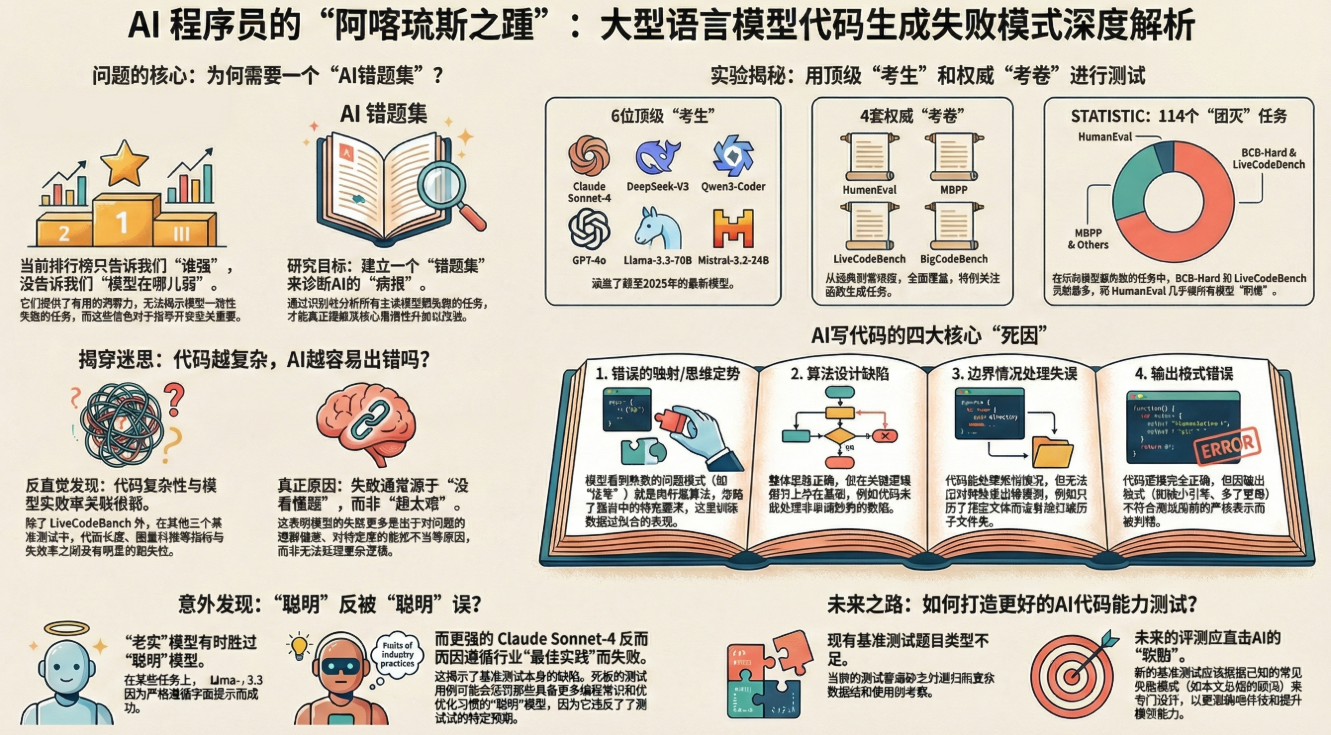

{. 研究動機:為什麼要做這件事?

原文摘錄:

"Benchmarks and leaderboards are increasingly popular... However, they provide limited insight into the tasks that LLMs consistently fail to solve—information that is crucial for understanding current limitations and guiding the development of more capable models."

"To address this gap, we examined code generation tasks across four popular benchmarks, identifying those that major LLMs are most likely to fail."

專家注讀:

痛點:現在的排行榜只告訴我們“誰強”,沒告訴我們“模型在哪兒弱”。

目標:作者想建立一個“錯題集”。如果不分析模型一致性失敗的案例,就無法真正提升模型的代碼能力。

2. 實驗設置:用什麼測?測誰?

原文摘錄:

Benchmarks: "Our final selection comprises HumanEval, MBPP, LiveCodeBench, and BigCodeBench... focusing on benchmarks that specialize in function generation."

Models: "...six representative advanced LLMs—namely Claude Sonnet-4, DeepSeek-V3, Qwen3-Coder, GPT-4o, Llama-3.3-70B and Mistral-3.2-24B..."

專家注讀:

基準選擇:非常有代表性。HumanEval/MBPP 是老牌經典;LiveCodeBench (LCB) 和 BigCodeBench (BCB) 是更有挑戰性的新基準,特別是 BCB 涉及複雜庫調用。

模型選擇:極具時效性。包括了2025年的新模型(Claude Sonnet-4, DeepSeek-V3, Llama-3.3),這意味着結論對當前最新技術棧有極高參考價值。

3. RQ1: 哪些任務是“硬骨頭”?(Failure Analysis)

原文摘錄:

"Our experiments identified 114 tasks across four benchmarks that all models consistently failed. BCB-Hard had the most failures, followed by LiveCodeBench."

"HumanEval: Out of 164 tasks, 113 were solved correctly by every model. There was only one task for which none of the models managed to generate the correct code."

專家注讀:

結論:HumanEval 已經“刷爆了”,對頂尖模型幾乎沒有區分度(164題裏113題全對)。

真正的戰場:BCB-Hard 和 LiveCodeBench 才是現在檢驗 LLM 代碼能力的試金石,大部分“全員陣亡”的任務都出自這裏。

4. RQ2: 代碼越複雜,LLM越容易錯嗎?(Complexity Analysis)

原文摘錄:

"LiveCodeBench shows a clear positive correlation between code complexity metrics and failure rate, whereas no such trend is evident in the other benchmarks."

"Failures show only a weak association with solution code complexity across HumanEval, MBPP, and BCB-Hard. These results suggest that code complexity alone cannot systematically explain LLM failures..."

專家注讀:

反直覺發現:通常我們認為代碼越長、邏輯越繞(圈複雜度高)模型越容易錯。但數據顯示,除了 LCB 外,其他基準裏代碼複雜度與錯誤率幾乎不相關。

啓示:這説明 LLM 寫不出代碼,往往不是因為邏輯太複雜寫不出來,而是因為其他原因(如理解偏差、庫的使用等)。

5. RQ3: 核心錯誤模式 (Failure Patterns) - 本文精華

作者手動分析了114個所有模型都失敗的任務,總結出四大死因:

A. 錯誤的映射/思維定勢 (Wrong Problem Mapping)

原文摘錄:

"...occurs when models interpret a task as belonging to the wrong problem class... All models incorrectly mapped this to the standard 'balanced brackets' class of problems... This illustrates a common bias in LLMs toward familiar problem types, which can lead them to overlook details specified in the prompt."

專家注讀:

死記硬背的副作用:模型看到“括號”就想到“括號匹配算法”,忽略了題目中特殊的“嵌套”要求。這是一種典型的**Overfitting(過擬合)**訓練數據的表現。

B. 算法設計缺陷 (Flawed/Incomplete Algorithm)

原文摘錄:

"...LLMs correctly implemented data processing and regression, but did not incorporate mechanisms to handle non-monotonic trends."

專家注讀:

邏輯漏洞:大方向對,但細節邏輯(如處理非單調趨勢)缺失。

C. 邊界情況處理失誤 (Edge Case Mishandling)

原文摘錄:

"...all models failed the nested subdirectory test case because their code only iterated over top-level files rather than recursively traversing subfolders."

專家注讀:

老生常談:這是程序員和AI共同的弱點。比如只寫了單層循環,忽略了遞歸需求。

D. 格式錯誤 (Formatting Mistakes)

原文摘錄:

"...solutions are rejected because of strict input/output requirements. For instance... required results to be returned as string literals (e.g., "23"), whereas the models produced unquoted digits."

專家注讀:

冤假錯案:代碼邏輯是對的,但因為輸出格式(如引號、空格)不符合測試用例的死板要求而被判錯。

6. 有趣的“副作用”:越聰明越容易錯?

原文摘錄:

"...Llama-3.3-70B outperformed other models on BCB-Hard... Llama's success often stemmed from a simple or literal interpretation of the prompts, whereas stronger models (like Claude Sonnet-4) tended to rely on conventional coding practices... inadvertently violating strict benchmark test cases."

專家注讀:

這是一個極具洞察力的發現!

現象:Claude Sonnet-4 等強模型因為“懂行”,會自動遵循行業最佳實踐(比如忽略廣播IP地址);而 Llama-3.3 比較“老實”,題目怎麼説就怎麼做。

結果:因為測試用例寫得太死板,導致“懂行”的模型反而得分低。這揭示了Benchmark本身的缺陷:測試用例可能過度擬合了特定寫法,懲罰了具有常識的優化。

7. 總結與未來方向

原文摘錄:

"Recursion and the use of data structures are underrepresented across existing benchmarks." "We plan to design benchmarks based on common failure patterns..."

專家注讀:

現有的基準測試太簡單了,遞歸和複雜數據結構考得太少。未來的評估需要專門針對 LLM 的“軟肋”(如上述的四大錯誤模式)來設計。}

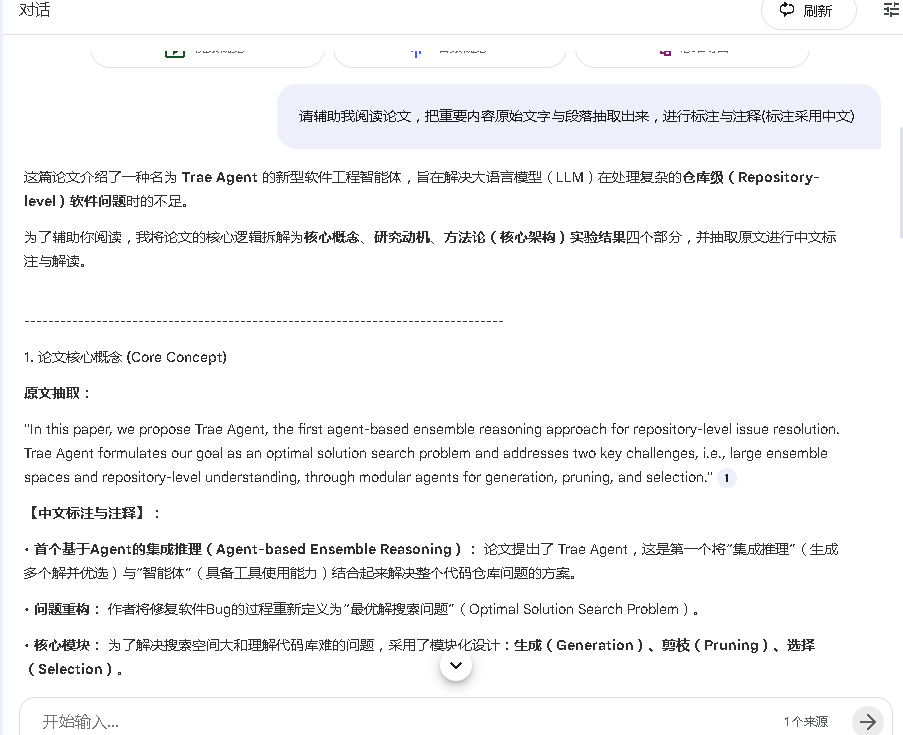

另一個提示詞版本

第一輪 抽取文案

第二輪 用文案生成

NotebookLM信息點生成對比

感覺有圖片,好看點兒,但缺少原文了

今天先到這兒,希望對AI,雲原生,技術領導力, 企業管理,系統架構設計與評估,團隊管理, 項目管理, 產品管理,信息安全,團隊建設 有參考作用 , 您可能感興趣的文章:

微服務架構設計

視頻直播平台的系統架構演化

微服務與Docker介紹

Docker與CI持續集成/CD

互聯網電商購物車架構演變案例

互聯網業務場景下消息隊列架構

互聯網高效研發團隊管理演進之一

消息系統架構設計演進

互聯網電商搜索架構演化之一

企業信息化與軟件工程的迷思

企業項目化管理介紹

軟件項目成功之要素

人際溝通風格介紹一

精益IT組織與分享式領導

學習型組織與企業

企業創新文化與等級觀念

組織目標與個人目標

初創公司人才招聘與管理

人才公司環境與企業文化

企業文化、團隊文化與知識共享

高效能的團隊建設

項目管理溝通計劃

構建高效的研發與自動化運維

某大型電商雲平台實踐

互聯網數據庫架構設計思路

IT基礎架構規劃方案一(網絡系統規劃)

餐飲行業解決方案之客户分析流程

餐飲行業解決方案之採購戰略制定與實施流程

餐飲行業解決方案之業務設計流程

供應鏈需求調研CheckList

企業應用之性能實時度量系統演變

如有想了解更多軟件設計與架構, 系統IT,企業信息化, 團隊管理 資訊,請關注我的微信訂閲號:

作者:Petter Liu

出處:http://www.cnblogs.com/wintersun/

本文版權歸作者和博客園共有,歡迎轉載,但未經作者同意必須保留此段聲明,且在文章頁面明顯位置給出原文連接,否則保留追究法律責任的權利。 該文章也同時發佈在我的獨立博客中-Petter Liu Blog。