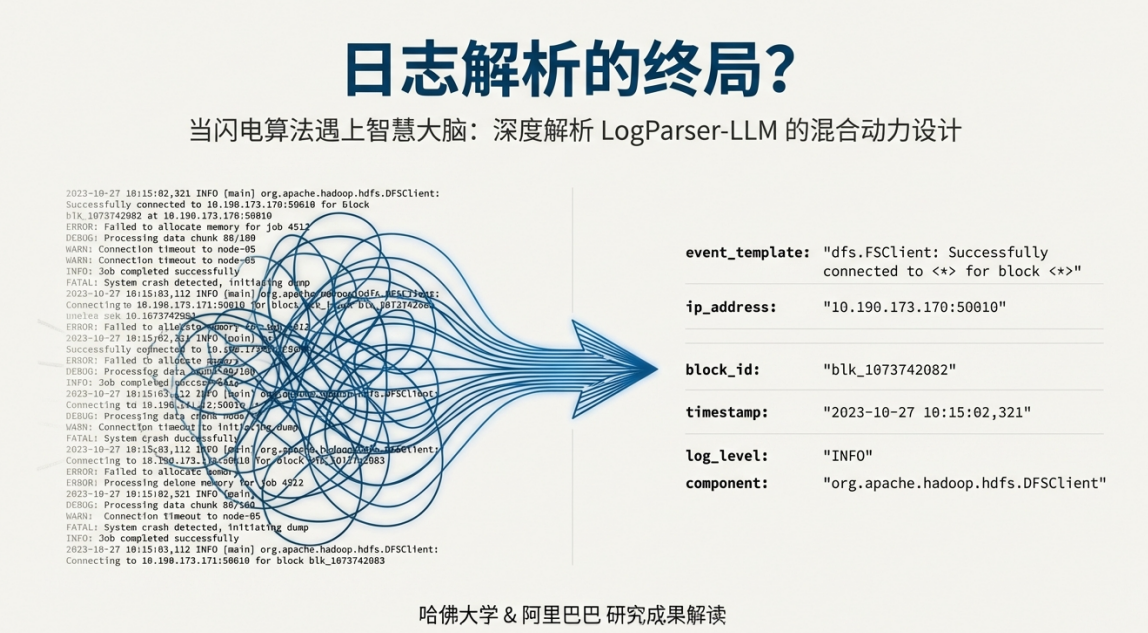

導言

在當今的工程領域,我們普遍面臨一個核心挑戰:如何從海量的、非結構化的數據(如日誌、配置文件、告警信息)中高效提取價值。這些數據是診斷系統故障、洞察系統行為的“救命稻草”,但其雜亂無章的格式對機器而言形同“天書”。大語言模型(LLM)的出現,以其前所未有的語義理解能力,為破解這一難題帶來了希望。然而,希望的背後隱藏着一個致命的矛盾:若將每日億級的日誌逐條交由LLM處理,其巨大的成本與時間延遲是任何生產系統都無法承受的。本文旨在為您揭示一種新型的解決方案——混合智能模式,它巧妙地化解了這一矛盾,為在工程領域務實地利用LLM鋪平了道路。

一.工程領域的困境:傳統方法的侷限與LLM的“昂貴智慧”

在評估任何新技術之前,我們必須首先清晰地認識到現有問題的根源和當前技術路線的瓶頸。只有深刻理解了“我們現在為何受困”,才能真正領會新範式的突破性價值所在。

1.1. 傳統解析技術的“天花板”

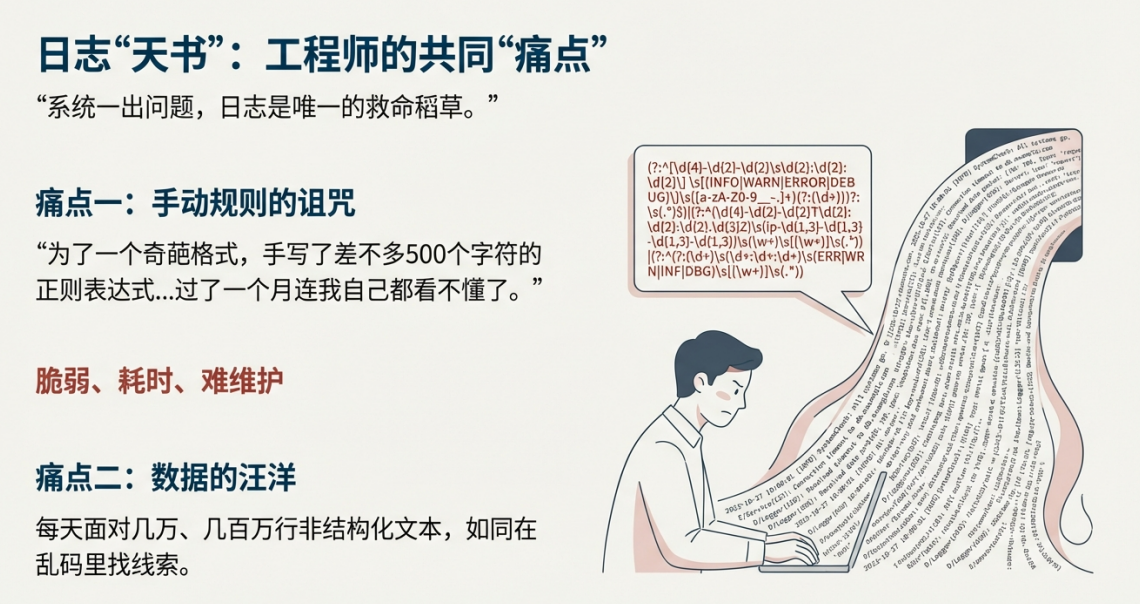

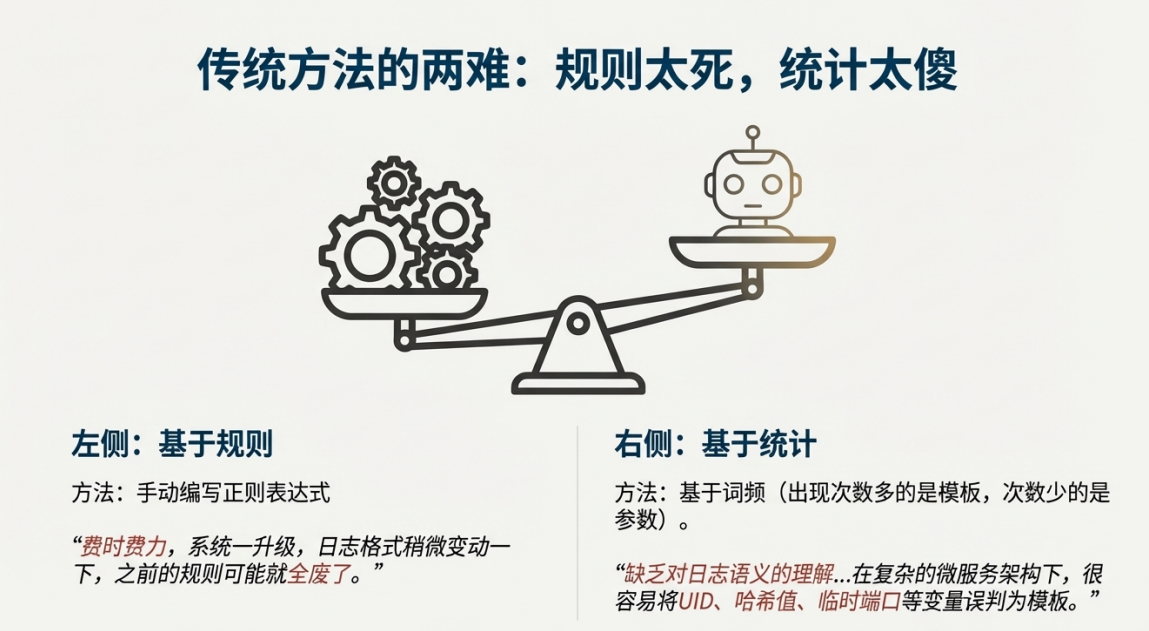

長期以來,工程師們依賴兩類傳統方法處理日誌等非結構化數據,但它們都已觸及其能力上限:

• 基於規則的方法(如正則表達式): 這種方法雖然直接,但極其脆弱和耗時。工程師需要為每一種日誌格式手動編寫複雜的規則。正如一位工程師在回憶如何處理一個奇葩的Java堆棧跟蹤日誌時所言,一個正則表達式可能“寫了差不多500個字符”,但“過了一個月連我自己都看不懂了”。更糟糕的是,一旦系統升級導致日誌格式微調,所有規則都可能失效,維護成本極高。

• 基於統計的方法(如詞頻統計): 這類方法通過統計詞語出現的頻率來區分“模板”(高頻詞)和“參數”(低頻詞)。在簡單的系統中尚可一用,但面對充滿UUID、哈希值、臨時端口的現代微服務架構時,它們因缺乏對文本真正的“語義理解”而頻繁出錯,無法準確識別模式。

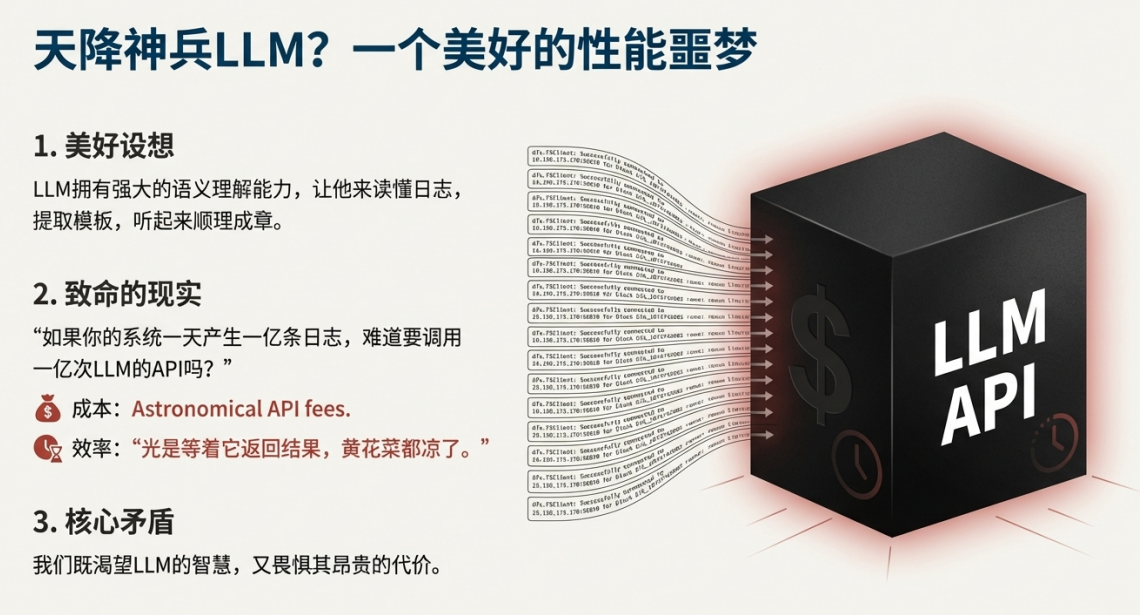

1.2. LLM的承諾與現實:能力與成本的衝突

大語言模型(LLM)的強大語義理解能力,恰好是解決上述傳統方法缺陷的理想武器。它能像人類一樣“讀懂”日誌,準確提取模式。然而,理想豐滿,現實骨感。LLM在工程應用中面臨着一個核心矛盾:

一方面,我們渴望其智慧;另一方面,我們畏懼其昂貴的代價。設想一個每天產生一億條日誌的系統,若要逐條調用LLM API進行解析,其成本將是天文數字,而處理時間(延遲)更是以天為單位計算,這在需要實時響應的生產環境中是完全不可行的。

正是為了解決這一“既要又要”的核心矛盾,一種全新的、更具智慧的設計思路——LogParser-LLM方案——應運而生。

二.混合模式範例:LogParser-LLM的核心設計思想

LogParser-LLM方案的價值不在於它“使用了LLM”,而在於它揭示了“如何巧妙地、有選擇性地使用LLM”。本節將深入剖析其架構,為您展示一幅平衡強大能力與經濟成本的實用工程藍圖。

2.1. 核心哲學:“盡力不用LLM”

該方案最核心的設計哲學可以總結為一句話:想盡一切辦法,避免調用LLM。它並非將LLM視為解決所有問題的萬能工具,而是將其定位為輕易不能動用的“專家王牌”。整個系統的設計精髓,在於用最高效、最低成本的常規手段處理99%的常規問題。

2.2. “高速分揀 + 專家診斷”的混合架構

該方案的架構由兩個核心組件協同工作構成:

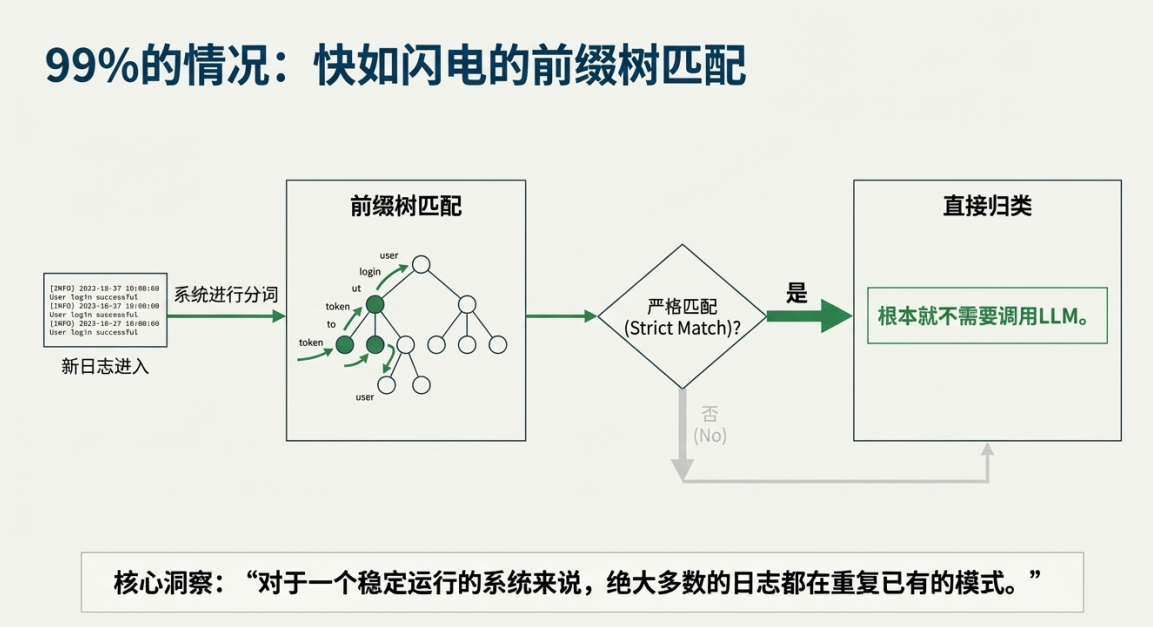

高速分揀系統(前端)

基於一種名為“前綴樹”的數據結構,構建了一個高效的初篩系統。該系統存儲了所有已知的日誌模式。當一條新日誌進入時,系統通過極快的內存查找操作,在“前綴樹”中進行匹配。如果找到完全匹配的已知模式,日誌就會被快速歸類,整個過程高效且低成本。

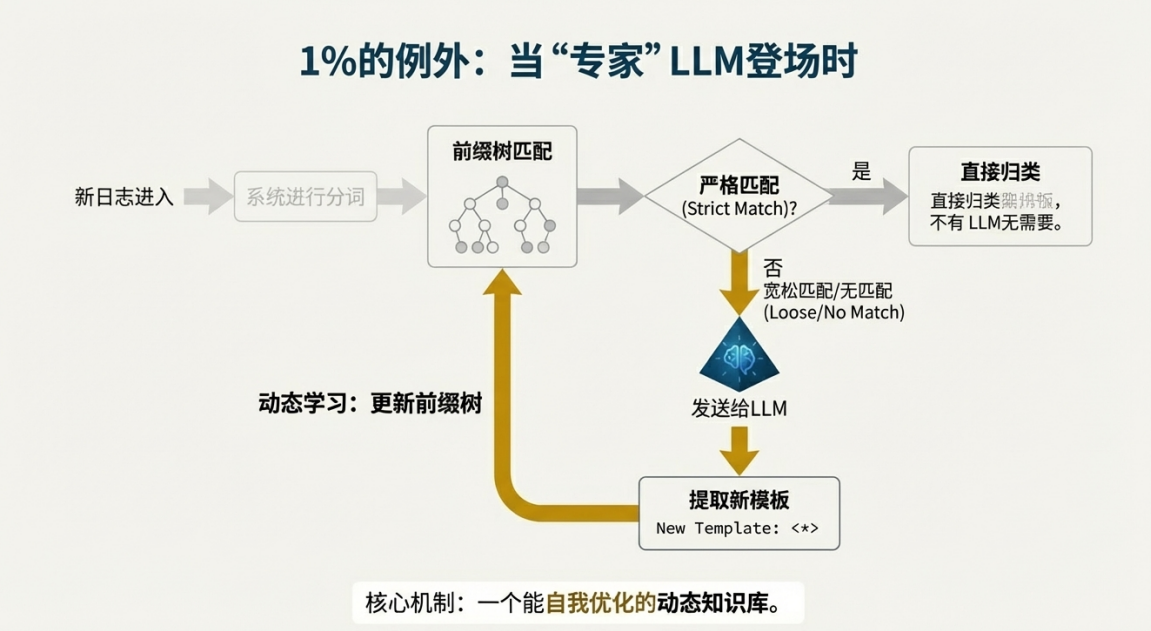

LLM專家組件(後端)

LLM的角色是一位“專家顧問”,僅在系統遇到前所未見的、未知的新日誌模式時才被激活。此時,系統會將這條“疑難雜症”日誌提交給LLM,利用其強大的語義理解能力生成一個新的、通用的日誌模板。它的作用是高智能地解決關鍵難題。

2.3. 自我優化的動態知識庫

這套混合架構形成了一個能夠自我學習和優化的閉環流程:

1. 快速匹配: 一條新日誌進入,首先由“前綴樹”進行高效匹配。對於一個穩定運行的系統,絕大多數日誌都屬於重複出現的已知模式。

2. 專家介入: 只有當匹配失敗(即遇到未知模式)時,這條日誌才會被提交給LLM。

3. 知識更新: LLM分析並生成新的日誌模板後,這個新模板會被添加回“前綴樹”中,成為系統知識庫的一部分。

這個流程使得系統能夠動態學習,越用越聰明。LLM的調用次數不再與“日誌總行數”相關,而是鋭減至約等於“日誌模板總數”的量級,從根本上解決了效率和成本問題。

2.4. 驚人的性能躍升:從“不可用”到“生產級”

數據最能説明問題。在一項針對360萬條真實日誌的測試中,不同策略的性能差異是顛覆性的:

|

策略 |

模型 |

處理360萬條日誌耗時 |

調用LLM次數 |

可行性評估 |

|

樸素策略 |

GPT-3.5 |

約 22天 |

3,600,000 |

完全不可行 |

|

LogParser-LLM |

GPT-4 |

約 26分鐘 |

平均 272.5 |

生產級可用 |

這些數據背後的意義是決定性的:22天意味着方案在真實生產環境中毫無可行性;而26分鐘則意味着它今天就可以被部署到預處理流程中,明天就能產生價值。這不僅僅是量級的差異,而是決定一個技術方案“能否在真實生產環境落地”的根本區別。

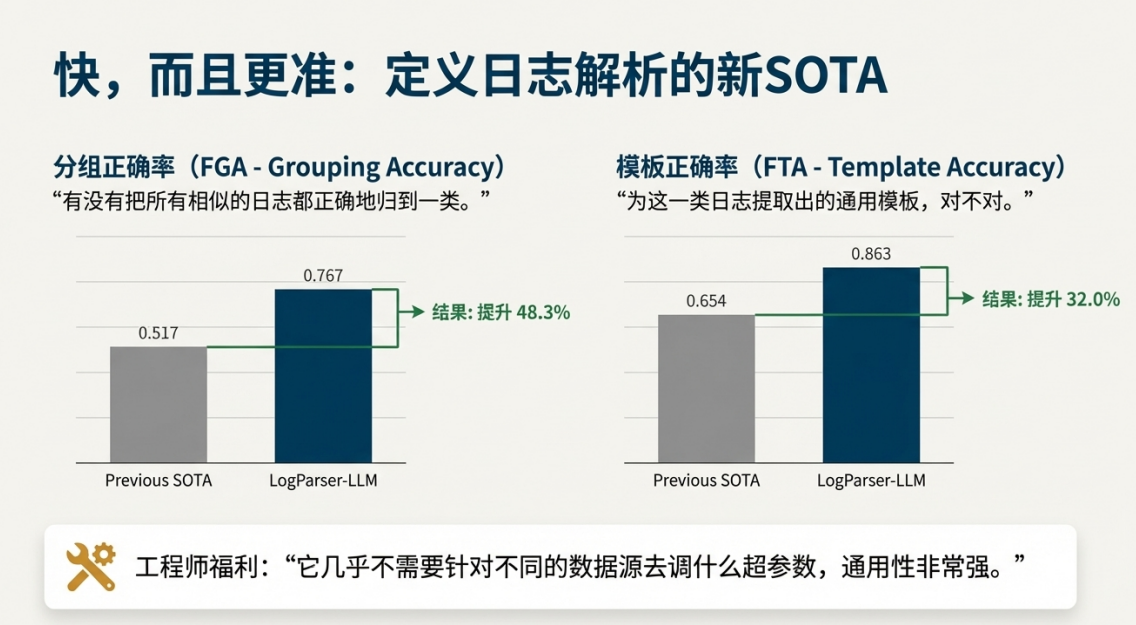

除了驚人的速度,該方案在準確性上也實現了巨大飛躍。在兩個關鍵指標上,其表現遠超以往的最佳方法:一是分組正確率(FGA),即是否能將相似的日誌正確歸為一類,該指標提升了48.3%;二是模板正確率(FTA),即為每類日誌提煉出的通用模板是否準確,該指標提升了32.0%。這證明了方案不僅跑得快,而且分得準、總結得好。

更重要的是,該方案具有極強的通用性,幾乎無需為不同的日誌源進行繁瑣的超參數調優,極大地降低了維護成本。

在解決了效率問題後,我們還需要關注另一個更深層次的問題——準確性。特別是,我們該如何定義和評估解析的“準確性”?

三. 超越對錯:重新定義語義解析的準確性

在智能化時代,評估系統性能的標準也需要升級。傳統評估指標無法覆蓋一個微妙但至關重要的問題——“解析粒度”。LogParser-LLM的研究不僅解決了技術問題,更在評估理念上提供了深刻洞見。

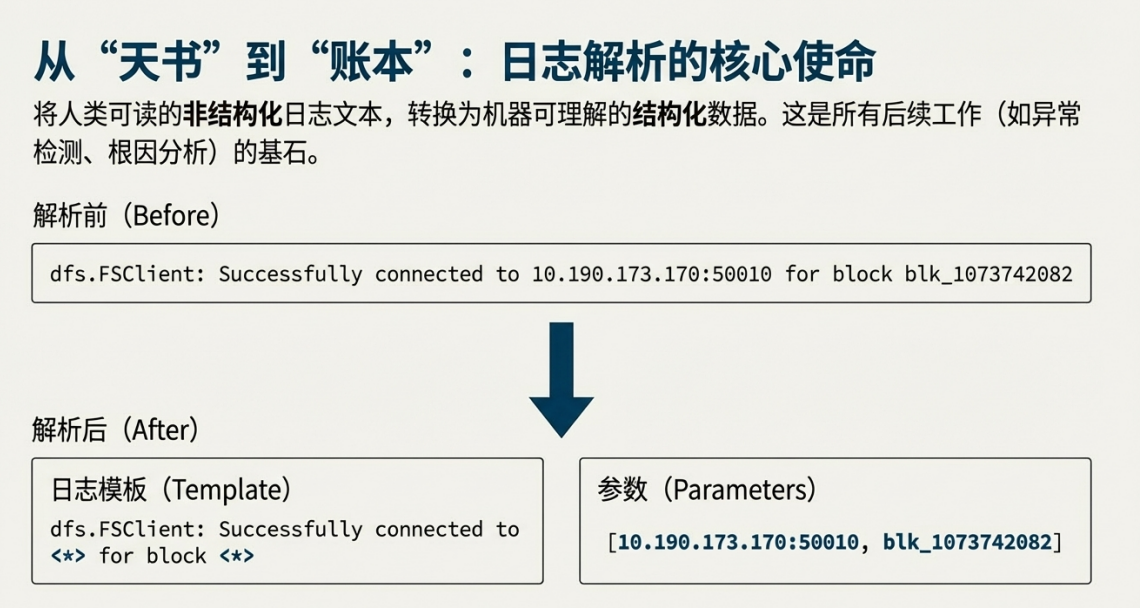

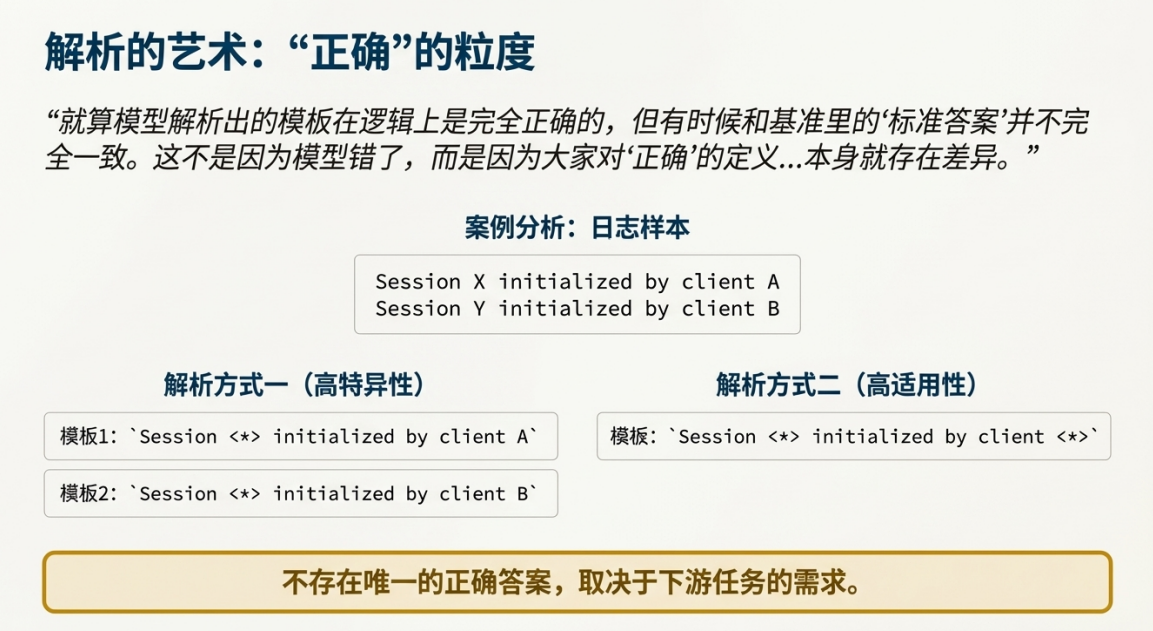

3.1. “解析粒度”的挑戰:沒有唯一的正確答案

以一組日誌為例:session X initialized by client A 和 session Y initialized by client B。對於這組日誌,存在至少兩種在邏輯上都“正確”的解析方式:

• 方式一(高特異性/低適用性): 生成兩個模板:session <*> initialized by client A 和 session <*> initialized by client B。這種方式保留了客户端信息,模板非常具體,但適用範圍窄。

• 方式二(低特異性/高適用性): 生成一個模板:session <*> initialized by client <*>。這種方式將客户端也視為變量,模板更通用,但丟失了客户端的具體信息。

哪一種才是對的?答案取決於下游的業務需求。如果後續分析需要區分不同客户端的行為,方式一更優;如果只是統計初始化總次數,方式二更簡潔。因此,不存在唯一的“正確”答案,這使得傳統的、基於字符串完全匹配的評估方法徹底失效。

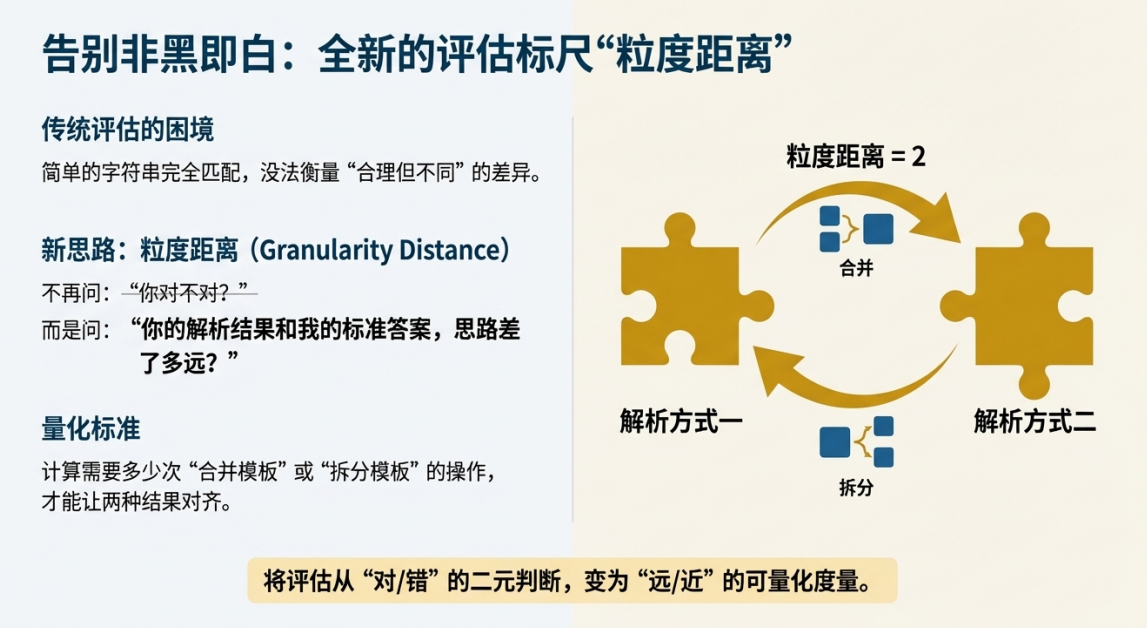

3.2. 創新的度量衡:“粒度距離”

為了解決這個評估難題,研究團隊提出了一個創新的評估指標——“粒度距離”(Granularity Distance)。

其核心思想發生了轉變:不再問“你的結果是否與標準答案完全一致”,而是問“你的解析思路與標準答案的思路相差多遠”。它通過計算需要多少次“合併模板”或“拆分模板”的操作才能使兩種結果對齊,從而將對解析粒度的評估從“對/錯”的二元判斷,轉變為“遠/近”的可量化度量,為工程實踐提供了更有意義的參考。

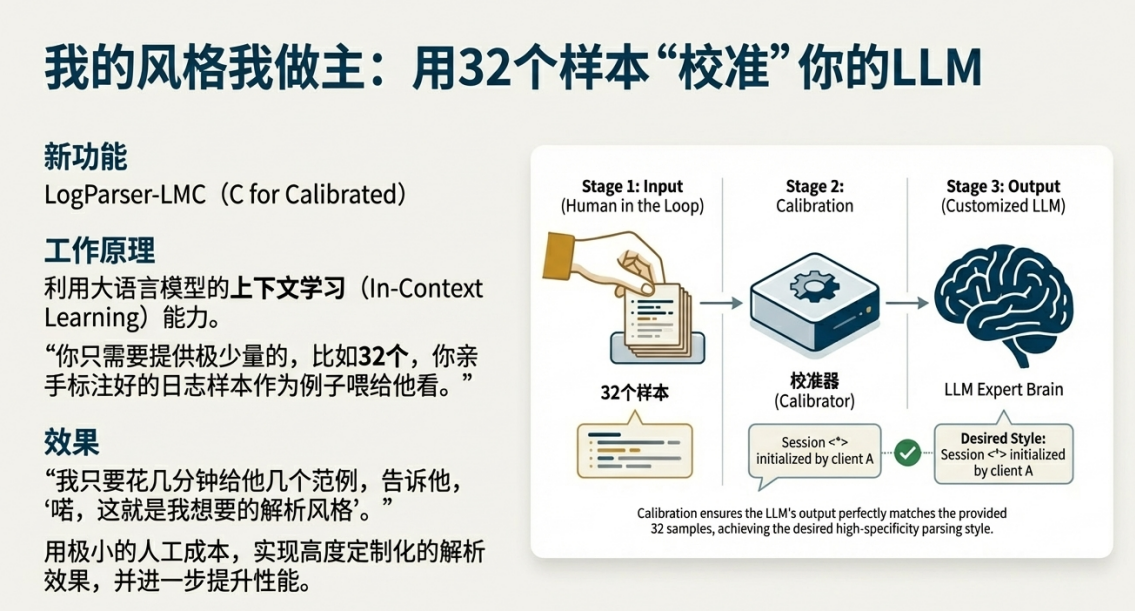

3.3. 人機協同:用極低成本實現定製化校準

更進一步,該方案還提供了一個校準版(LogParser-LLMC),允許用户根據自己的特定需求調整解析粒度。

它巧妙利用了LLM強大的上下文學習(In-context Learning)能力。工程師只需提供極少量(例如32個)高質量的人工標註範例,向模型展示自己期望的“解析風格”。模型便能“心領神會”,在後續的處理中遵循這一特定粒度。這種“人機迴環”(Human-in-the-loop)模式的價值在於,工程師可以用極小的代價,實現高度定製化和精準的解析效果。

LogParser-LLM不僅在性能上取得了突破,更在理念上提供了深刻洞見。其核心的混合模式可以被抽象出來,應用到更廣泛的工程領域。

四. 通用範式提煉:將“高效算法 + LLM專家”模式推廣應用

本簡報的最終目的不是僅僅介紹一個日誌解析工具,而是提煉其背後的通用設計哲學。我們希望為技術領導者和產品經理提供一個可複用的創新框架,用以解決各類複雜的工程問題。

4.1. 模式解構:99%的常規處理與1%的關鍵智能

我們可以將“高效傳統算法 + LLM專家組件”的混合模式抽象為一個通用框架,它由兩部分構成:

• 第一部分(護城河): 使用成熟、高效、確定性強的傳統算法構建核心處理引擎。這個引擎負責覆蓋絕大多數(99%)的常規、高頻場景,以此保證整個系統的低成本、高吞吐和高穩定性。

• 第二部分(攻堅矛): 將昂貴但智能的LLM作為“專家系統”或“智能外援”。它僅在傳統算法遇到無法處理的、需要深度語義理解或複雜判斷的疑難場景(1%)時被調用,用以解決最關鍵的難題。

4.2. 啓發與應用:在您的業務中尋找應用場景

現在,請思考一個問題:“在您的業務流程中,哪些任務目前依賴於繁瑣的硬編碼規則,卻又在關鍵環節需要人類的‘智能判斷’?”

這些場景正是應用此混合模式的絕佳機會。以下是幾個潛在的應用方向,希望能啓發您的思路:

• 複雜配置校驗: 用傳統解析器處理99%的標準化配置項。當遇到自定義腳本或複雜的邏輯依賴關係時,調用LLM進行語義層面的合理性校驗,判斷配置是否存在潛在風險。

• 智能化代碼審查(Code Review): 用靜態分析工具(Linter)自動發現常規的語法和風格問題。當需要判斷代碼是否遵循了某種複雜的設計模式,或識別潛在的邏輯缺陷時,讓LLM介入進行深度分析。

• 告警收斂與根因分析: 用高效算法對海量告警進行快速的去重和基礎分組。當需要理解不同系統來源、描述各異的告警是否指向同一個根本原因時,利用LLM進行語義聚類,智能地發現事件關聯。

總之,這一混合模式是在當前階段,在工程領域務實且高效地落地LLM價值的關鍵路徑。它不僅解決了眼前的技術難題,更為我們未來的技術創新提供了一張清晰的路線圖。