本文基於 Apache Flink PMC成員宋辛童在 Community Over Code Asia 2025 Streaming 專題技術分享中的演講內容整理而成,詳細介紹了Flink Agents項目的技術背景、架構設計和應用前景。

在人工智能技術快速發展的今天,AI應用從簡單的對話交互正在向更加複雜和智能化的方向演進。Apache Flink社區最近推出了一個全新的項目——Flink Agents,這是一個專門為事件驅動場景設計的智能體框架。本文將深入探討Flink Agents的技術架構、應用場景以及它在AI工程化道路上的重要意義。

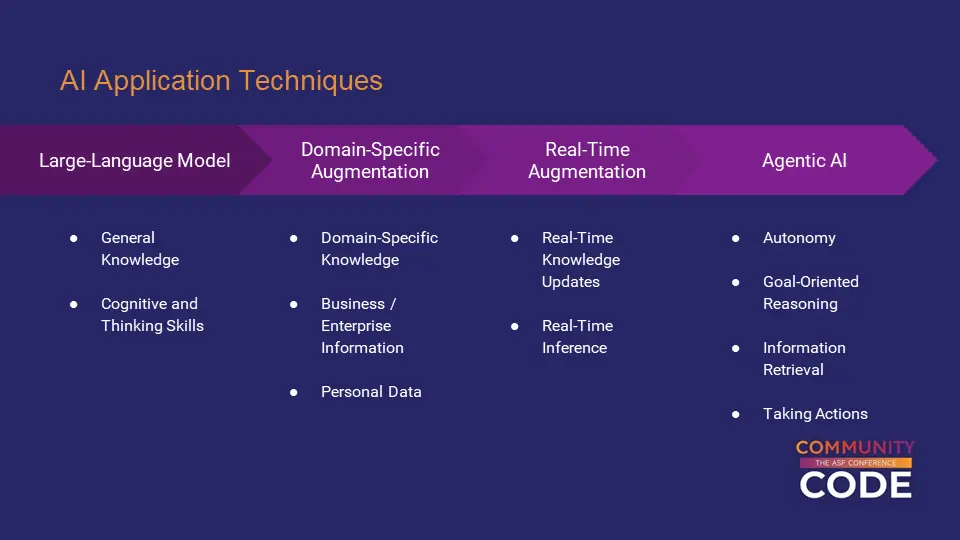

AI應用技術的四個發展層次

當前AI應用技術的發展可以分為四個主要層次。第一層是基礎的模型調用能力,這是所有AI應用的基礎。第二層是領域增強技術,通過專業知識的注入讓AI在特定領域具備更強的專業能力,而不再是一個通用的智能系統。

第三層是實時增強能力,這是一個至關重要的發展方向。在傳統的AI應用中,上下文信息往往是靜態的,而實時增強技術能夠讓AI訪問到最新鮮、最及時的上下文信息。舉例來説,當用户向客服機器人求助時,如果系統能夠實時獲知這個用户在一分鐘前剛剛使用產品時遇到了什麼錯誤,以及用户的歷史使用記錄,就能夠提供更加精準和個性化的服務。

第四層是智能體AI,這個層面就像給AI的"大腦"配上了"身體"。AI不僅能夠思考和分析,還能夠像人一樣以特定目標為導向,自主分析應該採取什麼行動。在這個過程中,AI可以主動獲取所需的信息,查閲相關資料,甚至使用各種工具來真正對外界產生影響。

當前Flink 社區在AI的應用領域主要集中在第三和第四個層次,而Flink Agents項目正是專注於第四層——智能體AI的工程化實現。

事件驅動智能體的獨特價值

市面上已經存在眾多AI 智能體框架,那麼為什麼Apache Flink社區還要開發一個新的框架呢?答案在於Flink Agents專注於一個特殊的應用場景——事件驅動的智能體。

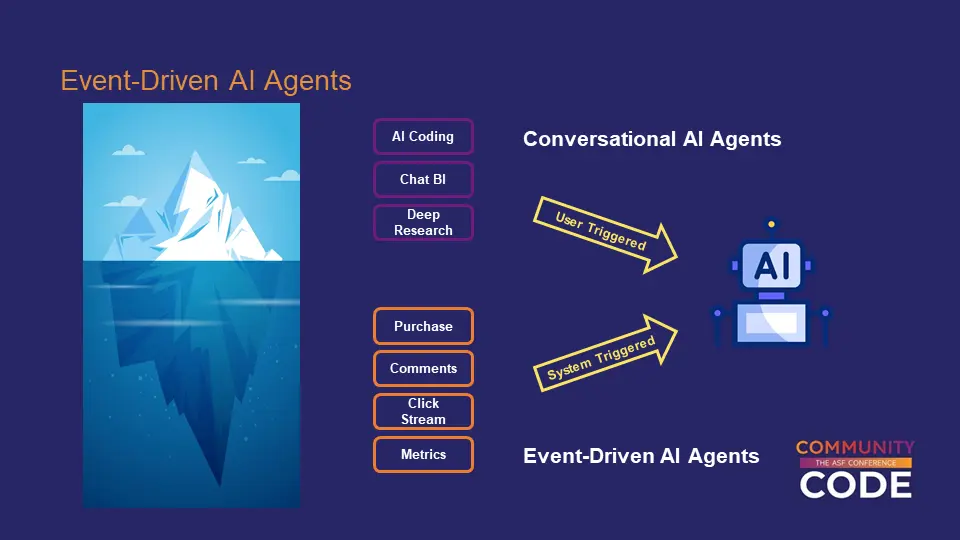

傳統的AI應用大多屬於對話式(Conversational)智能體,這種模式下用户通過對話框用自然語言描述問題或任務,然後讓AI去執行。這是一種用户主動觸發的交互模式,比如常見的 AI Coding、ChatBI、DeepResearch等產品都屬於這一類型。

與之相對的是事件驅動(Event-Driven)智能體,這種應用由系統自動產生的實時事件或數據更新來觸發AI的處理過程。隨着AI技術的發展和成熟,未來智能體的發展方向必然是工業化的,也就是説會有更多的AI請求由系統自動觸發,而不需要人工手動操作。這個趨勢就像數據分析領域的發展歷程一樣,從最初的人工編寫SQL查詢,發展到今天大量的OLAP分析都基於模板自動生成,能夠達到每秒數百QPS的處理能力。

典型應用場景解析

實時直播分析智能助手

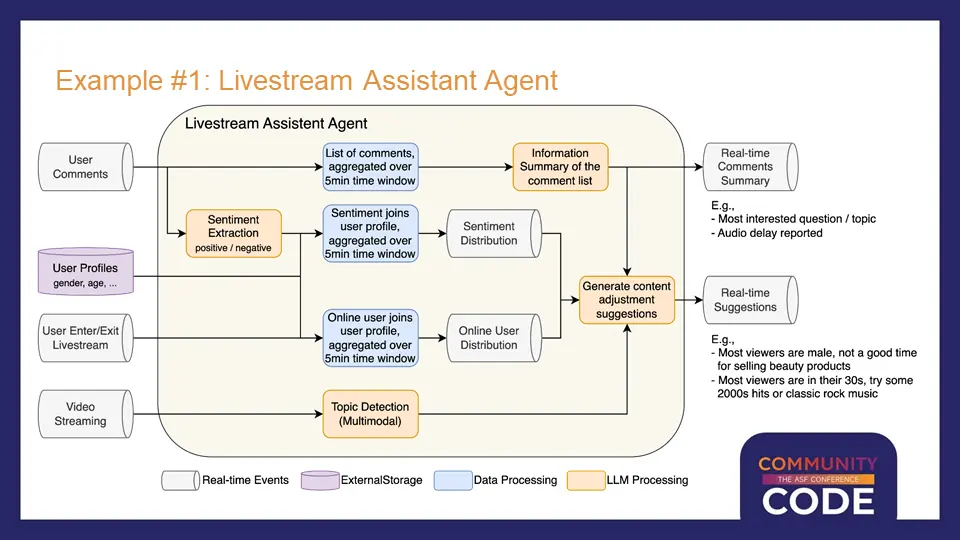

第一個典型應用場景是實時直播分析。在網絡直播或直播帶貨過程中,熱門直播間會產生大量的觀眾評論和彈幕。主播無法實時逐條閲讀和分析所有內容,傳統做法需要配備後台分析團隊和導播來完成這項工作。

通過事件驅動的AI智能體,系統可以實時分析最近幾分鐘內的所有彈幕評論,進行信息提取和彙總。比如識別出觀眾詢問最多的問題,或者及時發現技術問題(如音畫不同步、聲音延遲等),讓主播能夠及時響應和解決。

更進一步,結合多模態AI模型,系統還可以識別當前直播的主題和商品,分析觀眾的用户畫像。基於這些分析結果,AI可以提供有價值的建議,比如根據觀眾的性別和年齡分佈來調整商品推薦策略,或者根據觀眾的年齡特徵來選擇合適的背景音樂。

智能運維繫統

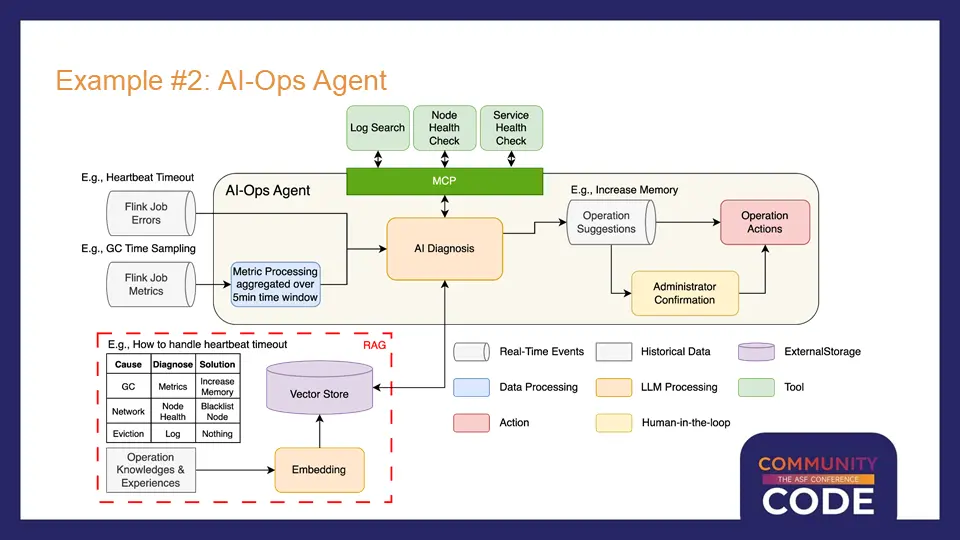

第二個應用場景是智能運維。以阿里雲的 Flink 雲產品為例,目前已經有一些基於規則的自動化運維能力,比如訂閲作業運行過程中的實時指標和異常事件,然後基於預設規則進行相應處理。

但是這種基於規則的方式存在侷限性,很多複雜問題無法有效解決。以心跳超時這個常見錯誤為例,它可能由多種不同原因引起:JVM內存問題導致的長時間GC、節點網絡問題,或者僅僅是底層資源集羣的正常調度。不同原因需要不同的診斷方法和解決方案,傳統的規則化編程很難覆蓋所有情況。

通過AI智能體的方式,系統可以在訂閲運行指標和異常事件的基礎上,將診斷過程交給AI處理。AI可以通過RAG技術查閲運維知識庫,根據積累的經驗選擇合適的診斷手段,比如通過工具調用進行日誌檢索或節點健康檢查。對於影響面較小的操作,AI可以直接執行;對於可能產生較大影響的操作,則通過人工確認後再執行。

事件驅動智能體的技術要求

通過上述應用場景分析,我們可以總結出事件驅動智能體的幾個關鍵技術特點。首先是實時性要求,事件產生後通常需要實時處理。其次是規模處理能力,系統自動觸發的事件數量和頻率遠大於人工觸發的請求,需要大規模分佈式計算能力支撐。

穩定性是另一個重要要求。與對話式智能體不同,事件驅動的智能體需要7×24小時長時間運行,沒有人能夠持續監控,因此必須具備強大的容錯和自我恢復能力。數據處理能力也必不可少,因為在整個應用的端到端流程中,往往伴隨着AI模型的非結構化處理和傳統的結構化數據處理。

最後是連接能力,需要能夠從不同系統中消費各種實時事件。這五個技術要求恰好與Apache Flink的核心能力高度吻合:毫秒級實時性、大規模分佈式處理、狀態管理和容錯能力、豐富的數據處理功能,以及對主流存儲系統的廣泛支持。

Flink Agents項目架構設計

基於上述技術背景,Apache Flink社區在2025年發起了Flink Agents項目。這個項目非常年輕,5月份提出提案,6月份正式投票通過,到目前為止只有幾個月的時間。有趣的是,這個項目是真正從零開始在社區中全新搭建的,而不是某個公司內部項目的開源版本。

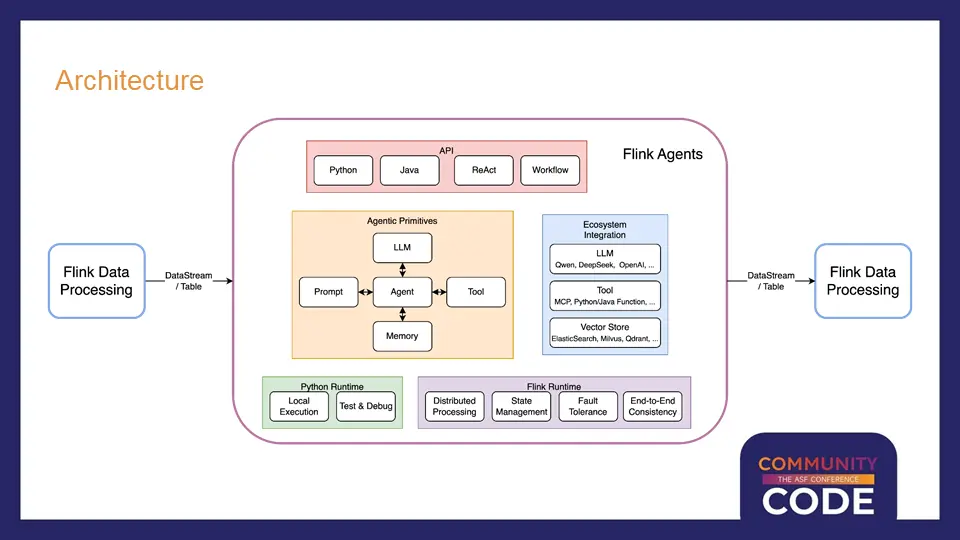

Flink Agents的架構設計體現了幾個核心設計理念。在智能體核心概念方面,沿用 AI Agent 的核心概念,對熟悉 Agent 的開發者沒有額外學習成本。在API層面,項目支持Python和Java兩種編程語言,同時提供不同接口來支持Workflow和ReAct兩種編程模式。

在生態系統方面,項目集成了市面上主流的模型提供商,支持MCP協議兼容以及Java、Python函數直接作為工具使用。對於向量存儲等常用組件,也提供了相應的抽象和標準實現,同時支持用户自定義擴展。

在運行時層面,項目提供了輕量級的Python運行時用於本地開發測試,以及基於完整Flink運行時的分佈式版本,能夠提供完整的分佈式執行、狀態管理、容錯和端到端一致性保障。

事件驅動編排架構

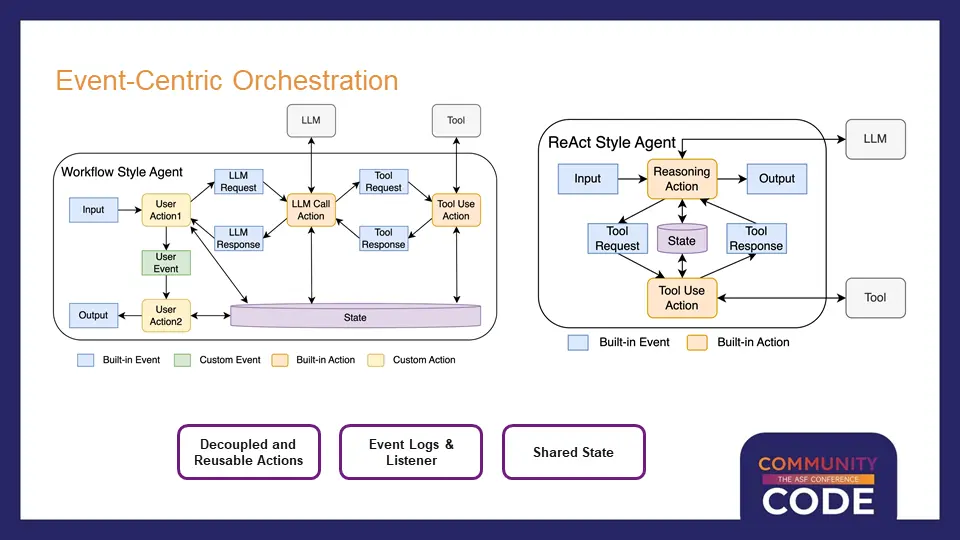

在智能體內部,Flink Agents採用了以事件為中心的編排方式。每個Agent由一系列Action組成,每個Action由特定的事件觸發,同時在執行過程中也可以通過發出新的事件來觸發其他Action的執行。

這種架構提供了足夠的靈活性,能夠同時支持Workflow和ReAct兩種主流的智能體開發方式。Workflow模式允許用户對智能體行為進行精細化控制,明確定義先做什麼、後做什麼,但編程複雜度相對較高。ReAct模式則將更多控制權交給AI模型,用户只需要指定模型版本、提示詞和可用工具,其餘工作交給AI自動處理。

項目中提到的Action和事件既可以是框架內置的,也可以是用户自定義的,還支持兩者混合使用。這種設計既支持框架本身的開發擴展,也滿足了企業級應用中平台型部門提供通用庫供業務部門使用的需求。

所有智能體內部發生的事情都以事件為載體進行傳遞,框架甚至可以提供關於事件更新、Action執行開始和結束等元事件。結合這些事件信息,系統能夠提供詳細的事件日誌來幫助用户理解智能體的執行過程,同時支持在線回調機制進行運行時監控。

技術展望與總結

Flink Agents項目的推出標誌着Apache Flink社區在AI領域的重要佈局。通過將Flink強大的流處理能力與AI智能體技術相結合,為事件驅動的AI應用提供了一個工業級的解決方案。

項目目前還處於早期開發階段,但其設計理念和技術架構已經展現出巨大的潛力。隨着AI技術的不斷髮展和工業化應用的深入,事件驅動的智能體將成為AI應用的重要發展方向。Flink Agents項目為這個領域的發展提供了一個強有力的技術基礎,值得持續關注和深入研究。

對於希望構建大規模、高可靠性AI應用的開發者和企業來説,Flink Agents提供了一個全新的技術選擇。它不僅繼承了Apache Flink在流處理領域的技術優勢,還針對AI應用的特殊需求進行了專門的設計和優化,有望成為下一代AI應用開發的重要工具。

更多內容

活動推薦

複製下方鏈接或者掃描二維碼

即可快速體驗 “一體化的實時數倉聯合解決方案”

瞭解活動詳情:https://www.aliyun.com/solution/tech-solution/flink-hologres