算力點白給!在 AI Ping 體驗 GLM-4.7 與 MiniMax M2.1 頂尖算力

前言:

隨着大模型進入“Agent時代”,開發者對模型在複雜工程與長鏈條任務中的表現提出了更高要求。國內領先的評測與聚合平台 AI Ping 近期重磅上線了兩款旗艦級模型:側重“一次性交付”與 Agentic Coding 的 GLM-4.7,以及在長鏈條執行與多語言能力上表現卓越的 MiniMax M2.1。本文將深度解析這兩款模型的底層優勢,並手把手教你如何通過 Claude Code 及 Coze 實現高效接入。

一、AI Ping介紹

AI Ping(aiping.cn)是一個國內領先的大模型服務評測與聚合平台,主要通過統一的接口集成國內外頂尖的大模型算力,為開發者和企業提供便捷的模型調用與性能比對服務。

1. 核心功能定位

- 大模型聚合服務:平台集成了多家主流廠商的模型(如智譜、MiniMax 等),並提供統一的 OpenAI 兼容接口,開發者只需一次接入即可在多個模型間無縫切換。

- 模型性能評測:作為評測平台,它能幫助用户根據不同任務(如代碼編寫、Agent 執行等)篩選最合適的模型,優化成本與效率。

- 工具流接入支持:支持將聚合的模型快速接入 Claude Code、Coze、Cursor 等主流 AI 開發工具,極大地降低了開發者使用高性能國內模型的門檻。

二、新模型介紹與解析

GLM-4.7(智譜 AI):深度思考的“編程架構師”

GLM-4.7 是專為複雜工程任務設計的旗艦模型,其核心突破在於將“思考模式”深度集成到編碼流程中。

- **Agentic Coding(代理化編程)**:

- 不同於傳統的單行代碼補全,GLM-4.7 側重於**“一次性交付”**。它能自主理解複雜的工程需求,進行方案拆解,並跨越多個文件進行邏輯編寫。對於 C++ 後端開發者而言,這不僅意味着它可以寫出單個函數,還能處理 CMake 構建配置、頭文件引用以及多模塊間的解耦。

- 三重“思考”機制:

- Preserved Thinking(持久化思考):在多輪對話中保留思考鏈路。當你在調試一個複雜的內存泄漏問題時,模型能“記住”之前的分析邏輯,避免在多輪追問中丟失上下文。

- 輪級思考控制:開發者可以按需開啓。簡單代碼生成時關閉以降低時延;在處理底層架構設計或複雜算法實現時開啓,以提升輸出的準確性與邏輯嚴密性。

- 交錯式思考:在執行每個 Action(如調用終端命令)之前都會進行自我審查,顯著降低了在 shell 環境中執行危險或錯誤命令的風險。

三、 MiniMax M2.1:極致效率的“執行專家”

MiniMax M2.1 則是面向高頻率、長鏈條 Agent 任務優化的典範,主打“快、準、省”。

- MoE(混合專家)架構的紅利:

- M2.1 通過選擇性激活參數,實現了在同等智能水平下,推理速度達到同級別模型的 2 倍。這對於需要頻繁調用的自動化腳本或持續集成的 CI/CD Agent 來説,極大地提升了響應比。

- 長鏈 Agent 深度優化:

- 在處理需要經過“調研 -> 規劃 -> 執行 -> 糾錯”多個環節的任務時,M2.1 表現出極強的穩定性。它在 τ2-Bench(智能體工具使用)評測中排名靠前,證明了其在多步驟複雜調用中的邏輯不“掉鏈子”的能力。

- 全球化工程能力:

- 強化了多語言環境下的工程處理能力。無論是處理多國語言的 API 文檔,還是在跨國協作的開源項目中編寫註釋和邏輯,M2.1 都能提供更加地道且符合工程規範的輸出。

模型綜合評價與對比

| 維度 | GLM-4.7 | MiniMax M2.1 |

|---|---|---|

| 核心定位 | “深度思考型” 編程專家 | “高能效執行型” Agent 專家 |

| 技術殺手鐗 | Preserved Thinking(持久化思考鏈),保留多輪對話邏輯 | MoE 架構,同級別智能下推理速度快 2 倍 |

| 擅長領域 | 複雜工程、跨文件修改、終端指令執行 | 長鏈條 Agent、多語言工程、高頻自動化任務 |

| 交付風格 | 追求**“一次性交付”**,減少往復修改 | 追求持續運行效率與高性價比 |

三、MiniMax M2.1 與 GLM-4.7 現已支持 API 一鍵接入

3.1 獲取密鑰

請依次點擊:主頁 的 個人中心 → API 密鑰

3.2 採用vscode接入

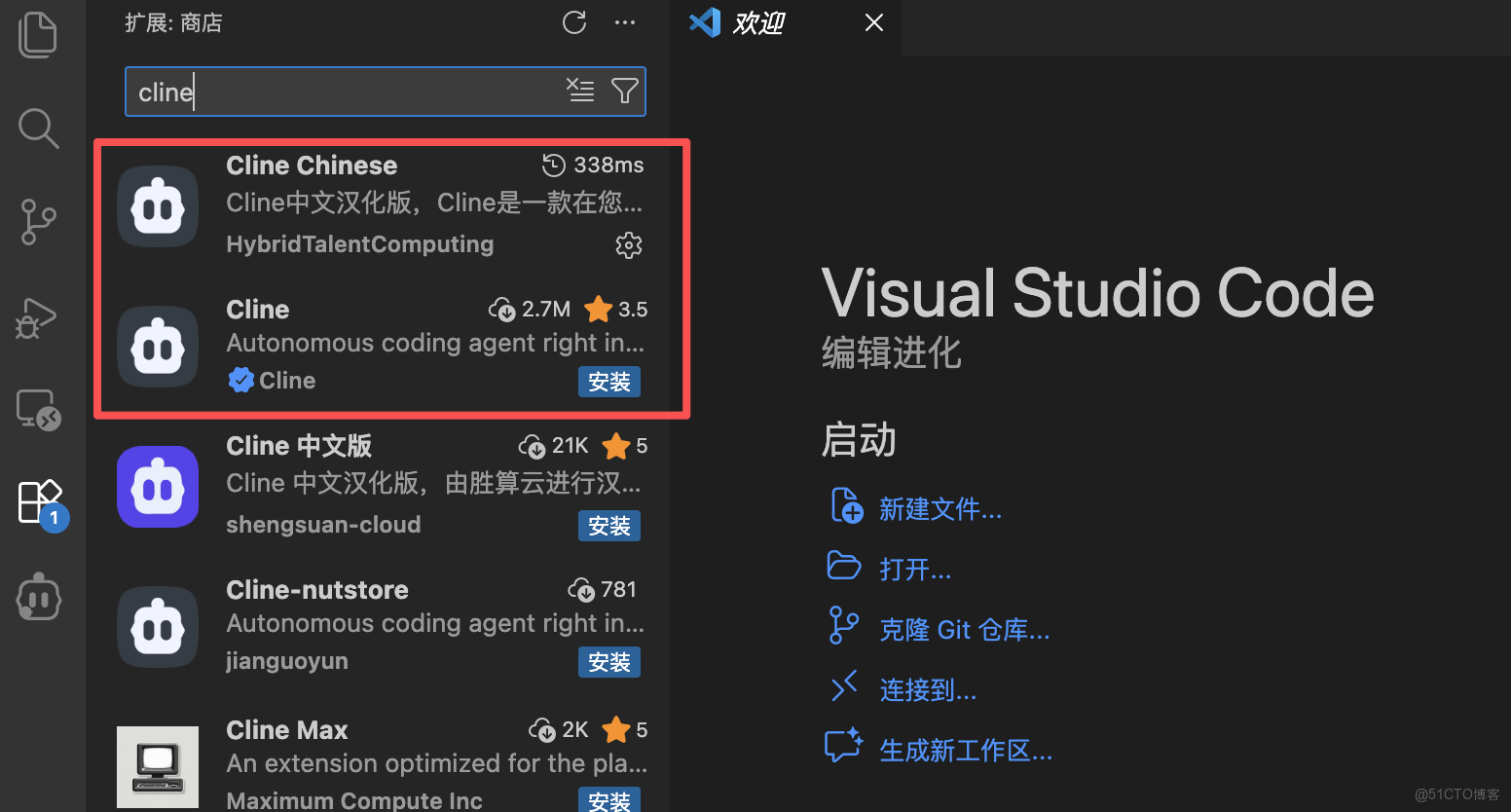

第一步:下載Cline

- 在擴展中直接搜Cline

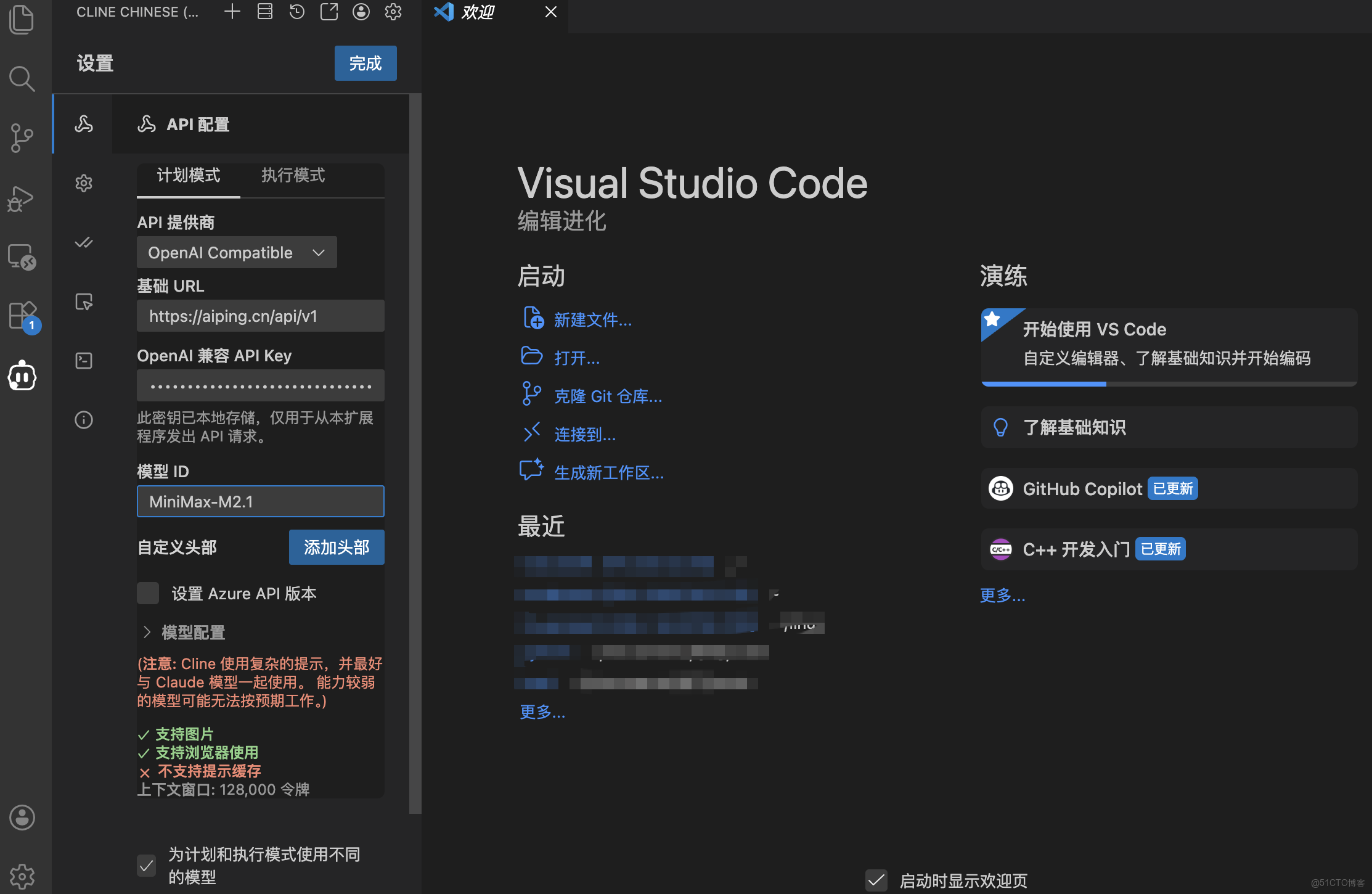

第二步:添加模型

- Base URL**:** 填入我們在 AI Ping 後台複製的聚合接口地址(是 https://aiping.cn/api/v1 )。這是我們將 IDE 連接到 AI Ping 智能路由的網關。

- API Key: 將剛才那串

QC-開頭的密鑰粘貼進去。 - 制定模型ID:

GLM-4.7MiniMax-M2.1可以直接複製進去。

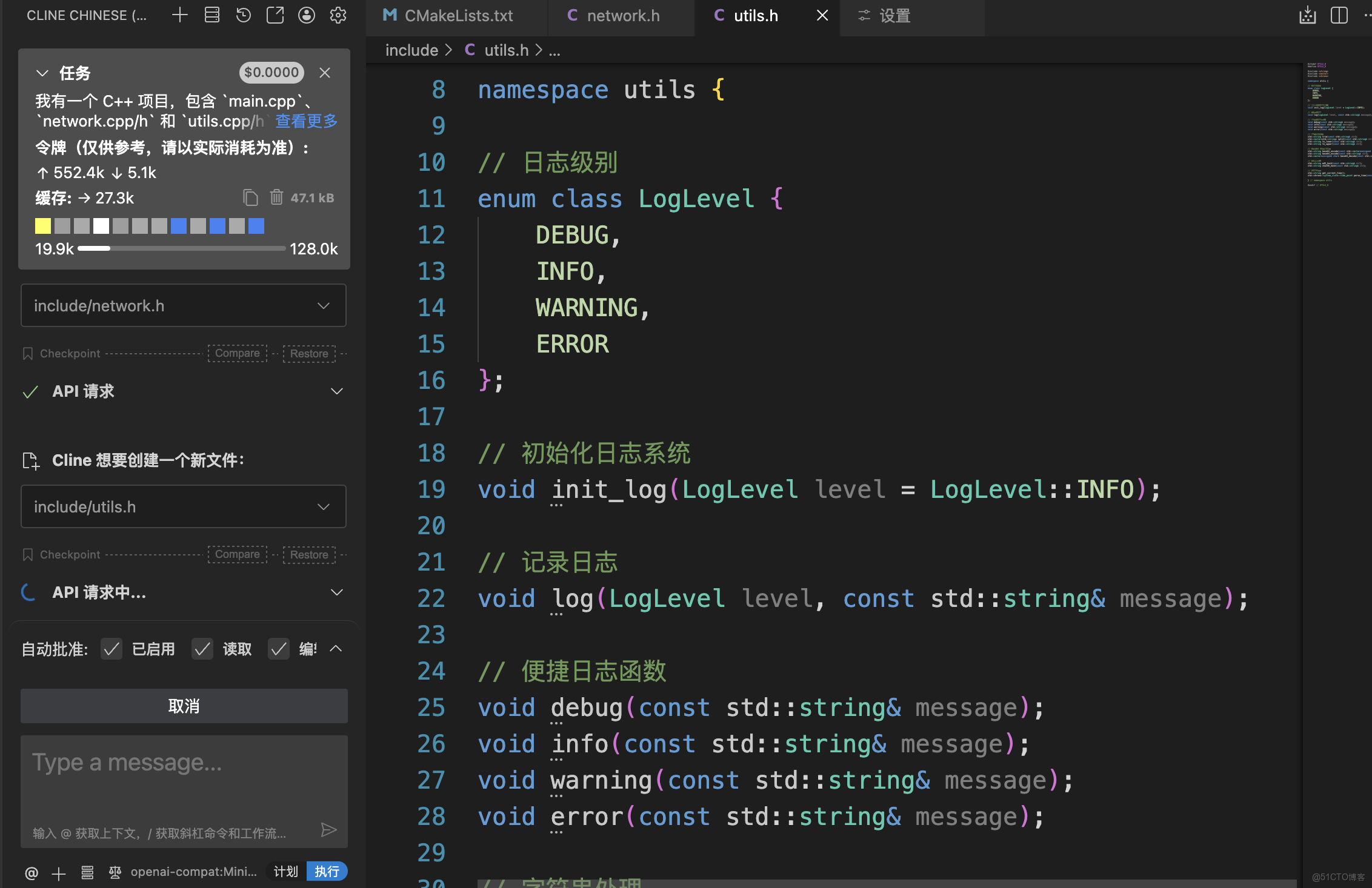

3.3 GLM-4.7 專項測試:複雜工程與深度邏輯

這些用例旨在挖掘 GLM-4.7 的“持久化思考(Preserved Thinking)”和“Agentic Coding”優勢。

- 配置詳細

3.3.1 跨文件架構重構

- 測試任務:將一個基於 Makefile 構建的多文件 C++ 項目重構為 CMake 項目。

- Prompt 示例:

我有一個 C++ 項目,包含

main.cpp、network.cpp/h和utils.cpp/h。目前使用 Makefile 編譯,依賴了pthread和openssl。請幫我編寫一個CMakeLists.txt,要求支持自動尋找依賴、設置 C++17 標準,併為network模塊創建一個靜態庫。請一次性提供完整的目錄結構建議和代碼。

3.3.2 項目構成

.

├── CMakeLists.txt # CMake 構建配置文件

├── README.md # 項目説明文檔

└── src/

├── main.cpp # 主程序入口

├── network/ # 網絡模塊(靜態庫)

│ ├── network.h

│ └── network.cpp

└── utils/ # 工具模塊(靜態庫)

├── utils.h

└── utils.cpp

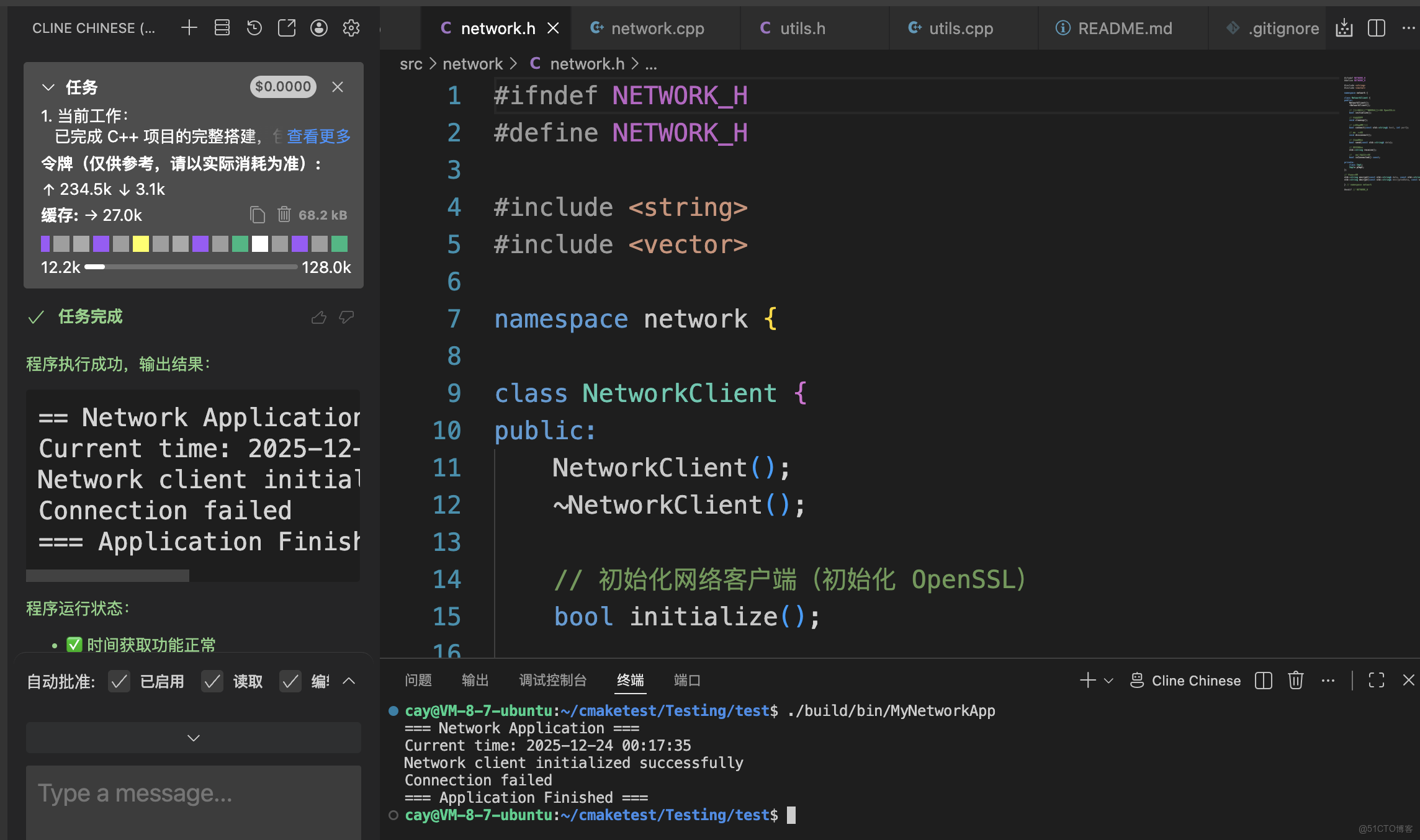

- 項目也是成功執行,全程我沒有進行任何操作,全程自主執行流

3.4 MiniMax M2.1 測試:多步邏輯流與文檔整理

測試目標:驗證其長鏈條 Agent 的執行穩定性和響應速度。

-

場景描述:模擬一個從“理解需求”到“生成文檔”的快速閉環。

-

Prompt 示例:

- 列出‘學生表’和‘課程表’需要包含的基礎字段。

- 為這兩個表寫出簡單的 SQL 創建語句(MySQL 語法)。

- 用中英雙語為這兩個表寫一段簡短的項目描述。 請儘量快速地一次性輸出,不要分批迴答。

多步邏輯執行力:模型成功完成了從字段列舉、SQL 編寫到中英雙語描述的所有步驟。這印證了 MiniMax M2.1在長鏈條 Agent 任務中的穩定性。

中英雙語工程質量:

- 中文描述:準確勾勒了系統核心功能,術語使用規範(如“核心數據結構”、“業務功能”)。

- 英文翻譯:翻譯質量極高,使用了“academic management system”和“course scheduling”等地道的專業詞彙,符合其“強化多語言工程能力”的技術特性。

總結

1. 兩款旗艦模型怎麼選?

- GLM-4.7 (智譜 AI): 它是“代碼專家”。擅長一次性處理複雜的編程任務和跨文件修改,適合寫代碼和搞工程。

- MiniMax M2.1: 它是“效率之王”。速度比同級快 2 倍,且成本極低,適合需要快速響應的長流程自動化任務。

2. AI Ping (aiping.cn) 平台亮點

- 一個接口管全部: 採用標準的 OpenAI 接口,支持 Claude Code 和 Coze 等工具一鍵切換模型。

- 性能看得見: 實時顯示每個模型的響應速度和價格,智能選出最划算的通道。

- 靈活配置: 你可以手動添加任何你想用的模型 ID。

3. 給開發者的避坑 & 福利

- 解決報錯: 如果看到

Invalid Model,通常是沒錢了或 ID 寫錯了。請核對 ID 並在控制枱確認算力點餘額。 - 薅羊毛攻略: 邀請一個好友註冊,雙方都能拿 20 元算力點,上不封頂。