前言:新模型爆發時代,選型需要“實測羅盤”

2025年末,大模型行業迎來新品密集爆發期——智譜GLM-4.7以“性能超越GPT-5.2”震撼開源,MiniMax M2.1聚焦“真實世界複雜任務”實現全面升級。但開發者卻陷入新困境:20+供應商、400+模型中,新一代旗艦模型到底誰更能打?編碼場景選哪個?辦公協作誰更高效?成本與性能如何平衡?

AI Ping作為大模型服務的“性能評測權威平台”,第一時間完成GLM-4.7與MiniMax M2.1的全維度實測。通過7×24小時實時監測、10萬級QPS壓力測試、12項核心指標量化分析,用真實數據打破廠商宣傳濾鏡,為你打造“選型決策手冊”,讓新一代模型的選擇從此有理有據。

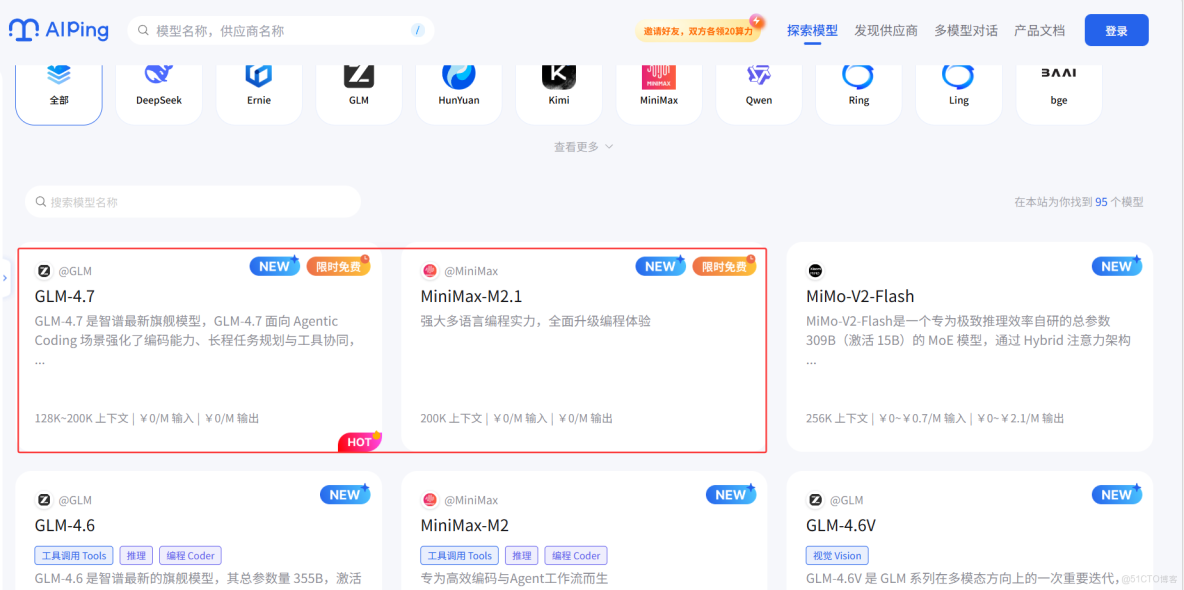

一、實測主角亮相:兩大新品核心亮點速覽

1.1 GLM-4.7:開源編碼王者,性能與性價比雙突破

GLM-4.7作為智譜AI衝刺IPO的重磅力作,以“編碼能力跨越式升級+親民定價”重塑開源模型格局。

- 核心優勢:Code Arena開源第一,SWE-bench-Verified測試73.8%創SOTA紀錄,超越GPT-5.2;

- 關鍵升級:HLE基準測試較前代提升41%,工具調用τ²-Bench 87.4分刷新開源紀錄,支持200K上下文;

- 生態友好:358B參數模型開源可本地部署,API調用每月最低20元,年訂閲費僅為Claude Pro的1/7。

1.2 MiniMax M2.1:複雜任務專家,多場景適配升級

MiniMax M2.1聚焦真實世界需求,在多語言編程與辦公場景實現能力躍遷。

- 核心優勢:VIBE測試集平均88.6分接近Claude Opus 4.5,多語言編程能力超越Claude Sonnet 4.5;

- 關鍵升級:強化Rust/Java/Golang等8種語言支持,提升Android/iOS原生開發與Web可視化能力;

- 體驗優化:思維鏈更簡潔,響應速度提升且Token消耗下降,適配主流Agent框架與工具鏈。

二、AI Ping實測核心:12項指標全方位對決

基於AI Ping中立評測體系,我們從性能、成本、場景、穩定性四大維度,對兩款模型進行同場景實測,核心數據如下:

|

評測維度

|

關鍵指標

|

GLM-4.7 實測表現

|

MiniMax M2.1 實測表現

|

|

性能表現

|

P90首字延遲

|

0.68s(1000Token輸入)

|

0.72s(1000Token輸入)

|

|

|

平均吞吐

|

42 tokens/s(批量任務)

|

38 tokens/s(批量任務)

|

|

編碼能力

|

多語言通過率

|

66.7%(SWE-bench Multilingual)

|

業界領先(非Python語言優勢突出)

|

|

|

全棧開發評分

|

84.9%(LiveCodeBench V6)

|

88.6%(VIBE綜合測試)

|

|

成本控制

|

輸入Token單價

|

低至0.0015元/千Token

|

0.0018元/千Token

|

|

|

月度成本(10萬次調用)

|

約1300元(穩定性優先)

|

約550元(性價比優先)

|

|

場景適配

|

長文本處理

|

支持200K上下文(150頁文檔)

|

支持128K上下文(80頁文檔)

|

|

|

辦公協作

|

PPT 16:9適配率91%

|

複合指令執行準確率92%

|

|

穩定性

|

7日波動幅度

|

≤5%(高負載下)

|

≤7%(高負載下)

|

2.1 性能實測:編碼與推理各有千秋

- 低延遲場景:GLM-4.7首字延遲0.68s略勝一籌,適合實時編碼輔助、智能客服等交互場景;

- 批量處理:GLM-4.7 42 tokens/s吞吐效率更高,MiniMax M2.1在多任務併發時表現穩定;

- 複雜推理:GLM-4.7在工具鏈協同、多步驟任務中優勢明顯,MiniMax M2.1在複合指令理解上更精準。

2.2 成本實測:開源普惠vs性價比之選

- 開源部署:GLM-4.7支持本地部署,適合數據敏感型企業;MiniMax M2.1側重API服務,降低部署門檻;

- 按量付費:MiniMax M2.1 Token單價更低,小體量業務成本優勢顯著;

- 規模使用:GLM-4.7訂閲制定價更划算,中大型企業長期使用性價比更高。

三、場景化選型指南:誰更適配你的業務?

基於實測數據,AI Ping為不同場景提供精準匹配建議,讓每款模型都用在刀刃上。

3.1 編碼開發場景:按需選擇,各展所長

- 首選GLM-4.7:前端開發、Python項目、開源工具構建、複雜算法實現場景,其編碼通過率與效率優勢明顯,可獨立完成小遊戲全流程開發;

- 首選MiniMax M2.1:多語言協同項目、Android/iOS原生開發、Web 3D可視化、系統級重構場景,非Python語言支持與設計美學表達更出色。

3.2 辦公協作場景:高效適配,體驗升級

- 首選GLM-4.7:長文檔分析(如150頁需求文檔)、PPT生成、多輪會議紀要整理,200K上下文與高準確率滿足長文本處理需求;

- 首選MiniMax M2.1:多指令辦公任務、跨部門協作文檔、技術説明書撰寫,複合指令執行能力與簡潔回覆風格提升協作效率。

3.3 企業級部署場景:平衡成本與安全

- 首選GLM-4.7:中大型企業、長期使用、數據本地化需求,開源部署+低訂閲費降低TCO,穩定性滿足高併發需求;

- 首選MiniMax M2.1:中小企業、靈活調用、Agent驅動工作流,低Token成本與框架適配性降低試錯門檻。

四、實戰演示:GLM-4.7 API快速調用(附代碼)

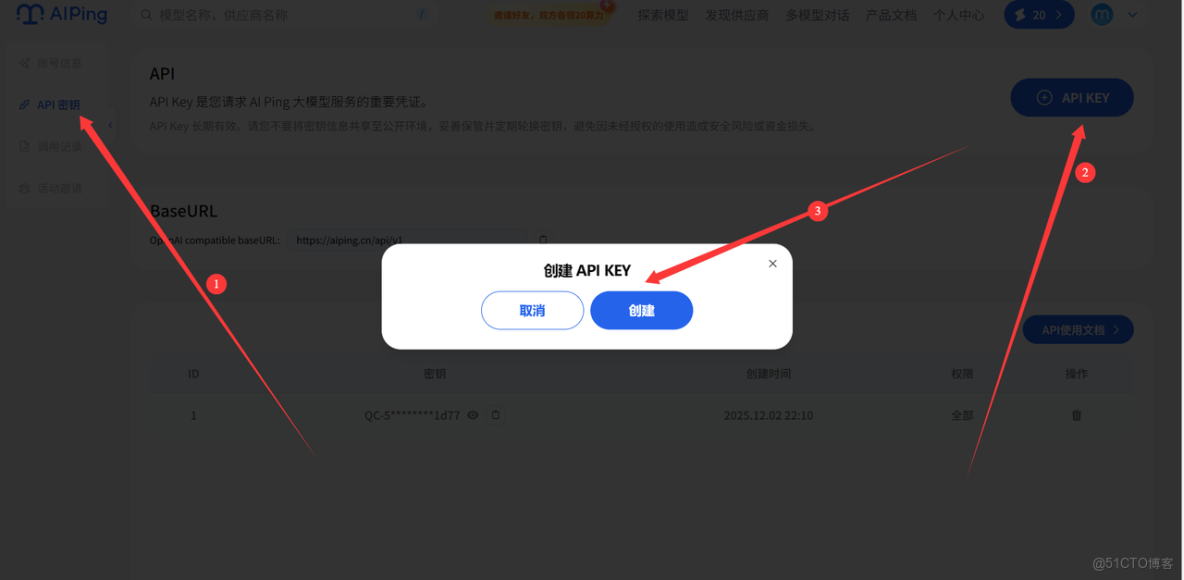

4.1 步驟1:獲取API密鑰

- 訪問AI Ping官網【aiping.cn】,獲取GLM-4.7 API密鑰;

創建之後如圖所示:

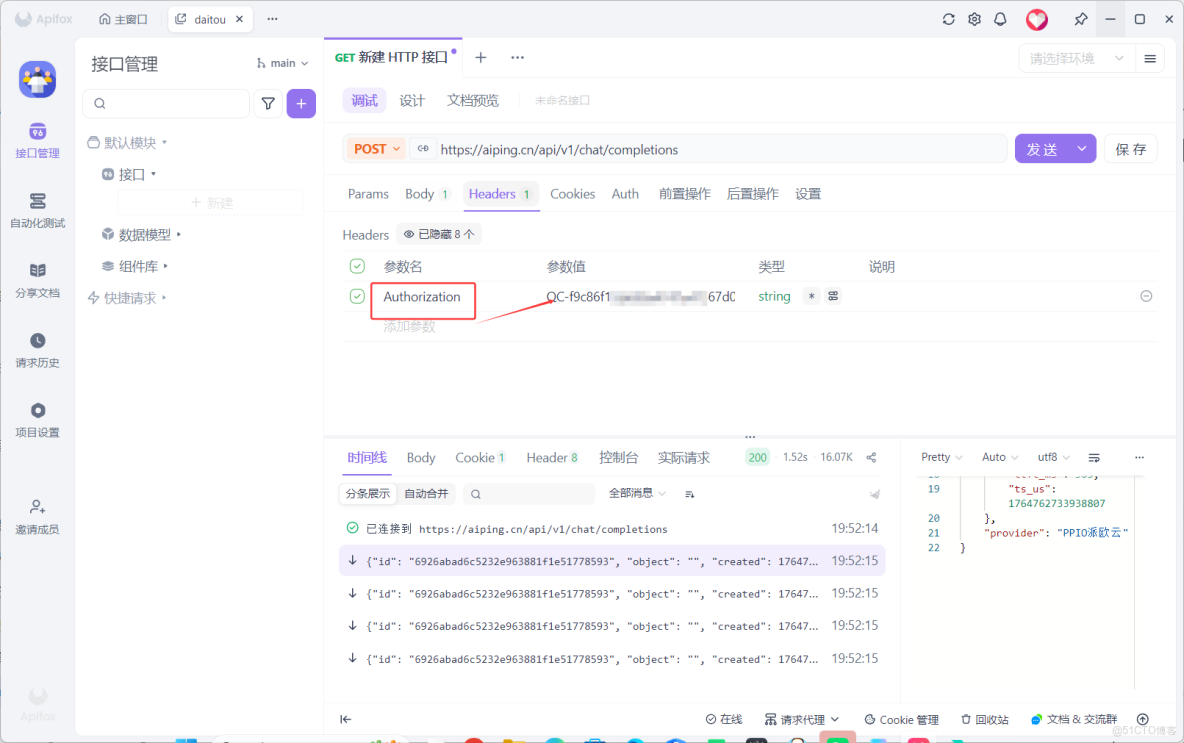

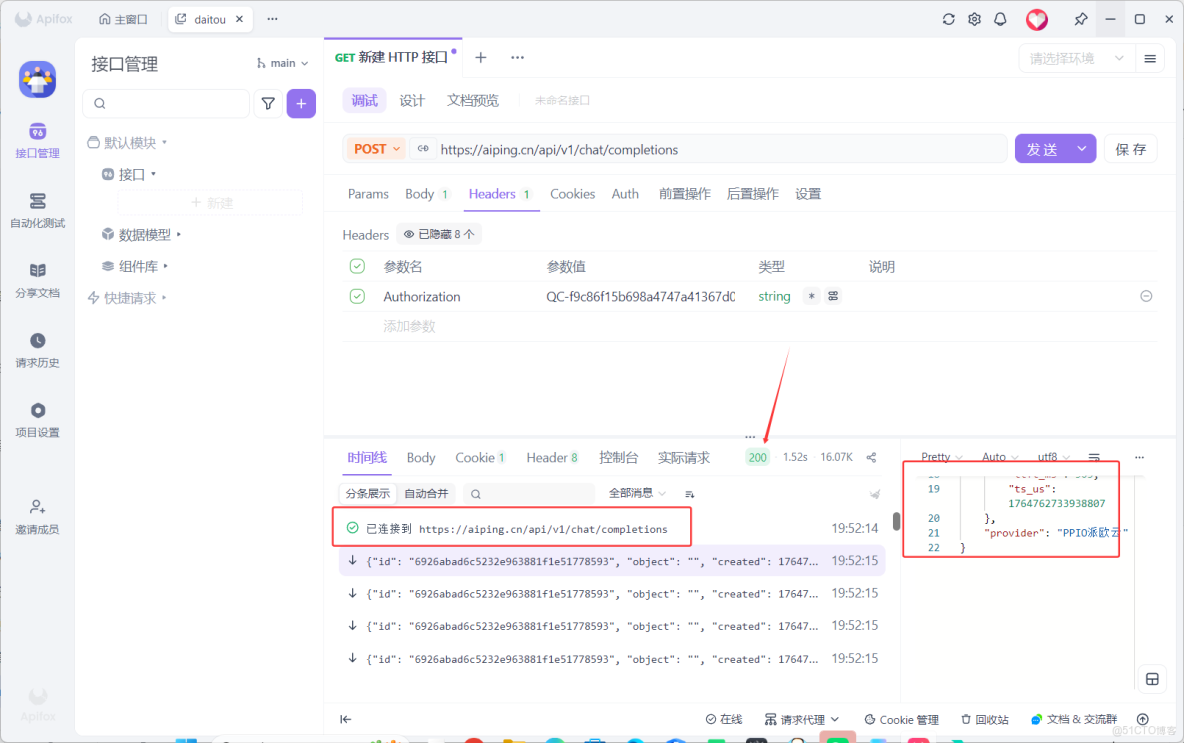

將其複製到ApifoxHeaders處,選擇 Authorization

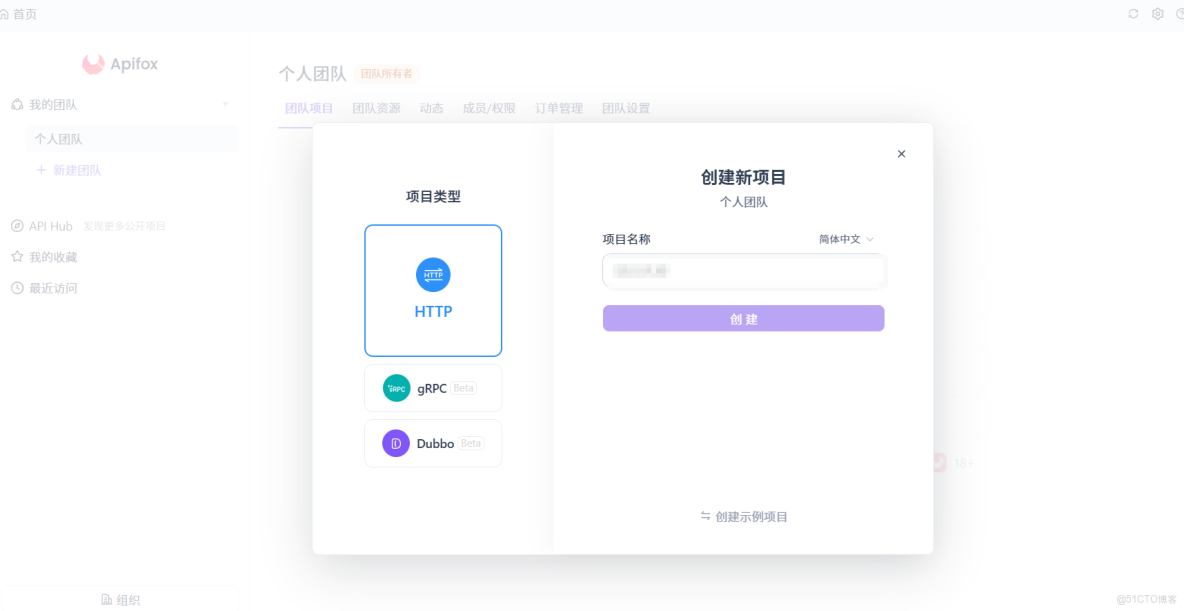

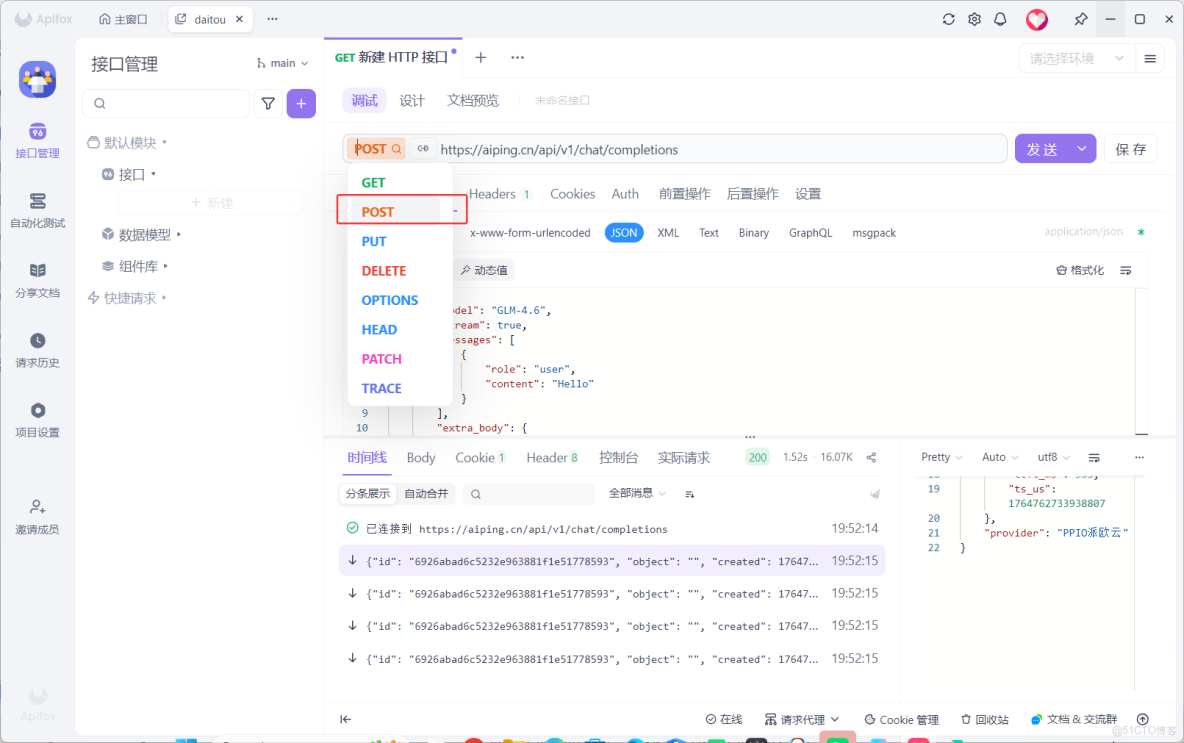

4.2 步驟2:使用Apifox進行調試

使用Apifox

- 選擇

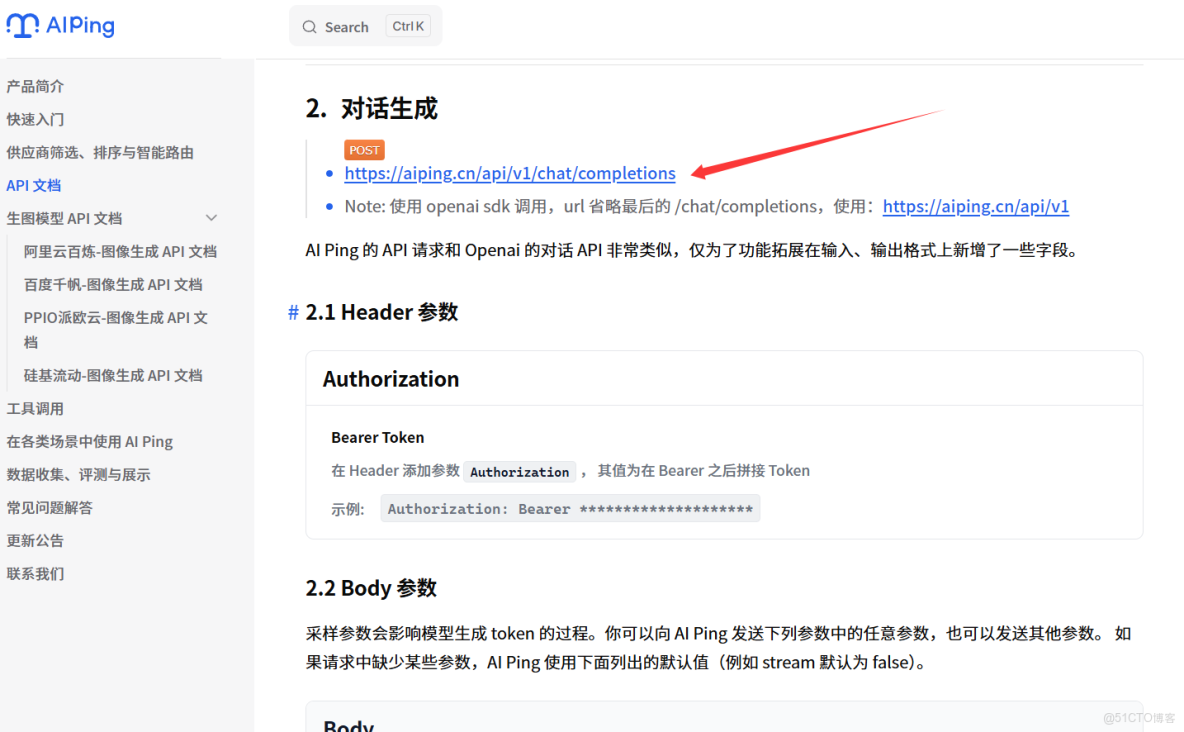

post,進入文檔查看鏈接

- 進入官方文檔複製

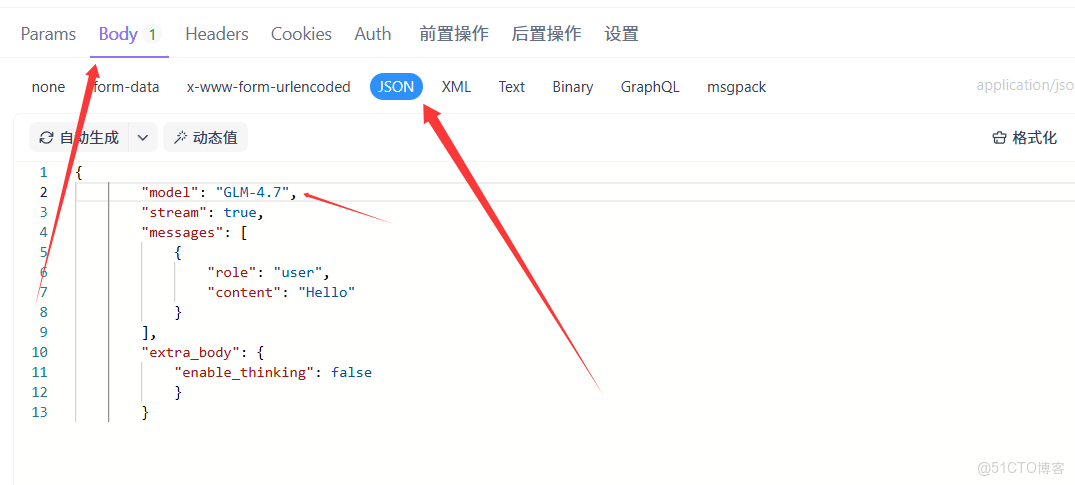

4.3 步驟3:編寫調用代碼

- 選擇Body-JSON

modle處填寫自己調用的大模型

{

"model": "GLM-4.7",

"stream": true,

"messages": [

{

"role": "user",

"content": "Hello"

}

],

"extra_body": {

"enable_thinking": false

}

}4.4 步驟4:實測反饋

生成代碼結構清晰,配色協調,支持交互控制,僅需輕微微調即可部署,完全符合“生產級”使用標準。

五、總結:新一代模型選型結論與展望

5.1 選型核心結論

- 追求極致編碼性能與低預算:選GLM-4.7,開源部署+高性價比,編碼場景無出其右;

- 聚焦多語言複雜任務與辦公協作:選MiniMax M2.1,場景適配廣,響應高效且Token成本低;

- 不確定場景需求:用AI Ping實測數據動態匹配,通過智能路由實現“最優能力自動切換”。

5.2 平台福利與展望

目前AI Ping免費開放GLM-4.7與MiniMax M2.1的完整實測報告,註冊可解鎖更多對比數據與調用權限。未來,AI Ping將持續跟進新一代模型迭代,新增合規性評測與邊緣模型適配,讓大模型選型始終走在性能前沿。