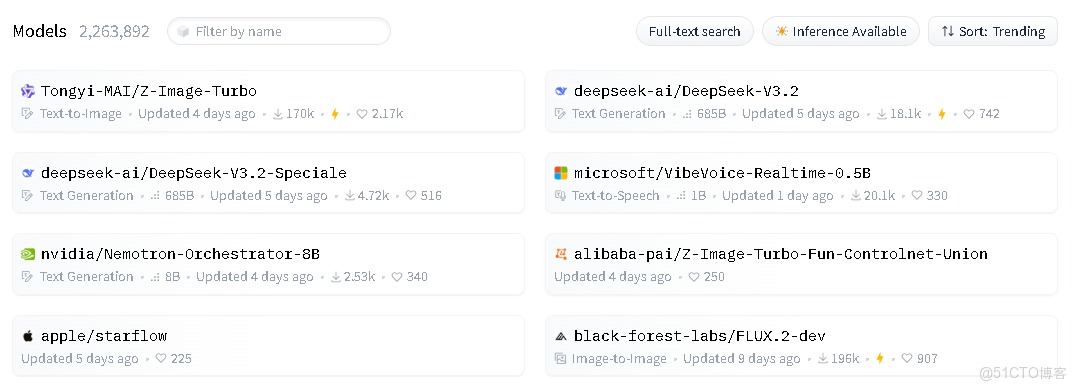

在AI技術日新月異的2025年,英偉達與香港大學聯合發佈了一項令人矚目的技術突破——Orchestrator-8B,近期在HuggingFace上保持着相當高的熱度。

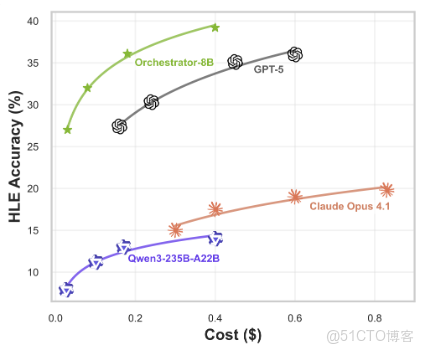

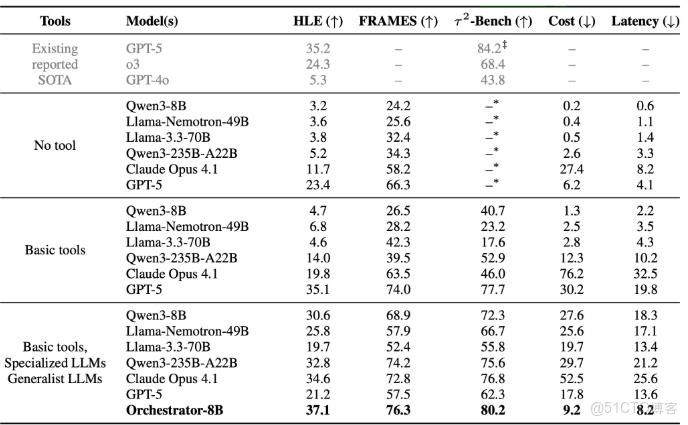

這個只有80億參數的小型模型,通過巧妙的強化學習訓練和工具調度策略,在人類最後的考試(HLE)基準測試中以37.1%的準確率超越了GPT-5的35.1%。Orchestrator-8B的誕生為複雜任務處理提供了更經濟、高效的解決方案。

值得注意的是,Ollama平台已提供非官方版本的Orchestrator-8B模型,即"Orchestrator-abliterated" 。該模型通過Sumandora的remove-refusals-with-transformers技術處理,移除了原始模型的內容過濾機制 。根據描述,這是一次"crude, proof-of-concept implementation"(粗糙的概念驗證實現),可能未完全解耦審查機制與核心邏輯 。使用該模型時需特別注意以下幾點:

- 內容安全風險:移除審查機制後,模型可能生成違反法律法規或倫理的內容,用户需自行過濾和承擔責任。

- 功能缺陷風險:非專業修改可能導致模型智能下降,如輸出混亂、邏輯錯誤或常識性錯誤,具體表現需待社區實測 。

- 工具調用風險:原生Orchestrator-8B的工具調度能力可能因審查機制移除而受到影響,導致工具選擇不當或過度調用。

- 穩定性問題:長週期決策可能因審查機制缺失而出現更嚴重的"漂移"現象,需謹慎測試。

一、背景與核心理念

傳統AI代理系統通常依賴單一大型語言模型(LLM)如GPT-5來完成任務,這種架構存在兩個致命缺陷:自我增強偏見和資源錯配 。研究表明,GPT-5在工具調用時會過度依賴自身簡化版模型(如GPT-5-mini被調用佔比高達66%),同時在78%的簡單任務中仍會調用頂級模型,造成嚴重的資源浪費 。

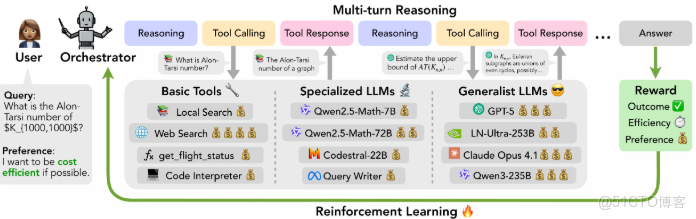

Orchestrator-8B的誕生源於香港大學與英偉達團隊對這一問題的深入思考。他們提出,人類在解決複雜問題時,會靈活調用各種外部資源,而AI系統也應該具備類似的能力。與其讓單一模型承擔所有任務,不如讓一個輕量級"協調者"管理多種專門的模型和工具,根據任務需求智能調度資源。這種思路與傳統"大模型單打獨鬥"形成鮮明對比,更像是一個精明的項目經理,知道何時該用什麼工具。

香港大學博士蘇弘錦(論文一作)和英偉達研究科學家Shizhe Diao(論文共一)領導的團隊,基於這一理念開發了ToolOrchestra框架,並通過該框架訓練出了Orchestrator-8B 。值得注意的是,Orchestrator-8B並非從頭訓練,而是基於阿里巴巴達摩院開源的Qwen3-8B模型進行微調 ,這使得模型既能保持一定的通用能力,又能專注於工具調度這一特定任務 。

二、技術架構與創新點

Orchestrator-8B的技術架構包含三個核心組成部分:Qwen3-8B微調、基於PPO優化的羣體相對策略優化(GRPO)算法和多目標優化機制。

在模型基礎層面,Orchestrator-8B採用了參數高效微調(PEFT)技術中的LoRA(低秩適應)方法 。具體來説,研究團隊在Qwen3-8B的注意力層引入了兩個低秩矩陣(秩r=64,縮放係數alpha=128),僅微調約524萬參數(佔總量的0.0655%) 。這種方法使得微調過程可以在單卡RTX 4090上完成,顯存佔用顯著降低,同時保持了模型的推理能力 。

強化學習訓練是Orchestrator-8B的核心創新。與傳統PPO(近端策略優化)不同,研究團隊採用了基於PPO優化的羣體相對策略優化(GRPO)算法 ,這是一種通過組內相對優勢(Advantage)計算來優化模型策略的方法 。GRPO的核心思想是通過組內樣本的相對比較替代傳統強化學習中的絕對價值估計,從而簡化訓練流程、提升計算效率並保持策略優化的穩定性 。訓練過程中,模型需要同時考慮三個獎勵因素:任務成功(二元獎勵)、效率(成本和時間)以及用户偏好(如隱私保護、低延遲等)。

多目標優化機制是Orchestrator-8B的另一大亮點。系統能夠根據用户需求動態調整三個獎勵的權重 ,而非採用固定的加權策略。例如,當用户強調"省錢"時,效率獎勵權重會自動提高;當用户要求"隱私保護"時,系統會優先選擇本地工具而非網絡搜索 。

工作流程上,Orchestrator-8B遵循三個主要步驟:首先解析用户指令和自然語言偏好(如"優先考慮低延遲"或"避免網絡搜索");然後生成推理過程並規劃行動;最後從可用工具中選擇並以統一的JSON格式發出工具調用 。這一過程可以持續進行,直到任務完成或達到50步的限制。

三、性能表現與基準測試

Orchestrator-8B在多個權威基準測試中表現出色,證明了其作為工具調度模型的有效性。

在**人類最後的考試(HLE)**基準測試中,Orchestrator-8B取得了37.1%的準確率,超過了GPT-5的35.1% 。

這些測試結果表明,Orchestrator-8B不僅在任務完成質量上優於GPT-5,更在資源利用效率上實現了質的飛躍 。特別是在處理需要多步驟操作的複雜任務時,Orchestrator-8B展現出強大的調度能力,能夠根據任務複雜度選擇合適的工具組合,避免不必要的資源消耗。

四、開源生態與未來發展方向

Orchestrator-8B的開源是其技術價值的重要體現。項目已在GitHub(https://github.com/NVlabs/ToolOrchestra/)和HuggingFace平台開源,包含完整的模型、代碼和訓練數據集ToolScale 。ToolScale數據集覆蓋金融、醫療、電商等10個領域,包含4063個多輪工具調用任務,為研究者提供了豐富的實驗素材 。

開源不僅降低了企業部署門檻,更推動了AI工具調度領域的研究創新。Orchestrator-8B的訓練方法(GRPO)和獎勵機制設計(多目標優化)為研究者提供了寶貴的參考,有助於構建更智能、更高效的複合AI系統。

需要注意的是,Orchestrator-8B遵循NVIDIA License ,其HuggingFace頁面明確標註:"This model is for research and development only" 。這意味着用户在使用Orchestrator-8B時需遵守NVIDIA的專用許可證條款,商業用途前必須聯繫NVIDIA獲取授權,不可直接用於盈利性項目。

未來,Orchestrator-8B的發展方向主要集中在三個方面:

首先是多模態工具整合。當前系統主要處理文本任務,未來可能會擴展到圖像、音頻、視頻等多種模態的工具協調,大大擴展應用範圍。

其次是遞歸協調系統。研究團隊展望構建遞歸的協調系統,即協調員可以調用其他協調員作為工具。這種"俄羅斯套娃"式的架構可能會帶來更強大的智能涌現效果 。

最後是實時定價策略優化。隨着AI服務市場的動態變化,工具調用成本也會隨之波動。未來Orchestrator-8B可能會引入更復雜的成本預測和優化機制,根據實時價格調整工具調度策略 。

五、與同類技術的對比分析

Orchestrator-8B並非工具調度領域的孤例,它與幾項相關技術存在顯著差異和優勢:

與谷歌DeepMind在2023年提出的Toolformer相比,Orchestrator-8B在工具選擇的靈活性和多樣性上更具優勢。Toolformer使用監督學習+自生成數據,讓12B參數的模型學會調用計算器、翻譯API等基礎工具,但未將大模型納入工具庫 。而Orchestrator-8B能夠協調GPT-5、Claude Opus 4.1等頂級大模型與專業工具,形成更強大的協同效應 。

與MIT和CMU聯合團隊的ToolRL相比,Orchestrator-8B的獎勵函數設計更為全面。ToolRL側重於任務正確性和工具調用效率,但未明確納入用户偏好 。Orchestrator-8B則通過用户偏好獎勵機制,使系統能夠更好地滿足用户的個性化需求。

與香港大學和微軟提出的Optimal Tool Calls(OCT)相比,Orchestrator-8B在多目標平衡能力上更為突出。OCT專注於工具調用成本優化,而Orchestrator-8B則同時優化結果質量、效率和用户偏好,形成了更全面的評估體系 。

Orchestrator-8B最大的技術突破在於證明了"小模型+工具調度"架構的有效性 。相比單一大模型,這種架構不僅降低了計算成本,還提高了任務處理效率和準確性。在HuggingFace平台上,Orchestrator-8B獲得極高評價,衝入熱門模型前五,充分證明了其技術價值和實用潛力 。

六、技術侷限性與挑戰

儘管Orchestrator-8B取得了顯著成就,但仍面臨一些技術侷限性和挑戰:

首先是工具庫依賴。Orchestrator-8B的性能高度依賴於可用工具的質量和多樣性。如果工具庫中缺乏特定領域的專業工具,系統可能無法充分發揮潛力。這要求企業在部署時需要根據自身需求構建合適的工具庫。

其次是長週期決策穩定性。雖然Orchestrator-8B支持50步的長週期決策,但隨着步驟增加,決策質量可能會逐漸下降。研究團隊發現,當步驟超過30後,部分模型會出現"漂移"現象,即決策逐漸偏離最優路徑 。如何保持長週期決策的穩定性仍是未來需要解決的問題。

最後是用户偏好量化。用户偏好獎勵機制需要將自然語言偏好轉化為可量化的獎勵信號。目前系統主要通過預設規則實現這一轉化,未來可能需要更復雜的機制來處理更復雜的偏好描述。

這些挑戰反映了工具調度技術的複雜性,也指明瞭未來研究的方向。隨着技術的不斷進步,我們有理由期待更多類似Orchestrator-8B的創新技術出現,進一步推動AI技術的發展和應用。