- [ ] ✅ 前提條件 系統已安裝 CUDA,且版本需與 Ollama 兼容。 以 NVIDIA 顯卡為例,驅動版本需 ≥ 452.39(官方要求)。 Ollama 支持 計算能力 ≥ 5.0 的 Nvidia GPU,具體兼容性請參考:CUDA GPU 列表。 其他顯卡支持情況見官方文檔:GPU 支持説明。

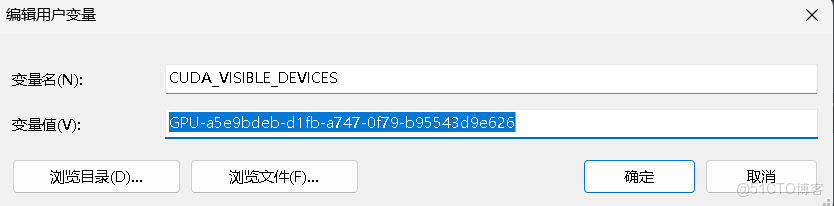

如果系統中有多個 NVIDIA GPU,並且希望限制 Ollama 使用其中的一部分卡,可以通過設置CUDA_VISIBLE_DEVICES環境變量實現。變量值為以逗號分隔的 GPU UUID列表。 Nvidia官方關於CUDA環境變量的參考鏈接地址:https://docs.nvidia.com/cuda/cuda-c-programming-guide/index.html#env-vars

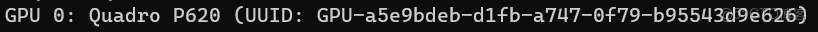

GPU的UUID可以通過使用以下命令查看

nvidia-smi -L得到結果類似下圖

假設只想使用第一張卡(UUID 為 GPU-a5e9bdeb-d1fb-a747-0f79-b95543d9e626),則在系統環境變量中添加:

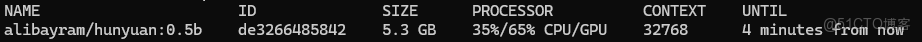

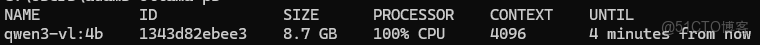

設置完成後運行大模型

ollama run alibayram/hunyuan:0.5b然後再起一個命令行窗口並執行 docker ps 查看就可以看到 processor裏面有cpu與gpu運行百分比

⚠️ 注意事項

如果模型比較大而顯存比較小也可能導致全部使用CPU

❗關於非官方環境變量的説明

網上有的文章中還需設置環境變量OLLAMA_GPU_LAYER值為CUDA,但是在ollama官網並沒有找到相關信息;

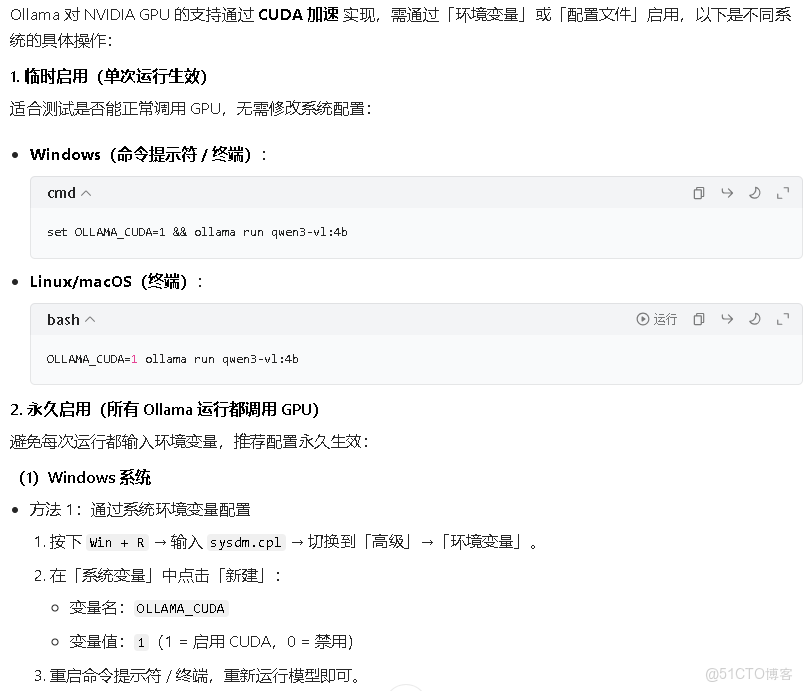

豆包反饋的需要設置OLLAMA_CUDA環境變量同樣在官網文檔中未找到,可能是ollama版本升級後導致的,也可能是大模型的幻覺導致的,建議以官方文檔為準