2025年,開源圖生圖模型領域迎來爆發式增長,三大代表模型——Kandinsky 5.0、Qwen-Image和Z-Image——以截然不同的技術路線和參數規模,共同重塑了AI圖像生成的生態格局。這些開源模型不僅降低了創作門檻,更通過多語言支持、中文排版優化和輕量化設計等創新,填補了國內AI圖像生成領域的空白。與2024年相比,2025年的開源圖生圖模型在推理速度、分辨率支持和中文適配上實現了全面突破,為創意產業、廣告營銷和內容創作等領域提供了強大工具。

一、三大開源圖生圖模型全景概覽

2025年的開源圖生圖模型呈現出明顯的差異化競爭格局:一方面,以俄羅斯Sber銀行的Kandinsky 5.0為代表的多語言支持模型專注於高效推理和國際化場景;另一方面,阿里通義千問團隊的Qwen-Image和通義實驗室的Z-Image則分別以中文排版優化和輕量化設計見長,形成了針對不同用户需求的互補生態。三大模型的發佈,標誌着全球開源圖生圖技術已達到工業級水準,為從個人創作者到專業設計團隊的全譜系用户提供了普惠化AI創作工具。

|

模型名稱

|

發佈時間

|

參數規模

|

核心架構

|

開源協議

|

主要特點

|

|

Kandinsky 5.0 Image Lite

|

2025年11月

|

6B

|

CrossDiT+Flow Matching

|

MIT協議

|

多語言支持,16步生成,最高1408×1408分辨率

|

|

Qwen-Image

|

2025年8月

|

20B

|

MMDiT架構

|

Apache 2.0

|

中文排版優勢,長文本渲染準確率89%,支持ControlNet

|

|

Z-Image

|

2025年11月28日

|

6B

|

S³-DiT架構

|

Apache 2.0

|

輕量化設計,8步採樣,最低8GB顯存支持

|

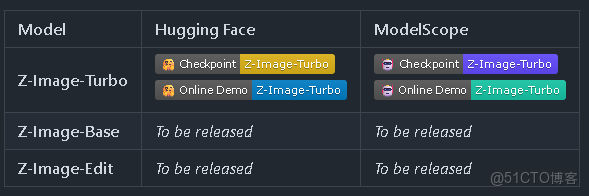

這三大模型的發佈,標誌着全球開源圖生圖技術已達到工業級水準。Kandinsky 5.0填補了開源領域多語言圖像編輯的空白,Qwen-Image解決了中文文本渲染的行業痛點,而Z-Image則通過極致的輕量化設計,將高質量圖像生成能力帶入消費級硬件(目前Z-Image-Turbo已發佈,Z-Image-Base和Z-Image-Edit尚未正式發佈)。它們共同推動了AI圖像生成技術的民主化進程,使創作不再是專業人士的專利。

二、Kandinsky 5.0:俄羅斯開源AI的里程碑之作

Kandinsky 5.0由俄羅斯Sber銀行於2025年11月正式開源,是歐洲最大的開源項目之一,成為圖像與視頻生成領域的全新標杆 。該系列包含三款核心模型:6B參數的Image Lite(圖像生成/編輯)、2B參數的Video Lite(文本/圖像到視頻生成)和19B參數的Video Pro(高質量視頻生成),均支持最長10秒視頻生成 。Image Lite作為圖生圖任務的主力模型,憑藉其多語言支持和高效推理能力,迅速在國際開發者社區引發熱議。

技術架構方面,Kandinsky 5.0採用基於流匹配(Flow Matching)範式和潛在擴散管道(Latent Diffusion Pipeline)的核心架構,核心骨幹網絡為CrossDiT(Cross-Attention Diffusion Transformer) 。其創新點在於引入NABLA稀疏注意力機制,通過鄰域自適應塊級稀疏注意力,將高分辨率視頻訓練/推理速度提升2.7倍,保持90%稀疏率且不損失質量 。模型通過多階段訓練流程(預訓練→監督微調→蒸餾→RL-based後訓練),將生成步驟(NFE)從100降至16,顯著提升了推理效率 。

在性能表現上,Kandinsky 5.0 Image Lite支持最高1408×1408分辨率的圖像生成與編輯 ,在人工評估(Side-by-Side)中,其圖像生成質量在視覺質量和構圖方面優於或持平於同類閉源模型 。模型通過VAE加速、文本編碼器量化等技術,顯存優化顯著,視頻模型Video Lite支持12GB以上家用顯卡,而Image Lite作為輕量級圖生圖模型,推測顯存需求更低(8-12GB) 。推理速度方面,16步生成(NFE=16),在A100單卡上約5-10秒/圖 ,相比傳統擴散模型的50-100步大幅提速。

適用場景方面,Kandinsky 5.0特別適合需要多語言支持的領域,例如國際廣告設計、跨文化內容創作等,能夠同時處理俄語和英語指令,生成拉丁字母和西裏爾字母的文字 。實測案例顯示,它能精準生成"俄羅斯傳統節日場景+中文祝福語"等複雜設計,節省設計師80%的修圖時間 。此外,在教育領域,Kandinsky 5.0能將多語言教學內容轉化為視覺畫面,為國際化教育項目提供支持 。

用户評價方面,開發者普遍認可其多語言能力和高效推理,但認為其生態工具鏈不夠完善,需要自行開發適配模塊。同時,ComfyUI兼容性尚未完全解決,ControlNet插件支持有限,這是其當前的主要短板 。然而,隨着開源社區的持續貢獻,這些問題有望在短期內得到改善。

三、Qwen-Image:中文圖像生成的革命性突破

Qwen-Image由阿里通義千問團隊於2025年8月5日正式開源,成為首個專注於中文場景的圖生圖模型,填補了開源領域中文排版與文本渲染的技術空白 。該模型採用20B參數的MMDiT(多模態擴散Transformer)架構,整合Qwen2.5-VL文本編碼器和增強版VAE,支持複雜的中文排版(如海報、PPT)和精準圖像編輯 。模型開源後迅速登上Hugging Face趨勢榜雙榜第一,成為2025年最具影響力的開源視覺模型之一 。

技術架構上,Qwen-Image通過雙流編碼機制平衡語義一致性與視覺保真度,創新性地引入MSRoPE(多模態可縮放旋轉位置編碼)技術,使模型能夠精準處理文本位置指令(如"左上角添加文字"),解決傳統模型中文本與圖像位置混淆的問題 。模型採用多階段訓練範式,聯合訓練T2I(文本到圖像)、TI2I(文本-圖像到圖像)和I2I(圖像到圖像重建)任務,基於共享潛在空間實現跨模態對齊,顯著提升了文本渲染精度 。

性能表現方面,Qwen-Image原生模型支持1024×1024分辨率 ,在LongText-Bench基準測試中,中文長文本渲染準確率達89%,將複雜序列(如π≈3.1415926-53589793)的生成錯誤率控制在3%以內 。模型通過LoRA低秩適配技術,能夠實現風格定製,開發者僅需微調不到0.5%的參數即可創建專屬風格 。魔搭社區已聚集超過3000位創作者,發佈涵蓋古風插畫、UI設計、工業建模等28個類別的專項模型,形成繁榮的開源生態 。

Qwen-Image的部署門檻已大幅降低,通過LoRA微調可將顯存需求降至16GB,支持消費級顯卡運行 。模型已兼容ComfyUI框架,提供原生工作流,支持FP8與BF16兩種精度版本,兼顧性能與畫質 。同時,Qwen-Image提供多種變體:Qwen-Image-Base(基礎開發版)、Qwen-Image-Turbo(極速版)和Qwen-Image-Edit(圖像編輯版),分別針對不同需求場景優化 。

最引人注目的是Qwen-Image的LoRA微調生態,通過"知識蒸餾+LoRA低秩適配"的混合技術方案,開發者僅需微調不到0.5%的參數即可定製專屬風格 。在電商領域,Qwen-Image的API服務已被超過200家品牌採用,構建虛擬試衣間,使點擊率平均提升25% 。在教育領域,模型能根據"鸚鵡素描九宮格教程"指令,自主分解從輪廓到細節的教學步驟,使內容生產成本降低70% 。

四、Z-Image:輕量級大模型的普惠革命

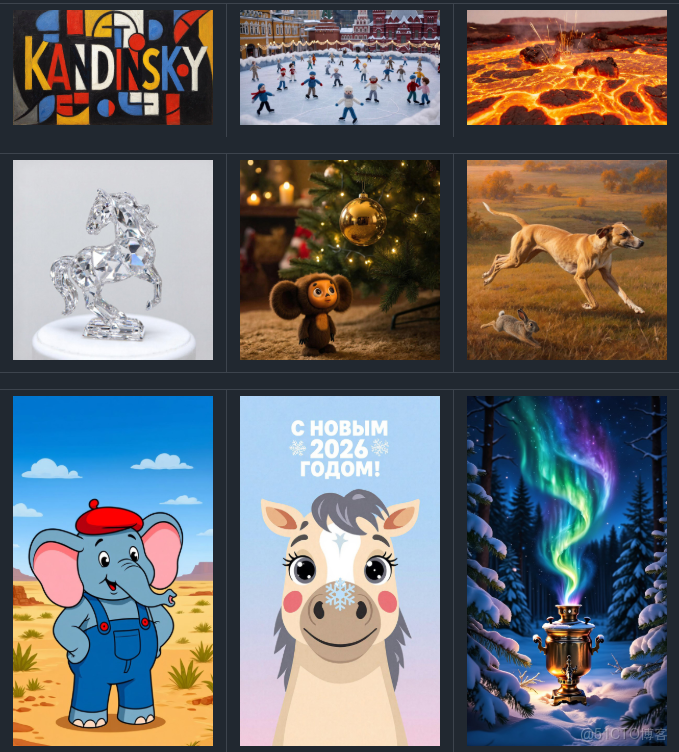

Z-Image由阿里巴巴通義實驗室於2025年11月28日發佈,迅速登頂Hugging Face趨勢榜雙榜第一,首日下載量達50萬次 ,成為2025年最具下載熱度的開源視覺模型之一。這款僅有6B參數的輕量模型,卻在視覺質量上接近20B級商業模型,為AI視覺生成帶來了性能、速度與普及度的三贏 。

技術架構上,Z-Image採用單流擴散Transformer(S³-DiT)架構,將文本、視覺語義token與圖像VAE token在序列層級拼接,相比雙流方案提升參數效率 。模型通過解耦DMD(分佈匹配蒸餾)與DMDR(強化學習增強)技術,實現了僅需8步採樣即可輸出高質量圖像的突破 ,同時支持Flash Attention和模型編譯等技術,進一步加速推理過程 。

在性能表現上,Z-Image-Turbo版本在H800 GPU上達到亞秒級推理延遲,消費級顯卡如RTX 3060或4070(16GB顯存)可流暢運行,甚至支持核顯用户通過在線Demo使用(需排隊等待) 。在AI Arena人工偏好評估中,Z-Image-Turbo的Elo評分達到開源模型最先進水平,特別在人像生成的皮膚紋理、場景構圖的空間關係處理上展現優勢 。中文海報的書法字體渲染錯誤率較基線模型下降63%,表明其在中文語義理解方面取得了顯著進步 。

Z-Image的部署門檻極低,16GB顯存即可運行,甚至支持核顯用户通過在線Demo使用(需排隊等待) 。模型已兼容ComfyUI框架,可直接導入使用,無需安裝第三方節點 ,大大簡化了部署流程。同時,Z-Image提供三種變體:Z-Image-Turbo(極速版)、Z-Image-Base(基礎開發版)和Z-Image-Edit(圖像編輯版),分別針對不同需求場景優化 。

最令人驚訝的是Z-Image的顯存優化能力,通過FP8量化技術,其Turbo版本可在僅8GB顯存的消費級顯卡上流暢運行 。這打破了高端圖像生成模型只能運行在A100等昂貴服務器顯卡上的慣例,讓普通開發者、設計師和研究人員在本地電腦上即可部署和使用最前沿的生成技術 。

在實測中,Z-Image展現出令人驚喜的性能表現。在考古現場紀錄片風格圖像生成測試中,雖然與Nano-Banana Pro相比在質感還原上稍顯不足,但與主流模型已能分庭抗禮 。人像生成測試中,三款模型均展現出優秀水準,但Z-Image更符合東方審美偏好,生成的人物面部細節清晰,光影自然均勻,幾乎沒有國產模型常見的"臉崩"問題 。

Z-Image在文本渲染上同樣表現出色,能夠穩定實現字形精準、排版工整。尤其在處理小字號、複雜排版或海報設計等高難度場景時,一級標題渲染效果自然,色彩、風格和排版都符合專業設計需求 。雖然在小字細節(如"港灣"、"故宮"等)上仍有提升空間,但整體文字處理能力已達到行業領先水平。

五、性能對比與用户選擇指南

從性能指標來看,三大開源圖生圖模型各有千秋:

|

模型名稱

|

分辨率支持

|

採樣步數

|

顯存需求

|

中文能力

|

開發難度

|

適用場景

|

|

Kandinsky 5.0

|

1408×1408

|

16步

|

16GB(最低,需量化卸載)/24GB(舒適運行)

|

中等

|

高

|

國際廣告設計、多語言內容創作

|

|

Qwen-Image

|

1024×1024

|

8-50步

|

16-42GB

|

頂尖

|

中

|

中文海報、電商產品圖、PPT設計

|

|

Z-Image

|

1024×1024

|

8步 35

|

8-16GB(Turbo/Base/Edit版本顯存需求會有差異)

|

優秀

|

低

|

日常創意設計、移動端部署

|

對於不同用户羣體,模型選擇建議如下:

消費級硬件用户:優先選擇Z-Image或Kandinsky 5.0,它們的部署門檻極低。Z-Image-Turbo在8GB顯存下即可運行,而Kandinsky 5.0 Image Lite需16GB以上顯存 。Z-Image的輕量化設計(6B參數)使其成為普通電腦用户的理想選擇,模型已兼容ComfyUI框架,部署簡單,適合快速上手 。特別是對於沒有獨立顯卡的用户,Z-Image-Turbo的在線Demo服務提供了"零門檻"體驗。

中文創意需求用户:Qwen-Image是唯一明確針對中文場景優化的開源圖生圖模型,其MSRoPE位置編碼技術使模型能夠精準處理文本位置指令,中文長文本渲染準確率達89% ,大幅領先同類模型。在電商海報、品牌宣傳等需要中文元素的場景中,Qwen-Image的表現尤為出色,支持豎排中文、公式排版等專業場景 ,為中文內容創作提供了強大工具。

多語言/國際化場景用户:Kandinsky 5.0是最佳選擇,其支持俄語和英語指令,能生成拉丁字母和西裏爾字母的文字 ,特別適合跨國廣告設計、教育插圖等需要多語言支持的場景。模型在人工評估中展現出卓越的視覺質量和構圖能力,適合需要高質量輸出的國際化項目。

開發者與研究者:三大模型都提供了完整的開源代碼和模型權重,但開發難度不同。Kandinsky 5.0基於Hugging Face的diffusers庫 ,需手動適配ComfyUI,對開發者技術要求較高,適合探索流匹配架構和多模態融合的前沿研究 。Qwen-Image提供LoRA微調教程和工具鏈,支持通過三行代碼注入LoRA模塊,訓練成本降低三分之二,適合中文場景定製和風格遷移研究 。Z-Image則採用Apache 2.0開源協議 ,提供完整的ComfyUI工作流和量化部署方案,適合快速驗證和集成 。

企業用户:Qwen-Image和Kandinsky 5.0均適合企業級應用,但路徑不同。Qwen-Image通過阿里雲PAI-EAS(彈性推理服務)提供API接口,支持毫秒級彈性擴容,輕鬆應對流量波動,適合廣告、電商等需要中文渲染的場景 。Kandinsky 5.0則需自行部署或通過火山引擎API接入,適合高分辨率視頻+圖像混合生成需求,但需自建基礎設施 。Z-Image則通過其極低的顯存需求(8GB起)和快速推理能力,成為中小企業的理想選擇 ,特別適合需要快速迭代和輕量化部署的項目。

六、開源圖生圖模型的未來發展趨勢

2025年的開源圖生圖模型不僅在技術上取得了突破,更在商業模式和生態建設上探索出新路徑。從技術趨勢來看,流匹配(Flow Matching)架構將成為繼擴散模型之後的新一代主流技術 ,Kandinsky 5.0的創新已引發廣泛討論。隨着流匹配技術的成熟,未來圖生圖模型的推理速度有望進一步提升,生成步驟可能從目前的16步進一步減少至8步以內,顯著降低計算成本。

多模態融合也是重要趨勢。Qwen-Image和Kandinsky 5.0均支持跨模態任務(如文本+圖像編輯、視頻生成),未來將形成更統一的多模態創作框架。Qwen-Image計劃擴展3D圖像生成、動態圖像編輯等功能,而Kandinsky 5.0則可能將視頻生成能力與圖像編輯深度整合 ,形成完整的創作工具鏈。隨着技術的演進,圖生圖模型將逐步從單一功能向全能創作助手轉變。

生態建設方面,LoRA模型生態和API服務將成為決定模型影響力的關鍵因素 。Qwen-Image的LoRA模型生態(ModelScope社區)和Stable Diffusion的ControlNet插件庫,形成開發者共創的活躍生態。未來,這些生態將更加繁榮,開發者只需通過簡單的API調用,即可實現從文本描述到圖像生成的端到端流程 ,進一步降低技術門檻。

從商業模式來看,開源模型正探索"基礎模型免費+增值服務收費"的模式 。Qwen-Image通過API調用實現盈利,提供彈性計費模式;Kandinsky 5.0則採用MIT協議 ,允許商業使用,但需自行部署;Z-Image同樣採用Apache協議 ,但通過更低的顯存需求和更快的推理速度,吸引開發者和中小企業。這種分層服務體系,使開源圖生圖技術能夠惠及從個人創作者到行業巨頭的全譜系用户 。

七、結語:開源圖生圖的普惠時代

2025年的開源圖生圖模型,從Kandinsky 5.0的多語言支持、Qwen-Image的中文排版優勢到Z-Image的輕量化設計,共同推動了AI圖像生成技術的民主化進程。這些模型不僅降低了創作門檻,更通過差異化定位滿足了從個人創作者到專業設計團隊的多樣化需求 。

對於普通用户而言,開源圖生圖模型使AI創作不再是遙不可及的黑科技,而是觸手可及的創意工具。隨着模型性能的不斷提升和部署門檻的持續降低 ,我們有望在2026年迎來AI圖像生成的全民普及時代。

對於開發者和研究者而言,開源模型提供了寶貴的實驗平台和創新基礎。通過微調和定製,這些模型可以適應特定行業的專業需求 ,如電商營銷、教育內容生產、影視分鏡設計等,創造巨大的商業價值。

開源與閉源的良性競爭,最終將推動整個AI圖像生成領域的發展 ,使技術更加成熟、應用更加廣泛。無論是追求極致畫質的專業創作者,還是需要快速生成創意的普通用户,都能在開源圖生圖模型中找到適合自己的工具,開啓AI輔助創作的新篇章。

未來,隨着邊緣計算和移動端部署技術的進步,開源圖生圖模型將在更多場景中發揮作用,如手機攝影構圖優化、AR/VR內容實時生成、智能車載系統交互界面等,成為數字內容創作的重要支柱。隨着API服務的普及和社區生態的繁榮 ,開源圖生圖模型將成為創意產業的核心基礎設施,推動全球視覺內容的高效生產與傳播。

在這場視覺生成的革命中,Kandinsky 5.0、Qwen-Image和Z-Image代表了不同的技術路線與生態策略,但共同目標是讓AI圖像生成技術更加普惠、高效和可控。作為開源社區的一員,我們有理由相信:未來屬於將美感、效率與責任深度融合的AI創造者。

最後,附上各模型的官方獲取鏈接,方便您快速體驗這些前沿技術:

- Kandinsky 5.0 Image Lite:https://huggingface.co/kandinskylab/kandinsky-5-image-lite

- Kandinsky 5.0 GitHub倉庫:https://github.com/kandinskylab/kandinsky-5

- Qwen-Image:https://huggingface.co/Qwen/Qwen-Image

- Qwen-Image GitHub倉庫:https://github.com/QwenLM/Qwen-Image

- Z-Image:https://huggingface.co/Tongyi-MAI/Z-Image-Turbo

- Z-Image GitHub倉庫:https://github.com/Tongyi-MAI/Z-Image

(注:部分模型需登錄Hugging Face賬號才能下載,且可能需要特定硬件配置才能獲得最佳體驗)