本人實測發現,本地配備的 16GB 顯存顯卡無法運行 LongCat-Image(龍貓圖片編輯)項目,即便開啓 CPU offloading(CPU 卸載)功能緩解顯存壓力,依然因顯存不足導致運行失敗。 為此,我在網上尋找共享算力資源,最終選擇租用 4090 顯卡進行測試,所使用的算力平台為【共績算力】(官網:https://www.gongjiyun.com/)。

值得一提的是,該平台對個人開發者提供免費算力申請的機會,降低了測試和開發的成本。

該平台創建雲主機的流程十分便捷,基礎鏡像已預裝Miniconda等開發必備軟件,無需額外配置基礎環境,極大節省了前期準備時間。考慮到需妥善保存項目數據,我額外開通了共享存儲卷並掛載至雲主機。不過結合兩次創建雲主機的實測體驗來看,共享存儲卷存在明顯短板——讀寫速度較慢;而云主機自帶的本地存儲則表現更優,讀寫效率顯著更高,建議大家根據實際需求選擇存儲方式。

登錄雲主機後,可直接參照 LongCat-Image 的官方倉庫(https://github.com/meituan-longcat/LongCat-Image)執行以下安裝步驟:

# 克隆項目倉庫(僅拉取main分支)

git clone --single-branch --branch main https://github.com/meituan-longcat/LongCat-Image

cd LongCat-Image

# 創建並激活conda虛擬環境(指定Python 3.10版本)

conda create -n longcat-image python=3.10

conda activate longcat-image

# 安裝項目依賴並以開發模式安裝項目

pip install -r requirements.txt

python setup.py develop

# 配置Hugging Face鏡像並下載模型權重

pip install "huggingface_hub[cli]"

export HF_ENDPOINT=https://hf-mirror.com

huggingface-cli download meituan-longcat/LongCat-Image-Edit --local-dir ./weights/LongCat-Image-Edit環境配置完成後,運行示例腳本進行圖片編輯測試:

python scripts/inference_edit.py需要説明的是,項目代碼中已內置CPU offloading機制,核心代碼如下,其作用是將部分模型權重卸載至CPU,以此降低顯存佔用、避免出現OOM(顯存溢出)錯誤:

pipe.enable_model_cpu_offload() # Offload to CPU to save VRAM (Required ~19 GB); slower but prevents OOM

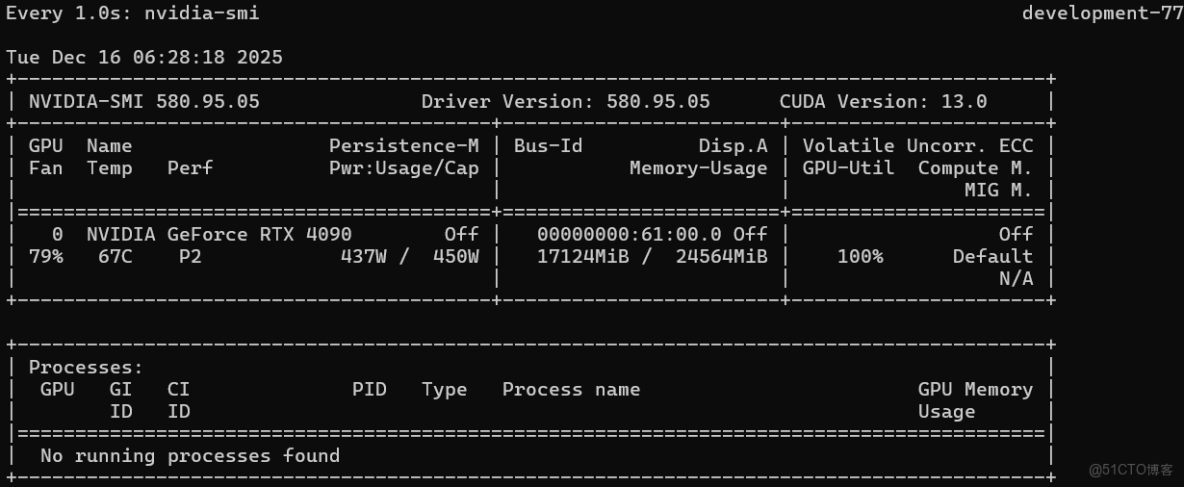

generator = torch.Generator("cpu").manual_seed(43)即便開啓了該優化機制,實測運行過程中顯卡顯存峯值佔用仍達約17GB。這也印證了本地16GB顯存顯卡無法運行的核心原因——顯存容量不足;而4090顯卡的24GB顯存,恰好能滿足項目穩定運行的需求。

以下為本次測試的實際效果對比: demo中編輯前的原圖:

經過LongCat-Image編輯實現將“車換成摩托車”後的效果:

從編輯效果來看,整體表現十分出色:不僅成功實現了“車換摩托車”的核心需求,細節處理也相當到位,就連陰影部分都還原得自然逼真,沒有出現明顯的違和感。