數據庫監控與運維自動化:從被動救火到主動防禦

2025年凌晨3點,某電商平台數據庫突然宕機,運維團隊花了4小時才恢復服務,直接損失超百萬。事後排查發現,其實系統早在2小時前就出現了磁盤IO異常,但傳統監控工具未能及時預警。這個真實案例告訴我們:沒有監控的數據庫就像沒有儀表盤的飛機,而不會自動化運維的DBA,終將被重複工作淹沒。

今天我們將學習如何搭建全方位的數據庫監控體系,用自動化工具解放雙手,讓數據庫運維從"災後救火"升級為"主動防禦"。

監控指標體系:給數據庫裝個"體檢儀"

想象你去醫院體檢,醫生會測血壓、心率、血常規等指標。數據庫監控也是同樣道理,需要從性能、可用性、安全三個維度建立指標體系。

性能指標:數據庫的"心率血壓"

CPU使用率是最基礎的指標,MySQL的CPU消耗主要來自SQL解析和數據排序。正常情況下應低於70%,如果持續高於80%,就要檢查是否有慢查詢。可以通過show global status like 'CPU%'命令查看,或使用top命令觀察mysqld進程的CPU佔用。

內存使用方面,重點關注InnoDB Buffer Pool命中率,理想值應高於99%。計算公式為:(1 - (Innodb_buffer_pool_reads / Innodb_buffer_pool_read_requests)) * 100%。如果命中率低於95%,説明內存不足,需要調大innodb_buffer_pool_size參數。

磁盤IO是最容易出現瓶頸的環節。iostat -x 1命令能實時顯示磁盤吞吐量(kB_read/s、kB_wrtn/s)和響應時間(await)。MySQL的寫入性能還可以通過Innodb_data_writes和Innodb_data_write_requests計算平均每次寫入大小,判斷是否開啓了批量寫入優化。

連接數監控也很關鍵。max_connections參數決定了最大併發連接數,通過show status like 'Threads_connected'查看當前連接數,當接近閾值80%時就需要擴容了。同時要警惕Threads_running數值過高,這通常意味着有大量長事務阻塞。

可用性指標:業務連續性的"晴雨表"

數據庫 uptime是最直觀的可用性指標,通過show global status like 'Uptime'獲取,單位是秒。企業級數據庫要求每年可用性達到99.99%,意味着每年允許的 downtime 不能超過52.56分鐘。

主從複製延遲對讀寫分離架構至關重要。在從庫執行show slave status,關注Seconds_Behind_Master值,正常應小於10秒。延遲過大可能導致讀數據不一致,嚴重時需要檢查網絡帶寬或優化從庫SQL線程。

QPS/TPS反映數據庫的整體負載能力。QPS(每秒查詢數)計算公式:Questions / Uptime;TPS(每秒事務數)計算公式:(Com_commit + Com_rollback) / Uptime。這兩個指標需要結合業務峯值設置告警閾值。

安全指標:數據防護的"防火牆"

用户權限審計是安全監控的基礎。定期執行select user,host,privilege from mysql.user檢查是否存在超權限賬號,特別是%主機權限和FILE、SUPER等危險權限。

慢查詢日誌不僅影響性能,還可能泄露敏感信息。通過show variables like 'slow_query_log'確認慢查詢日誌已開啓,long_query_time建議設為1秒,定期分析日誌中的全表掃描語句。

連接來源監控能及時發現異常訪問。show processlist命令可查看當前連接的IP和執行語句,配合防火牆設置IP白名單,拒絕來自未知IP的連接請求。

自動化運維工具:讓機器替你幹活

當數據庫服務器數量超過5台,手動運維就會變得力不從心。自動化運維工具能幫我們批量執行命令、配置管理和狀態監控,目前最流行的是Ansible和Puppet。

Ansible:無代理的自動化神器

Ansible的最大優勢是無需在目標機器安裝代理,通過SSH協議通信,非常適合管理分散的數據庫服務器。它使用YAML格式的Playbook定義操作流程,例如下面這個批量部署MySQL配置文件的Playbook:

- name: 部署MySQL配置文件

hosts: db_servers

tasks:

- name: 複製配置文件

copy:

src: ./my.cnf

dest: /etc/my.cnf

mode: 0644

owner: mysql

group: mysql

notify:

- restart mysql

handlers:

- name: restart mysql

service:

name: mysqld

state: restartedAnsible的模塊非常豐富,mysql_db模塊可以管理數據庫,mysql_user模塊維護用户權限,command模塊執行SQL語句。例如創建數據庫和用户的任務:

- name: 創建應用數據庫

mysql_db:

name: appdb

state: present

login_user: root

login_password: "{{ root_password }}"

- name: 創建應用用户

mysql_user:

name: appuser

password: "{{ app_password }}"

priv: 'appdb.*:ALL'

host: '%'

state: presentPuppet:基於聲明式的配置管理

Puppet採用聲明式語法,你只需描述系統應該達到的狀態,Puppet會自動計算如何實現。它需要在服務端和客户端都安裝代理程序,適合管理大規模服務器集羣。

一個管理MySQL服務的Puppet Manifest文件(mysql.pp)如下:

class mysql {

package { 'mysql-server':

ensure => installed,

}

service { 'mysqld':

ensure => running,

enable => true,

require => Package['mysql-server'],

}

file { '/etc/my.cnf':

source => 'puppet:///modules/mysql/my.cnf',

owner => 'mysql',

group => 'mysql',

mode => '0644',

require => Package['mysql-server'],

notify => Service['mysqld'],

}

}

include mysqlPuppet的優勢在於配置漂移檢測,會定期檢查客户端配置是否符合預期,自動修復偏差。這對數據庫配置標準化非常有價值,確保所有實例使用統一的優化參數。

工具選擇建議

中小規模環境(1-20台服務器)優先選擇Ansible,部署簡單,學習成本低;大規模環境(20台以上)推薦Puppet,有更強大的版本控制和報告功能。兩者都支持與監控系統集成,實現故障自動修復。

日誌管理與分析:數據庫的"黑匣子"

飛機的黑匣子記錄所有飛行數據,數據庫日誌也是排查問題的關鍵依據。MySQL有多種日誌,需要建立集中化的日誌管理系統。

日誌類型與配置

錯誤日誌(Error Log)記錄啓動、關閉和嚴重錯誤,配置:

log_error = /var/log/mysql/error.log

log_warnings = 2 # 記錄所有警告二進制日誌(Binary Log)記錄數據變更,用於主從複製和時間點恢復,配置:

server-id = 1

log_bin = /var/log/mysql/mysql-bin.log

expire_logs_days = 7 # 自動清理7天前的日誌

binlog_format = row # 基於行的複製更安全慢查詢日誌(Slow Query Log)記錄執行時間長的SQL,配置:

slow_query_log = 1

slow_query_log_file = /var/log/mysql/slow.log

long_query_time = 1 # 超過1秒的查詢

log_queries_not_using_indexes = 1 # 記錄未使用索引的查詢日誌集中管理方案

單台服務器的日誌可以通過tail、grep命令查看,但多實例環境需要集中管理。推薦使用ELK Stack(Elasticsearch+Logstash+Kibana):

- Logstash作為日誌收集器,通過file插件讀取MySQL日誌文件,grok插件解析日誌格式:

input {

file {

path => "/var/log/mysql/slow.log"

start_position => "beginning"

sincedb_path => "/dev/null"

}

}

filter {

grok {

match => { "message" => "Query_time: %{NUMBER:query_time:float}\s+Lock_time: %{NUMBER:lock_time:float}\s+Rows_sent: %{NUMBER:rows_sent:int}\s+Rows_examined: %{NUMBER:rows_examined:int}\s+use %{WORD:database};\s+SET timestamp=%{NUMBER:timestamp};\s+%{GREEDYDATA:sql}" }

}

}

output {

elasticsearch {

hosts => ["localhost:9200"]

index => "mysql-slowlog-%{+YYYY.MM.dd}"

}

}- Elasticsearch存儲日誌數據,提供全文檢索能力。

- Kibana創建可視化儀表盤,展示慢查詢趨勢、TOP SQL等指標。

日誌分析實戰技巧

慢查詢分析常用工具是mysqldumpslow和pt-query-digest。例如找出執行次數最多的慢查詢:

pt-query-digest /var/log/mysql/slow.log | head -n 30二進制日誌分析可以確定數據變更時間點:

mysqlbinlog --start-datetime="2025-01-01 00:00:00" /var/log/mysql/mysql-bin.000001定期日誌分析能幫我們發現:

- 頻繁執行的低效率SQL(例如未加索引的查詢)

- 異常的數據刪除或更新操作

- 數據庫連接來源異常的IP地址

常見故障處理流程:從發現到恢復的標準化

數據庫故障處理就像醫院急診,需要標準化流程才能提高效率。以下是五大常見故障的處理步驟:

連接數爆滿故障

現象:應用報"Too many connections"錯誤,Threads_connected接近max_connections。

應急處理:

- 立即登錄數據庫:mysql -u root -p -h 127.0.0.1(本地登錄不受連接數限制)

- 查看連接列表:show full processlist

- 終止空閒連接:kill [ID](優先終止Sleep狀態超過300秒的連接)

- 臨時調大連接數:set global max_connections=2000

根本解決:

- 優化應用連接池配置,設置合理的maxActive和minIdle

- 增加wait_timeout和interactive_timeout,減少連接創建頻率

- 檢查是否有連接未釋放的代碼bug

主從複製中斷

現象:show slave status顯示Slave_IO_Running: No或Slave_SQL_Running: No。

IO線程中斷處理:

- 檢查錯誤信息:Last_IO_Error: ...

- 常見原因:網絡不通、主庫binlog文件損壞、從庫權限不足

- 修復命令:stop slave io_thread; start slave io_thread;

SQL線程中斷處理:

- 檢查錯誤信息:Last_SQL_Error: ...

- 常見原因:主鍵衝突、表結構不一致、權限不足

- 跳過錯誤(緊急情況):set global sql_slave_skip_counter=1; start slave sql_thread;

- 數據修復:用主庫備份恢復從庫,重新搭建複製

慢查詢風暴

現象:CPU使用率突然飆升,QPS下降,大量會話處於"Sending data"狀態。

處理步驟:

- 找出TOP SQL:show processlist按Time排序

- 終止慢查詢:kill [ID](注意不要批量kill所有會話)

- 臨時方案:set global slow_query_log=ON記錄慢查詢

- 優化SQL:添加索引、改寫SQL、限制返回行數

預防措施:

- 上線前SQL評審,禁止全表掃描

- 設置max_execution_time限制查詢執行時間

- 對大表查詢實施分片或分頁

數據誤刪除

現象:執行了錯誤的DELETE或DROP語句,數據丟失。

恢復流程:

- 立即停止應用寫入:flush tables with read lock;(防止數據被覆蓋)

- 確定刪除時間點:通過binlog找到誤操作SQL的position

- 時間點恢復:mysqlbinlog --start-position=xxx --stop-position=yyy mysql-bin.000001 | mysql -u root -p

- 驗證數據:對比恢復前後的數據量

預防措施:

- 開啓binlog,使用row格式

- 重要操作前備份,例如:create table t_backup as select * from t where ...

- 對delete/update語句強制要求where條件,最好通過工具執行

磁盤空間滿

現象:寫入數據時報"Disk full"錯誤,df -h顯示磁盤使用率100%。

應急處理:

- 找出大文件:du -sh /var/log/mysql/*

- 臨時清理:刪除舊的binlog(注意保留最新的幾個)、壓縮慢查詢日誌

- 擴展空間:添加磁盤或調整分區

長期優化:

- 設置binlog自動過期:expire_logs_days=7

- 實施日誌輪轉:配置logrotate切割MySQL日誌

- 監控磁盤增長趨勢,提前擴容

自動化備份與恢復:數據安全的"保險繩"

數據備份是數據庫運維的最後一道防線,必須實現全自動化,杜絕人為疏忽。

備份策略設計

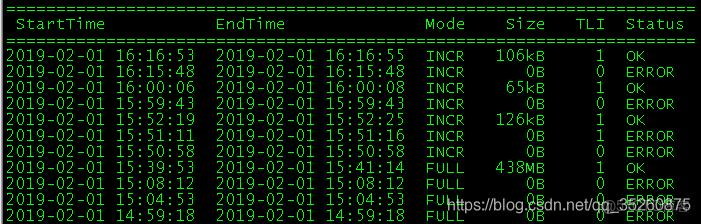

全量+增量+binlog的三級備份策略能兼顧恢復速度和數據完整性:

- 全量備份:每週日凌晨3點執行,使用mysqldump:

mysqldump -u root -p --single-transaction --master-data=2 --all-databases | gzip > /backup/full_$(date +%Y%m%d).sql.gz參數説明:

- --single-transaction:InnoDB熱備份

- --master-data=2:記錄binlog位置信息(不註釋)

- --all-databases:備份所有數據庫

- 增量備份:每天凌晨3點執行,備份binlog:

mysqladmin -u root -p flush-logs

cp /var/log/mysql/mysql-bin.00000[1-9] /backup/increment/- binlog備份:實時備份,通過腳本監控binlog文件生成

自動化備份腳本

使用Bash腳本實現備份自動化,並添加日誌和校驗:

#!/bin/bash

BACKUP_DIR="/backup"

DATE=$(date +%Y%m%d)

FULL_BACKUP_FILE="$BACKUP_DIR/full_$DATE.sql.gz"

LOG_FILE="$BACKUP_DIR/backup_$DATE.log"

# 全量備份

echo "[$(date +'%Y-%m-%d %H:%M:%S')] Starting full backup..." >> $LOG_FILE

mysqldump -u root -p"$DB_PASSWORD" --single-transaction --master-data=2 --all-databases | gzip > $FULL_BACKUP_FILE

# 檢查備份是否成功

if [ $? -eq 0 ]; then

echo "[$(date +'%Y-%m-%d %H:%M:%S')] Full backup completed: $FULL_BACKUP_FILE" >> $LOG_FILE

# 計算MD5校驗值

md5sum $FULL_BACKUP_FILE > "$FULL_BACKUP_FILE.md5"

else

echo "[$(date +'%Y-%m-%d %H:%M:%S')] Full backup failed!" >> $LOG_FILE

# 發送告警郵件

mail -s "MySQL Backup Failed" admin@example.com < $LOG_FILE

exit 1

fi

# 清理7天前的備份

find $BACKUP_DIR -name "full_*.sql.gz" -mtime +7 -delete

find $BACKUP_DIR -name "backup_*.log" -mtime +30 -delete將腳本添加到crontab:

0 3 * * 0 /usr/local/bin/mysql_full_backup.sh # 每週日3點全量備份

0 3 * * 1-6 /usr/local/bin/mysql_increment_backup.sh # 工作日3點增量備份備份恢復演練

備份不是目的,能恢復才是關鍵。每月應進行一次恢復演練:

- 恢復測試步驟:

# 創建測試目錄

mkdir /tmp/restore_test

cd /tmp/restore_test

# 解壓全量備份

gunzip < /backup/full_20250101.sql.gz | mysql -u root -p test

# 應用增量binlog

mysqlbinlog /backup/increment/mysql-bin.000002 | mysql -u root -p test

# 驗證數據

mysql -u root -p -e "select count(*) from test.users"- 恢復時間目標(RTO)測試:記錄從開始恢復到業務可用的總時間,企業級要求RTO<4小時。

- 恢復點目標(RPO)測試:檢查恢復後的數據是否包含最後一次增量備份的數據,確保數據丟失量<RPO(通常要求<5分鐘)。

實踐任務:從零搭建自動化運維體系

理論學習後,通過以下實踐鞏固今天的知識點:

任務1:部署Prometheus+Grafana監控

- 安裝Prometheus:

wget https://github.com/prometheus/prometheus/releases/download/v2.45.0/prometheus-2.45.0.linux-amd64.tar.gz

tar xzf prometheus-2.45.0.linux-amd64.tar.gz

cd prometheus-2.45.0.linux-amd64- 配置prometheus.yml:

scrape_configs:

- job_name: 'mysql'

static_configs:

- targets: ['localhost:9104'] # mysqld_exporter地址- 安裝mysqld_exporter:

wget https://github.com/prometheus/mysqld_exporter/releases/download/v0.14.0/mysqld_exporter-0.14.0.linux-amd64.tar.gz

tar xzf mysqld_exporter-0.14.0.linux-amd64.tar.gz- 創建.my.cnf:

[client]

user=exporter

password=exporter_password

host=localhost- 啓動exporter:

./mysqld_exporter --config.my-cnf=.my.cnf &任務2:編寫Ansible自動化腳本

- 創建inventory文件:

[db_servers]

db1 ansible_host=192.168.1.101

db2 ansible_host=192.168.1.102- 編寫數據庫備份Playbook(backup.yml):

- name: MySQL Backup

hosts: db_servers

gather_facts: no

tasks:

- name: Create backup directory

file:

path: /backup

state: directory

mode: 0755

- name: Dump database

mysql_db:

state: dump

name: all

target: /backup/full_{{ ansible_date_time.date }}.sql

login_user: root

login_password: "{{ mysql_root_password }}"

- name: Compress backup

archive:

path: /backup/full_{{ ansible_date_time.date }}.sql

dest: /backup/full_{{ ansible_date_time.date }}.sql.gz

format: gz

- name: Delete uncompressed file

file:

path: /backup/full_{{ ansible_date_time.date }}.sql

state: absent- 執行Playbook:

ansible-playbook -i inventory backup.yml --extra-vars "mysql_root_password=your_password"任務3:配置自動化備份與恢復

- 編寫備份腳本(參考上文)並添加到crontab

- 故意刪除一張測試表的數據

- 使用binlog進行時間點恢復

- 編寫恢復驗證腳本,檢查數據一致性

總結:邁向智能化運維

今天我們系統學習了數據庫監控指標體系、自動化運維工具、日誌管理、故障處理和備份恢復五大模塊。從被動響應到主動監控,從手動操作到自動化腳本,這是每個DBA成長的必經之路。

記住:最好的運維是不需要運維。未來的數據庫運維將向AIOps方向發展,通過機器學習預測性能瓶頸,自動生成優化建議。但在此之前,紮實掌握今天所學的基礎技能,才能在數據庫出問題時臨危不亂。

明天是MySQL 21天學習計劃的最後一天,我們將學習數據庫架構演進和性能優化實戰,為整個課程畫上圓滿句號。保持好奇心,持續學習,你就能成為一名優秀的數據庫工程師!