前言

本文聚焦國內領先大模型服務評測與聚合平台AI Ping最新上線的兩款旗艦模型——GLM-4.7與MiniMax M2.1,深度解析二者核心定位與差異:GLM-4.7側重複雜工程任務一次性交付與Agentic Coding場景;MiniMax M2.1專攻長鏈Agent執行,強化多語言工程能力與持續運行效率。

( )

目錄

一、旗艦模型詳解:GLM-4.7 vs MiniMax M2.1

1.1 GLM-4.7:Agentic Coding先鋒,複雜工程交付專家

1.1.1 GLM-4.7簡介

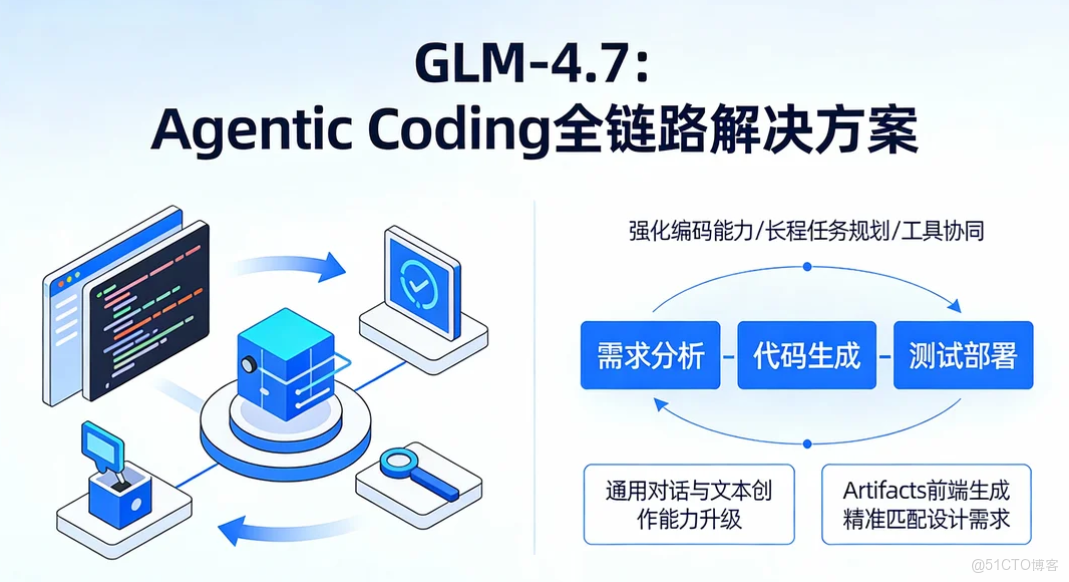

- GLM-4.7是智譜AI推出的最新旗艦模型,專為Agentic Coding場景量身打造,核心強化編碼能力、長程任務規劃與工具協同能力,依託可控推理機制,實現複雜工程任務的穩定、高效交付。

- GLM-4.7是智譜AI推出的新一代旗艦模型,核心定位為“Agentic Coding全鏈路解決方案”,專為複雜工程場景的一次性落地設計。

- 模型通過強化編碼能力、長程任務規劃與工具協同機制,搭配可控推理框架,可實現從需求分析到代碼生成、測試部署的全流程自主完成。

- 在基礎能力層面,GLM-4.7的通用對話與文本創作能力全面升級,回覆邏輯更清晰、語言更自然;在專業場景中,其指令遵循度大幅提升,尤其在Artifacts前端生成領域,可精準匹配設計需求,生成的界面代碼兼具美觀度與可複用性。

1.1.2 與MiniMax M2.1的核心差異

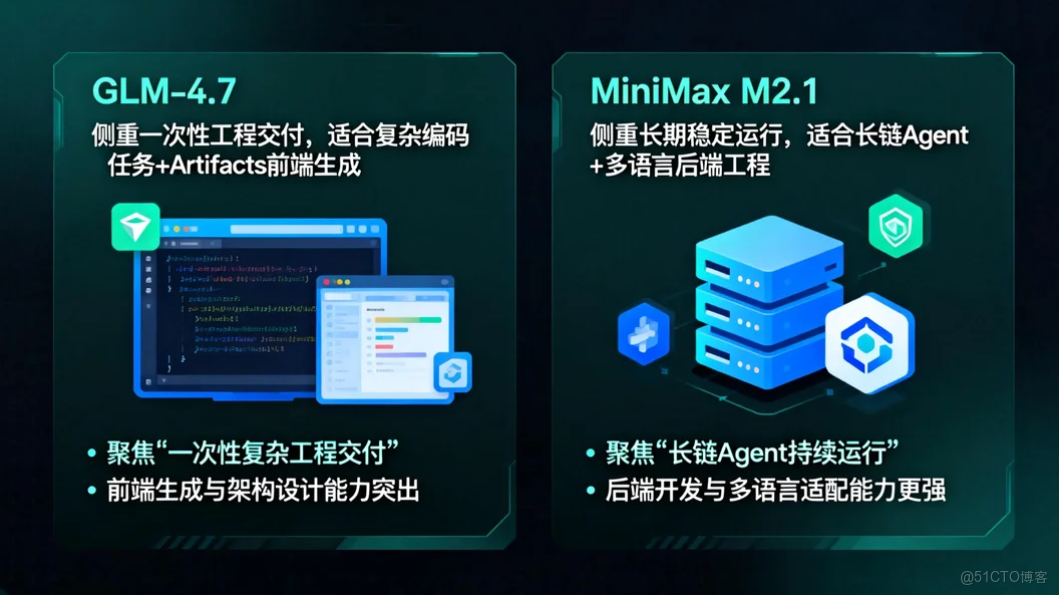

- GLM-4.7:側重一次性工程交付,適合複雜編碼任務 + Artifacts前端生成;

- MiniMax M2.1:側重長期穩定運行,適合長鏈Agent + 多語言後端工程。

- GLM-4.7:以“一次性交付”為核心,擅長複雜編碼任務拆解與前端界面生成,適合項目初始化、核心架構落地等場景;

- MiniMax M2.1:以“長期穩定運行”為核心,強化多語言後端開發與長鏈任務執行,適合Agent工作流搭建、持續迭代優化等場景。

1.1.3 GLM-4.7實測數據

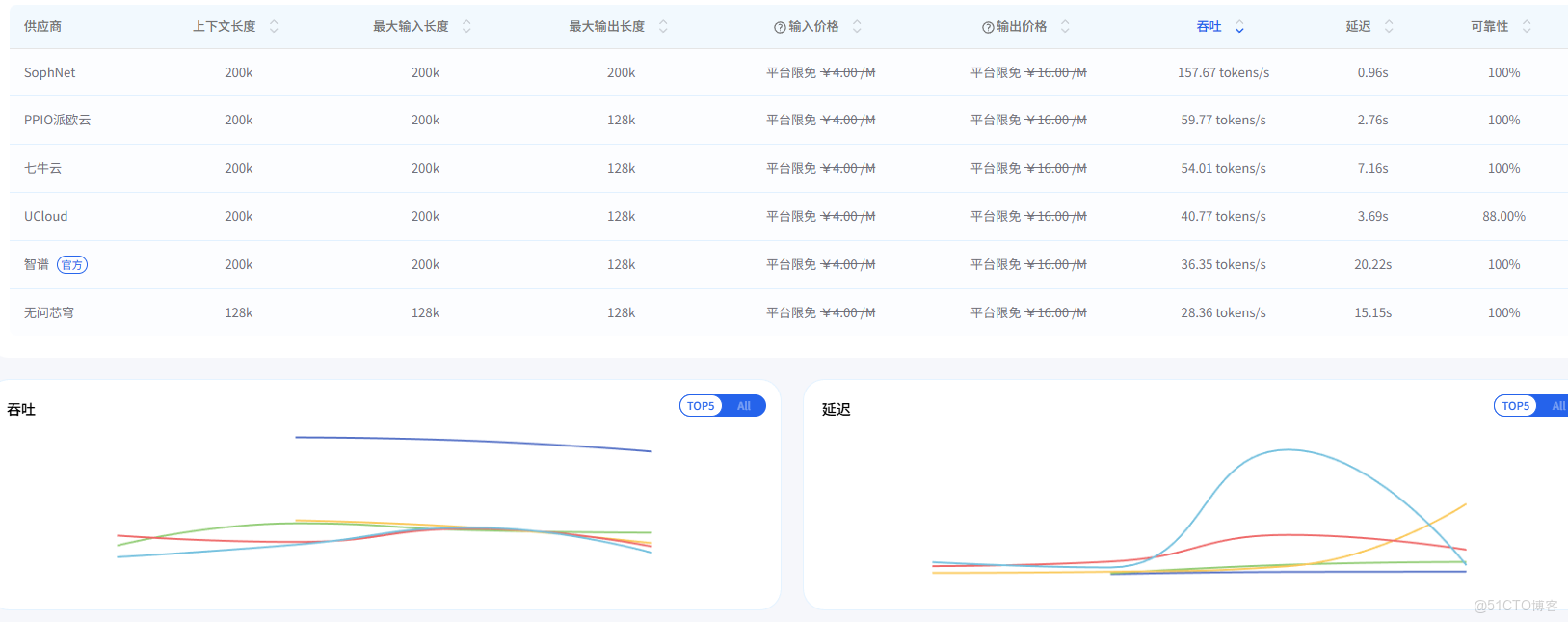

以下為AI Ping平台實測數據(數據截至2025年12月23日18:00),客觀呈現模型真實性能:基於AI Ping標準化評測體系,我們對GLM-4.7進行了全場景實測(數據截至2025年12月23日18:00),核心性能表現如下,所有數據均可在平台實時查看驗證:

1.1.4 GLM-4.7調用方式

AI Ping提供統一OpenAI兼容接口,調用流程簡單便捷,具體代碼如下:AI Ping為GLM-4.7提供統一的OpenAI兼容接口,無需額外適配開發,獲取API Key後即可快速調用,具體流程與代碼示例如下:

from openai import OpenAI

openai_client = OpenAI(

base_url="https://www.aiping.cn/api/v1",

api_key="***", # 替換為你的AI Ping API KEY

)

response = openai_client.chat.completions.create(

model="GLM-4.7",

stream=True,

extra_body={

"provider": {

"only": [],

"order": [],

"sort": None,

"input_price_range": [],

"output_price_range": [],

"input_length_range": [],

"throughput_range": [],

"latency_range": []

}

},

messages=[

{"role": "user", "content": "Hello"}

]

)

for chunk in response:

if not getattr(chunk, "choices", None):

continue

reasoning_content = getattr(chunk.choices[0].delta, "reasoning_content", None)

if reasoning_content:

print(reasoning_content, end="", flush=True)

content = getattr(chunk.choices[0].delta, "content", None)

if content:

print(content, end="", flush=True)

1.2 MiniMax M2.1:長鏈Agent利器,多語言工程強者

1.2.1 MiniMax M2.1簡介

- MiniMax M2.1是MiniMax推出的最新旗艦模型,聚焦長鏈Agent執行場景,核心強化多語言工程能力、持續運行效率與收斂推理路徑。

- 依託高效MoE架構,實現吞吐與穩定性的出色平衡,為長期Agent工作流提供堅實支撐。MiniMax M2.1是MiniMax團隊面向企業級Agent場景推出的旗艦模型,核心優勢在於“長鏈任務執行效率”與“多語言工程適配性”。

- 模型採用高效MoE架構,在保障高吞吐的同時降低資源消耗,可穩定支撐長時間運行的Agent工作流。

- 模型強化了Rust/Go/Java/C++等8種生產級代碼的支持能力,對Android/iOS原生開發與Web可視化開發適配更完善;在長時間Agent工作流執行中,推理路徑更收斂、工具調用更高效,憑藉低激活參數與200k長上下文優勢,連續編碼與持續運行吞吐進一步提升。

1.2.2 與GLM-4.7的核心差異

- GLM-4.7:側重一次性工程交付,適合複雜編碼任務 + Artifacts前端生成;

- MiniMax M2.1:側重長期穩定運行,適合長鏈Agent + 多語言後端工程。

- GLM-4.7:聚焦“一次性複雜工程交付”,前端生成與架構設計能力突出;

- MiniMax M2.1:聚焦“長鏈Agent持續運行”,後端開發與多語言適配能力更強。

1.2.3 MiniMax M2.1實測數據

以下為AI Ping平台實測數據(數據截至2025年12月23日18:00),客觀呈現模型真實性能:基於AI Ping標準化評測體系,我們對MiniMax M2.1進行了全場景實測(數據截至2025年12月23日18:00),核心性能表現如下,所有數據均可在平台實時查看驗證:

1.2.4 MiniMax M2.1調用方式

同樣支持統一OpenAI兼容接口,調用代碼如下:MiniMax M2.1同樣支持AI Ping統一的OpenAI兼容接口,調用流程與GLM-4.7一致,僅需修改模型名稱參數,具體代碼示例如下:

from openai import OpenAI

openai_client = OpenAI(

base_url="https://www.aiping.cn/api/v1",

api_key="***", # 替換為你的AI Ping API KEY

)

response = openai_client.chat.completions.create(

model="MiniMax-M2.1",

stream=True,

extra_body={

"provider": {

"only": [],

"order": [],

"sort": None,

"input_price_range": [],

"output_price_range": [],

"input_length_range": [],

"throughput_range": [],

"latency_range": []

}

},

messages=[

{"role": "user", "content": "Hello"}

]

)

for chunk in response:

if not getattr(chunk, "choices", None):

continue

reasoning_content = getattr(chunk.choices[0].delta, "reasoning_content", None)

if reasoning_content:

print(reasoning_content, end="", flush=True)

content = getattr(chunk.choices[0].delta, "content", None)

if content:

print(content, end="", flush=True)

二、選型指南:如何精準匹配GLM-4.7與MiniMax M2.1?

GLM-4.7與MiniMax M2.1均為旗艦級模型,但定位和適用場景差異明顯。結合AI Ping實測數據與場景適配性分析,為你整理了詳細的選型指南:GLM-4.7與MiniMax M2.1雖同屬旗艦級模型,但核心定位與場景適配性差異顯著。結合AI Ping實測數據與大量項目落地經驗,我們整理了清晰的選型指南,幫助開發者快速匹配最優模型:

2.1 核心差異對比

示此內容從核心能力、架構特性、場景適配、成本表現四大維度,對兩款模型進行全面對比:

2.2 場景選型決策表

此內容針對不同業務場景,明確最優模型選擇及核心依據:

2.3 快速決策流程圖

是否需要生成前端/UI?

- 是 → GLM-4.7

- 否 → 是否涉及Rust/Go/Java/C++等後端語言?

- 是 → MiniMax M2.1

- 否 → 任務是否需要長時間持續運行?

- 是 → MiniMax M2.1

- 否 → 是否需要一次性完成複雜工程交付?

- 是 → GLM-4.7

- 否 → 兩者均可,按個人偏好選擇

- 是 → GLM-4.7

- 否 → 是否涉及Rust/Go/Java/C++等後端語言?

- 是 → MiniMax M2.1

- 否 → 任務是否需要長時間持續運行?

- 是 → MiniMax M2.1

- 否 → 是否需要一次性完成複雜工程交付?

- 是 → GLM-4.7

- 否 → 兩者均可,按個人偏好選擇

2.4 組合使用建議

對於大型複雜項目,推薦組合使用兩款模型,實現優勢互補:對於大型複雜項目,單一模型難以覆蓋全流程需求,推薦組合使用GLM-4.7與MiniMax M2.1,實現優勢互補,提升項目落地效率:

- GLM-4.7:負責項目初始化、核心架構設計、前端界面生成等一次性複雜工程交付任務;

- MiniMax M2.1:負責後端邏輯實現、長鏈業務流程搭建、持續迭代優化等長期運行任務。

- GLM-4.7:負責項目初始化階段的需求分析、核心架構設計、前端界面生成,快速完成原型落地;

- MiniMax M2.1:負責項目迭代階段的後端邏輯實現、長鏈業務流程搭建、Agent工具集成,保障長期穩定運行。

三、使用GLM-4.7實戰演示:獲取API KEY與平台使用指南

以GLM-4.7模型為例接入它的API進行測試模型為例,演示從選型到調用的步驟:

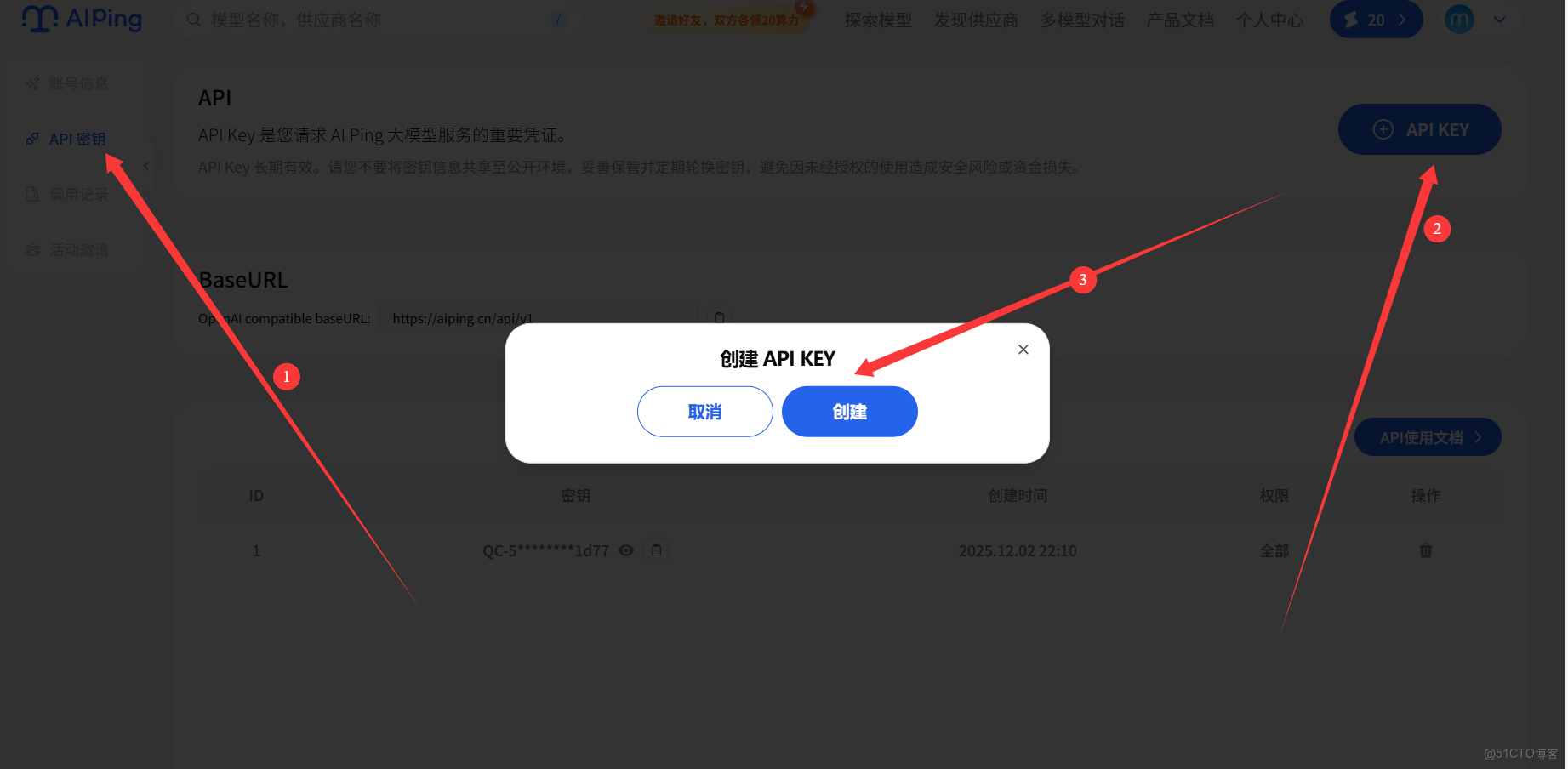

3.1 步驟1:創建API密鑰

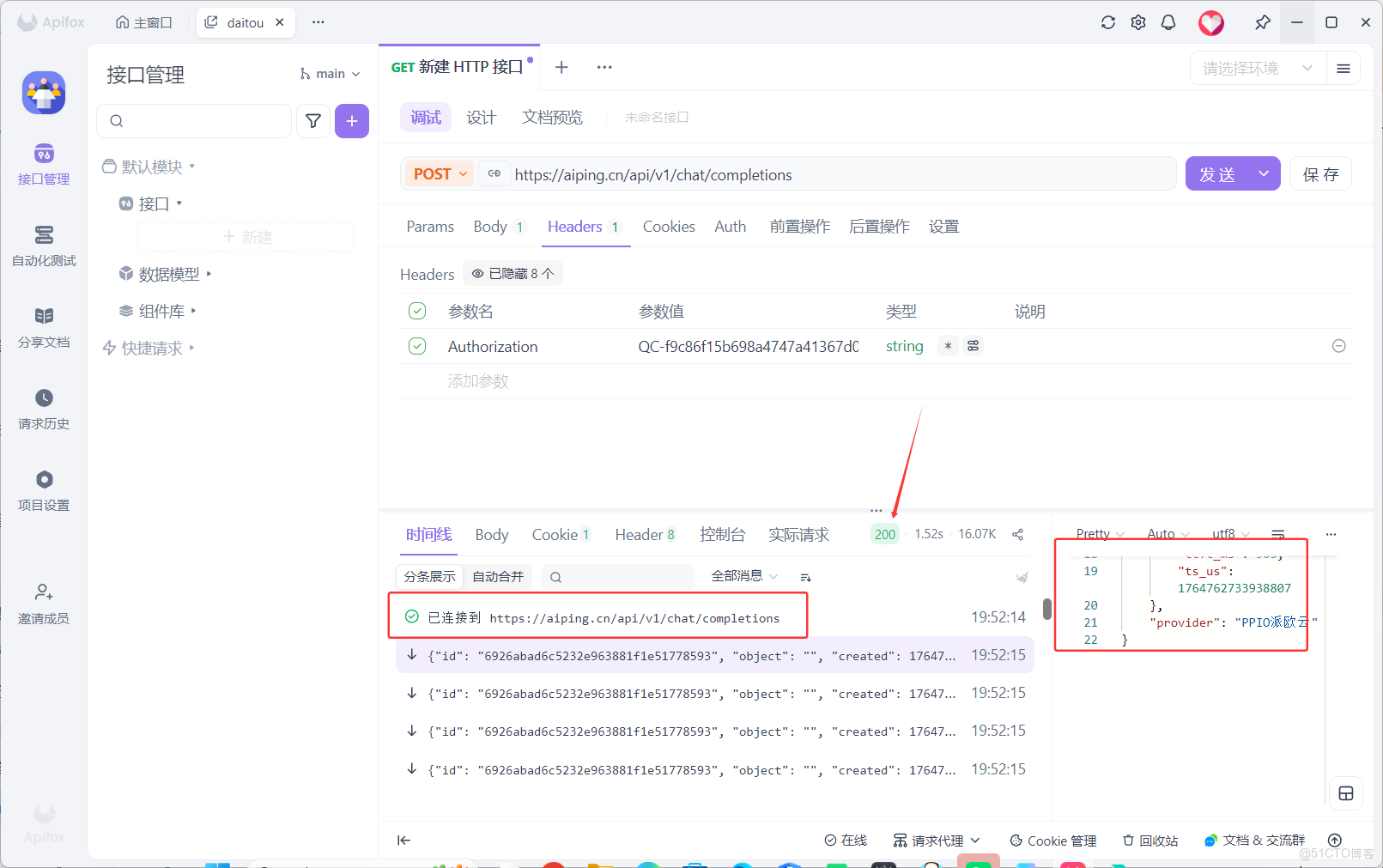

創建之後如圖所示:

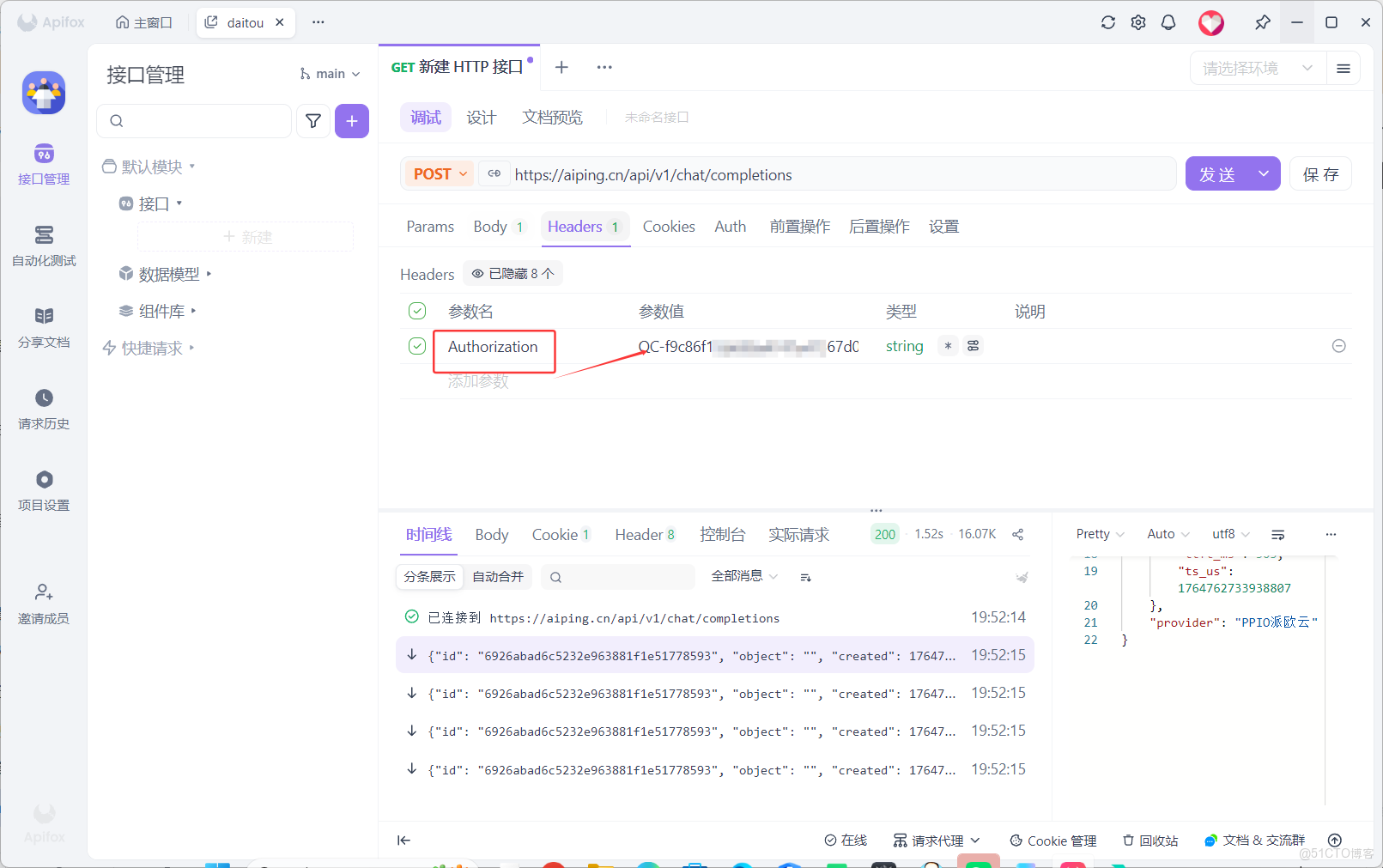

將其複製到ApifoxHeaders處,選擇 Authorization

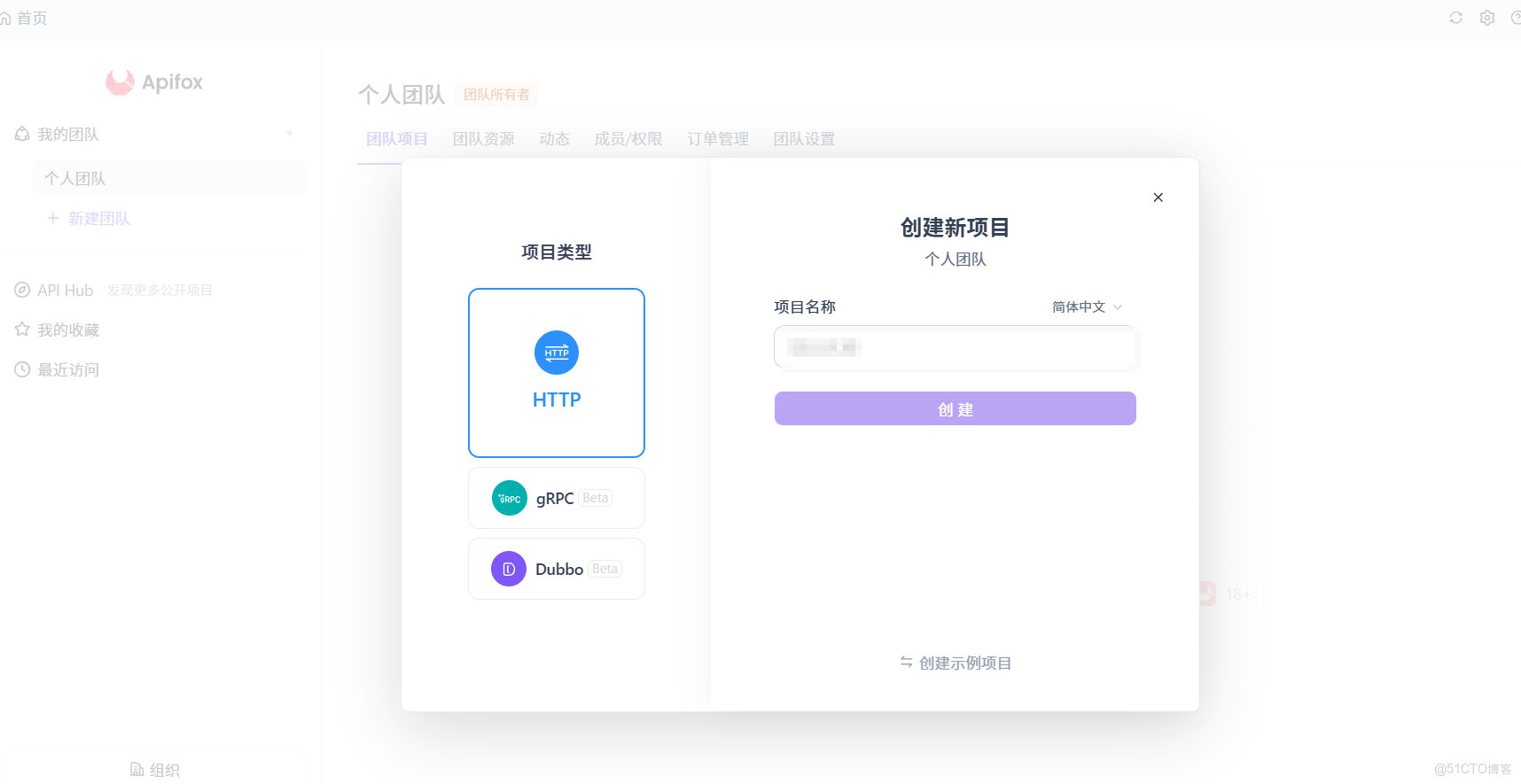

3.2 步驟2:使用Apifox進行調試

Apifox官網鏈接:https://app.apifox.com/main(注意這裏需要下載)

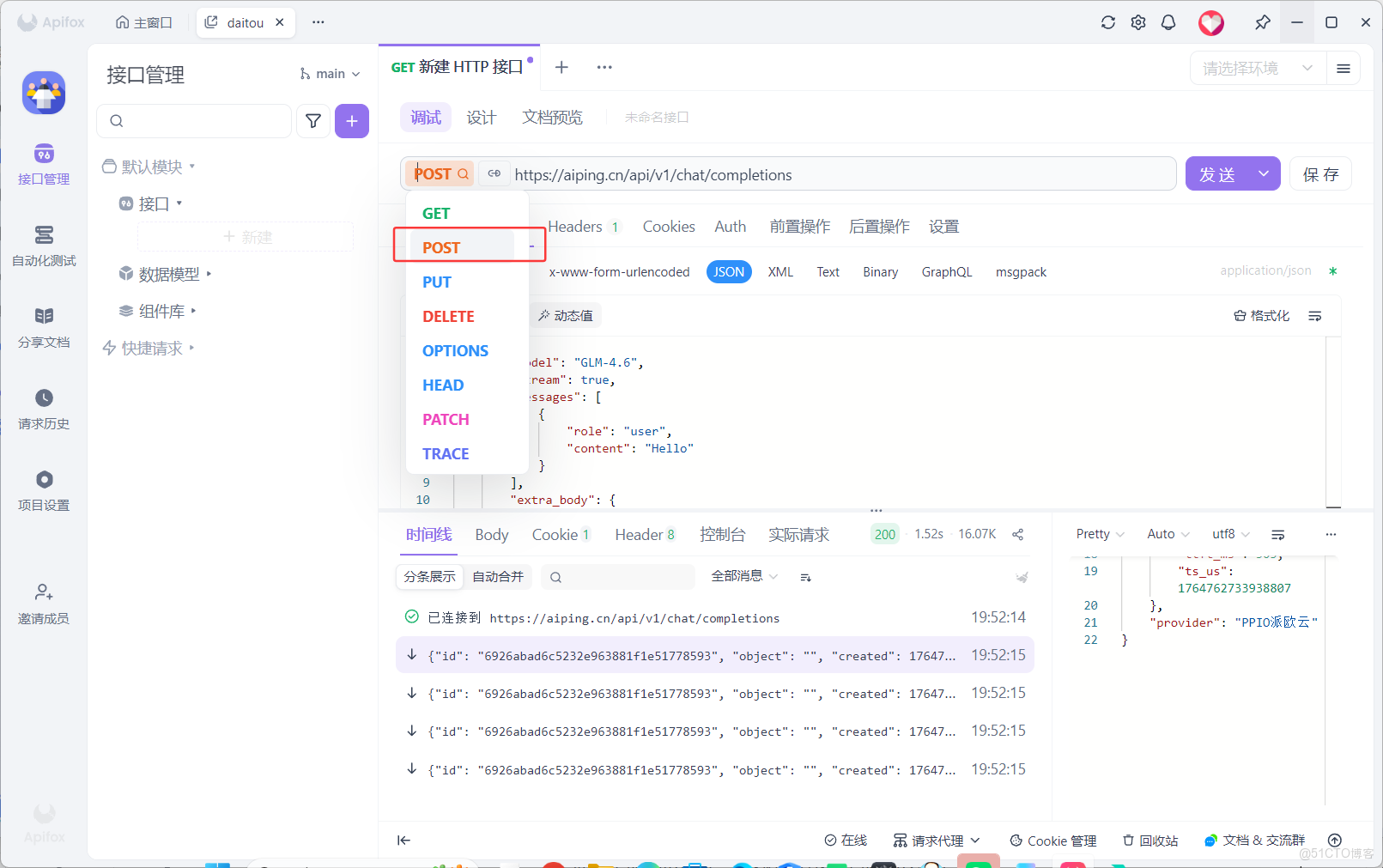

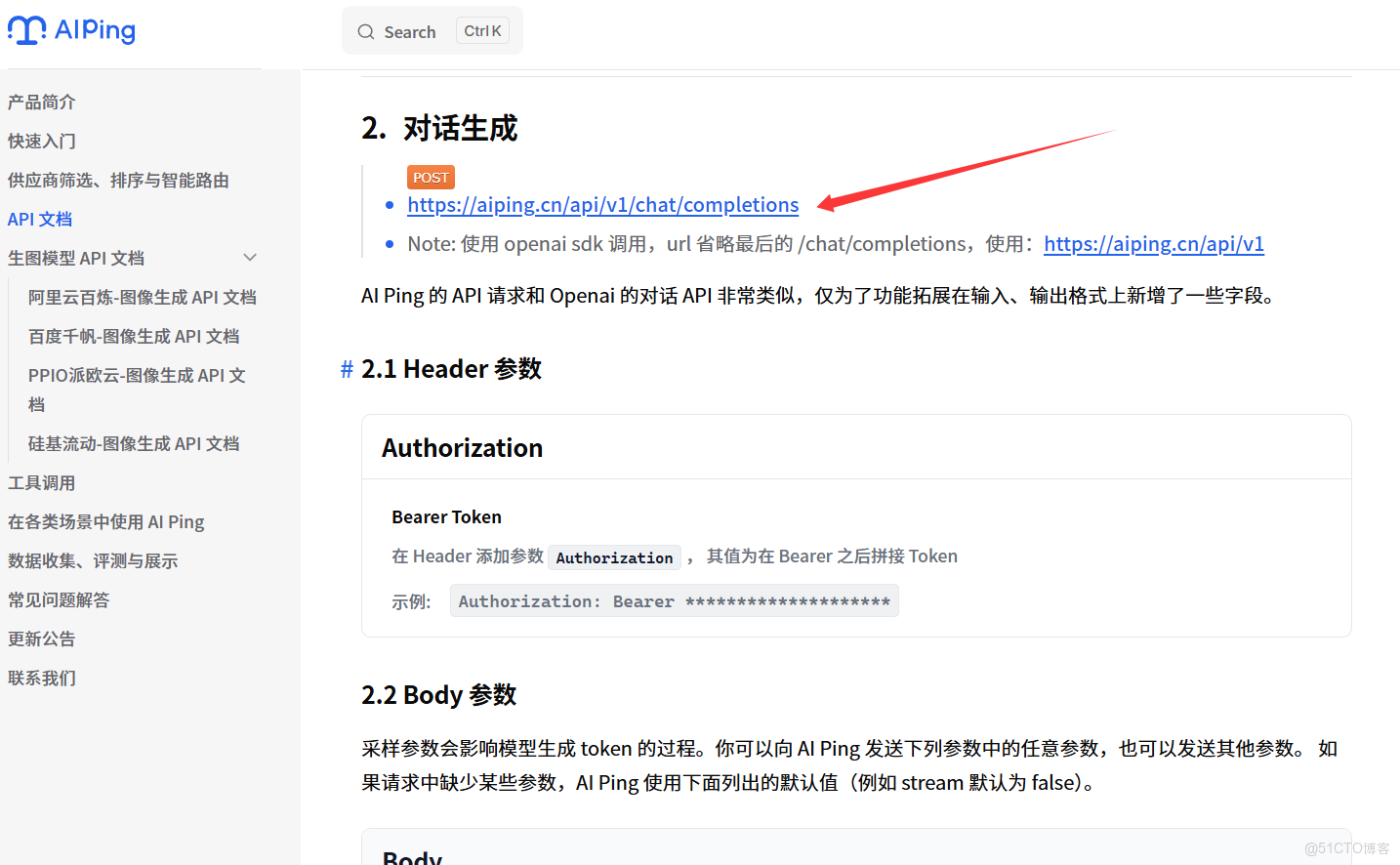

- 選擇

post,進入文檔查看鏈接

- 進入官方複製鏈接

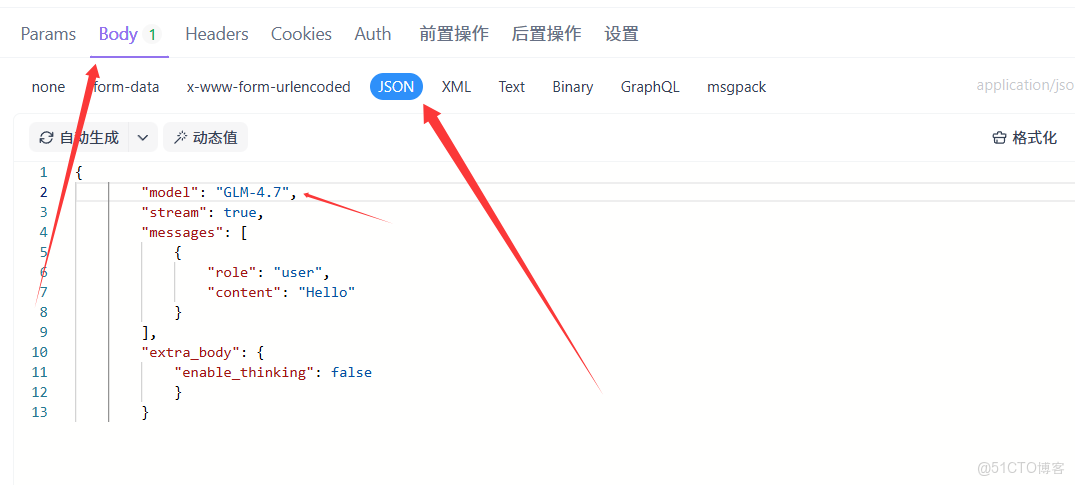

3.3 步驟3:編寫調用代碼

- 選擇Body-JSON

modle處填寫自己調用的大模型

{

"model": "GLM-4.7",

"stream": true,

"messages": [

{

"role": "user",

"content": "Hello"

}

],

"extra_body": {

"enable_thinking": false

}

}

3.4 結果果檢查

説明我們已經打通自動化生產線!

四、總結:旗艦模型,AI開發更高效

- AI Ping作為國內領先的大模型聚合平台,本次上線的GLM-4.7與MiniMax M2.1兩款旗艦模型,分別精準覆蓋複雜工程一次性交付與長鏈Agent持續運行兩大核心場景,為開發者提供了更豐富、更優質的選擇。

- 作為國內領先的大模型評測與聚合平台,AI Ping此次上線的GLM-4.7與MiniMax M2.1,精準填補了“複雜工程落地”與“長鏈Agent運行”兩大核心場景的需求空白,為開發者提供了高性價比的旗艦模型選擇。