前言:大模型選型的“隱形成本”

當你打開第17個大模型官網,對着“128K上下文”“0.01元/千Token”的參數表陷入迷茫時,或許已經踩中了AI開發的第一個坑:選型失誤的成本,遠高於技術開發本身**。2025年,國內大模型服務供應商已超20家,模型數量突破230個。開發者常因“免費模型延遲過高”“付費服務吞吐量不達標”被迫重構系統——而這一切,本可以通過科學的性能評測**避免。

AI Ping,這個被稱為“大模型服務界大眾點評”的平台,正是為解決這一痛點而生。它以7×24小時的實時監測、全維度的性能指標,讓開發者從“盲選模型”轉向“數據驅動的精準匹配”。

目錄

一、AI Ping:大模型服務的“性能透視鏡”

官方鏈接入口:【點擊進入】

本平台面對所有開發者免費使用,並免費送30算例金供大家使用更多大模型

1.1 平台定位:從“評測工具”到“決策中樞”

AI Ping是清華系團隊打造的大模型****服務性能評測與選型平台,核心定位是“用數據消除大模型選型的信息差”。它並非直接提供AI服務,而是通過整合20+供應商、400+模型服務,輸出延遲、吞吐、成本等12項核心指標,成為開發者的“性能羅盤”。

1.2 核心功能:三大模塊構建選型閉環

- 性能榜單:以“吞吐-延遲”二維座標圖呈現模型實時表現,標註“低延遲+高吞吐”的理想區域;

- 模型詳情庫:收錄每個模型的上下文長度、輸入/輸出成本、最大輸出長度等參數;

- 智能對比工具:支持多模型指標橫向對比,自動生成TCO(總擁有成本)分析報告。

我們可通過如下性能座標圖查看各種模型的吞吐表現:

1.3 智能路由:靜態配置到動態優化

- 傳統困境

- 供應商選擇依賴經驗,無法實時響應性能變化

- 固定綁定單一供應商,缺乏靈活性

- 人工切換成本高,響應速度慢

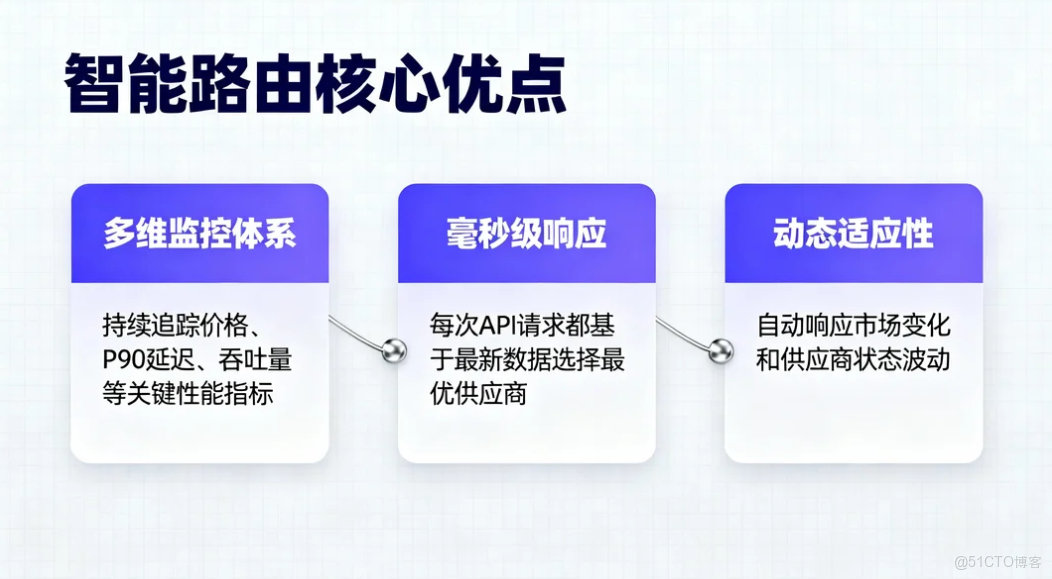

- 智能路由—數據驅動的實時決策

- 多維監控體系:持續追蹤價格、P90延遲、吞吐量等關鍵性能指

- 毫秒級響應:每次API請求都基於最新數據選擇最優供應商

- 動態適應性:自動響應市場變化和供應商狀態波動

總而言之,智能路由技術的興起,標誌着AI服務消費模式從“選擇供應商” 到“選擇最優能力” 的根本轉變。它不僅僅是技術工具的升級,更是整個行業思維模式的變革。 智能路由正在這條正確的道路上穩步前行,為構建更加智能、高效、普惠的AI應用生態奠定堅實基礎。

二、AI Ping的核心優勢:讓選型“有理有據”

2.1 中立性:數據驅動,拒絕“廠商濾鏡”

AI Ping的評測數據由清華大學與中國軟件評測中心聯合提供,通過自動化壓力測試(模擬10萬級QPS場景)、長週期監測(7×24小時)確保客觀性——你不會看到“收推廣費只誇優點”的測評,只會看到某模型“上下文超2000Token後延遲陡增300%”的真實數據。

2.2 全維度:12項指標覆蓋業務全場景

相比傳統評測僅關注“生成質量”,AI Ping的指標體系直擊開發痛點:

| 核心維度 | 關鍵指標 | 業務價值 |

|---|---|---|

| 性能表現 | P90首字延遲、平均吞吐 | 決定實時交互/批量任務的體驗 |

| 成本控制 | 輸入/輸出Token單價 | 避免“小業務用出大賬單” |

| 場景適配 | 上下文長度、最大輸出長度 | 匹配長文本處理/代碼生成需求 |

| 穩定性 | 7日性能波動曲線 | 規避高峯期服務“掉鏈子” |

2.3 低門檻:零部署,網頁端直接用

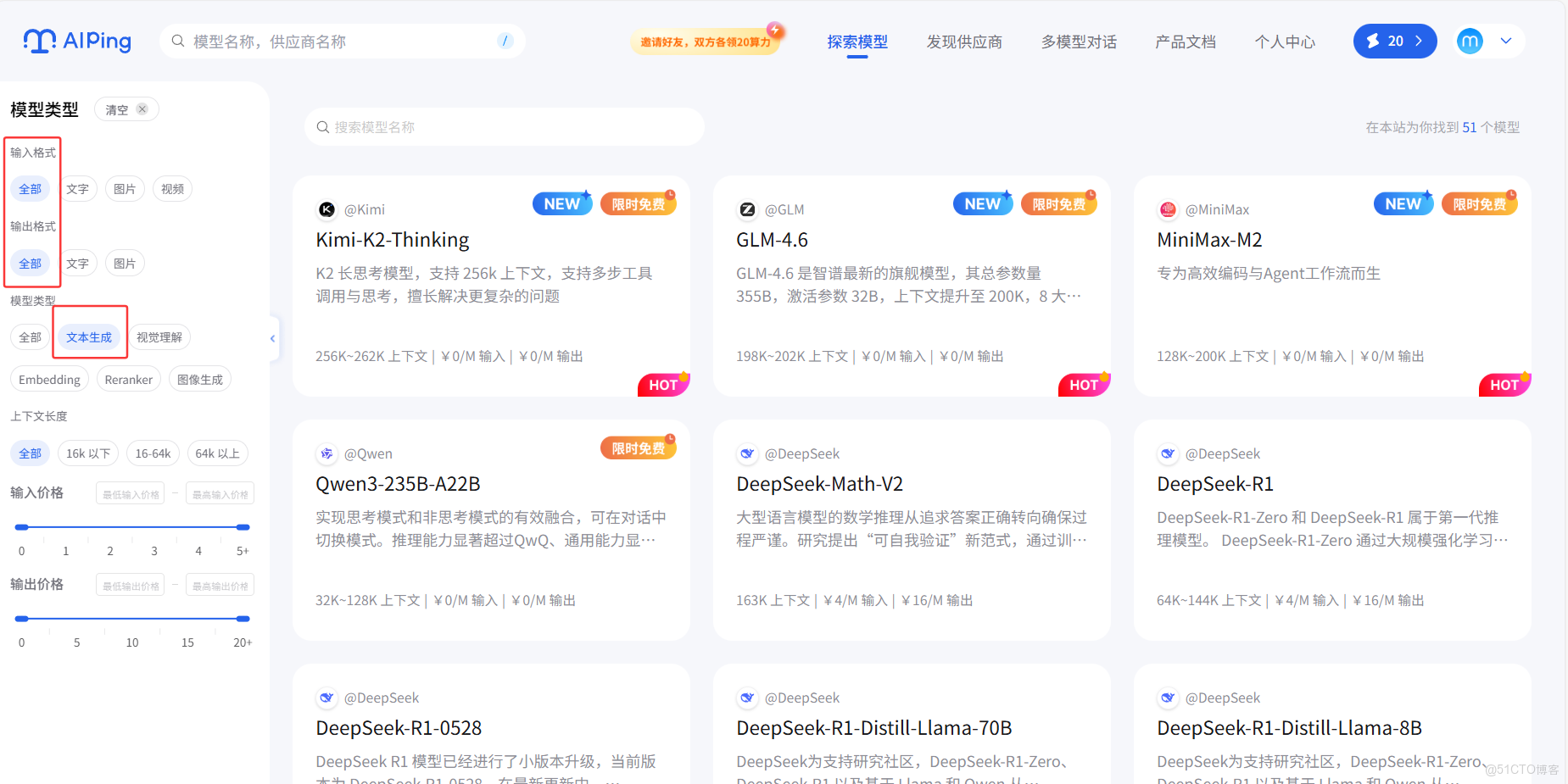

無需安裝任何工具,打開【aiping.cn】即可查看所有公開數據:選擇關鍵詞,比如文本生成,平台會自動篩選出Kimi、千問,DeepSeek等相關模型。

三、精準匹配:如何用AI Ping找到“你的模型”

3.1 第一步:明確業務場景的核心訴求

首先得明確我們自己的任務需求,入以下不同場景的指標優先級截然不同:

- 實時交互(如智能客服):優先選“延遲≤0.8s”的模型(如並行智算雲的DeepSeek);

- 批量處理(如文本摘要):優先選“吞吐≥35 tokens/s”的服務(如阿里雲百鍊);

- 長文本任務(如文檔分析):優先選“上下文≥128K”的模型(如百度智能雲ERNIE)。

3.2 第二步:用“性能座標圖”縮小範圍

AI Ping的“吞吐-延遲”座標圖中,每個數據點代表一個模型服務:

| 區域位置 | 性能特徵(延遲+吞吐) | 適用場景 |

|---|---|---|

| 右上區域 | 低延遲 + 高吞吐 | 實時對話、高併發交互等核心場景(“全能優選”) |

| 左上區域 | 低延遲 + 低吞吐 | 輕量、對處理速度要求不高的場景 |

| 右下區域 | 高延遲 + 高吞吐 | 批量數據處理、非實時推理等場景 |

| 左下區域 | 高延遲 + 低吞吐 | 儘量避開(體驗差+效率低) |

3.3 第三步:用“成本模擬器”做最終決策

輸入“每日調用10萬次,每次輸出2000Token”,AI Ping會自動計算不同模型的月度成本:

- 免費模型(如MiniMax-M2):月度成本約500元,但延遲波動大;

- 付費模型(如GLM-4.6):月度成本約1200元,但穩定性提升80%。

四、實戰:基於AI Ping的API配置全流程

以GLM-4.6模型為例接入它的API進行測試模型為例,演示從選型到調用的步驟:

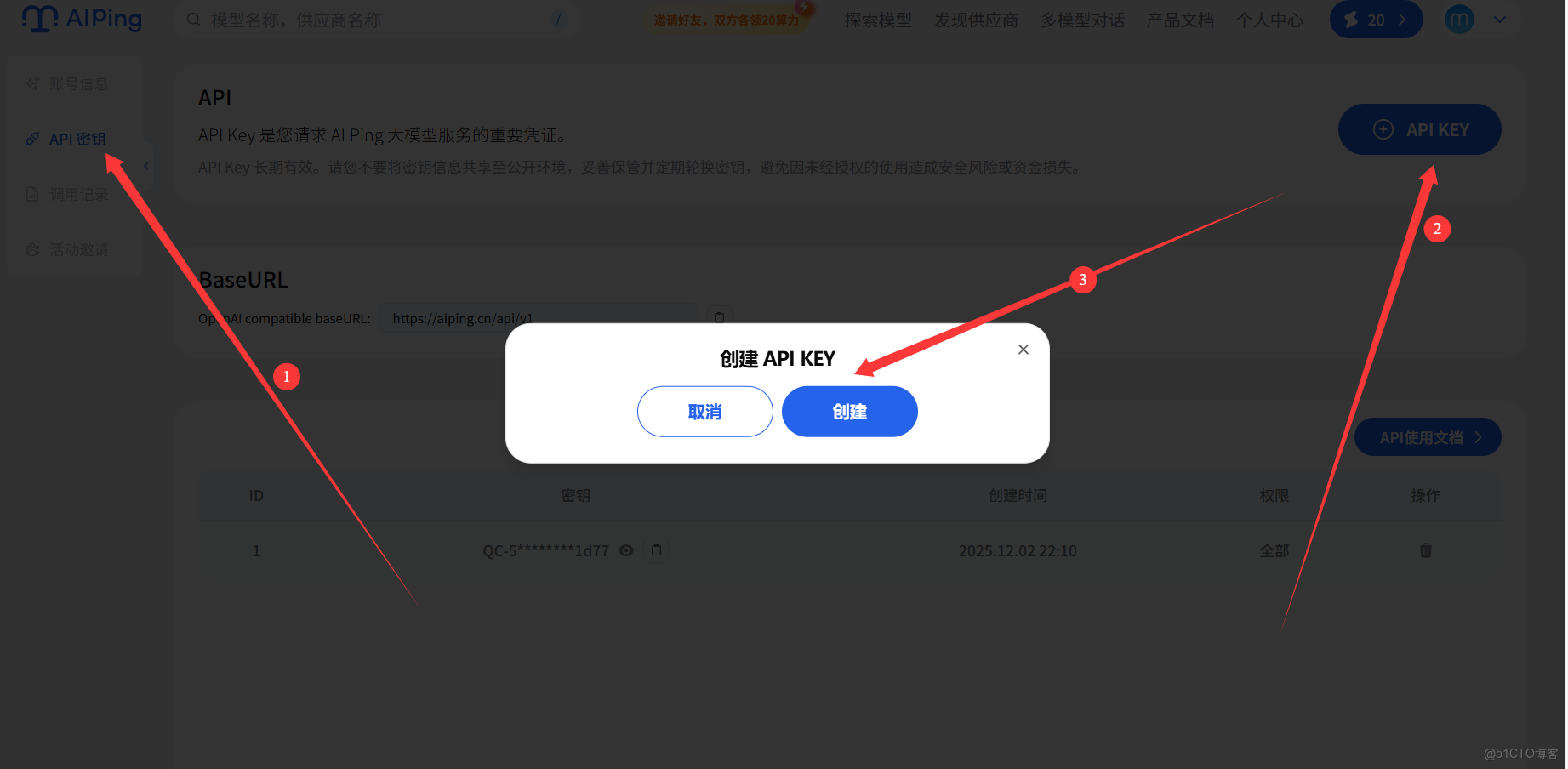

4.1 步驟1:創建API密鑰

創建之後如圖所示:

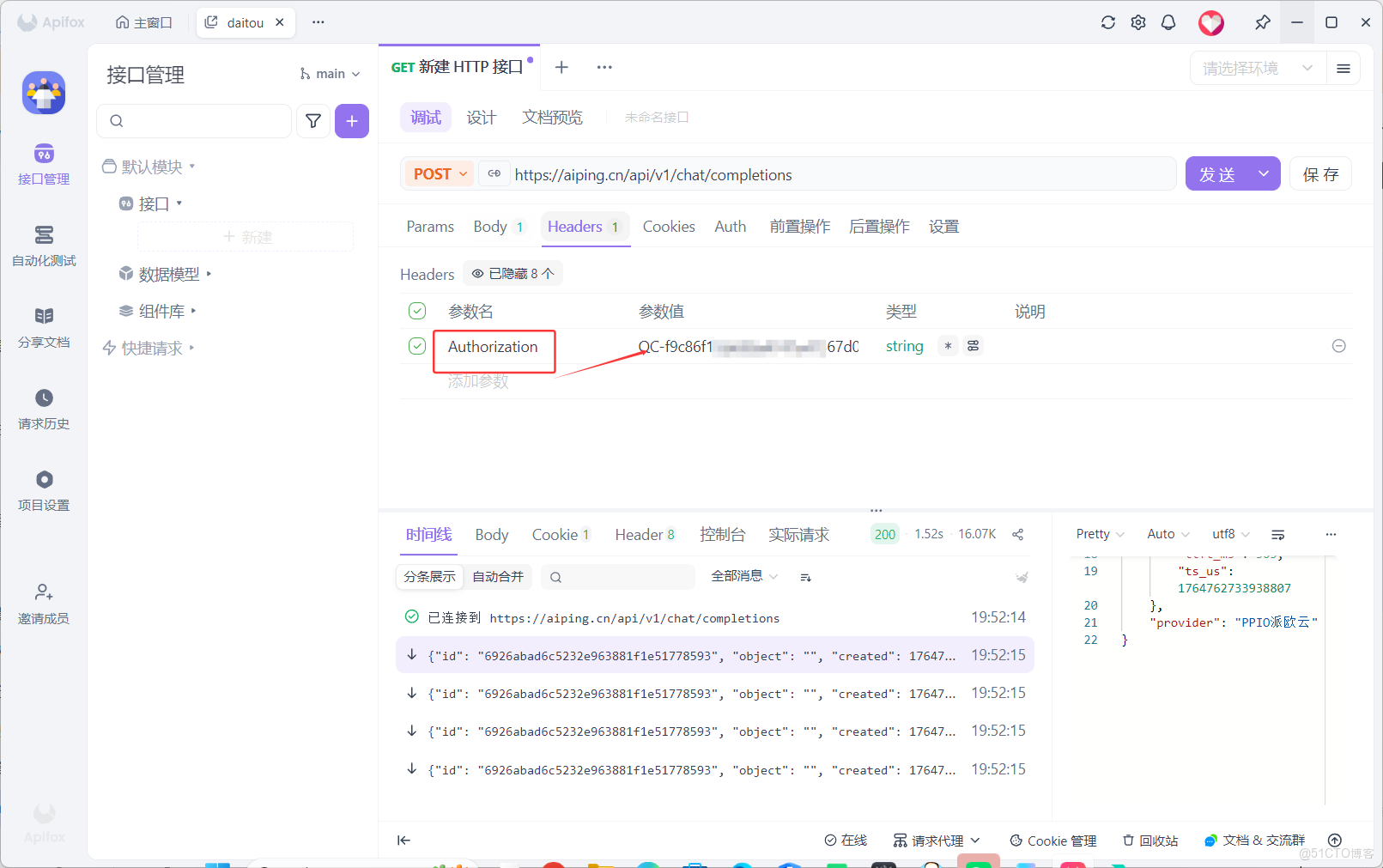

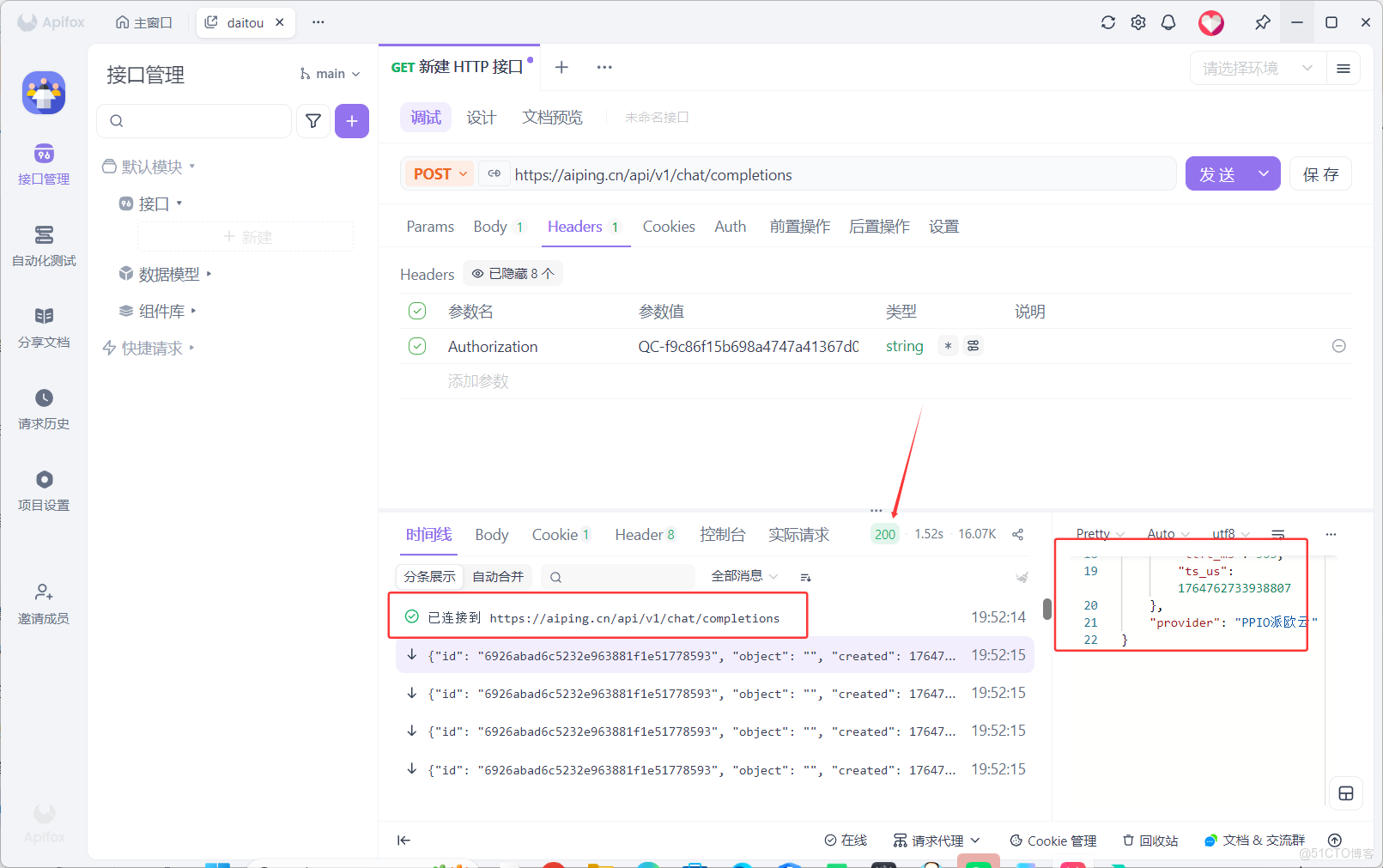

將其複製到ApifoxHeaders處,選擇 Authorization

4.2 步驟2:使用Apifox進行調試

Apifox官網鏈接:https://app.apifox.com/main(注意這裏需要下載)

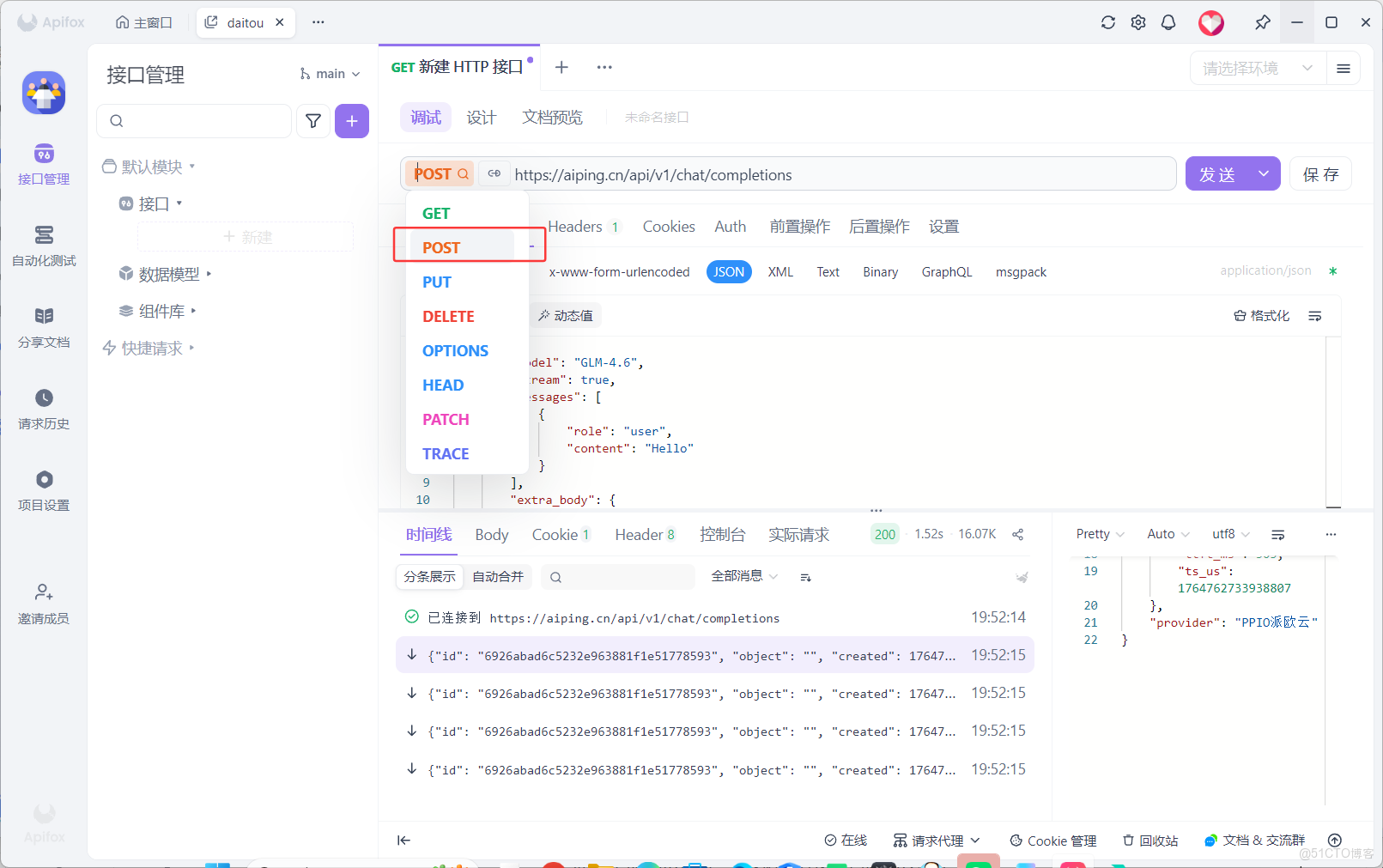

- 選擇

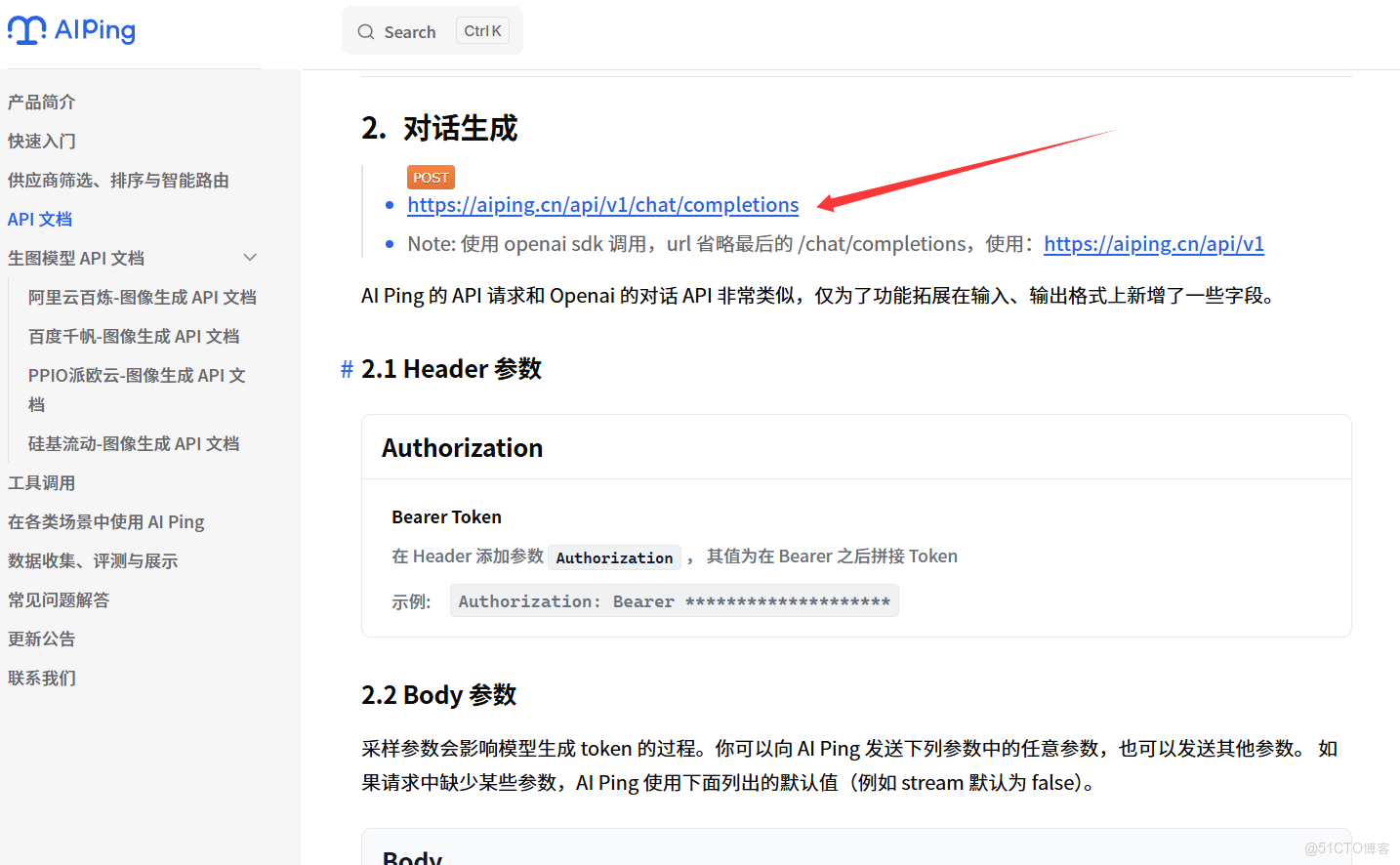

post,進入文檔查看鏈接

- 進入官方複製鏈接

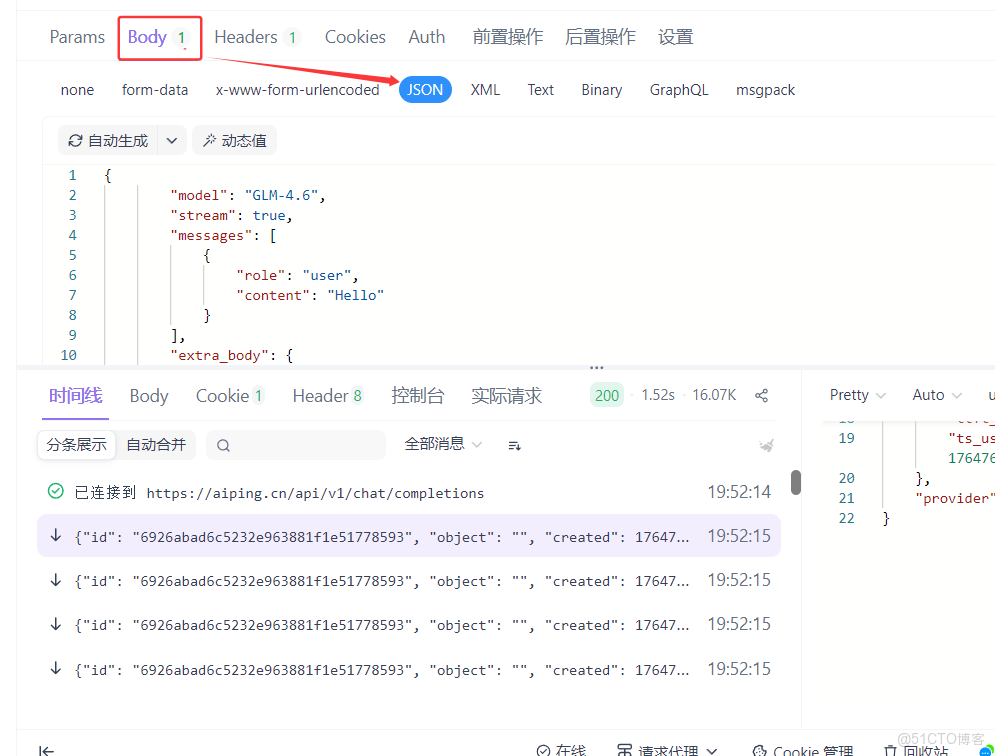

4.3 步驟3:編寫調用代碼

- 選擇Body-JSON

modle處填寫自己調用的大模型

{

"model": "GLM-4.6",

"stream": true,

"messages": [

{

"role": "user",

"content": "Hello"

}

],

"extra_body": {

"enable_thinking": false

}

}

4.4 解結果檢查

説明我們已經打通自動化生產線!

五、總結與展望:AI Ping的“下一步”

AI Ping的價值,在於將大模型選型從“經驗驅動”轉向“數據驅動”——它讓開發者不再依賴“博主推薦”,而是用7×24小時的性能數據做決策。

未來,AI Ping將向“AI效能中樞”進化:

- 推出“自動優化引擎”:根據業務負載自動切換模型;

- 新增“合規性評測”:覆蓋數據本地化、隱私保護等政策要求;

- 接入“邊緣模型”:適配AIPC(AI個人計算機)的端側部署需求。

在大模型從“可用”到“好用”的路上,AI Ping是開發者的“性能羅盤”——用數據撥開迷霧,讓AI真正成為業務增長的引擎。