摘要

本文介紹了國內領先的大模型服務評測與聚合平台 AI Ping 最新上線的兩款旗艦模型——GLM-4.7 與 MiniMax M2.1。GLM-4.7 智譜出品,側重複雜工程任務的一次性交付與 Agentic Coding 場景;MiniMax M2.1 則面向長鏈 Agent 執行,強化多語言工程能力與持續運行效率。兩款模型均可在 AI Ping 平台,支持統一 OpenAI 兼容接口調用。本文還將詳細介紹如何通過 Claude Code 和 Coze 等工具接入使用這兩款強力模型。

AI Ping

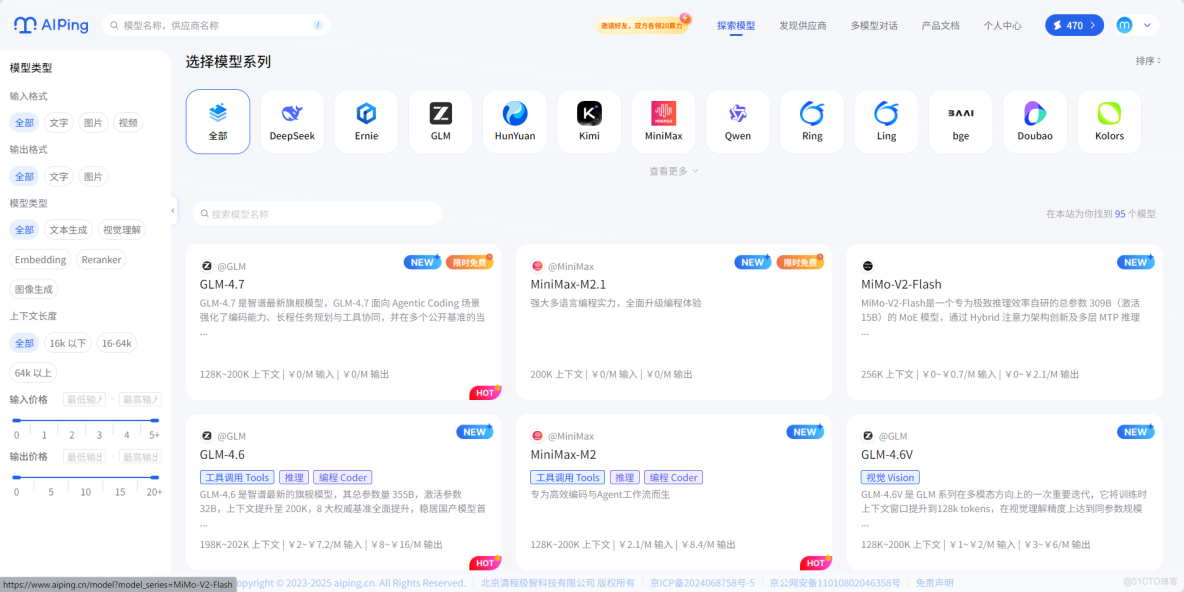

AI Ping(aiping.cn)是國內領先的大模型服務評測與聚合平台,致力於為開發者提供全面、客觀、真實的模型性能數據和統一調用入口。平台已接入智譜、MiniMax、DeepSeek、通義千問等主流廠商,覆蓋95+模型,涵蓋文本生成、視覺理解、圖像生成、Embedding、Reranker 等多種類型。

平台核心優勢包括:多供應商統一調用——一套接口切換不同供應商;性能數據可視化——實時展示吞吐、延遲、價格、可靠性等關鍵指標;智能路由——高峯時段自動選擇最優供應商保障穩定性。目前 GLM-4.7、MiniMax-M2.1、DeepSeek-V3.2 等旗艦模型可,更有邀請好友雙方各得20元算力點的活動,上不封頂。

GLM-4.7 與 MiniMax M2.1 分別代表了當前國產模型在工程交付能力 與 Agent 長期運行效率 上的兩種成熟路線: 前者通過可控推理與工具協同,強化複雜工程任務的一次性交付; 後者依託高效 MoE 架構與多語言優化,面向 AI-native 組織的持續 Agent 工作流。 兩者都不再以單輪生成質量為核心,而是直指真實複雜工程場景中的長期穩定工作能力。可以看到兩大強力模型已經上線並且免費!

模型庫

AI Ping 模型庫概覽,大部分的模型都是免費使用~

- NEW - 新上線:GLM-4.7、MiniMax-M2.1、MiMo-V2-Flash、Ring-1T 等

- FREE - 免費:DeepSeek-V3.2、GLM-4.7、MiniMax-M2.1、Doubao-Seedream-4.5 等

- HOT - 熱門:GLM-4.6、MiniMax-M2、DeepSeek系列等

模型系列分類

|

系列 |

廠商 |

代表模型 |

|

GLM |

智譜 |

GLM-4.7(NEW)、GLM-4.6、GLM-4.5、GLM-Z1系列 |

|

MiniMax |

MiniMax |

MiniMax-M2.1(NEW)、MiniMax-M2、MiniMax-M1-80k |

|

DeepSeek |

深度求索 |

DeepSeek-V3.2(FREE)、DeepSeek-R1系列、DeepSeek-V3系列 |

|

Qwen |

阿里通義 |

Qwen3系列、Qwen2.5系列、Qwen-Coder、Qwen-VL |

|

Kimi |

月之暗面 |

Kimi-K2-Thinking、Kimi-K2-Instruct |

|

Doubao |

字節跳動 |

Doubao-Seedream-4.5(FREE)、Doubao-Seedream-4.0 |

|

Hunyuan |

騰訊混元 |

Hunyuan-A13B、HunyuanImage-3.0 |

|

Ernie |

百度文心 |

ERNIE-4.5系列 |

|

Ling/Ring |

百靈 |

Ling-1T、Ring-1T |

|

Kolors |

快手 |

Kolors |

|

Kling |

可靈 |

Kling-V1/V1.5/V2/V2.1 |

|

即夢 |

字節 |

即夢圖片生成、即夢文生圖 |

|

Wan |

通義萬相 |

Wan2.5系列 |

|

BGE |

BAAI |

bge-reranker系列 |

|

MiMo |

小米 |

MiMo-V2-Flash(NEW) |

模型類型覆蓋

|

類型 |

説明 |

|

文本生成 |

通用對話、推理、編碼 |

|

視覺理解 |

圖像/視頻理解、OCR |

|

圖像生成 |

文生圖、圖生圖、圖像編輯 |

|

Embedding |

文本向量化 |

|

Reranker |

檢索重排序 |

價格範圍

|

類型 |

輸入價格 |

輸出價格 |

|

免費模型 |

¥0/M |

¥0/M |

|

付費模型 |

¥0.1~¥15/M |

¥0.1~¥60/M |

上下文長度

|

範圍 |

模型示例 |

|

16K 以下 |

部分小參數模型、專用模型 |

|

16-64K |

Qwen2.5系列、GLM-4系列部分版本 |

|

64K 以上 |

GLM-4.7(200K)、MiniMax-M2.1(200K)、DeepSeek-R1(144K)、Kimi-K2(256K) |

AI Ping 平台通過統一接口聚合了多家供應商的模型服務,用户可以按模型系列、模型類型、輸入/輸出格式、上下文長度、價格等多維度篩選,快速找到最適合的模型。

GLM-4.7

GLM-4.7簡介

GLM-4.7 是智譜最新旗艦模型,GLM-4.7 面向 Agentic Coding 場景強化了編碼能力、長程任務規劃與工具協同,並在可控推理機制支撐下實現了複雜工程任務的穩定交付。通用能力全面提升,回覆更簡潔自然,寫作更具沉浸感。在執行復雜智能體任務時,指令遵循能力更強,Artifacts 與 Agentic Coding 的前端美感和長程任務完成效率進一步提升。

與 MiniMax M2.1 的對比:

- GLM-4.7:側重一次性工程交付,適合複雜編碼任務 + Artifacts 前端生成

- MiniMax M2.1:側重長期穩定運行,適合長鏈 Agent + 多語言後端工程

GLM-4.7實測數據

AI Ping 平台測試數據(數據截至 2025 年 12 月 23 日 18:00)

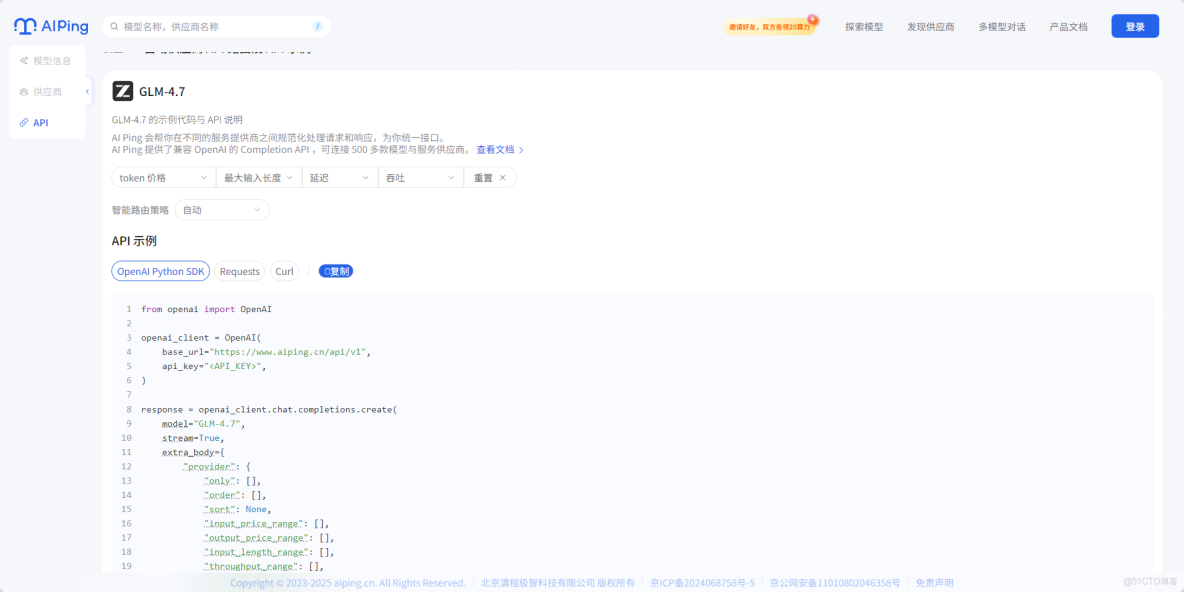

GLM-4.7調用方式

AI Ping還提供了詳細的調用方式:

from openai import OpenAI

openai_client = OpenAI(

base_url="https://www.aiping.cn/api/v1",

api_key="***",

)

response = openai_client.chat.completions.create(

model="GLM-4.7",

stream=True,

extra_body={

"provider": {

"only": [],

"order": [],

"sort": None,

"input_price_range": [],

"output_price_range": [],

"input_length_range": [],

"throughput_range": [],

"latency_range": []

}

},

messages=[

{"role": "user", "content": "Hello"}

]

)

for chunk in response:

if not getattr(chunk, "choices", None):

continue

reasoning_content = getattr(chunk.choices[0].delta, "reasoning_content", None)

if reasoning_content:

print(reasoning_content, end="", flush=True)

content = getattr(chunk.choices[0].delta, "content", None)

if content:

print(content, end="", flush=True)MiniMax-M2.1

MiniMax-M2.1簡介

MiniMax M2.1 是 MiniMax 最新旗艦模型,MiniMax M2.1 面向長鏈 Agent 執行場景強化了多語言工程能力、持續運行效率與收斂推理路徑,並在高效 MoE 架構支撐下實現了吞吐與穩定性的出色平衡。多語言工程能力強化,對 Rust / Go / Java / C++ 等生產級代碼支持更完善。在執行長時間 Agent 工作流時,推理路徑更收斂、工具調用更高效,憑藉低激活參數與 200k 長上下文優勢,連續編碼與持續運行吞吐進一步提升。

與 GLM-4.7 的對比:

- GLM-4.7:側重一次性工程交付,適合複雜編碼任務 + Artifacts 前端生成

- MiniMax M2.1:側重長期穩定運行,適合長鏈 Agent + 多語言後端工程

MiniMax-M2.1實測數據

AI Ping 平台測試數據(數據截至 2025 年 12 月 23 日 18:00)

MiniMax-M2.1調用方式

AI Ping還提供了詳細的調用方式:

from openai import OpenAI

openai_client = OpenAI(

base_url="https://www.aiping.cn/api/v1",

api_key="***",

)

response = openai_client.chat.completions.create(

model="MiniMax-M2.1",

stream=True,

extra_body={

"provider": {

"only": [],

"order": [],

"sort": None,

"input_price_range": [],

"output_price_range": [],

"input_length_range": [],

"throughput_range": [],

"latency_range": []

}

},

messages=[

{"role": "user", "content": "Hello"}

]

)

for chunk in response:

if not getattr(chunk, "choices", None):

continue

reasoning_content = getattr(chunk.choices[0].delta, "reasoning_content", None)

if reasoning_content:

print(reasoning_content, end="", flush=True)

content = getattr(chunk.choices[0].delta, "content", None)

if content:

print(content, end="", flush=True)如何選擇模型?

GLM-4.7 與 MiniMax M2.1 雖然都是旗艦級模型,但定位和適用場景有明顯差異。根據你的具體需求,可參考以下選型指南:

核心差異對比

|

維度 |

GLM-4.7 |

MiniMax M2.1 |

|

技術路線 |

可控推理 + 工具協同 |

高效 MoE 架構 |

|

核心優勢 |

一次性工程交付能力 |

長期穩定運行效率 |

|

語言專長 |

Python、前端全棧 |

Rust、Go、Java、C++ 等多語言後端 |

|

上下文長度 |

200K |

200K |

|

最佳場景 |

Agentic Coding、Artifacts 前端生成 |

長鏈 Agent 工作流、持續編碼 |

|

推理風格 |

路徑可控、指令遵循強 |

路徑收斂、工具調用高效 |

場景選型決策表

|

你的需求場景 |

推薦模型 |

理由 |

|

前端開發 + UI 生成 |

GLM-4.7 |

Artifacts 能力強,前端代碼美觀度更高 |

|

需要快速生成完整項目 |

GLM-4.7 |

一次性交付能力強,適合從零到一構建 |

|

後端多語言開發 |

MiniMax M2.1 |

對 Rust/Go/Java/C++ 支持更完善 |

|

構建 AI Agent 系統 |

MiniMax M2.1 |

長鏈工作流穩定,推理路徑收斂 |

|

需要長時間運行的編碼任務 |

MiniMax M2.1 |

持續運行吞吐更高,穩定性更好 |

|

複雜任務規劃與執行 |

GLM-4.7 |

指令遵循能力強,長程任務規劃更可控 |

|

多輪對話式開發 |

MiniMax M2.1 |

在持續交互中表現更穩定 |

|

單次生成質量要求高 |

GLM-4.7 |

可控推理機制保證輸出質量 |

快速決策流程圖

是否需要生成前端/UI?

├── 是 → GLM-4.7

└── 否 → 是否涉及 Rust/Go/Java/C++ 等後端語言?

├── 是 → MiniMax M2.1

└── 否 → 任務是否需要長時間持續運行?

├── 是 → MiniMax M2.1

└── 否 → 是否需要一次性完成複雜工程交付?

├── 是 → GLM-4.7

└── 否 → 兩者均可,按個人偏好選擇組合使用建議

對於大型項目,可以考慮組合使用兩款模型:

- GLM-4.7:負責項目初始化、核心架構設計、前端界面生成

- MiniMax M2.1:負責後端邏輯實現、長鏈業務流程、持續迭代優化

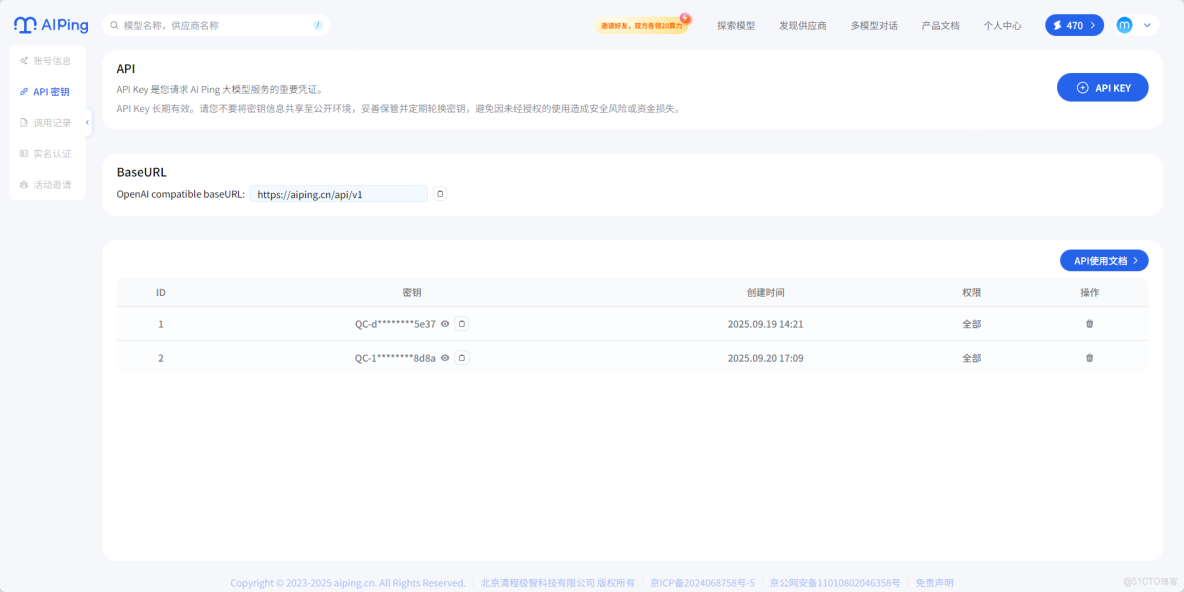

獲取API KEY

API KEY頁面,也可參考文檔,複製即可。

如何使用AI Ping?

Claude Code中使用GLM-4.7

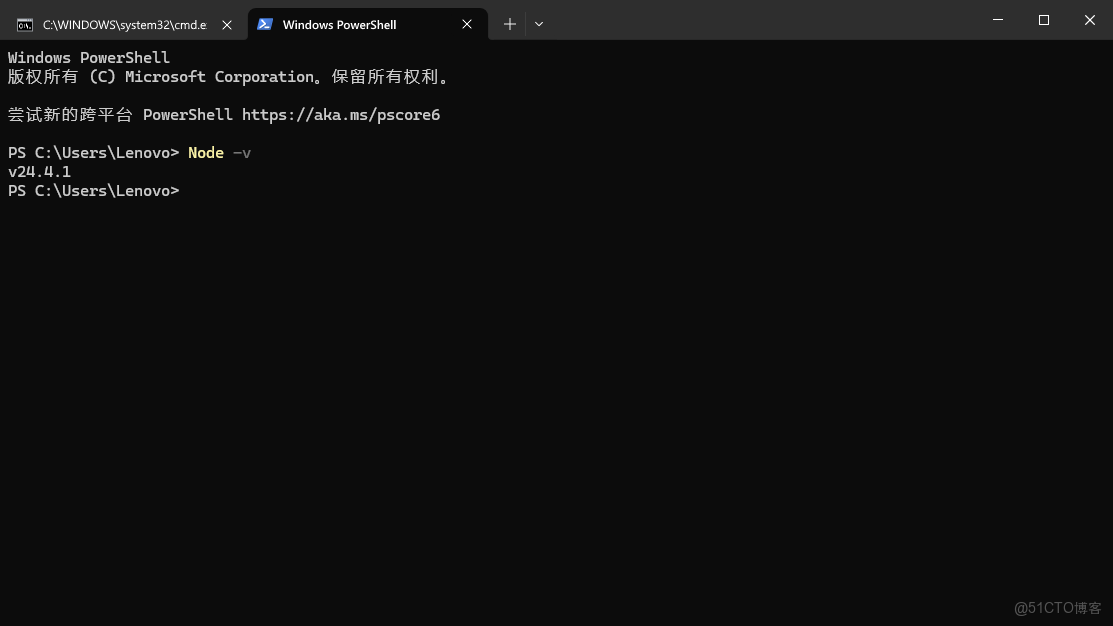

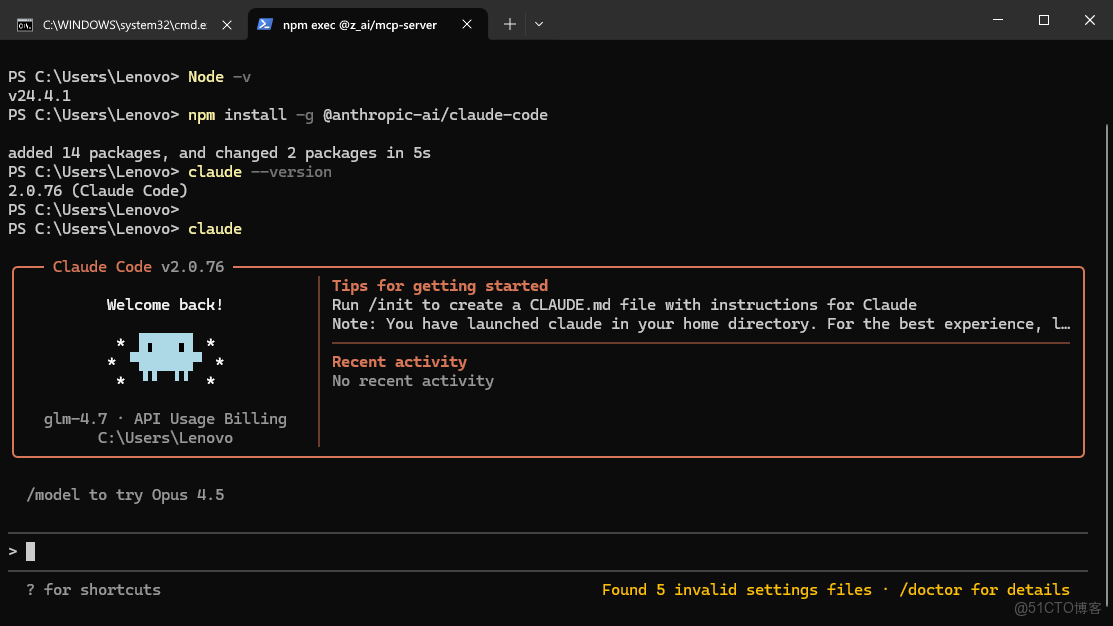

首先需要Nodejs環境,我這裏是v24.4.1

安裝claude code

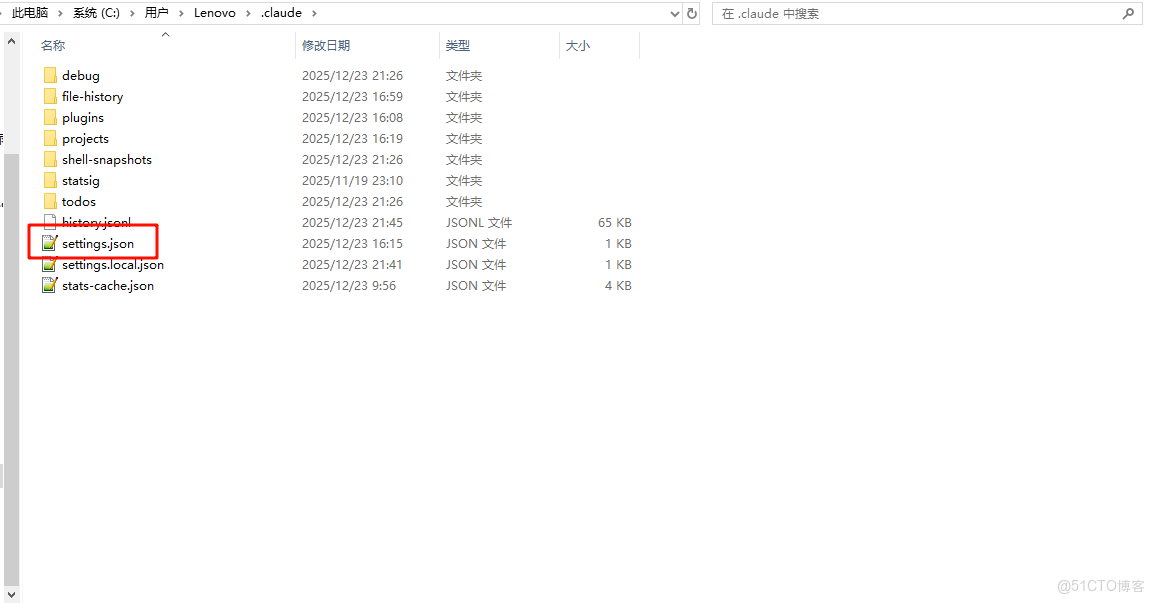

npm install -g @anthropic-ai/claude-code在~/.claude/settings.json中找到這個配置文件

將下方的內容替換到其中

{

"env": {

"ANTHROPIC_BASE_URL": "https://aiping.cn/api/v1/anthropic",

"ANTHROPIC_AUTH_TOKEN": "<YOUR_API_KEY>",

"API_TIMEOUT_MS": "3000000",

"CLAUDE_CODE_DISABLE_NONESSENTIAL_TRAFFIC": 1,

"ANTHROPIC_MODEL": "GLM-4.7",

"ANTHROPIC_SMALL_FAST_MODEL": "GLM-4.7",

"ANTHROPIC_DEFAULT_SONNET_MODEL": "GLM-4.7",

"ANTHROPIC_DEFAULT_OPUS_MODEL": "GLM-4.7",

"ANTHROPIC_DEFAULT_HAIKU_MODEL": "GLM-4.7"

}

}然後終端輸入claude啓動

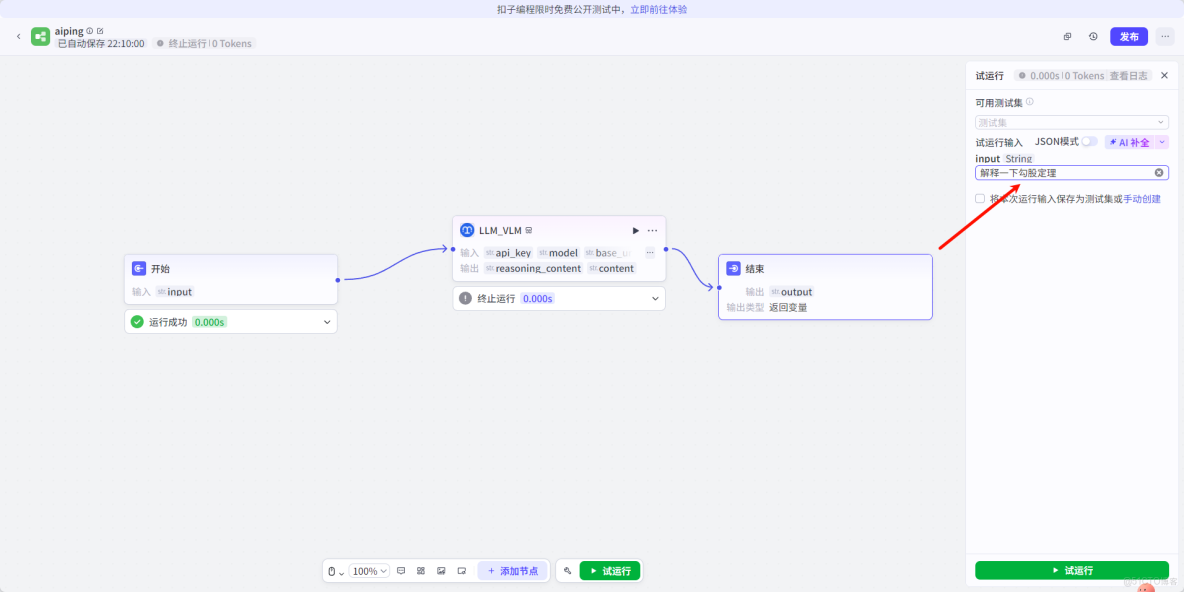

Coze中使用MiniMax-M2.1

Coze(釦子)是字節跳動推出的 AI Bot 開發平台,支持通過插件方式調用 AI Ping 的模型服務。以下是在 Coze 中集成 MiniMax-M2.1 的完整步驟:

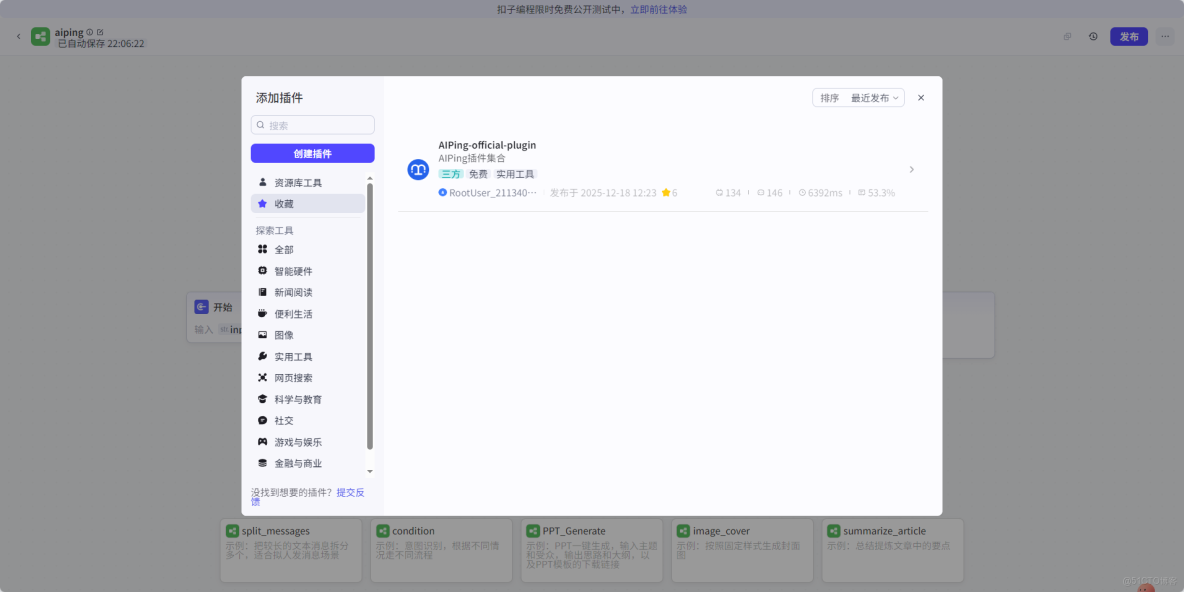

步驟一:安裝 AI Ping 插件

- 登錄 Coze 官網,進入左側插件市場

- 在搜索框中輸入

AIPing-official-plugin進行搜索 - 點擊插件詳情頁,點擊右上角的收藏按鈕(方便後續快速找到)

圖:Coze 插件市場搜索 AI Ping 官方插件

步驟二:創建智能體和工作流

- 回到 Coze 首頁,點擊創建智能體,填寫名稱和描述

- 在智能體編輯頁面中,點擊工作流標籤頁

- 點擊+ 添加新工作流,選擇從空白創建

圖:創建新的智能體

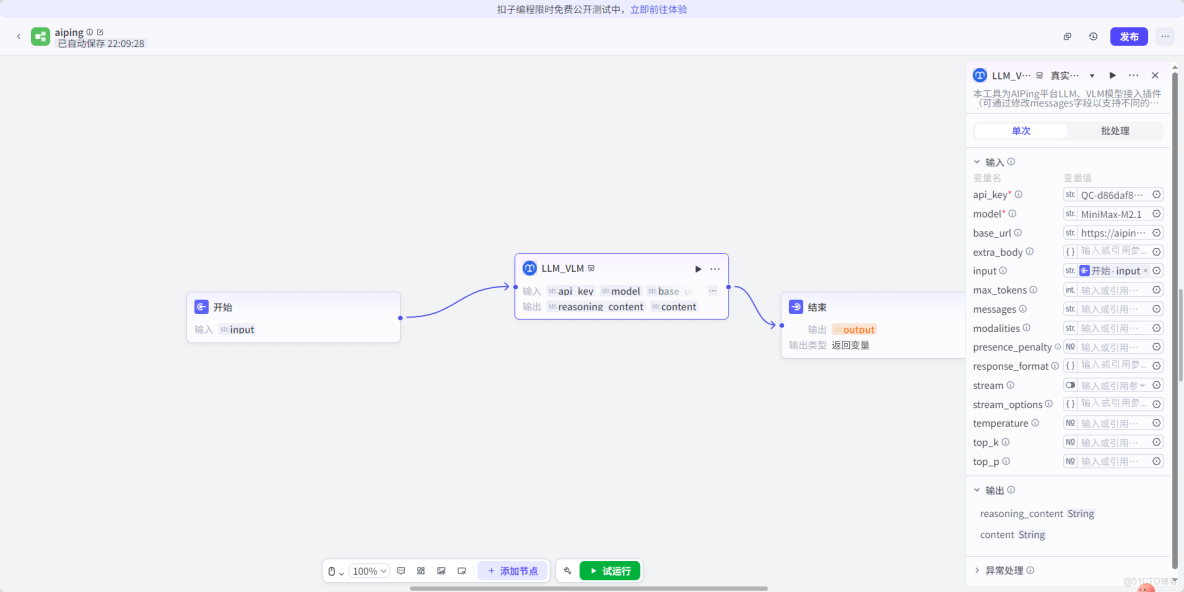

步驟三:配置 AI Ping 插件節點

- 在工作流編輯器中,點擊+ 添加節點

- 在節點類型中選擇插件,然後從我的收藏中找到

AIPing-official-plugin - 點擊插件卡片將其添加到工作流中

圖:在工作流中選擇 AI Ping 插件

步驟四:配置插件參數

- 點擊 AI Ping 插件節點,配置以下參數:

- model: 模型名稱,填寫

MiniMax-M2.1 - messages: 對話消息列表,按 JSON 格式配置

- stream: 是否流式輸出,可選

true或false - temperature: 温度參數,控制輸出隨機性(0-1)

- max_tokens: 最大生成 token 數

圖:配置 AI Ping 插件參數

步驟五:測試與發佈

- 點擊右上角試運行按鈕,輸入測試消息驗證插件是否正常工作

- 查看運行結果,確認模型返回符合預期

圖:試運行工作流

- 測試通過後,點擊發佈按鈕,即可在對話中使用配置好的智能體

圖:查看運行結果

提示:AI Ping 插件支持所有平台接入的模型,你可以將 model 參數替換為 GLM-4.7 或其他模型名稱,靈活切換使用。

總結

AI Ping 作為國內領先的大模型聚合平台,本次上線的 GLM-4.7 與 MiniMax M2.1 兩款旗艦模型各有側重,為開發者提供了豐富的選擇:

|

模型 |

核心優勢 |

適用場景 |

|

GLM-4.7 |

可控推理、工具協同、Artifacts 前端生成 |

複雜編碼任務、一次性工程交付 |

|

MiniMax M2.1 |

高效 MoE 架構、多語言工程、長上下文 |

長鏈 Agent 工作流、持續穩定運行 |

平台亮點:

- 95+ 模型全覆蓋,支持文本生成、視覺理解、圖像生成等多種類型

- 統一 OpenAI 兼容接口,零成本切換模型

- 實時性能數據可視化(吞吐、延遲、價格、可靠性)

- 智能路由自動選擇最優供應商

- 邀請好友雙方各得 20 元算力點,上不封頂

無論是需要快速完成複雜編碼任務,還是構建長期穩定運行的 AI Agent,AI Ping 都能提供合適的模型選擇。趕快註冊體驗,薅取這波免費算力羊毛吧!