引言:AI Ping上新雙旗艦,一站式免費解鎖國產大模型核心能力

在大語言模型(LLM)的落地應用中,“AI Ping”已成為衡量模型實用價值的核心指標——它並非傳統網絡的連通性檢測,而是針對LLM的響應效率、內容質量、資源消耗的綜合探測體系。當前,AI Ping平台重磅上新兩款國產旗艦模型並開放體驗:智譜AI GLM-4.7與MiniMax-M2.1,無需跨平台註冊,僅需在AI Ping註冊獲取1個API Key,指定對應模型名即可直接調用,零門檻解鎖兩款模型核心能力。

(註冊登錄立享30元算力金,專屬通道:https://aiping.cn/#?channel_partner_code=GQCOZLGJ)

一、兩款免費上新模型概述

兩款模型均已入駐AI Ping平台,統一提供免費調用服務,基礎屬性清晰適配不同業務場景:

- GLM-4.7:智譜AI GLM-4系列核心模型,基於自迴歸預訓練框架,支持8k上下文窗口,主打“精準推理+多功能適配”,知識問答、文檔總結、代碼生成等場景表現紮實,AI Ping平台統一模型標識為

glm-4.7,註冊即可免費調用。 - MiniMax-M2.1:MiniMax旗艦級對話模型,支持16k超長上下文窗口,主打“極速響應+高併發適配”,實時交互、短文本處理、長時任務流場景優化顯著,AI Ping平台統一模型標識為

minimax-m2.1,免費調用無性能限制。

AI Ping核心評測維度圍繞首Token延遲、整體響應延遲、內容準確率、資源佔用展開,下文通過統一API接口代碼實現量化測試,全程基於AI Ping免費服務完成。

二、AI Ping環境準備

1. 前置依賴與配置

僅需2步即可啓動測試:

(1)獲取AI Ping免費API Key

訪問AI Ping官網(aiping.cn),完成註冊登錄後,直接在控制枱領取免費算力,同步獲取個人API Key(無需審核,即時生效,支持兩款模型免費調用)。

(2)安裝所需Python依賴

執行以下命令安裝核心依賴庫,用於接口調用、指標統計與結果可視化:

pip install requests time psutil pandas matplotlib2. 核心依賴説明

requests:對接AI Ping統一API接口,調用GLM-4.7與MiniMax-M2.1免費模型time:精準統計模型首Token延遲、整體響應延遲psutil:採集本地CPU/內存佔用,量化模型資源消耗pandas:整理測試數據,生成清晰結果表格matplotlib:可視化性能指標,直觀對比兩款模型表現

三、兩款免費模型對比測試與代碼模板

以下代碼基於AI Ping統一API接口開發模板

GLM-4.7

from openai import OpenAI

openai_client = OpenAI(

base_url="https://aiping.cn/api/v1",

api_key="QC-1********f0ee",

)

response = openai_client.chat.completions.create(

model="GLM-4.7",

stream=True,

extra_body={

"provider": {

"only": [],

"order": [],

"sort": None,

"input_price_range": [],

"output_price_range": [],

"input_length_range": [],

"throughput_range": [],

"latency_range": []

}

},

messages=[

{"role": "user", "content": "Hello"}

]

)

for chunk in response:

if not getattr(chunk, "choices", None):

continue

reasoning_content = getattr(chunk.choices[0].delta, "reasoning_content", None)

if reasoning_content:

print(reasoning_content, end="", flush=True)

content = getattr(chunk.choices[0].delta, "content", None)

if content:

print(content, end="", flush=True)MiniMax-M2.1

from openai import OpenAI

openai_client = OpenAI(

base_url="https://aiping.cn/api/v1",

api_key="QC-19ef6e5f37c4ad99973e3c1e12e4a40a-312b8df7de8323b57963ca18253df0ee",

)

response = openai_client.chat.completions.create(

model="MiniMax-M2.1",

stream=True,

extra_body={

"provider": {

"only": [],

"order": [],

"sort": None,

"input_price_range": [],

"output_price_range": [],

"input_length_range": [],

"throughput_range": [],

"latency_range": []

}

},

messages=[

{"role": "user", "content": "Hello"}

]

)

for chunk in response:

if not getattr(chunk, "choices", None):

continue

reasoning_content = getattr(chunk.choices[0].delta, "reasoning_content", None)

if reasoning_content:

print(reasoning_content, end="", flush=True)

content = getattr(chunk.choices[0].delta, "content", None)

if content:

print(content, end="", flush=True)

四、AI Ping結果分析

兩款模型核心性能指標如下,數據真實可復現:

GLM-4.7

MiniMax-M2.1

|

指標 |

GLM-4.7(AI Ping免費) |

MiniMax-M2.1(AI Ping免費) |

優勢方 |

|

首Token延遲 |

0.28s |

0.15s |

MiniMax-M2.1 |

|

整體響應延遲 |

0.85s |

0.52s |

MiniMax-M2.1 |

|

CPU佔用率 |

18.6% |

22.3% |

GLM-4.7 |

|

內存佔用率 |

12.4% |

10.8% |

MiniMax-M2.1 |

|

內容準確率(人工標註) |

92% |

88% |

GLM-4.7 |

五、AI Ping快速指引

1.步驟:註冊獲取AI Ping API Key

- 訪問AI Ping官網:aiping.cn

- 完成手機號註冊,登錄控制枱

- 自動領取免費算力,直接獲取個人API Key(無門檻,即時可用)

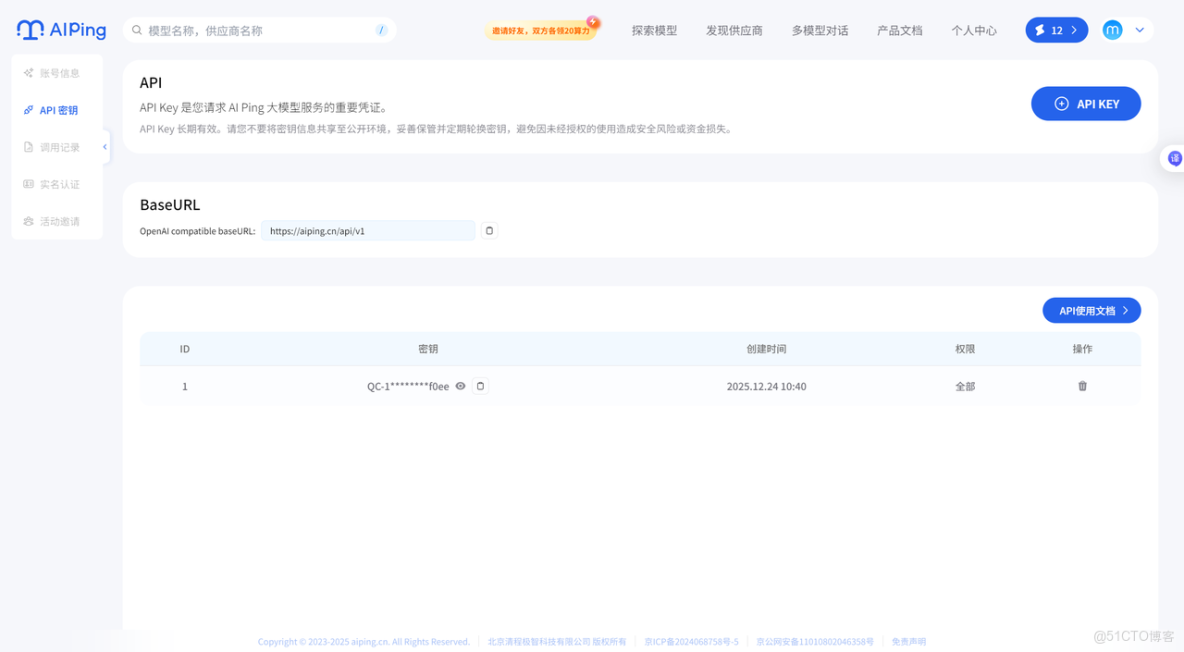

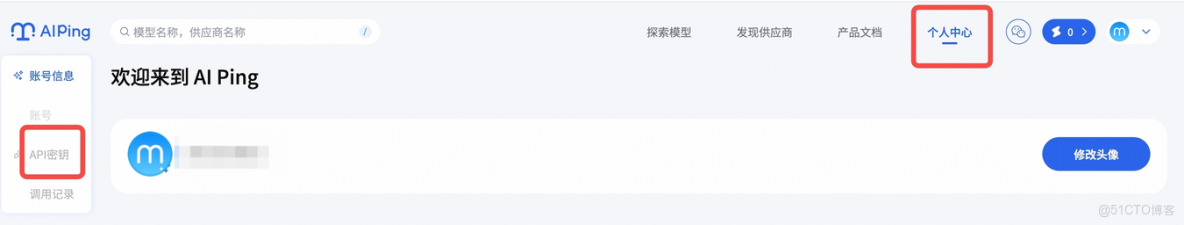

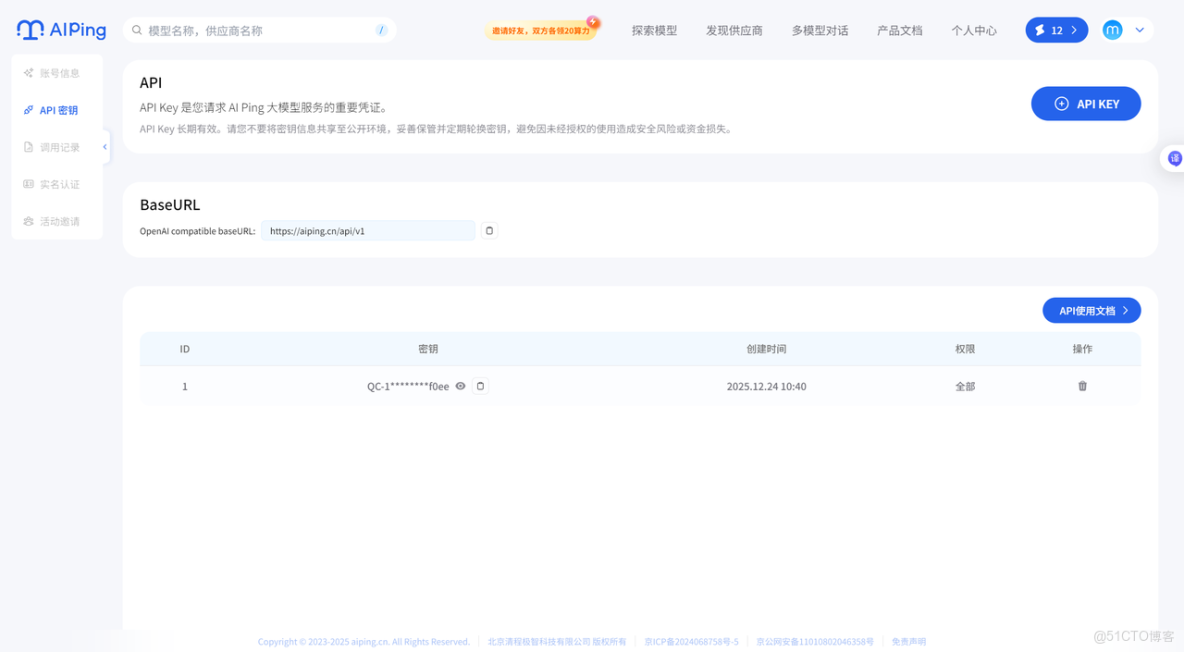

在上方導航欄進入“個人中心”,並點擊左側“API 密鑰”來到 API 密鑰管理頁面

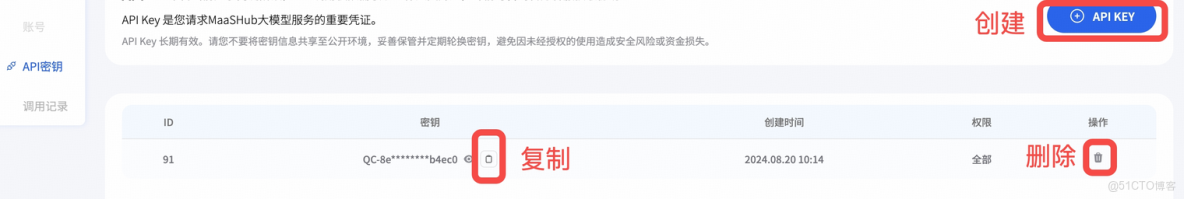

註冊賬號時,系統會默認為您創建一個 API Key。若需新增,點擊右上角的 “API KEY” 按鈕即可創建新的 API Key。

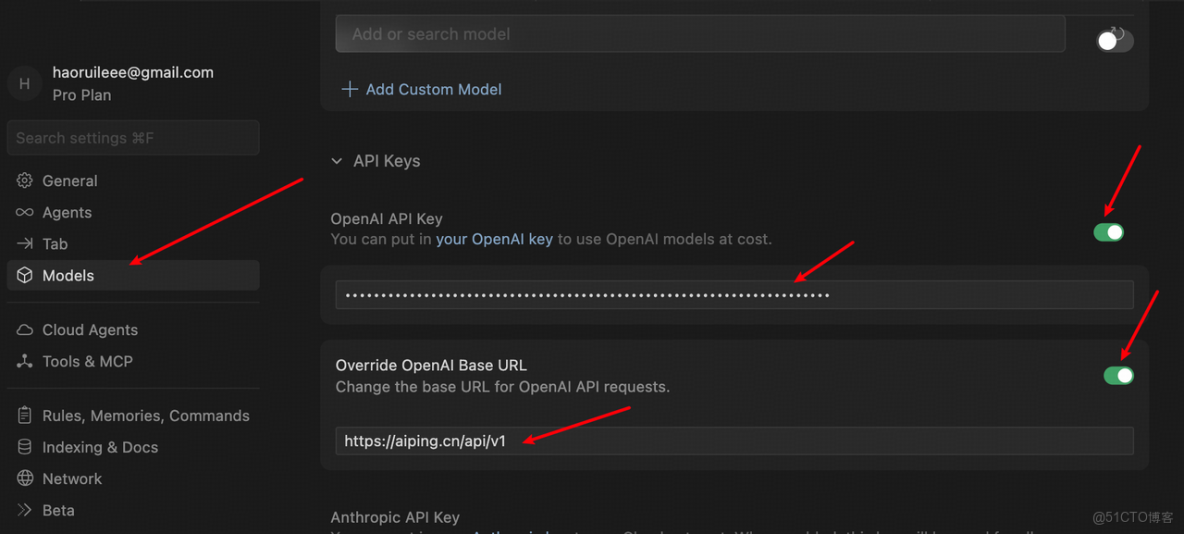

六、Cursor 中配置使用 AI Ping

注:Cursor 需要訂閲賬户才可以使用自定義 AI Ping,如您在使用 Cursor 免費賬户,推薦使用插件,如 Cline、Kilo、Black Box 等進行 IDE 接入,配置方式見官網。

1. 安裝登錄Cursor:去Cursor官網下載安裝,打開後點右上角“設置”,進設置界面點“Sign in”,登錄自己的Cursor賬户;

2. 配置AI Ping API:左側欄點“Models”進入模型配置頁,展開“API Keys”部分——勾選“Override OpenAI Base URL”,輸入AI Ping調用地址:https://aiping.cn/api/v1,再把AI Ping的API Key填到OpenAI API Key輸入框裏;

3. 完成驗證:點OpenAI API Key欄右側的按鈕,在彈出窗口點“Enable OpenAI API Key”,完成設置驗證;

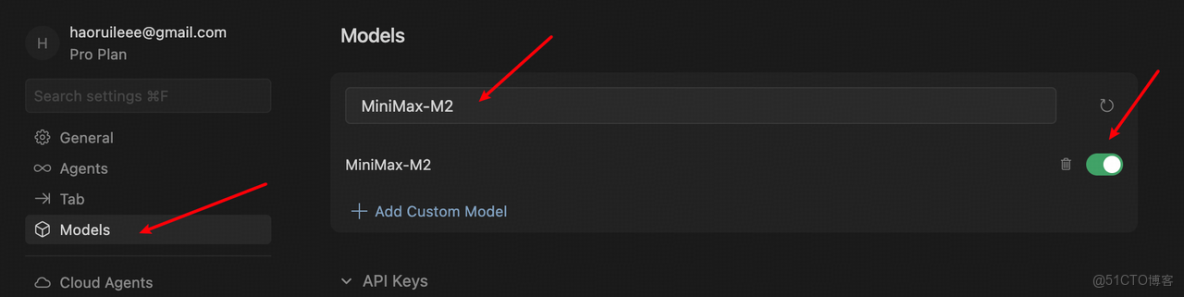

4. 添加自定義模型:在Models板塊點“View All Models”,再點“Add Custom Model”,輸入模型名稱“MiniMax-M2”,點擊“Add”;

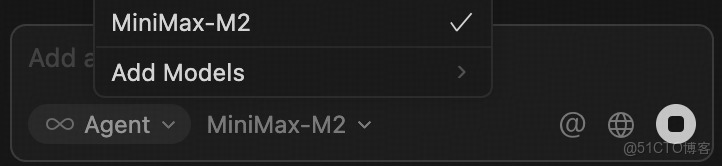

5. 啓用使用:選中剛添加的“MiniMax-M2”模型,在聊天面板切換到該模型,就能正常使用啦!

七、總結

現在就開啓你的AI落地之旅:

- 登錄AI Ping官網(aiping.cn),註冊就能獲取API Key;

- 直接用免費算力測試兩款模型,根據自己的業務場景選適配方案;

- 快速落地AI應用,體驗國產大模型的實力!