前言:從模型選型到工程落地,開發者為何需要 AI Ping

隨着大模型技術的飛速發展,開發者在模型選型、多平台調用適配及智能體搭建等環節面臨諸多痛點:性能評測缺乏客觀依據、不同供應商接口差異大導致開發效率低下、複雜場景下模型與業務需求難以精準匹配。在此背景下,AI Ping 平台應運而生,其整合大模型評測與一站式調用能力,為開發者提供全鏈路解決方案。本文將圍繞 AI Ping 平台展開,系統介紹其核心功能與價值,深入解析平台已實測上線的 GLM-4.7 與 MiniMax M2.1 兩款國產旗艦大模型的技術特點與性能表現,並詳細呈現基於 Dify 搭建智能體、在 Claude Code 中配置調用模型的實操流程,助力開發者高效完成模型選型、調用適配與智能體開發,充分釋放大模型技術在實際工程場景中的價值。邀請好友體驗 AI Ping,https://aiping.cn/#?channel_partner_code=GQCOZLGJ (註冊登錄立享30元算力金)

AI Ping 平台概覽:大模型評測 + 統一調用的一站式解決方案

AI Ping 是一款集大模型服務平台評測與一站式調用功能於一體的平台,被開發者稱為大模型 API 服務的大眾點評,平台圍繞開發者模型選型與高效調用兩大核心需求,構建專業評測體系與統一服務能力,助力開發者降本增效

- 提供7×24 小時持續評測與性能榜單,覆蓋數十家供應商數百個模型的延遲、吞吐、可靠性等關鍵指標,結合模型核心參數詳情頁,為選型提供客觀可驗證的依據,其數據支撐的排行榜獲權威機構認可

- 打造統一 API 接口與智能路由功能,開發者通過一個接口即可調用多平台模型,智能路由能根據業務需求與實時數據動態匹配最優供應商,兼顧高峯期服務穩定性與非高峯期成本優化

- 上線個人數據中心,提供清晰的 API 調用報表,涵蓋模型、供應商、Token 消耗及費用等信息,幫助開發者科學分析並優化成本投入

GLM-4.7 模型解析:面向 Agentic Coding 的工程級大模型

GLM-4.7 是智譜最新推出的大模型,主打Agentic Coding智能體編碼場景,強化了編碼能力、長任務規劃與工具協同能力,在公開基準榜單中表現領先;同時通用能力升級,回覆更簡潔自然、寫作沉浸感更強,執行復雜智能體任務時工具調用指令更精準,前端美感與長任務效率都有提升

- 基礎參數:支持 128K~200K 上下文長度,當前部分供應商提供平台限免

- 性能表現:SophNet 供應商支持 200K 全維度長度,吞吐 157.67 tokens/s、延遲 0.96s;PPIO 流膠雲支持 200K 上下文 / 輸入、128K 輸出,吞吐 59.77 tokens/s、延遲 2.76s,兩者可靠性均為 100%

- 調用方式:通過 AI Ping 統一接口調用,兼容 OpenAI Completion API,可由智能路由自動匹配最優供應商,也支持手動指定服務商

AI Ping給GLM-4.7也提供了調用API示例

from openai import OpenAI

openai_client = OpenAI(

base_url="https://www.aiping.cn/api/v1",

api_key="QC-759e8536f1db9d18ec4f3dcb1b90044d-a3629e8a3743d0b37cb56d677577c7e9",

)

response = openai_client.chat.completions.create(

model="GLM-4.7",

stream=True,

extra_body={

"provider": {

"only": [],

"order": [],

"sort": None,

"input_price_range": [],

"output_price_range": [],

"input_length_range": [],

"throughput_range": [],

"latency_range": []

}

},

messages=[

{"role": "user", "content": "Hello"}

]

)

for chunk in response:

if not getattr(chunk, "choices", None):

continue

reasoning_content = getattr(chunk.choices[0].delta, "reasoning_content", None)

if reasoning_content:

print(reasoning_content, end="", flush=True)

content = getattr(chunk.choices[0].delta, "content", None)

if content:

print(content, end="", flush=True)MiniMax M2.1 模型解析:高吞吐長上下文的多語言編程引擎

MiniMax-M2.1具備強大多語言編程能力的大模型,從 AI Ping 平台的展示信息可以看到它的核心特點

- 基礎參數:支持 200K 上下文長度,最大輸入 / 輸出長度均為 200K/192K,當前在部分供應商處提供免費 token 使用

- 性能表現:以 MiniMax 官方和七牛雲這兩個供應商為例,其吞吐分別達到 81.36 tokens/s、75.94 tokens/s,延遲則為 1.15s、2.29s,可靠性均為 100%

- 使用方式:可通過 AI Ping 的統一 API 接口調用(兼容 OpenAI 的 Completion API 格式),也支持在線對話,平台還提供了自動供應商路由功能,能根據性能動態匹配最優服務方

另外AI Ping 為 MiniMax-M2.1 提供兼容 OpenAI Completion API 規範的統一調用接口,可自動適配不同服務提供商的請求 / 響應格式,無需單獨適配原廠接口,同時支持對接 500 + 款模型與服務供應商。

from openai import OpenAI

openai_client = OpenAI(

base_url="https://www.aiping.cn/api/v1",

api_key="QC-759e8536f1db9d18ec4f3dcb1b90044d-a3629e8a3743d0b37cb56d677577c7e9",

)

response = openai_client.chat.completions.create(

model="MiniMax-M2.1",

stream=True,

extra_body={

"provider": {

"only": [],

"order": [],

"sort": None,

"input_price_range": [],

"output_price_range": [],

"input_length_range": [],

"throughput_range": [],

"latency_range": []

}

},

messages=[

{"role": "user", "content": "Hello"}

]

)

for chunk in response:

if not getattr(chunk, "choices", None):

continue

reasoning_content = getattr(chunk.choices[0].delta, "reasoning_content", None)

if reasoning_content:

print(reasoning_content, end="", flush=True)

content = getattr(chunk.choices[0].delta, "content", None)

if content:

print(content, end="", flush=True)基於 Dify 的智能體實戰:接入 GLM-4.7 與 MiniMax M2.1

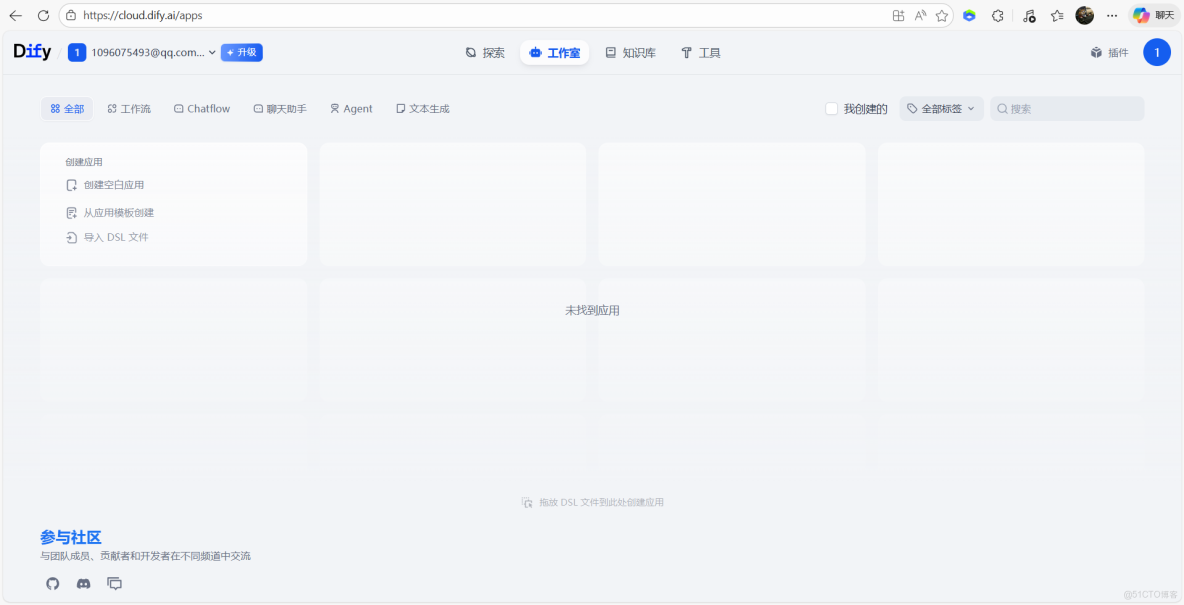

1、進入Dify平台

2、通過插件市場安裝:進入 dify 插件市場,搜索AI Ping,進行安裝

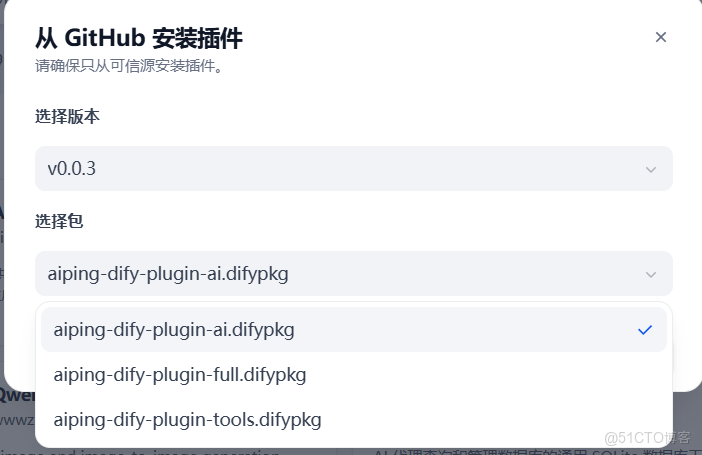

3、通過 github 安裝:點擊 dify 插件頁中的安裝插件,選擇通過 github 安裝

4、選擇版本和安裝包

5、按照成功

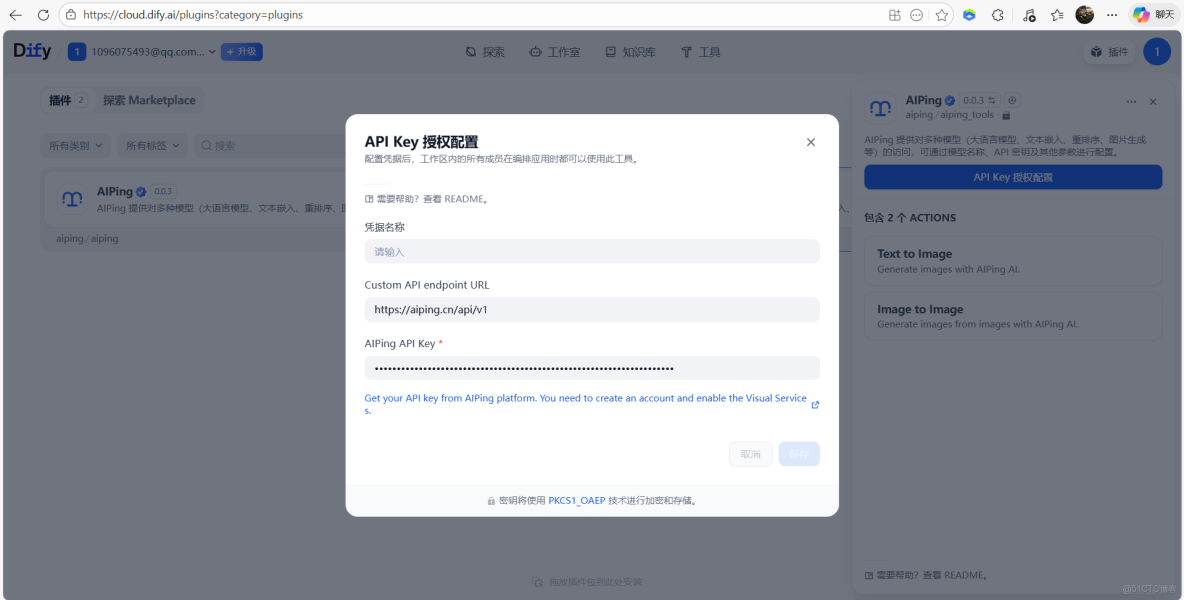

6、AI Ping官網獲取API Key

7、API Key 配置

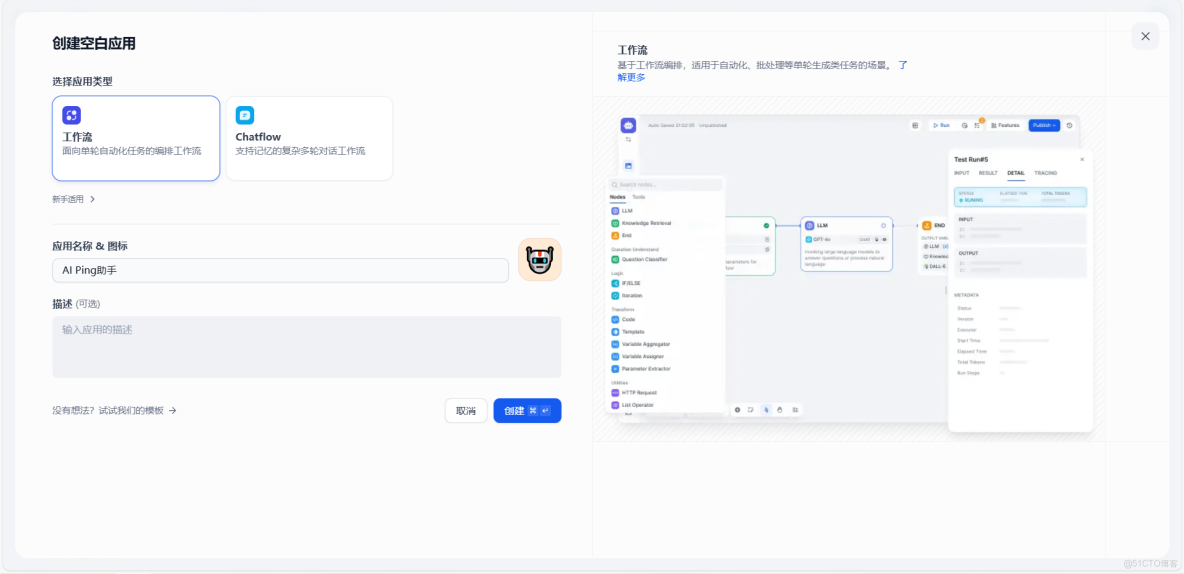

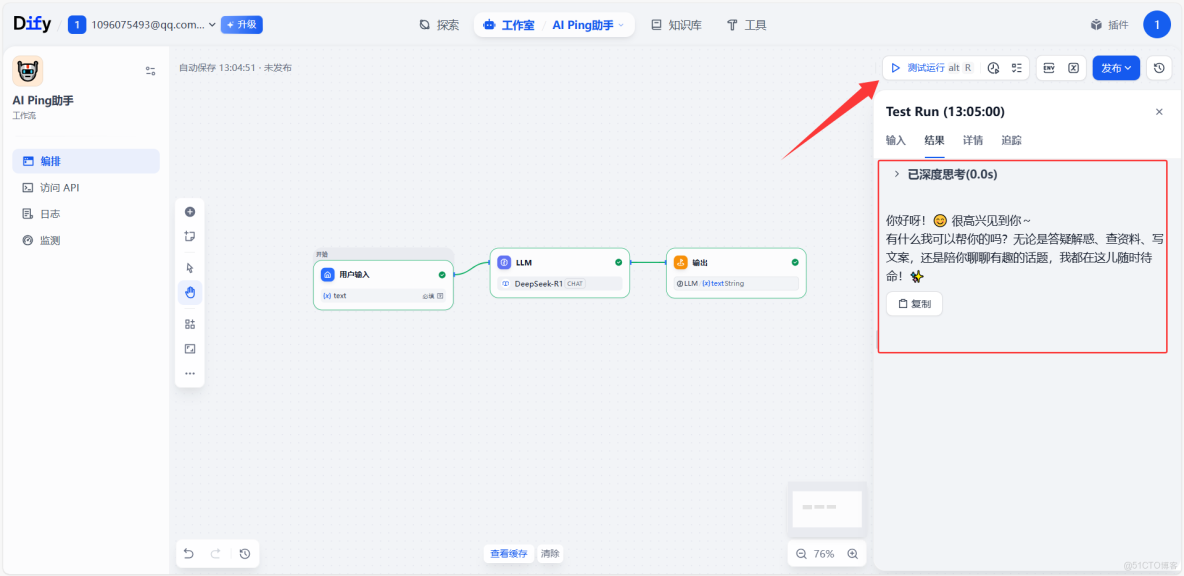

9、工作流搭建測試,配置空白應用

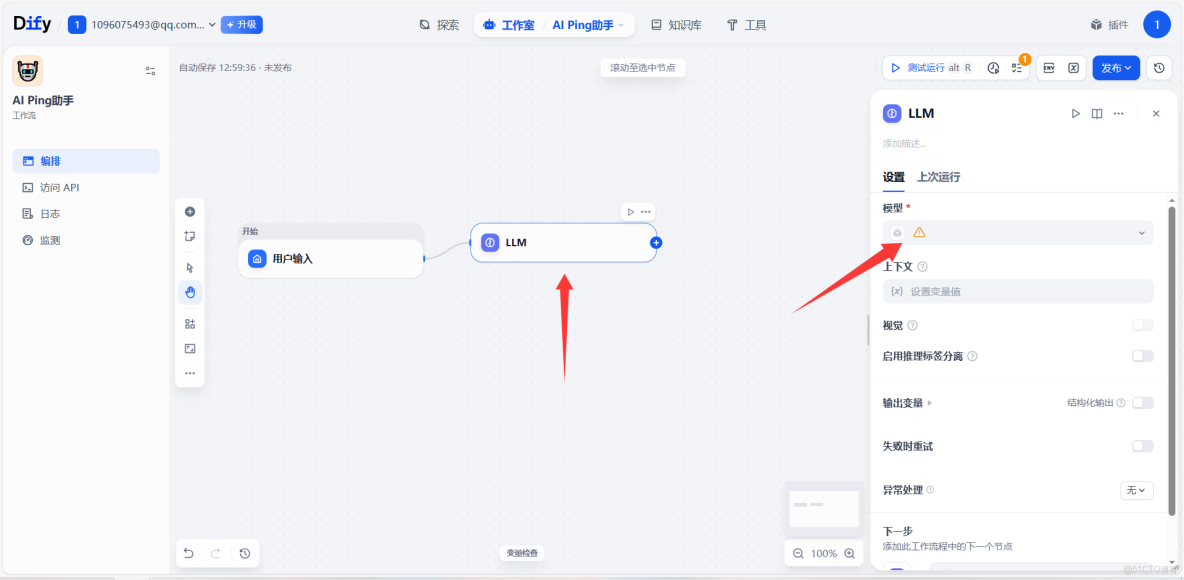

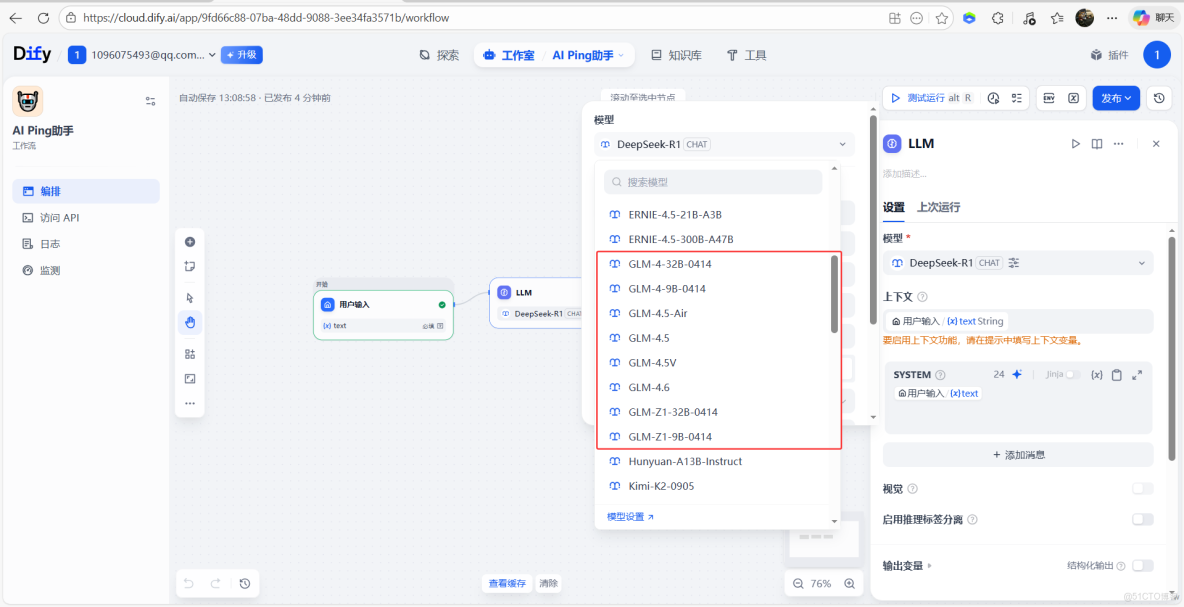

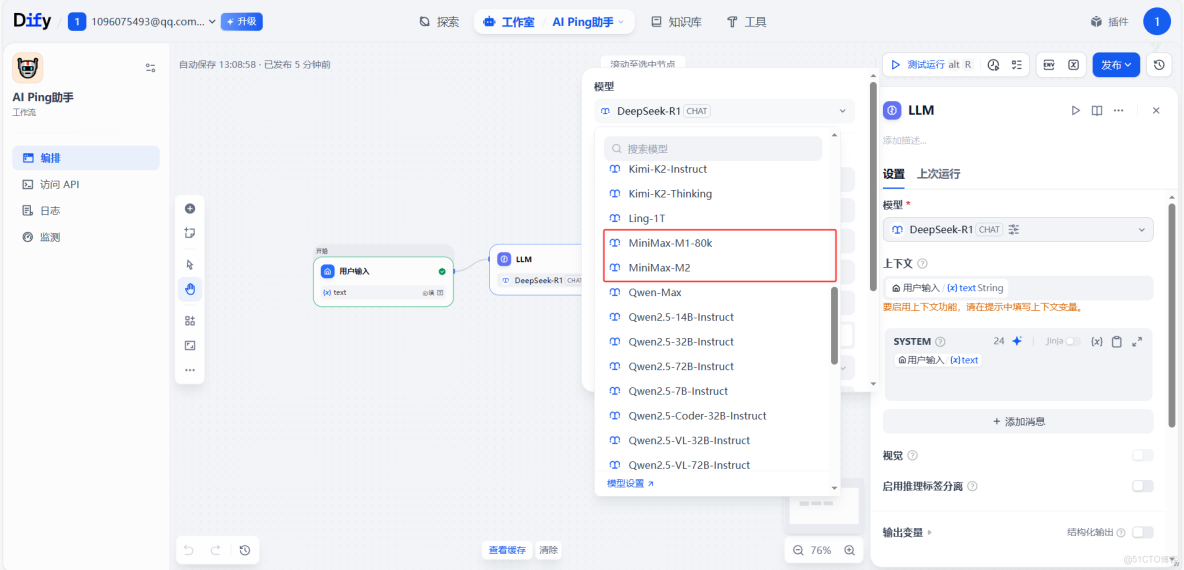

10、添加LLM節點,選擇模型

11、可以看到模型有需要可以根據自己的需要選擇合適的模型

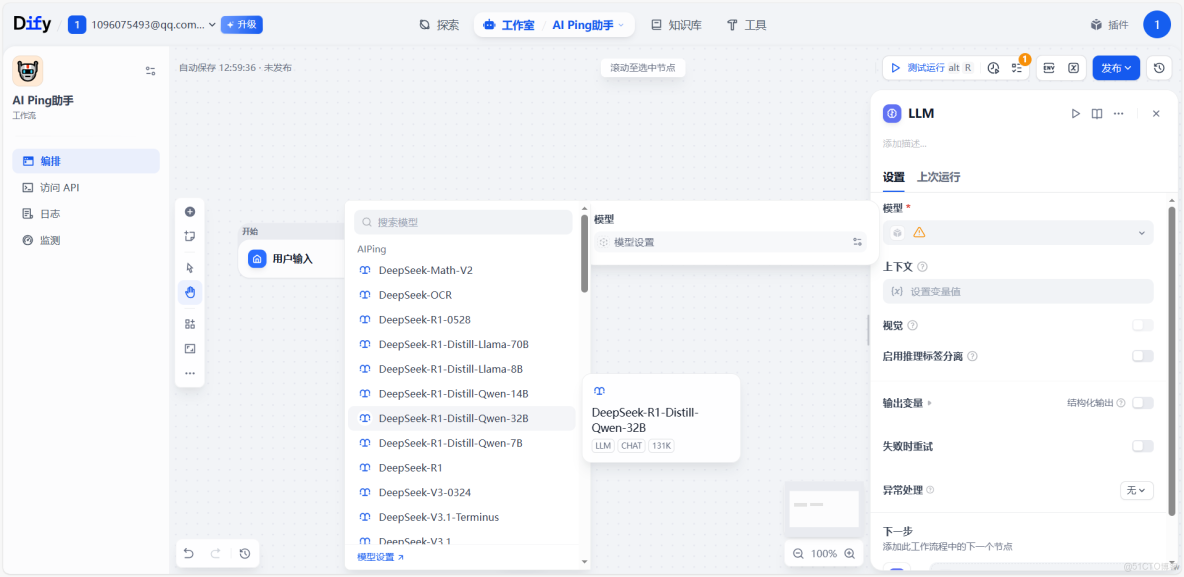

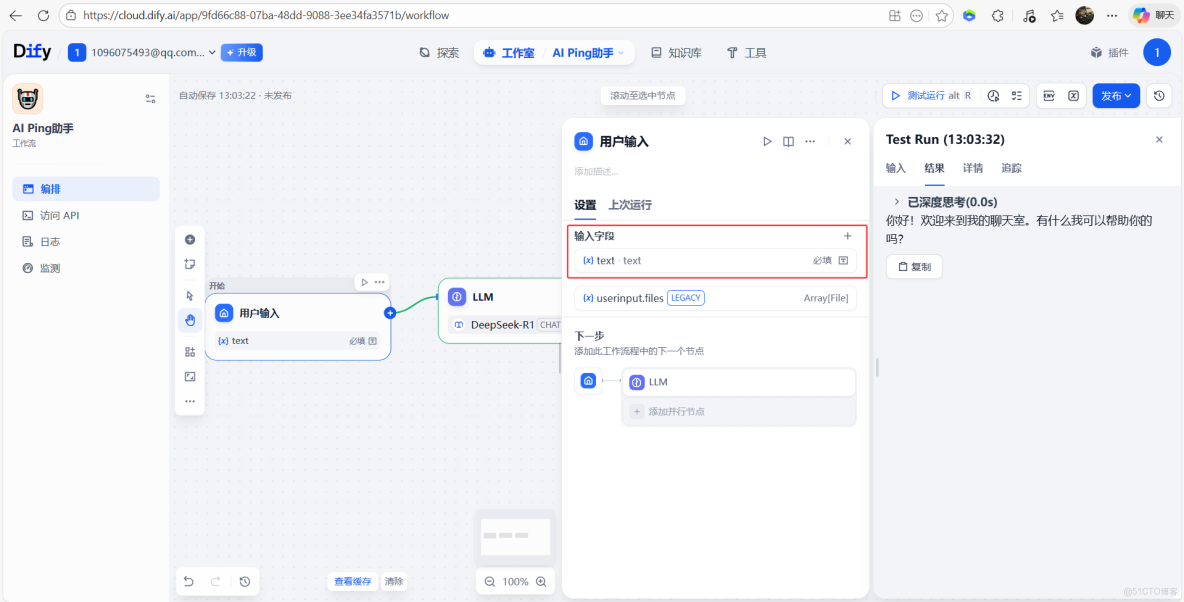

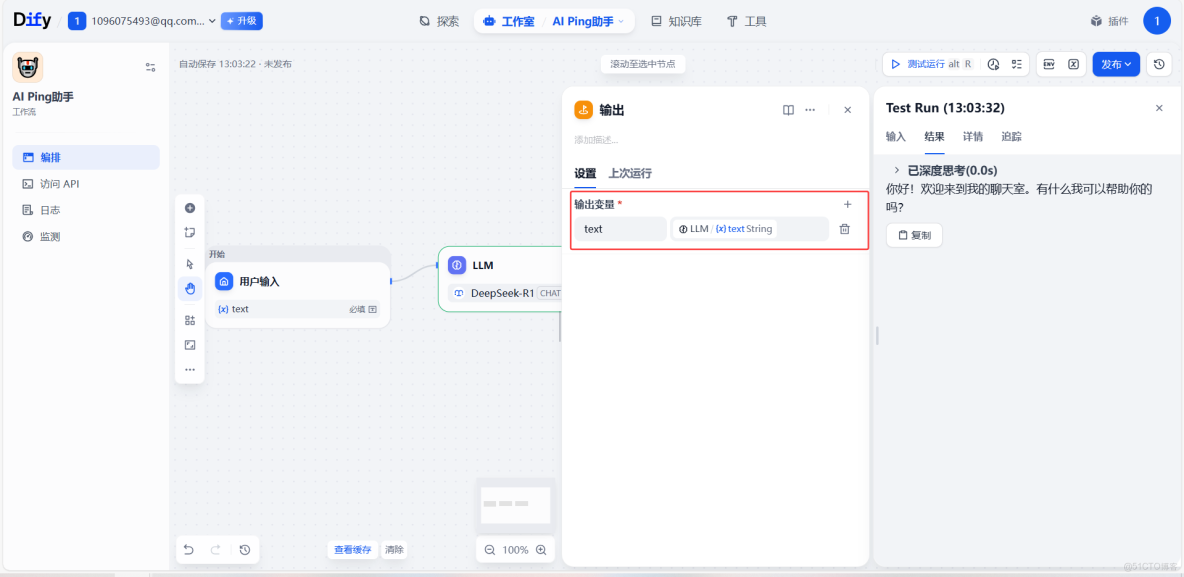

12、輸入字段配置、LLM上下文配置、輸出配置

13、測試輸出

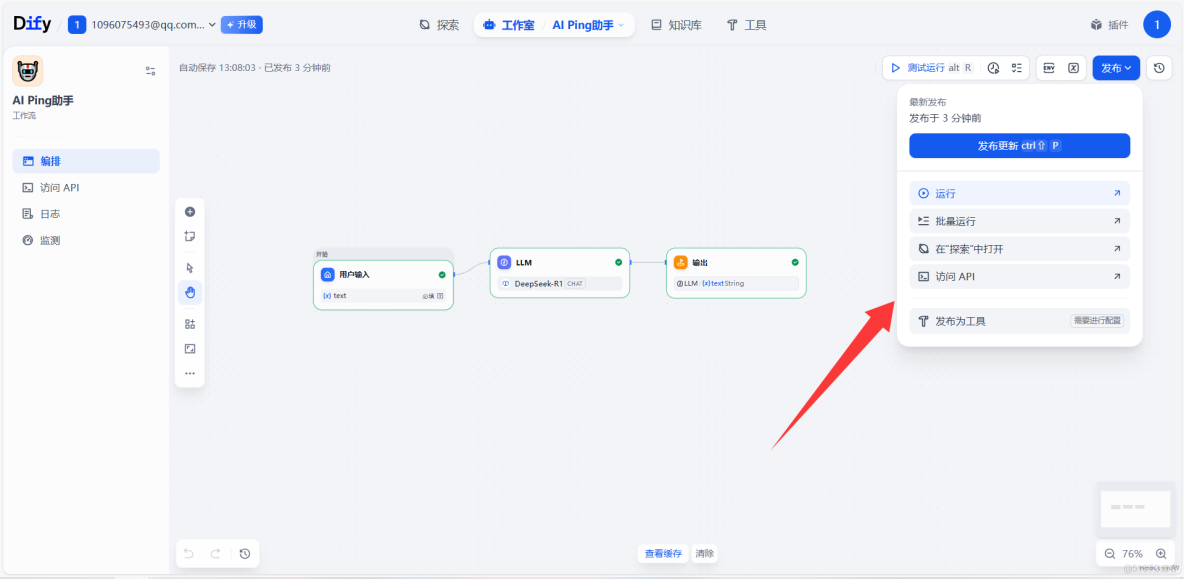

14、搭建好的Agent可以發佈到市場,可以根據需求打造自己的智能體,AI Ping可以一鍵管理各大模型,文生圖,文本輸出都應有盡有

15、GLM-4.7和MiniMax M2.1 也提供了最新的支持

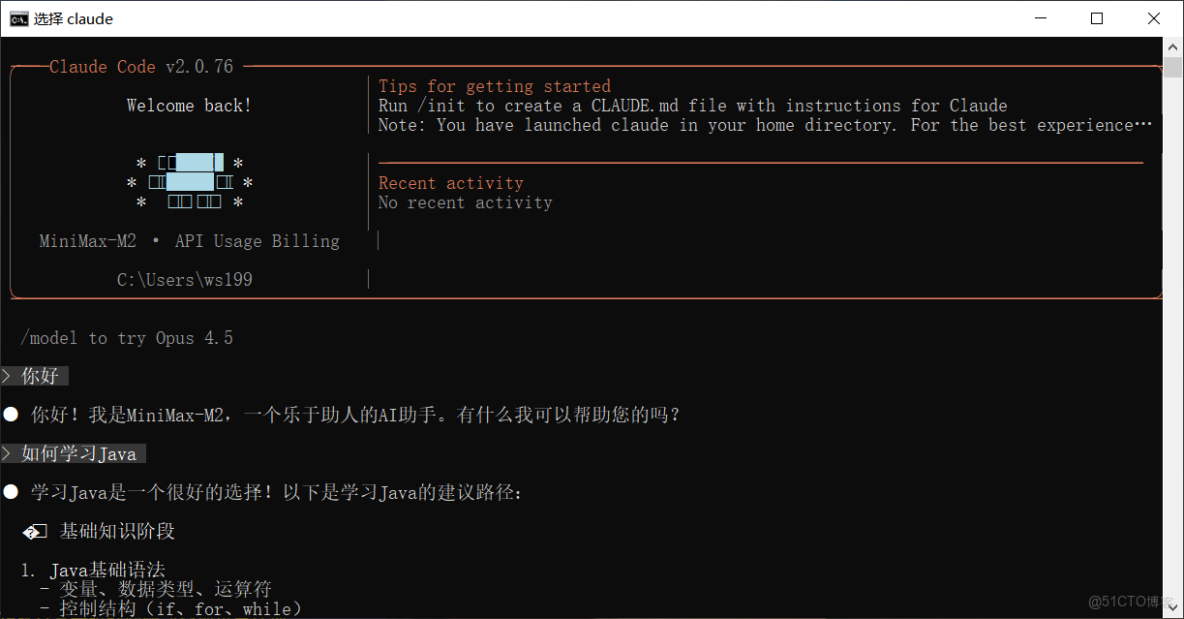

Claude Code 接入實戰:通過 AI Ping 調用 MiniMax M2.1

系統需求

- 操作系統:macOS 10.15 及以上、Ubuntu 20.04+/Debian 10+ 或 Windows 10+(支持 WSL 1、WSL 2 或 Windows 版 Git)

- 硬件配置:內存 4 GB 及以上

- 軟件依賴:Node.js 18+

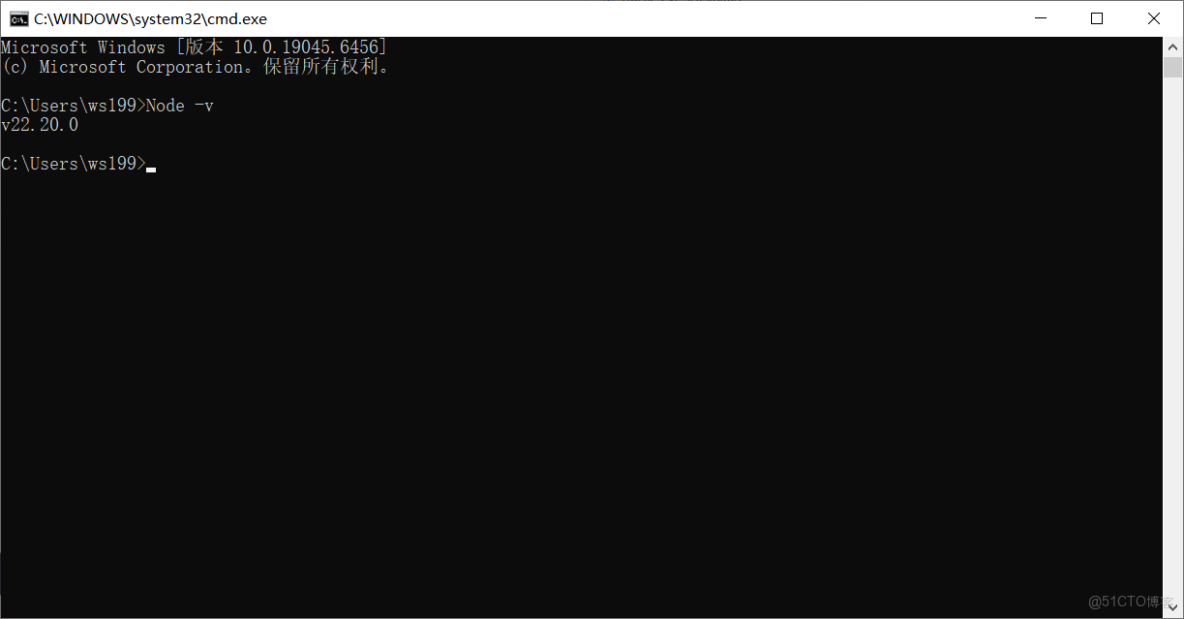

1、檢查node版本是否符合條件

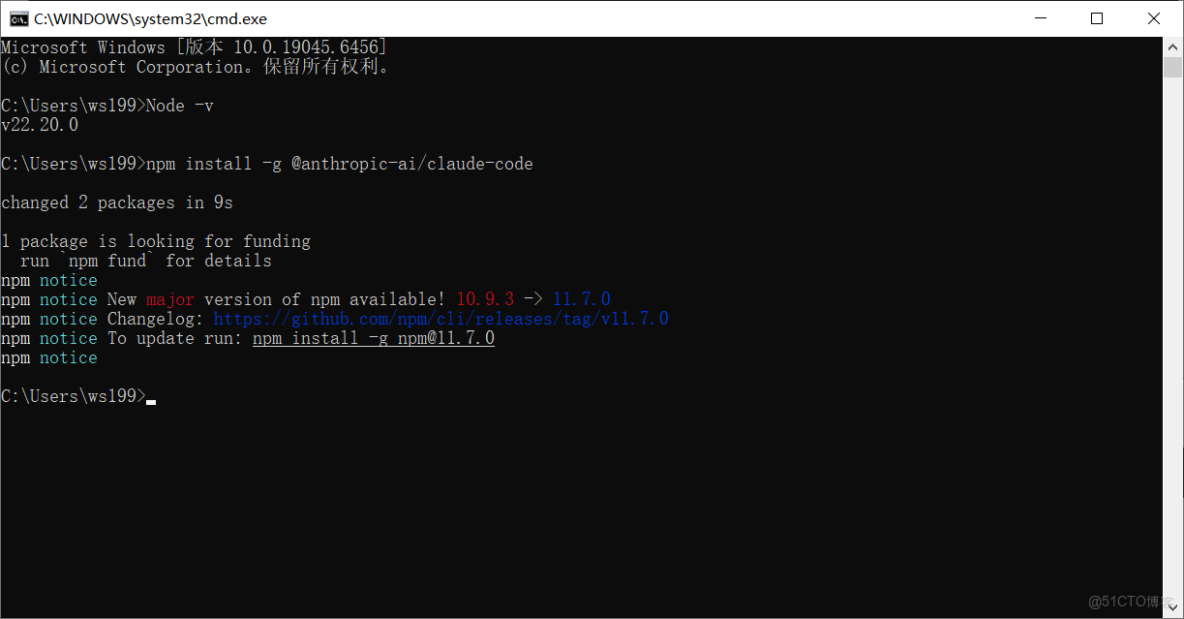

Node -v2、下載Claude Code

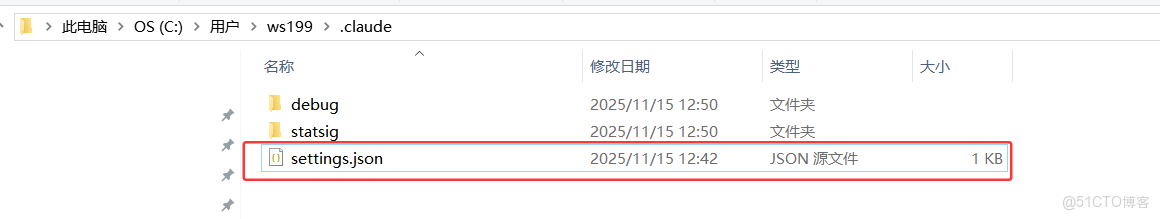

npm install -g @anthropic-ai/claude-code3、找到settings.json文件配置API KEY

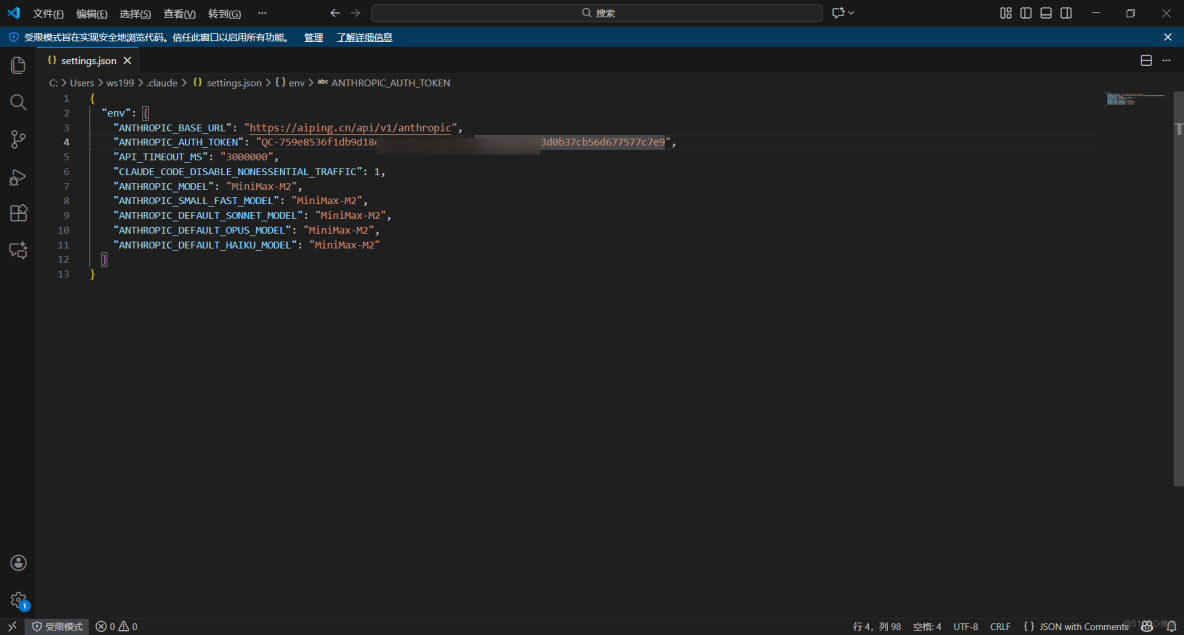

4、按照官方做法配置文件settings.json

{

"env": {

"ANTHROPIC_BASE_URL": "https://aiping.cn/api/v1/anthropic",

"ANTHROPIC_AUTH_TOKEN": "<YOUR_API_KEY>",

"API_TIMEOUT_MS": "3000000",

"CLAUDE_CODE_DISABLE_NONESSENTIAL_TRAFFIC": 1,

"ANTHROPIC_MODEL": "MiniMax-M2",

"ANTHROPIC_SMALL_FAST_MODEL": "MiniMax-M2",

"ANTHROPIC_DEFAULT_SONNET_MODEL": "MiniMax-M2",

"ANTHROPIC_DEFAULT_OPUS_MODEL": "MiniMax-M2",

"ANTHROPIC_DEFAULT_HAIKU_MODEL": "MiniMax-M2"

}

}5、配置完成後,進入工作目錄,在終端中運行 claude 命令以啓動 Claude Code,啓動後,選擇 “信任此文件夾 (Trust This Folder)”,以允許 Claude Code 訪問該文件夾中的文件,隨後開始在 Claude Code 中使用 MiniMax-M2

GLM-4.7 vs MiniMax M2.1:工程能力與 Agent 場景對比

GLM-4.7 與 MiniMax M2.1 兩款國產旗艦大模型已在 AI Ping 平台實測上線,前者聚焦複雜工程任務的穩定交付與工具協同,支持推理強度按需調節,後者依託高效 MoE 架構強化多語言工程能力與長鏈 Agent 執行效率,二者均跳出單輪生成質量維度,指向真實場景的長期穩定運行需求;平台已接入多家供應商,提供性能數據可視化、多供應商統一接口調用及智能路由功能,用户可查看吞吐、延遲、可靠性等核心指標並靈活切換供應商,無需重複接入維護,高效驗證適配自身業務的模型與調用方案。

面向真實工程的編碼能力

- GLM-4.7 強調複雜任務的穩定完成與工程交付

- MiniMax M2.1 系統強化 Rust / Go / Java / C++ 等多語言工程,服務真實生產代碼

Agent 與工具調用導向

- GLM-4.7 通過可控思考機制提升多步任務穩定性

- MiniMax M2.1 通過高效 MoE 與收斂推理路徑,適合連續編碼與長鏈 Agent 執行

長期運行下的效率與成本權衡

- GLM-4.7 支持推理強度按需調節,在準確率與成本間靈活取捨

- MiniMax M2.1 以低激活參數與長上下文優勢,提升吞吐與持續運行效率

總結:AI Ping 如何打通大模型選型、調用與智能體落地

本文聚焦集大模型評測與一站式調用於一體的AI Ping 平台,介紹其 7×24 小時性能評測、統一 API 接口、智能路由及成本分析核心能力,詳解平台已上線的 GLM-4.7主打複雜工程任務交付與工具協同與 MiniMax M2.1強化多語言編碼與長鏈 Agent 執行兩款國產旗艦模型的參數、性能及調用示例,並提供基於 Dify 搭建發佈智能體、在 Claude Code 中配置接口調用模型的實操方案,打通大模型選型、調用與智能體開發全鏈路

- 平台能力一體化:集成 7×24 小時大模型性能評測、統一 API 調用、智能路由及成本分析功能,一站式解決開發者模型選型與高效調用需求

- 模型支撐精準化:提供 GLM-4.7複雜工程任務交付 + 工具協同與 MiniMax M2.1多語言編碼 + 長鏈 Agent 執行兩款國產旗艦模型,覆蓋不同業務場景的核心需求

- 實操鏈路全打通:配套 Dify 智能體搭建發佈、Claude Code 接口配置調用的完整實操方案,實現從模型選型到智能體開發的全流程落地