Coze 工作流大進化:接入 AIPing 免費接口,打造硬核 C++ 後端分析專家

前言:

全體開發者請注意,這波“算力羊毛”真的要薅禿了![平台名稱] 剛剛放出了年末最強更新:不僅一次性上線了兩款業內公認的最強國產大模型,更把“誠意”直接寫在了激勵機制裏——只要參與,就能無門檻獲取 **[具體額度]**的通用算力點數。

當你還在為昂貴的 API 調用費糾結時,先行者已經通過這波推廣紅利實現了“算力自由”。今天我不聊虛的,直接手把手教你如何高效複用這些頂尖模型,並利用規則最大化你的獎勵收益。乾貨在後頭,建議先贊後看!

一、AI Ping 平台詳細介紹

AI Ping 是一款專為開發者設計的 AI 模型聚合與算力分發平台。它的核心定位是打破不同大模型廠家的 API 牆,讓開發者通過統一的接口、更低的成本、更快的速度,實現“算力自由”。

1.1 核心定位:開發者的一站式“模型武器庫”

AI Ping 的本質是一個 MaaS(模型即服務)聚合平台。

- 模型聚合技術: 它不生產大模型,而是將市面上最頂尖的模型(如智譜 AI、MiniMax、DeepSeek、OpenAI、Anthropic 等)集成在一起。

- 統一接口: 開發者無需去每家公司申請 API Key,只需接入 AI Ping,即可調用全網主流模型。這極大地降低了多模型集成的開發工作量。

1.2 技術優勢:快、穩、硬

圖片中特別提到了“2 倍速的推理快感”和“深度思考的編程邏輯”,這揭示了該平台的幾項關鍵技術指標:

- 高併發與低延遲: 平台通過自研的路由調度算法,將請求分發至負載最低的算力節點。對於開發者來説,最直觀的感受就是 Token 的吐出速度比直接調用原廠 API 更快。

- 深度適配最新旗艦: * 智譜 GLM-4.7: 這是 2025 年 12 月發佈的頂尖開源/閉源增強版,專為 Agent(智能體)和 Coding(編程) 場景優化,具備極強的代碼生成和長程任務規劃能力。

- MiniMax M2.1: 同樣是 12 月底發佈,該模型系統性提升了多語言編程(C++、Rust、Go等)能力,並引入了 Interleaved Thinking(交織思考機制),在處理複雜邏輯時更具“人腦感”。

1.3 核心功能模塊

- 算力中心: 提供通用的算力點數(通用算力點)。這種點數不限模型,開發者可以用同樣的點數調用 GLM,也可以切換到 MiniMax,避免了各家充值無法互通的尷尬。

- 模型實驗室: 允許開發者對不同模型進行“同台競技”測試,對比在同一 Prompt 下各模型的推理質量和 Token 消耗。

- 開發者工具集: 兼容 OpenAI、Anthropic 等主流協議,支持直接接入 Cursor、VS Code、Claude Code 等 IDE 插件。

二、上新模型深度剖析

2.1 GLM-4.7:國產最強開源編程旗艦

智譜 AI 發佈的 GLM-4.7 是其最新一代旗艦級開源模型,在編程和長程規劃能力上實現了跨越式提升。

- 性能標杆: 在全球權威的編碼評估系統 Code Arena 中,GLM-4.7 位列開源模型第一、國產模型第一,其表現甚至超越了 GPT-5.2。

- Agentic Coding(智能體編程): 該模型不再只是簡單的代碼生成,而是具備了端到端的開發能力。它能理解複雜的業務邏輯,自主規劃長程任務,並協同多個工具(如瀏覽器、代碼解釋器)完成複雜的工程級交付。

- 前端與視覺理解: 針對前端場景進行了深度調優,支持“截圖即代碼”,生成的頁面在佈局、交互和審美上已接近直接可用的水平。

- 技術參數: 支持 128K~200K 的超長上下文窗口,能夠一次性處理大規模的代碼庫或長文檔。

2.2 MiniMax-M2.1:為 Agent 與多語言協作而生

由 MiniMax 推出的 M2.1 是一款極其強調 “交錯思考”(Interleaved Thinking) 的模型,在多語言編程和執行效率上表現驚人。

- 交錯思考機制(核心亮點): M2.1 原生支持在每一輪工具調用(Tool Use)前,先根據環境反饋進行思考再決策。這種“先思考、再行動”的模式極大地提升了 Agent 運行的穩定性,使其在複雜辦公和編程流中更像“真人”。

- 卓越的多語言能力: 不同於傳統模型側重 Python,M2.1 系統性提升了 C++、Rust、Java、Golang、TypeScript 等多種主流語言的性能,覆蓋了從底層系統到應用層開發的完整鏈路。

- 極致性價比: 採用高效的 MoE(混合專家)架構(總參數 230B,激活參數僅 10B),其推理速度是 Claude 3.5 Sonnet 的 2 倍,而成本大幅下降。

- 全球排名: 在第三方評測 Artificial Analysis 中,M2 綜合分位列 全球前五、開源第一,成功躋身全球大模型第一梯隊。

2.3 模型對比總結

|

特性 |

智譜 GLM-4.7 |

MiniMax-M2.1 |

|

核心優勢 |

編程基準測試(Code Arena)全球頂尖,工程交付能力強

|

“交錯思考”機制,Agent 工具調用極穩

|

|

編程強項 |

Python、前端代碼美學、代碼解釋器協同

|

Rust/Java/C++ 等多語言全鏈路協作

|

|

上下文 |

128K ~ 200K

|

200K

|

|

適用場景 |

複雜工程代碼生成、自動化 PPT/文檔製作

|

連續工作流 Agent、高性能多語言後台開發

|

三、agent(coze)平台絲滑接入AI Ping

3.1 查找AIPing-official-plugin插件

- 進入 coze 插件市場,搜索“AIPing-official-plugin”(點擊插件詳情頁,可以進行“收藏”)

3.2 創建一個工作流

- 點擊項目開發就可以啦

3.3 設置參數

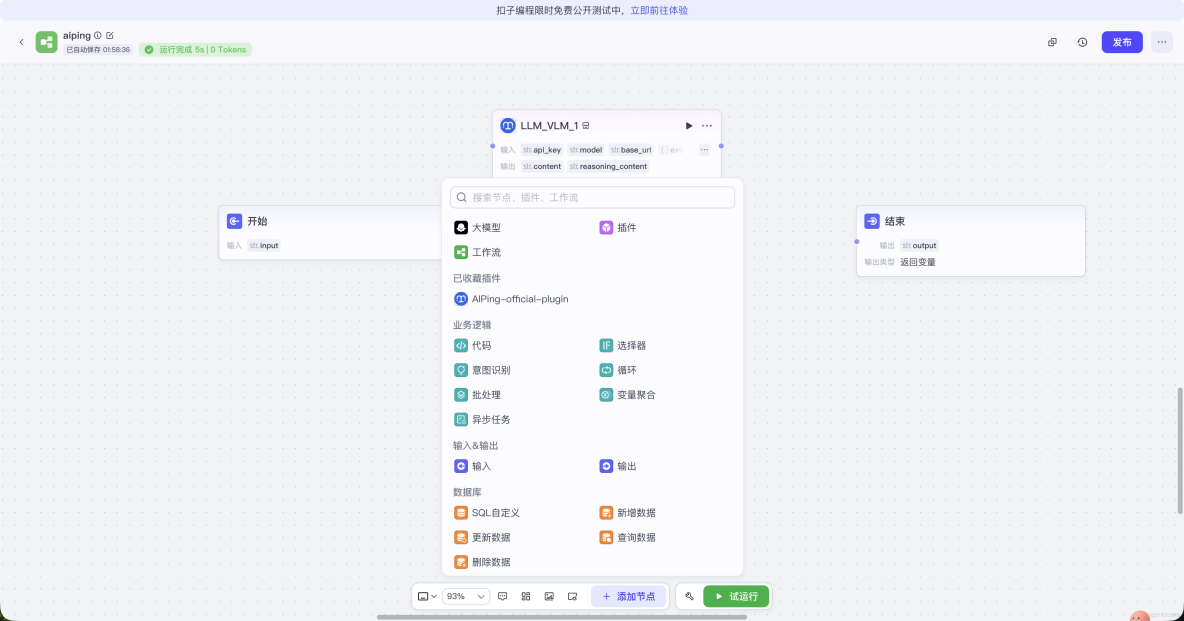

- 點擊添加節點,進行插件選擇

- 配置好信息: api-key model等等

3.4 驗證可行性

- 技術鏈路可行性:極高 (Seamless Integration)

- 協議兼容性: AIPing 提供的 Base URL (

https://aiping.cn/api/v1) 和 API Key 能夠直接填入 Coze 的 HTTP 插件或自定義 LLM 節點中。這説明 AIPing 完美兼容 OpenAI 標準協議。 - 模型調用: 你成功在 Coze 中驅動了 MiniMax-M2.1。從輸出結果看,模型對 C++23

std::coroutine與 Gogoroutine的底層差異(如棧分配、調度機制)給出了深入的分析,這證明了這種鏈路在處理硬核技術問題時的生產力。

- 算力成本可行性:滿分 (Cost-Effective)

- 限時紅利: 第一張圖片顯示 GLM-4.7 和 MiniMax-M2.1 目前在 AIPing 上處於 “限時免費” 狀態(輸入輸出均為 ¥0/M)。

- 零成本擼 Agent: 傳統的 Coze 官方模型(如 GPT-4)可能消耗平台點數,而通過 AIPing 中轉這種“限時免費”的旗艦模型,你可以零成本構建具備極強編程能力的 Agent,非常適合學生和獨立開發者進行大規模壓力測試或構建複雜應用。

四、總結

一、 雙旗艦模型:精準對標開發需求

|

維度

|

GLM-4.7 (智譜 AI)

|

MiniMax M2.1

|

|

核心基因 |

Agentic Coding:專為智能體自主編程設計 |

多語言專家:橫跨 C++、Rust、Go 等全棧語言 |

|

技術殺手鐗 |

Artifacts 預覽:支持前端代碼實時渲染與交互 |

MoE 高效架構:極速響應,支持 200K 超長上下文 |

|

實戰表現 |

擅長處理從需求分析到工程交付的全鏈路任務

|

擅長深度邏輯拆解(如 C++23 與 Go 協程底層對比) |

二、 平台硬實力:為什麼選擇 AI Ping?

- 極簡集成:提供標準的 OpenAI 兼容接口,僅需更換

Base URL和API Key即可在 Coze 中一鍵驅動頂級算力。 - 數據透明:實時監控每一條請求的吞吐量、延遲及穩定性,讓開發者對模型性能有“上帝視角”。

- 零元白嫖:GLM-4.7 與 MiniMax M2.1 目前開啓限時免費(輸入輸出 ¥0/M),是進行壓力測試和構建原型機的最佳時機。

- 福利回饋:通過專屬邀請鏈路,好友雙方均可鎖定 20 元通用算力點,輕鬆應對後續收費模型的調用需求。