在機器學習中,人們常常驚歎於深度神經網絡在圖像、語音和自然文本領域的突破性表現。然而,當問題回到表格化的結構化數據時,一種看似“樸素”的模型類型——樹模型(Tree-based Model)——卻長期佔據主導位置。從工業設備故障診斷到電子商務推薦系統,樹模型的表現常常超過複雜的深度學習架構。為什麼這種層級劃分的模型能夠在結構化數據上展現出如此強大的效能?這不僅是一個關於模型選擇的問題,更是關於數據本質與算法機制的思考。

理解這一問題,需要從三個維度展開:結構化數據的統計與信息特性、樹模型的結構與歸納偏好(inductive bias),以及兩者之間的深度匹配機制。樹模型的成功並非偶然,而是數學結構、計算策略與現實數據規律的契合產物。

1. 結構化數據的本質與統計特徵

結構化數據(Structured Data)通常以表格形式出現,每一行對應一個樣本,每一列對應一個特徵。與連續信號或圖像不同,結構化數據的特徵往往具有高度異質性,這對建模提出了特殊要求。具體特性如下:

1.1 特徵異質性(Feature Heterogeneity)

在結構化數據中,特徵類型可能包括連續數值、離散類別、布爾值或日期等。例如,金融數據中可能包含收入(連續值)、信用等級(離散類別)、是否有貸款歷史(布爾值)等。對於神經網絡或線性模型,異質特徵通常需要歸一化或嵌入處理,而樹模型通過節點劃分即可直接處理不同類型特徵。

1.2 非線性交互(Nonlinear Interaction)

特徵之間往往有複雜的交互效應。例如,貸款審批結果可能不僅取決於收入

其中

1.3 稀疏性與信息分佈不均(Sparsity and Imbalanced Information)

在許多應用中,部分特徵對目標變量有顯著影響,而其他特徵幾乎無關。例如,信用評分可能主要依賴信用歷史長度和收入,而教育背景或性別貢獻較小。信息量的差異可以用熵來量化,對於分類問題,特徵

其中

1.4 樣本量與噪聲敏感性

結構化數據在實際應用中,樣本量往往有限,這增加了模型對噪聲敏感性。如果模型複雜度過高,則容易過擬合。樹模型通過限制樹深、最小劃分樣本數或葉節點樣本數,可以在偏差與方差之間達到動態平衡。

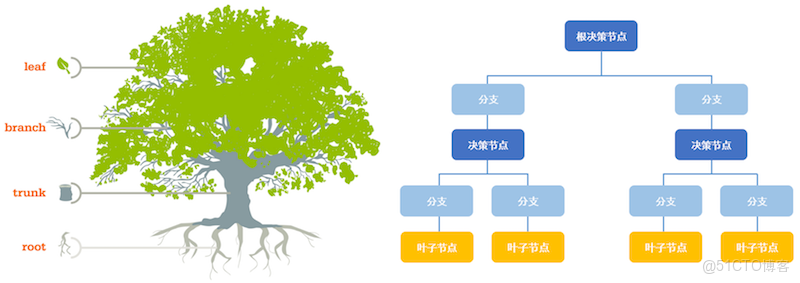

2. 樹模型的核心原理

樹模型(Tree-based Model)通過遞歸劃分特徵空間,將複雜的輸入映射問題轉化為一系列局部決策。最基礎的形式是決策樹(Decision Tree)。

2.1 節點劃分機制

每個非葉節點選擇一個特徵

劃分的目標是最大化子集的純度。在分類任務中,可以使用信息增益或基尼係數(Gini Index)作為純度度量:

其中

樹模型會選擇劃分

2.2 樹的遞歸構建

劃分操作在每個子節點遞歸進行,直到滿足中斷條件,例如:

- 樹達到最大深度

;

- 節點樣本數少於最小閾值

;

- 劃分無法顯著降低方差或提升純度。

樹的最後葉節點輸出預測值

- 分類:葉節點取多數類別

- 迴歸:葉節點取平均值

2.3 樹模型的優點

樹模型具備多項天然優勢:

- 非線性建模能力:遞歸劃分可以捕獲複雜的非線性關係。

- 異質特徵處理:無需歸一化或嵌入。

- 魯棒性:對異常值和缺失值敏感性低。

- 可解釋性:每個劃分條件清晰明確,可追蹤決策路徑。

然而,單棵樹容易過擬合,因此通常需要集成方法(Bagging、Boosting)提升穩定性和泛化能力,這將在後續章節詳細討論。

3. 集成學習:從單棵樹到強學習器

樹模型的真正價值,來自於集成(Ensemble)。通過將多棵弱學習器(單樹)組合,可以顯著提升性能。兩種最核心的集成策略是 Bagging 和 Boosting。

3.1 Bagging與隨機森林(Random Forest)

Bagging(Bootstrap Aggregating)的思想是:從原始數據集中多次有放回採樣,訓練多棵獨立的樹,然後對它們的預測取平均或投票。

隨機森林(Random Forest, RF)在Bagging的基礎上進一步引入特徵隨機性:每次劃分時隨機選擇部分特徵供決策。這種隨機性降低了各樹之間的相關性,提高了整體泛化能力。

Bagging的本質是方差縮減。假設每棵樹的預測誤差方差為

3.2 Boosting與梯度提升(Gradient Boosting)

Boosting通過迭代修正殘差的方式逐步提升性能。以梯度提升樹(Gradient Boosted Decision Tree, GBDT)為例:

- 初始模型

是常數;

- 在第

次迭代中,計算殘差:

其中

是損失函數;

- 訓練一棵新樹

來擬合殘差;

- 更新模型:

其中

是學習率。

Boosting相當於在函數空間上進行梯度下降,每棵樹是對損失函數負梯度方向的一步近似。這使得GBDT在偏差與方差之間達到動態平衡。

現代實現如 XGBoost、LightGBM、CatBoost,通過高效的特徵劃分算法、梯度直方圖、正則化與並行優化,將樹模型推向工業級水準。

4. 結構化數據與樹模型的“匹配原理”

為什麼樹模型在結構化數據上比神經網絡更有效?原因可以總結為以下幾點匹配機制:

4.1 劃分結構與特徵異質性匹配

樹模型在每次劃分中只選擇一個特徵,而不是同時處理所有特徵。這種“局部聚焦”結構天然適合處理特徵分佈各異的數據。例如,某些特徵為類別型,某些為連續型,樹劃分過程無需特徵標準化或嵌入變換。

4.2 非線性交互的自動發現

樹模型通過遞歸劃分,可以隱式捕獲複雜的特徵交互。例如,樹的不同路徑代表了不同的特徵組合邏輯條件。與神經網絡中依賴多層非線性組合不同,樹模型的特徵交互是離散且明確的。

4.3 局部決策的可解釋性

每個節點的決策條件清晰,形成可追溯的邏輯鏈。對結構化數據而言,可解釋性至關重要,尤其在金融等高監管領域。

4.4 稀疏性與信息增益機制的契合

信息增益(Information Gain)衡量劃分後純度的提升,這種機制會自動聚焦在最具預測力的特徵上。對於特徵冗餘或稀疏的結構化數據,樹模型能自動“忽略”噪聲特徵,而神經網絡往往需要正則化或特徵篩選。

4.5 樣本規模與泛化能力的平衡

深度神經網絡在低樣本量下容易陷入過擬合,而樹模型的劃分規則具備較強的統計約束,使其在中小數據集上表現優越。Boosting中的學習率與樹深控制了學習的步長和複雜度,進一步平衡偏差與方差。

5. 樹模型與神經網絡的對比分析

從理論視角看,神經網絡與樹模型的歸納偏好完全不同。神經網絡傾向於逼近連續函數,而樹模型逼近分段常數函數。若結構化數據的特徵之間缺乏空間連續性,分段結構反而更加高效。

|

比較維度

|

樹模型

|

神經網絡

|

|

數據類型

|

異質、稀疏、低維

|

連續、平滑、高維

|

|

特徵處理

|

自動離散化

|

需要歸一化、嵌入

|

|

交互建模

|

自動條件組合

|

隱式學習,需大樣本

|

|

訓練複雜度

|

中等

|

較高

|

|

可解釋性

|

強

|

弱

|

|

對樣本量敏感性

|

穩定

|

需要大數據

|

有趣的是,近年來也出現了“神經樹融合”類模型,如DeepGBM、TabNet、NODE等,它們嘗試讓神經網絡在表格數據上學習樹模型的離散結構,但其性能仍難以全面超越高優化度的GBDT。這反映出樹模型的結構優勢並非僅是計算結果,而是源於統計規律的深層適配。

6. 數學視角:劃分空間與貝葉斯解釋

從貝葉斯視角看,樹模型實際上在做條件分佈的分塊逼近。假設數據服從聯合分佈

這種分塊近似在結構化數據中極其有效,因為特徵間往往沒有連續性假設。相比之下,神經網絡的連續映射假設:

隱含了光滑性(smoothness),而表格數據的真實映射可能是高度不連續的。例如,貸款是否批准的決策可能因“信用等級=A級”與“B級”而驟變,樹模型可直接表示這種非連續性。

7. 工業實踐與算法優化

在工業實踐中,樹模型不僅性能強,還具有極高的計算效率與可部署性。以下是關鍵優化方向:

- 基於直方圖的劃分搜索(Histogram-based Split Finding): 將連續特徵離散化,大幅減少計算複雜度;

- 葉節點正則化: XGBoost在目標函數中引入正則項:

控制模型複雜度;

- 高效並行與GPU加速: LightGBM的基於梯度的單邊採樣(GOSS)與直方圖差分算法顯著加速訓練;

- 類別特徵編碼: CatBoost通過有序目標統計編碼(Ordered Target Encoding)有效處理類別變量,避免目標泄露。

這些優化不僅提高了性能,也確保了模型在工業規模數據集上的可擴展性。

8. 結論

樹模型在結構化數據上表現卓越,源於它在統計規律、算法結構與信息特性的高度契合。它通過層次化劃分自然適應特徵異質性,通過信息增益機制實現局部最優決策,通過集成學習策略平衡偏差與方差。神經網絡擅長連續映射,而樹模型擅長離散劃分;前者適用於感知任務,後者適用於邏輯性強的決策系統。

在機器學習的譜系中,樹模型是一種“結構化理性”的象徵。它不依賴大規模數據或複雜參數,而是通過精確劃分與統計一致性,在現實世界的結構化信息中挖掘出規律性的核心。