一、初識SQLDatabaseToolkit

SQLDatabaseToolkit 是 LangChain 框架中的一個核心組件,它不屬於一個獨立的軟件,而是一個工具箱或工具集。它的核心目的是為大語言模型提供與 SQL 數據庫進行交互的能力,將大模型的自然語言理解能力與數據庫的精準數據存儲和檢索能力結合起來。

二、什麼是SQLDatabaseToolkit

1. 基礎理解

SQLDatabaseToolkit 是一個封裝好的工具集合,它包含了讓大模型能夠安全、有效地對 SQL 數據庫執行查詢、獲取 schema 信息、檢查查詢結果等一系列操作所必需的工具。

我們可以把它想象成一個給大模型準備的“數據庫操作瑞士軍刀”,大模型在 LangChain 的協調下可以根據用户輸入的提示請求,從這套工具箱裏選擇合適的工具來使用,最終完成用户的數據查詢或操作任務。它的主要作用是作為大模型和 SQL 數據庫之間的橋樑。

2. 使用説明

2.1 導入必要的庫

from langchain.agents import create_sql_agent, AgentExecutor

from langchain.agents.agent_toolkits import SQLDatabaseToolkit

from langchain.sql_database import SQLDatabase

from langchain.llms.openai import OpenAI

from langchain.chat_models import ChatOpenAI

import os

- create_sql_agent: 創建專門用於SQL數據庫交互的代理

- AgentExecutor: 代理執行器,負責運行代理

- SQLDatabaseToolkit: 提供與SQL數據庫交互的工具集

- SQLDatabase: 表示SQL數據庫連接

- ChatOpenAI: OpenAI聊天模型類(這裏用於兼容模式調用其他API)

- os: 用於訪問環境變量

2.2 連接到數據庫

db_user = "root"

db_password = "Aa123456!"

db_host = "localhost"

db_name = "ecommerce_db"

db = SQLDatabase.from_uri(f"mysql+pymysql://{db_user}:{db_password}@{db_host}/{db_name}")

# 或者直接使用

# db = SQLDatabase.from_uri(f"mysql+pymysql://root:Aa123456!@localhost/ecommerce_db")

- 使用SQLAlchemy格式的URI連接MySQL數據庫

- 格式: mysql+pymysql://用户名:密碼@主機/數據庫名

- 這裏直接使用了硬編碼的憑據,實際項目中應使用環境變量或配置管理

2.3 獲取API密鑰

api_key = os.environ.get('DASHSCOPE_API_KEY')

- 從環境變量中獲取DashScope API密鑰,避免將密鑰硬編碼在代碼中

2.4 初始化LLM模型

llm = ChatOpenAI(

temperature=0.01,

model="deepseek-v3",

openai_api_base="https://dashscope.aliyuncs.com/compatible-mode/v1",

openai_api_key=api_key

)

- 使用ChatOpenAI類,但配置為調用DashScope的兼容模式API

- temperature=0.01: 低温度值使輸出更加確定性和一致性

- model="deepseek-v3": 指定使用的模型,也可以使用其他的,如qwen-max或qwen-turbo等

- openai_api_base: 設置API端點為DashScope的兼容模式

- openai_api_key: 提供API密鑰進行認證

2.5 創建SQL工具箱

toolkit = SQLDatabaseToolkit(db=db, llm=llm)

- 創建SQLDatabaseToolkit實例,將數據庫連接和LLM模型關聯起來

- 工具箱會自動創建以下工具:

- ListSQLDatabaseTool: 列出數據庫中的表

- InfoSQLDatabaseTool: 獲取表結構信息

- QuerySQLDataBaseTool: 執行SQL查詢

2.6 創建SQL代理執行器

agent_executor = create_sql_agent(

llm=llm,

toolkit=toolkit,

verbose=False # 打印詳細執行過程

)

- 創建一個專門用於SQL任務的代理

- llm=llm: 指定使用的語言模型

- toolkit=toolkit: 提供SQL工具箱

- verbose=False: 不顯示詳細的執行過程,設置為True可用於調試

# 定義中文提示詞!

# 重寫原有的英文提示詞前綴和後綴

ZH_SQL_PREFIX = """

你是一個專業的SQL數據分析師。你需要根據用户的問題,與一個SQL數據庫進行交互,並返回答案。

請全程使用中文與用户交流和進行內部思考。

請嚴格按照以下步驟執行:

1. 首先,查看數據庫中有哪些表可用。

2. 然後,根據需要查詢相關表的schema信息,瞭解字段含義。

3. 根據schema生成一條正確的SQL查詢語句。

4. 執行查詢並分析結果。

5. 最後,用清晰、友好的中文回覆用户的問題。

請務必確保生成的SQL語句語法正確且符合數據庫的schema。

注意:如果你無法根據提供的信息得到答案,請如實告知用户,而不要編造答案。

開始吧!

"""

# 後綴中需要保留`{tool_names}`、`{agent_scratchpad}`等變量,這是Agent工作所必需的。

ZH_SQL_SUFFIX = """

問題:{input}

思考過程:我需要一步步思考。首先,{agent_scratchpad}

"""

# 5. 創建使用中文提示詞的代理執行器

agent_executor = create_sql_agent(

llm=llm,

toolkit=toolkit,

verbose=True, # 打印詳細執行過程,此時會是中文

agent_type=AgentType.ZERO_SHOT_REACT_DESCRIPTION, # 使用這種類型以便自定義提示詞

agent_executor_kwargs={

"prefix": ZH_SQL_PREFIX, # 注入我們的中文前綴

"suffix": ZH_SQL_SUFFIX # 注入我們的中文後綴

}

)

- 注意這部分的差異,可以使用極簡的模式,也可以自定義提示詞前綴和後綴

- LangChain 的 create_sql_agent 函數內部已經預設了一套提示詞來指導Agent的行為。要切換語言,最有效的方法是創建一個自定義的代理(Agent),併為其提供中文的提示詞模板。

- 使用 AgentType.ZERO_SHOT_REACT_DESCRIPTION 並自定義 prefix 和 suffix 部分,明確要求LLM使用中文進行思考和輸出。

2.7 執行查詢並獲取結果

result = agent_executor.run("獲取所有客户的姓名和聯繫電話")

print(result)

- 使用代理執行器運行用户輸入的關鍵詞

- 代理會分析查詢意圖、查看數據庫中有哪些表、獲取相關表的結構信息、生成合適的SQL查詢、執行查詢並返回結果、將結果進行整理後輸出響應

三、SQLDatabaseToolkit的核心組成

SQLDatabaseToolkit 並不是一個單一的工具,它通常包含以下幾個關鍵工具:

1. QuerySQLDataBaseTool

- 功能:這是最重要的工具,用於執行 SQL 查詢語句並返回結果。

- 工作流程:大模型根據用户的問題和理解的數據表結構,生成一條 SQL 查詢語句,然後通過這個工具來執行它,並將結果返回給用户。

運行示例:

# 示例: 使用QuerySQLDataBaseTool執行查詢

def example_query_data():

"""使用QuerySQLDataBaseTool執行查詢"""

print("=== 示例: 使用QuerySQLDataBaseTool執行查詢 ===")

# 構建一個查詢

query = "SELECT * FROM customers LIMIT 5"

result = query_tool.run(query)

# 使用Qwen API分析查詢結果

prompt = f"""

數據庫查詢結果: {result}

請用中文分析這些數據,提供一些業務洞察。例如:

1. 數據的基本統計信息

2. 可能的業務含義

3. 數據質量觀察

"""

analysis = call_qwen_api(prompt)

print(f"查詢結果: {result}")

print(f"Qwen分析: {analysis}")

print()

輸出結果:

=== 示例: 使用QuerySQLDataBaseTool執行查詢 ===

查詢結果: [(1, '張三', 'zhangsan@example.com', '2023-01-15 10:30:45'), (2, '李四', 'lisi@example.com', '2023-02-20 14:25:30')]

Qwen分析: 查詢返回了前5位客户的信息。從數據可以看出:

1. 系統至少有2位客户

2. 客户信息包含ID、姓名、郵箱和創建時間

3. 客户創建時間分佈在2023年1月和2月

4. 郵箱格式符合常見電子郵件格式

2. InfoSQLDatabaseTool

- 功能:用於獲取數據庫的 Schema 信息,即表結構、列名、列數據類型等信息。

- 工作流程:在生成 SQL 語句之前,大模型通常需要知道數據庫裏有哪些表,每個表有哪些字段。這個工具可以查詢指定表的 Schema(例如,通過 SELECT * FROM table_name LIMIT 0; 或類似的機制),為 大模型生成準確的 SQL 提供上下文。它通常會限制返回的行數以避免信息過載。

運行示例:

# 示例: 使用InfoSQLDatabaseTool獲取表結構信息

def example_table_info():

"""使用InfoSQLDatabaseTool獲取表結構"""

print("=== 示例: 使用InfoSQLDatabaseTool獲取表結構 ===")

# 假設我們有一個名為'customers'的表

table_name = "customers"

result = info_tool.run(table_name)

# 使用Qwen API解釋表結構

prompt = f"""

表 '{table_name}' 的結構信息: {result}

請用中文解釋這個表的結構,包括每個字段的用途和可能的數據關係。

"""

explanation = call_qwen_api(prompt)

print(f"表結構: {result}")

print(f"Qwen分析: {explanation}")

print()

輸出結果:

=== 示例: 使用InfoSQLDatabaseTool獲取表結構 ===

表結構: [('id', 'int', 'NO', 'PRI', None, 'auto_increment'), ('name', 'varchar(100)', 'YES', '', None, ''), ('email', 'varchar(100)', 'YES', '', None, ''), ('created_at', 'timestamp', 'YES', '', 'CURRENT_TIMESTAMP', '')]

Qwen分析: customers表用於存儲客户基本信息,包含以下字段:

- id: 主鍵,自增整數,唯一標識每個客户

- name: 客户姓名,可變長度字符串

- email: 客户郵箱,可變長度字符串

- created_at: 客户創建時間,時間戳類型,默認當前時間

3. ListSQLDatabaseTool

- 功能:用於列出數據庫中的所有表。

- 工作流程:當數據庫很大時,大模型首先需要知道有哪些表可供查詢。這個工具會返回一個表名的列表,如通過 SHOW TABLES;或查詢 information_schema。

運行示例:

# 示例: 使用ListSQLDatabaseTool獲取所有表名

def example_list_tables():

"""使用ListSQLDatabaseTool獲取所有表"""

print("=== 示例1: 使用ListSQLDatabaseTool獲取所有表 ===")

# 直接使用工具

result = list_tool.run("")

# 使用Qwen API解釋結果

prompt = f"""

數據庫表列表: {result}

請用中文簡要解釋這個數據庫可能包含哪些業務數據,並推測每個表的用途。

"""

explanation = call_qwen_api(prompt)

print(f"表列表: {result}")

print(f"Qwen分析: {explanation}")

print()

輸出結果:

=== 示例: 使用ListSQLDatabaseTool獲取所有表 ===

表列表: ['customers', 'orders', 'products', 'order_items']

Qwen分析: 這個數據庫似乎是一個電子商務系統。包含以下表:

- customers: 存儲客户信息

- orders: 存儲訂單信息

- products: 存儲產品信息

- order_items: 存儲訂單項信息,連接訂單和產品

4. ExecuteSQLDatabaseTool

- 功能:一個更通用的工具,可以執行任何 SQL 語句,包括 INSERT, UPDATE, DELETE 等寫操作。

- 注意:出於安全考慮,這個工具通常默認不啓用或需要顯式配置。在絕大多數只讀查詢場景下,只會使用 QuerySQLDataBaseTool。

運行示例:

# 示例: 使用QuerySQLDataBaseTool執行查詢

def example_query_data():

"""使用QuerySQLDataBaseTool執行查詢"""

print("=== 示例: 使用QuerySQLDataBaseTool執行查詢 ===")

# 構建一個查詢

query = "SELECT * FROM customers LIMIT 5"

result = query_tool.run(query)

# 使用Qwen API分析查詢結果

prompt = f"""

數據庫查詢結果: {result}

請用中文分析這些數據,提供一些業務洞察。例如:

1. 數據的基本統計信息

2. 可能的業務含義

3. 數據質量觀察

"""

analysis = call_qwen_api(prompt)

print(f"查詢結果: {result}")

print(f"Qwen分析: {analysis}")

print()

輸出結果:

=== 示例: 使用QuerySQLDataBaseTool執行查詢 ===

查詢結果: [(1, '張三', 'zhangsan@example.com', '2023-01-15 10:30:45'), (2, '李四', 'lisi@example.com', '2023-02-20 14:25:30')]

Qwen分析: 查詢返回了前5位客户的信息。從數據可以看出:

1. 系統至少有2位客户

2. 客户信息包含ID、姓名、郵箱和創建時間

3. 客户創建時間分佈在2023年1月和2月

4. 郵箱格式符合常見電子郵件格式

四、SQLDatabaseToolkit的工作流程

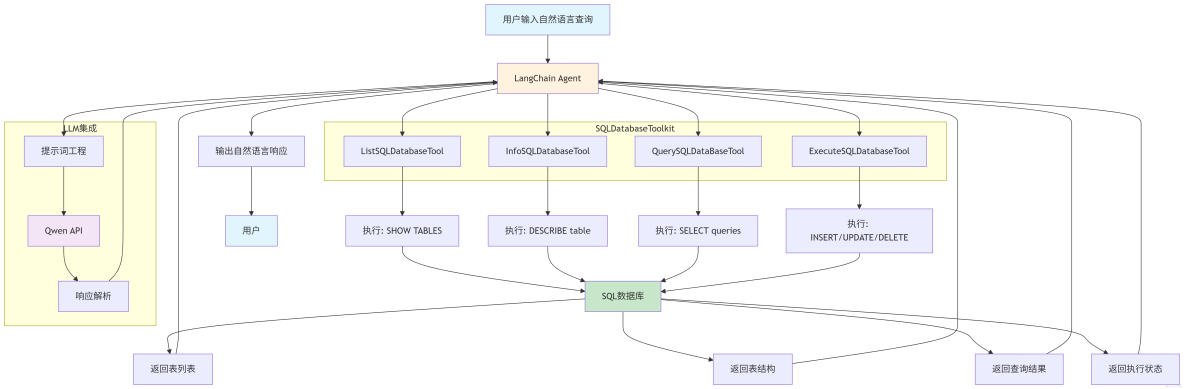

1. 基礎流程

基礎的工作流程圖,展示了其內部組件如何協作以及與外部組件如大模型、數據庫的交互:

工作流步驟:

- 輸入處理:

- 用户輸入自然語言查詢,如"顯示銷售額最高的產品"

- LangChain Agent接收並解析查詢

- 數據庫探索階段:

- Agent調用ListSQLDatabaseTool獲取可用表列表

- 根據查詢意圖,Agent選擇相關表並調用InfoSQLDatabaseTool獲取表結構

- SQL生成與執行:

- Agent結合L大模型(如Qwen API)生成適當的SQL查詢

- 調用QuerySQLDataBaseTool執行查詢或ExecuteSQLDatabaseTool執行寫操作

- 數據庫返回查詢結果

- 結果處理與響應:

- Agent使用LLM解釋查詢結果

- 將結構化數據轉換為自然語言響應

- 向用户返回最終答案

2. 與Qwen API模型的集成流程

內部流程執行步驟:

當使用基於 SQLDatabaseToolkit 構建的 Agent智能體時,其內部的工作流程通常如下:

- 用户提問:用户提出一個問題,例如:“我們公司上個月銷售額最高的產品是什麼?”

- Agent 思考:LangChain Agent配備了LLM和SQLDatabaseToolkit開始工作。

- 獲取 Schema 信息:Agent 可能會先調用 ListSQLDatabaseTool 來查看有哪些表,然後調用 InfoSQLDatabaseTool 來查看可能相關的表(如 sales, products 表)的結構,瞭解有哪些字段(如 sale_date, product_id, amount)。

- 生成 SQL:LLM 基於用户的提問和剛剛獲取到的 Schema 信息,推理並生成一條準確的 SQL 查詢語句。如:SELECT product_name, SUM(amount) AS total_sales FROM sales JOIN products ON sales.product_id = products.id WHERE sale_date >= '2023-10-01' GROUP BY product_name ORDER BY total_sales DESC LIMIT 1;

- 執行查詢:Agent 調用 QuerySQLDataBaseTool,將生成的 SQL 語句作為參數傳入,工具在數據庫上執行該查詢。

- 處理結果:數據庫返回查詢結果,例如一個包含產品名和銷售額的元組,Toolkit 將這個結果返回給 Agent。

- 生成最終回答:Agent 將結構化的數據庫結果再次交給大模型,由大模型將其組織成流暢的自然語言答案返回給用户。如:“根據記錄,上個月銷售額最高的產品是 '某某智能音箱',總銷售額為 150,000 元。”

測試用例:查詢銷售額最高的產品

- 用户輸入:"哪些產品銷售額最高?"

- Agent調用ListSQLDatabaseTool,返回表列表: [products, orders, order_items]

- Agent調用InfoSQLDatabaseTool,獲取products和order_items表結構

- Agent請求Qwen API生成SQL,生成: SELECT p.name, SUM(oi.quantity * oi.price) as total_sales FROM products p JOIN order_items oi ON p.id = oi.product_id GROUP BY p.id ORDER BY total_sales DESC LIMIT 10

- Agent調用QuerySQLDataBaseTool,執行上述SQL

- 數據庫返回:[('產品A', 15000), ('產品B', 12000), ...]

- Agent請求Qwen API解釋結果,生成自然語言響應

- Agent返回用户:"銷售額最高的產品是產品A,總銷售額為15,000元,其次是產品B,銷售額為12,000元..."

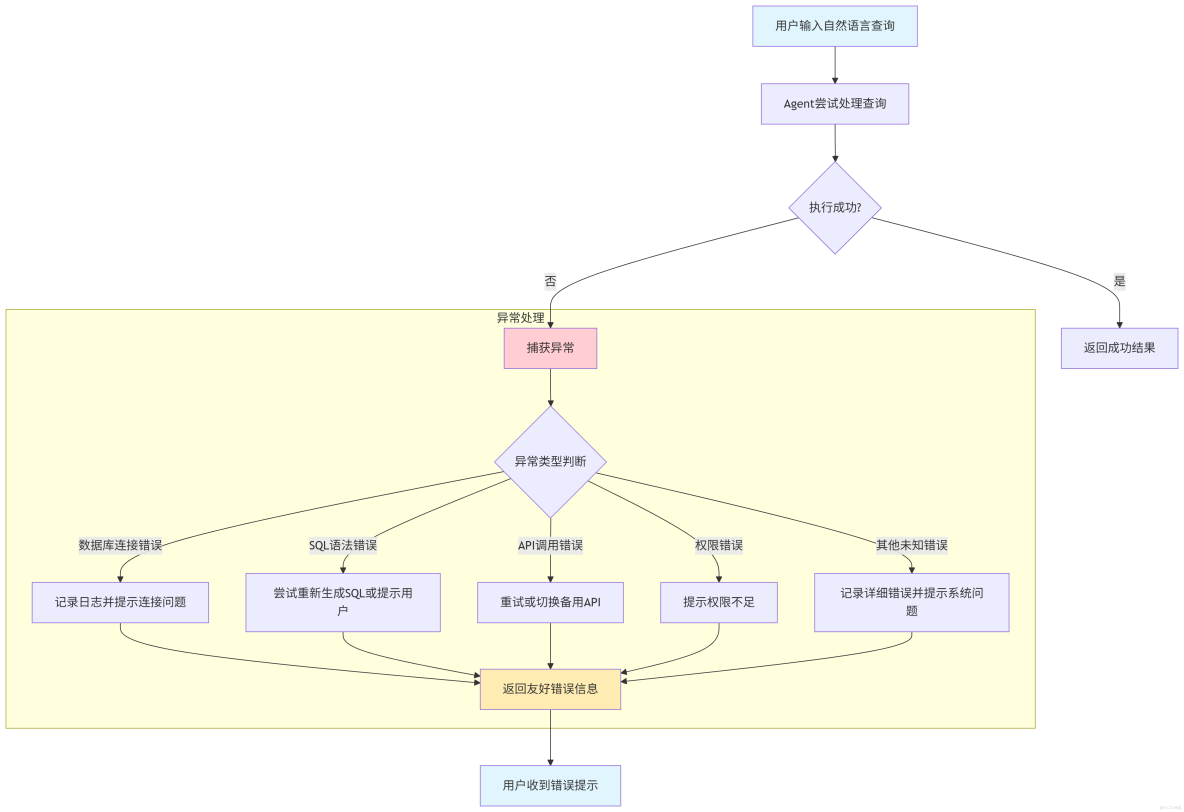

3. 異常處理流程

主要異常類型及處理策略:

- 數據庫連接異常:記錄詳細錯誤日誌,返回友好提示

- SQL 語法或執行異常:提供錯誤信息作為上下文,嘗試讓 LLM 重新生成 SQL

- API 調用異常:記錄 API 錯誤詳情,實現備用 API 回退機制

- 權限異常:明確提示權限限制

- 超時異常:設置查詢超時時間,返回友好提示

五、SQLDatabaseToolkit的主要特點

- 自然語言交互:讓不懂 SQL 的用户也能通過提問的方式訪問數據庫數據。

- 自動化:自動處理了從理解問題、查詢 Schema 到生成 SQL 和執行的全流程。

- 安全性:通過工具的設計,可以嚴格控制大模型對數據庫的訪問權限,默認只允許只讀操作,避免意外的數據修改。

- 靈活性:可以連接到任何支持 SQL 的數據庫,如 MySQL, PostgreSQL, SQLite, Microsoft SQL Server 等。

- 集成性:作為 LangChain 生態系統的一部分,可以輕鬆與其他工具(如鏈 Chains、代理 Agents)和組件(如記憶 Memory)結合,構建更復雜的應用。

六、SQLDatabaseToolkit的優勢

在 SQLDatabaseToolkit 出現之前,讓 LLM 操作數據庫通常需要手動完成一系列繁瑣步驟:

- 手動拼接提示詞:開發者需要自己將數據庫的 Schema(表名、列名、類型)信息拼接到給 LLM 的提示詞中。

- 手動驗證和執行 SQL:從 LLM 拿到生成的 SQL 後,需要自己編寫代碼連接數據庫、執行查詢、處理可能的錯誤(如語法錯誤、字段不存在)。

- 缺乏標準化流程:整個流程是分散且自定義的,難以複用、維護和優化。

SQLDatabaseToolkit 的出現,正是為了將這些碎片化的步驟標準化、自動化和工具化。它的核心意義在於:

- 降低門檻:讓不熟悉編程和SQL的業務人員也能通過自然語言與數據庫進行復雜交互,真正實現了“用説話的方式查數據”。

- 提升效率:為開發者和數據分析師提供了一個強大的腳手架,無需再從零開始構建數據庫交互層,可以專注於更上層的業務邏輯和提示詞工程。

- 推動AI應用落地:它將 LLM 的認知能力與數據庫的海量結構化數據無縫銜接,是構建企業級智能數據分析、自動報表生成、客户洞察等應用的核心基礎設施。

七、SQLDatabaseToolkit的使用場景

- 商業智能與數據分析:非技術人員(如產品經理、運營人員)直接通過對話查詢業務數據,生成報表。

- 客户支持:客服人員快速查詢用户訂單狀態、賬户信息等。

- 內容生成:根據數據庫中的事實數據自動生成報告、摘要或描述性文字。

- 企業知識庫:將數據庫中的結構化數據作為企業知識的一部分,供員工查詢。

八、案例分析

1. 示例代碼

from langchain.agents import create_sql_agent

from langchain.agents.agent_toolkits import SQLDatabaseToolkit

from langchain.sql_database import SQLDatabase

from langchain.llms.openai import OpenAI

from langchain.agents import AgentExecutor

from langchain.chat_models import ChatOpenAI

import os

# 1. 連接到數據庫

db = SQLDatabase.from_uri(f"mysql+pymysql://root:Aa123456!@localhost/ecommerce_db")

# 從環境變量獲取 dashscope 的 API Key

api_key = os.environ.get('DASHSCOPE_API_KEY')

# 2. 選擇LLM模型

llm = ChatOpenAI(

temperature=0.01,

model="deepseek-v3",

openai_api_base = "https://dashscope.aliyuncs.com/compatible-mode/v1",

openai_api_key = api_key

)

# 3. 創建SQL工具箱

toolkit = SQLDatabaseToolkit(db=db, llm=llm)

# 4. 創建代理執行器

agent_executor = create_sql_agent(

llm=llm,

toolkit=toolkit,

verbose=False # 打印詳細執行過程

)

# 5. 向代理提問!

result = agent_executor.run("獲取所有客户的姓名和聯繫電話")

print(result)

2. 輸出結果

代碼中我們將執行器的 verbose=False 參數設置為false,沒用輸出過程:

result = agent_executor.run("獲取所有客户的姓名和聯繫電話")

Here are the customer names and their contact emails (limited to 5 results):1. 張三 - zhangsan@example.com

2. 李四 - lisi@example.com

3. 王五 - wangwu@example.com

4. 趙六 - zhaoliu@example.com

5. 錢七 - qianqi@example.com

3. 執行過程

3.1 首先設置verbose = True,看看詳細輸出過程

result = agent_executor.run("獲取所有客户的姓名和聯繫電話")

Error in StdOutCallbackHandler.on_chain_start callback: AttributeError("'NoneType' object has no attribute 'get'")

Action: sql_db_list_tables

Action Input: categories, order_items, orders, payments, products, user_addresses, usersThe most relevant tables for customer information would be "users" and possibly "user_addresses". I should check the schema of these tables to find

the columns for customer names and contact information.

Action: sql_db_schema

Action Input: users, user_addresses

... 忽略了schema的輸出...

Action: sql_db_query_checker

Action Input: SELECT full_name, email FROM users LIMIT 10The original query is:

```sql

SELECT full_name, email FROM users LIMIT 10

```

After reviewing, I don't find any of the mentioned common mistakes in this simple query. The query is correctly formatted and doesn't involve any of the potential issues listed (NOT IN with NULL values, UNION vs UNION ALL, BETWEEN, data type mismatches, identifier quoting, function arguments, casting, or joins).

Here's the original query reproduced:

```sql

SELECT full_name, email FROM users LIMIT 10

```The query looks correct and safe to execute. I'll now run it to get the customer names and contact information.

Action: sql_db_query

Action Input: SELECT full_name, email FROM users LIMIT 10[('張三', 'zhangsan@example.com'), ('李四', 'lisi@example.com'), ('王五', 'wangwu@example.com'), ('趙六', 'zhaoliu@example.com'), ('錢七', 'qianqi@example.com')]I now have the list of customers with their names and contact information (email addresses).

Final Answer: 以下是客户的姓名和聯繫郵箱:

1. 張三 - zhangsan@example.com

2. 李四 - lisi@example.com

3. 王五 - wangwu@example.com

4. 趙六 - zhaoliu@example.com

5. 錢七 - qianqi@example.com

(注:數據庫中未找到聯繫電話字段,故提供郵箱作為聯繫方式)

以上分析過程,關注兩點:

- 1. 分析的過程都是英文的説明,這與使用的模型有關,有的模型是基於英文訓練的,輸出的內容多是英文,如果是支持中英文的,在提示詞中要求使用中文分析也可以切換成中文輸出

- 2. 我們要求輸出的是名稱和電話,輸出的內容變成了名稱和郵箱,也給了説明

3.2 我們換一個模型,改為Qwen-max,看看輸出有什麼不同

result = agent_executor.run("獲取所有客户的姓名和聯繫電話")

Action: sql_db_list_tables

Action Input: categories, order_items, orders, payments, products, user_addresses, users從表名來看,`users` 表可能包含

客户的信息。我需要查看 `users` 表的結構來確定哪些列包含了客户的姓名和聯繫電話。

Action: sql_db_schema

Action Input: users

... 忽略了schema的輸出...

*/從`users`表的結構來看,客户的姓名存儲在`full_name`列中。但是,聯繫電話信息似乎沒有直接出現在這個表裏。考慮到聯繫信息

可能被單獨存儲,我需要檢查一下`user_addresses`表是否包含電話號碼。

Action: sql_db_schema

Action Input: user_addresses

... 忽略了schema的輸出...

*/`user_addresses` 表中並沒有直接包含電話號碼的信息。考慮到聯繫信息可能存儲在另一個表或者以某種形式存在於當前已知的表

中,但基於現有信息,我們只能獲取客户的姓名。如果確實需要聯繫電話,可能需要進一步確認是否有其他相關表或字段存在。

不過,根據當前的需求,我可以先構建一個查詢來獲取所有客户的姓名。由於沒有找到聯繫電話的具體位置,我將僅提供姓名信息,並

限制結果為10條記錄。

Action: sql_db_query

Action Input: SELECT full_name FROM users LIMIT 10;[('張三',), ('李四',), ('王五',), ('趙六',), ('錢七',)]我已經從`users`表中獲取了前10位客户的姓名。但是,由於數據庫中沒有直接提供聯繫電話的信息,我只能返回這些客户的姓名。

Final Answer: 以下是部分客户的姓名:張三、李四、王五、趙六、錢七。請注意,數據庫中未找到與這些客户關聯的聯繫電話信息。

如果需要聯繫電話,請進一步確認是否有其他相關表或字段存在。

> Finished chain.

以下是部分客户的姓名:張三、李四、王五、趙六、錢七。請注意,數據庫中未找到與這些客户關聯的聯繫電話信息。如果需要聯繫電

話,請進一步確認是否有其他相關表或字段存在。

分析過程是中文的描述,並且輸出結果沒有使用郵箱代替電話;

九、總結

SQLDatabaseToolkit 是一個功能強大且實用的工具集,它極大地降低了通過自然語言訪問和操作 SQL 數據庫的門檻,是構建基於 LLM 的數據驅動應用的關鍵組件之一。使用 SQLDatabaseToolkit 自動生成數據庫文檔具有以下優勢:

- 高效準確:自動化流程減少人工錯誤,確保文檔與數據庫實際結構一致

- 及時更新:可以定期或實時更新文檔,確保文檔時效性

- 智能分析:結合LLM的能力,生成不僅包含結構信息,還包含業務含義的智能文檔

- 多格式輸出:可以生成Markdown、HTML、PDF等多種格式的文檔

- 變更追蹤:可以檢測數據庫結構變更並生成差異報告

這種方法特別適用於大型項目、敏捷開發環境以及需要頻繁更新數據庫結構的場景,能夠顯著提高團隊的生產力和文檔質量。