一、AI Ping 中的模型

隨着大語言模型技術的飛速發展,AI 輔助編程已成為新常態。其中,“氛圍編程”作為一種新興範式,強調開發者通過自然語言與 AI 進行流暢交互,在沉浸式的開發環境中獲得代碼建議、問題解答和自動化任務支持 。這種範式極大地依賴於強大的後端 AI 模型和順暢的前端工具集成。在此背景下,一個名為 AI Ping 的新興 API 聚合服務應運而生。

AI Ping是國內領先的大模型服務評測與聚合平台,致力於為開發者提供全面、客觀、真實的模型性能數據和統一調用入口。平台已接入智譜、MiniMax、DeepSeek、通義千問等主流廠商,覆蓋近百種模型,涵蓋文本生成、視覺理解、圖像生成、Embedding、Reranker 等多種類型。

最近AI Ping上線了最新的強大模型包括:MiniMax-M2.1、GLM-4.7。

模型庫:

AI Ping 模型庫概覽,熱門模型如下:

- NEW - 新上線:GLM-4.7、MiniMax-M2.1、MiMo-V2-Flash、Ring-1T 等

- FREE - 免費:DeepSeek-V3.2、GLM-4.7、MiniMax-M2.1、Doubao-Seedream-4.5 等

- HOT - 熱門:GLM-4.7、GLM-4.6、MiniMax-M2、DeepSeek系列等

二、模型介紹與使用

GLM-4.7模型

GLM-4.7介紹

GLM-4.7 是智譜最新旗艦模型,GLM-4.7 面向 Agentic Coding 場景強化了編碼能力、長程任務規劃與工具協同,並在可控推理機制支撐下實現了複雜工程任務的穩定交付。通用能力全面提升,回覆更簡潔自然,寫作更具沉浸感。在執行復雜智能體任務時,指令遵循能力更強,Artifacts 與 Agentic Coding 的前端美感和長程任務完成效率進一步提升。

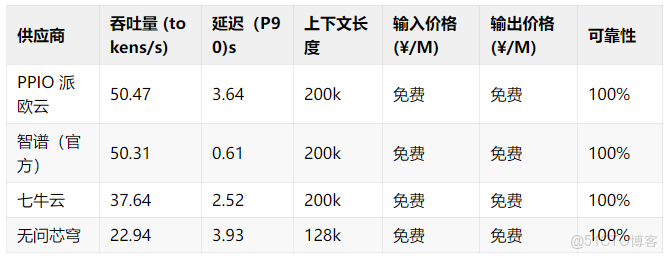

GLM-4.7實測數據

AI Ping 平台測試數據

GLM-4.7 的示例代碼與 API 説明

AI Ping 會幫你在不同的服務提供商之間規範化處理請求和響應,為你統一接口。

AI Ping 提供了兼容 OpenAI 的 Completion API ,可連接 500 多款模型與服務供應商。

from openai import OpenAI

openai_client = OpenAI(

base_url="https://www.aiping.cn/api/v1",

api_key="QC-********************************",

)

response = openai_client.chat.completions.create(

model="GLM-4.7",

stream=True,

extra_body={

"provider": {

"only": [],

"order": [],

"sort": None,

"input_price_range": [],

"output_price_range": [],

"input_length_range": [],

"throughput_range": [],

"latency_range": []

}

},

messages=[

{"role": "user", "content": "Hello"}

]

)

for chunk in response:

if not getattr(chunk, "choices", None):

continue

reasoning_content = getattr(chunk.choices[0].delta, "reasoning_content", None)

if reasoning_content:

print(reasoning_content, end="", flush=True)

content = getattr(chunk.choices[0].delta, "content", None)

if content:

print(content, end="", flush=True)MiniMax-M2.1模型

MiniMax-M2.1介紹

MiniMax M2.1 是 MiniMax 最新旗艦模型,MiniMax M2.1 面向長鏈 Agent 執行場景強化了多語言工程能力、持續運行效率與收斂推理路徑,並在高效 MoE 架構支撐下實現了吞吐與穩定性的出色平衡。在執行長時間 Agent 工作流時,推理路徑更收斂、工具調用更高效,憑藉低激活參數與 200k 長上下文優勢,連續編碼與持續運行吞吐進一步提升。

MiniMax-M2.1實測數據

AI Ping 平台測試數據

MiniMax-M2.1 的示例代碼與 API 説明

AI Ping 會幫你在不同的服務提供商之間規範化處理請求和響應,為你統一接口。

AI Ping 提供了兼容 OpenAI 的 Completion API ,可連接 500 多款模型與服務供應商。

from openai import OpenAI

openai_client = OpenAI(

base_url="https://www.aiping.cn/api/v1",

api_key="QC-****************",

)

response = openai_client.chat.completions.create(

model="MiniMax-M2.1",

stream=True,

extra_body={

"provider": {

"only": [],

"order": [],

"sort": None,

"input_price_range": [],

"output_price_range": [],

"input_length_range": [],

"throughput_range": [],

"latency_range": []

}

},

messages=[

{"role": "user", "content": "Hello"}

]

)

for chunk in response:

if not getattr(chunk, "choices", None):

continue

reasoning_content = getattr(chunk.choices[0].delta, "reasoning_content", None)

if reasoning_content:

print(reasoning_content, end="", flush=True)

content = getattr(chunk.choices[0].delta, "content", None)

if content:

print(content, end="", flush=True)三、核心:AI Ping 統一 API 接口規範

為了適配不同的 CLI 工具,我們首先需要理解 AI Ping 提供的統一 API 接口規範。AI Ping 巧妙地將不同模型的原生 API 封裝成與 OpenAI API 格式兼容的接口,這極大地簡化了集成過程。

- API 端點 (Endpoint URL): AI Ping 提供了一個統一的 API 基礎 URL。所有模型調用都通過這個地址進行路由。根據對類似服務的分析 這個地址通常形如:

base_url = "https://aiping.cn/api/v1"- 認證方式 (Authentication): AI Ping 採用

Bearer Token的認證方式。開發者需要在請求的Authorization頭中包含從 AI Ping 平台獲取的 API 密鑰 。

Authorization: Bearer <您的AI_PING_API_KEY>- 模型標識符 (Model ID): 在請求體中,通過

model字段指定要使用的模型 。AI Ping 為免費模型分配了以下標識符:

- MiniMax-M2.1:model="MiniMax-M2.1"

- GLM-4.7:model="GLM-4.7"

四、獲取免費的 AI Ping API 密鑰

在配置任何工具之前,首要任務是獲取 AI Ping 的免費 API 密鑰。

- 訪問 AI Ping 官方平台: 打開瀏覽器,訪問 AI Ping 的官方網站:https://www.aiping.cn/。

- 註冊並登錄賬户: 使用您的手機號碼、郵箱或 GitHub 賬户進行註冊和登錄。

- 進入 API 密鑰管理頁面: 登錄後,在個人中心中找到API秘鑰。

- 創建新的 API 密鑰: 點擊“創建新密鑰”(Create new key),系統會生成一個以 QC

-開頭的字符串。請立即複製並妥善保管此密鑰。

五、分步配置指南:將 AI Ping 集成到四大 CLI 工具

接下來,我們將詳細介紹如何在不同操作系統(Linux, macOS, Windows with WSL)上配置四款主流的 CLI 編碼工具。

4.1 環境準備

確保您的開發環境滿足以下基本要求:

- Node.js: 版本需

v18.0.0或更高。推薦使用nvm(Node Version Manager) 進行安裝和管理 。 - Git: 版本需

2.23+。 - Python: 版本需

3.10+(某些工具或其插件可能需要)。 - Shell 環境: 推薦使用 Zsh (配合 Oh My Zsh) 或 Bash。

4.2 工具一:Claude Code 配置指南

Claude Code 是由 Anthropic 開發的一款功能強大的終端原生 AI 助手,以其對項目上下文的深度理解和多文件操作能力而聞名 。

步驟 1:安裝 Claude Code

打開終端,使用 npm 進行全局安裝 。

npm install -g @anthropic-ai/claude-code安裝完成後,運行以下命令驗證是否成功:

claude --version終端輸出:

步驟 2:配置環境變量

Claude Code 通過環境變量來配置 API 端點和密鑰。由於 AI Ping 提供了 OpenAI 兼容的 API,我們可以通過設置 OPENAI_API_KEY 和 OPENAI_API_BASE 兩個環境變量來“欺騙”Claude Code,使其連接到 AI Ping。

打開您的 shell 配置文件(如 ~/.zshrc 或 ~/.bashrc),在文件末尾添加以下內容 :

# AI Ping Configuration for Claude Code

export OPENAI_API_BASE="https://aiping.cn/api/v1"

export OPENAI_API_KEY="<此處粘貼您獲取的AI_PING_API_KEY>"保存文件後,執行 source ~/.zshrc 或 source ~/.bashrc 使配置生效。

步驟 3:選擇並啓用模型

默認情況下,Claude Code 可能會嘗試調用其原生模型。我們需要通過命令行參數或配置文件指定使用 AI Ping 提供的模型。

方法A:通過命令行參數

每次啓動時,通過 -m 或 --model 參數指定模型 :

# 使用 Kimi-K2-Thinking 模型

claude edit "src/app.js" -m "aiping/minimax-m2.1" -p "請重構這個文件,將所有回調函數改為 async/await 語法"

# 使用 GLM-4.7 模型

claude -m "aiping/glm-4.7" "請為我編寫一個檢查密碼強度的 Python 函數"方法B:通過全局配置文件(推薦)

為了避免每次都輸入模型名稱,我們可以修改 Claude Code 的全局配置文件。該文件通常位於 ~/.config/claude-code/mcp_settings.json 。如果文件不存在,請先運行一次 claude 命令讓其自動創建。

編輯該文件,設置 defaultModel 字段:

{

"defaultModel": "aiping/minimax-m2.1",

"telemetry": {

"disabled": true

}

}通過這種方式,您將 MiniMax-M2.1 設置為默認模型。現在,您可以直接運行 claude 命令,它將自動使用 AI Ping 的模型。

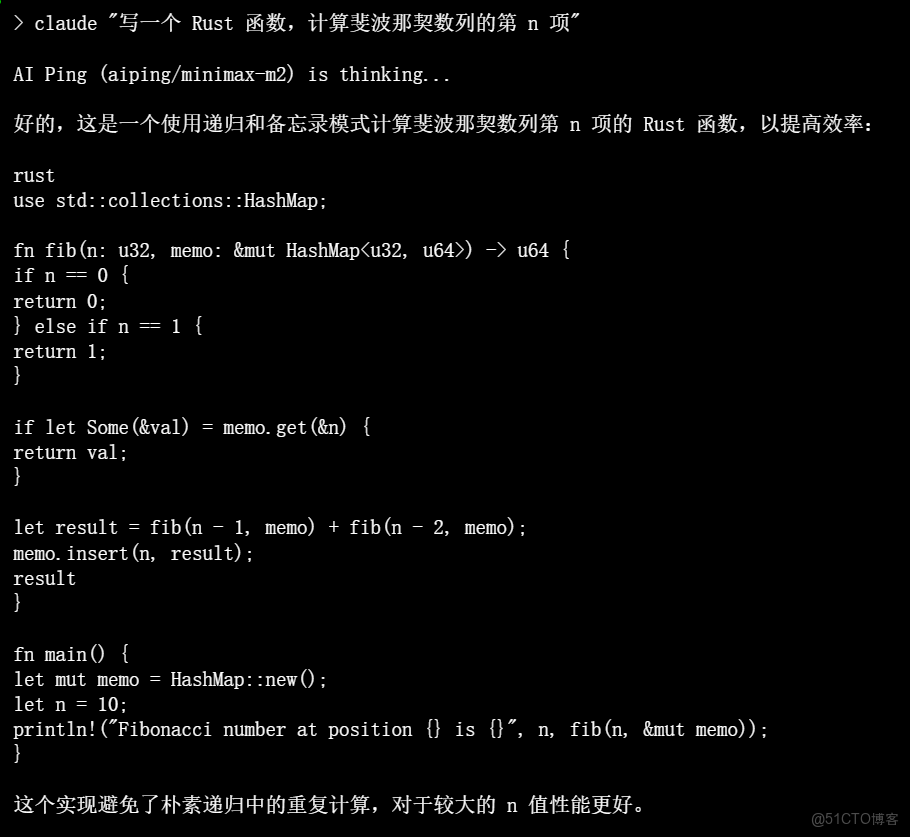

終端輸出(使用配置好的 Claude Code):

4.3 工具二:Codex CLI 配置指南

Codex CLI 是 OpenAI 開源的一款本地編碼代理工具,允許開發者在終端中與代碼庫進行交互 。它同樣支持通過環境變量配置 API。

步驟 1:安裝 Codex CLI

使用 npm 進行全局安裝 :

npm install -g @openai/codex步驟 2:配置環境變量

與 Claude Code 類似,我們配置 OPENAI_API_KEY 和 OPENAI_API_BASE 兩個變量。如果您已為 Claude Code 配置過,此步驟可以跳過。

# AI Ping Configuration for Codex CLI

export OPENAI_API_BASE="https://aiping.cn/api/v1"

export OPENAI_API_KEY="<此處粘貼您獲取的AI_PING_API_KEY>"記得 source 您的配置文件。

步驟 3:配置模型

Codex CLI 允許通過 ~/.codex/config.toml 文件來配置默認模型 。創建並編輯此文件:

# ~/.codex/config.toml

# 設置默認使用的模型為 AI Ping 的 GLM-4.7

model = "aiping/glm-4.7"步驟 4:開始使用

現在,您可以在項目目錄中啓動 Codex CLI,並開始與 AI Ping 的模型進行交互。

# 進入你的項目目錄

cd my-project

# 啓動 codex

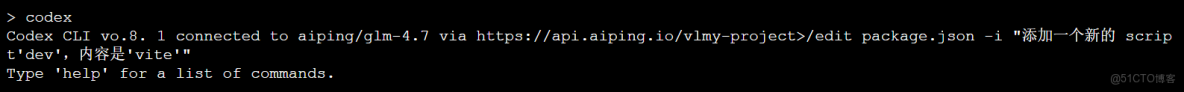

codex終端輸出:

六、總結與展望

本文詳細給大家介紹瞭如何利用 AI Ping 提供的限時免費大模型資源,最近AI Ping上線了最新的強大模型包括:MiniMax-M2.1、GLM-4.7。这兩個大模型功能強大,模型輸出效果都很好。我們通過遵循本指南提供的分步操作,開發者可以零成本地在自己熟悉的終端環境中,享受到頂級 AI 模型帶來的編程效率提升。

利用 AI Ping 提供的 OpenAI 兼容 API 接口,通過設置標準的環境變量(如 OPENAI_API_BASE 和 OPENAI_API_KEY)或工具特定的配置,將這些 CLI 工具的請求重定向到 AI Ping 服務。隨着 AI 技術的不斷普及,類似 AI Ping 的聚合服務將使開發者能夠更靈活、更低成本地切換和使用來自不同提供商的先進模型。我們鼓勵開發者積極擁抱“氛圍編程”這一新範式,並持續關注 AI Ping 等平台未來的發展,抓住更多技術紅利,打造更加智能和高效的開發工作流。

https://aiping.cn/#?channel\_partner\_code=GQCOZLGJ (註冊登錄立享30元算力金)