本週論文包括Meta AI提出了一種名為 data2vec 的自監督學習新架構,在多種模態的基準測試中超越了現有 SOTA 方法;谷歌、MIT 等提出分類器可視化解釋方法 StylEx等。

目錄

- data2vec: A General Framework for Self-supervised Learning in Speech, Vision and Language

- Explaining in Style: Training a GAN to explain a classifier in StyleSpace

- Automated Reinforcement Learning (AutoRL): A Survey and Open Problems

- An Introduction to Autoencoders

- Vision Transformer with Deformable Attention

- Pushing the limits of self-supervised ResNets: Can we outperform supervised learning without labels on ImageNet?

- Instant Neural Graphics Primitives with a Multiresolution Hash Encoding

- ArXiv Weekly Radiostation:NLP、CV、ML 更多精選論文

論文 1:data2vec: A General Framework for Self-supervised Learning in Speech, Vision and Language

- 作者:Alexei Baevski、Wei-Ning Hsu、 Qiantong Xu 等

- 論文鏈接:https://ai.facebook.com/research/data2vec-a-general-framework-for-self-supervised-learning-in-speech-vision-and-language

摘要: Meta AI(原 Facebook AI)提出了一種名為 data2vec 的自監督學習新架構,在多種模態的基準測試中超越了現有 SOTA 方法。

data2vec 是首個適用於多模態的高性能自監督算法。Meta AI 將 data2vec 分別應用於語音、圖像和文本,在計算機視覺、語音任務上優於最佳單一用途算法,並且在 NLP 任務也能取得具有競爭力的結果。此外,data2vec 還代表了一種新的、全面的自監督學習範式,其提高了多種模態的進步,而不僅僅是一種模態。data2vec 不依賴對比學習或重建輸入示例,除了幫助加速 AI 的進步,data2vec 讓我們更接近於製造能夠無縫地瞭解周圍世界不同方面的機器。data2vec 使研究者能夠開發出適應性更強的 AI,Meta AI 相信其能夠在多種任務上超越已有系統。

data2vec 訓練方式是通過在給定輸入的部分視圖的情況下預測完整輸入模型表示(如下動圖所示):首先 data2vec 對訓練樣本的掩碼版本(學生模型)進行編碼,然後通過使用相同模型參數化為模型權重的指數移動平均值(教師模型)對輸入樣本的未掩碼版本進行編碼來構建訓練目標表示。目標表示對訓練樣本中的所有信息進行編碼,學習任務是讓學生在給定輸入部分視圖的情況下預測這些表示。

Meta AI 使用標準的 Transformer 架構(Vaswani 等人,2017):對於計算機視覺,Meta AI 使用 ViT 策略將圖像編碼為一系列 patch,每個 patch 跨越 16x16 像素,然後輸入到線性變換(Dosovitskiy 等人, 2020;Bao 等人,2021)。語音數據使用多層 1-D 卷積神經網絡進行編碼,該網絡將 16 kHz 波形映射到 50 Hz 表示(Baevski 等人,2020b)。對文本進行預處理以獲得子詞(sub-word)單元(Sennrich 等人,2016;Devlin 等人,2019),然後通過學習的嵌入向量將其嵌入到分佈空間中。

**推薦:**首個多模態高性能自監督算法,語音、圖像文本全部 SOTA。

論文 2:Explaining in Style: Training a GAN to explain a classifier in StyleSpace

- 作者:Oran Lang 、 Yossi Gandelsman 、 Michal Yarom 等

- 論文鏈接:https://arxiv.org/pdf/2104.13369.pdf

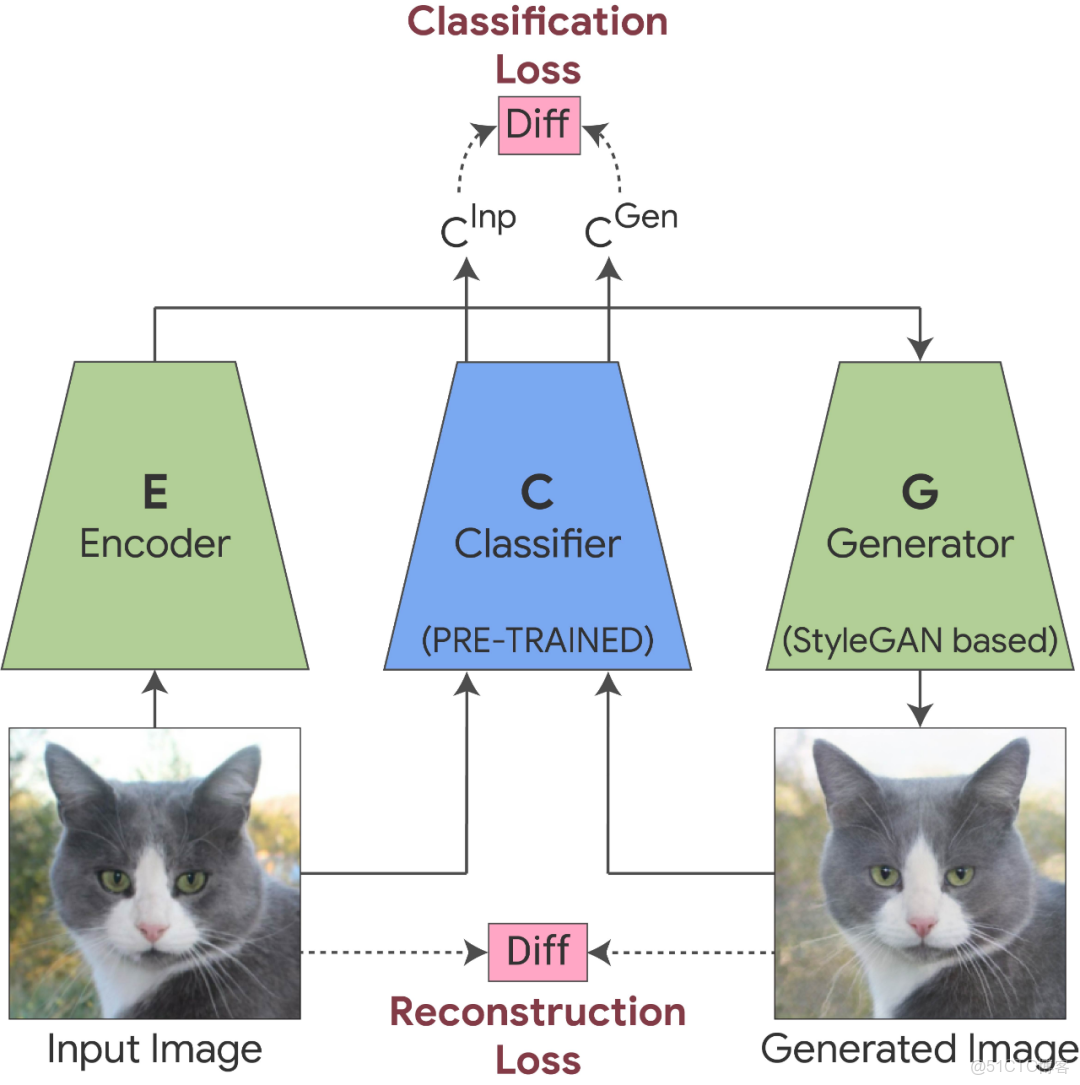

摘要: 來自谷歌、 希伯來大學、 MIT 等機構的研究者提出了一種新的分類器可視化解釋方法,相關論文被 ICCV 2021 接收。他們提出了 StylEx ,可以自動發現和可視化影響分類器的解耦屬性(disentangled attributes)。StylEx 允許通過單獨操作這些屬性來探索單個屬性的影響(也就是説,更改一個屬性不會影響其他屬性)。StylEx 適用於廣泛的領域,包括動物、樹葉、面部和視網膜圖像。該研究結果表明,StylEx 找到的屬性與語義屬性非常吻合,可以生成有意義的特定於圖像的解釋,並且在用户研究中可以被人們所解釋。

給定一個分類器和一個輸入圖像,該研究希望找到並可視化影響其分類的各個屬性。研究人員採用了可以生成高質量圖像的 StyleGAN2 架構,整個過程包括兩個階段:

第一階段訓練 StylEx:StylEx 通過使用兩個附加組件訓練 StyleGAN 生成器來實現。第一個是編碼器,它與具有 reconstruction-loss 的 GAN 一起訓練,並強制生成的輸出圖像在視覺上與輸入相似,從而允許生成器應用於任何給定的輸入圖像。然而,僅僅只有圖像的視覺相似性是不夠的,因為它可能不一定捕獲對特定分類器(例如醫學病理學)重要的細微視覺細節。

第二階段提取解耦屬性:訓練完成之後,研究者在經過訓練的分類器的 StyleSpace 中搜索顯著影響分類器的屬性,他們對每個 StyleSpace 進行操作並測量其對分類概率的影響。對於給定的圖像,研究者尋找對圖像分類影響最大的屬性。這一過程可以找到 top-K 個特定圖像屬性。對每個類的圖像重複這個過程,可以進一步發現特定類的 top-K 屬性,這個端到端的系統被命名為 StylEx。

推薦: 谷歌、MIT 等提出分類器可視化解釋方法 StylEx。

論文 3:Automated Reinforcement Learning (AutoRL): A Survey and Open Problems

- 作者:Jack Parker-Holder 、 Raghu Rajan 、 Xingyou Song 等

- 論文鏈接:https://arxiv.org/pdf/2201.03916.pdf

**摘要:**強化學習 (RL) 與深度學習的結合帶來了一系列令人印象深刻的成果,許多人認為(深度)強化學習提供了通向通用智能體的途徑。然而,RL 智能體的成功通常對訓練過程中的設計選擇高度敏感,可能需要繁瑣且容易出錯的手動調整。這使得將 RL 用於新問題具有挑戰性,同時也限制了 RL 的全部潛力。

在機器學習的許多其他領域,AutoML 已經表明可以自動化此類設計選擇,並且在應用於 RL 時也產生了有希望的初步結果。然而,自動強化學習 (AutoRL) 不僅涉及 AutoML 的標準應用,還包括 RL 獨有的額外挑戰,這使得研究者自然而然地產生了一些不同的方法。

AutoRL 已成為 RL 研究的一個重要領域,為從 RNA 設計到圍棋等遊戲的各種應用提供了希望。由於 RL 中考慮的方法和環境具有多樣性,因此許多研究都是在不同的子領域進行的。來自牛津大學、弗萊堡大學、谷歌研究院等機構的十餘位研究者撰文試圖統一 AutoRL 領域,並提供了通用分類法,該研究詳細討論了每個領域並提出未來研究人員可能感興趣的問題。

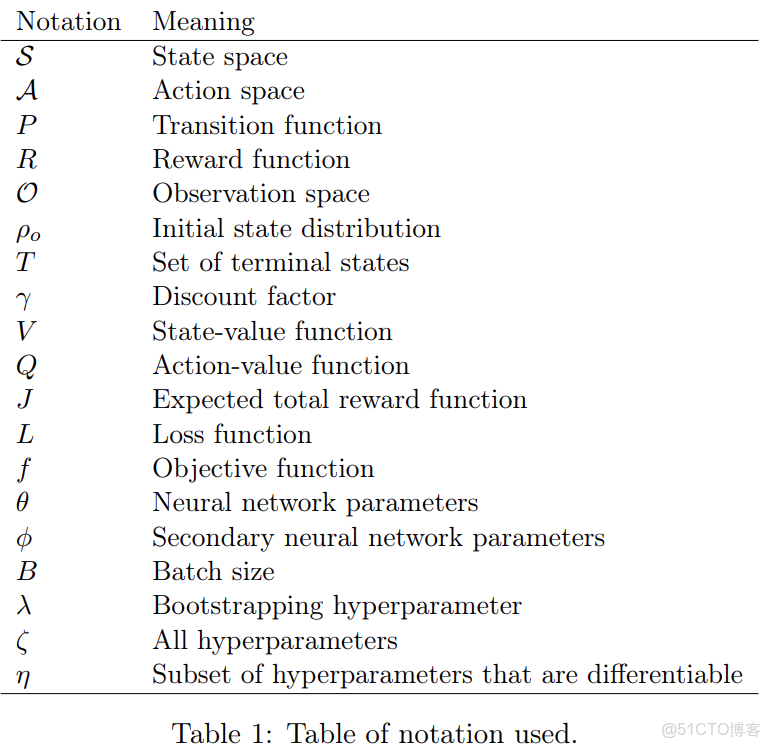

如下表 3 所示,該研究按照大類總結了 AutoRL 方法的分類,方法分類將體現在第四章的每一小節:

推薦: 牛津大學、谷歌等十餘位學者撰文綜述 AutoRL。

論文 4:An Introduction to Autoencoders

- 作者:Umberto Michelucci

- 論文鏈接:https://arxiv.org/abs/2201.03898

**摘要:**TOELT LLC 聯合創始人兼首席 AI 科學家 Umberto Michelucci 對自編碼器進行了全面、深入的介紹。

神經網絡通常用於監督環境,這意味着對於每個訓練觀測值 x_i,都將有一個標籤或期望值 y_i。在訓練過程中,神經網絡模型將學習輸入數據和期望標籤之間的關係。

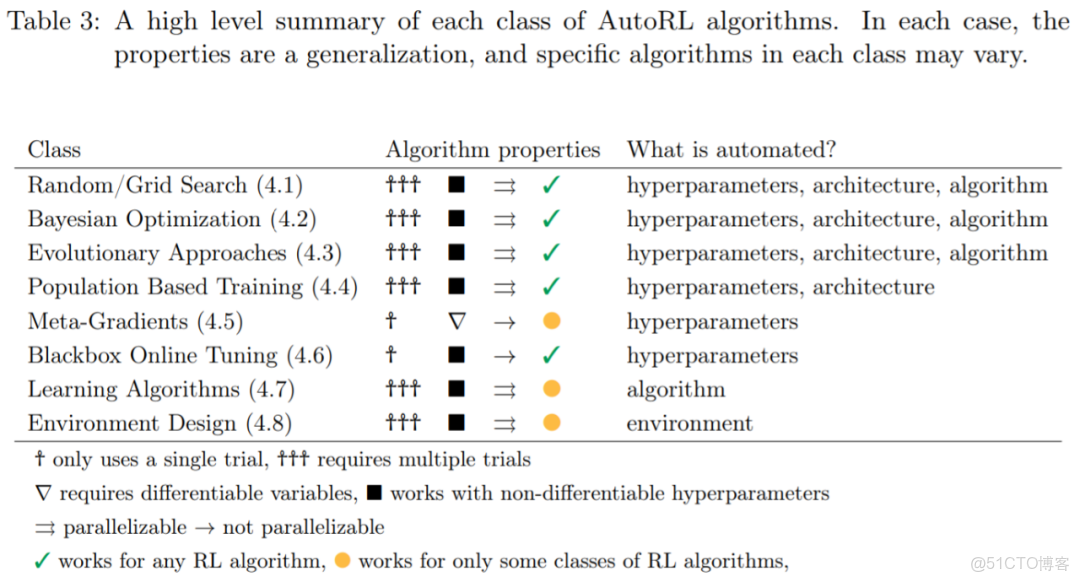

現在,假設只有未標記的觀測數據,這意味着只有由 i = 1,… ,M 的 M 觀測數據組成的訓練數據集 S_T。

在這一數據集中,x_i ∈ R^n,n ∈ N。

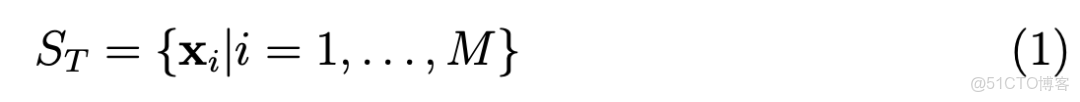

1986 年,Rumelhart,Hinton 和 Williams 首次提出了自動編碼器(Autoencoder),旨在是學習以儘可能低的誤差重建輸入觀測值 x_i。

為什麼要學習重建輸入觀測值?

如果你很難想象這意味着什麼,想象一下由圖片組成的數據集。自編碼器是一個讓輸出圖像儘可能類似輸入之一的算法。也許你會感到困惑,因為似乎沒有理由這樣做。為了更好地理解為什麼自編碼器是有用的,我們需要一個更加翔實 (雖然還沒有明確) 的定義。

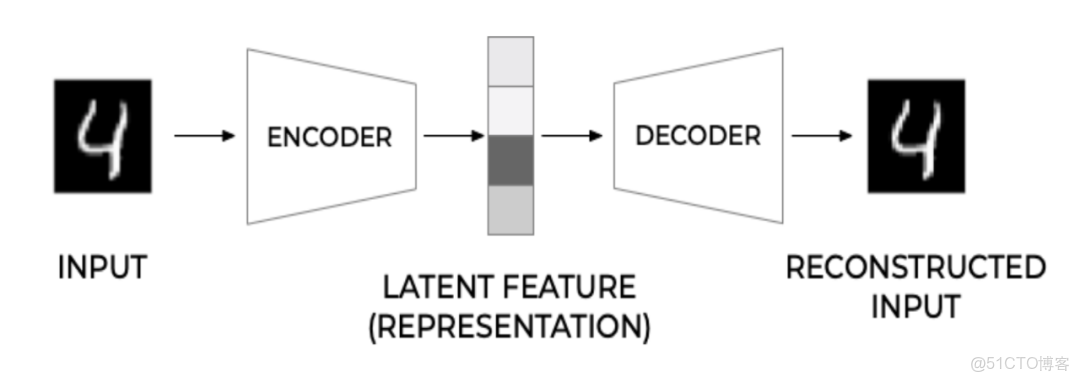

為了更好地理解自編碼器,我們需要了解它的經典架構。如圖 1 所示。自編碼器的主要組成部分有三個:編碼器、潛在特徵表示和解碼器。

圖 1: 自動編碼器的一般架構。

推薦: 自編碼器 26 頁綜述論文:概念、圖解和應用。

論文 5:Vision Transformer with Deformable Attention

- 作者:Zhuofan Xia 、 Xuran Pan 、 Shiji Song 等

- 論文鏈接:https://arxiv.org/abs/2201.00520v1

摘要: 清華大學、AWS AI 和北京智源人工智能研究院的研究者提出了一種新型可變形自注意力模塊,其中以數據相關的方式選擇自注意力中鍵值對的位置。這種靈活的方案使自注意力模塊能夠專注於相關區域並捕獲更多信息特徵。

可變形注意力 Transformer(Deformable Attention Transformer,DAT),是一種具有可變形注意力的通用主幹網絡模型,適用於圖像分類和密集預測任務。該研究通過大量基準測試實驗證明了該模型的性能提升。

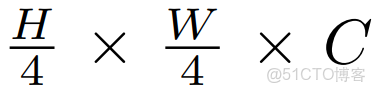

該研究在 Transformer(等式 (4))中的可變形注意力替換了 vanilla MHSA,並將其與 MLP(等式 (5))相結合,以構建一個可變形的視覺 transformer 塊。在網絡架構方面, DAT 與[7, 26, 31, 36] 共享類似的金字塔結構,廣泛適用於需要多尺度特徵圖的各種視覺任務。如下圖 3 所示,形狀為 H × W × 3 的輸入圖像首先被步長為 4 的 4 × 4 非重疊卷積嵌入,然後一個歸一化層獲得

補丁嵌入。

為了構建分層特徵金字塔,主幹包括 4 個階段,步幅逐漸增加。在兩個連續的階段之間,有一個步長為 2 的非重疊 2×2 卷積,對特徵圖進行下采樣,將空間大小減半並將特徵維度加倍。

在分類任務中,該研究首先對最後階段輸出的特徵圖進行歸一化,然後採用具有池化特徵的線性分類器來預測對數;在對象檢測、實例分割和語義分割任務中,DAT 在集成視覺模型中扮演主幹的角色,以提取多尺度特徵。該研究為每個階段的特徵添加一個歸一化層,然後將它們輸入到以下模塊中,例如對象檢測中的 FPN [23] 或語義分割中的解碼器。

推薦: 清華可變形注意力 Transformer 模型優於多數 ViT。

論文 6:Pushing the limits of self-supervised ResNets: Can we outperform supervised learning without labels on ImageNet?

- 作者:Nenad Tomasev 、 Ioana Bica 、 Brian McWilliams 等

- 論文鏈接:https://arxiv.org/abs/2201.05119

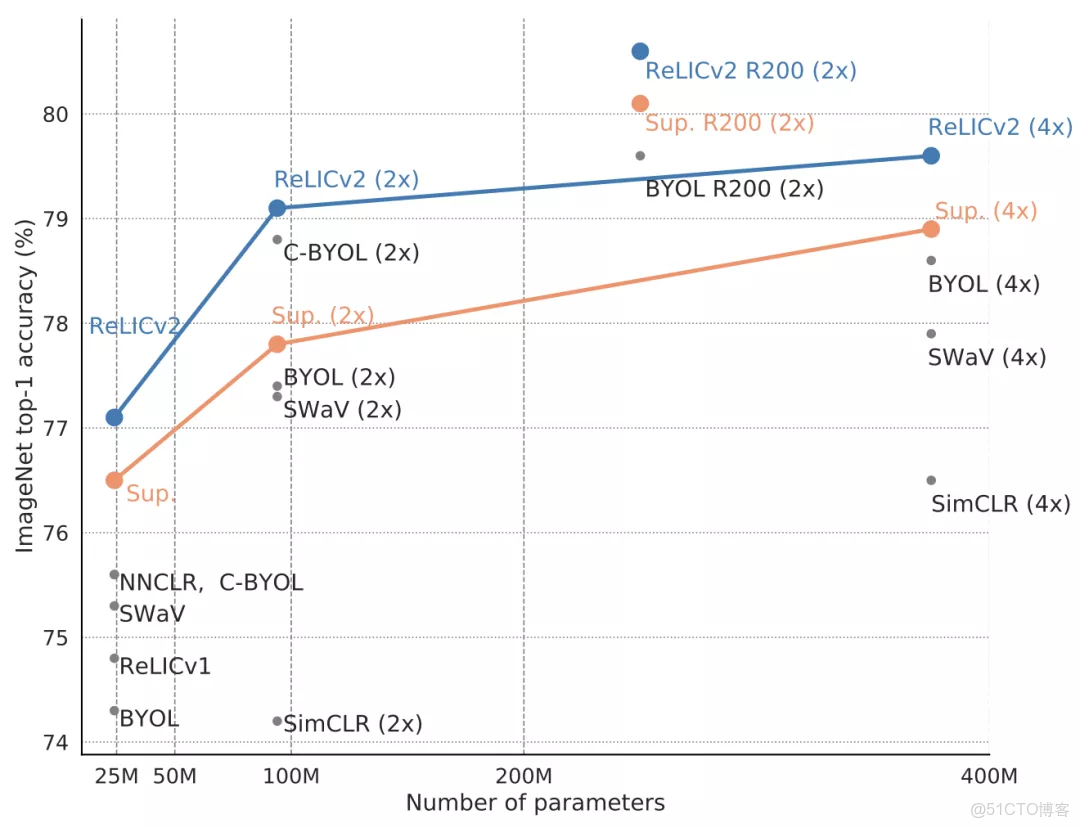

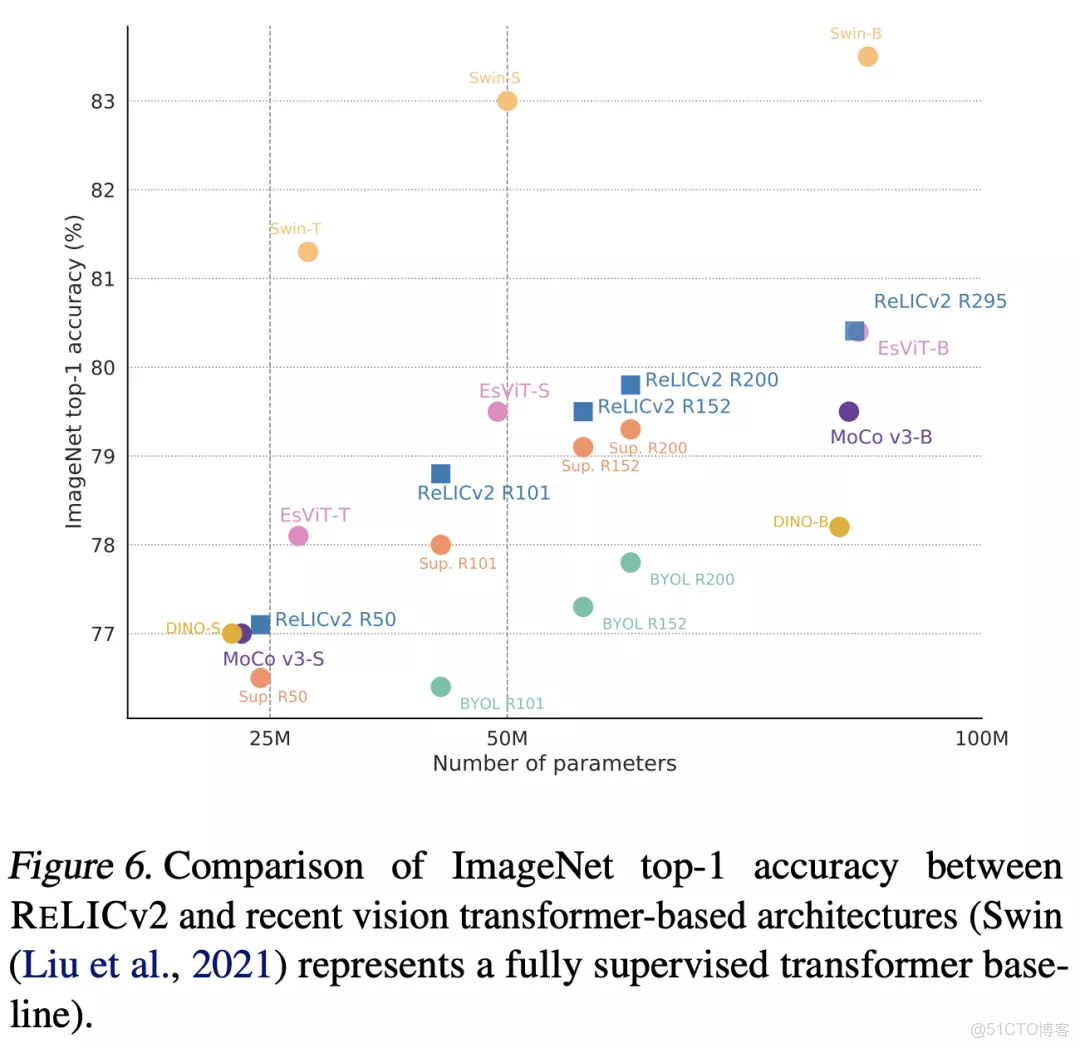

**摘要:**儘管自監督方法最近在殘差網絡表示學習方面取得了進展,但它們在 ImageNet 分類基準上的表現仍然低於監督學習,這限制了它們在性能關鍵設置中的適用性。基於先前的理論見解(Mitrovic 等人,2021 年),DeepMind、牛津大學、圖靈研究院聯合推出了 RELICv2,它結合了明確的不變性損失和對比目標,該研究證明在 ImageNet 中使用相同網絡架構進行同等條件下的對比,無標註訓練數據集的效果可以超過有監督學習。

具體而言,RELICv2 使用 ResNet50 架構的線性評估在 ImageNet 上實現了 77.1% 的 top-1 分類準確率,使用更大的 ResNet 模型實現了 80.6% 的準確率,大大超過了 SOTA 自監督方法。

值得注意的是,RELICv2 是第一個使用一系列標準 ResNet 架構(ResNet101、ResNet152、ResNet200)在同類比較中始終優於監督基線的表示學習方法。最後,該研究表明,儘管使用了 ResNet 編碼器,RELICv2 仍可與 SOTA 自監督視覺 transformer 相媲美。

推薦: DeepMind 新作 RELICv2 。

論文 7:Instant Neural Graphics Primitives with a Multiresolution Hash Encoding

- 作者:THOMAS MÜLLER 、 ALEX EVANS 等

- 論文鏈接:https://nvlabs.github.io/instant-ngp/assets/mueller2022instant.pdf

摘要: 英偉達訓練 NeRF,最快只需 5 秒(例如訓練狐狸的 NeRF 模型)!實現的關鍵在於一種多分辨率哈希編碼技術,英偉達在論文《 Instant Neural Graphics Primitives with a Multiresolution Hash Encoding》進行了詳細解讀。

英偉達在 4 個代表性任務中對多分辨率哈希編碼技術進行驗證,它們分別是神經輻射場(NeRF)、十億(Gigapixel)像素圖像近似、神經符號距離函數(SDF)和神經輻射緩存(NRC)。每個場景都使用了 tiny-cuda-nn 框架訓練和渲染具有多分辨率哈希輸入編碼的 MLP。

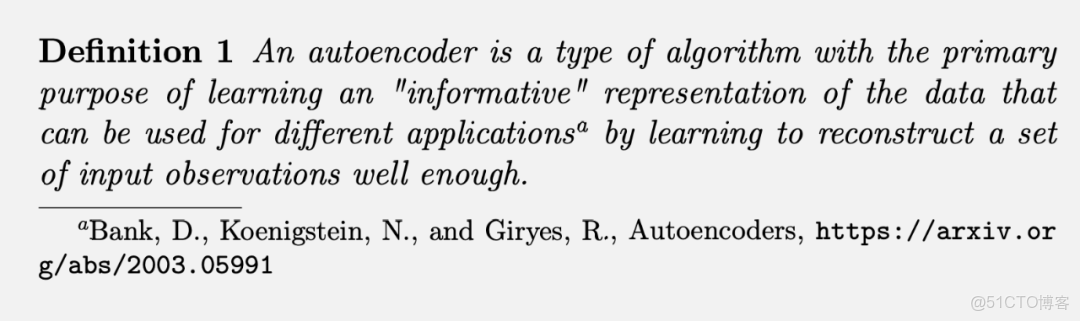

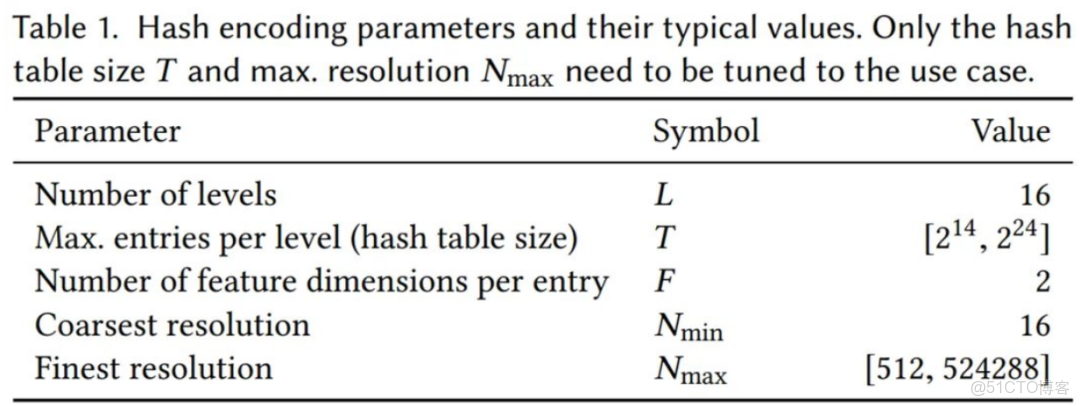

英偉達的神經網絡不僅有可訓練的權重參數 Φ,還有可訓練的編碼參數 θ。這些被排列成 L 個級別(level),每個級別包含多達 T 個 F 維 的特徵向量。這些超參數的典型值如下表 1 所示:

多分辨率哈希編碼的顯著特徵在於獨立於任務的自適應性和高效性。首先來看自適應性。英偉達將一串網格映射到相應的固定大小的特徵向量陣列。低分辨率下,網格點與陣列條目呈現 1:1 映射;高分辨率下,陣列被當作哈希表,並使用空間哈希函數進行索引,其中多個網格點為每個陣列條目提供別名。這類哈希碰撞導致碰撞訓練梯度平均化,意味着與損失函數最相關的最大梯度將佔據支配地位。因此,哈希表自動地優先考慮那些具有最重要精細尺度細節的稀疏區域。與以往工作不同的是,訓練過程中數據結構在任何點都不需要結構更新。

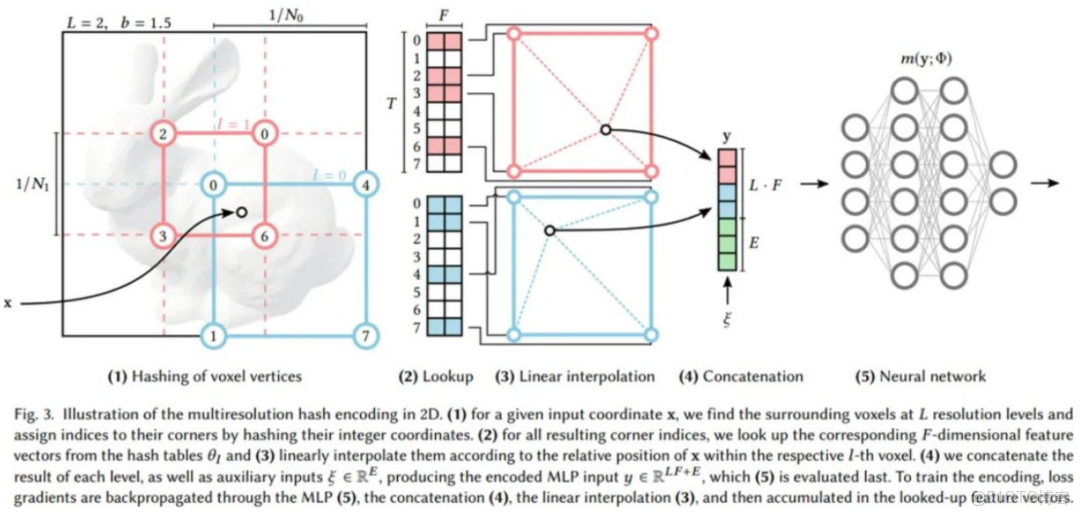

然後是高效性。英偉達的哈希表查找是,不需要控制流。這可以很好地映射到現代 GPU 上,避免了執行分歧和樹遍歷中固有的指針雕鏤(pointer-chasing)。所有分辨率下的哈希表都可以並行地查詢。下圖 3 展示了多分辨率哈希編碼中的執行步驟:

2D 多分辨率哈希編碼示意圖

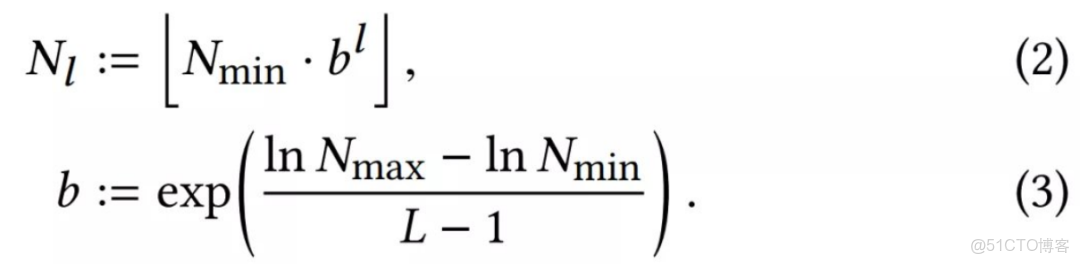

如上圖所示,每個級別(其中兩個分別顯示為紅色和藍色)都是獨立的,並在概念上將特徵向量存儲在網格頂點處,其中最低和最高分辨率之間的幾何級數 [N_min, N_max] 表示為:

推薦: 英偉達新技術訓練 NeRF 模型最快只需 5 秒,單張 RTX 3090 實時渲染。

ArXiv Weekly Radiostation

機器之心聯合由楚航、羅若天發起的ArXiv Weekly Radiostation,在 7 Papers 的基礎上,精選本週更多重要論文,包括NLP、CV、ML領域各10篇精選,並提供音頻形式的論文摘要簡介,詳情如下:

本週 10 篇 NLP 精選論文是:

1. Improving Neural Machine Translation by Denoising Training. (from Dacheng Tao)

2. Memory-assisted prompt editing to improve GPT-3 after deployment. (from Yiming Yang)

3. COLD: A Benchmark for Chinese Offensive Language Detection. (from Minlie Huang)

4. Prompt Learning for Few-Shot Dialogue State Tracking. (from Tat-Seng Chua)

5. A Benchmark for Generalizable and Interpretable Temporal Question Answering over Knowledge Bases. (from Salim Roukos)

6. LaMDA: Language Models for Dialog Applications. (from Zhifeng Chen, Adam Roberts)

7. WANLI: Worker and AI Collaboration for Natural Language Inference Dataset Creation. (from Noah A. Smith)

8. UnifiedSKG: Unifying and Multi-Tasking Structured Knowledge Grounding with Text-to-Text Language Models. (from Dragomir Radev, Noah A. Smith)

9. A Survey of Pretrained Language Models Based Text Generation. (from Ji-Rong Wen)

10. Polarity and Subjectivity Detection with Multitask Learning and BERT Embedding. (from Erik Cambria)

本週 10 篇 CV 精選論文是:

1. MeMViT: Memory-Augmented Multiscale Vision Transformer for Efficient Long-Term Video Recognition. (from Jitendra Malik)

2. End-to-end Generative Pretraining for Multimodal Video Captioning. (from Cordelia Schmid)

3. Revisiting Weakly Supervised Pre-Training of Visual Perception Models. (from Ross Girshick, Piotr Dollár, Laurens van der Maaten)

4. ConDor: Self-Supervised Canonicalization of 3D Pose for Partial Shapes. (from Leonidas J. Guibas)

5. CLIP-TD: CLIP Targeted Distillation for Vision-Language Tasks. (from Shih-Fu Chang)

6. Semi-automatic 3D Object Keypoint Annotation and Detection for the Masses. (from Roland Siegwart)

7. What can we learn from misclassified ImageNet images?. (from Laurent Itti)

8. Learning Pixel Trajectories with Multiscale Contrastive Random Walks. (from Alexei A. Efros)

9. AirPose: Multi-View Fusion Network for Aerial 3D Human Pose and Shape Estimation. (from Michael J. Black)

10. Stitch it in Time: GAN-Based Facial Editing of Real Videos. (from Daniel Cohen-Or)

本週 9 篇 ML 精選論文是:

1. Dual Space Graph Contrastive Learning. (from Philip S. Yu)

2. Minimax Demographic Group Fairness in Federated Learning. (from Guillermo Sapiro)

3. The Enforcers: Consistent Sparse-Discrete Methods for Constraining Informative Emergent Communication. (from Katia Sycara)

4. Uncertainty Quantification in Scientific Machine Learning: Methods, Metrics, and Comparisons. (from George Em Karniadakis)

5. GradTail: Learning Long-Tailed Data Using Gradient-based Sample Weighting. (from Dragomir Anguelov)

6. IDEA: Interpretable Dynamic Ensemble Architecture for Time Series Prediction. (from Tong Zhang)

7. Training Free Graph Neural Networks for Graph Matching. (from Tat-Seng Chua)

8. Domain-shift adaptation via linear transformations. (from Russell Greiner)

9. Decoupling the Depth and Scope of Graph Neural Networks. (from Viktor Prasanna)