文章目錄

- 引言

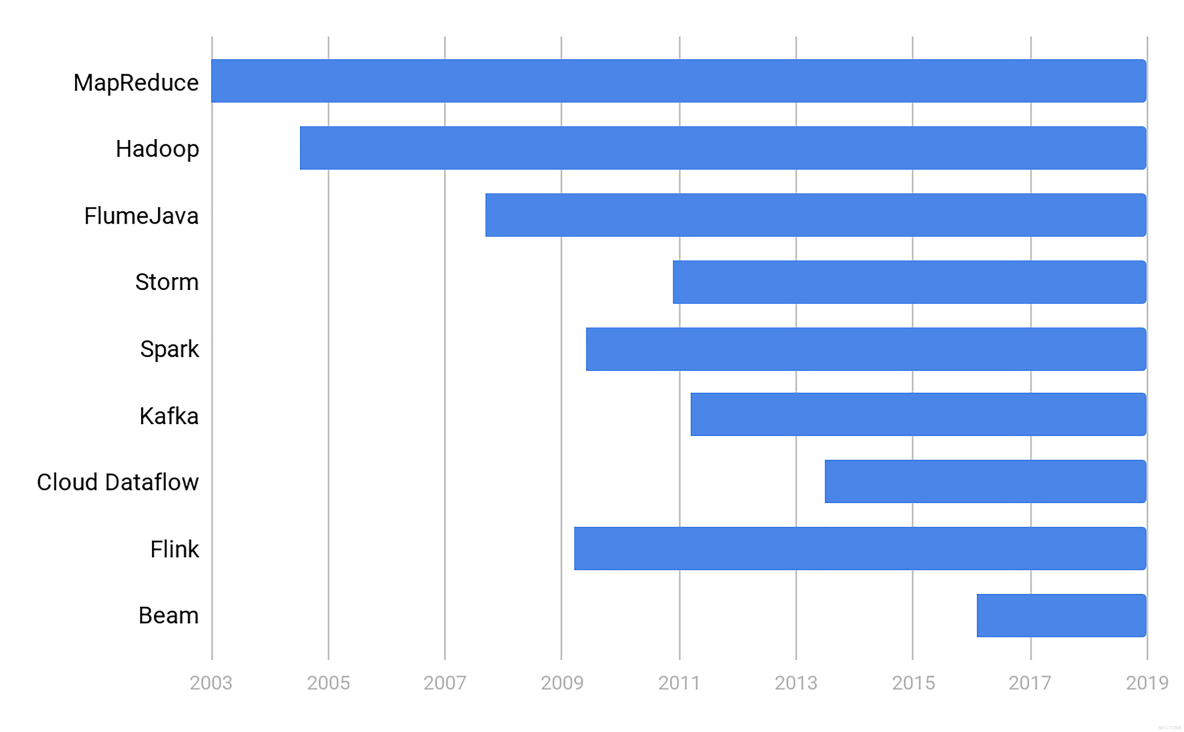

- 一、技術演化:大規模數據處理的三個時代

- 1. 石器時代 —— MapReduce誕生前的混沌狀態

- 2. 青銅時代 —— MapReduce的革命與標準化

- 3. 蒸汽機時代 —— FlumeJava/Apache Beam引領新紀元

- 二、MapReduce為何被淘汰?技術剖析與實例解讀

- 1. 高昂的維護成本 —— 工程複雜性爆炸

- 2. 時間性能“達不到”用户期待 —— 配置與調優難以落地

- 3. 擴展性與統一性不足 —— 新一代需求倒逼範式升級

- 三、對比分析與行業實踐案例

- 1. MapReduce與Spark

- 2. 數據分片策略實踐

- 四、技術趨勢與未來展望

- 1. 批處理與流處理統一——Apache Beam數據流模型

- 2. 面向可測試性、監控性與工程可擴展性的架構設計

- 結論

引言

在互聯網與科技產業高速發展的今天,數據規模以指數級增長。如何高效、穩定地處理、分析與挖掘這些龐大的數據,成為影響企業創新力與競爭力的核心技術挑戰。MapReduce一度是大數據處理領域革命性的解決方案,被廣泛採用。然而近年來,硅谷一線公司卻紛紛棄用MapReduce,轉向更先進的數據處理框架(如FlumeJava及其開源實現Apache Beam)。本文將深入剖析大規模數據處理技術的發展脈絡,覆盤MapReduce的歷史地位,詳解其被淘汰的根本原因,並展望下一代數據處理技術的趨勢與實踐,為開發者、研究者和技術愛好者提供一線認知與工程參考。

一、技術演化:大規模數據處理的三個時代

1. 石器時代 —— MapReduce誕生前的混沌狀態

在2003年前,互聯網公司已面臨極其龐大的數據處理需求。例如Google當時需應對數十億次的搜索請求。各家企業或個人各自開發工具,缺乏統一抽象,處理流程零散且難以複製。

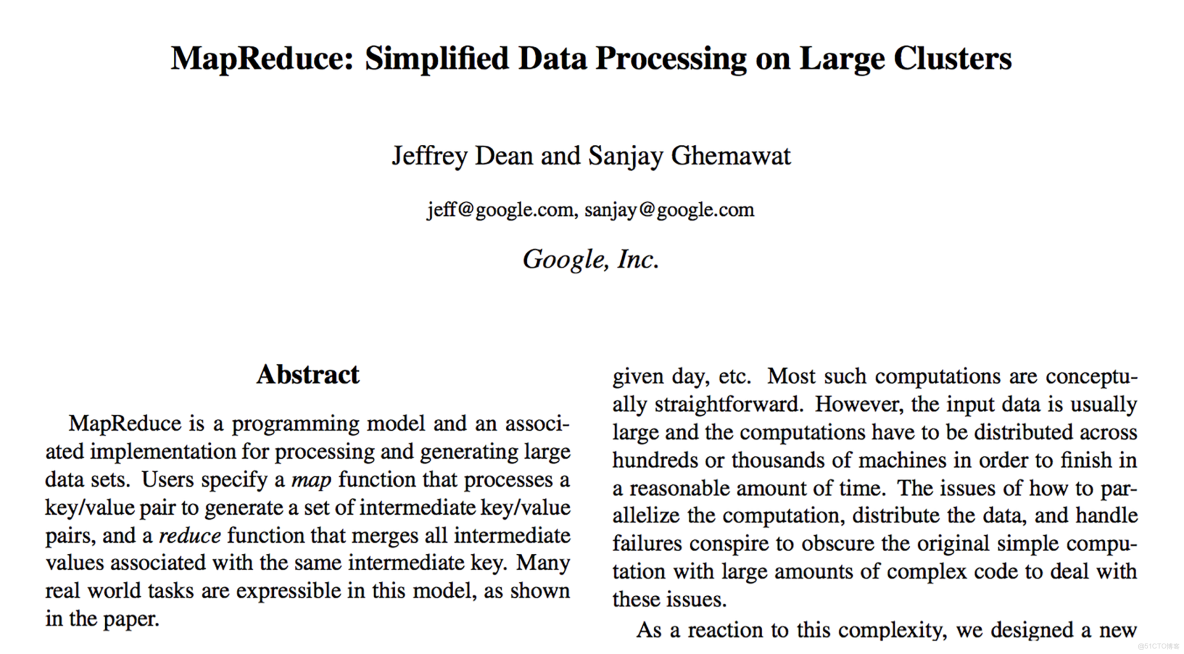

2. 青銅時代 —— MapReduce的革命與標準化

2003年,《MapReduce: Simplified Data Processing on Large Clusters》論文問世,Google的傑夫·迪恩(Jeff Dean)和桑傑·賈馬瓦特(Sanjay Ghemawat)抽象出“Map-Reduce”編程模型,統一了分佈式數據處理邏輯。Hadoop體系在開源社區疾速發展,將GFS、BigTable、MapReduce等架構理念引入大眾技術實踐。這個階段,MapReduce成為超大規模數據處理的行業基準,推動了數據工程、數據分析、人工智能等方向的基礎設施進化。

3. 蒸汽機時代 —— FlumeJava/Apache Beam引領新紀元

到2014年,Google內部已很少新寫MapReduce程序。2016年起,Google用FlumeJava(內部專用,非Apache Flume)替代MapReduce完成新員工培訓,宣佈正式邁入數據處理統一模式的新時代。Apache Beam作為FlumeJava的開源演進,推動了批處理與流處理接口的統一,極大提升了工程效率與可維護性。

二、MapReduce為何被淘汰?技術剖析與實例解讀

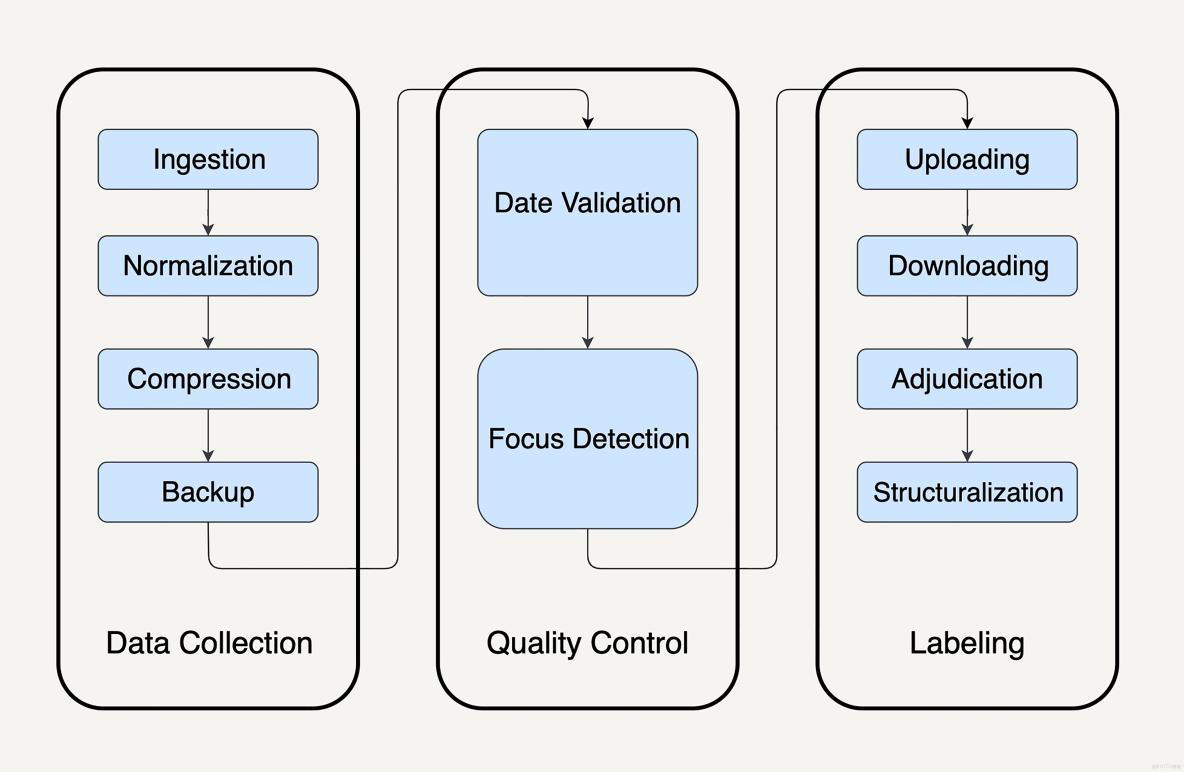

1. 高昂的維護成本 —— 工程複雜性爆炸

MapReduce的核心思想雖簡潔,但在真實業務場景下極端複雜。例如:

假設一家公司需預測美團股價,關鍵指標之一為街頭活躍的美團外賣電動車數量。要求通過處理所有外賣電動車圖片完成指標分析,在實際商用場景下往往需要配置多達十個以上的MapReduce任務鏈:

- 數據導入(分散數據歸集、下載)

- 數據格式統一(不同渠道標準化)

- 數據壓縮(優化存儲資源)

- 數據備份(數據冗餘風險控制)

- 數據有效性、質量控制(時間、清晰度等檢測)

- 人工標註/自動識別(數據矯正與結構化)

每個環節均需處理分佈式異常、狀態機協調、容錯重試,運維和開發人員陷入複雜狀態機、流程管理、錯誤追蹤的泥潭,遠超表面宣傳的“簡單模型”。

許多開發者需自研或選型專門的流程編排系統(如Airflow、Oozie),系統可擴展性、可靠性降級,業務上線週期冗長,維護成本直線上升。

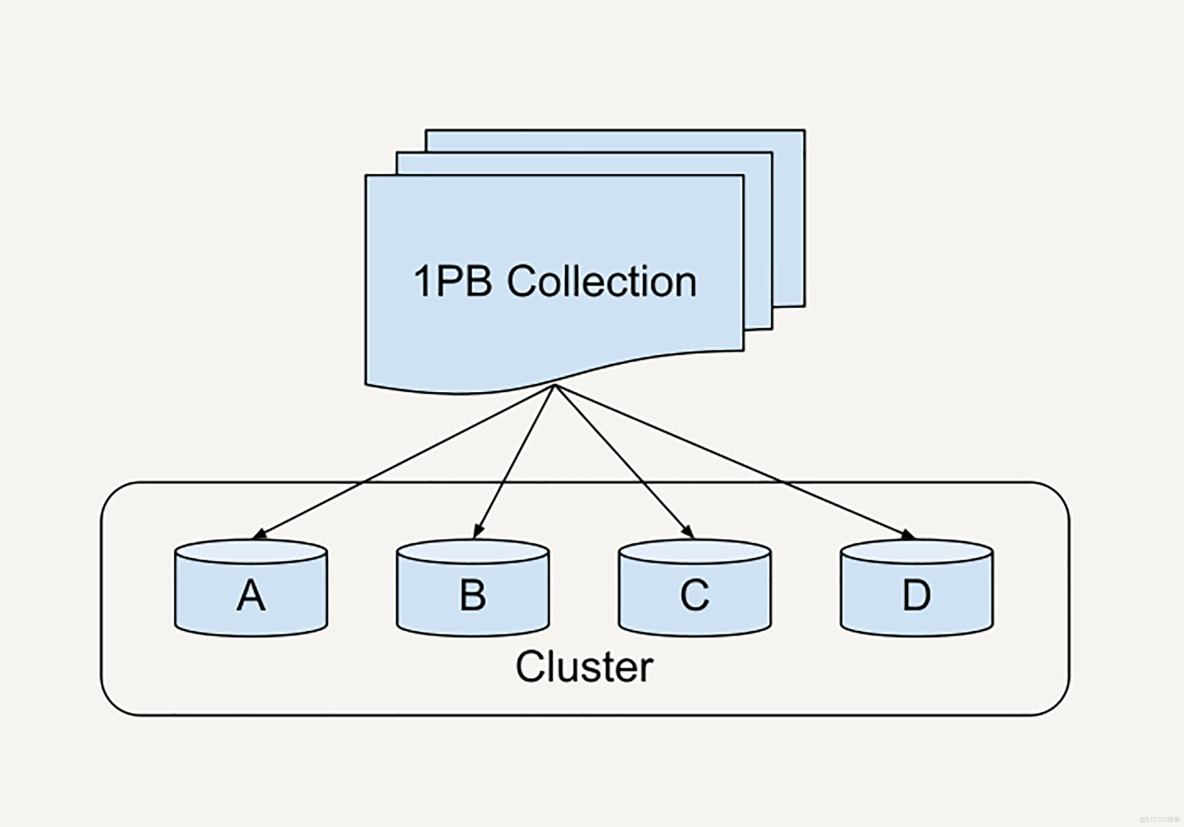

2. 時間性能“達不到”用户期待 —— 配置與調優難以落地

MapReduce對性能的要求極高,參數配置涉及分片(sharding)、緩衝區(buffer)、預讀策略(prefetch)、緩存大小等諸多細節。即使頂尖企業如Google,針對1PB數據的排序實驗,從2007年12小時優化到2012年0.5小時,耗時五年,依賴工程師無數手冊及動態分片技術才能勉強應對業務增長。[1]

實際開發中,初級工程師很難掌握如此豐富的調優技巧,隨時面臨“掉隊者”問題(stragglers),即某台worker被分配的數據超量遲遲未處理,影響整體任務進度。分片策略不合理將導致數據傾斜、節點負載不均、重試困難,嚴重製約系統吞吐能力與性能穩定性。

3. 擴展性與統一性不足 —— 新一代需求倒逼範式升級

隨着“流式數據處理(streaming)”與“批處理(batch)”需求日益融合,傳統MapReduce模型在編程接口、數據調度、監督監控等方面顯露短板。FlumeJava/Apache Beam引入統一編程範式,可實現從單條數據到億級數據的無縫擴展,簡化接口,增強測試與監控能力,推動數據處理範式的系統性升級。

三、對比分析與行業實踐案例

1. MapReduce與Spark

- 複雜度:MapReduce多階段需頻繁讀取磁盤,流程拆分,維護成本高;Spark採用DAG(有向無環圖)建模,鏈式RDD處理,大幅簡化流程與運維。

- 性能:Spark優先基於內存計算,MapReduce依賴磁盤IO,性能差距顯著。

- 數據傾斜處理:Spark 3.0引入動態分片與傾斜partition調整,顯著提升處理均衡性與自動化能力。

2. 數據分片策略實踐

在Facebook等平台處理用户數據時,分片函數設計直接影響均勻性與容錯能力:

- 哈希分片(hash)便於均衡但節點變動需重新分配。

- 一致性哈希環(consistent hashing with virtual nodes)適合維護高可用分佈,但實現較複雜。

- 動態採樣與分區合併/拆分適用於未知分佈但技術門檻高。

- Round Robin分片簡化但容錯弱,易丟失任務恢復能力。

合理採樣字段(如用户ID、註冊時間等),結合動態分片、數據傾斜自動檢測與優化,是實際大規模數據工程所推薦的方案。

四、技術趨勢與未來展望

1. 批處理與流處理統一——Apache Beam數據流模型

批處理(bounded dataset)與流處理(unbounded dataset)早期分屬不同技術範式。隨着實時分析、數據湖等應用場景興起,統一的編程模型成為必然趨勢。Apache Beam以“Dataflow Model”為核心,兼容Spark、Flink、Google Dataflow等多平台,既支持高效批處理,也能優雅應對流數據分析,降低跨平台遷移與學習成本。

2. 面向可測試性、監控性與工程可擴展性的架構設計

新一代數據處理系統強調:

- 可測試性:支持單元測試、集成測試,便於快速驗證與穩定迭代。

- 可監控性:精細化性能指標監控、自動報警與異常檢測。

- 無縫擴展性:兼容從單條數據到億級數據的橫向拓展,無需重構核心邏輯。

結論

MapReduce作為開創性技術模型,於大規模數據處理中扮演了里程碑角色,但其高昂運維成本、調優複雜性、生態落後以及流批需求的無法融合,決定了其被新一代分佈式數據處理技術取代。開發者應積極關注如Apache Beam、Spark等現代大數據處理框架,理解分片策略、異常處理、容錯機制,勇於理解並實踐統一的數據流編程模型。技術升級不僅關乎工具換代,更關乎認知變革與工程實踐的進化。