一、狂飆年代的另一面:熱度背後是結構性焦慮

2025年,中國的機器人賽道正在經歷一場罕見的“資本風暴”。短短一年內,數十家機器人企業密集奔赴IPO,從倉儲、酒店、家居,到農業、醫療、巡檢,無一不在講述自己的“具身智能故事”。

表面上,這是一場繁榮:政策紅利、產業基金、港股“18C通道”,為創業公司提供了前所未有的融資窗口;技術層面,AI感知、動力學控制、語義理解的突破,也為“機器人革命”提供了想象空間。

但如果深入到技術層、商業層與系統層,你會發現另一面:很多機器人的“智能”,依然停留在算法與樣機層;它們能動,但未必能感知——能執行,卻未必能理解。

這正是當前機器人產業的最大斷層:智能大腦在突飛猛進,而感知神經卻依然薄弱。

從技術架構上看,任何“具身智能”都離不開三個基本支柱:

感知(Perception) → 決策(Decision) → 執行(Action)

如今,大量機器人在“決策”和“執行”層面不斷優化,卻忽略了最前端的感知鏈路。而在真實世界,延遲200毫秒與500毫秒的差別,不只是體驗問題,而是安全邊界、能否自主判斷的生死分界。

在這場資本與技術的賽跑中,那些能從“算法公司”轉向“系統型公司”的企業,才真正具備長期生命力。而系統的靈魂,不是AI模型,而是感知基建。

二、機器需要“神經系統”:從“視頻輸入”到“智能感知”的鏈路重構

無論是人形機器人、倉儲搬運機器人,還是巡檢無人機、安防巡邏車,它們都共享同一個事實:

真正驅動智能的,不是算法模型,而是感知鏈路。

在物理世界中,視覺信號是所有感知中信息密度最高的維度。它決定了機器“看見什麼”“理解什麼”,更決定了它能否安全、準確、實時地與環境互動。

然而,今天大量機器人在宣傳中強調“AI算法”“大模型”“自研控制系統”,卻鮮少有人關注——視頻從採集到決策之間的那條管道,是否足夠高效、穩定、低延遲。

一個具身智能系統的真正反應速度,並不是模型計算時間的長短,而是整條視頻鏈路的整體時延:

從攝像頭採集 → 傳輸 → 解碼 → 識別 → 決策 → 反饋,每一步都在消耗時鐘。任何一個環節的不穩定,都可能讓機器“看見”與“行動”之間錯開現實幾百毫秒。

這正是機器人產業最被低估的工程真相:智能的“上限”,往往取決於感知鏈路的“下限”。

因此,真正的機器人操作系統不該只被理解為ROS(Robot Operating System),而是一套能讓視覺、聽覺、觸覺等多模態信號在毫秒級穩定流動的神經通信系統。在這套系統中,視頻鏈路就是機器的“視神經”,而音頻與傳感輸入構成它的“聽覺與觸覺神經”。

SmartMediaKit(大牛直播SDK)正是這條神經幹線的核心構建者之一。它紮根於“視頻感知鏈路層”,以十餘年的工程演化沉澱出穩定的、跨平台的、可嵌入的低延遲視頻傳輸體系。在機器人、無人機、低空巡檢、安防協作、遠程運維等場景中,SmartMediaKit 已不僅僅是“播放或推流工具”,而是整個智能體系統中最接近“神經系統中樞”的一環——它讓機器看得見現實,也能在現實的時間尺度內反應。

三、十年演進:從視頻引擎到智能體的“感知中樞”

任何產業真正的技術突破,都不是一蹴而就的,而是長期積累的結果。如果説當下的“機器人IPO狂潮”代表着感知智能的商業化前夜,那麼 SmartMediaKit(大牛直播SDK)過去十年的演進,則是一條靜默而堅韌的“感知鏈演化史”。

它並非從機器人起步,但卻為機器人時代做好了最紮實的準備。在許多公司還在討論“AI能讓機器多聰明”時,SmartMediaKit 一直在解決一個更基礎的問題:讓機器可靠地“看見”世界。

(一)1.0階段:從“視頻通信”到“低延遲基因”

最初,SmartMediaKit只是一個為實時直播、視頻採集和推流而生的SDK。它的使命很單純——把視頻數據儘可能快、儘可能穩地傳到遠端。然而正是這一目標,逼出了它後來所有的核心能力:

- 自研音視頻引擎,擺脱通用框架的性能瓶頸;

- 精細化時間戳同步與多流管理機制;

- 跨平台一致性與輕量級內核設計。

這一時期,它為“低延遲”建立了工程基因,也形成了“系統化穩定”的產品哲學。在直播行業,這讓它具備了競爭力;在機器人時代,這些特性卻變成了決定機器能否實時感知的核心基礎。

安卓RTMP播放器同時播放4路RTMP流延遲測試

(二)2.0階段:模塊化中台——為“系統”而非“應用”設計

隨着邊緣計算與多端融合的浪潮到來,SmartMediaKit 開始脱離傳統播放器的定義。它將核心功能拆解成若干獨立模塊:RTSP/RTMP 推流、RTSP/RTMP/HTTP-FLV/WS-FLV 超低延遲播放器、輕量級 RTSP Server、HTTP-FLV 與 WS-FLV 服務、GB28181 設備接入、錄像模塊……

每個模塊既可單獨使用,又能以中台形態組合為系統服務。這種“組件化”的架構設計,使 SmartMediaKit 從“一個SDK”演化為“可嵌入的媒體中台”,既能跑在機器人主控板上,也能運行在無人機、安防節點、乃至雲端服務上。

它不再只是一個功能庫,而是一個可重構的感知基礎設施。這正是機器人行業今天最缺乏的能力:

既能上雲,也能下端,既能單機,也能羣協。

Android平台Unity3D下RTMP播放器延遲測試

(三)3.0階段:智能化融合——讓機器“邊看邊理解”

當AI進入實時視頻流,感知鏈路的價值被重新定義。SmartMediaKit 早在設計之處,就支持外部編碼前後、解碼前後的音視頻對接,將AI推理嵌入視頻處理路徑中。

視頻幀不再只是傳輸對象,而是實時分析的輸入源。AI模型(YOLO、NCNN、TensorRT等)直接在流中被調用,實現“看見 → 理解 → 標註 → 反饋”的閉環。

這讓SmartMediaKit第一次從“傳輸層”躍升到“認知層”:它不僅服務於播放,更參與了決策鏈本身。

在工業機器人中,它幫助系統在毫秒級內識別異常信號;在低空無人機中,它讓前端攝像流可實時推送目標檢測結果;在安防系統中,它直接對接GB28181平台,將“識別事件”轉換為“控制命令”。

這意味着:視頻不再是被動信號,而是主動感知。

SmartMediaKit由此成為AI智能體系統中不可或缺的“感知中樞”。

Android平台RTSP播放器時延測試

(四)技術哲學的轉變:從“做視頻”到“做神經”

十年間,SmartMediaKit的邊界不斷擴大,但它的核心理念始終未變:把延遲做到極致,把鏈路做到可複用。

從直播到機器人,從播放到AI協同,它始終在回答同一個問題:——當機器要面對真實世界,它需要什麼樣的神經系統?

SmartMediaKit的答案是:一個穩定、可編排、跨平台、能嵌入AI的低延遲視頻神經網絡。正是這種長期主義的底層積累,讓它在機器人產業浪潮到來之前,已經悄然具備了承載“智能體視頻基建”的完整能力。

Windows平台 RTSP vs RTMP播放器延遲大比拼

四、低延遲,是智能化的生存邊界

在機器人系統中,“延遲”不是性能參數,而是生死線。越過200ms,機器就會“脱離現實”;控制信號與畫面不同步,智能就成了幻覺。真正能在端到端維度穩定壓縮至<200ms 的系統少之又少。多數實驗室數據停留在理想網絡下,現實環境中波動巨大。SmartMediaKit 的優勢就在於——它把低延遲做成了工程學,而非論文。

1️⃣ 多層時序控制:系統內部的 JitterBuffer 自適應算法持續感知網絡抖動,以毫秒級的節奏調整播放速率與同步策略。無論是多實例播放、雙向回傳還是邊緣協作,SmartMediaKit 都能讓畫面與控制“處在同一拍點”。

2️⃣ 低拷貝傳輸:在底層內核中,SmartMediaKit 讓視頻幀在 CPU 與 GPU 之間低拷貝流轉。數據不再被重複搬運,而是在內存池中以流水線方式直通處理,顯著降低系統延遲與功耗,也避免了多線程環境的緩存抖動。

在具身智能時代,這不是技術細節,而是生存條件。AI 模型的識別率再高,如果延遲讓機器反應慢半拍,那就意味着——“看見”與“行動”之間,永遠隔着一堵牆。低延遲,不只是體驗,更是智能系統的存在方式。

低延遲,不是附加功能,而是生存條件。

Android平台Unity共享紋理模式RTMP播放延遲測試

五、從單體機器人到羣體智能:感知協同的未來

機器人行業的下一個臨界點,不在“單體智能”,而在“羣體協同”。當一台機器具備實時感知能力,它只是一個個體;當數百台機器能共享感知、協同決策,它才構成真正的智能體系。

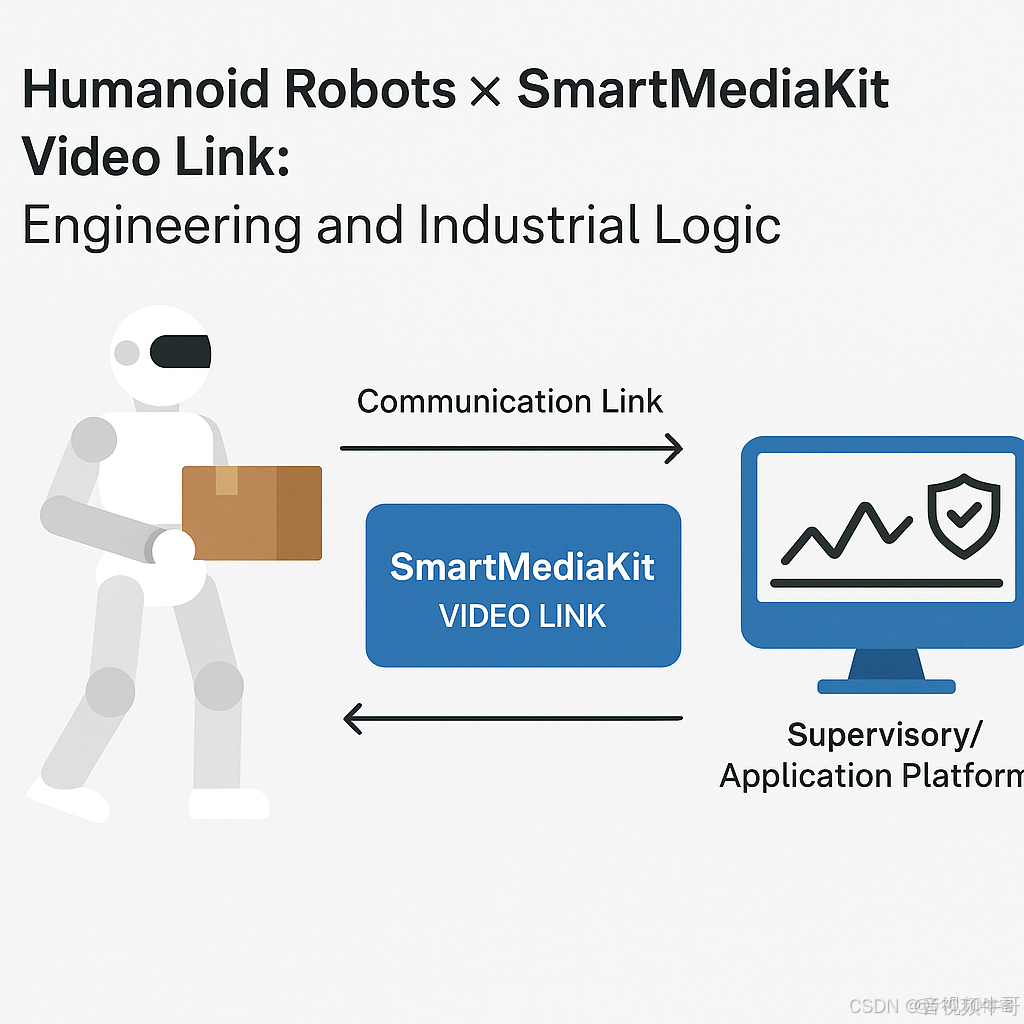

未來的無人機編隊、倉儲調度系統、園區巡檢網絡、安防聯動平台,都需要多節點實時同步、動態調度與跨域決策。而這背後的技術支點,不是某個AI模型,而是一套統一的“視頻感知中樞”——

能讓感知流在“機器人 ↔ 平台 ↔ 雲端AI”之間自由流動、低延遲閉環的系統。

1️⃣ SmartHTTPServerMgr:羣體可視化與多節點實時管理

在分佈式場景下,SmartHTTPServerMgr 充當了可視化調度核心。它通過輕量級 HTTP-FLV 與 WS-FLV 服務,讓多個機器人視頻流可同時接入同一Web控制端,支持多路畫面拼接、實時狀態監控與跨終端可視化。在智慧園區與無人巡檢系統中,它能讓指揮中心“一屏總覽”,形成真正意義上的多點實時“視頻神經網絡”。

2️⃣ SmartGBD(GB28181接入模塊):打通政企級視頻中樞

SmartGBD 是 SmartMediaKit 在行業融合中的關鍵節點。兼容 GB28181-2016/2022 協議,讓機器人、無人機、移動終端都能以標準國標方式接入公安、能源、交通、政企安防平台。這意味着機器人的視頻鏈路不再孤立,而能直接納入城市級監控體系,實現“前端智能節點 → 中樞調度平台”的低延遲直連。對於巡檢機器人、警用無人機、能源企業而言,這讓“看得見”真正變成了“能協同”。

3️⃣ SmartRecorder(MP4 Sinker):可追溯的分佈式記憶

在多節點系統中,實時只是感知的一半,記錄才是記憶的開始。SmartRecorder 體系提供了高性能、本地可裁剪的 MP4/FLV 錄像模塊,支持邊推邊錄、前後時段緩存、斷點續錄與遠程同步存儲。這些能力讓每個機器人都具備“自我日誌”功能,在羣體協作中既能共享實時畫面,也能保留獨立證據鏈。在工業巡檢、能源管控、安防執法等場景中,這一模塊成為系統可審計性的重要保障。

4️⃣ SmartAIAdapter:從“看見”到“行動”的神經突觸

SmartAIAdapter 是 SmartMediaKit 通往具身智能的關鍵接口。它讓視頻流可在邊緣側直接嵌入 AI 推理模塊(YOLO、TensorRT、NCNN 等),並以事件驅動形式向控制層回傳識別結果。當機器人識別出“異常”、“危險”或“任務目標”時,AIAdapter 能即時觸發 SmartPublisher 推流、SmartRecorder 錄像或控制系統指令,真正實現“看見即行動”。

它是機器視覺神經系統中的“突觸層”,負責將感知信號轉化為動作信號。

5️⃣ SmartPublisher / SmartPlayer:雲邊協同的雙向入口

SmartPublisher 負責視頻上行,SmartPlayer 負責視頻下行,兩者共同構成 SmartMediaKit 在雲邊通信中的基礎入口。通過 RTSP、RTMP、HTTP-FLV多協議支持,系統可在不同網絡形態下穩定運行,實現多機器人、跨域平台的實時音視頻互通。

在協同作業場景中,它們就是機器神經系統的“輸入與輸出神經元”。

6️⃣ SmartRTSPServer:

視頻感知的“交換中樞”這三個模塊構成 SmartMediaKit 的輕量級流媒體內核,為機器人集羣提供自建分發、邊緣中繼與協議轉換能力。相比傳統雲平台方案,它無需龐大服務器集羣,即可在局域網內完成多節點流分發,支持“邊緣即中樞”的低延遲部署模式。

這讓機器人系統能在本地自治運行,同時保持對外開放性。

7️⃣ 感知雲邊一體:機器的神經網絡架構

這些模塊共同構成了一個高度協同的“感知雲邊一體系統”:

- 機器人是前端神經末梢;

- SmartMediaKit 各模塊是神經幹線與突觸;

- 平台AI與決策系統則是中樞大腦。

感知數據在邊緣採集、在中台匯聚、在雲端理解,形成真正意義上的“具身智能神經迴路”。

無論是無人機集羣巡檢、機器人編隊協作,還是城市安防與低空經濟網絡,SmartMediaKit 正成為這一代智能系統的“視覺骨架”與“神經底座”。

六、行業啓示:從“可用”到“可複用”的躍遷

今天的機器人行業正站在一個新的分水嶺上。過去的競爭圍繞算法、算力和融資展開,而如今,真正的分水線在於——誰能讓系統穩定、可複製、可演進。

在早期階段,機器人更多是“樣機智能”——能演示、能感知、能運行。但要邁向“系統智能”,企業必須跨過一條看不見的門檻:複用性。所謂複用,不只是“把技術再用一次”,而是讓模塊具備跨場景遷移、跨平台適配與長期演進的能力。這既是一種工程哲學,也是一種產業戰略。

在這個意義上,感知基建是最具複用價值的部分。視頻感知、音頻採集、AI識別、協議服務、邊緣推流,這些能力不僅屬於機器人,也屬於無人機、安防終端、教育機器人、醫療輔具乃至工業檢測系統。一旦底層架構足夠標準化、接口足夠開放,它就能成為整個智能生態的“共用神經”。

SmartMediaKit 正是沿着這條複用路徑演化而來。它的架構並非單一應用定製,而是跨平台、跨形態、跨生態的通用感知中台。無論是 Android/iOS 的移動端設備,還是 Windows/Linux 的工業主機,甚至 Unity3D虛擬仿真環境,都能以相同的接口和邏輯嵌入 SmartMediaKit 模塊體系。

這種一致性帶來的,不僅是開發效率的提升,更是企業生命週期的延長。當行業進入整合期,算法迭代會過時,融資窗口會關閉,但那些在底層打磨出“可複用標準”的系統,反而能成為生態的穩定支點。

真正能穿越資本週期的,不是最快上市的企業,而是那些讓別人也能“複用”的企業。在智能化浪潮中,複用性就是延續性,架構就是護城河。

七、結語:當機器真正“看見”

機器人IPO的狂潮,像極了當年的移動互聯網浪潮。熱度之下,資本會退潮,概念會冷卻,但留下的,一定是那些在底層默默構築基建的人。

SmartMediaKit 的故事正是這股浪潮的縮影。當行業熱議大模型、算法、算力時,它選擇了另一條更艱難也更根本的路——讓機器真正看見世界。在它的架構中,低延遲不只是指標,而是反應速度的生命線;模塊化不只是結構,而是系統複用的基因;跨平台不只是兼容,而是一種長期的生態設計。

未來的智能競爭,不再是算法快與慢的比拼,而是系統能否在真實世界中持續運轉。當機器具備感知、理解、協同的能力,它不只是工具,而是一個能參與世界的“智能體”。

真正的智能,不在實驗室的模型裏,而在延遲被壓縮到毫秒、畫面與決策同步的那一瞬間。那時,機器不再只是“被控制”,而是真正參與現實的存在。

當機器真正看見,智能就不再是算法的產物,而是世界的一部分。