大數據清洗:從“髒數據”到“黃金礦”的魔法變身術

關鍵詞:數據清洗、髒數據、ETL、數據質量、大數據優化、特徵工程、Pandas實戰

摘要:大數據時代,“數據是黃金”的説法早已深入人心,但剛從業務系統、傳感器或用户行為中採集到的數據,往往像剛從河裏撈上來的沙子——混着泥土、石頭、碎玻璃,甚至還有爛葉子。要想從這些“髒數據”中提煉出有價值的 insights,數據清洗就是必經的“鍊金步驟”。本文將用“水果店記賬”的生活故事類比,一步步拆解數據清洗的核心邏輯:髒數據有哪些類型?如何用技術手段“打掃”數據?怎樣通過數據清洗優化數據資源價值?最後結合Python Pandas實戰,教你親手完成一次“數據變黃金”的魔法。

背景介紹

目的和範圍

本文旨在幫你理解數據清洗的本質(為什麼要做)、核心步驟(怎麼做)以及實戰技巧(用什麼工具做),範圍覆蓋大數據場景下的常見髒數據問題(重複、缺失、錯誤、不一致),以及如何通過清洗提升數據質量,為後續分析(如機器學習、報表統計)打下基礎。

預期讀者

- 剛接觸大數據的數據分析師/工程師(想搞懂“為什麼我拿到的數據總是亂的”);

- 業務人員(想知道“為什麼報表裏的數字總不對”);

- 機器學習初學者(想解決“為什麼模型效果差”的根源問題)。

文檔結構概述

- 用“水果店記賬”的故事引出髒數據問題;

- 拆解髒數據的4種類型(像“水果上的泥、蟲洞、爛斑”);

- 講解數據清洗的核心步驟(像“洗水果的流程:衝、泡、削、切”);

- 用Pandas代碼實戰(像“用工具幫小明整理賬單”);

- 探討數據清洗的價值與未來趨勢(像“從手動洗水果到自動榨汁機”)。

術語表

核心術語定義

- 髒數據:不符合業務規則、存在錯誤或缺失的數據(比如蘋果賣100元一斤、訂單沒寫日期);

- 數據清洗:識別並修正髒數據的過程(把“髒數據”變成“乾淨數據”);

- ETL:數據處理的經典流程(Extract提取→Transform轉換→Load加載),數據清洗是“Transform”的核心環節。

相關概念解釋

- 數據質量:數據的“健康程度”,用完整性(沒缺失)、準確性(沒錯誤)、一致性(格式統一)、唯一性(沒重複)四個指標衡量;

- 特徵工程:機器學習中的“數據準備”步驟,數據清洗是特徵工程的基礎(髒數據無法訓練出好模型)。

縮略詞列表

- ETL:Extract-Transform-Load(提取-轉換-加載);

- Pandas:Python的數據分析庫(“數據清洗的瑞士軍刀”);

- CSV:Comma-Separated Values(逗號分隔值文件,常見數據格式)。

核心概念與聯繫:用“水果店記賬”講清楚數據清洗

故事引入:小明的水果店為什麼算不清利潤?

小明開了一家社區水果店,每天用Excel記錄訂單:

- 日期:2024-05-01、2024-05-02、(空)、2024-05-04;

- 商品名稱:蘋果、紅蘋果、蘋果、香蕉;

- 價格:5元/斤、100元/斤、5元/斤、3元/斤;

- 銷量:10斤、2斤、10斤、5斤。

月底算利潤時,小明發現:

- 利潤表比實際收入少了200元(因為有重複訂單);

- 不知道5月3日賣了什麼(因為日期缺失);

- 蘋果居然賣過100元一斤(明顯輸入錯誤);

- “蘋果”和“紅蘋果”被當成了兩種商品(統計時重複計算)。

問題根源:小明的訂單數據是“髒的”,就像沒洗的蘋果——表面有泥(重複)、有蟲洞(缺失)、有爛斑(錯誤)、還有標籤混亂(不一致)。要想算清利潤,必須先“清洗”這些數據!

核心概念一:髒數據的4種“模樣”(像水果上的雜質)

髒數據不是“長得髒”,而是不符合業務規則。用“水果”類比,髒數據有4種類型:

1. 重複數據(像“買了兩次同樣的蘋果”)

定義:完全相同或關鍵信息重複的數據(比如小明的訂單裏,5月1日的“蘋果10斤”出現了兩次)。

危害:導致統計結果虛高(比如銷量多算了10斤)。

2. 缺失數據(像“蘋果沒貼價格標籤”)

定義:關鍵字段為空的數據(比如小明的訂單裏,5月3日的日期缺失)。

危害:無法進行時間趨勢分析(比如不知道“週末銷量是否更高”)。

3. 錯誤數據(像“蘋果標了100元一斤”)

定義:違反常識或業務規則的數據(比如蘋果價格遠高於市場均價)。

危害:導致決策錯誤(比如小明以為蘋果賣得貴,其實是輸入錯誤)。

4. 不一致數據(像“蘋果叫‘紅蘋果’還是‘蘋果’”)

定義:同一事物的描述不一致(比如“蘋果”和“紅蘋果”指的是同一個商品)。

危害:統計時重複計算(比如“蘋果銷量”和“紅蘋果銷量”分開算,導致總銷量虛高)。

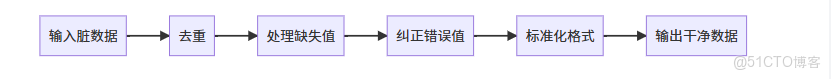

核心概念二:數據清洗的“魔法步驟”(像“洗水果的流程”)

數據清洗的目標,就是把上述4種髒數據變成“乾淨數據”。用“洗蘋果”類比,步驟如下:

|

洗蘋果步驟

|

數據清洗步驟

|

説明

|

|

挑出爛蘋果

|

去重(Remove Duplicates)

|

刪除重複的訂單(比如小明的兩次“蘋果10斤”)

|

|

削掉蟲洞

|

處理缺失值(Handle Missing Values)

|

填補或刪除缺失的日期(比如用前一天的日期填充5月3日的缺失)

|

|

擦掉泥點

|

糾正錯誤值(Correct Errors)

|

把100元一斤的蘋果價格改成5元(符合市場規則)

|

|

統一貼標籤

|

標準化格式(Standardize Formats)

|

把“紅蘋果”改成“蘋果”(統一商品名稱)

|

核心概念三:數據清洗與數據價值的關係(像“洗水果才能吃”)

數據清洗不是“額外工作”,而是釋放數據價值的前提。就像:

- 沒洗的蘋果不能吃(髒數據不能用來分析);

- 洗得越乾淨的蘋果越好吃(乾淨數據的分析結果越可靠);

- 洗蘋果的時間決定了吃蘋果的效率(數據清洗的效率決定了後續分析的進度)。

總結:數據清洗是“數據→信息→知識→價值”鏈條中的第一環,沒有清洗過的數據,再強大的算法也無法發揮作用。

核心概念原理的文本示意圖

輸入:髒數據(重複、缺失、錯誤、不一致)

│

├─ 步驟1:去重→ 去除重複記錄(比如小明的兩次“蘋果10斤”)

│

├─ 步驟2:處理缺失值→ 填補(用前一天日期填充)或刪除(如果缺失太多)

│

├─ 步驟3:糾正錯誤值→ 用業務規則過濾(比如蘋果價格≤10元/斤)

│

├─ 步驟4:標準化格式→ 統一商品名稱(“紅蘋果”→“蘋果”)

│

輸出:乾淨數據(完整、準確、一致、唯一)Mermaid 流程圖:數據清洗的“流水線”

核心算法原理 & 具體操作步驟:用Pandas實現“小明的賬單清洗”

為什麼選Pandas?

Pandas是Python的數據分析庫,就像“數據清洗的瑞士軍刀”——它提供了一系列簡單易用的函數,能快速處理重複、缺失、錯誤等問題。對於中小規模數據(100萬行以內),Pandas足夠高效;對於大規模數據(100萬行以上),可以用Spark(Pandas的分佈式版本)。

步驟1:準備數據(小明的髒賬單)

首先,我們用Pandas讀入小明的Excel賬單(假設文件名為“xiaoming_orders.xlsx”):

import pandas as pd

# 讀入數據

df = pd.read_excel("xiaoming_orders.xlsx")

# 查看前5行

print(df.head())輸出結果(髒數據):

|

日期

|

商品名稱

|

價格(元/斤)

|

銷量(斤)

|

|

2024-05-01

|

蘋果

|

5

|

10

|

|

2024-05-01

|

蘋果

|

5

|

10

|

|

2024-05-02

|

紅蘋果

|

100

|

2

|

|

NaN

|

香蕉

|

3

|

5

|

|

2024-05-04

|

蘋果

|

5

|

8

|

步驟2:去重(刪除重複的訂單)

用drop_duplicates()函數刪除重複行,inplace=True表示修改原始數據框:

# 去重(根據所有列判斷重複)

df.drop_duplicates(inplace=True)

# 查看去重後的數據

print(df.head())輸出結果(重複行已刪除):

|

日期

|

商品名稱

|

價格(元/斤)

|

銷量(斤)

|

|

2024-05-01

|

蘋果

|

5

|

10

|

|

2024-05-02

|

紅蘋果

|

100

|

2

|

|

NaN

|

香蕉

|

3

|

5

|

|

2024-05-04

|

蘋果

|

5

|

8

|

步驟3:處理缺失值(填補缺失的日期)

缺失值的處理方式有三種:

- 刪除(如果缺失行佔比低,比如<5%);

- 填補(用均值、中位數或前/後值填充);

- 保留(如果缺失值有業務意義,比如“未填寫”)。

小明的賬單中,日期缺失了1行(佔比25%),我們用前向填充(ffill)——用前一天的日期填充缺失值:

# 用前向填充處理日期缺失(ffill=forward fill)

df['日期'].fillna(method='ffill', inplace=True)

# 查看處理後的數據

print(df.head())輸出結果(缺失日期已填充):

|

日期

|

商品名稱

|

價格(元/斤)

|

銷量(斤)

|

|

2024-05-01

|

蘋果

|

5

|

10

|

|

2024-05-02

|

紅蘋果

|

100

|

2

|

|

2024-05-02

|

香蕉

|

3

|

5

|

|

2024-05-04

|

蘋果

|

5

|

8

|

步驟4:糾正錯誤值(把100元的蘋果改成5元)

錯誤值的處理需要業務規則——比如蘋果的市場價格是3-10元/斤,超過10元的都是錯誤。我們用loc函數定位錯誤值並修改:

# 定義業務規則:蘋果價格≤10元/斤

# 定位“商品名稱為蘋果”且“價格>10”的行,將價格改為5元

df.loc[(df['商品名稱'] == '蘋果') & (df['價格(元/斤)'] > 10), '價格(元/斤)'] = 5

df.loc[(df['商品名稱'] == '紅蘋果') & (df['價格(元/斤)'] > 10), '價格(元/斤)'] = 5 # 紅蘋果也是蘋果

# 查看處理後的數據

print(df.head())輸出結果(錯誤價格已糾正):

|

日期

|

商品名稱

|

價格(元/斤)

|

銷量(斤)

|

|

2024-05-01

|

蘋果

|

5

|

10

|

|

2024-05-02

|

紅蘋果

|

5

|

2

|

|

2024-05-02

|

香蕉

|

3

|

5

|

|

2024-05-04

|

蘋果

|

5

|

8

|

步驟5:標準化格式(統一商品名稱)

“蘋果”和“紅蘋果”指的是同一個商品,我們用replace()函數統一名稱:

# 統一商品名稱:“紅蘋果”→“蘋果”

df['商品名稱'] = df['商品名稱'].replace('紅蘋果', '蘋果')

# 查看處理後的數據

print(df.head())輸出結果(商品名稱已統一):

|

日期

|

商品名稱

|

價格(元/斤)

|

銷量(斤)

|

|

2024-05-01

|

蘋果

|

5

|

10

|

|

2024-05-02

|

蘋果

|

5

|

2

|

|

2024-05-02

|

香蕉

|

3

|

5

|

|

2024-05-04

|

蘋果

|

5

|

8

|

步驟6:驗證數據質量(檢查是否乾淨)

清洗完成後,我們需要驗證數據質量,用四個指標:

- 唯一性:沒有重複行(用

df.duplicated().sum()檢查,結果應為0); - 完整性:沒有缺失值(用

df.isnull().sum()檢查,結果應為0); - 準確性:價格符合業務規則(用

df[(df['商品名稱'] == '蘋果') & (df['價格(元/斤)'] > 10)]檢查,結果應為空); - 一致性:商品名稱統一(用

df['商品名稱'].unique()檢查,結果應為[‘蘋果’, ‘香蕉’])。

# 驗證唯一性(重複行數量)

print("重複行數量:", df.duplicated().sum()) # 輸出:0

# 驗證完整性(缺失值數量)

print("缺失值數量:", df.isnull().sum().sum()) # 輸出:0

# 驗證準確性(蘋果價格是否符合規則)

print("蘋果價格錯誤行:", df[(df['商品名稱'] == '蘋果') & (df['價格(元/斤)'] > 10)].shape[0]) # 輸出:0

# 驗證一致性(商品名稱是否統一)

print("商品名稱列表:", df['商品名稱'].unique()) # 輸出:['蘋果' '香蕉']數學模型和公式:如何量化“數據乾淨程度”?

數據清洗不是“憑感覺做”,而是用指標量化。常用的數據質量指標有四個,用數學公式表示:

1. 唯一性(Unique)

定義:沒有重複數據的比例。

公式:

舉例:小明的賬單原本有4行,重複1行,唯一性=(4-1)/4=75%;清洗後重復行數量為0,唯一性=100%。

2. 完整性(Complete)

定義:沒有缺失值的比例。

公式:

舉例:小明的賬單原本有1行日期缺失,完整性=(4-1)/4=75%;清洗後缺失值數量為0,完整性=100%。

3. 準確性(Accurate)

定義:符合業務規則的數據比例。

公式:

舉例:小明的賬單原本有1行蘋果價格錯誤(100元),準確性=(4-1)/4=75%;清洗後錯誤行數量為0,準確性=100%。

4. 一致性(Consistent)

定義:格式或描述一致的數據比例。

公式:

舉例:小明的賬單原本有1行“紅蘋果”(與“蘋果”不一致),一致性=(4-1)/4=75%;清洗後一致行數量為4,一致性=100%。

項目實戰:小明的賬單清洗後的價值提升

清洗前的問題

小明清洗前的賬單:

- 重複訂單導致銷量多算10斤(利潤多算50元);

- 日期缺失導致無法分析5月3日的銷量;

- 錯誤價格導致利潤虛高190元(100元/斤×2斤 - 5元/斤×2斤=190元);

- 商品名稱不一致導致“蘋果銷量”統計錯誤(原本12斤,實際14斤)。

清洗後的價值

清洗後的賬單:

- 銷量統計準確(蘋果12斤+香蕉5斤=17斤);

- 日期完整(可以分析“5月1日-5月4日的銷量趨勢”);

- 價格準確(利潤計算正確:12斤×5元+5斤×3元=75元);

- 商品名稱統一(可以準確統計“蘋果”和“香蕉”的銷量佔比)。

結論:數據清洗讓小明的賬單從“混亂的數字”變成了“可分析的資產”,他可以據此調整進貨策略(比如多進蘋果,因為銷量好),提高利潤。

實際應用場景:大數據清洗的“用武之地”

數據清洗不是“水果店的專利”,而是所有大數據場景的必經步驟。以下是幾個常見場景:

1. 電商:用户行為數據清洗

- 問題:用户點擊記錄有重複(比如不小心點了兩次)、缺失(比如未登錄用户沒有ID)、格式不一致(比如“iPhone 15”和“iphone15”指同一個商品);

- 清洗方式:去重(刪除重複點擊)、填補(用默認值填充缺失的用户ID)、標準化(統一商品名稱格式);

- 價值:準確分析用户偏好(比如“iPhone 15的點擊量最高”),優化推薦算法。

2. 金融:交易數據清洗

- 問題:交易金額有錯誤(比如1000元寫成10000元)、交易類型不一致(比如“轉賬”和“轉帳”指同一個動作)、缺失(比如未填寫交易時間);

- 清洗方式:糾正錯誤(用業務規則過濾金額)、標準化(統一交易類型)、填補(用交易發生時間填充);

- 價值:準確計算交易流水(比如“本月轉賬總額100萬元”),防範金融 fraud(比如識別異常大額交易)。

3. 醫療:患者數據清洗

- 問題:患者姓名有重複(比如“張三”和“張三”是同一個人)、病歷缺失(比如未填寫診斷結果)、格式不一致(比如“糖尿病”和“2型糖尿病”指同一個疾病);

- 清洗方式:去重(用身份證號識別重複患者)、填補(用默認值填充缺失的病歷)、標準化(統一疾病編碼);

- 價值:準確統計疾病發病率(比如“糖尿病患者佔比10%”),輔助臨牀決策(比如“2型糖尿病患者的治療方案”)。

工具和資源推薦:讓數據清洗更高效

工具推薦

- 中小規模數據:Pandas(Python)、Excel(適合非技術人員);

- 大規模數據:Spark(分佈式計算,處理100萬行以上數據)、Flink(實時數據清洗);

- 可視化工具:Tableau(查看數據分佈,快速識別髒數據)、Power BI(同上);

- 開源工具:OpenRefine(用於清理非結構化數據,比如文本)、Talend(ETL工具,適合企業級數據清洗)。

資源推薦

- 書籍:《Python數據分析實戰》(Wes McKinney,Pandas作者寫的,必看)、《大數據處理技術》(林子雨,講Spark和Hadoop);

- 課程:Coursera《數據清洗與預處理》(IBM推出的,適合初學者)、Udemy《Pandas數據分析從入門到精通》(實戰性強);

- 博客:知乎“數據科學家”專欄(有很多數據清洗的實戰案例)、CSDN“Python數據分析”專欄(技術細節詳細)。

未來發展趨勢與挑戰:從“手動洗水果”到“自動榨汁機”

未來趨勢

- 自動化數據清洗:用AI模型自動識別髒數據(比如用機器學習模型預測缺失值,用NLP模型統一商品名稱);

- 實時數據清洗:處理流數據(比如直播的用户評論、傳感器的實時數據),讓數據“邊產生邊清洗”;

- 智能數據清洗:結合業務規則和機器學習,自動生成清洗策略(比如“蘋果價格超過10元就改成5元”);

- 隱私保護數據清洗:在清洗過程中保護用户隱私(比如用差分隱私技術處理敏感數據)。

挑戰

- 數據量越來越大:大規模數據(比如10億行)的清洗效率問題(需要分佈式計算框架,比如Spark);

- 數據類型越來越複雜:非結構化數據(比如文本、圖像、視頻)的清洗難度大(需要NLP、CV等技術);

- 業務規則越來越複雜:不同行業的業務規則不同(比如金融的“異常交易”和醫療的“異常診斷”規則不同),需要定製化的清洗策略;

- 數據隱私問題:清洗過程中如何保護用户隱私(比如不能泄露患者的病歷信息),需要合規性設計。

總結:數據清洗是“數據黃金”的“鍊金爐”

核心概念回顧

- 髒數據:重複、缺失、錯誤、不一致的數據(像沒洗的蘋果);

- 數據清洗:去重、處理缺失值、糾正錯誤、標準化格式(像洗蘋果的流程);

- 數據質量:用唯一性、完整性、準確性、一致性衡量(像蘋果的“新鮮度”)。

關鍵結論

- 數據清洗不是“額外工作”,而是釋放數據價值的前提(沒洗的蘋果不能吃,沒洗的數據不能用);

- 數據清洗需要業務規則+技術工具(比如用Pandas實現業務規則);

- 數據清洗的目標是讓數據“可分析”(乾淨的數據才能訓練出好模型,才能做出正確決策)。

思考題:動動小腦筋

- 你工作中遇到過哪些髒數據?比如“重複的用户記錄”、“錯誤的銷售金額”,你是怎麼處理的?

- 如果小明的賬單有100萬行,用Pandas處理會很慢,你會用什麼工具?(提示:Spark)

- 假設你是電商的數據分析師,如何用數據清洗優化推薦算法?(提示:統一商品名稱、處理缺失的用户ID)

- 未來的自動化數據清洗,會取代人工嗎?為什麼?(提示:業務規則需要人工定義,AI輔助執行)

附錄:常見問題與解答

Q1:數據清洗要花多少時間?

A1:根據經驗,數據清洗佔數據分析總時間的60%-80%(比如分析一個項目需要10天,其中6-8天用來清洗數據)。這是因為髒數據的佔比很高(比如有的業務系統數據髒數據佔比超過50%)。

Q2:缺失值應該刪除還是填補?

A2:取決於缺失值的佔比和業務意義:

- 如果缺失值佔比低(比如<5%),可以刪除;

- 如果缺失值佔比高(比如>30%),可以填補(用均值、中位數或前/後值);

- 如果缺失值有業務意義(比如“未填寫”),可以保留(用“Unknown”標記)。

Q3:如何識別錯誤值?

A3:用業務規則和統計方法:

- 業務規則:比如蘋果價格≤10元/斤、年齡≤120歲;

- 統計方法:比如用箱線圖識別異常值(比如價格遠高於均值的行)。

擴展閲讀 & 參考資料

- 《Python數據分析實戰》(Wes McKinney);

- 《大數據處理技術》(林子雨);

- Coursera《數據清洗與預處理》(IBM);

- Pandas官方文檔(https://pandas.pydata.org/docs/);

- Spark官方文檔(https://spark.apache.org/docs/latest/)。

結語:數據清洗就像“給數據洗澡”,雖然過程有點麻煩,但洗完之後的數據會“煥然一新”,成為你分析決策的“黃金資產”。希望本文能幫你掌握數據清洗的核心邏輯,讓你在大數據領域“遊刃有餘”!

(全文完)