文本生成圖片

Qwen-Image (28B,文生圖) 模型大小:57GB https://www.modelscope.cn/models/Qwen/Qwen-Image

Qwen-Image-Edit-2509 (28B,圖文生圖) 模型大小:60GB https://www.modelscope.cn/models/Qwen/Qwen-Image-Edit-2511

Qwen 系列中的一個圖像生成基礎模型,在 複雜文本渲染 和 精確圖像編輯 方面取得了顯著進展。實驗顯示,該模型在圖像生成和編輯方面具有強大的通用能力,特別是在文本渲染方面表現出色,尤其是在中文上。

目標:生成單張靜態圖像,需保持空間一致性(物體佈局、風格等)。

挑戰:空間細節刻畫、高分辨率生成、文本與視覺內容對齊。

- 主流方案:擴散模型(如 Stable Diffusion、DALL·E 3)為主流。

- 核心組件:

- 文本編碼器(如 CLIP、T5):將文本映射為語義向量。

- 生成網絡:擴散模型通過迭代去噪生成圖像。

- 空間控制模塊:通過注意力機制(Cross-Attention)對齊文本與圖像區域。

- 關鍵技術:

- 空間注意力:文本 token 與圖像特徵圖局部交互。

- 超分辨率網絡:從低分辨率到高分辨率的逐級生成(如 Latent Diffusion)。

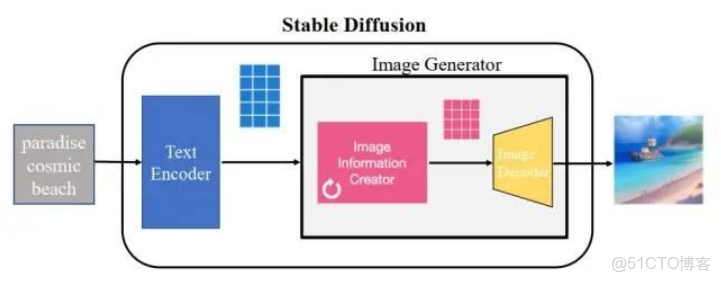

Stable Diffusion 模型架構

Stable Diffusion 是一種基於 Latent Diffusion Model (LDM) 的生成模型,主要用於 文本到圖像 (text-to-image) 和 圖像到圖像 (image-to-image) 的生成任務。其核心架構包括 VAE (變分自編碼器)、U-Net 和 CLIP 模塊,通過 擴散 (Diffusion) 和 去噪 (Denoising) 操作生成高質量圖像。

Stable Diffusion 的輸入和輸出在 像素空間 和 隱空間 (Latent Space) 之間轉換。輸入圖像通過 Encoder 壓縮為隱向量,經過擴散和去噪處理後,再通過 Decoder 解碼回像素空間。

- VAE (變分自編碼器): VAE 的作用是將圖像從像素空間壓縮到隱空間,並在生成階段將隱向量解碼回圖像。它的 Encoder 和 Decoder 是預訓練的,訓練時參數固定。VAE 的特點是計算複雜度低,支持無監督訓練。

- U-Net:U-Net 是模型的核心組件,負責在擴散過程中預測噪聲。其結構包括降採樣層、中間層和上採樣層,形成類似字母 "U" 的形狀。通過 ResBlock 和 Spatial Transformer,U-Net 能結合時間步長和條件信息(如文本)進行去噪。

- CLIP 模塊:CLIP 用於將文本信息編碼為向量表示,作為條件輸入到 U-Net 的注意力模塊中。CLIP 是預訓練的,能夠加速模型訓練並提高文本與圖像的語義一致性。

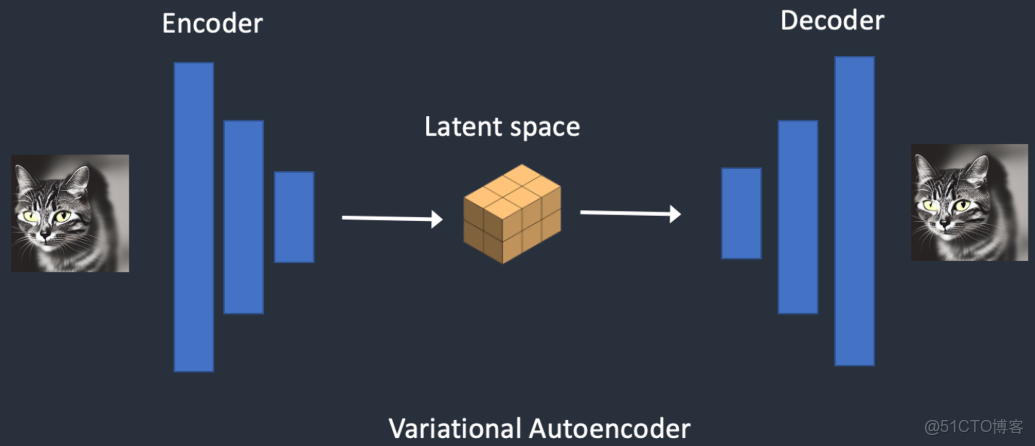

VAE(Variational Auto Encoders)

在LDM中,如何將原始圖片“壓縮”轉換至隱空間,經過處理再轉換回來,即使用VAE的Encoder和Decoder。這個模塊是預訓練好的,在LDM訓練時固定住參數。

原理:原始張量輸入,經過非常簡單的網絡結構,轉換成較小的張量,在Latent張量上,加一點點噪聲擾動,用對稱的簡單網絡結構,還原回原始大小,對比輸入前後的張量是否相似

特點:

網絡計算複雜度比較低

Encoder和Decoder可以分開使用

無監督訓練,不需要標註輸入的label

U-Net模塊

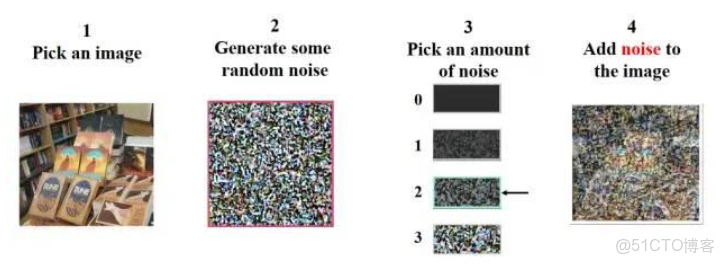

1)擴散 (Diffusion) :輸入圖像經過 Encoder 轉換為隱向量後,加入高斯噪聲,生成多個時間步的噪聲向量。最終,隱向量會趨近於高斯分佈的純噪聲。

用 random 函數生成從強到弱的多個強度噪聲,比如圖 8 裏 0~3 有 4 個強度的噪聲。訓練時把噪聲強度和加噪後圖片輸入到 Unet,計算預測噪聲圖和真正噪聲圖之間的誤差損失,通過反向傳播更新 unet 參數。

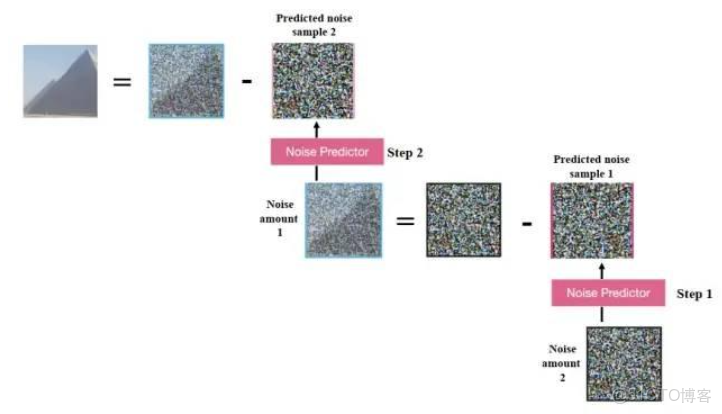

2)去噪 (Denoising) :在生成階段,從高斯噪聲開始,通過 U-Net 逐步去噪,恢復到原始隱向量。最後,Decoder 將隱向量解碼為圖像。

訓練好 Unet 後,如圖 9 所示,從加噪圖片中推斷出噪聲後,就可以用加噪圖減掉噪聲來恢復原圖;重複這個過程,第一步預測噪聲圖後再減去噪聲圖,用更新後的加噪圖進行第二步去噪,最終就能得到一張很清晰的生成圖片。由於使用了高斯分佈的 KL 散度損失,Unet 生成圖片實際上是接近訓練集分佈的,和訓練集有着相同像素規律。也就是説,使用真實場景的寫實訓練集去訓練模型,它的結果就會具有寫實風格,儘量符合真實世界規律。

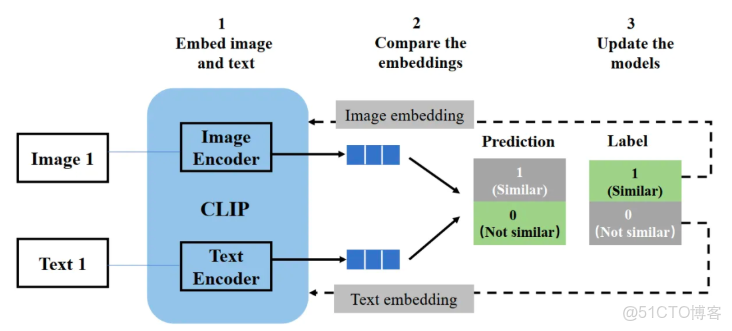

CLIP模塊

CLIP 模型結構包含一個圖片 encoder 和一個文字 encoder,類似於推薦場景常用到的經典雙塔模型。

- 訓練時,從訓練集隨機取出一些樣本(圖片和標籤配對的話就是正樣本,不匹配的話就是負樣本),CLIP 模型的訓練目標是預測圖文是否匹配;

- 取出文字和圖片後,用圖片 encoder 和文字 encoder 分別轉換成兩個 embedding 向量,稱作圖片 embedding 和文字 embedding;

- 用餘弦相似度來比較兩個 embedding 向量相似性,並根據標籤和預測結果的匹配程度計算損失函數,用來反向更新兩個 encoder 參數。

- 在 CLIP 模型完成訓練後,輸入配對的圖片和文字,這兩個 encoder 就可以輸出相似的 embedding 向量,輸入不匹配的圖片和文字,兩個 encoder 輸出向量的餘弦相似度就會接近於 0。

推理時,輸入文字可以通過一個 text encoder 轉換成 text embedding,也可以把圖片用 image encoder 轉換成 image embedding,兩者就可以相互作用。

在生成圖片的採樣階段,把文字輸入利用 text encoder 轉換成嵌入表示 text embedding,作為 Unet 網絡的 condition 條件。

Stable Diffusion 模型訓練與預測

- 訓練階段 輸入圖像經過 Encoder 壓縮為隱向量,加入噪聲後通過 U-Net 去噪,最終還原為圖像。通過計算生成圖像與原始圖像的差距(如 KL 散度),更新 U-Net 的參數。

- 預測階段 從高斯噪聲開始,結合條件輸入,通過 U-Net 逐步去噪,最終通過 Decoder 生成圖像。

文本生成視頻

通義萬相2.2-文生視頻-A14B(28B) https://www.modelscope.cn/models/Wan-AI/Wan2.2-T2V-A14B

目標:生成連續動態序列,需同時保持空間一致性與時間一致性(物體運動、場景過渡等)。

挑戰:時間維度的連貫性、運動規律建模、計算複雜度更高。

- 主流方案:在圖像生成基礎上擴展時間維度。

- 核心擴展:

- 時間維度建模:

- 3D U-Net:在擴散模型中引入時間層(如 Sora 的時空擴散模型)。

- 時空注意力:在空間注意力基礎上增加時間注意力層。

- 運動建模模塊:

- 光流預測:顯式建模幀間運動(早期方法)。

- 時序插值網絡:生成中間幀保證流暢性。

- 分層生成策略:

- 先生成關鍵幀,再插幀或補全中間幀(如 Make-A-Video)。

- 時空分治:分離空間編碼(圖像內容)與時間編碼(運動模式)。

擴散模型是當前文本到視頻生成領域的主流架構,被廣泛應用於OpenAI Sora、Stable Video Diffusion等系統中。本文將從基本原理出發,實現一個基於擴散原理的架構,構建能夠根據文本提示生成視頻或GIF的模型系統。

擴散架構核心組件

3D U-Net結構:專為視頻處理設計,能夠有效處理隨時間變化的幀序列。此U-Net架構融合了多重注意力機制:

- 時間注意力:負責捕捉幀間的時序關聯

- 空間注意力:處理每一幀內的區域關係

- 這些注意力層與特殊功能模塊協同工作,從視頻數據中提取關鍵特徵

擴散過程原理:模型的工作機制可以簡述為以下步驟:

- 向訓練視頻添加噪聲直至其變為純隨機分佈

- 模型學習逆向過程,即從噪聲中恢復原始信號

- 生成階段,從隨機噪聲出發,模型逐步去除噪聲

- 文本提示通過BERT轉換為嵌入向量,引導UNet的去噪方向

- 通過反覆迭代,最終生成與文本語義匹配的視頻內容

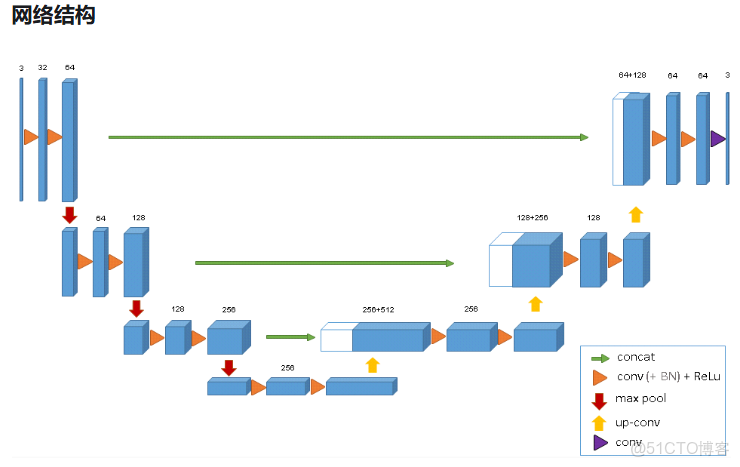

3D U-net的網絡結構與標準的U-net非常類似:

- 有一條編碼路徑和一條解碼路徑,每一條都有4個分辨率級別

- 編碼路徑每一層包含兩個3×3×3卷積,每一個都後接一個ReLU層,然後是一個2×2×2的每個方向上步長都為2的最大池化層

- 在解碼路徑,每一層包含一個步長為2的2×2×2的反捲積層,緊跟兩個3×3×3的卷積層,每一個都後接一個RuLU層

- 在ReLU之前使用了batch normalization

- 為其提供原始的高分辨率特徵最後一層為1×1×1的卷積層,可以減少輸出的通道數

- 最後的輸出通道數為標籤的類別數量

- 網絡的輸入為3通道的132×132×116的像素集合。輸出的大小為44×44×28(通道數為類別數)。

- 使用加權softmax損失函數,使得網絡可以使用稀疏註釋的數據進行訓練。將未標記的像素的權重設置為零,使得網絡可以僅從有標記的像素中學習,並推廣到整個立體數據。

兩者差異

|

維度

|

文本生成圖片

|

文本生成視頻

|

|

基本結構

|

2D 生成(空間)

|

3D 生成(空間+時間)

|

|

注意力機制

|

空間注意力(文本-圖像區域)

|

時空注意力(文本-視頻片段)

|

|

生成方式

|

單次生成整張圖像

|

常分層生成(關鍵幀→插幀/擴展)

|

|

訓練數據

|

圖像-文本對(如 LAION)

|

視頻-文本對(稀缺,常用圖像數據預訓練)

|

|

計算複雜度

|

相對較低(處理單幀)

|

極高(幀數×分辨率×時長)

|

|

一致性要求

|

空間一致性

|

空間+時間雙重一致性

|

時間維度:

- 許多視頻生成模型基於圖像模型改造,增加時間建模模塊(如 Time-Aware U-Net)。

數據策略:

- 圖像生成依賴大規模圖像-文本對。

- 視頻生成常先用圖像數據預訓練,再用少量視頻數據微調時間模塊。

評估標準差異:

- 圖像生成評估:畫面質量、文本相關性、多樣性。

- 視頻生成額外評估:運動平滑性、時序一致性、動態合理性。