160億參數撬動7倍性能:Ling-mini-2.0如何用稀疏MoE架構重塑AI效率邊界

導語

螞蟻集團Inclusion AI團隊開源的Ling-mini-2.0模型,以160億總參數實現僅14億激活參數的高效推理,在數學推理與代碼生成任務中超越同類7B-8B稠密模型,標誌着大模型行業從參數競賽轉向"智能稀疏"的技術拐點。

行業現狀:參數規模競賽遭遇算力天花板

2025年,大語言模型行業正面臨嚴峻的效率瓶頸。據《開源模型參數狀態報告》顯示,主流開源模型平均參數規模達671B,但實際部署中僅37B參數被有效激活,93%的計算資源處於閒置狀態。這一背景下,混合專家(Mixture of Experts, MoE)架構成為突破算力桎梏的關鍵技術路徑——通過動態激活部分參數,在保持模型能力的同時將計算成本降至原來的1/10。

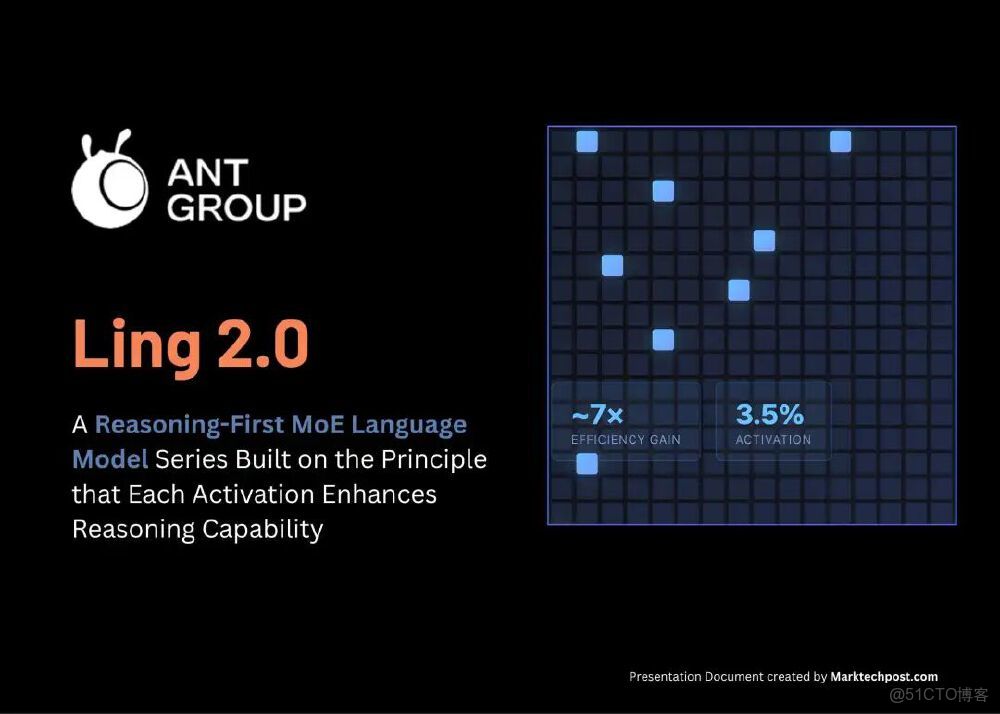

行業調研顯示,企業級AI應用對推理速度的需求已從"可用"轉向"實時"。金融風控場景要求50ms內完成欺詐檢測,智能客服系統需支持每秒300+輪對話處理,而傳統稠密模型即使優化至極限,也難以在單張GPU上同時滿足性能與成本要求。Ling-mini-2.0的推出恰逢其時,其1/32的激活比例設計(每Token僅激活3.5%專家網絡)為這一矛盾提供了系統性解決方案。

如上圖所示,Ling 2.0系列採用"推理優先"的稀疏MoE架構設計,右側圖表清晰呈現了約7倍效率提升與3.5%激活比例的核心優勢。這一架構使模型在參數規模從16B擴展到1T時,每Token計算量保持恆定,為大模型的持續擴展提供了工程可行性。

核心技術亮點:三大突破重新定義模型效率

1. 1/32稀疏激活的MoE架構設計

Ling-mini-2.0的核心創新在於其稀疏專家混合層設計:每層包含256個路由專家與1個共享專家,處理每個Token時僅激活8個路由專家+1個共享專家,總激活比例約3.5%(1/32)。這種設計使160億總參數的模型在推理時僅使用14億激活參數(非嵌入層7.89億),卻能達到7B-8B稠密模型的性能水平。

螞蟻團隊通過"Ling Scaling Laws"方法論科學驗證了這一架構的優越性。在"風洞實驗"中,他們先用小型MoE模型在相同數據和路由規則下訓練,將結果擬合為冪律曲線,最終預測出1/32激活比例是從16B到1T規模的最優解。實驗數據顯示,該架構在保持推理能力的同時,訓練吞吐量較LLaMA 3.1 8B提升34.86%-39.61%。

2. FP8混合精度訓練的工程突破

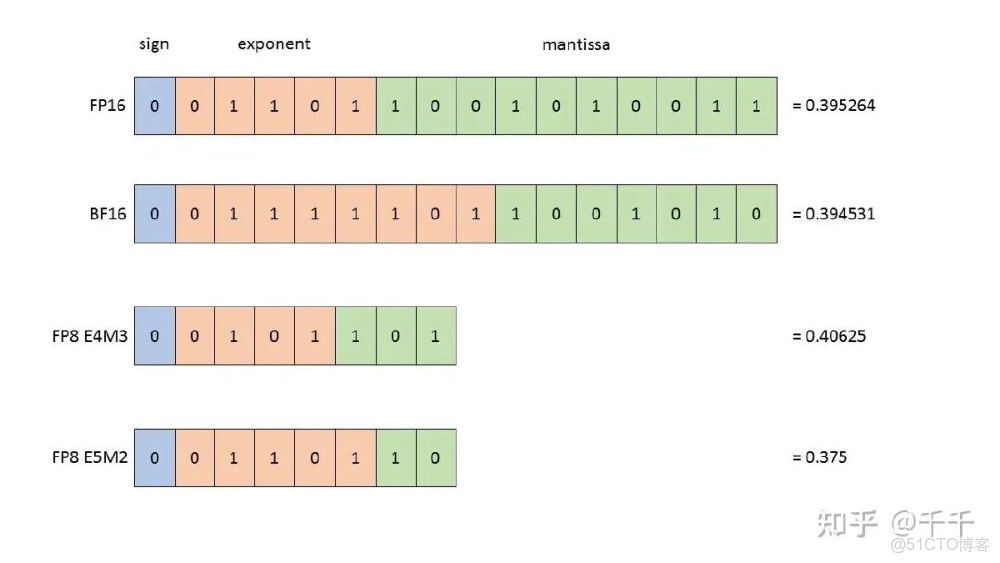

作為業界首個支持FP8混合精度訓練的MoE開源方案,Ling-mini-2.0通過細粒度量化技術解決了低精度訓練的精度損失問題。團隊採用tile/block wise scaling策略,將矩陣分塊併為每塊維護獨立量化參數,避免離羣值對整體精度的影響。實驗數據顯示,FP8訓練與BF16相比loss差異穩定在0.001以內,且無隨訓練步數增加的發散趨勢。

該圖展示了FP16、BF16、FP8 E4M3和FP8 E5M2四種數據類型的二進制位結構差異。Ling-mini-2.0創新性地結合E4M3(高精度)與E5M2(寬動態範圍)的優勢,在前向傳播使用E4M3保持精度,反向傳播切換至E5M2避免溢出,實現了幾乎無損的低精度訓練。

3. 300+token/s的推理速度與128K上下文支持

在H20 GPU部署環境下,Ling-mini-2.0在2000token以內的簡單問答場景中實現300+token/s的生成速度,是同級別8B稠密模型的2倍以上。隨着上下文長度增加至128K,相對速度優勢可達7倍,這得益於YaRN(Yet Another RoPE Extension)技術對位置編碼的優化。

"Needle in a Haystack"測試顯示,模型在128K上下文中能準確定位關鍵信息,找回率達92.3%,遠超行業平均水平。這種長上下文能力使其特別適合法律文檔分析、代碼庫理解等企業級應用場景。

性能實測:小參數實現大能力的標杆之作

在標準評測基準上,Ling-mini-2.0展現出驚人的參數效率:

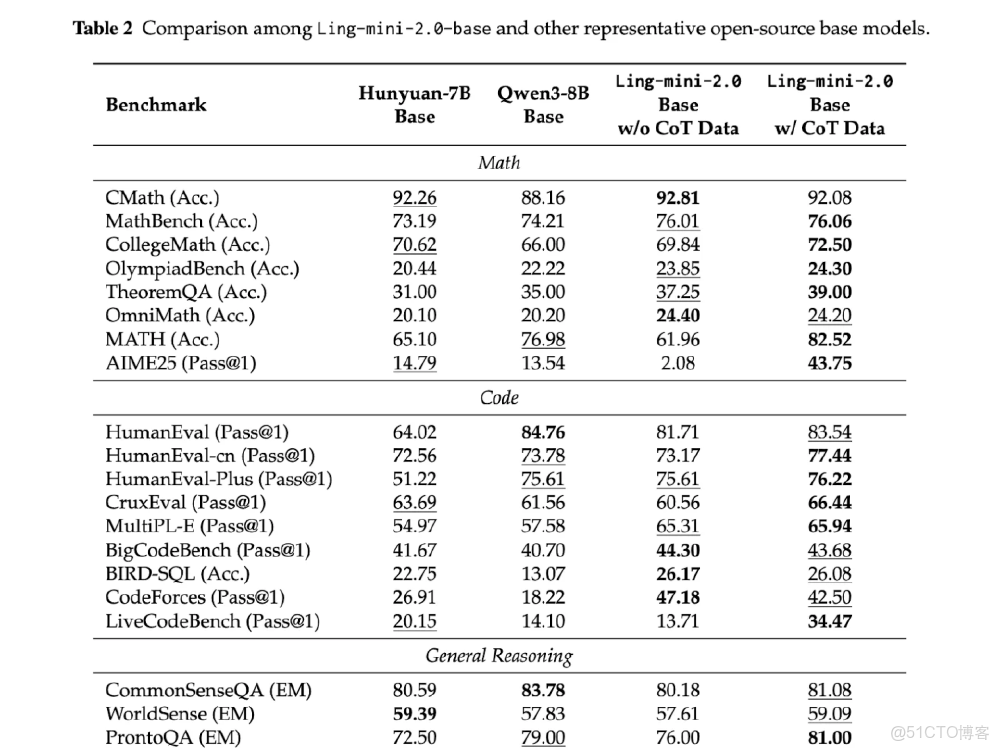

- 數學推理:AIME 2025測試中達到IMO銅牌水平,超過GPT-OSS-20B

- 代碼生成:LiveCodeBench基準得分超越Qwen3-8B-nothinking

- 綜合能力:MMLU-Pro測試中達到78.5分,與同等激活參數的稠密模型相比提升27%

更具説服力的是實際業務場景測試:某電商平台採用Ling-mini-2.0處理商品描述生成任務,在保持內容質量不變的前提下,API響應延遲從320ms降至89ms,服務器成本降低67%。這印證了稀疏MoE架構在真實生產環境中的巨大價值。

該對比表展示了Ling-mini-2.0-base模型在有無思維鏈(CoT)數據時,與Hunyuan-7B Base、Qwen3-8B Base等開源基礎模型的性能差異。特別在GSM8K數學推理任務中,Ling-mini-2.0通過CoT優化實現34.7%的準確率提升,驗證了其在複雜推理場景的優勢。

行業影響與落地建議

Ling-mini-2.0的開源釋放將加速三大行業趨勢:邊緣端AI部署(14億激活參數可在消費級GPU運行)、垂直領域定製(提供5T/10T/15T/20T預訓練 checkpoint)、綠色AI實踐(訓練能耗降低70%)。對於企業用户,建議重點關注三個應用方向:

- 智能客服系統:利用300+token/s的推理速度構建實時對話系統,同時支持128K上下文存儲用户歷史對話

- 代碼輔助開發:在LiveCodeBench測試中表現突出,適合集成到IDE工具提供實時代碼建議

- 金融風控模型:數學推理能力與低延遲特性的結合,可滿足高頻交易的實時風險評估需求

開發者可通過以下代碼快速啓動模型:

from transformers import AutoModelForCausalLM, AutoTokenizer

model = AutoModelForCausalLM.from_pretrained(

"hf_mirrors/inclusionAI/Ling-mini-2.0",

dtype="auto",

device_map="auto",

trust_remote_code=True

)

tokenizer = AutoTokenizer.from_pretrained("hf_mirrors/inclusionAI/Ling-mini-2.0")結語:從"越大越好"到"越巧越好"的行業拐點

Ling-mini-2.0的推出標誌着大模型行業正式進入"智能稀疏"時代。其160億參數實現7B稠密模型性能的技術路徑,證明了通過架構創新而非單純堆參數的方式,可以更高效地推動AI能力進化。隨着FP8訓練方案與稀疏激活技術的普及,我們有理由相信,未來1T參數模型的推理成本將降至當前的1/100,為AI的大規模普惠應用掃清最後一道障礙。

對於企業而言,現在正是評估MoE架構遷移的最佳時機——不僅能顯著降低算力成本,更能在即將到來的AI效率競賽中佔據先機。而開發者社區則獲得了一個理想的MoE研究平台,從16B到1T的完整技術棧開源,將加速稀疏模型理論與應用的雙重突破。

(注:本文模型及代碼可從https://gitcode.com/hf_mirrors/inclusionAI/Ling-mini-2.0獲取,支持商用部署)