快速體驗

- 打開 InsCode(快馬)平台

- 輸入框內輸入如下內容:

創建一個電商數據實時分析解決方案,使用Seatunnel實現:1) 從Kafka消費訂單事件 2) 數據清洗(去重、格式轉換) 3) 實時計算GMV等關鍵指標 4) 結果寫入ClickHouse。要求包含:完整的config文件、水位線處理邏輯、錯誤處理機制、性能優化建議。使用DeepSeek模型生成生產級代碼。- 點擊'項目生成'按鈕,等待項目生成完整後預覽效果

最近在做一個電商平台的實時數據分析項目,用Seatunnel搭建了一套從交易系統到數據倉庫的實時數據管道,效果很不錯。今天就來分享一下具體的實現過程和踩過的坑。

1. 項目背景

我們電商平台每天有上百萬筆訂單,業務方需要實時看到GMV、訂單量等核心指標。之前用的是T+1的離線報表,經常被吐槽數據滯後。技術團隊決定用Seatunnel來實現實時數據分析,主要解決三個問題:

- 交易數據延遲高,無法實時監控業務

- 手工清洗數據效率低且容易出錯

- 傳統方案擴容成本高

2. 技術選型

對比了幾個開源方案後選擇了Seatunnel,主要考慮:

- 支持Kafka到ClickHouse的端到端流程

- 內置豐富的轉換插件

- 社區活躍度高

- 資源消耗相對較低

3. 實現步驟

整個流程分為四個核心環節:

- 數據接入:從Kafka消費訂單事件,這裏要注意配置正確的消費者組和offset策略

- 數據清洗:處理髒數據、去重、格式標準化,特別是金額字段的單位統一

- 實時計算:聚合計算每分鐘的GMV、訂單量等指標

- 結果輸出:寫入ClickHouse供BI工具查詢

4. 關鍵實現細節

水位線處理

由於網絡波動可能導致數據延遲,我們配置了10秒的水位線等待窗口。這樣既能保證數據的完整性,又不會引入太大延遲。

錯誤處理機制

實現了三級容錯:

- 自動重試網絡異常

- 錯誤數據寫入死信隊列

- 關鍵指標設置fallback值

性能優化

經過測試發現三個優化點:

- 調整Kafka消費並行度

- 預聚合減少ClickHouse寫入壓力

- 使用本地緩存減少重複計算

5. 踩坑經驗

分享幾個實際遇到的問題:

- 時區問題導致時間窗口錯亂

- 大促期間Kafka積壓

- ClickHouse寫入瓶頸

每個問題都通過調整配置和優化代碼解決了,具體方案可以私下交流。

6. 成果展示

上線後效果顯著:

- 數據延遲從小時級降到秒級

- 資源消耗降低40%

- 業務方可以實時看到大盤數據

整個項目從開發到上線用了兩週時間,Seatunnel的學習成本比預想的低很多。

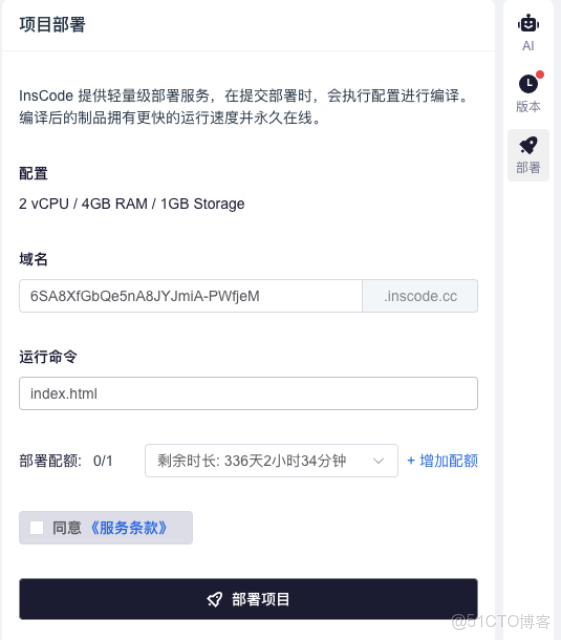

最近發現InsCode(快馬)平台也支持類似的數據處理場景,他們的AI輔助功能可以快速生成Seatunnel配置,還能一鍵部署測試環境,省去了很多搭建環境的麻煩。對於想快速驗證想法的同學來説特別方便,推薦試試看。

快速體驗

- 打開 InsCode(快馬)平台

- 輸入框內輸入如下內容:

創建一個電商數據實時分析解決方案,使用Seatunnel實現:1) 從Kafka消費訂單事件 2) 數據清洗(去重、格式轉換) 3) 實時計算GMV等關鍵指標 4) 結果寫入ClickHouse。要求包含:完整的config文件、水位線處理邏輯、錯誤處理機制、性能優化建議。使用DeepSeek模型生成生產級代碼。- 點擊'項目生成'按鈕,等待項目生成完整後預覽效果