摘要

在構建跨境電商數據中台或BI系統時,“數據源”的獲取是第一步也是最關鍵的一步。本文將從技術架構和工程實踐的角度,深度對比三種主流的亞馬遜數據獲取方案:SaaS成品工具、自建分佈式爬蟲系統,以及第三方數據採集API。我們將重點分析它們在系統穩定性、數據實時性、反爬策略、維護成本和集成靈活性等方面的技術差異,為技術負責人和架構師在進行技術選型時提供一份詳盡的參考依據。

一、跨境電商的數據依賴:一個無法迴避的問題

1.1 為什麼選品和運營會越來越“卷”?

在過去,電商運營在某種程度上依賴經驗和直覺。但進入2025年,隨着市場透明度的提高,這種方法的侷限性日益凸顯。根本原因在於——所有市場參與者都在使用同一套標準化的工具和方法論。當成百上千的賣家利用相同的SaaS平台分析數據、使用相同的關鍵詞工具、複製相似的運營策略時,所謂的“藍海”會迅速變成“紅海”,差異化優勢幾乎消失殆盡。

1.2 數據是決策背後的底層邏輯

頂級的電商團隊早已認識到,真正的競爭壁壘來源於數據優勢。他們不再依賴通用的SaaS工具,而是致力於構建一個數據驅動的決策系統。這意味着他們需要一種更強大、更靈活的數據獲取方式,通過內部算法與自有業務邏輯相結合,構建出貼合自身運營需求的分析模型,從而在激烈的競爭中實現真正的差異化。

二、亞馬遜運營決策需要哪些關鍵數據?

在討論如何獲取數據之前,我們首先需要明確一個問題——對於精細化運營,到底需要哪些維度的亞馬遜數據?

2.1 商品詳情頁數據(包括Review、Customer Says)

- 標題、副標題、品牌

- 描述、變體信息、五點描述、A+頁面內容

- 用户評分的歷史趨勢、Review數量的增減

- “Customer Says”模塊的詞頻與情感傾向(正面/負面)

- 近期新增或刪除評論的波動情況

這些數據是理解商品本身表現與用户真實反饋的基礎。

2.2 關鍵詞排名與Sponsored廣告分佈

- 特定關鍵詞下的商品排名(自然位與廣告位)

- Sponsored廣告的展示頻率與佔位情況

- 不同時間點(例如每小時)的排名與廣告位變化

- 搜索結果中廣告與自然流量的比例

對SP廣告位的追蹤,是分析競爭強度與流量成本的關鍵。

2.3 類目熱銷榜與新上架商品

- Top 100榜單上商品的動態變化

- 類目下的新品上架頻率

- 上榜商品的價格與銷量趨勢

- 上升榜/下滑榜的變化情況

這些數據有助於識別市場趨勢品類和品類的新陳代謝速率。

2.4 店鋪監控與價格趨勢分析

- 競爭對手店鋪的上新、下架動態

- 核心競品的價格浮動規律與調價週期

- 是否採用SP廣告以及評論策略的跡象

這類數據主要用於競品監控和行為建模。

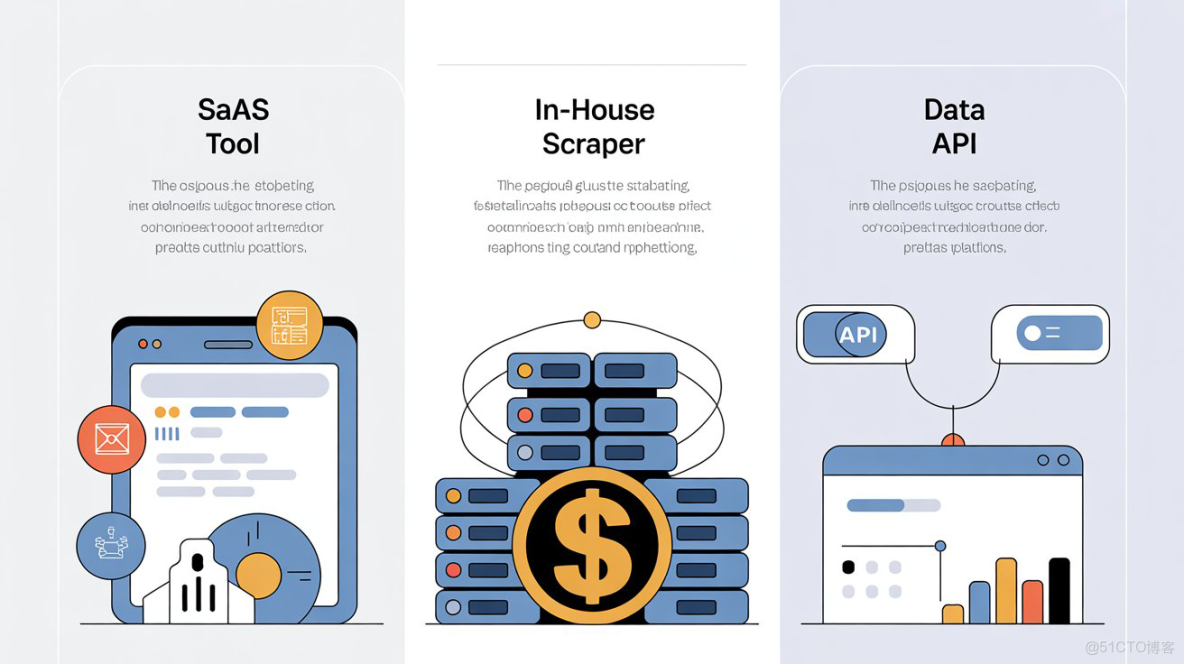

三、亞馬遜數據採集的三種主流技術方案

3.1 SaaS選品工具:標準化,但靈活性和深度有限

3.1.1 優勢:開箱即用,技術門檻低

SaaS類工具(如賣家精靈、JungleScout等)最大的優點是降低了數據獲取的門檻,它們通常具備:

- 友好的用户界面,上手快

- 標準化的功能模塊,如關鍵詞研究、榜單監控、銷量預估等

- 適合處於起步階段或輕量化運營的賣家

3.1.2 弊端:數據滯後,定製能力弱

從技術角度看,SaaS工具的侷限性也十分明顯:

- 數據實時性差: 數據更新頻率通常是天級,無法滿足對市場實時變化(如價格戰)的監控需求。

- 數據維度和深度有限: 無法按需進行自定義的批量、深度採集,例如,無法針對1000個自定義ASIN列表,每小時採集一次價格和庫存。

- 集成性差: 數據通常以報表形式提供,難以與企業內部的BI或ERP系統進行自動化、程序化的對接。

3.2 自建爬蟲團隊:高度定製,但維護成本極高

3.2.1 優勢:完全可控,定製能力強

對於有技術實力的公司,自建爬蟲似乎是理想選擇:

- 可以根據自身的業務流程,100%定製化設計抓取邏輯和數據結構。

- 數據存儲在自有服務器,安全性高。

- 理論上可以無限擴展采集範圍。

3.2.2 弊端:技術與資金投入巨大,穩定性難以保障

自建爬蟲是一項系統工程,其背後是巨大的隱形成本:

- 高昂的技術成本: 需要招聘專業的爬蟲工程師和數據工程師,並投入大量時間進行開發和調試。

- 持續的“軍備競賽”: 亞馬遜的反爬策略在持續、快速地升級。你需要不斷投入資源來更新反爬蟲方案、維護高質量的代理IP池、處理驗證碼和設備指紋等問題。

- 穩定性挑戰: 大規模採集(例如每日更新數萬個ASIN)對系統的併發能力、任務調度和容錯機制都提出了極高的要求,穩定性難以保證。

3.3 使用第三方數據採集API:靈活性與穩定性的平衡

3.3.1 API方案的核心思想

第三方數據採集API的核心思想,是將最複雜、最耗費資源的“數據抓取”環節(包括反爬蟲對抗、IP代理管理、頁面解析等)作為一種標準化的雲服務提供給開發者。開發者無需關心底層的實現細節,只需通過簡單的API調用,即可獲取到處理好的、乾淨的結構化數據。

3.3.2 優勢:兼顧靈活性、實時性與成本效益

- 實時性強: 優秀的API服務通常能提供分鐘級甚至秒級的實時數據。

- 維護成本低: 由專業的服務商負責應對目標網站的結構變更和反爬升級,內部團隊無需再為此耗費精力。

- 靈活性高: 開發者可以按需、批量地調用API,將獲取的數據靈活地集成到任何自有系統中。

- 成本可控: 通常採用按量付費的模式,邊際成本低,無需承擔高昂的初期投入和固定的人力成本。

四、不同方案的綜合對比分析

為了更直觀地展示三者的區別,我們從多個維度進行對比:

|

比較維度

|

SaaS工具

|

自建爬蟲

|

數據採集API(Pangolin Scrape API)

|

|

數據廣度 |

固定字段和頁面

|

可擴展,但需開發

|

通常支持全平台、多類頁面

|

|

數據深度 |

簡化字段

|

可完全定製

|

通常覆蓋全字段(Review、廣告等)

|

|

實時性 |

日級更新

|

不確定,依賴自身系統能力

|

通常為分鐘級

|

|

成本 |

月付/年付費用高

|

初期投入和人力成本極高

|

邊際成本低,靈活計費

|

|

技術門檻 |

無

|

非常高

|

低至中等(僅需API集成能力)

|

|

定製能力 |

低

|

極高

|

較高(支持參數控制與場景定製)

|

|

適合人羣 |

新手賣家

|

具備強大技術實力的大型企業

|

希望兼顧靈活性與效率的成熟賣家/數據團隊

|

五、為什麼成熟的電商團隊更傾向於Scrape API方案?

5.1 內部有選品邏輯,追求差異化競爭

對於月銷達到數十萬美元級別以上的成熟團隊,SaaS工具提供的“大眾化”數據早已無法滿足其精細化運營的需求。他們更看重的是:

- 數據的獨特性與可驗證性: 需要獲取不是每個人都能輕易得到的一手原始數據。

- 與自有系統的深度融合: 將獲取的數據無縫對接到內部的BI系統、庫存管理系統和自動化調價引擎中,形成決策閉環。

- 更精細化的分析維度: 例如,圍繞關鍵詞的流量來源分佈、評論中的用户情緒導向等,進行更深度的建模分析。

5.2 使用Scrape API與外部數據構建私有數據庫

成熟團隊通常配備數據分析師和開發人員,他們會利用數據採集API,將亞馬遜的公開數據與**站外信號(如Google搜索熱度、社交媒體趨勢)**相結合,搭建自己的私有數據倉庫。這種方式可以:

- 打造專屬的、不可複製的選品和運營模型。

- 構建私有的商品標籤庫和熱詞體系。

- 實現跨平台的數據聯動分析(例如Amazon+Shopify+TikTok)。

5.3 數據掌握在手,決策更主動

API的使用,讓團隊對運營節奏、推廣節點、備貨策略擁有了前瞻性的掌控能力。例如,他們可以做到:

- 每小時監控核心關鍵詞的Sponsored廣告位變化,及時發現競爭對手的投放策略異常。

- 定期獲取類目內所有新增ASIN,分析是否有強大的新玩家介入。

- 實時追蹤核心競品的Review頻率和情感變化,洞察其產品生命週期的階段。

六、深度解析:一個優秀的亞馬遜數據採集API應具備哪些特質?

當決定採用 Scrape API方案時,如何評估一個API服務商的優劣?一個優秀的API應具備以下特質:

6.1 強大的實時採集能力與全面的字段解析

API的核心價值在於數據的實時性和完整性。一個專業的API應該能提供業內領先的分鐘級實時採集能力,並支持對頁面的全字段解析,包括:

- 商品描述、五點圖文、所有變體信息

- 完整的用户評論(Review)內容

- Sponsored廣告的精確位置

- “Customer Says”模塊的情緒傾向和熱門評論

同時,應支持返回HTML原文、結構化JSON、Markdown等多種數據格式,以適應不同的應用場景。

6.2 針對電商場景的深度定製功能

通用的網頁抓取API與專業的電商API有本質區別。專業的API會提供針對電商場景的深度功能,例如,市面上一些領先的服務(如Pangolin Scrape API)可以做到:

- 極高的Sponsored廣告採集率: 能夠達到98%以上,這對於廣告分析至關重要。

- 按郵編/地區採集: 允許開發者通過設置郵編等參數,獲取特定地域的搜索結果和商品信息,這對於分析區域性差異和本地化廣告非常有價值。

- 強大的參數化控制: 支持通過參數控制採集的語言、時區、頁面序號等,提供高度的靈活性。

6.3 為非開發者設計的無代碼解決方案

此外,一個成熟的解決方案,還應該考慮到團隊中的非技術人員(如運營、市場人員)的數據需求。因此,提供配套的可視化、無代碼操作工具是一個巨大的加分項。這類工具(例如Pangolin的Data Pilot)通常允許用户通過簡單的表單配置,就能完成複雜的採集任務,並自動生成可直接用於運營分析的Excel報表,極大地降低了整個團隊使用數據的門檻。

七、實戰應用案例解析

7.1 熱門關鍵詞SP廣告分佈與評論傾向分析

某成熟賣家團隊,通過專業的第三方API,每小時採集“wireless earbuds”關鍵詞的搜索結果頁,用於分析:

- 哪些ASIN在前10位反覆出現?

- 哪些是Sponsored廣告位?廣告位的穩定性如何?

- 這些頭部商品的Review中,有哪些高頻提及的優缺點?

- “Customer Says”模塊反映出的用户核心需求是什麼?

基於這些一手的、高頻次的數據,團隊能夠準確判斷該關鍵詞下的流量競爭是否真實可控,以及市場的產品機會點在哪裏。

7.2 構建ASIN數據庫與熱賣榜趨勢監控

一家為賣家提供軟件服務的公司,需要構建一個龐大的ASIN數據倉庫。他們通過數據採集API,每天自動化地完成以下工作:

- 採集亞馬遜主要類目的Best Sellers榜單。

- 針對榜單上的每一個ASIN,採集其變體數量、價格變動歷史、排名走勢。

- 將這些數據與Google Trends等外部數據源關聯,進行跨平台趨勢評估。

最終,他們基於這個私有數據庫,開發出了一套AI選品算法,為客户提供高潛力的每日新品線索。

八、常見技術問題解答(FAQ)

8.1 自建爬蟲到底需要投入多少技術資源?

通常一個最小配置的團隊需要至少1名前端抓取工程師(負責逆向和解析)和1名數據工程師(負責數據清洗和存儲),此外還需要持續投入資金用於購買和維護代理IP池。整體成本高昂且項目週期長,失敗風險高。

8.2 第三方API會被平台封禁嗎?穩定性如何?

一個專業的第三方API服務商的核心價值就在於此。他們通常會通過大規模的分佈式IP資源、智能請求調度、瀏覽器指紋模擬和持續更新的防封架構,來保證極高的採集成功率和系統穩定性。開發者無需再關心這些底層細節。

8.3 API返回的數據質量如何保證?

專業的API服務通常內置了數據校驗和清洗邏輯,能夠提供乾淨、標準化的結構化數據。同時,支持返回頁面HTML原文的能力,也為需要進行二次校驗和深度解析的用户提供了靈活性。

8.4 API數據如何與內部BI系統集成?

主流的API服務都會提供標準化的JSON數據格式,這種格式可以非常方便地通過各種方式(如Webhook推送、定時拉取等)與主流的BI工具(如Tableau, Power BI, Looker)或內部數據倉庫進行對接。

九、總結:技術選型,是戰略決策而非戰術選擇

在選品與精細化運營的新時代,數據獲取方式決定了你的決策上限。

- SaaS 工具適合初入跨境的賣家,它解決了“從無到有”的問題,但天花板明顯。

- 自建爬蟲適合擁有頂尖技術團隊和充足預算的公司,它解決了“高度定製”的問題,但成本高、風險大。

- 而Pangolin 數據採集API,則在靈活性、時效性、數據深度與成本效益之間,為絕大多數成長型和成熟型賣家找到了最佳的平衡點。

它讓每一個懂數據價值的運營團隊,都有機會擁有與頂級大賣同等的數據獲取能力,在選品、運營、營銷的各個環節,做出更快、更準、更深的決策。選擇正確的數據工具,比投入更多的資金本身更為重要。