和昨天的那篇U²Net同作者,但是更早一點。

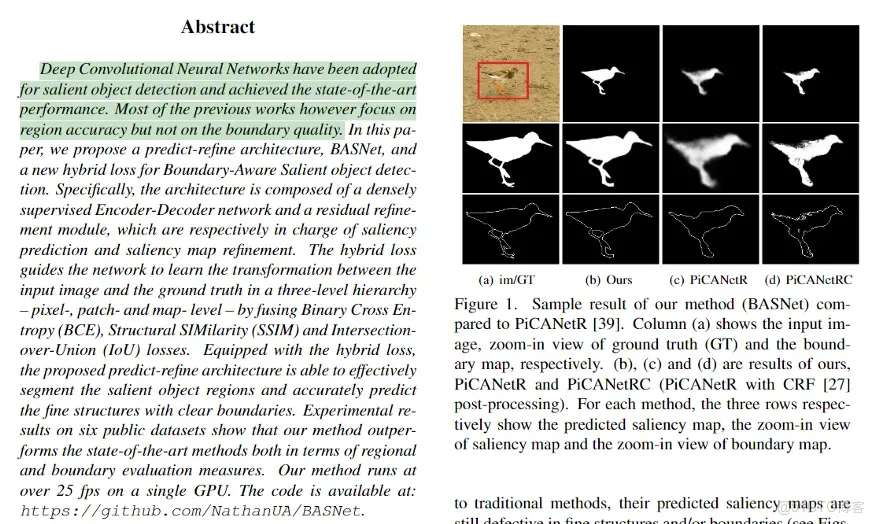

大多數深度學習方法→在顯著性預測時側重於區域預測→但現在他們創建了一個新的損失函數→也考慮了目標的邊界。

顯著性預測→我們人類擅長於此→關注給定的圖像或視頻中的“重要”目標。(但沒有很多方法考慮目標的邊界)。現在有很多深度學習模型結合了不同的表示方式。

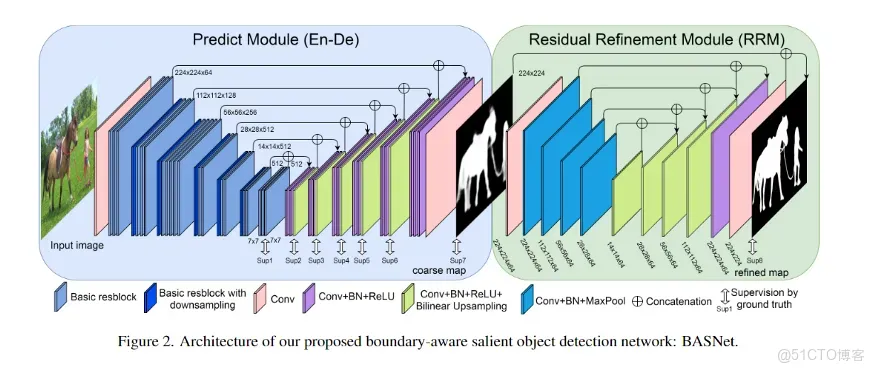

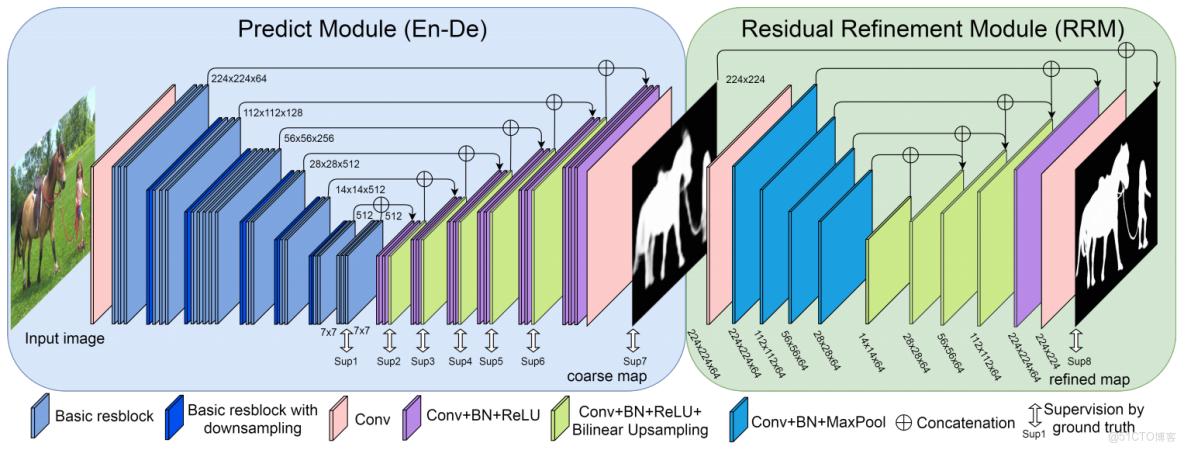

就像U-net方法一樣,→內部特徵也可以直接使用。

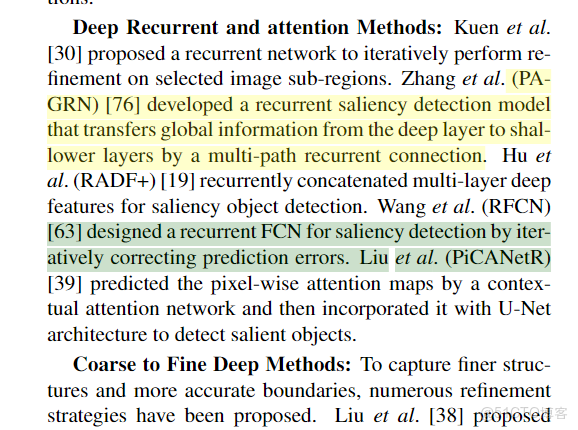

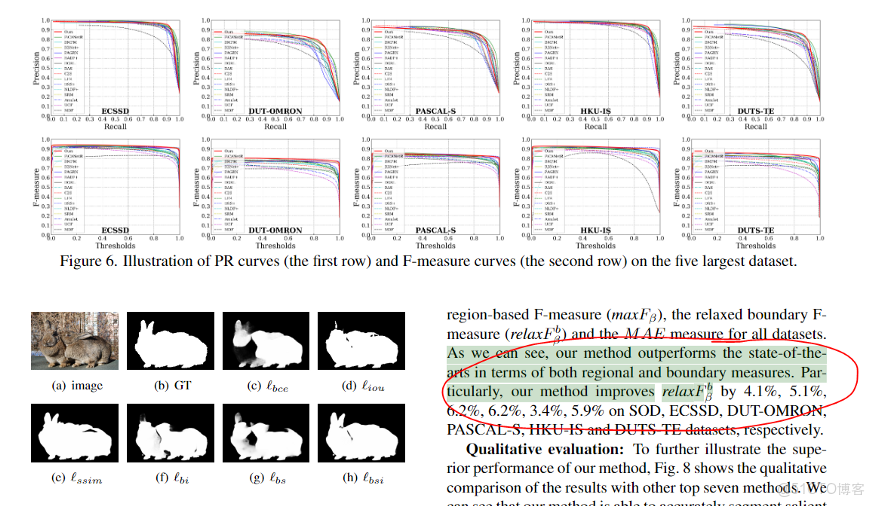

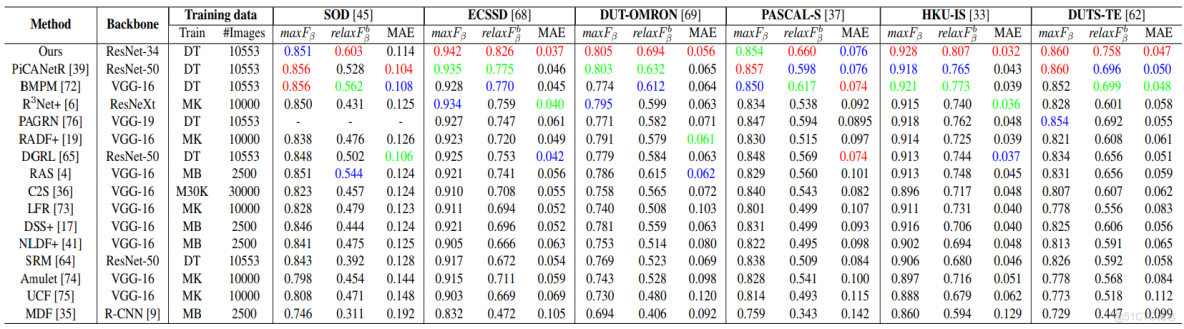

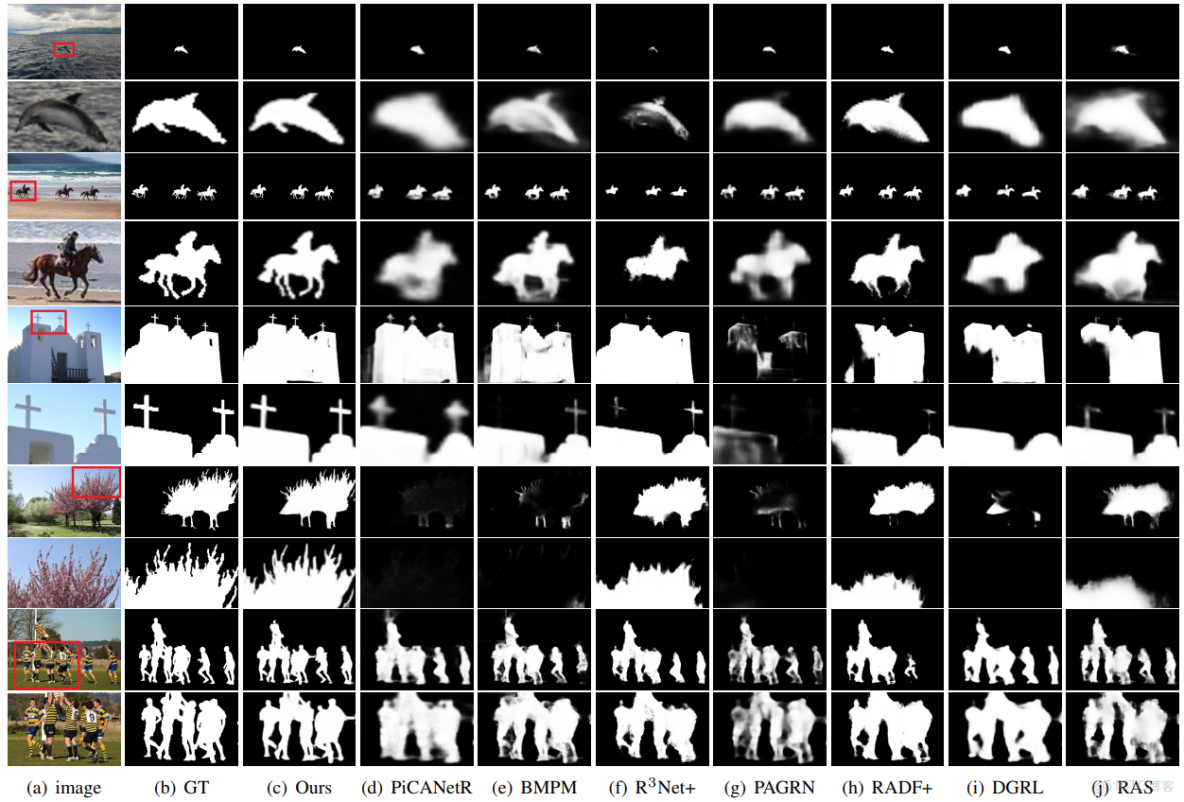

看起來他們的想法是對的 —— 他們的方法確實比其他SOTA方法更好。(大部分方法使用FCN→全卷積網絡→有些實際上使用RNN網絡進行迭代預測)。

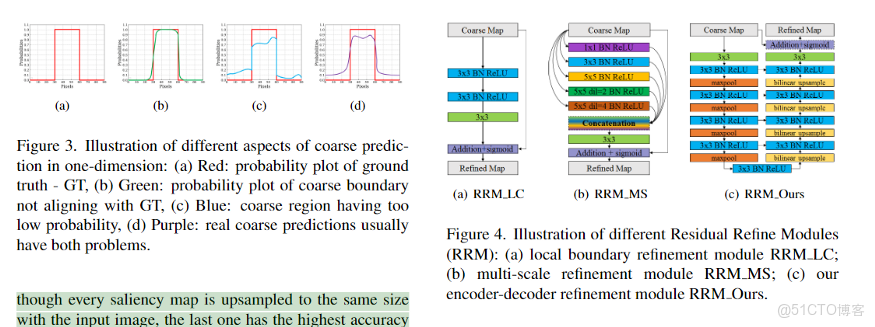

解決這個問題有許多方法,但不知道哪一種是最好的。

這是一個非常有趣的選擇。(第一個網絡比第二個網絡大得多→池化層沒有真正使用)。

拼接→內部特性映射→更好的預測。

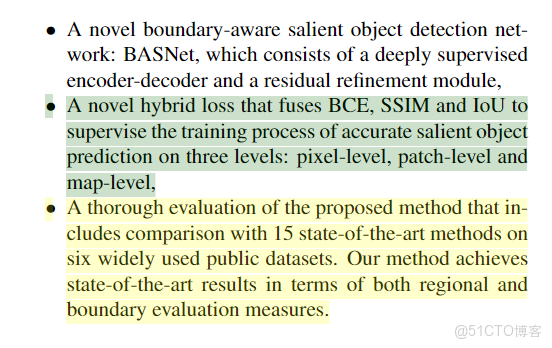

他們還手工創建了一個細化模塊 —— 這類創新並不容易實現。此外,還調整了損失函數,成功地訓練了整個網絡。

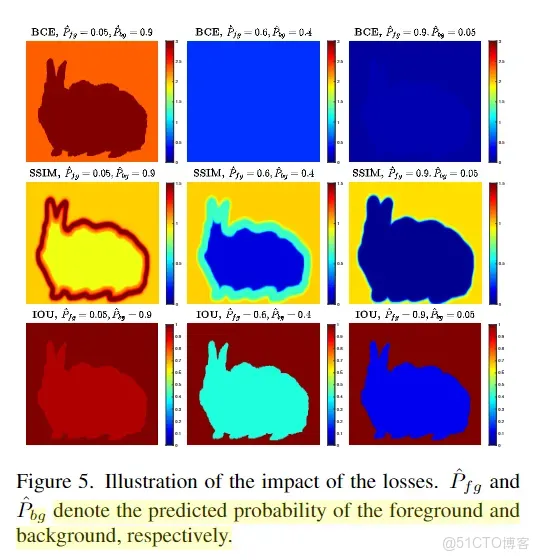

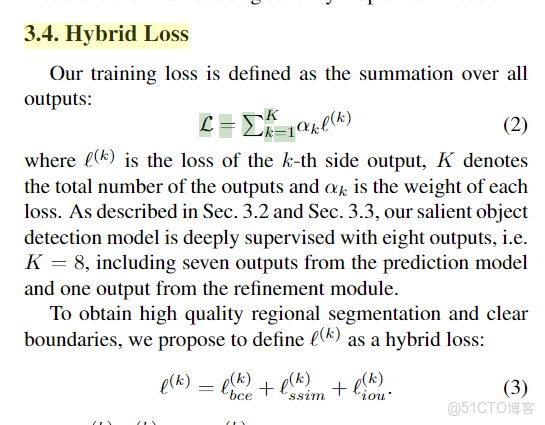

邊界損失項被添加到二元交叉熵中 —— SSIM也包括在內——這是相當大的。我還不知道這個度量是可微的。IoU 損失也被使用了→許多不同的損失被合併起來→這是我看到越來越多的趨勢之一。

這些損失的組合 → 導致更平滑的預測。

損失越多越好?看來他們的情況就是這樣:

README.md

BASNet

Code for CVPR 2019 paper 'BASNet: Boundary-Aware Salient Object Detection code', Xuebin Qin, Zichen Zhang, Chenyang Huang, Chao Gao, Masood Dehghan and Martin Jagersand.

Contact: xuebin[at]ualberta[dot]ca

(2020-May-09) NEWS! Our new Salient Object Detection model (U^2-Net), which is just accepted by Pattern Recognition, is available now!

U^2-Net: Going Deeper with Nested U-Structure for Salient Object Detection

Evaluation

Evaluation Code

Required libraries

Python 3.6

numpy 1.15.2

scikit-image 0.14.0

PIL 5.2.0

PyTorch 0.4.0

torchvision 0.2.1

glob

The SSIM loss is adapted from pytorch-ssim.

Usage

- Clone this repo

git clone https://github.com/NathanUA/BASNet.git- Download the pre-trained model basnet.pth from GoogleDrive or baidu extraction code: 6phq, and put it into the dirctory 'saved_models/basnet_bsi/'

- Cd to the directory 'BASNet', run the training or inference process by command:

python basnet_train.pyorpython basnet_test.pyrespectively.

We also provide the predicted saliency maps (GoogleDrive,Baidu) for datasets SOD, ECSSD, DUT-OMRON, PASCAL-S, HKU-IS and DUTS-TE.

Architecture

Quantitative Comparison

Qualitative Comparison

Citation

@InProceedings{Qin_2019_CVPR,

author = {Qin, Xuebin and Zhang, Zichen and Huang, Chenyang and Gao, Chao and Dehghan, Masood and Jagersand, Martin},

title = {BASNet: Boundary-Aware Salient Object Detection},

booktitle = {The IEEE Conference on Computer Vision and Pattern Recognition (CVPR)},

month = {June},

year = {2019}

}