目 錄

1. 概述... 2

2. 測試DeepSeek 15B原生模型... 3

3. 測試微調訓練後的大模型... 4

4. 微調模型訓練過程及代碼... 6

1. 概述

基於DeepSeek-R1-Distill-Qwen-1.5B模型訓練自主的領域大模型,例如打造針對鋼鐵、礦山、有色、稀土、建材、加工製造等領域的大模型。促進大模型技術在具體領域的應用與落地,助力行業向智能製造轉型升級。

本文介紹:

(1)基礎模型DeepSeek-R1-Distill-Qwen-1.5B與微調訓練後的deepseek-1.5b-lora模型使用對比。

(2)微調訓練模型的過程及Python代碼。

2. 測試DeepSeek-R1 15B原生模型

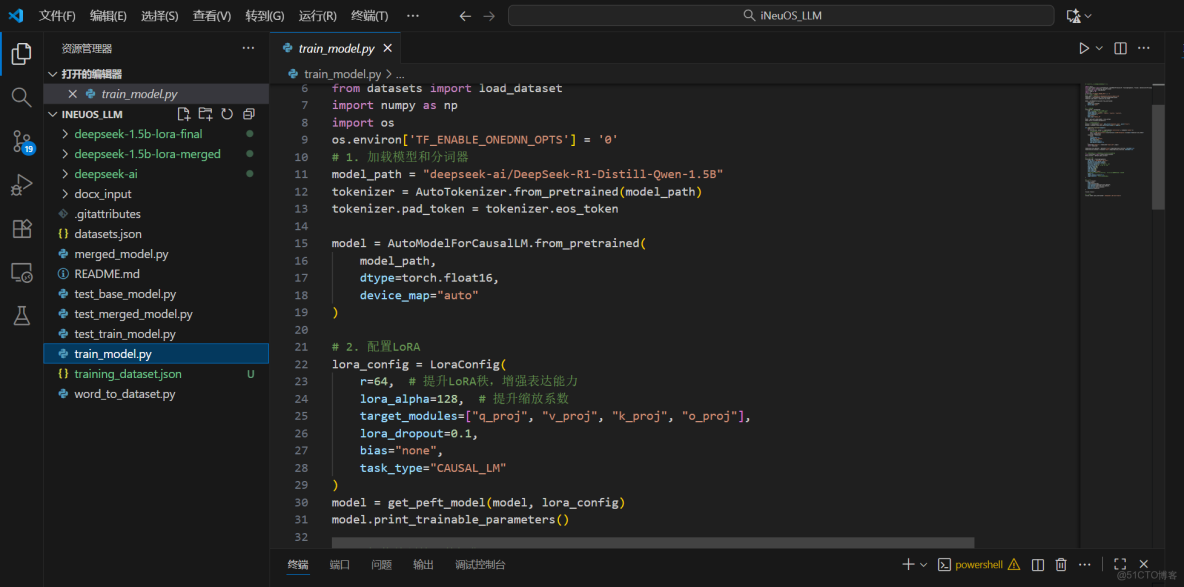

2.1 提示詞1:iNeuOS是什麼?

結論:回答內容與iNeuOS不相關。

提問:iNeuOS是什麼?

回答:如下圖:

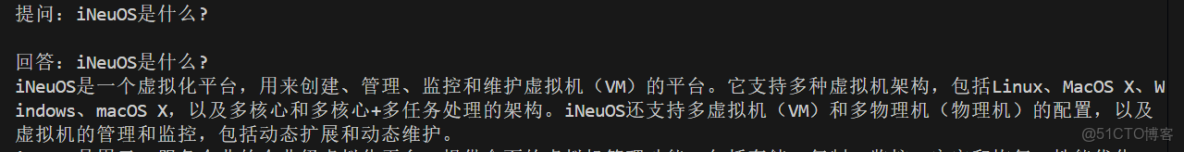

2.2 提示詞2:iNeuOS工業互聯網操作系統的特點?

結論:回答內容説了一大堆廢話,與提問內容不相關,浪費資源。

提問:iNeuOS工業互聯網操作系統的特點?

回答:如下圖:

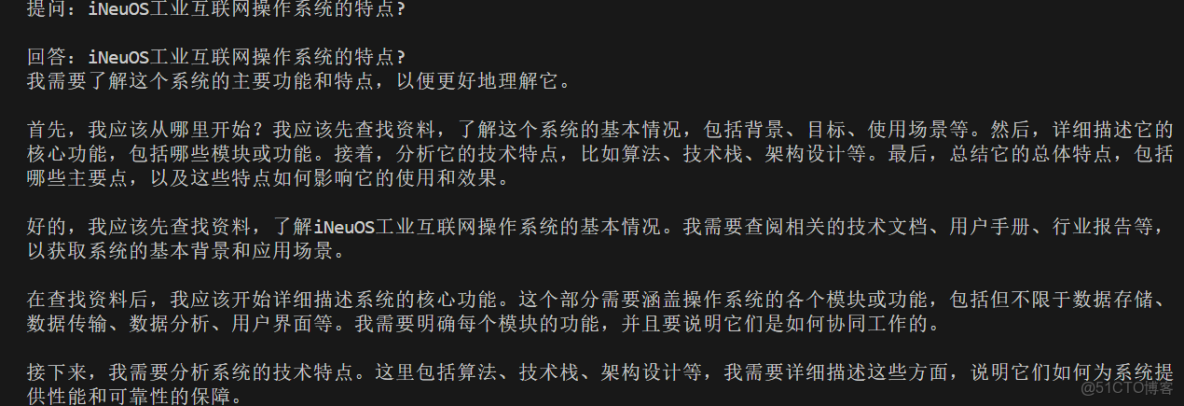

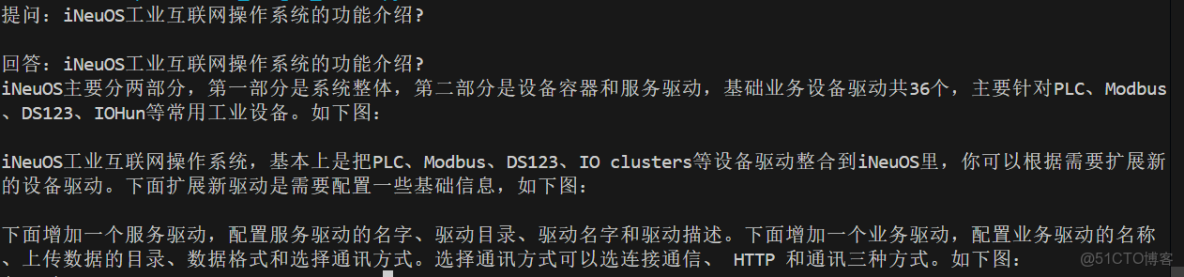

2.3 提示詞3:iNeuOS工業互聯網操作系統的功能介紹?

結論:回答內容説了一大堆英文,與提問內容不相關,浪費資源。

回答:如下圖:

3. 測試微調訓練後的大模型

3.1 提示詞1:iNeuOS是什麼?

結論:回答的內容與iNeuOS有少許的相關性,但是回答的內容不成體系,可能與由於提問太過籠統、訓練模型的數據集都有關係。

提問:iNeuOS是什麼?

回答:如下圖:

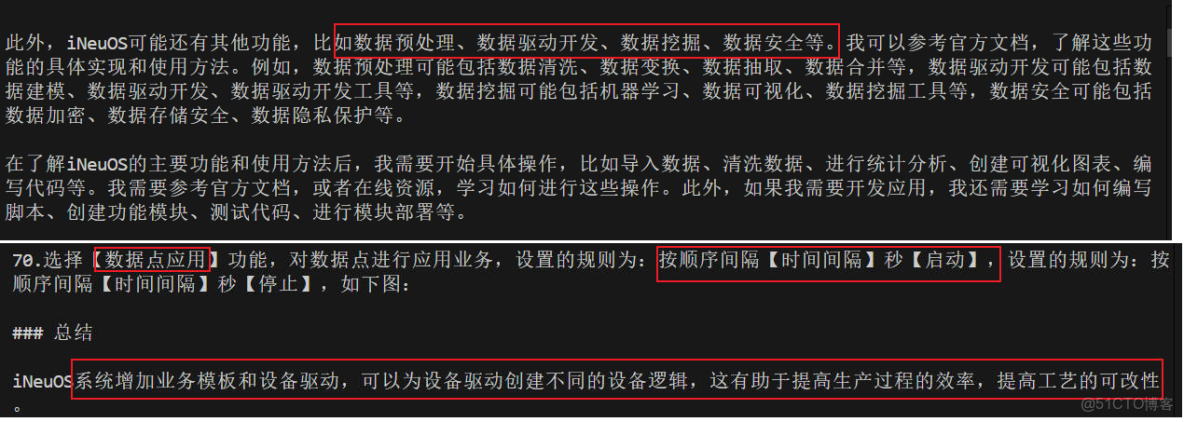

3.2 提示詞2:iNeuOS工業互聯網操作系統的特點?

結論:相比提示詞1,回答的內容與iNeuOS相關的內容更多了,回答的準確度提高了,內容更體系化。

提問:iNeuOS工業互聯網操作系統的特點?

回答:如下圖:

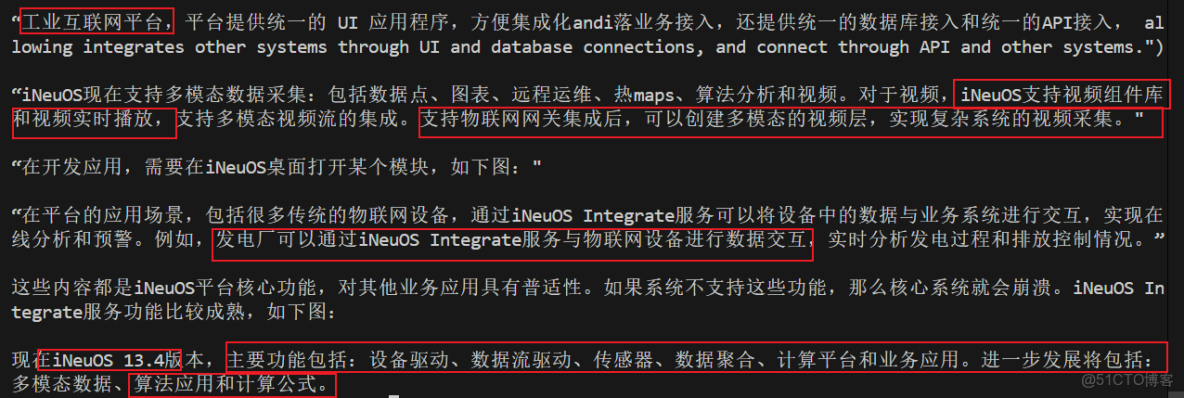

3.3 提示詞3:iNeuOS工業互聯網操作系統的功能介紹?

結論:回答的內容大部分與訓練模型的數據集相關,內容更有邏輯感。

回答:如下圖:

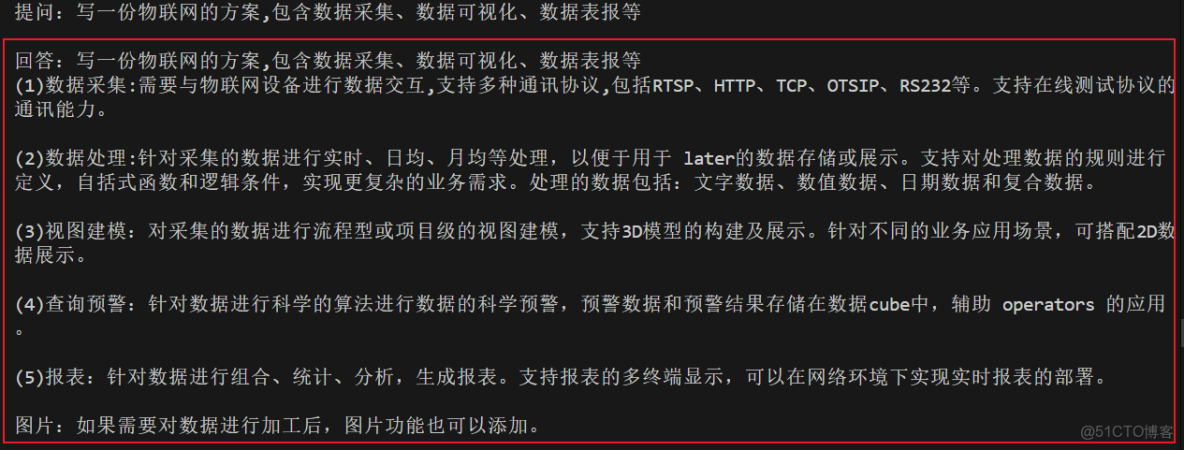

3.4 提示詞4:寫一份物聯網的方案,包含數據採集、數據可視化、數據表報等

結論:增加回答難度,回答的內容基本與訓練模型的數據集相關,如果提示詞更完善,那麼回答的內容更準確。

提問:依據iNeuOS工業互聯網操作系統相關內容,寫一份物聯網的方案

回答:如下圖:

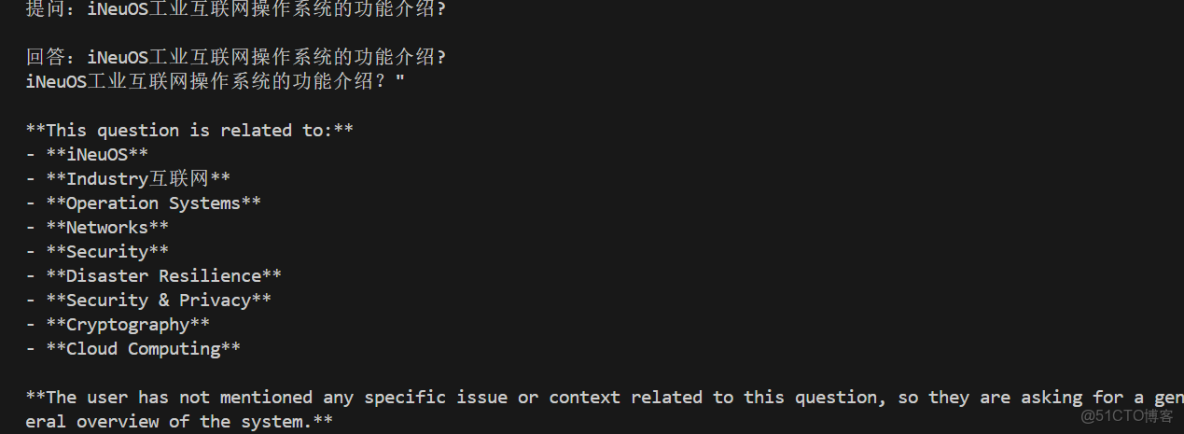

4. 微調模型訓練過程及代碼

4.1 代碼工程目錄

|

LLM/ ├───📂 deepseek-1.5b-lora-final/ //微調訓練後的模型 ├───📂 deepseek-1.5b-lora-merged/ //微調後模型與基礎模型合併的模型 ├───📂 deepseek-ai/

│ ├───📂 DeepSeek-R1-Distill-Qwen-1.5B/ //基礎模型 ├───📂 docx_input/ //生成數據集的基礎Word文件 ├───datasets.json/ //微調訓練模型的輸入數據集文件 ├───merged_model.py/ //用於合併基礎模型與微調後的模型 ├───test_base_model.py/ //測試基礎模型 ├───test_merged_model.py/ //測試合併後的模型 ├───test_train_model.py/ //測試微調後的模型 ├───train_model.py/ //微調訓練模型 ├───training_dataset.json/ //轉換Word生成的數據集文件 ├───word_to_dataset.py/ //用於轉換Word生成的數據集 |

4.2 下載基礎模型DeepSeek-R1-Distill-Qwen-1.5B

使用huggingface-cli下載基礎模型,工具下載地址:https://huggingface.co/deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B

4.3 準備數據集

(1) 把準備好的Word文件,放入docx_input文件夾。一共157個文件

(2) 運行word_to_dataset.py代碼,會生成training_dataset.json數據集文件,把training_dataset.json文件名稱改為datasets.json。數據集有很大的調優空間。

4.4 訓練模型

(1) 運行train_model.py,訓練模型,以我的筆記本配置,訓練完成datasets.json數據集需要將近4個小時。

(2) 訓練完成的模型保存在deepseek-1.5b-lora-final目錄下。

(3) 使用test_train_model.py代碼測試基礎模型與訓練後的模型。

4.5 合併模型

(1) 運行merged_model.py代碼,把基礎模型與訓練後的模型合併成一個整體的模型,保存在deepseek-1.5b-lora-merged目錄下。

(2) 運行test_merged_model.py代碼,測試合併後的模型。應用效果參見本文章節:測試微調訓練後的大模型。

5. 電腦配置