在現代分佈式系統架構中,負載均衡(Load Balancing)已經從一項可選技術演變為保障系統可用性、性能與穩定性的核心基礎設施。

隨着互聯網業務的爆炸式增長,單機服務器的處理能力瓶頸日益凸顯,負載均衡技術應運而成為解決高併發、大流量場景的關鍵手段。

服務器單機困境

以常見的Tomcat應用服務器為例,在默認配置下僅能開啓150個線程(Tomcat 8.5.x版本)來處理併發請求。當業務高峯期到來時,超過線程池上限的請求只能在隊列中等待,系統響應時間急劇惡化。這種架構的核心問題在於:

- 處理能力固定:單台服務器的併發處理能力受硬件資源限制

- 無容錯能力:服務器故障直接導致業務中斷

- 擴展性差:垂直擴展(升級硬件)成本高且存在上限

- 資源利用不均:無法根據實時負載動態調配資源

負載均衡

假設單台服務器可處理2000個併發請求,部署5台服務器並配置負載均衡後,整體處理能力可提升至10000個請求,更重要的是,負載均衡可以帶來的優勢:

- 高可用性:單點故障不影響整體服務

- 水平擴展:通過增加服務器節點提升容量

- 資源優化:根據算法策略合理分配流量

- 靈活部署:支持灰度發佈、藍綠部署等高級策略

國內互聯網巨頭如阿里巴巴、騰訊、百度、字節跳動、美團等均大規模應用負載均衡技術。

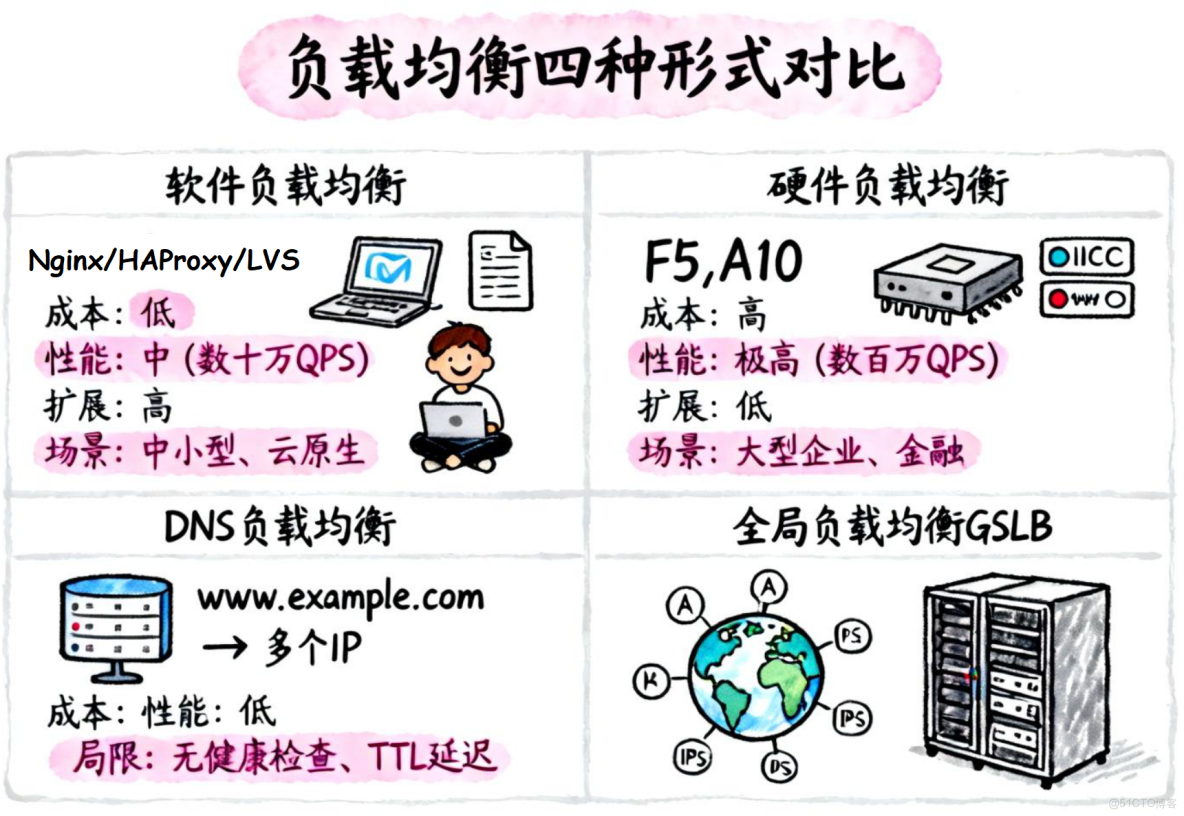

負載均衡的四種核心形式

一、軟件負載均衡(SLB):靈活性與成本優勢

軟件負載均衡通過在通用服務器上部署代理程序實現流量分發,以軟件為主要載體。

核心實現工具:

- Nginx:高性能Web服務器:

- 七層(應用層),基於HTTP請求頭、URL等應用信息進行流量分發,支持靈活的路由策略(輪詢、加權輪詢、IP哈希等)。

- 四層(TCP/UDP層),基於IP地址和端口號(不解析應用層數據),適用於數據庫、遊戲等對實時性要求高的場景。

- HAProxy:

- 七層,基於HTTP協議,保持會話、URL路徑匹配、ACL訪問控制等

- 四層,分析IP層及TCP/UDP層流量,基於IP加端口進行負載均衡

- LVS(Linux Virtual Server):

- 四層:基於TCP/IP、Linux內核化進行路由和轉發

技術特點:

- 基於通用服務器硬件,無需專用設備

- 支持豐富的負載均衡算法(輪詢、最少連接、哈希等)

- 可通過配置文件靈活調整策略

- 社區活躍,開源方案零成本

適用場景:

- 中小型企業或預算有限的項目

- 需要快速迭代和靈活配置的業務

- 動態擴展需求強烈的雲原生架構

- 開發測試環境

二、硬件負載均衡(HLB):高性能與可靠性

硬件負載均衡採用專用設備實現,通過優化的芯片和固件提供極致性能。

主流產品:

- F5 Big-IP:市場佔有率最高的企業級負載均衡設備

- A10 Networks:高性能應用交付控制器

- Citrix NetScaler:應用交付和負載均衡解決方案

技術特點:

- 專用ASIC芯片實現硬件加速

- 提供SSL卸載、深度數據包檢測(DPI)等高級功能

- 雙電源、雙鏈路等冗餘設計保障高可用

- 廠商提供專業技術支持和SLA保障

適用場景:

- 大型企業核心業務系統

- 金融、電信等對性能和穩定性要求極高的行業

- 超大規模併發流量場景(百萬級併發)

- 需要複雜應用層優化的場景

三、DNS負載均衡:地理分佈與簡單調度

DNS負載均衡通過域名解析層面實現流量分發,是最簡單的負載均衡形式。

實現原理:

為同一域名配置多個A記錄,DNS服務器根據策略返回不同IP地址:

www.example.com IN A 192.168.1.1

www.example.com IN A 192.168.1.2

www.example.com IN A 192.168.1.3技術特點:

- 實現極其簡單,無需額外設備或軟件

- 支持基於地理位置的智能解析

- DNS TTL控制緩存時間

- 成本幾乎為零

適用場景:

- 全球化業務的CDN加速

- 跨地域數據中心的粗粒度調度

- 簡單的流量分發需求

- 靜態資源服務

侷限性:

- DNS緩存導致切換延遲(TTL時間內無法實時調整)

- 無法感知後端服務器健康狀態

- 無法實現會話保持

- 調度策略簡單,缺乏細粒度控制

四、全局負載均衡(GSLB):智能調度與容災

GSLB結合DNS與健康檢查機制,對分別放在不同地理位置的服務器羣間做負載均衡。實現跨數據中心的智能流量調度。

對於某個請求,應該將其指定到哪個服務羣,應該是用什麼標準來進行這種選擇,一般考慮 臨近程度和負載大小,即距離和服務器羣負載比較。

核心功能:

- 健康檢查:實時監控後端節點狀態

- 智能路由:基於延遲、地理位置、負載等多維度決策

- 故障自愈:自動將流量切換至健康節點

- 容災能力:支持多活、同城雙活、異地災備等架構

適用場景:

- 多數據中心多活架構

- 跨雲、混合雲部署

- 需要智能容災的關鍵業務

- 全球化業務的精細化調度

軟硬件負載均衡深度對比

|

對比維度

|

硬件負載均衡

|

軟件負載均衡

|

|

性能表現 |

專用ASIC芯片,數百萬併發,微秒級延遲 |

受通用硬件限制,數十萬併發,毫秒級延遲 |

|

可靠性 |

冗餘設計(雙電源/雙鏈路),MTBF高 |

依賴軟件穩定性,需多節點冗餘保障 |

|

功能豐富度 |

SSL卸載、DPI、應用層優化、全協議支持 |

基礎功能完善,高級功能需插件擴展 |

|

成本投入 |

初始投資高(數十萬至數百萬),維保費用高 |

軟件授權費用低或免費,硬件成本低 |

|

部署複雜度 |

需專業工程師,配置複雜,調試周期長 |

Web界面或配置文件,部署快速,易於管理 |

|

擴展性 |

垂直擴展為主,橫向擴展需增購設備 |

水平擴展靈活,可快速增加節點 |

|

靈活性 |

配置相對固化,調整週期長 |

配置靈活,支持熱更新和快速迭代 |

|

維護成本 |

廠商技術支持,維保費用高 |

社區支持或自主運維,成本可控 |

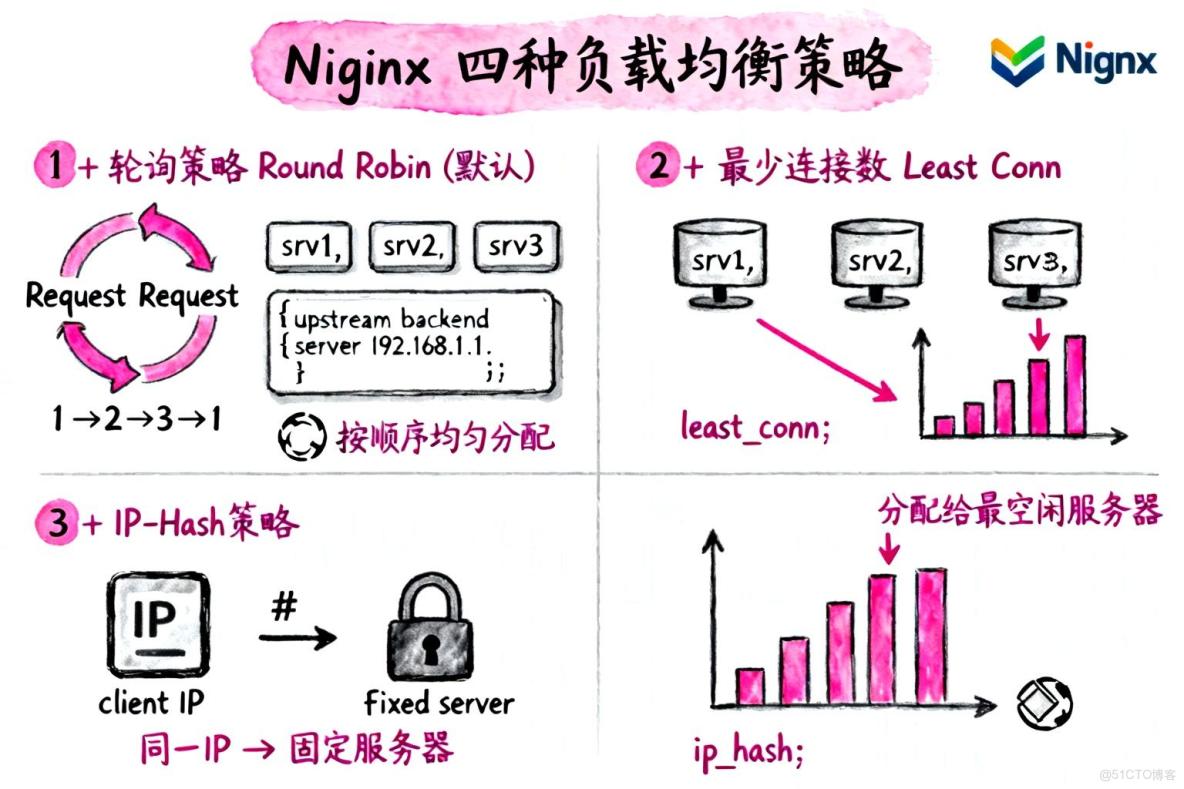

Nginx負載均衡策略詳解

Nginx作為最流行的軟件負載均衡解決方案,提供了四種內置的負載均衡策略,每種策略適用於不同的業務場景。

1. 輪詢策略(Round Robin)- 默認策略

原理:按照配置順序依次將請求分配給後端服務器,實現均勻分佈。

配置示例:

upstream backend {

server 192.168.1.1;

server 192.168.1.2;

server 192.168.1.3;

}

server {

listen 80;

location / {

proxy_pass http://backend;

}

}適用場景:

- 後端服務器性能相近

- 無狀態服務(如靜態資源、API網關)

- 簡單場景的快速部署

優點:配置簡單,分配均勻

缺點:未考慮服務器實時負載差異

2. 最少連接數策略(Least Connections)

原理:優先將請求分配給當前活動連接數最少的服務器,實現動態負載均衡。

配置示例:

upstream backend {

least_conn; # 啓用最少連接數策略

server 192.168.1.1;

server 192.168.1.2;

server 192.168.1.3;

}

server {

listen 80;

location / {

proxy_pass http://backend;

}

}適用場景:

- 請求處理時間差異大的業務

- 長連接服務(如WebSocket)

- 後端服務器性能不均的情況

優點:動態平衡負載,避免某台服務器過載

缺點:需要維護連接狀態,略增加Nginx開銷

3. IP-Hash策略

原理:根據客户端IP地址的哈希值決定後端服務器,保證同一客户端的請求固定分配到同一服務器。

配置示例:

upstream backend {

ip_hash; # 啓用IP-Hash策略

server 192.168.1.1;

server 192.168.1.2;

server 192.168.1.3;

}

server {

listen 80;

location / {

proxy_pass http://backend;

}

}適用場景:

- 會話保持需求(Session Sticky)

- 用户登錄狀態存儲在應用服務器本地

- 無法使用Redis等中間件存儲會話的場景

優點:解決會話保持問題,無需額外中間件

缺點:

- 負載分佈不均(用户分佈不均勻)

- 服務器擴縮容影響較大

- 不適用於CDN或代理後的場景

4. 加權負載均衡(Weighted)

原理:根據服務器配置的權重值分配請求,權重高的服務器獲得更多流量。

配置示例:

upstream backend {

server 192.168.1.1 weight=3; # 權重3,接收60%流量

server 192.168.1.2 weight=1; # 權重1,接收20%流量

server 192.168.1.3 weight=1; # 權重1,接收20%流量

}

server {

listen 80;

location / {

proxy_pass http://backend;

}

}配置説明:5次請求中,3次分配給srv1,1次給srv2,1次給srv3

適用場景:

- 後端服務器硬件配置差異大

- 新舊服務器混合部署

- 灰度發佈(新版本低權重,觀察穩定性)

- 需要精細化流量控制的場景

優點:充分利用高性能服務器資源,靈活控制流量分配

缺點:需要人工配置權重,需要對服務器性能有準確評估

Nginx負載均衡實現原理

Nginx的負載均衡處理流程如下:

客户端 → DNS解析(域名→Nginx IP) → Nginx服務器

→ URL匹配與負載均衡算法 → 選擇後端服務器

→ 代理請求至後端 → 後端處理並返回結果

→ Nginx返回給客户端關鍵技術點:

- 反向代理:Nginx作為中間層接收客户端請求

- 健康檢查:自動檢測後端服務器狀態(需第三方模塊或Nginx Plus)

- 連接複用:通過upstream keepalive優化性能

- 協議支持:HTTP、HTTPS、FastCGI、uwsgi、SCGI、memcached、gRPC

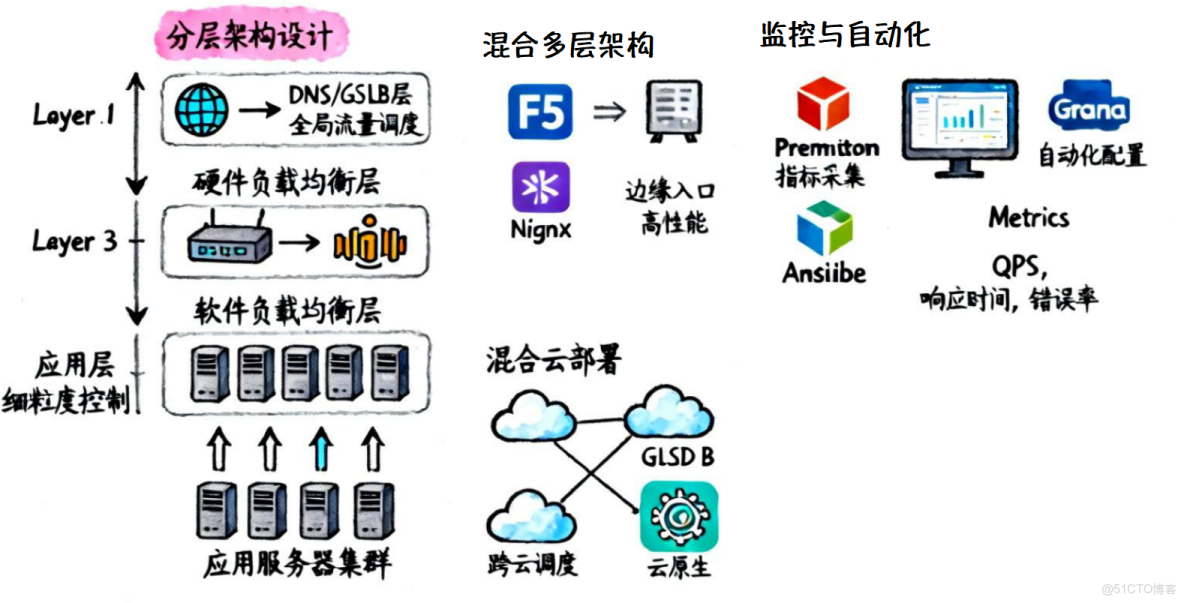

最佳實踐與架構建議

1. 分層架構設計

在實際生產環境中,單一負載均衡方案往往無法滿足所有需求,建議採用分層架構:

三層負載均衡架構:

[DNS/GSLB層] - 全局流量調度,跨地域容災

↓

[硬件負載均衡層] - 邊緣入口,高性能四層轉發

↓

[軟件負載均衡層] - 應用層負載均衡,細粒度控制

↓

[應用服務器集羣]架構優勢:

- 高可用性:多層冗餘,單點故障影響範圍小

- 性能優化:各層發揮所長,硬件處理大流量,軟件實現複雜邏輯

- 靈活擴展:軟件層易於橫向擴展,硬件層保障性能基線

- 成本均衡:核心節點用硬件,邊緣節點用軟件

2. 混合雲部署策略

隨着混合雲架構的普及,負載均衡需要跨越公有云、私有云和IDC:

推薦方案:

- GSLB:實現跨雲流量調度和智能路由

- 雲負載均衡服務:使用雲廠商提供的ALB/NLB服務

- 自建Nginx集羣:處理內部微服務間流量

配置示例(Nginx跨雲代理):

upstream cloud_a {

server 10.1.1.1:80; # 雲A的服務器

server 10.1.1.2:80;

}

upstream cloud_b {

server 10.2.1.1:80; # 雲B的服務器

server 10.2.1.2:80;

}

server {

listen 80;

# 基於URL路徑路由

location /api/v1/ {

proxy_pass http://cloud_a;

}

location /api/v2/ {

proxy_pass http://cloud_b;

}

}3. 監控與自動化運維

負載均衡系統需要完善的監控和自動化能力:

監控指標:

- 性能指標:QPS、響應時間、連接數、帶寬

- 健康指標:後端服務器存活率、錯誤率

- 資源指標:CPU、內存、網絡I/O

工具鏈推薦:

- Prometheus + Grafana:指標採集與可視化

- Ansible/Terraform:配置自動化部署

- Consul/Etcd:服務發現與配置中心

- ELK Stack:日誌分析與問題排查

4. 容量規劃與性能調優

容量規劃要注意 冗餘設計、分級保障(區分核心業務和邊緣業務)、彈性伸縮(彈性擴縮容)

在實際部署中,不存在一勞永逸的方案,而應採用分層架構和組合策略,充分發揮不同負載均衡技術的優勢。通過硬件保障性能基線,軟件提供靈活性,DNS/GSLB實現全局調度,最終構建一個高可用、高性能、易擴展的負載均衡體系,這才是支撐現代分佈式系統的最佳實踐。