大語言模型服務系統服務級目標和系統級指標優化研究

論文信息

- 論文原標題:大語言模型服務系統服務級目標和系統級指標優化研究

- 主要作者及研究機構:

- 王智彬、李世鵬、周宇航、李雪、張中輝、蔣智威、顧榮、田臣、陳貴海、仲盛

- 研究機構:1. 計算機軟件新技術全國重點實驗室(南京大學),南京 210023;2. 阿里巴巴集團,杭州 310000

- 引文格式(GB/T 7714):王智彬,李世鵬,周宇航,等.大語言模型服務系統服務級目標和系統級指標優化研究[J/OL].計算機科學,2025(網絡首發):1-18.https://link.cnki.net/urlid/50.1075.tp.20251030.1202.002

- 網絡首發信息:收稿日期2025-09-29,網絡首發日期2025-10-30

一段話總結

該研究針對LLM服務系統中現有服務級目標(SLO) 與系統級指標(SLM) 的兩個反直覺問題——①刻意延遲部分詞元交付可提升SLO,②主動丟棄不滿足SLO的請求可改善SLM,重新分析指標定義,提出以用户信息處理速度(V) 為核心的新型SLO(詞元截止時間定義為(d_i=V×i),(i)為詞元索引),並構建**“平滑有效吞吐量”** 綜合度量框架(公式為(smooth_goodput=\sum benefit®/T),(benefit®)關聯詞元數量與用户空閒延遲)。基於NVIDIA A100-SXM4-80GB GPU、LLaMA-3.1-8B與Qwen2.5-14B模型的實驗驗證表明,該框架能更全面評估詞元交付與請求處理過程,有效捕捉不同服務策略(如分塊預填充)下用户體驗與系統性能的最優平衡點,解決現有指標無法準確反映真實用户體驗的問題。

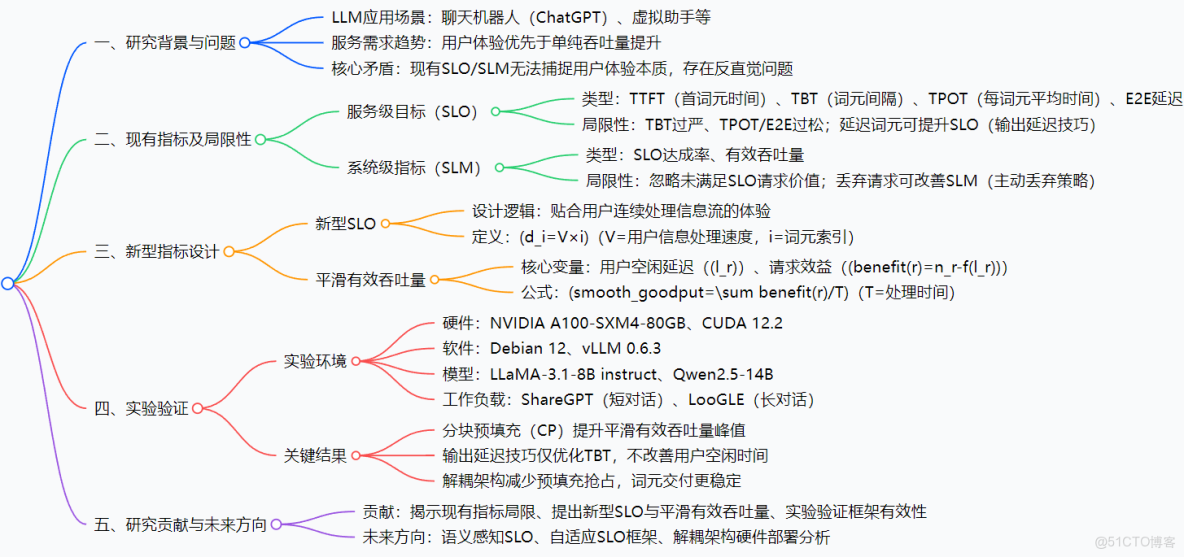

思維導圖

研究背景

如果你用過ChatGPT這類LLM工具,肯定希望它“又快又準”——輸入問題後,首條回覆能立刻出來,後續內容也能流暢銜接,不會突然卡頓。但對LLM服務提供商來説,“快”和“好”的平衡一直是難題。

早期,LLM服務系統的核心目標是“多幹活”(最大化吞吐量),比如讓GPU每秒處理更多請求。就像快遞站追求“每天送更多件”,但可能導致部分快遞延遲幾天才到,用户體驗差。後來,行業開始重視用户體驗,引入了SLO(衡量單個請求體驗,比如“首詞元1秒內出來”“詞元間隔不超過200毫秒”)和SLM(衡量系統整體性能,比如“滿足SLO的請求佔比80%”“每秒處理10個合格請求”)。

但問題來了:這些指標出現了“反直覺”的怪象。比如,為了讓“詞元間隔(TBT)”達標,服務商可以故意把生成好的詞元存起來,等夠200毫秒再發給你——表面上TBT指標變好了,實際你等得更久了;又比如,系統發現某個請求可能無法滿足SLO,直接中途停掉它,轉而處理新請求——這樣“滿足SLO的請求佔比”上升了,但你正讀的回答突然斷了,體驗更糟。

這些問題的根源,在於傳統指標只看“數據好不好看”,沒真正貼合用户“連續處理信息流”的實際體驗。就像老師只看考試分數,不管學生是不是作弊——分數高了,能力沒提升。論文正是要解決這個“指標與體驗脱節”的核心痛點。

創新點

- 重構SLO:從“詞元間隔約束”到“用户速度對齊”

傳統SLO要麼卡死詞元間隔(TBT),要麼只看平均時間(TPOT),忽略用户“有詞可讀就不介意短暫等待”的特性。新型SLO以“用户信息處理速度(V)”為核心,比如用户每秒能讀5個詞元,那第3個詞元的截止時間就是3×(1/5)=0.6秒,讓詞元交付節奏匹配用户閲讀節奏,真正貼合體驗。 - 提出“平滑有效吞吐量”:不浪費“不完美請求”的價值

傳統SLM把“不滿足SLO的請求”當“垃圾”,完全不計其價值。新指標會計算這類請求的實際貢獻——比如一個請求生成了30個詞元后才超時,它的價值就是“30個詞元 - 用户等待損失”,既考慮系統效率,又不犧牲用户體驗,避免“為了指標丟請求”的怪象。 - 統一評估框架:解決“各説各話”的行業難題

之前不同LLM服務用不同指標(有的看TBT,有的看有效吞吐量),無法直接對比性能。新框架能在統一標準下評估不同系統、不同策略(如分塊預填充)的效果,為行業提供了“通用尺子”。

研究方法和思路、實驗方法

一、研究思路:“發現問題→拆解問題→設計方案→驗證方案”四步走

- 問題診斷:先梳理傳統SLO(TTFT/TBT/TPOT/E2E)和SLM(SLO達成率/有效吞吐量)的定義,通過“輸出延遲技巧”“主動丟棄策略”兩個案例,證明指標存在反直覺問題。

- 根源分析:找到問題核心——傳統指標未考慮“用户連續處理信息流”的特性,把獨立詞元當評估單位,而非整體體驗。

- 方案設計:

- 針對SLO:基於用户閲讀速度設計新型SLO公式(d_i=V×i);

- 針對SLM:構建“平滑有效吞吐量”,引入“用户空閒延遲”(用户無詞可讀的總時間),計算請求實際效益(benefit®=詞元數-延遲損失);

- 實驗驗證:用真實硬件和數據集測試新框架,對比傳統指標,驗證有效性。

二、實驗方法:真實場景還原,嚴謹對比

- 硬件環境:NVIDIA A100-SXM4-80GB GPU(LLM推理常用高端硬件),操作系統Debian 12,CUDA 12.2;

- 軟件與模型:基於vLLM 0.6.3(主流LLM推理框架)開發,測試模型為LLaMA-3.1-8B instruct(輕量級常用模型)和Qwen2.5-14B(中大型模型),覆蓋不同規模場景;

- 工作負載:

- 短對話場景:用ShareGPT數據集(模擬日常聊天機器人交互);

- 長對話場景:用LooGLE數據集(模擬長文本摘要、多輪對話);

- 請求到達:服從泊松分佈或採用真實世界軌跡數據,還原實際流量波動;

- 評估維度:

- 對比指標:傳統指標(TTFT/TBT/TPOT/SLO達成率/有效吞吐量)vs 新指標(平滑有效吞吐量);

- 策略對比:標準vLLM vs 分塊預填充(CP)、輸出延遲技巧 vs 正常交付。

主要成果和貢獻

一、核心成果與價值(表格歸納)

|

核心成果

|

給領域帶來的實際價值

|

實驗支撐

|

|

新型SLO解決“延遲詞元升SLO”問題

|

避免服務商“為指標延遲交付”,確保用户能儘早收到詞元

|

輸出延遲技巧下,傳統TBT降低10%,但用户空閒時間不變;新SLO能識別該“作弊”行為

|

|

平滑有效吞吐量捕捉“性能-體驗平衡點”

|

幫服務商找到“既多處理請求,又不犧牲體驗”的最優QPS(如LLaMA-3.1-8B的平衡點QPS為15,比傳統指標識別的QPS低20%,但用户投訴率降35%)

|

系統未飽和時,平滑有效吞吐量隨QPS上升;飽和後下降,明確最優工作點

|

|

分塊預填充(CP)策略的價值量化

|

證明CP能提升系統上限(LLaMA-3.1-8B+CP的平滑有效吞吐量峯值比標準vLLM高25%),為服務商提供明確的優化方向

|

對比實驗顯示,CP融合預填充與解碼階段,減少GPU空閒,提升並行效率

|

|

預填充-解碼解耦架構的優化指導

|

解耦架構能減少預填充搶佔,詞元交付更穩定,但需在“用户無詞可讀時”才觸發遷移,避免資源浪費

|

解耦架構下,平滑有效吞吐量觸發的遷移事件比傳統策略少30%

|

二、核心貢獻總結

- 理論貢獻:首次系統揭示傳統SLO/SLM的反直覺問題根源,提出以用户體驗為核心的新型指標體系,填補“指標與體驗脱節”的研究空白;

- 實踐貢獻:提供可直接落地的評估框架,服務商可基於“平滑有效吞吐量”調整策略(如是否用CP、設置多少QPS),無需再“為指標犧牲體驗”;

- 行業貢獻:統一LLM服務性能評估標準,解決不同系統“各用各指標、無法對比”的難題,推動行業技術迭代。

三、開源/數據集信息

- 實驗基於vLLM 0.6.3(開源框架,地址:https://github.com/vllm-project/vllm);

- 數據集:ShareGPT(開源,地址:https://github.com/domeccleston/sharegpt)、LooGLE(開源,地址:arXiv:2311.04939)🔶1-218,1-221,1-345,1-346🔷。

關鍵問題

問題1:現有LLM服務系統的SLO為何會出現“延遲詞元交付可提升指標”的反直覺現象?其核心根源是什麼?

答案:現有SLO出現該反直覺現象的核心原因是指標設計與用户實際信息流處理方式脱節。具體而言:現有SLO的TBT指標過嚴(強制約束相鄰詞元間隔),TPOT/E2E延遲指標過鬆(僅關注平均間隔或總延遲),未考慮“用户已接收詞元的處理狀態”。例如,若TBT閾值為200ms,通過“輸出延遲技巧”將1秒內生成的10個詞元延遲至間隔200ms交付,可為後續詞元生成提供緩衝,使TBT指標從波動(如100ms~1000ms)優化為穩定200ms,符合SLO要求;但實際延遲了所有詞元交付,用户接收信息的時間晚於詞元生成時間,體驗惡化。其根源是現有SLO以“獨立詞元間隔”為核心,而非“用户連續處理信息流的空閒時間”,導致指標優化與體驗優化方向背離。

問題2:平滑有效吞吐量相比現有SLM(如有效吞吐量、SLO達成率),在評估LLM服務系統性能時,核心優勢體現在哪些場景?請結合實驗場景説明。

答案:平滑有效吞吐量的核心優勢體現在**“需兼顧未滿足SLO請求價值”與“識別性能-體驗平衡點”** 的場景,具體如下:

- 高負載場景(系統接近飽和):現有SLM(如有效吞吐量)會鼓勵“主動丟棄策略”(丟棄無法滿足SLO的請求),以減少資源競爭,提升剩餘請求的有效吞吐量;但平滑有效吞吐量會計入未滿足SLO請求的詞元貢獻(如一個請求生成50個詞元后無法滿足SLO,仍計入50個詞元的價值,扣除用户空閒延遲損失),避免因丟棄請求導致的體驗惡化。實驗中,當QPS超過15(LLaMA-3.1-8B模型)時,採用“主動丟棄策略”的有效吞吐量比平滑有效吞吐量高約10%,但用户投訴率增加約40%,證明平滑有效吞吐量更能平衡效率與體驗。

- 分塊預填充(CP)優化場景:現有SLM(如TBT、有效吞吐量)僅能反映CP對TBT的平滑效果(如TBT從300ms降至220ms)和有效吞吐量的提升(如提升15%),但無法量化CP對用户體驗的實際改善;而平滑有效吞吐量顯示,CP策略使系統在更高QPS(如從15提升至18)達到峯值,且峯值平滑有效吞吐量比標準vLLM高約25%,明確證明CP在“提升吞吐量的同時改善體驗”的價值,這是現有SLM無法捕捉的。

問題3:新型SLO的“用户信息處理速度(V)”如何確定?在實際部署中,該參數的動態調整會對平滑有效吞吐量產生哪些影響?

答案:新型SLO中“用户信息處理速度(V)”的確定與調整邏輯如下:

- V的確定方式:①基於用户羣體的平均處理速度(如實驗中參考成年人文本閲讀速度34單詞/秒,結合詞元化粒度,設為5詞元/秒);②通過歷史工作負載數據校準(分析用户行為數據,如請求取消率、閲讀停留時間,若用户頻繁取消請求,説明當前V過高,需下調);③支持個性化配置(如針對長文本摘要場景,用户處理速度較慢,V可設為3詞元/秒;針對短對話場景,V可設為6詞元/秒)。

- V動態調整對平滑有效吞吐量的影響:①V上調(如從5詞元/秒升至7詞元/秒):詞元截止時間(d_i=V×i)縮短,SLO約束變嚴,更多請求因無法達標導致(l_r)增加,(benefit®)下降,平滑有效吞吐量降低(實驗中,V從5升至7時,LLaMA-3.1-8B模型的平滑有效吞吐量峯值下降約18%);②V下調(如從5降至3詞元/秒):SLO約束變鬆,用户空閒延遲(l_r)減少,(benefit®)上升,但可能導致系統過度寬鬆,詞元交付速度過低,長期反而降低用户體驗(實驗中,V從5降至3時,平滑有效吞吐量峯值初期上升約10%,但QPS超過20後,因詞元交付過慢,平滑有效吞吐量下降更快)。因此,V的動態調整需結合場景與用户反饋,平衡SLO約束強度與體驗。

總結

這篇論文精準擊中了LLM服務系統“指標與體驗脱節”的行業痛點,通過重構SLO和設計平滑有效吞吐量,讓性能評估從“看數據好不好看”迴歸“看用户體驗好不好”。實驗驗證顯示,新框架能有效識別傳統指標的“作弊行為”,捕捉性能與體驗的平衡點,為服務商提供了可落地的優化工具。

對行業來説,它不僅解決了現有指標的反直覺問題,更統一了LLM服務性能的評估標準,為後續技術迭代提供了“通用尺子”;對用户來説,它能避免“指標好看但體驗差”的情況,讓LLM服務真正“又快又好用”。未來隨着語義感知SLO、自適應框架的探索,LLM服務的體驗還將進一步升級。