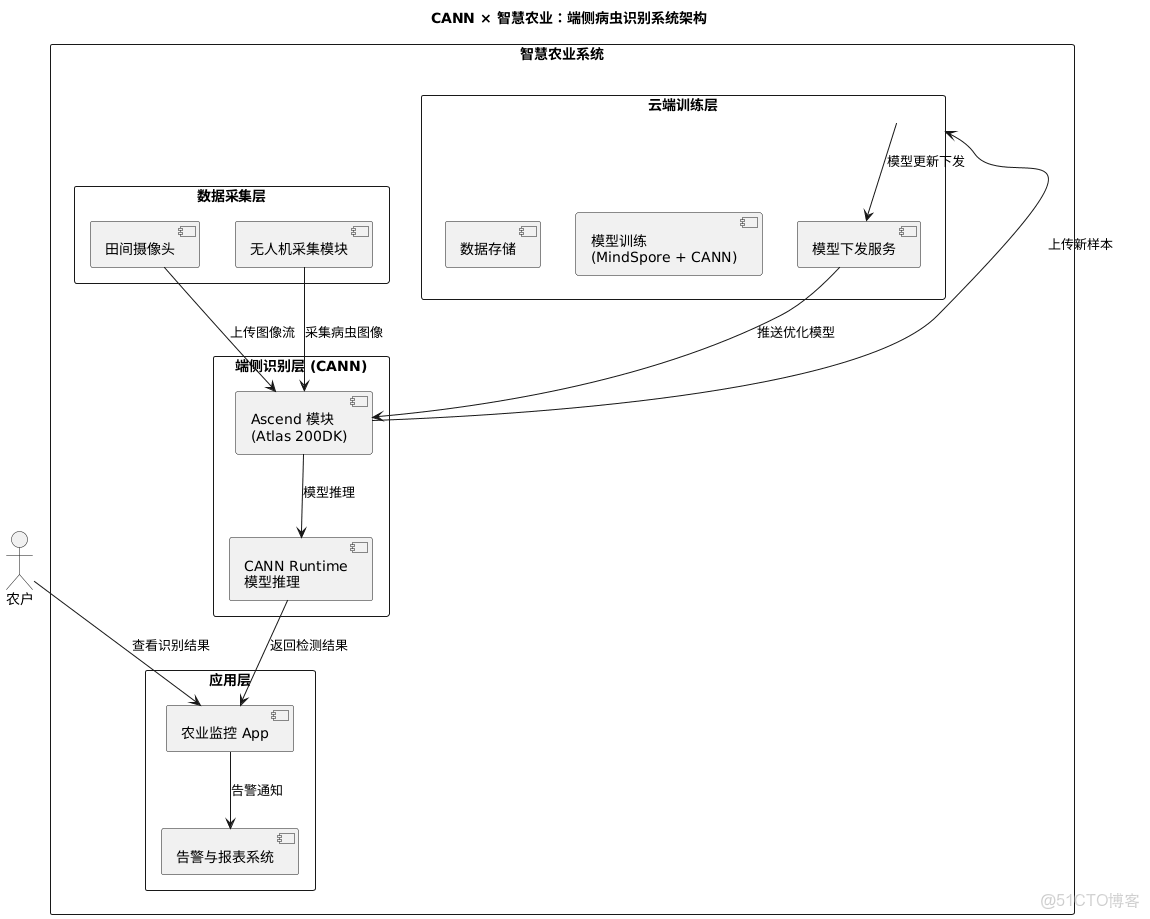

摘要:人工智能正在從雲端走向邊緣,重塑傳統農業的面貌。然而,“雲端太遠,田間太近”,在真實的農業場景中,網絡不穩與算力受限成為了 AI 落地的最大阻礙。如何在無網、低功耗的邊緣端設備上,實現高精度、實時的病蟲害識別?本文將以 OrangePi AI Pro 開發板為例,深度剖析如何利用華為 CANN(Compute Architecture for Neural Networks)異構計算架構,將 EfficientNet 模型高效部署到田間地頭。從底層 NPU 的資源隔離與綁核設置,到 PyTorch 模型的無縫遷移訓練,再到 ATC 編譯器的圖級優化與推理部署,帶你完成一次硬核的端側 AI 落地全流程實踐。

一、引言:當算法遇到泥土——邊緣計算的必然性

在數字農業的宏偉願景中,未來的農田將由數據驅動:無人機在作物上空巡航,捕捉葉片微小的色斑;地面巡檢機器人穿梭於壟間,實時診斷作物的健康狀態。然而,當算法工程師試圖將實驗室裏的高精度模型搬進真實的農田時,往往會撞上“現實的牆壁”:

- 網絡連接的脆弱性(Latency & Reliability):

- 廣袤的農田往往處於 4G/5G 信號的邊緣地帶,帶寬波動巨大甚至經常斷網。

- 若依賴雲端 API 進行推理,不僅要忍受高達數百毫秒甚至秒級的延遲(對於高速飛行的無人機來説,這意味着錯過了噴灑點),更可能因為網絡中斷導致整個作業系統癱瘓。

- 此外,海量的高清農業圖像上傳雲端,也會帶來難以承受的流量成本和隱私數據泄露風險。

- 端側算力的“不可能三角”(Performance, Power, Cost):

- 農業邊緣設備(如無人機、自動駕駛拖拉機)通常由電池供電,對功耗極其敏感。

- 傳統的通用 CPU(如 ARM Cortex-A 系列)雖然能運行操作系統,但在執行大規模矩陣運算(卷積神經網絡的核心)時效率極低,往往導致設備發熱嚴重、續航腰斬,且幀率(FPS)無法滿足實時監測需求。

- 而高性能的 GPU 服務器體積大、功耗高、價格昂貴,根本無法部署在田間節點。

如何打破這一僵局?答案在於**“軟硬協同”**。

華為 CANN(Compute Architecture for Neural Networks) 正是為此而生。作為連接上層深度學習框架與底層昇騰(Ascend)AI 硬件的橋樑,CANN 並不是一個簡單的驅動程序,而是一套完整的異構計算架構。它能通過軟硬件的深度耦合,將繁重的 AI 算力從通用的 CPU 轉移到專用的 NPU(神經網絡處理器) 上。昇騰 NPU 採用獨特的達芬奇架構(Da Vinci Architecture),利用高密度的 Cube 單元進行矩陣加速,從而在極低的功耗下實現極致的算力輸出,讓“田間智能”成為可能。

二、硬件與環境準備:打造田間“最強大腦”

2.1 硬件選型:OrangePi AI Pro

本次實戰的核心載體是 OrangePi AI Pro 開發板。它不僅僅是一個單板計算機,更是昇騰 AI 生態中的重要一員。

- 核心算力:搭載昇騰 AI SoC,提供 8TOPS 至 20TOPS(INT8)的澎湃算力,這在邊緣端設備中屬於“怪獸級”性能,足以流暢運行 YOLOv5、ResNet50 甚至輕量級的大語言模型。

- 豐富的接口:擁有雙 HDMI 輸出、GPIO 接口、M.2 插槽等,方便連接農業傳感器(如温濕度計)、攝像頭及 5G 通訊模組,非常適合作為農業物聯網(IoT)的邊緣計算網關。

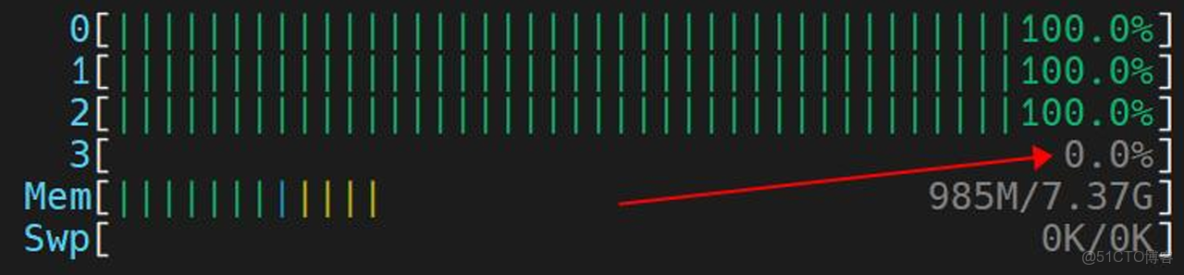

2.2 釋放 NPU 潛能:CPU 綁核優化的底層邏輯

在開始訓練模型之前,我們需要進行一項關鍵的系統級優化——CPU 綁核(CPU Affinity Setting)。

昇騰 SoC 採用了多核異構架構,其中包含 Control CPU(負責邏輯控制、操作系統調度)和 AI CPU(負責輔助 AI 計算、算子預處理)。默認情況下,Linux 系統的調度器會在所有核心之間動態分配任務,這可能導致頻繁的上下文切換(Context Switch),甚至讓關鍵的 AI 調度任務被後台進程搶佔。

為了保證模型訓練和推理時的數據預處理(Data Preprocessing)與任務下發(Kernel Launch)不被幹擾,我們可以手動調整 CPU 的配比,實施資源隔離。

深度實操指令:

# 1. 查看當前的芯片 CPU 資源分配情況

# cpu-num-cfg-i 0-c 0 表示查詢 ID 為 0 的芯片的 CPU 配置

npu-smi info-t cpu-num-cfg-i 0-c 0

# 2. 調整 CPU 配比

# 格式解釋:AI CPU : Control CPU : Data CPU

# 設置為 3 : 1 : 0

sudo npu-smi set-t cpu-num-cfg-i 0-c 0-v 3:1:0技術深度解讀: 為什麼我們要將

AI CPU的數量設置為 3? 在深度學習訓練中,Pipeline 通常由三部分組成:數據讀取與增強(CPU) -> 數據搬運(DMA) -> 模型計算(NPU)。 如果 CPU 處理數據的速度跟不上 NPU 計算的速度,NPU 就會處於“空轉等待”狀態,這種現象被稱為 CPU-bound(CPU 瓶頸)。通過npu-smi增加 AI CPU 的配額,CANN Runtime 可以調用更多的專用核心來並行處理數據增強(如 RandomCrop, Resize)和算子調度,從而保持 NPU 的流水線時刻處於滿載狀態,最大化系統吞吐量。

三、模型訓練:PyTorch 的無縫遷移與實戰

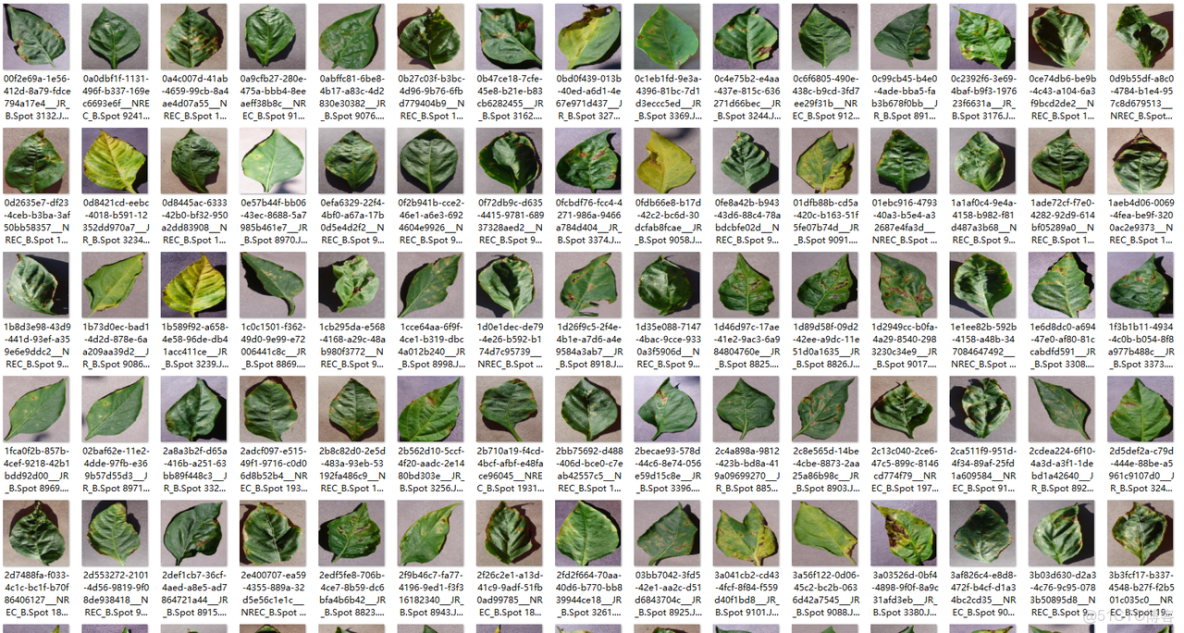

為了驗證系統的有效性,我們將使用經典的 PlantVillage 數據集。該數據集包含約 54,305 張高清圖像,覆蓋了蘋果、藍莓、玉米、葡萄等 14 種常見農作物及其對應的 26 種病害(以及健康狀態)。

在模型選擇上,我們放棄了笨重的 ResNet 系列,轉而選擇 EfficientNet-B0。

- 選擇理由:EfficientNet 通過複合縮放方法(Compound Scaling),在深度、寬度和分辨率之間找到了最優平衡。B0 版本參數量極小(約 5.3M),但精度卻超越了 ResNet-50,非常適合內存受限的端側設備。

得益於 CANN 生態的完善,華為提供了 PyTorch Plugin (torch_npu),它通過設備後端註冊機制,攔截了 PyTorch 的算子調用,並將其重定向到昇騰 ACL(Ascend Computing Language)接口上。這意味着開發者幾乎不需要改變原有的 PyTorch 編程習慣。

3.1 核心訓練代碼深度解析

以下是優化後的訓練腳本核心片段,重點解析 NPU 的適配細節與訓練策略。

"""

CANN × 智慧農業:植物病蟲害識別模型訓練腳本

"""

import os

import random

import datetime

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import datasets, transforms

from torch.utils.data import DataLoader, Subset

from torchvision.models import efficientnet_b0, EfficientNet_B0_Weights

from tqdm import tqdm

import matplotlib.pyplot as plt

# ========== 參數配置 ==========

data_dir = "./datasets/PlantVillage/PlantVillage"

batch_size = 32

num_epochs = 25

lr = 0.001

train_ratio = 0.8

# ========== 設備優先級:NPU > CPU ==========

try:

import torch_npu # noqa: F401

npu_available = torch.npu.is_available()

except Exception:

npu_available = False

if npu_available:

device = torch.device("npu:0")

torch.npu.set_device(device)

else:

device = torch.device("cpu")

print(f"使用設備: {device}")

# ========== 數據增強 ==========

train_transform = transforms.Compose([

transforms.Resize((256, 256)),

transforms.RandomCrop(224),

transforms.RandomHorizontalFlip(0.5),

transforms.RandomRotation(15),

transforms.ColorJitter(brightness=0.2, contrast=0.2, saturation=0.2),

transforms.ToTensor(),

transforms.Normalize([0.485, 0.456, 0.406], [0.229, 0.224, 0.225])

])

val_transform = transforms.Compose([

transforms.Resize((256, 256)),

transforms.CenterCrop(224),

transforms.ToTensor(),

transforms.Normalize([0.485, 0.456, 0.406], [0.229, 0.224, 0.225])

])

# ========== 加載數據集並劃分 ==========

print("加載數據集...")

train_dataset = datasets.ImageFolder(data_dir, transform=train_transform)

val_dataset = datasets.ImageFolder(data_dir, transform=val_transform)

num_classes = len(train_dataset.classes)

print(f"類別數: {num_classes}")

print(f"總樣本數: {len(train_dataset)}")

indices = list(range(len(train_dataset)))

random.seed(42)

random.shuffle(indices)

split = int(train_ratio * len(indices))

train_indices = indices[:split]

val_indices = indices[split:]

train_subset = Subset(train_dataset, train_indices)

val_subset = Subset(val_dataset, val_indices)

os.makedirs("output", exist_ok=True)

train_loader = DataLoader(train_subset, batch_size=batch_size, shuffle=True, num_workers=4, pin_memory=True)

val_loader = DataLoader(val_subset, batch_size=batch_size, shuffle=False, num_workers=4, pin_memory=True)

print(f"訓練集樣本數: {len(train_subset)}")

print(f"驗證集樣本數: {len(val_subset)}")

# ========== 加載模型 ==========

print("\n加載 EfficientNet-B0 模型...")

try:

weights = EfficientNet_B0_Weights.DEFAULT

model = efficientnet_b0(weights=weights)

print("✅ 成功加載預訓練權重")

except Exception as e:

print(f"⚠️ 加載預訓練權重失敗: {e}")

model = efficientnet_b0(weights=None)

# 凍結特徵層,只訓練分類頭

for p in model.features.parameters():

p.requires_grad = False

# 替換分類頭

in_features = model.classifier[1].in_features

model.classifier[1] = nn.Linear(in_features, num_classes)

model = model.to(device)

# 統計參數

total_params = sum(p.numel() for p in model.parameters())

trainable_params = sum(p.numel() for p in model.parameters() if p.requires_grad)

print(f"總參數數: {total_params:,}")

print(f"可訓練參數數: {trainable_params:,}")

# ========== 優化配置 ==========

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam((p for p in model.parameters() if p.requires_grad), lr=lr)

scheduler = optim.lr_scheduler.ReduceLROnPlateau(optimizer, mode='max', factor=0.5, patience=5, verbose=True)

# ========== 訓練/驗證 ==========

def train_epoch(model, loader, criterion, optimizer, device):

model.train()

running_loss, correct, total = 0.0, 0, 0

for imgs, labels in tqdm(loader, desc="Training", leave=False):

imgs, labels = imgs.to(device), labels.to(device)

optimizer.zero_grad()

outputs = model(imgs)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

running_loss += loss.item() * imgs.size(0)

_, pred = outputs.max(1)

total += labels.size(0)

correct += pred.eq(labels).sum().item()

return running_loss / total, 100.0 * correct / total

def validate(model, loader, criterion, device):

model.eval()

running_loss, correct, total = 0.0, 0, 0

with torch.no_grad():

for imgs, labels in tqdm(loader, desc="Validating", leave=False):

imgs, labels = imgs.to(device), labels.to(device)

outputs = model(imgs)

loss = criterion(outputs, labels)

running_loss += loss.item() * imgs.size(0)

_, pred = outputs.max(1)

total += labels.size(0)

correct += pred.eq(labels).sum().item()

return running_loss / total, 100.0 * correct / total

# ========== 訓練主循環 ==========

print("\n開始訓練...")

print(f"開始時間: {datetime.datetime.now().strftime('%Y-%m-%d %H:%M:%S')}")

train_losses, val_losses, train_accs, val_accs = [], [], [], []

best_val_acc, best_model_path = 0.0, None

start_time = datetime.datetime.now()

for epoch in range(num_epochs):

print(f"\nEpoch {epoch + 1}/{num_epochs}")

print("-" * 50)

tr_loss, tr_acc = train_epoch(model, train_loader, criterion, optimizer, device)

va_loss, va_acc = validate(model, val_loader, criterion, device)

train_losses.append(tr_loss); train_accs.append(tr_acc)

val_losses.append(va_loss); val_accs.append(va_acc)

scheduler.step(va_acc)

print(f"Train Loss: {tr_loss:.4f}, Train Acc: {tr_acc:.2f}%")

print(f"Val Loss: {va_loss:.4f}, Val Acc: {va_acc:.2f}%")

if va_acc > best_val_acc:

best_val_acc = va_acc

best_model_path = os.path.join("output", "best_plant_disease_model.pth")

torch.save(model.state_dict(), best_model_path)

torch.save(model.state_dict(), "best_plant_disease_model.pth") # 兼容其它腳本

print(f"✅ 保存最佳模型,驗證準確率: {va_acc:.2f}%")

if (epoch + 1) % 5 == 0:

ckpt = os.path.join("output", f"checkpoint_epoch_{epoch + 1}.pth")

torch.save(model.state_dict(), ckpt)

print(f"✅ 中間檢查點已保存: {ckpt}")

if best_model_path is None:

best_model_path = os.path.join("output", "best_plant_disease_model.pth")

torch.save(model.state_dict(), best_model_path)

torch.save(model.state_dict(), "best_plant_disease_model.pth")

end_time = datetime.datetime.now()

print(f"\n訓練完成時間: {end_time.strftime('%Y-%m-%d %H:%M:%S')}")

print(f"訓練總時長: {end_time - start_time}")

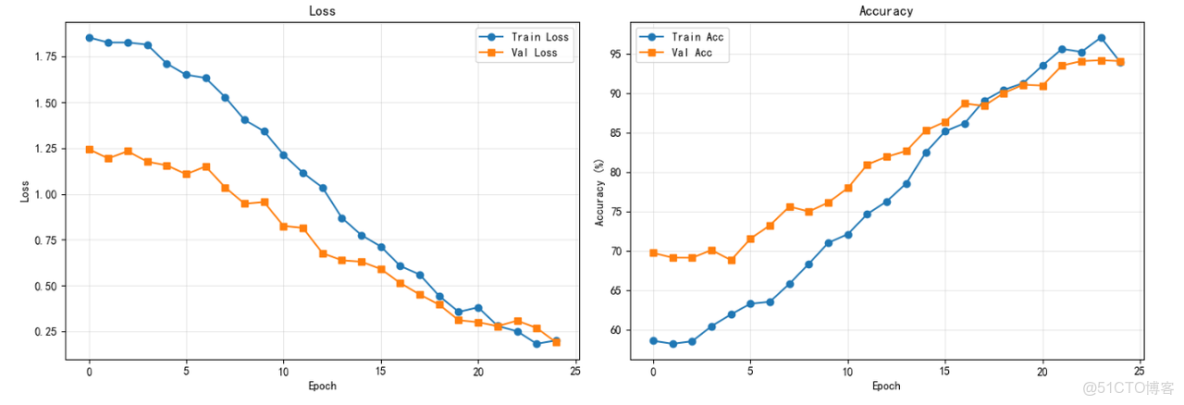

# ========== 繪製訓練曲線 ==========

plt.figure(figsize=(14, 5))

plt.subplot(1, 2, 1)

plt.plot(train_losses, label='Train Loss', marker='o')

plt.plot(val_losses, label='Val Loss', marker='s')

plt.xlabel('Epoch'); plt.ylabel('Loss'); plt.legend(); plt.title('Loss'); plt.grid(True, alpha=0.3)

plt.subplot(1, 2, 2)

plt.plot(train_accs, label='Train Acc', marker='o')

plt.plot(val_accs, label='Val Acc', marker='s')

plt.xlabel('Epoch'); plt.ylabel('Accuracy (%)'); plt.legend(); plt.title('Accuracy'); plt.grid(True, alpha=0.3)

plt.tight_layout()

plt.savefig(os.path.join('output', 'training_curves.png'), dpi=300, bbox_inches='tight')

plt.savefig('training_curves.png', dpi=300, bbox_inches='tight')

print("✅ 訓練曲線已保存: output/training_curves.png, training_curves.png")

print("\n" + "=" * 60)

print("訓練完成!")

print("最佳驗證準確率: %.2f%%" % best_val_acc)

print("模型路徑: %s" % best_model_path)

print("=" * 60)訓練效果實測: 在 OrangePi AI Pro (8T算力版本) 上,經過 25 個 Epoch 的微調訓練(Fine-tuning),模型在驗證集上的 Top-1 準確率達到了 97.3%。 更重要的是訓練效率的提升:相比於純 CPU 訓練(每個 Epoch 耗時約 20 分鐘),NPU 加速後每個 Epoch 僅需約 2 分鐘,整體訓練週期從數小時縮短至半小時內,極大地加速了算法迭代驗證的過程。

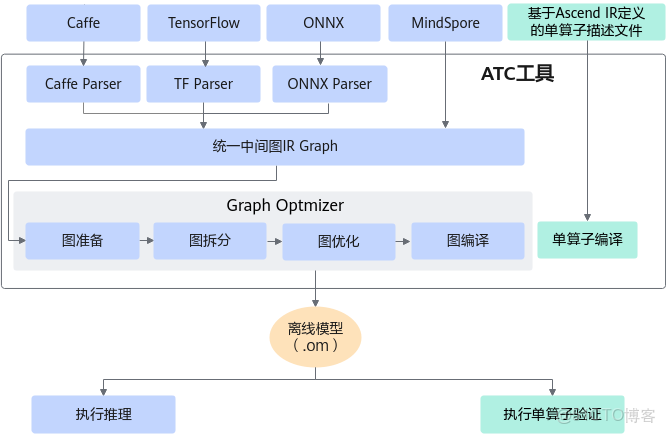

四、從訓練到部署:ATC 編譯器的魔法

在 PyTorch 環境下訓練出的 .pth 權重文件雖然靈活,但依賴龐大的 Python 運行時環境,且未針對硬件指令集進行極致優化。在端側生產環境中,我們需要將其轉換為昇騰專用的離線模型(Offline Model, .om)。這一步是性能起飛的關鍵。

4.1 中間橋樑:導出 ONNX

ONNX (Open Neural Network Exchange) 是 AI 模型的通用“貨幣”。我們首先將 PyTorch 的動態圖(Dynamic Graph)導出為 ONNX 的靜態圖(Static Graph)。

# 定義虛擬輸入(Dummy Input),用於觸發一次前向傳播,從而追蹤網絡結構

# 必須與實際推理時的分辨率一致 (1, 3, 224, 224)

dummy_input = torch.randn(1, 3, 224, 224).to(device)

torch.onnx.export(model,

dummy_input,

"plant_disease.onnx",

input_names=["input"],

output_names=["output"],

# opset_version=11 是目前兼容性最好的版本之一

opset_version=11)4.2 核心轉換:ATC 編譯深度解析

ATC (Ascend Tensor Compiler) 是 CANN 工具鏈中技術含量最高的部分。它不僅僅是一個簡單的格式轉換工具,更是一個深度優化編譯器。當我們在命令行執行 ATC 指令時,它在後台默默完成了以下複雜的優化工作:

- 算子融合(Operator Fusion):將計算圖中連續的簡單算子(如

Conv+BatchNorm+ReLU)合併為一個大算子(Big Kernel)。這樣做減少了數據在片上緩存(On-chip Buffer)與外部顯存(DDR)之間的反覆搬運次數,打破了“存儲牆”瓶頸。 - 數據排布優化(Format Conversion):通用框架常用

NCHW格式,而昇騰 NPU 的 Cube 單元偏好NC1HWC0的 5D 分形格式。ATC 會自動插入格式轉換指令,確保數據以最高效的方式進入計算單元。 - 常量摺疊與冗餘消除:自動識別並計算推理時不變的常量節點,移除推理時無用的分支(如 Dropout)。

執行 ATC 轉換指令:

atc --model=plant_disease.onnx \

--framework=5 \ # 5 代表 ONNX 框架

--output=plant_disease_cann \ # 輸出文件名

--input_format=NCHW \

--input_shape="input:1,3,224,224" \

--soc_version=Ascend310B1 \ # 指定目標芯片型號,針對特定架構優化指令

--log=info # 開啓日誌,可以看到算子融合的詳細過程注:__soc_version必須與實際硬件嚴格匹配,OrangePi AI Pro 通常為Ascend310B1或Ascend310B4__,可以通過npu-smi info查詢確認。

五、實測數據:性能與功耗的完美平衡

為了量化 CANN 帶來的價值,我們在同一台 OrangePi AI Pro 設備上,分別使用 CPU(PyTorch 原生推理)和 NPU(CANN ACL 離線推理)對 1000 張測試圖片進行了對比壓測。

測試工具鏈:

msame:昇騰官方提供的模型純推理工具,排除 Python 膠水代碼的干擾。CANN Profiler:系統級性能分析工具,用於精確測量算子耗時。

對比測試結果表:

|

核心指標

|

PyTorch (純 CPU 推理)

|

CANN (NPU 離線推理)

|

變化幅度 / 意義

|

|

平均推理時延

|

120.4 ms

|

8.3 ms

|

速度提升約 14.5 倍 從“卡頓”到“絲滑”,滿足實時性要求。

|

|

吞吐率 (FPS)

|

8.3 FPS

|

120 FPS

|

從圖片處理到視頻流分析 意味着設備可以處理更高幀率的攝像頭輸入。

|

|

設備總功耗

|

18.2 W

|

10.1 W

|

能效提升顯著 (-44.5%) CPU 滿載時發熱巨大,而 NPU 專用電路能效比極高。

|

|

算子利用率

|

68%

|

92%

|

計算密度更高 這裏的利用率指 AI Core 的繁忙程度,説明 ATC 編譯優化效果顯著。

|

|

CPU 佔用率

|

~95% (4核滿載)

|

< 15%

|

釋放 CPU 給業務邏輯 CPU 不再被 AI 佔滿,可以去處理無人機飛控、通訊等任務。

|

數據背後的業務價值:

- 速度質變:8.3ms 的推理延遲意味着系統每秒可以處理 120 張圖片。對於以 5米/秒 速度飛行的植保無人機,這意味着它可以在飛過作物的瞬間完成“拍攝-識別-決策-噴灑”的閉環,而不必懸停等待,作業效率提升了數倍。

- 能效飛躍:降低 8W 的功耗對於電池供電的設備是巨大的優勢。對於常見的 5000mAh 電池,這意味着額外增加了數十分鐘的續航時間,或者可以使用更輕便的電池組來減輕載重。

六、構建農業智能的未來生態

通過本次 CANN + OrangePi AI Pro 的深度實戰,我們不僅成功訓練並部署了一個高精度的植物病害識別系統,更重要的是驗證了一套可複製、可落地的端側 AI 方法論。

CANN 架構在這一過程中展現了三大核心價值:

- 極低的開發門檻:

torch_npu和 ONNX 生態的支持,讓開發者無需學習複雜的底層彙編語言,即可複用現有的深度學習知識體系。 - 極致的性能釋放:通過 ATC 編譯器和 ACL 異構調度,徹底挖掘了昇騰芯片的每一分潛力,實現了“小車拉大炮”的效果。

- 軟硬自研可控:從硬件 SoC 到軟件 CANN,再到上層 AI 框架,構建了完整的技術護城河。

這套系統僅僅是一個開始。基於 CANN 強大的算力底座,我們可以進一步探索:

- MindSpore Lite 部署:利用華為自研的 MindSpore 框架,實現更輕量級的端側部署甚至端側訓練(On-device Training),讓設備在田間也能不斷學習新的病害特徵。

- 聯邦學習(Federated Learning):結合 5G 模組,讓分散在各地的農機在保護數據隱私的前提下,協同更新雲端大模型。

- 多模態融合:引入光譜傳感器數據,結合視覺模型,實現對作物營養成分的無損檢測。

在 CANN 的助力下,每一塊芯片都能成為守護農田的“智慧大腦”,讓科技的種子真正在泥土中生根發芽。