本文作者:黃浴 | 以前提到過此文(在想法中),WACV‘2021錄取:“CenterFusion: Center-based Radar and Camera Fusion for 3D Object Detection“

https://arxiv.org/abs/2011.04841

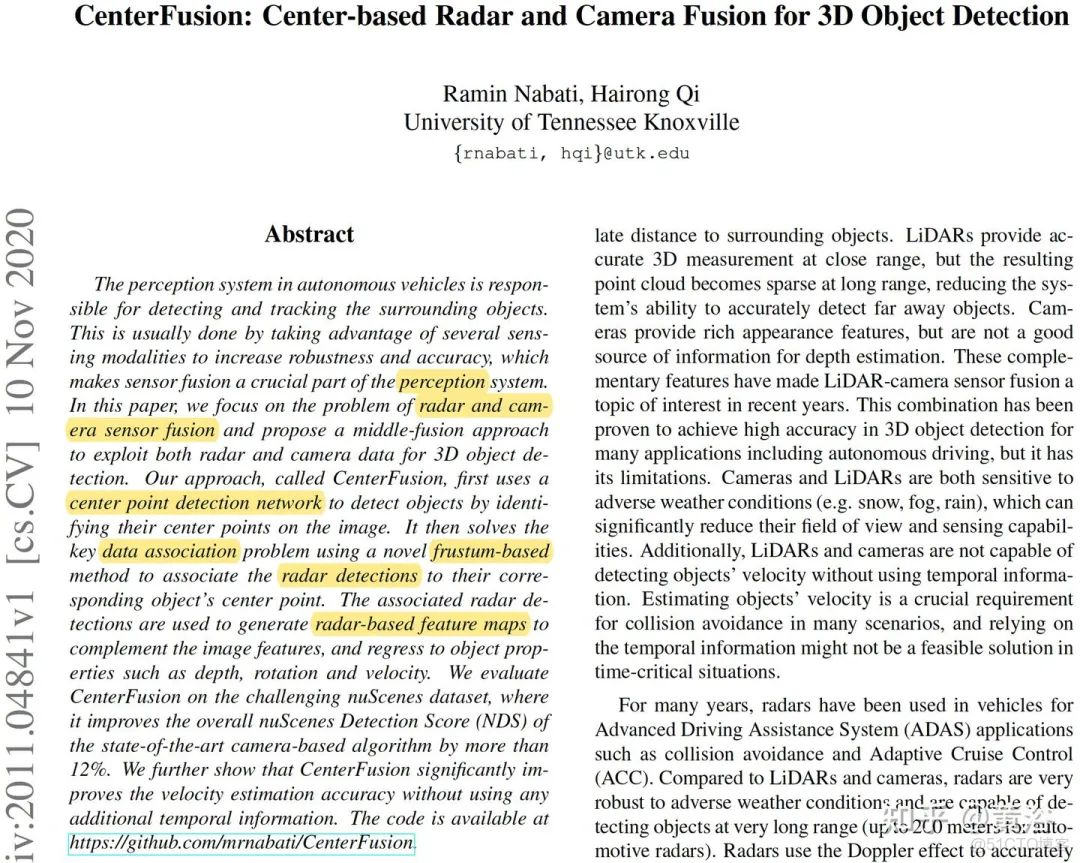

摘要:這是一個middle fusion方法,CenterFusion,它先通過一個center point檢測法得到圖像的目標,然後和雷達檢測結果做數據相關,採用的是一個frustum-based方法。最後關聯的目標檢測產生基於雷達的特徵圖補充圖像特徵,這樣迴歸目標的深度、旋轉角和深度。

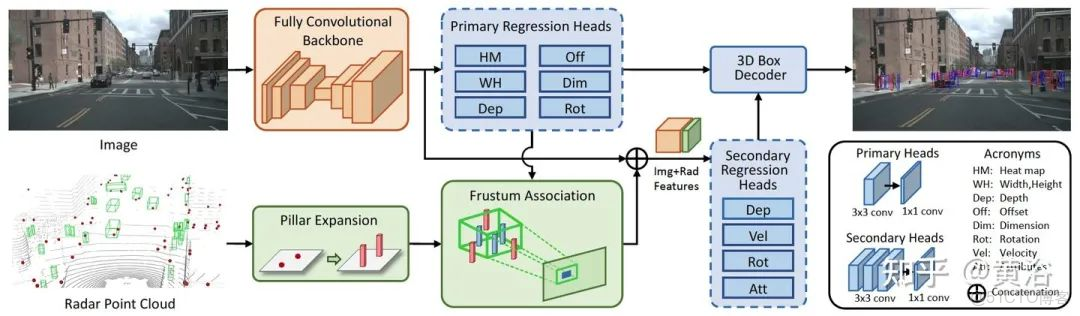

網絡架構如圖所示:跟摘要説的那樣,細節見下面模塊分析。

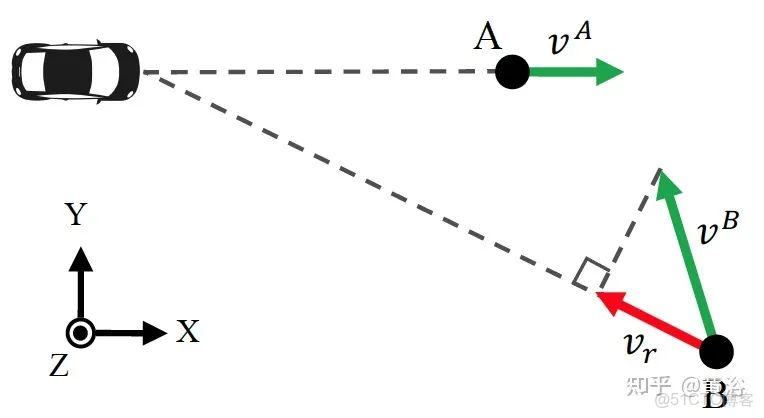

首先,需要搞清楚雷達信號檢測的是徑向深度和目標實際速度的不同,如圖:

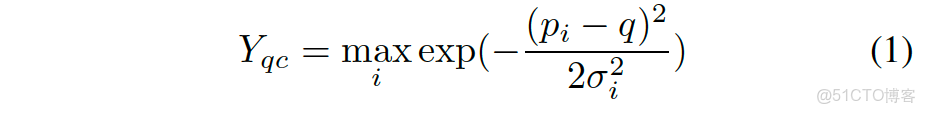

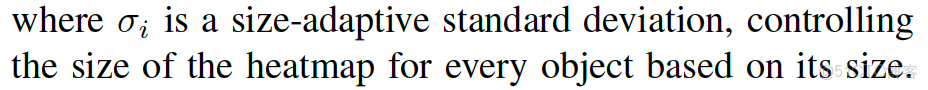

作者採用CenterNet方法,無錨單目的目標檢測方法。其中keypoint的heatmap定義為:

採用一個卷積encoder-decoder網絡預測Y。基於此,迴歸3D目標的深度、尺寸和朝向。其訓練分類損失,即focal loss:

CenterFusion利用CenterNet先得到一個初步檢測,然後修正的DLA(deep layer aggregation)網絡作為主幹,在primary regression head中預測初步的3D目標信息,其中構成包括一個3X3的卷積層和一個1X1的卷積層。

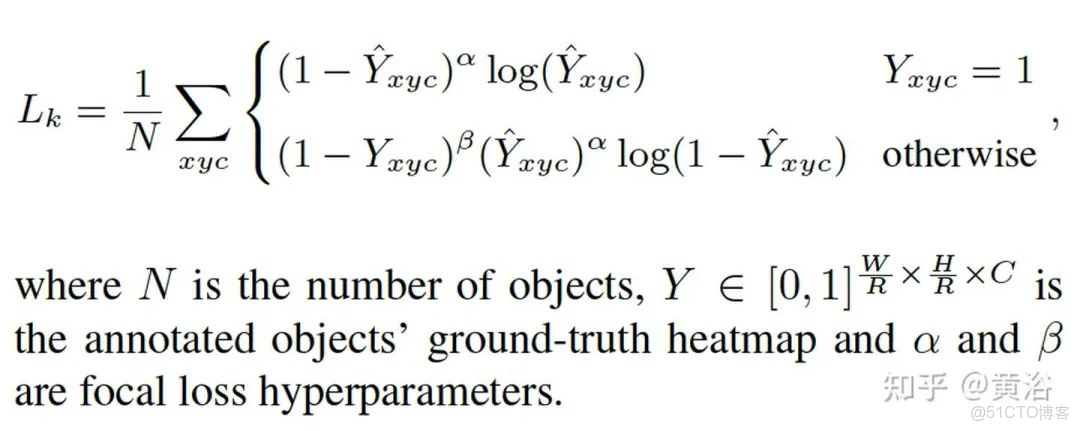

Frustum association是關鍵融合雷達和圖像的機制。用圖像2D框和其深度+大小的估計構建一個3D RoI frustum,如圖所示:

如果有多個雷達檢測點在這個RoI,直接取距離最近的一個。注意這裏提到一個scaling factor可增大frustum尺寸,以便包容深度估計的誤差。

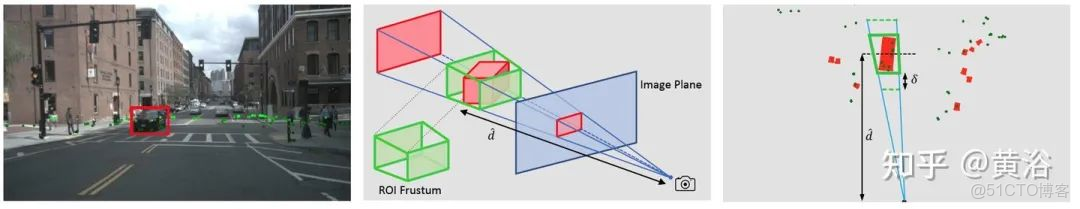

另外,目標高度的不準確,作者採用Pillar expansion對雷達點雲做預處理。如圖所示:第一行是雷達點雲擴大成3D pillar的顯示,第二行是直接把pillars和圖像匹配的結果,相關較弱。第三行是frustum相關,減少了上面的深度值重疊,也防止背景目標(如大樓)錯分類成前景。

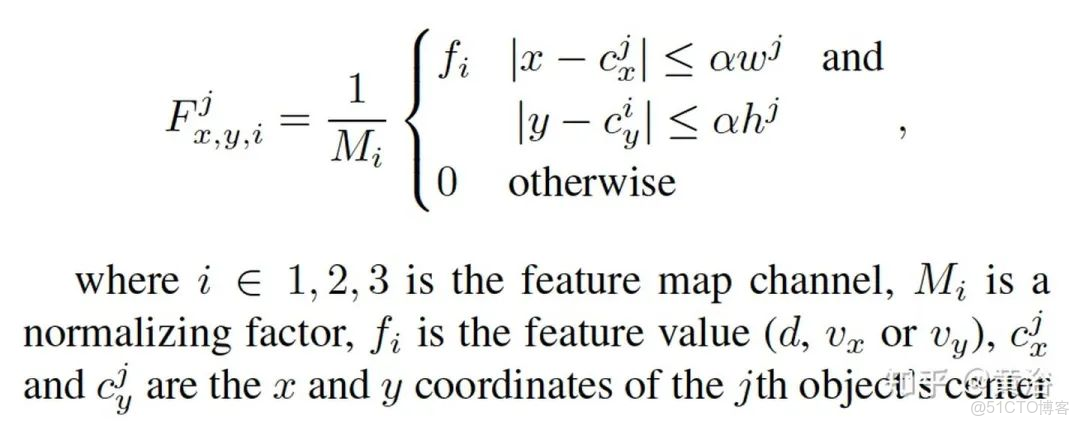

圖像和雷達的數據相關之後,可以提取雷達目標特徵,深度和速度等。

如果兩個目標有重疊的heatmap區域,按距離取最近的。

之後,這些特徵進入secondary regression head,其結構包括3個3X3卷積層和一個1X1卷積層。最後結果需要經過一個box decoder得到。

訓練中regression head的損失採用SmoothL1 loss,center point heatmap採用focal loss,而attributes regression head基於Binary Cross Entropy (BCE) loss。

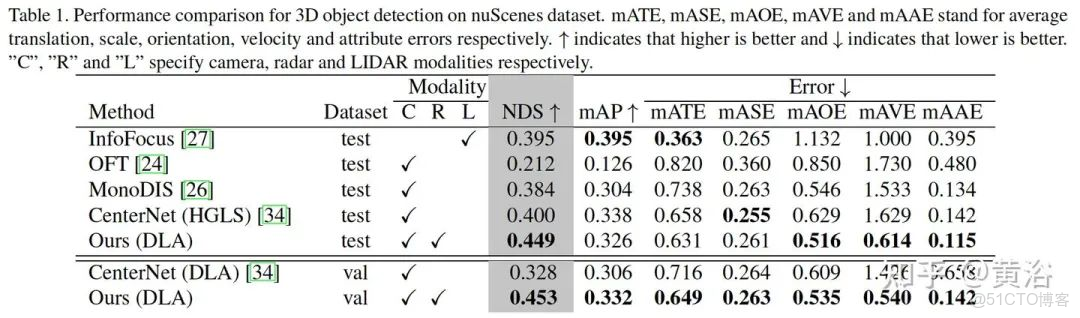

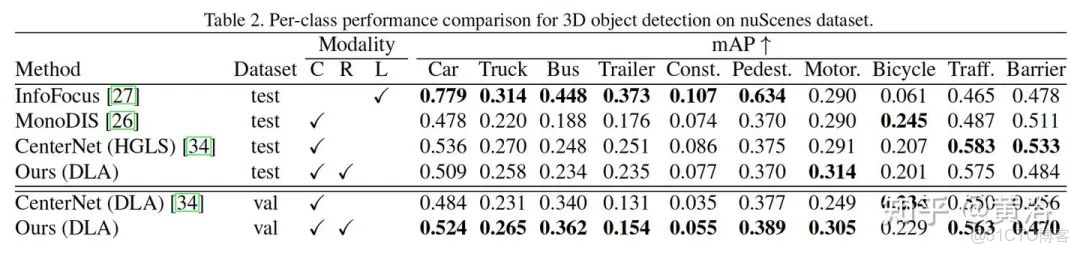

看一下結果:

性能比較表

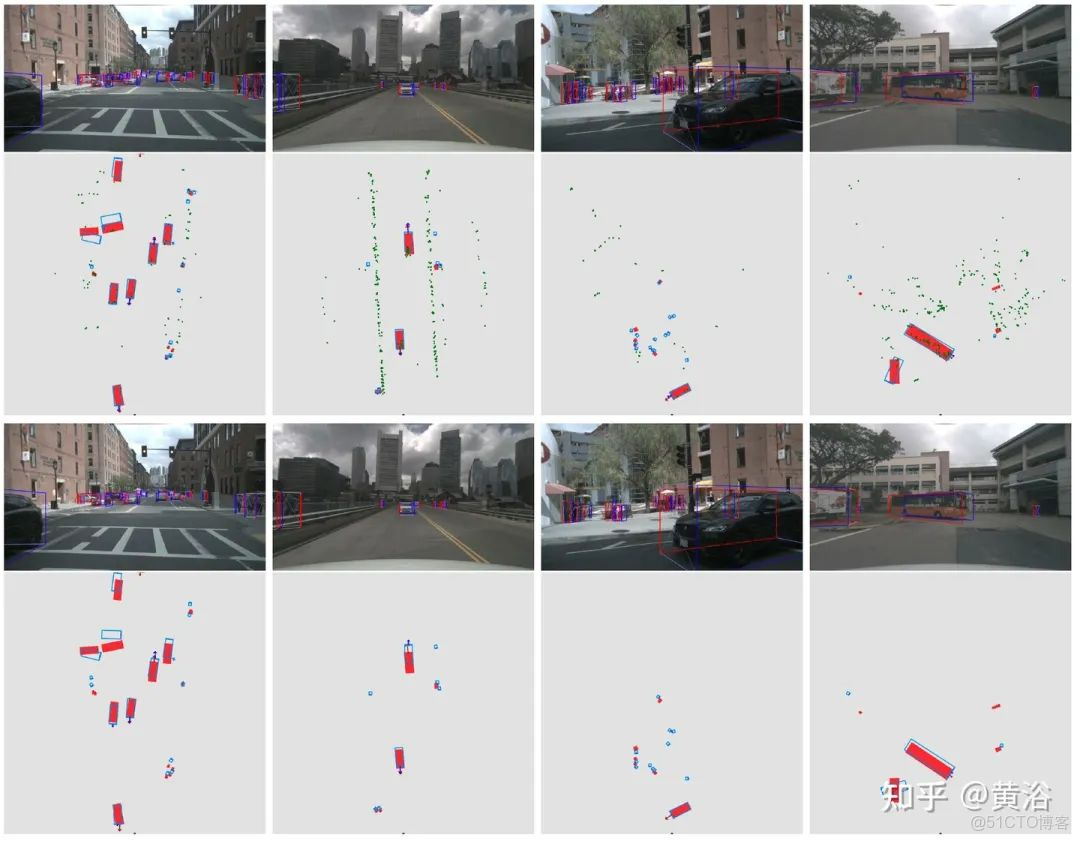

直觀結果比較如下:1-2行CenterFusion,3-4行CenterNet。

雷達點雲綠色,目標框GT紅色,目標預測速度藍色箭頭。