車牌識別的相關步驟

1.車牌檢測:第一步是從汽車上檢測車牌所在位置。我們將使用OpenCV中矩形的輪廓檢測來尋找車牌。如果我們知道車牌的確切尺寸,顏色和大致位置,則可以提高準確性。通常,也會將根據攝像機的位置和該特定國家/地區所使用的車牌類型來訓練檢測算法。但是圖像可能並沒有汽車的存在,在這種情況下我們將先進行汽車的,然後是車牌。

2.字符分割:檢測到車牌後,我們必須將其裁剪並保存為新圖像。同樣,這可以使用OpenCV來完成。

3. 字符識別:現在,我們在上一步中獲得的新圖像肯定可以寫上一些字符(數字/字母)。因此,我們可以對其執行OCR(光學字符識別)以檢測數字。

1.車牌檢測

讓我們以汽車的樣本圖像為例,首先檢測該汽車上的車牌。然後,我們還將使用相同的圖像進行字符分割和字符識別。如果您想直接進入代碼而無需解釋,則可以向下滾動至此頁面的底部,提供完整的代碼,或訪問以下鏈接。https://github.com/GeekyPRAVEE/OpenCV-Projects/blob/master/LicensePlateRecoginition.ipynb

在次使用的測試圖像如下所示。

圖片來源鏈接:https : //rb.gy/lxmiuv

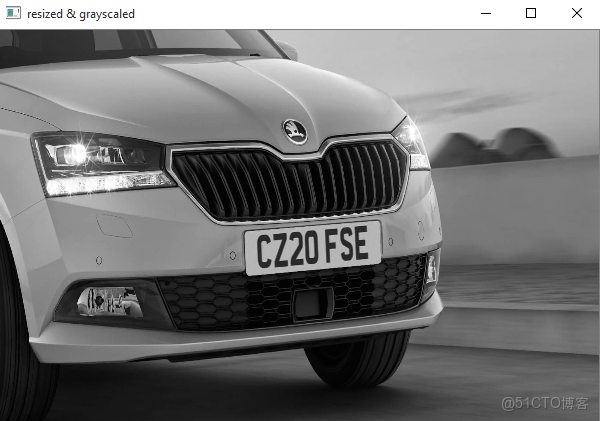

第1步: 將圖像調整為所需大小,然後將其灰度。相同的代碼如下

img = cv2.resize(img, (620,480) )

gray = cv2.cvtColor(img, cv2.COLOR_BGR2GRAY) #convert to grey scale調整大小後,可以避免使用較大分辨率的圖像而出現的以下問題,但是我們要確保在調整大小後,車號牌仍保留在框架中。在處理圖像時如果不再需要處理顏色細節,那麼灰度變化就必不可少,這加快了其他後續處理的速度。完成此步驟後,圖像將像這樣被轉換

步驟2:每張圖片都會包含有用和無用的信息,在這種情況下,對於我們來説,只有牌照是有用的信息,其餘的對於我們的程序幾乎是無用的。這種無用的信息稱為噪聲。通常,使用雙邊濾波(模糊)會從圖像中刪除不需要的細節。

gray = cv2.bilateralFilter(gray, 13, 15, 15)語法為 destination_image = cv2.bilateralFilter(source_image, diameter of pixel, sigmaColor, sigmaSpace)。我們也可以將sigma顏色和sigma空間從15增加到更高的值,以模糊掉更多的背景信息,但請注意不要使有用的部分模糊。輸出圖像如下所示可以看到該圖像中的背景細節(樹木和建築物)模糊了。這樣,我們可以避免程序處理這些區域。

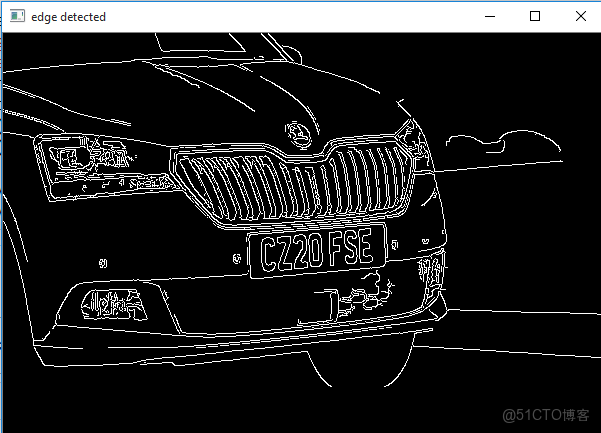

步驟3:下一步是我們執行邊緣檢測的有趣步驟。有很多方法可以做到,最簡單和流行的方法是使用OpenCV中的canny edge方法。執行相同操作的行如下所示

edged = cv2.Canny(gray, 30, 200) #Perform Edge detection語法為destination_image = cv2.Canny(source_image,thresholdValue 1,thresholdValue 2)。閾值谷1和閾值2是最小和最大閾值。僅顯示強度梯度大於最小閾值且小於最大閾值的邊緣。結果圖像如下所示

步驟4:現在我們可以開始在圖像上尋找輪廓

cnotallow=cv2.findContours(edged.copy(),cv2.RETR_TREE,

cv2.CHAIN_APPROX_SIMPLE)

contours = imutils.grab_contours(contours)

contours = sorted(contours,key=cv2.contourArea, reverse = True)[:10]

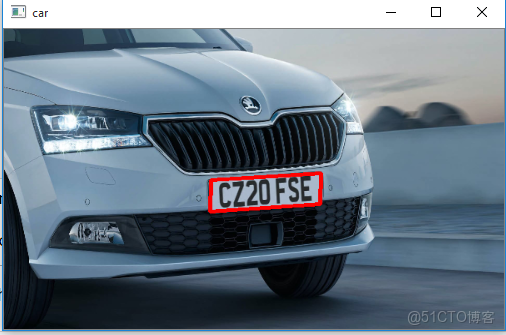

screenCnt = None一旦檢測到計數器,我們就將它們從大到小進行排序,並只考慮前10個結果而忽略其他結果。在我們的圖像中,計數器可以是具有閉合表面的任何事物,但是在所有獲得的結果中,牌照號碼也將存在,因為它也是閉合表面。

為了過濾獲得的結果中的車牌圖像,我們將遍歷所有結果,並檢查其具有四個側面和閉合圖形的矩形輪廓。由於車牌肯定是四邊形的矩形。

for c in cnts:

# approximate the contour

peri = cv2.arcLength(c, True)

approx = cv2.approxPolyDP(c, 0.018 * peri, True)

# if our approximated contour has four points, then

# we can assume that we have found our screen

if len(approx) == 4:

screenCnt = approx

break找到正確的計數器後,我們將其保存在名為screenCnt的變量中,然後在其周圍繪製一個矩形框,以確保我們已正確檢測到車牌。

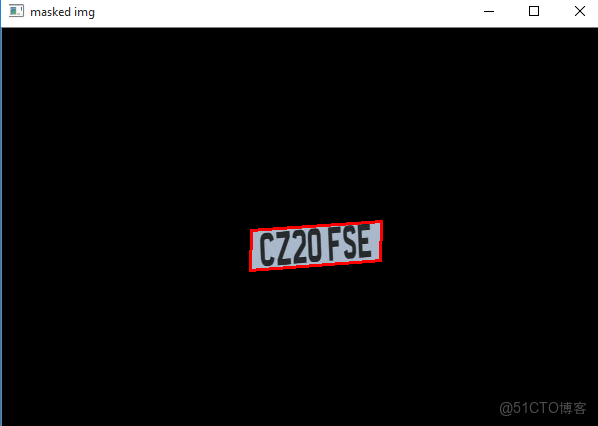

步驟5:現在我們知道車牌在哪裏,剩下的信息對我們來説幾乎沒有用。因此,我們可以對整個圖片進行遮罩,除了車牌所在的地方。相同的代碼如下所示

# Masking the part other than the number plate

mask = np.zeros(gray.shape,np.uint8)

new_image = cv2.drawContours(mask,[screenCnt],0,255,-1,)

new_image = cv2.bitwise_and(img,img,mask=mask)被遮罩的新圖像將如下所示

2.字符分割

車牌識別的下一步是通過裁剪車牌並將其保存為新圖像,將車牌從圖像中分割出來。然後,我們可以使用此圖像來檢測其中的字符。下面顯示了從主圖像裁剪出ROI(感興趣區域)圖像的代碼

# Now crop

(x, y) = np.where(mask == 255)

(topx, topy) = (np.min(x), np.min(y))

(bottomx, bottomy) = (np.max(x), np.max(y))

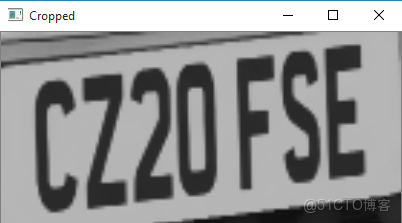

Cropped = gray[topx:bottomx+1, topy:bottomy+1]結果圖像如下所示。通常添加到裁剪圖像中,如果需要,我們還可以對其進行灰色處理和邊緣化。這樣做是為了改善下一步的字符識別。但是我發現即使使用原始圖像也可以正常工作。

3.字符識別

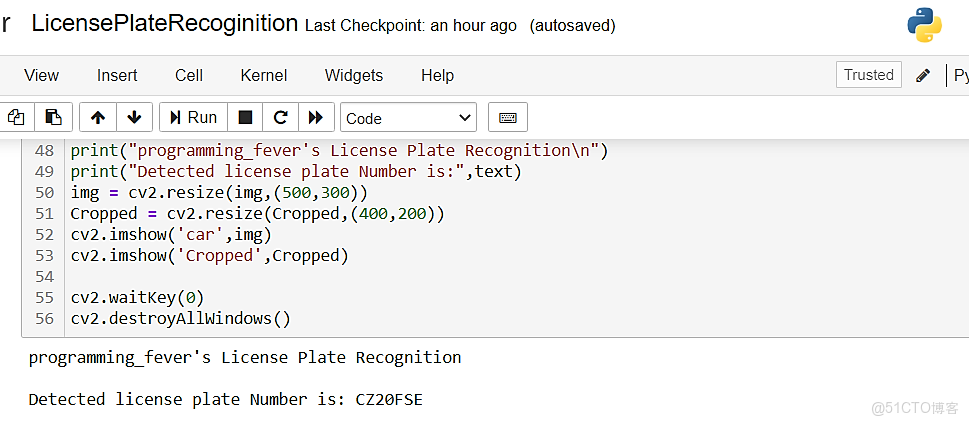

該車牌識別的最後一步是從分割的圖像中實際讀取車牌信息。就像前面的教程一樣,我們將使用pytesseract包從圖像讀取字符。相同的代碼如下

#Read the number plate

text = pytesseract.image_to_string(Cropped, cnotallow='--psm 11')

print("Detected license plate Number is:",text)原始圖像上印有數字“ CZ20FSE”,並且我們的程序檢測到它在jupyter筆記本上打印了相同的值。

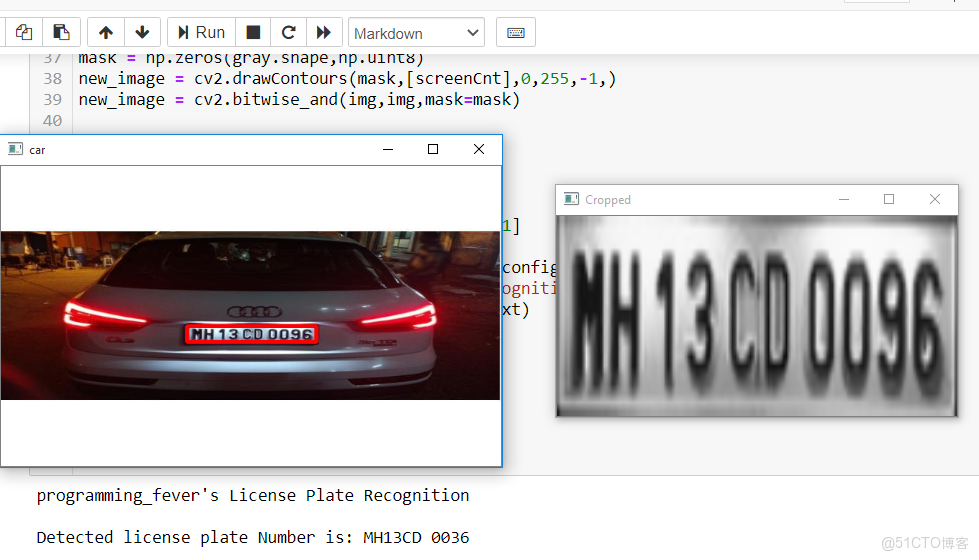

車牌識別失敗案例

車牌識別的完整代碼,其中包含程序和我們用來檢查程序的測試圖像。要記住,此方法的結果將不準確。準確度取決於圖像的清晰度,方向,曝光等。為了獲得更好的結果,您可以嘗試同時實現機器學習算法。

這個案例中我們的程序能夠正確檢測車牌並進行裁剪。但是,Tesseract庫無法正確識別字符。OCR已將其識別為“ MH13CD 0036”,而不是實際的“ MH 13 CD 0096”。通過使用更好的方向圖像或配置Tesseract引擎,可以糾正此類問題。

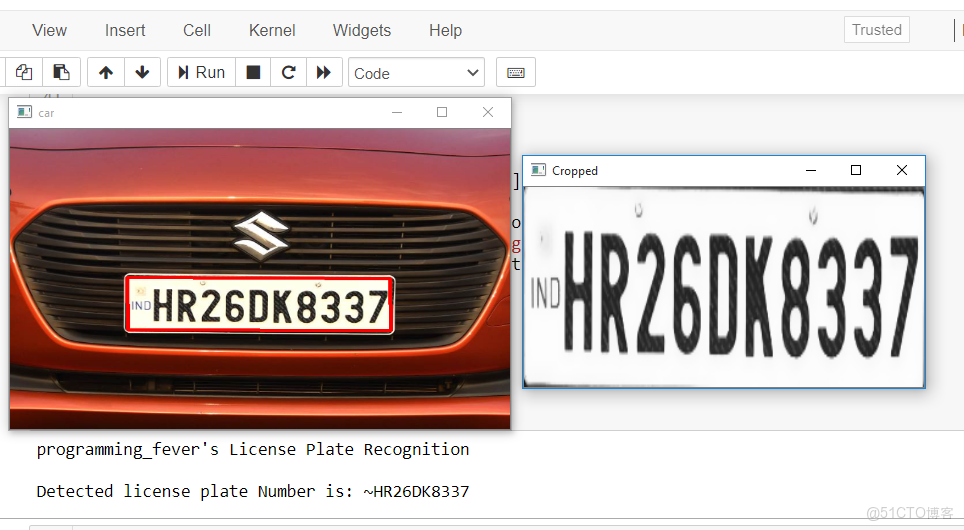

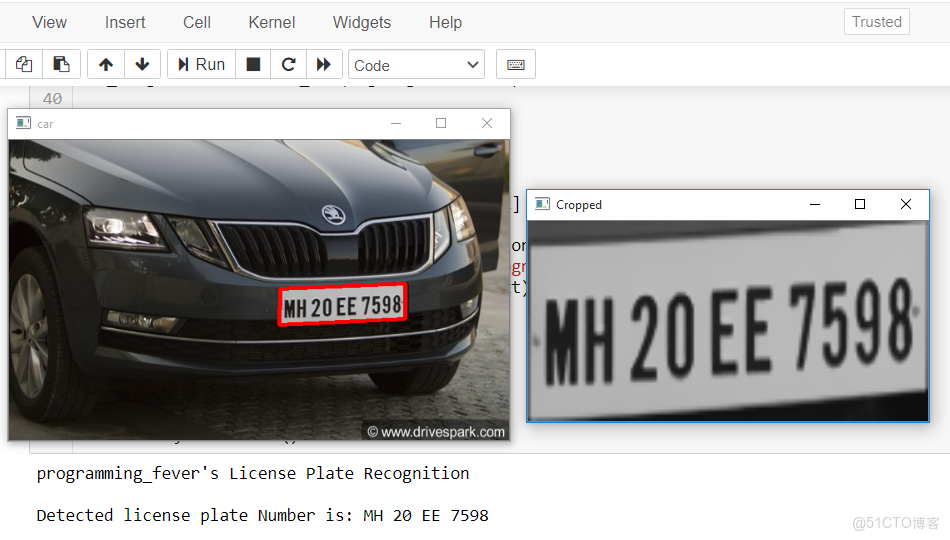

其他成功的例子

大多數時候,圖像質量和方向都是正確的,程序能夠識別車牌並從中讀取編號。下面的快照顯示了獲得的成功結果。

完整代碼

#@programming_fever

import cv2

import imutils

import numpy as np

import pytesseract

pytesseract.pytesseract.tesseract_cmd = r'C:\Program Files (x86)\Tesseract-OCR\tesseract.exe'

img = cv2.imread('D://skoda1.jpg',cv2.IMREAD_COLOR)

img = cv2.resize(img, (600,400) )

gray = cv2.cvtColor(img, cv2.COLOR_BGR2GRAY)

gray = cv2.bilateralFilter(gray, 13, 15, 15)

edged = cv2.Canny(gray, 30, 200)

contours = cv2.findContours(edged.copy(), cv2.RETR_TREE, cv2.CHAIN_APPROX_SIMPLE)

contours = imutils.grab_contours(contours)

contours = sorted(contours, key = cv2.contourArea, reverse = True)[:10]

screenCnt = None

for c in contours:

peri = cv2.arcLength(c, True)

approx = cv2.approxPolyDP(c, 0.018 * peri, True)

if len(approx) == 4:

screenCnt = approx

break

if screenCnt is None:

detected = 0

print ("No contour detected")

else:

detected = 1

if detected == 1:

cv2.drawContours(img, [screenCnt], -1, (0, 0, 255), 3)

mask = np.zeros(gray.shape,np.uint8)

new_image = cv2.drawContours(mask,[screenCnt],0,255,-1,)

new_image = cv2.bitwise_and(img,img,mask=mask)

(x, y) = np.where(mask == 255)

(topx, topy) = (np.min(x), np.min(y))

(bottomx, bottomy) = (np.max(x), np.max(y))

Cropped = gray[topx:bottomx+1, topy:bottomy+1]

text = pytesseract.image_to_string(Cropped, cnotallow='--psm 11')

print("programming_fever's License Plate Recognition\n")

print("Detected license plate Number is:",text)

img = cv2.resize(img,(500,300))

Cropped = cv2.resize(Cropped,(400,200))

cv2.imshow('car',img)

cv2.imshow('Cropped',Cropped)

cv2.waitKey(0)

cv2.destroyAllWindows()