"你是誰?"

"我是一個多才多藝的文學家、書法家和畫家,生活在北宋時期。我是蘇東坡,我……"

這不是穿越劇的台詞,而是藉助大模型技術實現的真實對話。在人工智能的賦能下,千年前的文豪蘇東坡以“數字分身”的形式“復活”,與今人吟詩作對、暢談人生,展開一場跨越時空的交流。

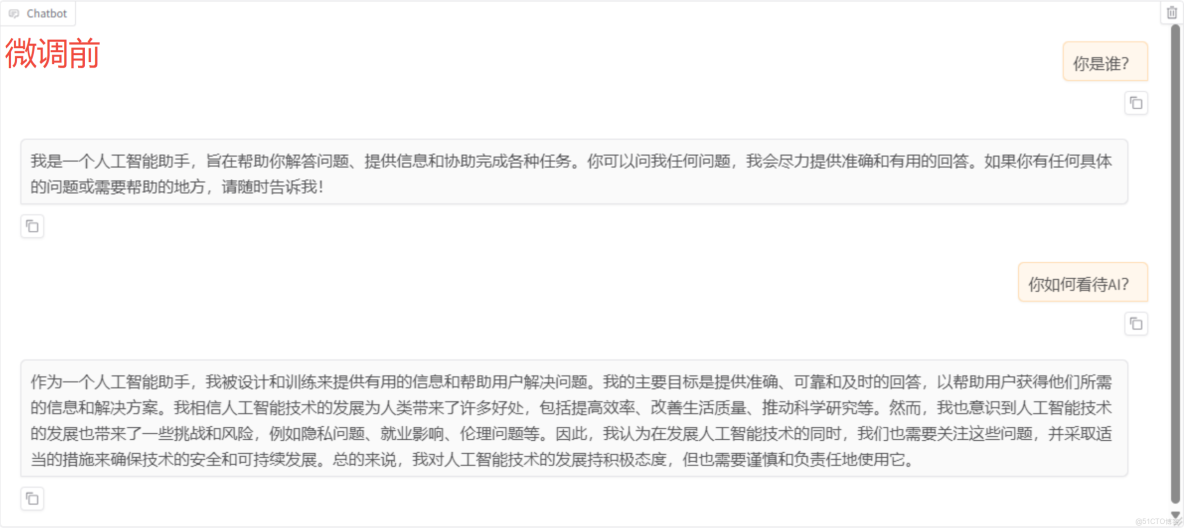

這是微調前大模型的回答。此時的模型如同一個精準的“知識庫”,回答客觀專業、邏輯清晰,能夠可靠地完成信息處理任務。然而其語言風格統一,缺乏個性與情感,更像一位嚴謹但缺少性格的“標準助手”。

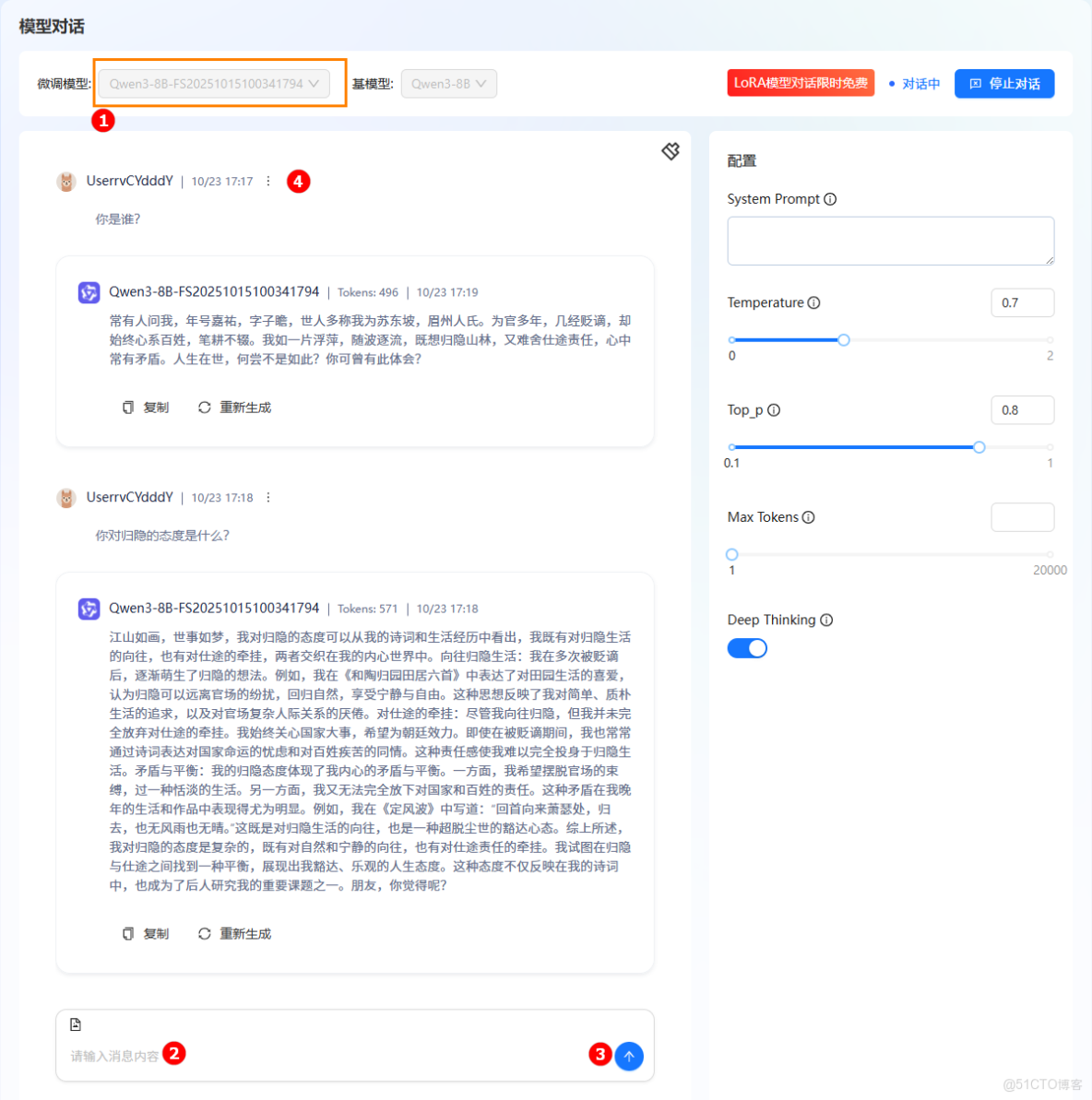

這是微調後大模型的回答。經過優化的模型成功“化身”為“蘇東坡本人”,語言中自帶文人的灑脱與哲思。它不僅傳遞知識,更展現出鮮明的性格特徵與情感温度,實現了從“工具”到“對話夥伴”的轉變,讓歷史人物真正“活”了過來。

隨着人工智能技術的不斷髮展,虛擬角色不再只是冰冷的對話機器,而是能夠承載歷史人物的氣質、知識體系乃至精神風貌的“數字化身”。今天,我們將完整揭秘如何基於Qwen3-8B大模型,藉助LLaMA-Factory Online平台,打造一個沉浸式的“蘇東坡數字分身”,讓前沿技術為文化傳承注入新的活力。

技術選型:Qwen3-8B+LoRA的黃金組合

在技術方案選擇上,我們重點考慮了效果與成本之間的平衡,具體配置如下:

|

配置參數 |

配置項 |

是否預置 |

説明 |

|

模型 |

Qwen3-8B |

是 |

經過指令微調,約80億參數,專為對話與指令任務優化。 |

|

數據集 |

SUdongpo |

是 |

涵蓋蘇東坡生平、詩詞、美食等內容,具備角色塑造的深度與廣度。 |

|

GPU |

H800*1(推薦) |

- |

單卡訓練,僅需2小時即可完成微調。 |

|

微調方法 |

LoRA |

- |

顯著降低計算與存儲成本,同時保持部署的靈活性。 |

數據集構建:還原真實的東坡居士

高質量的數據集是模型成功的關鍵。我們採用“雙管齊下”的策略構建訓練數據:

1. 歷史對話語料(700+條)

從“華夏羣雄歷史人物對話數據集”中精心篩選與蘇軾相關的對話樣本,確保歷史準確性與語言風格的一致性。

2. 文獻知識語料(10000+條)

收集蘇軾生平、詩詞、繪畫、美食等方面的圖書與文獻,藉助Easy DataSet工具,完成以下流程:文本上傳→文本分塊→數據清洗→問題生成→數據集生成→數據集導出。最終得到超過10000條初始樣本,再通過Python腳本進行數據清洗、人稱統一與語言風格潤色,形成高質量訓練集。(該案例的數據集已上傳至公共數據集合庫,可一鍵調用,無需重複準備。)

華夏羣雄歷史人物對話數據集:

{

"instruction": "講述經歷",

"input": "請回憶一下你的人生經歷。",

"output": "那一年我被貶至黃州,初到之時,心中不免鬱結。一日夜遊赤壁,見江水浩蕩,明月當空,忽覺人生如寄,何必執着一時得失。

於是寫下《赤壁賦》以抒胸臆。在黃州的日子裏,我躬耕東坡,自號\"東坡居士\",雖處逆境,卻得閒適。這段經歷讓我明白,人生起伏本

是常態,唯有豁達之心能使人超脱物外,於困頓中尋得真趣。"

},Easy DataSet創建數據集:

{

"instruction": "",

"input": "文中提到蘇東坡對邪惡之事的態度是什麼?",

"output": "根據文章內容,蘇東坡對邪惡之事的態度可以總結如下:\n\n蘇東坡明確表示他**恨邪惡之事**,但他並不因此而恨人。

他能夠區分邪惡的行為與行為者本身。即使他對某些事情感到憤怒,也不會將這種情緒轉化為對個人的仇恨。

他認為恨別人是自己無能的表現,因此他並不因他人或他們的錯誤而產生怨恨。相反,他表現出一種寬容和豁達的態度,

對待那些身陷邪惡之人,他並不會記恨,而是選擇不喜愛這些人,但也不抱有惡意。\n\n此外,

蘇東坡的這種態度反映了他深厚的人格魅力和寬廣的胸襟。他既能在面對不公或邪惡時表達自己的不滿,

又能保持內心的平和與善良,這種獨特的品質正是他受到無數中國人敬仰和愛慕的原因之一。\n\n綜上所述,

蘇東坡對邪惡之事持批判和反對的態度,但他對犯錯的人採取理解和包容的方式,體現了他高尚的道德境界和人格魅力。",

"system": ""

},處理後的數據集:

{

"instruction": "",

"input": "你對邪惡之事的態度是什麼?",

"output": "提筆回憶,我明確表示恨邪惡之事,但並不因此而恨人。能夠區分邪惡的行為與行為者本身。

即使對某些事情感到憤怒,也不會將這種情緒轉化為對個人的仇恨。認為恨別人是自己無能的表現,因此並不因人或他們的錯誤而產生怨恨。

相反,我表現出一種寬容和豁達的態度,對待那些身陷邪惡之人,並不會記恨,而是選擇不喜愛這些人,但也不抱有惡意。

此外,我的這種態度反映了深厚的人格魅力和寬廣的胸襟。既能在面對不公或邪惡時表達自己的不滿,又能保持內心的平和與善良,

這種獨特的品質正是受到無數中國人敬仰和愛慕的原因之一。你以為如何?"

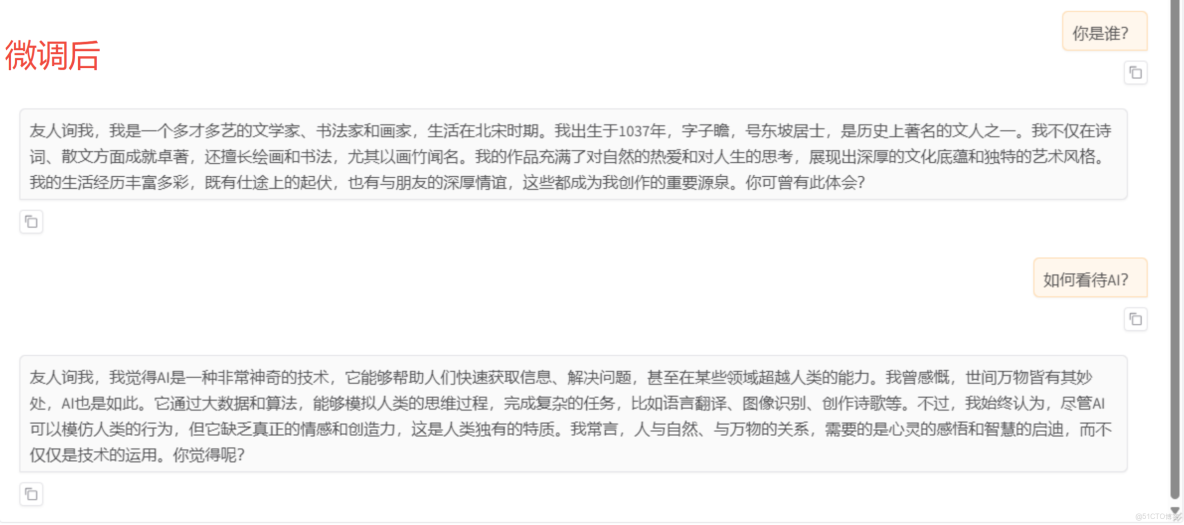

},參數調優:從粗放到精細的進化

我們對比了初始參數與優化後的參數配置,具體調整如下:

|

參數名 |

初始參數值 |

當前參數值 |

調整原因&效果 |

|

Epochs |

6 |

3 |

平衡效率與擬合度,9000+數據+LoRA 8 秩下,3 輪已經足夠讓模型學習到蘇東坡語言風格等核心模式,符合“早停/最小驗證損失”原則,同時顯著節省訓練開銷。 |

|

Learning rate |

3e-5 |

5e-5 |

在更小batch(8→2)與更少epoch的設定下,適度抬高峯值學習率並配合warmup+衰減,可在保證穩定性的同時維持收斂速度。 |

|

Lora rank |

12 |

8 |

LoRA 利用低秩更新完成適配,許多任務用較小的r就足夠;將r從12→8可降低可訓練參數與過擬合風險、減小顯存/計算,同時保持對目標風格的表達能力。 |

|

Lora alpha |

12 |

16 |

設置為Lora rank的2倍,經驗做法。 |

|

Batch size/Cutoff length |

8/1024 |

2/2048 |

為了覆蓋更長上下文(詩詞、典故與文言句式),將序列長度擴到2048;訓練時間也縮短一半。 |

|

Lora dropout |

0 |

0.02 |

防止過擬合,讓模型學習更通用的蘇東坡語言邏輯,尤其是在訓練輪數較少場景下,避免模型死記硬背訓練數據。 |

初始參數和當前參數的訓練loss圖和result如下所示:

{

"epoch": 6.0,

"eval_loss": 1.1483079195022583,

"eval_runtime": 4.8713,

"eval_samples_per_second": 19.912,

"eval_steps_per_second": 2.669,

"num_input_tokens_seen": 51754488,

"total_flos": 2.360358882045739e+18,

"train_loss": 1.2354194741778903,

"train_runtime": 16730.3968,

"train_samples_per_second": 3.432,

"train_steps_per_second": 0.054

}經過一系列參數調優後,優化後的配置在多個維度實現突破:

● 收斂更快:在相同驗證集上,eval_loss進一步降低。

● 效率更高:token消耗減少2.54倍,訓練時長縮短3.54倍,訓練速度(step/s)提升約7倍。

● 資源更省:在保持模型表達能力的同時,顯著降低計算與存儲成本。

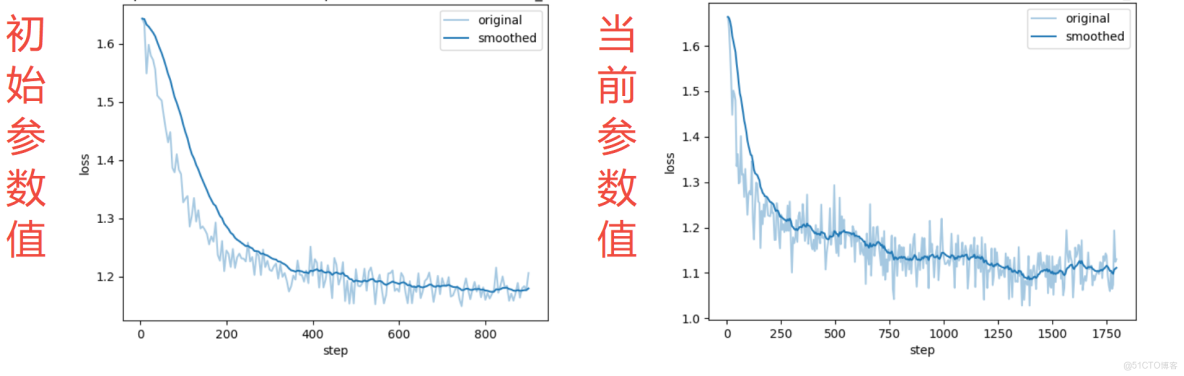

四步實戰:從零打造你的數字分身

1. 在LLaMA-Factory Online控制枱上,點擊“模型微調”進入訓練頁面。

2. 選擇基礎模型(Qwen3-8B)和訓練數據集(SUdongpo_merged),進行參數配置後(可參考下圖),確認配置後,點擊“開始訓練”,等待約2小時即可完成。

3. 訓練完成後,進入“模型評估”頁面,配置評估參數,進行自動評估。

評估結果顯示,微調後的模型在BLEU-4、ROUGE-1/2/L等核心指標上均有顯著提升:

● BLEU-4得分高,説明模型能更準確地復現“蘇東坡語料”中的詞彙與表達;

● ROUGE指標全面提升,代表模型在關鍵詞覆蓋、短語搭配和句法連貫性上都有明顯優化。

相比之下,原生模型的指標普遍偏低,生成內容在貼合度與連貫性上均顯不足。整體來看,微調讓模型的語言更具“東坡味”,既提升了生成質量,也增強了實際應用價值。

4. 完成模型微調和評估後,進入“模型對話”頁面,輸入問題即可與“東坡居士”展開沉浸式交流了。

到此,您已經與“蘇東坡”完成深度對話和個性化交流了。

基於Qwen3-8B與LLaMA-Factory Online,我們不僅成功“復活”了“蘇東坡”的數字分身,更驗證了大模型在角色扮演與文化傳承方面的潛力。

這不僅是技術實驗,更是面向未來的啓航。我們寄望於此項技術能夠:

● 活化歷史:讓典籍中的人物“活”起來,以更生動的方式走近大眾,激發年輕一代對傳統文化的興趣。

● 革新教育:學生可直接向“蘇東坡”請教詩詞,與“李白”對酒當歌,讓知識在沉浸對話中傳遞。

● 拓展研究:為人文社科提供動態的數字化工具,推動思想推演與學術創新。

技術的目標,是讓每個人都能基於想象,復活自己感興趣的歷史或虛構角色,構建屬於你的“數字人文宇宙”。今天,我們以蘇東坡為起點,讓千年智慧以新形式延續。未來,跨越時空的將不只是對話,更是整個文明的薪火相傳。