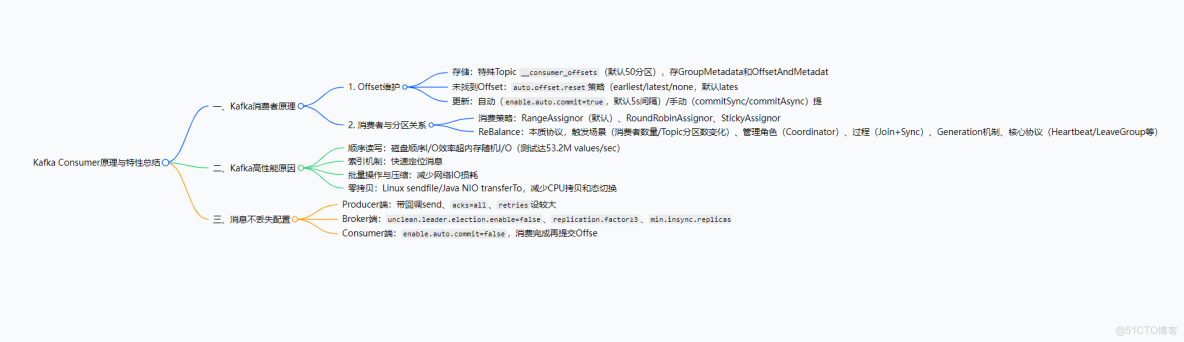

1. 一段話總結

本文圍繞Kafka Consumer展開,詳細解析了Offset維護原理(含存儲於特殊Topic __consumer_offsets、未找到Offset時的auto.offset.reset策略及手動/自動提交機制)、消費者與分區的關係(默認RangeAssignor等分配策略、觸發ReBalance的場景及Coordinator的管理作用),同時介紹了Kafka高性能的核心原因(順序讀寫、索引、批量操作與壓縮、零拷貝機制),並給出了保障消息不丟失的關鍵配置(如Producer端acks=all、Broker端replication.factor≥3等)。

2. 思維導圖(mindmap)

3. 詳細總結

一、Kafka消費者原理

1. Offset維護原理

Offset是消費者消費消息的位置標識,其維護直接影響消費連續性,核心包括存儲、未找到時的策略及更新機制三部分:

- Offset存儲

- 存儲位置:早期存ZK,現存Broker端特殊Topic

__consumer_offsets(默認offsets.topic.num.partitions=50個分區,每個分區默認1個副本)。 - 存儲內容:該Topic存儲兩類序列化對象

GroupMetadata:消費者組內各消費者信息(含編號)OffsetAndMetadata:消費者組與各分區的Offset元數據(含Offset值、提交時間等)

- 分區映射:通過哈希計算確定消費者組Offset對應的

__consumer_offsets分區,公式為Math.abs(consumer_group_id.hashCode()) % 50(如組gp-assign-group-1計算後對應某一分區)。 - 查看方式:

- 查看消費者組與分區的Offset關係:

./kafka-consumer-groups.sh --bootstrap-server 192.168.8.144:9092,192.168.8.145:9092,192.168.8.146:9092 --describe --group gp-assign-group-1- 結果字段含義如下表:

|

字段

|

含義説明

|

|

PARTITION

|

分區編號

|

|

CURRENT-OFFSET

|

下一個未使用的Offset

|

|

LOG-END-OFFSET(LEO)

|

下一條待寫入消息的Offset(最新Offset+1)

|

|

LAG

|

消費延遲量(LEO - CURRENT-OFFSET)

|

|

CONSUMER-ID

|

消費該分區的消費者ID

|

- 查看

__consumer_offsets內容:

./kafka-console-consumer.sh --topic __consumer_offsets --bootstrap-server 192.168.8.144:9092,192.168.8.145:9092,192.168.8.146:9092 --formatter "kafka.coordinator.group.GroupMetadataManager\$OffsetsMessageFormatter" --from-beginning- 未找到Offset的處理策略

當新消費者組消費已有分區(無歷史Offset記錄)時,由auto.offset.reset參數控制消費起始位置,參數取值及含義如下表:

|

參數值

|

含義説明

|

|

earliest

|

從最早的消息(序號最小)開始消費,可獲取歷史消息

|

|

latest

|

從最新的消息(最後發送)開始消費,默認值,無法獲取歷史消息

|

|

none

|

若未找到消費者組的歷史Offset,直接拋出異常

|

|

其他值

|

拋出異常

|

- Offset更新機制

Offset由消費者主動提交給Broker更新,分為自動提交和手動提交兩種方式:

- 自動提交:

enable.auto.commit=true(默認),消費者消費消息後自動提交,提交頻率由auto.commit.interval.ms控制(默認5秒)。 - 手動提交:

enable.auto.commit=false,需調用方法觸發提交

consumer.commitSync():同步提交,提交成功前阻塞consumer.commitAsync():異步提交,不阻塞但需處理回調

- 注意:若不提交或提交失敗,Broker端Offset不更新,下次消費會重複獲取消息。

2. 消費者與分區的關係

消費者組(Consumer Group)對Topic分區的消費分配及動態調整是核心,包括消費策略、ReBalance機制兩部分:

- 消費策略(分區分配策略)

消費者組內的消費者與Topic分區遵循“一個消費者可消費多個分區,但一個分區僅能被組內一個消費者消費”的規則,分配策略由partition.assignment.strategy參數控制,支持三種策略:

|

策略名稱

|

分配邏輯

|

示例(5分區,2消費者)

|

|

RangeAssignor(默認)

|

按分區序號連續分配,“按坨分配”

|

消費者1:分區0、1、2;消費者2:分區3、4

|

|

RoundRobinAssignor

|

輪詢分配,按消費者順序依次分配分區

|

消費者1:分區0、2、4;消費者2:分區1、3

|

|

StickyAssignor

|

優先保證分區分配均勻,其次儘量與上次分配保持一致(結果不固定)

|

可能為消費者1:分區0、3、4;消費者2:分區1、2

|

- 特殊場景:若消費者數量>分區數量,多餘消費者無分區可消費(“站着上課”)。

- 手動指定分區:使用

consumer.assign(Arrays.asList(tp))(tp為TopicPartition對象),此時消費者組ID失效,不參與自動分配。

- ReBalance(分區再均衡)

ReBalance是消費者組動態調整分區分配的協議,確保分區在消費者變化時仍均勻分配:

- 觸發場景:

- 消費者組內消費者數量變化(新增/下線消費者)

- 訂閲的Topic分區數變化(新增/減少分區)

- 管理角色:Coordinator(GroupCoordinator),每個消費者組對應一個Coordinator,由

__consumer_offsets分區的Leader所在Broker擔任。 - 核心機制:

- ReBalance Generation:“屆”,每次ReBalance後Generation號+1,上一屆消費者無法向新一屆提交Offset(隔離無效提交)。

- 核心協議:共5種,ReBalance主要用到前4種

|

協議名稱

|

作用説明

|

|

Heartbeat

|

消費者定期向Coordinator發送心跳,證明存活

|

|

LeaveGroup

|

消費者主動告知Coordinator退出組

|

|

SyncGroup

|

組內Leader將分配方案同步給所有成員

|

|

JoinGroup

|

消費者請求加入組,Coordinator收集成員信息

|

|

DescribeGroup

|

查看組信息(成員、分配方案等),供管理員使用

|

- 執行流程:分為Join和Sync兩步

- Step 1(Join):所有消費者發送

JoinGroup請求給Coordinator,Coordinator選1個消費者作為Leader,並將成員/訂閲信息發給Leader。 - Step 2(Sync):Leader制定分配方案,通過

SyncGroup請求上報Coordinator;其他消費者發送空SyncGroup請求,Coordinator將方案通過響應返回給所有消費者。

二、Kafka高性能核心原因

Kafka基於磁盤存儲卻能實現百萬級TPS(普通服務器測試數據),核心依賴四大機制:

- 順序讀寫

- 原理:Kafka消息僅追加到磁盤文件末尾(順序寫),消費時按順序讀取,避免磁盤隨機尋址的耗時(隨機I/O需反覆定位扇區,順序I/O無需重複尋址)。

- 性能對比:測試顯示磁盤順序讀寫速度達53.2M values/sec,超內存隨機讀寫(36.7M values/sec)。

- 索引機制

- 作用:通過索引文件快速定位消息在數據文件中的位置,減少磁盤I/O次數,提升消費效率。

- 批量操作與文件壓縮

- 批量操作:將多條消息打包成

RecordBatch批量傳輸和存儲,減少網絡請求和磁盤操作次數。 - 文件壓縮:對批量消息進行壓縮(如Gzip、Snappy),降低網絡傳輸帶寬和磁盤存儲佔用。

- 零拷貝機制

- 傳統I/O問題:消費消息需4次拷貝(磁盤→內核緩衝區→用户緩衝區→Socket緩衝區→網卡)、4次態切換(用户態↔內核態),CPU參與2次拷貝,效率低。

- 零拷貝實現:依賴Linux

sendfile系統調用(Java中對應FileChannel.transferTo方法),直接從內核緩衝區將數據傳輸到網卡(僅2次DMA拷貝,無CPU拷貝),減少態切換和拷貝次數,性能提升至少1倍。

三、Kafka消息不丟失配置

需從Producer、Broker、Consumer三端協同配置,保障消息全鏈路不丟失:

|

端類型

|

配置項

|

配置值/建議

|

作用説明

|

|

Producer

|

消息發送方法

|

使用 |

通過回調感知發送失敗,針對性處理(如重試)

|

|

|

|

消息需被所有副本(含Leader和Follower)接收,才視為“已提交”

|

|

|

|

較大值(如10)

|

網絡抖動時自動重試發送,避免臨時失敗導致消息丟失

|

|

|

Broker

|

|

|

禁止落後過多的Follower競選Leader,避免消息丟失

|

|

|

≥3

|

每個分區至少3個副本,提升數據冗餘度

|

|

|

|

>1(如2)

|

消息需寫入至少2個副本才視為“已提交”,推薦 |

|

|

Consumer

|

|

|

關閉自動提交,確保業務邏輯處理完成後再手動提交Offset,避免消費未完成卻提交導致消息丟失

|

4. 關鍵問題

問題1:Kafka消費者組的Offset為何從ZK遷移到__consumer_offsets Topic?兩種存儲方式的核心差異是什麼?

- 答案:早期Offset存儲於ZK,因ZK的設計定位是分佈式協調(而非高頻讀寫存儲),當消費者組數量多、Offset更新頻繁時,會導致ZK讀寫性能損耗大,無法支撐高併發場景;遷移到

__consumer_offsetsTopic後,利用Kafka本身的高吞吐、高可用特性(分區副本機制),能高效承載Offset的存儲與更新。

核心差異如下表:

|

對比維度

|

ZK存儲Offset

|

|

|

性能

|

高頻讀寫損耗大,性能低

|

依託Kafka高吞吐,性能高

|

|

可用性

|

依賴ZK集羣,無Kafka自身副本保障

|

支持分區副本(默認1副本,可配置更多),可用性高

|

|

存儲內容

|

僅Offset值

|

含Offset值、提交時間、消費者組元數據等完整信息

|

問題2:Kafka的ReBalance機制可能導致“消費停頓”,如何從配置和策略上減少ReBalance的頻率和影響?

- 答案:減少ReBalance需從“避免觸發場景”和“優化機制”兩方面入手:

- 避免不必要的觸發場景:

- 控制消費者數量:確保消費者數量≤Topic分區數,避免多餘消費者(減少消費者下線觸發ReBalance的概率)。

- 穩定Topic分區:提前規劃好Topic分區數,避免頻繁新增/減少分區。

- 優化消費者存活檢測:合理設置

session.timeout.ms(默認10秒,消費者斷連後Coordinator等待的超時時間)和heartbeat.interval.ms(默認3秒,心跳發送間隔),避免因網絡波動誤判消費者下線(建議heartbeat.interval.ms設為session.timeout.ms的1/3)。

- 優化ReBalance影響:

- 使用StickyAssignor策略:該策略儘量保持分區分配與上次一致,減少ReBalance後分區遷移的範圍,降低消費停頓時間。

- 批量提交Offset:手動提交時避免頻繁提交,減少ReBalance時Offset提交衝突的概率。

問題3:在保障Kafka消息不丟失的配置中,為何要求replication.factor > min.insync.replicas?若兩者相等會導致什麼問題?

- 答案:

replication.factor是分區的副本總數,min.insync.replicas是消息“已提交”所需寫入的最小副本數,要求replication.factor > min.insync.replicas的核心目的是“保留冗餘副本,應對部分副本下線場景”,確保分區仍能正常寫入消息。

若兩者相等(如replication.factor=2且min.insync.replicas=2),當任意一個副本(如Follower)下線時,剩餘副本數(1個)<min.insync.replicas(2個),此時Broker會拒絕Producer的消息寫入請求,導致整個分區無法正常工作,影響業務可用性。

推薦配置示例:replication.factor=3、min.insync.replicas=2,即使1個副本下線,剩餘2個副本仍滿足min.insync.replicas要求,分區可正常寫入,同時保留1個冗餘副本應對極端情況。