最新案例動態,請查閲基於華為開發者空間雲主機——5分鐘讓華為雲主機加持 DeepSeek。小夥伴們快來領取華為開發者空間進行實操吧!

1 概述

1.1 案例介紹

華為開發者空間,是為全球開發者打造的專屬開發者空間,致力於為每位開發者提供一台雲主機、一套開發工具和雲上存儲空間,匯聚昇騰、鴻蒙、鯤鵬、GaussDB、歐拉等華為各項根技術的開發工具資源,並提供配套案例指導開發者 從開發編碼到應用調測,基於華為根技術生態高效便捷的知識學習、技術體驗、應用創新。

免費領取開發者空間雲主機

→ PC端

→ 移動端

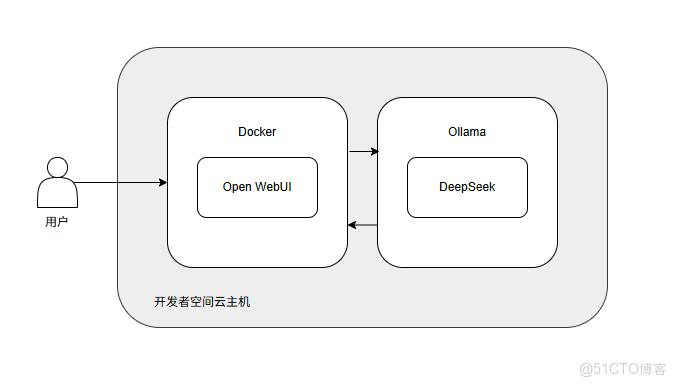

本案例演示如何在華為開發者空間雲主機上,一步步完成Open WebUI環境搭建及 DeepSeek模型接入,並進行簡單的文本生成任務。

1.2 適用對象

- 企業研發團隊

- AI/ML 愛好者

- 高校師生

1.3 案例時間

本案例總時長預計60分鐘。

1.4 案例流程

説明:

- 打開華為開發者空間雲主機;

- 安裝並啓動Ollama模型服務;

- 安裝Open WebUI;

- 使用Ollama部署DeepSeek模型;

- 通過Open WebUI使用DeepSeek進行聊天交互。

1.5 資源總覽

本案例預計花費0元。

| 資源名稱 | 規格 | 單價(元) | 時長(分鐘) |

| 開發者空間–雲主機 | 4 vCPUs 8 GB Ubuntu 24.04 Server 定製版 | 0 | 60 |

2 環境配置

2.1 開發者空間配置

面向廣大開發者羣體,華為開發者空間提供一個隨時訪問的“開發桌面雲主機”、豐富的“預配置工具集合”和靈活使用的“場景化資源池”,開發者開箱即用,快速體驗華為根技術和資源。

如果還沒有領取開發者空間雲主機,可以參考免費領取雲主機文檔領取。

領取雲主機後可以直接進入華為開發者空間工作台界面,點擊打開雲主機 \> 進入桌面連接雲主機。

2.2 安裝 Ollama

Ollama 是一個強大的開源工具,旨在幫助用户輕鬆地在本地運行、部署和管理大型語言模型(LLMs)。它提供了一個簡單的命令行界面,使用户能夠快速下載、運行和與各種預訓練的語言模型進行交互。Ollama 支持多種模型架構,並且特別適合那些希望在本地環境中使用 LLMs 的開發者和研究人員。

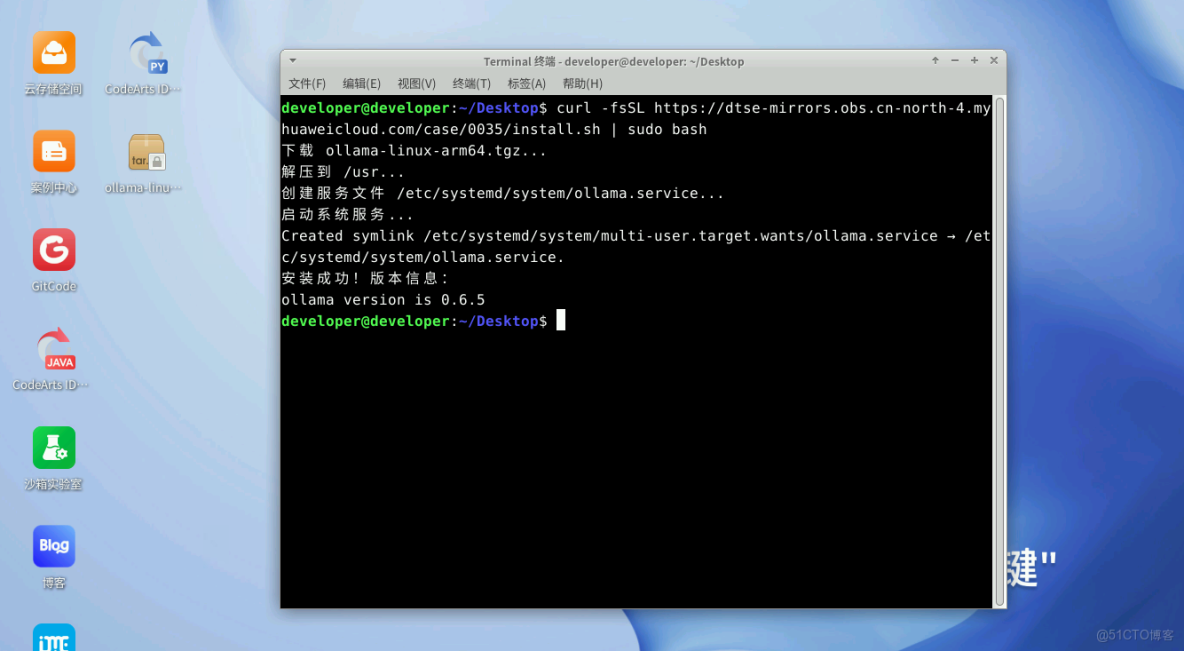

# 安裝Ollama腳本

curl -fsSL https://dtse-mirrors.obs.cn-north-4.myhuaweicloud.com/case/0035/install.sh | sudo bash設置並啓動Ollama服務。

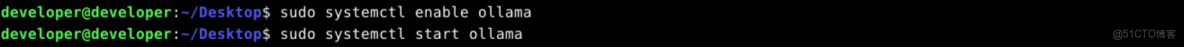

sudo systemctl enable ollama

sudo systemctl start ollama接下來可以根據需要,藉助 Ollama 工具來部署大模型。

2.3 安裝Open WebUI

打開雲主機命令行窗口輸入以下命令,更新軟件包。

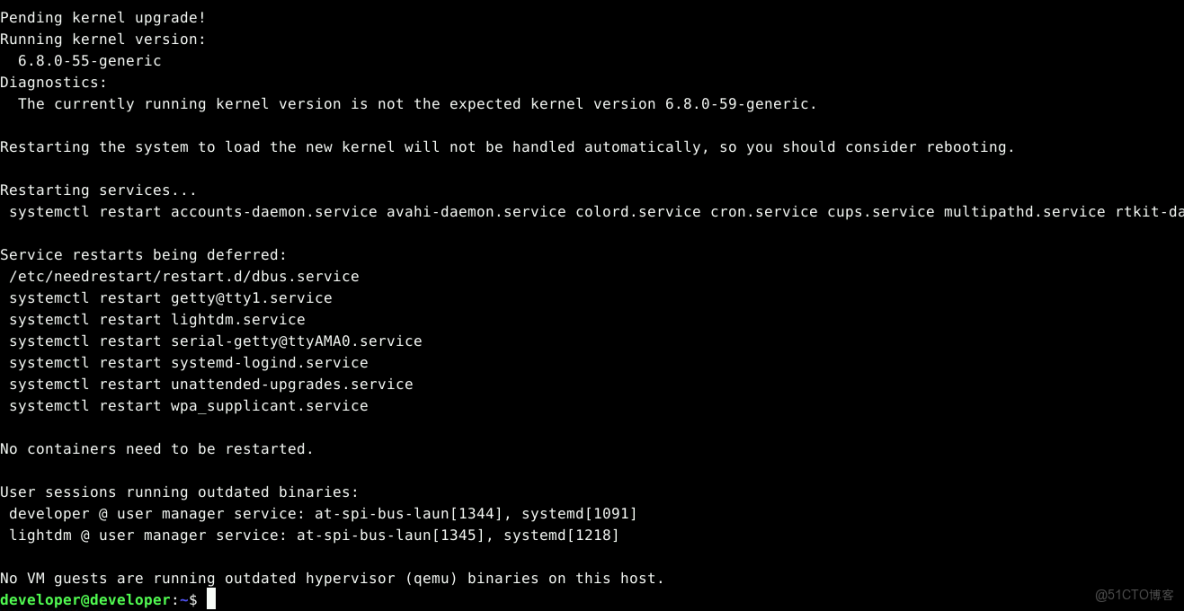

sudo apt update

sudo apt upgrade -y卸載舊版本Docker(如果已安裝)。

sudo apt-get remove docker docker-engine docker.io containerd runc安裝必要的依賴。

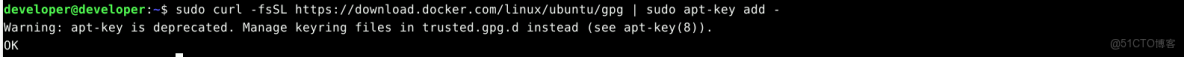

sudo apt install apt-transport-https ca-certificates curl software-properties-common添加Docker的官方GPG密鑰。(如果雲主機已安裝dokcer,且操作上一步卸載再安裝,執行該步驟第一次會報找不到OpenPGP,須再次執行)

sudo curl -fsSL https://download.docker.com/linux/ubuntu/gpg | sudo apt-key add -添加Docker的APT源。

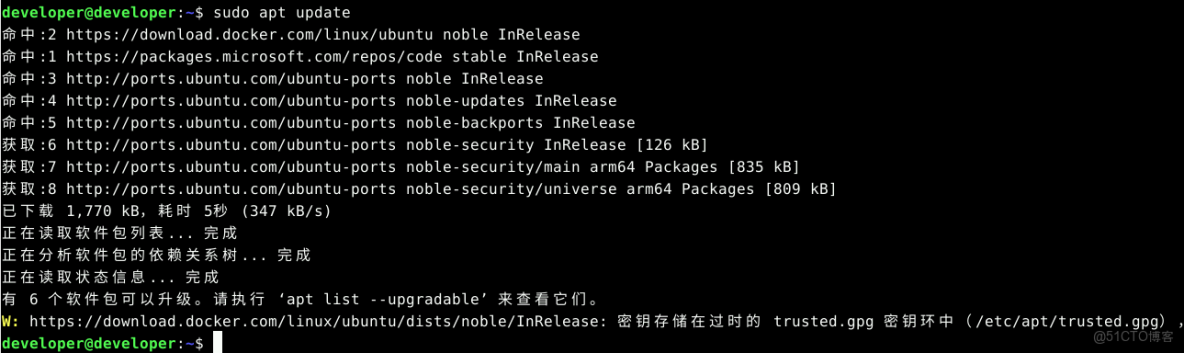

sudo add-apt-repository "deb [arch=amd64] https://download.docker.com/linux/ubuntu $(lsb_release -cs) stable"更新APT包索引。

sudo apt update安裝Docker CE。

sudo apt install docker-ce驗證Docker是否安裝成功。

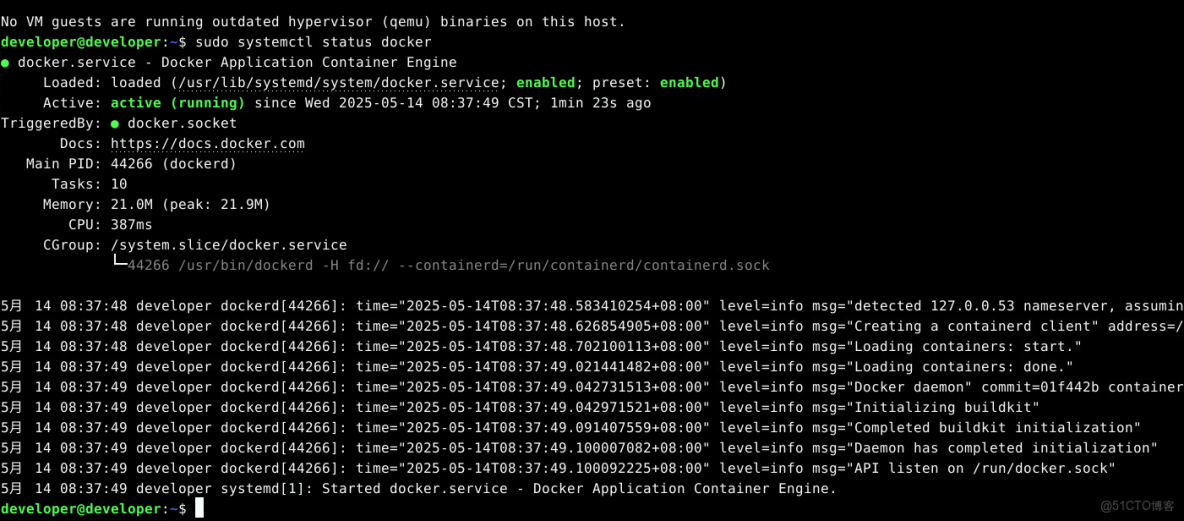

sudo systemctl status docker設置Docker自動啓動。

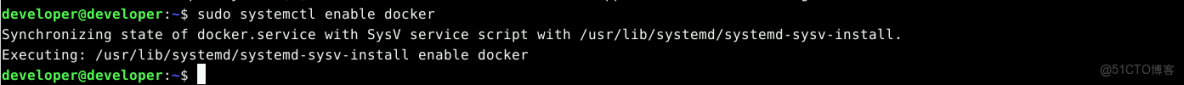

sudo systemctl enable docker安裝 Open WebUI。

sudo docker pull ghcr.io/open-webui/open-webui:main運行 Open WebUI 容器。

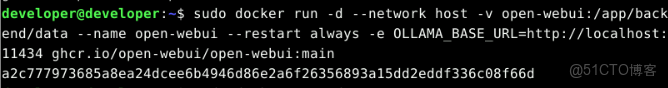

sudo docker run -d --network host -v open-webui:/app/backend/data --name open-webui --restart always -e OLLAMA_BASE_URL=http://localhost:11434 ghcr.io/open-webui/open-webui:main大概等待兩分鐘,容器可以啓動完成。

瀏覽器輸入 localhost:8080,即可訪問Open WebUI。

注:如果訪問失敗,可以輸入下面命令查看日誌。

# 查看容器狀態

sudo docker ps -a | grep open-webui# 檢查日誌

sudo docker logs open-webui3 實戰項目

3.1 使用Ollama部署DeepSeek模型

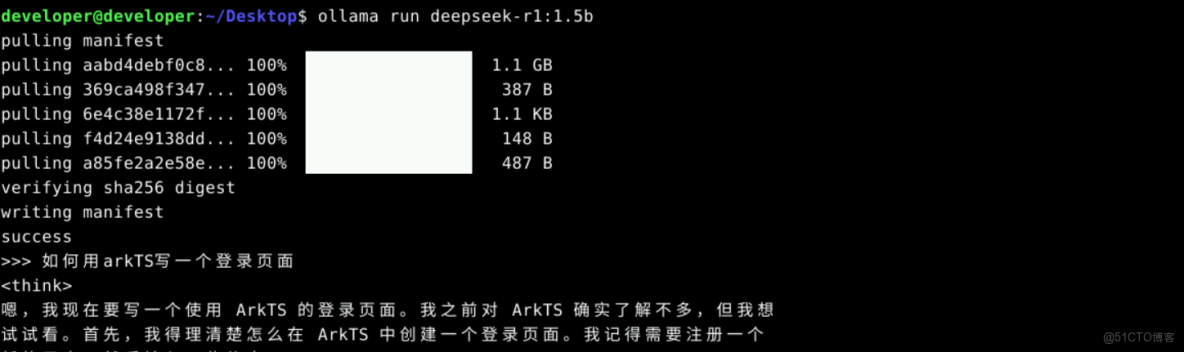

部署 deepseek-r1:1.5b 版本,執行 DeepSeek 的安裝命令,安裝完成後,DeepSeek 將自動運行。

ollama run deepseek-r1:1.5b安裝完成後,我們可以直接在終端裏和 DeepSeek 進行交互。

ctrl + D退出Ollama。

3.2 通過Open WebUI使用DeepSeek進行聊天交互

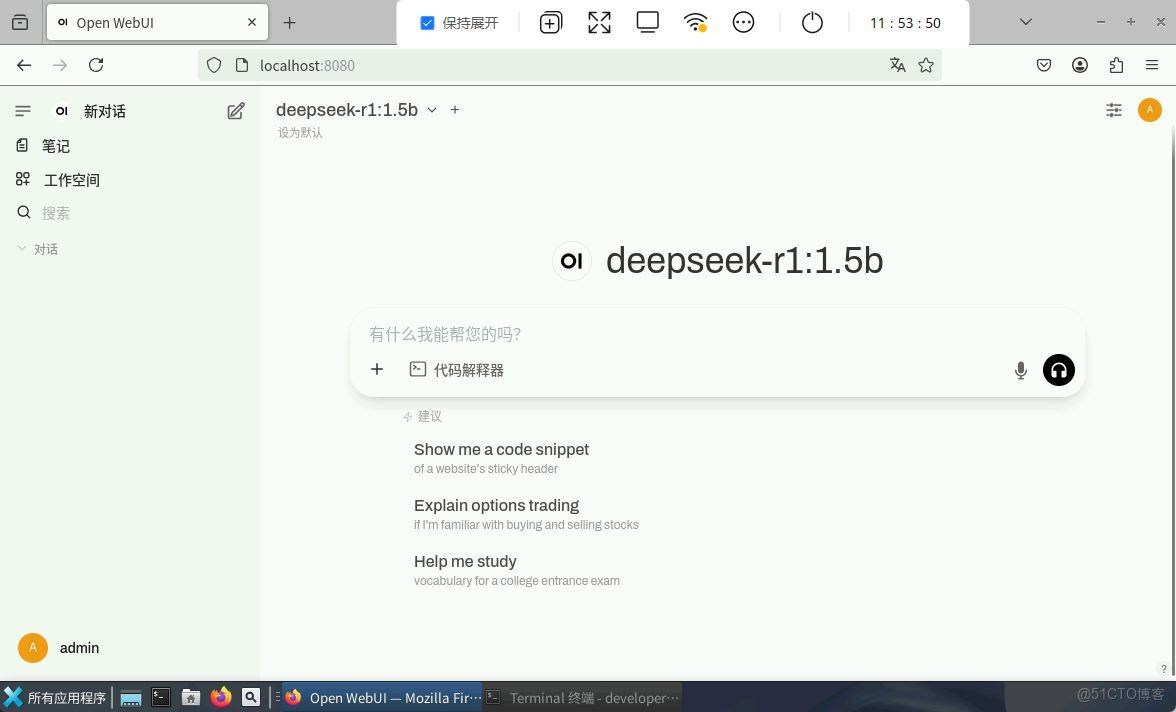

瀏覽器輸入localhost:8080,訪問Open WebUI。

首次登錄,需要創建管理員賬號。登錄後,界面如下:

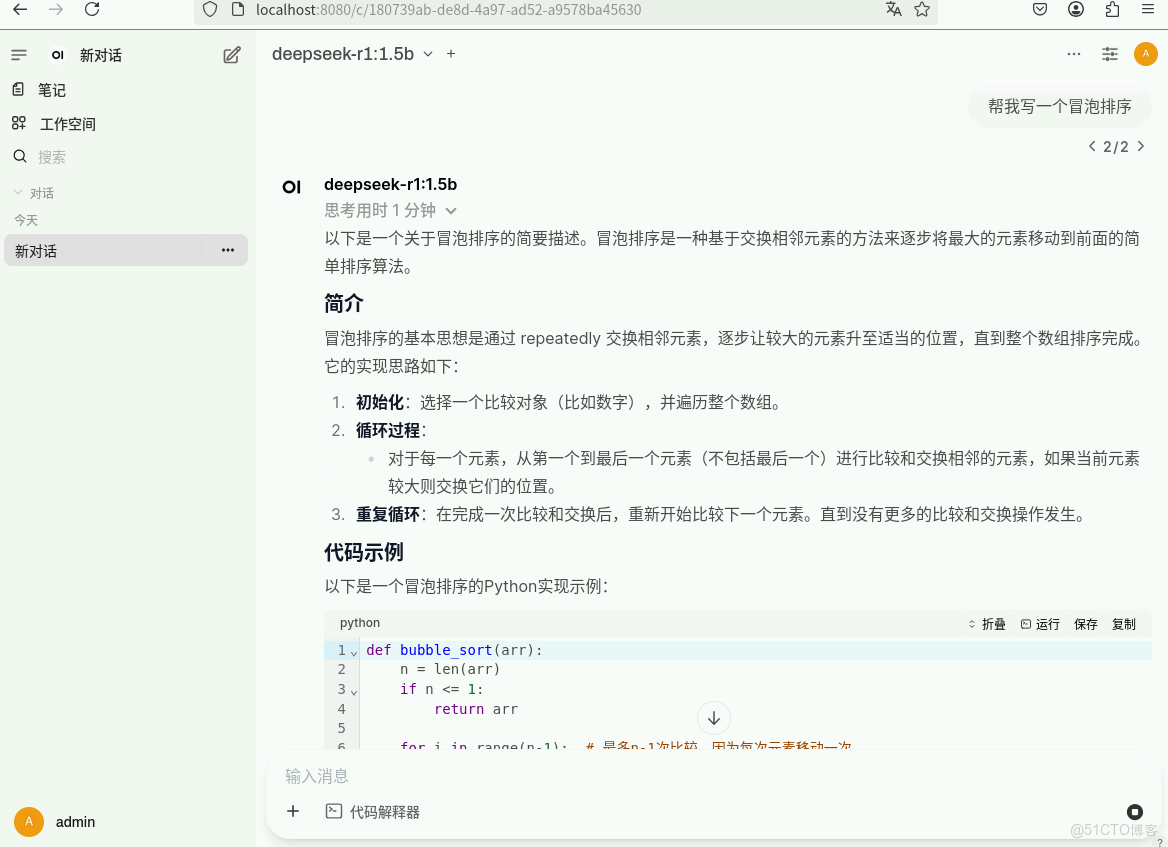

向deepseek-r1模型提問,比如:“幫我寫一個冒泡排序”。

可以看到模型自動回覆成功。

以上就是DeepSeek-R1結合Open WebUI的使用。大家可以帶着自己想要提問的問題,測試本次部署的應用。

開發者空間官網 開發者空間案例中心 開發者空間活動專題