近日,阿里巴巴通義團隊開源了Fun-ASR-Nano-2512和Fun-CosyVoice3-0.5B-2512兩款語音AI模型。前者是輕量級語音識別模型,後者是多語言語音合成模型,共同構成端側“聽+説”閉環方案。此次開源的核心看點在於,僅0.8B參數的Fun-ASR-Nano在多項評測中性能接近12B參數的頂級模型。

一個僅0.8B參數的“小個子”,在語音識別賽場上,竟跑出了接近12B“巨無霸”的成績單。阿里通義開源的Fun-ASR-Nano,正將這場“效率革命”變為現實。

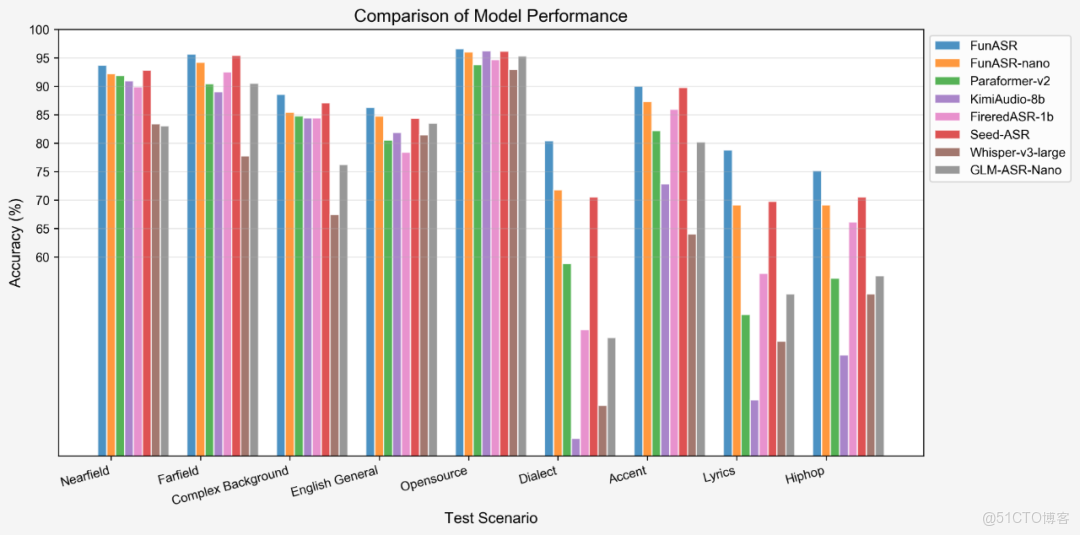

根據官方技術報告,Fun-ASR-Nano在多個真實工業場景數據集上的平均詞錯誤率(WER)為9.38%。作為對比,參數規模是其15倍的頂級模型Seed-ASR(約12B)在相同測試集上的平均WER為8.71%,兩者差距已進入毫釐之間。

更關鍵的是,在一些複雜場景下,小模型的優勢反而凸顯。例如,在“複雜背景噪音”測試集上,Fun-ASR-Nano的WER為17.07%,優於另一款1.1B參數的開源模型FireRed-ASR的15.56%。這表明,單純堆砌參數並非通往高性能的唯一路徑,模型效率與優化策略同樣關鍵。

然而,報告也揭示了一個行業“潛規則”:在公開的學術基準測試集上,幾乎所有模型都能刷出漂亮的低WER。但一旦切換到未經“污染”的真實工業數據集,性能排名便會發生劇烈洗牌。這提醒我們,脱離真實場景的“榜單第一”可能只是美麗的泡沫,而Fun-ASR-Nano的評測更側重於工業級應用的真實表現。

如此高的參數效率從何而來?其技術報告清晰地勾勒出三條核心路徑:數據縮放、模型縮放與LLM深度集成。

- 數據質量的“降維打擊”:模型使用了數千萬小時的預訓練音頻數據,並構建了包含數百萬小時的監督微調數據。關鍵不在於“多”,而在於“精”和“全”。數據中不僅有人工轉錄的高質量語料,還通過複雜的流水線生成了偽標籤數據,並專門合成了用於噪聲魯棒性、代碼切換、熱詞定製等場景的特殊數據。用高度定向、多樣化的數據去“餵養”模型,遠比盲目堆砌通用數據更有效。

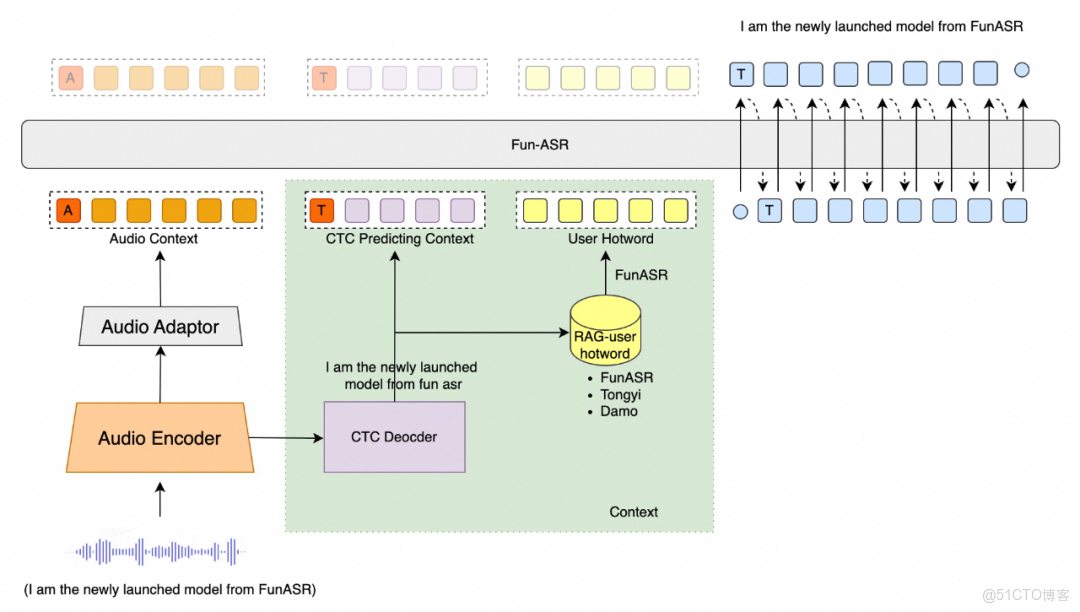

- 架構創新的“四兩撥千斤”:Fun-ASR採用了創新的四組件架構。對於Nano版本,團隊將音頻編碼器壓縮至0.2B參數,LLM解碼器控制在0.6B。其核心秘訣在於用更精巧的適配器和訓練策略,將小規模音頻特徵與大語言模型的語義知識高效對齊。例如,在預訓練音頻編碼器時,創新性地使用預訓練文本大模型(Qwen3)的層來初始化編碼器,將文本世界的語言學知識“注入”語音表徵學習,加速了收斂並提升了質量。

- 面向生產的“魔鬼訓練”:模型沒有停留在實驗室的“温室”環境。為了應對真實世界的挑戰,團隊進行了大量生產級優化:

- 抗噪訓練:通過大規模噪聲數據增強,在複雜噪音環境測試集上帶來了約13%的平均相對性能提升。

- 流式能力:專門構建模擬流式解碼過程的訓練數據,減少訓練與推理的失配。

- 強化學習調優:設計了一套針對語音識別任務的強化學習框架(FunRL),不僅優化WER,還加入關鍵詞召回、抗幻覺、語言匹配等專項獎勵,直接優化終端用户體驗。

雙星協同:構建本地化“聽+説”AI閉環

Fun-ASR-Nano-2512與Fun-CosyVoice3-0.5B-2512的組合,共同指向一個明確目標:在手機、汽車、IoT設備等資源受限的終端上,構建一個完全離線、低延遲、高隱私的語音交互閉環。這標誌着語音AI正從依賴雲端算力的“重服務”,向普惠、自主的“輕能力”範式轉變。

Fun-ASR-Nano:專注高效語音識別與噪聲魯棒性

Fun-ASR-Nano的0.8B參數設計,本身就是對端側部署的極致妥協與優化。它的核心使命不是追求實驗室榜單的極限分數,而是在真實世界的複雜場景中,實現穩定、可用的識別能力。

- 效率與實戰的平衡:模型採用了深度優化的Transformer架構,其設計邏輯是犧牲部分處理極端複雜語句的“智力”,換取更廣泛的設備適配性和實時性。這使得它能在手機處理器上流暢運行,首字延遲低至160ms,從根本上解決了雲端識別帶來的隱私和延遲痛點。

- 數據驅動的噪聲魯棒性:資料顯示,其性能逼近12B巨頭的關鍵,在於針對性的生產級優化。通過在大規模訓練數據中混合環境噪聲(如餐廳、地鐵背景音),並進行噪聲魯棒性專項訓練,模型在嘈雜環境下的平均識別性能提升了約13%。這證明,針對具體痛點(噪聲、口音)的精細化數據工程,其價值不亞於單純擴大模型規模。

- 直面真實挑戰:模型還特別優化了流式識別能力,並引入抗“幻覺”訓練(在純噪聲數據上學習不編造文本),以勝任會議轉錄、直播字幕等實時場景。同時,其支持7種中文方言和26種地區口音,這是對中國複雜語言環境的務實迴應。

Fun-CosyVoice3:0.5B模型實現多語言零樣本克隆

與“耳朵”配套的“嘴巴”Fun-CosyVoice3,則以0.5B的極小體量,實現了兩項突破性能力:多語言合成與零樣本音色克隆。

- “零樣本”降低應用門檻:傳統高質量語音克隆需要目標説話人數小時的錄音數據。而“零樣本”意味着用户僅需提供一段3秒以上的陌生語音,模型就能即時模仿其音色,並用該聲音合成新內容。

- 多語言能力複用參數:模型支持中、英、日等多種語言的合成與音色遷移。這意味着,用一段中文錄音克隆的聲音,可以直接用來講英文故事。這種跨語言音色解耦,極大地減少了為全球化應用部署多個模型的成本和複雜度。

- 客觀看待能力邊界:必須指出,0.5B的模型容量存在天花板。與參數大一個數量級的頂級TTS模型相比,它在情感飽滿度、韻律自然度等極致表現力上可能存在差距。其優勢在於,在可接受的合成質量下,實現了速度、體積和功能性的最佳平衡,非常適合端側實時反饋。

兩者協同,價值倍增。這套方案讓開發者能以極低成本,在本地搭建從“聽到”到“説出”的完整管道。這不僅關乎技術,更是阿里為搶佔下一代AI應用生態底座所下的先手棋。

開源模型與商業方案的差距及實際部署挑戰

然而,將開源模型直接等同於“工業級解決方案”,是一種危險的誤解。論文指標的光鮮,往往掩蓋了真實部署中的“魔鬼細節”。

開源版本是功能“閹割版”,工程化成本高昂。

技術報告中詳細闡述了Fun-ASR為生產環境所做的多項深度優化,如流式識別、定向熱詞定製、強化學習後訓練等。而這些生產級優化能力,很可能並未完全包含在開源的小模型版本中。開發者拿到的是一個強大的“基礎引擎”,但要想讓它穩定運行,仍需面對:

* 部署與維護:從環境配置、硬件適配到持續更新,需要專業的AI工程團隊,其人力成本可能遠超直接調用雲端API。

* 定製化門檻:針對特定行業術語或口音進行高質量微調,需要專業的數據處理和算法知識,遠非“一鍵克隆”那麼簡單。

* 合規與風險:企業需要自行構建高可用架構、安全審計和隱私合規保障,並獨自承擔相關風險。

因此,阿里開源模型的真正價值,在於為中小開發者、研究機構和有強定製化需求的團隊提供了強大的“基座”。 但對於追求穩定、省心、全鏈路服務的企業客户而言,成熟的商業方案在短期內仍是更穩妥的選擇。

這場開源盛宴,你是會選擇擁抱“引擎”自己造車,還是繼續購買成熟的“整車”服務?你的選擇背後,又考量了哪些我們未曾提及的風險與機遇? 歡迎在評論區分享你的看法。如果這篇文章幫你撥開了開源模型的重重迷霧,請點贊、分享,讓更多同行看到。