作者:互聯網運維技術保障團隊-Mo Han、Zhou Jianhua

在飛速發展的互聯網信息化時代下,抓住並充分利用“流量”將為業務增長帶來“潑天”富貴,已成為共識。如何通過真實、海量的數據打造一個集成本、質量、效率於一體的融合流量管理平台,也成了各行各業的關注焦點,本文通過”撥測“與“融合流量管理”兩個維度,來分享vivo在流量管理領域的一些實踐和探索。

本文為2025年 vivo 開發者大會互聯網技術專場分享內容之一,在公眾號對話框回覆【2025VDC】獲取 2025VDC 互聯網技術會場議題相關資料。

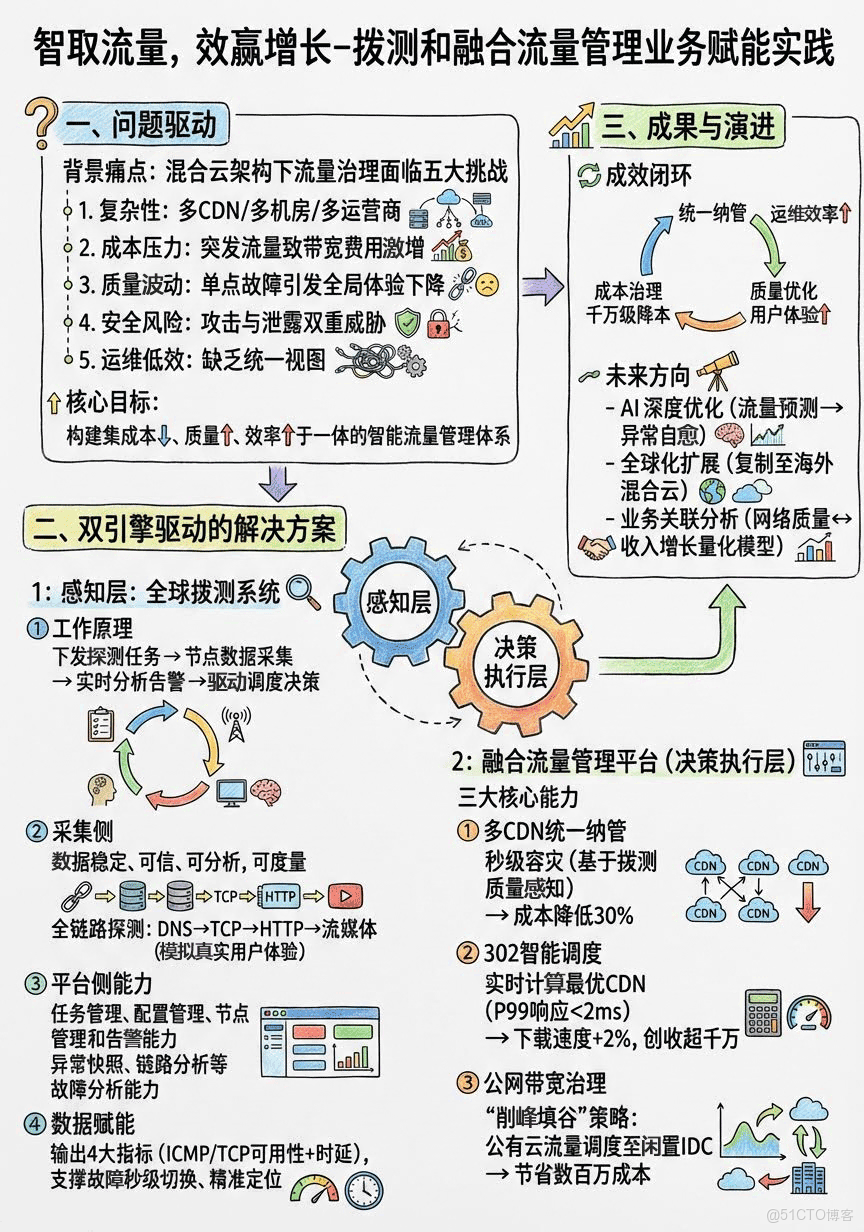

1分鐘看圖掌握核心觀點👇

圖1 VS 圖2,您更傾向於哪張圖來輔助理解全文呢?

一、背景

在飛速發展的互聯網信息化時代下,抓住並充分利用“流量”將為業務增長帶來“潑天”富貴,已成為共識。如何通過真實、海量的數據打造一個集成本、質量、效率於一體的融合流量管理平台,也成了各行各業的關注焦點,本文通過“撥測”與“融合流量管理”兩個維度,來分享vivo在流量管理領域的一些實踐和探索。

二、全球撥測

2.1 什麼是撥測

簡單來説,撥測就是一套模擬真實用户行為,主動進行健康檢查和性能測量的旁路監控系統。 它就像我們派出去的無數“觀察者”,通過這些“觀察者”,我們主要可以實現三大目標:

一是性能監控:它可以模擬用户對某個網絡接口或者網址,發起主動探測,檢測網絡的延遲、丟包,錯誤,及時發現網絡風險和故障。

二是產品優化:從用户視角去對比不同版本的性能差異,為產品迭代提供數據支持。

三是可用性監控:模擬用户使用業務場景和完整流程,評估業務的真實質量,及時發現業務可用性問題。

2.2 vivo撥測平台介紹

在vivo,撥測的核心使命,就是為所有業務和產品高可用保駕護航,網絡性能監控、業務可用性監控,產品優化分析、這是基礎能力,確保我們的服務穩定可靠。

在這基礎能力之上以及結合本次分享的主題,我們孵化了另外一種場景-“網絡調度檢測”,我們會持續地對CDN、機房、運營商這些基礎鏈路進行探測和分析,一旦發現問題,就可以基於撥測數據動態調整網絡策略,以實現流量和故障智能調度目的。

2.3 vivo撥測的原理介紹

瞭解了vivo自有節點規模後,那麼撥測如何工作的?下面這張圖清晰展示了vivo撥測系統的基本工作原理,它主要分為三步:

第一步,下發執行探測任務。

平台會向分佈在全球的邊緣探測節點,下發探測指令,比如去訪問某個網址,或者訪問某一接口,也或者下載某個APP等。

第二步,數據採集與分析。

節點在執行任務時,會收集網絡丟包率,響應時間、可用性等性能數據,並進行實時分析。

第三步,閾值和可用性告警。

如果發現探測結果超出了我們設定的閾值,比如訪問超時、不可用,檢測告警系統就會立即觸發告警,並可以聯動 智能調度策略 進行自動處理,比如切換線路,切換災備機房,切換運營商等。

2.4 vivo撥測能力介紹-採集側

為了管理如此龐大的節點網絡並執行復雜的任務,我們的撥測平台構建哪些技術能力呢?大家可以看下面這張架構圖,

首先、在採集側,我們具備了從底層的DNS解析、TCP建聯,到上層的HTTP可用性、私有協議,再到網頁首屏、流媒體等全方位的用户體驗檢測能力。

同時,我們對執行撥測節點的耗電,網絡環境,執行策略,配置管控都做了精細化管理 保障採集的撥測數據穩定、可信、可分析,可度量。

2.5 vivo撥測能力介紹-平台側

在平台側,我們同樣具備任務管理、配置管理、節點管理和告警能力。可以實現多維度的任務下發,比如可以按國家、省份、城市、地區、運營商、機型,網絡等維度下發。

同時,我們也具備了劫持,CDN故障等場景的檢測告警能力、以及異常快照、鏈路分析等故障分析能力 確保收集到的撥測數據得到充分的應用,同時經過大數據分析和AI能力加持,做到業務問題 一分鐘發現、即時告警。

vivo撥測平台體驗地址:https://dial.vivo.com.cn

2.6 撥測如何支撐智能流量調度

如此海量的撥測數據,究竟是如何支撐流量調度的呢?

下面這張圖清晰展示了其工作原理。

首先,是“輸入”環節。

IP元數據管理平台會將公網服務IP信息同步到撥測平台,其中IP元數據包含6大關鍵維度:

- IP信息

- 歸屬運營

- 歸屬業務

- 歸屬機房

- 歸屬集羣

- 歸屬IDC

其次,是“執行”環節。

這些帶有元數據的服務公網IP信息,會生成具體的“IP任務”,通過“任務調度”系統,下發給我們遍佈全球的“邊緣探測節點”,執行探測任務。

接着,是數據分析處理環節。

探測結果數據會通過統一網關實時存入時序數據庫中,其中、結果數據包含四大關鍵指標:

- ICMP Ping 可用性

- TCP Ping 可用性

- ICMP Ping 時延

- TCP Ping 時延

這些指標,最終構成了智能調度的核心數據基礎。

最後,就是流量智能調度的應用。

有了這些精準、實時的數據,我們就能賦能一系列上層的智能調度場景,比如:

- 故障快速恢復:一旦撥測發現某個IP不可用,調度系統可以秒級將它切換走。

- 故障精準定位:我們可以快速定位到問題出在哪個地域、哪個運營商,以及哪個線路。

- 流量異常檢測:通過持續的性能數據對比分析,發現潛在的流量衝擊和質量惡化 風險。

- 流量智能調度:基於質量和成本目標,結合業務場景、動態調整流量分配。

三、融合流量管理

3.1 技術背景

vivo採用了自建私有云和公有云結合的混合雲架構。用户的訪問流量,會通過DNS、CDN、負載均衡等一系列網絡基礎設施,最終到達我們的業務服務。

這個架構非常典型,但它也給我們帶來了五大核心挑戰。

- 複雜性:多運營商、多CDN、多機房,管理難度巨大。

- 成本壓力:帶寬費用,特別是突發流量帶來的額外開銷,非常高昂。

- 質量挑戰:任何一個環節的網絡波動,都會影響用户體驗。

- 安全風險:內部主動上網和外部衝擊,都是潛在的威脅。

- 運維效率:缺乏統一視圖和自動化能力,排障和變更操作將非常耗時。

面對這些問題,我們的目標很明確:就是要構建一個智能、高效、安全的一體化解決方案,最終實現降成本、提質量、強安全、提效率!

為了實現這些,平台落地為一系列具體的解決方案,比如:通過DNS域名解析、CDN加速接入來統一流量入口;通過302智能調度、機房帶寬調度來實現智能決策;通過WAF攔截、外發流量檢測來保障安全;並通過全鏈路監控和故障預案來實現自動化運維。

3.2 平台實踐

那麼,我們是如何做的呢?

下面是平台的整體技術架構,它是一個典型的分層架構。

- 最底層是網絡資源,包括了我們對接的DNS、CDN、機房網絡等所有供應商。

- 往上是數據採集層,它會從機房、CDN、業務埋點、撥測系統等各個源頭,全面地採集流量、日誌和監控指標數據。

- 數據之上,是數據處理與分析層,我們使用大數據平台對數據進行實時和離線處理,並利用調度和檢測算法,來挖掘數據背後的價值。

- 架構的核心是控制與執行層,它通過API網關和自動化編排能力,去實際地配置和調度底層的網絡資源。

- 最上層是展現與交互層,通過一個統一的管理門户,面向業務和運維人員,提供接入、管控、報表等一系列服務。

通過這個架構,我們將複雜的流量管理工作,平台化、系統化了。

3.2.1 多CDN統一接入納管

我們深入到具體的實踐場景。

首先是CDN的治理。

我們打造的“融合CDN”平台,核心價值體現在六個方面:

- 配置融合:統一了不同廠商的配置標準,大大提升了管理效率。

- 流量調度:支持多種策略,讓調度既精準又靈活。

- 數據融合:在一個平台就能看到所有廠商的數據指標。

- 成本優化:通過一系列運營手段,我們成功將成本降低了30%。

- 秒級容災:基於全網撥測點的質量感知,一旦發生故障,可以自動調度,實現秒級容災。

- 智能運維:同樣基於撥測節點,可以智能地進行故障的根因定位。

3.2.2 融合CDN產品架構

下面這張架構圖展示了我們如何實現這些價值。大家可以看到,我們通過一個“融合CDN管理平台”,把全球主流CDN廠商的API都接入進來,屏蔽了底層的差異。

對於業務方來説,他們只需要通過我們統一的控制枱或OpenAPI進行操作。同時,平台集成了我們的端側質量埋點、智能解析、302智能調度等核心能力,形成了一個強大的調度中心,為用户提供最優的加速體驗。

在融合CDN中,302智能調度是我們最核心、最有價值的能力之一。

如圖,即使是在同一個地區,不同的CDN廠商,在同一時間的下載速度,是不一樣的。藍色的線可能在某個小時最快,但下一個小時,也許綠色的線就反超了。

這就帶來一個核心問題:我們如何保證我們的用户,總能用到當下那個最快的CDN呢?同時,當某個廠商出現故障時,我們又如何快速地把用户切換走,實現容災呢?這就是302智能調度要解決的問題。

3.2.3 302智能調度

為了解決這個問題,我們設計了這套技術方案。它非常巧妙,主要分為四步:

- 第一步,客户端,也就是我們的業務服務端,在響應用户請求時,它不會直接返回一個寫死的下載地址。

- 第二步,它會先向我們的“302調度服務”發起一次請求,問一個問題:“現在哪個CDN最快?”

- 第三步,我們的調度服務,會根據海量的埋點數據,通過智能算法進行實時計算,然後立刻告訴業務服務端一個最優的廠商域名。

- 第四步,業務服務端拿到這個最優域名後,再通過302跳轉的方式,把用户引導過去。

整個過程對用户是完全透明的,但我們確保了用户的每一次下載,走的都是當下最優的路徑。

這套方案的背後,是一個強大的技術架構在支撐。 大家可以看到,它包含了完整的指標數據採集處理層和調度執行層。

我們通過ETL、Druid等大數據技術,對海量的業務指標數據進行實時處理。 在控制層,我們有靈活的調度策略管理和多重調度算法。

在調度執行層,我們通過統一的網關,為商店、遊戲、系統升級等八十多個業務場景提供服務。

整個架構的設計,核心就是為了保證四點:精細化控制、故障快速切換、實時性與動態適應,以及靈活可擴展。

正是這些,才讓我們的調度服務既快又準。

最終帶來了什麼樣的效果呢?

- 首先是性能:我們的服務端P99響應時間做到了小於2毫秒!這對用户來説是完全無感的。同時,配置變更可以秒級生效,實現了真正的實時。

- 其次是規模:目前每天的調度執行次數,超過了60億次!覆蓋了我們80多個核心業務場景。

- 最後是業務價值:通過這套系統,我們為應用商店等業務,帶來了整體下載速度提升超過2%!

- 更關鍵的是,它為我們的商業化帶來了超過千萬元的收入提升!這就是技術驅動業務增長最直接體現!

3.2.4 公網帶寬治理

講完了CDN,我們再來看另一個成本大頭:機房公網帶寬。 從這張全網公網帶寬的趨勢圖。可以看到,在2022年之前,我們的帶寬增幅是比較大的,成本壓力也隨之而來。

但是,從2023年開始,增幅明顯趨於平穩。 這不是因為業務停滯了,而是因為我們進行了一系列持續的成本治理和運營。比如,我們重點針對主動上網、埋點業務和出入向均衡進行了專項優化,成功地將帶寬增長控制在了可預期的範圍內。

接下來,我就為大家介紹一下我們實現這個目標的關鍵能力。 要實現公網帶寬降本,我們同樣打造了一套公網帶寬調度體系。

這套體系主要包含了幾個核心能力:

- 首先,是IDC機房帶寬的智能調度,這是我們進行流量騰挪的基礎。

- 其次,是帶寬用量的歸因分析和成本分攤,讓我們清楚每一分開銷花在了哪裏。

- 最後,也是最重要的,是基於撥測數據的質量調度和監控,確保我們在優化成本的同時,不犧牲用户體驗。

如下產品架構圖,展示了我們全球混合雲環境下,公網帶寬調度的全貌。 當一個vivo的全球用户發起訪問時,我們的智能解析系統(VHS),會成為第一個決策入口。

它會結合來自我們全球撥測點的源站質量監測數據,以及我們VIP地址池的管理策略,智能地判斷,應該把這個用户的請求,解析到哪個地域的哪個機房。

這個機房,可能是我們在北京的自建IDC,也可能是我們在新加坡、德國的火山雲或谷歌雲。

整個決策過程,都會在我們的統一控制枱上進行可視化的管理和干預,包括成本調度、質量調度、故障分析等等。通過這套架構,我們實現了對全球流量的“宏觀調控”。

在眾多調度策略中,有一個非常有效的成本調度策略,就是“公有云調度自建機房”。

它的核心原理,其實就是利用了不同資源的計費模型差異。大家知道,公有云是按流量計費,用多少算多少;而我們的自建IDC,是按帶寬峯值計Fèi,就像包月套餐。

那麼,這裏就有了一個巨大的優化空間。大家看這張圖,我們的監控系統會實時採集自建IDC的帶寬用量。當發現IDC處於帶寬低谷時,比如凌晨,流量很少,帶寬大量閒置,非常浪費。

這時,我們的調度決策系統就會自動執行切換,通過DNS解析或者CDN源站變更,把一部分原本跑在公有云上的流量,調度到我們閒置的自建IDC上來。

這個“削峯填谷”的動作,效果非常顯著:公有云調度到IDC的流量佔比超過了60%,每年為我們節省了數百萬的流量成本!

四、總結與展望

通過“撥測監控”和“融合流量管理平台”的這一系列實踐,我們取得了哪些顯著的成效呢?

- 首先,在統一納管上,我們屏蔽了底層供應商的差異,對外提供了一致的接口能力,大大提升了運維效率。

- 其次,在提升質量上,我們為核心業務,比如應用商店,帶來了整體下載速度超過2%的提升,這對用户體驗是實實在在的改善。

- 第三,在降低成本上,我們通過一系列智能調度手段,實現了CDN和公網帶寬的千萬級降本,這是非常可觀的經濟效益。

- 最後,也是最重要的,我們實現了營收增效!質量的提升和成本的優化,最終轉化為了商業化運營收入的顯著提升!

我們的探索和實踐還在路上,接下來,我們主要有三個發展方向:

- 第一,是AI驅動的深度優化。我們將引入更強大的AI能力,去實現更精準的流量預測和更智能的異常自愈。

- 第二,是多雲/混合雲流量管理的持續深化。我們會將當前的成功經驗,擴展到更廣闊的海外市場,為公司全球化的出海業務保駕護航。

- 第三,也是我們認為極具價值的一點,是打通網絡質量和業務指標的關聯。我們要建立起業務增長和網絡指標的關聯分析能力,用數據證明每一次網絡優化,是如何實實在在地為業務收入增長賦能的!