moe(混合專家模型)

作為一種基於 Transformer 架構的模型,混合專家模型主要由兩個關鍵部分組成:

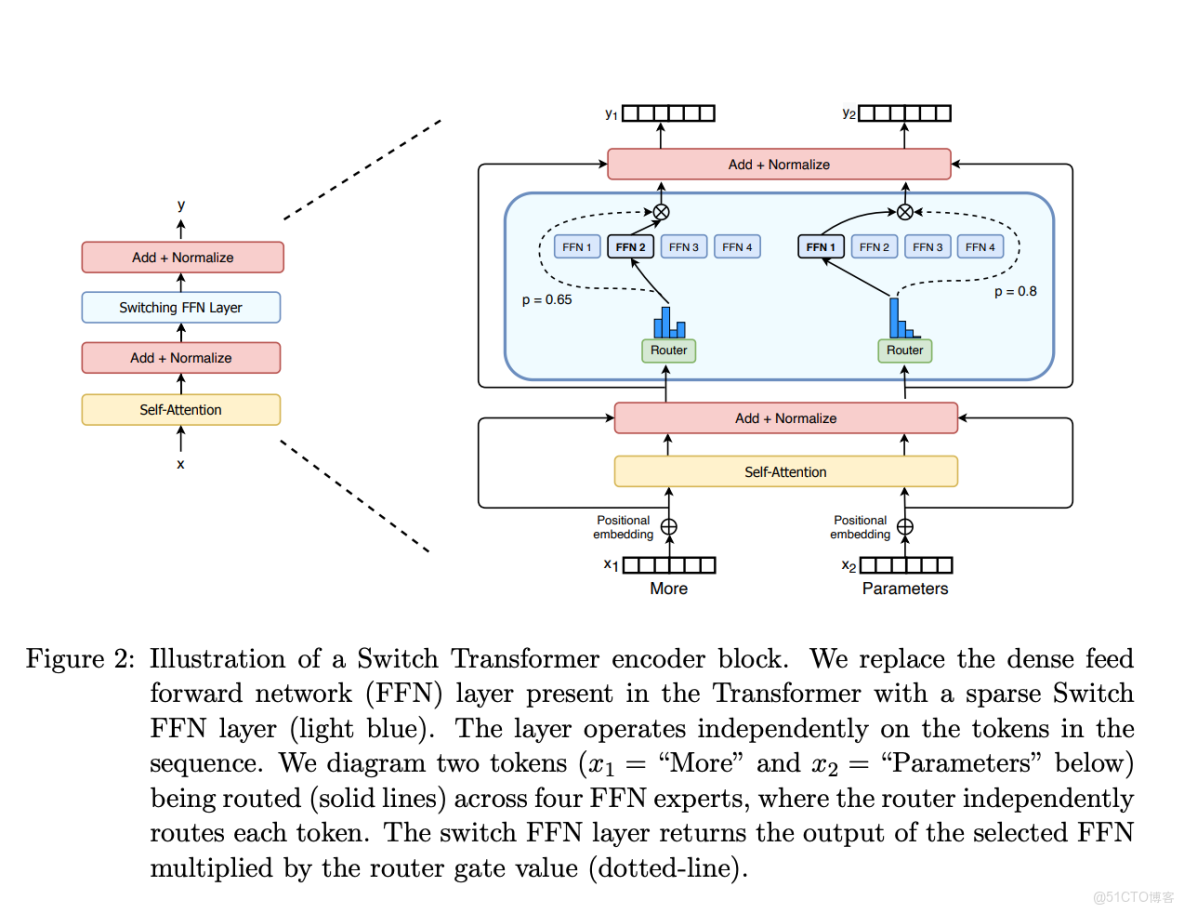

- 稀疏 MoE 層: 這些層代替了傳統 Transformer 模型中的前饋網絡 (FFN) 層。MoE 層包含若干“專家”(例如 8 個),每個專家本身是一個獨立的神經網絡。在實際應用中,這些專家通常是前饋網絡 (FFN),但它們也可以是更復雜的網絡結構,甚至可以是 MoE 層本身,從而形成層級式的 MoE 結構。

- 門控網絡或路由: 這個部分用於決定哪些令牌 (token) 被髮送到哪個專家。例如,在下圖中,“More”這個令牌可能被髮送到第二個專家,而“Parameters”這個令牌被髮送到第一個專家。有時,一個令牌甚至可以被髮送到多個專家。令牌的路由方式是 MoE 使用中的一個關鍵點,因為路由器由學習的參數組成,並且與網絡的其他部分一同進行預訓練。

moe 架構圖:

moe參數計算

一、先理清Mixtral 8x7B的參數構成:為什麼是47B而非56B?

MoE模型的參數並非“所有部分都獨立拆分”,而是“共享基礎層 + 獨立專家層(FFN) ”的混合結構,這是理解參數總量的關鍵:

- 核心定義:Mixtral 8x7B的“8x7B”是“8個專家,每個專家的參數規模等效7B稠密模型”,但僅FFN層(前饋神經網絡層) 是8個專家獨立擁有的,其他層(如注意力層、歸一化層、嵌入層)是所有專家共享的。

- 參數計算邏輯:

- 先看7B稠密模型的參數分佈:7B參數中,FFN層佔比約60%-70%(行業常規比例,以60%為例),即7B×60%≈4.2B/專家;

- 8個專家的獨立FFN參數:8×4.2B≈33.6B;

- 共享層參數(非FFN部分):7B - 4.2B≈2.8B(這部分不隨專家數量增加而增加);

- 總參數≈33.6B(獨立FFN)+ 2.8B(共享層)≈36.4B?——不對,實際Mixtral 8x7B的等效稠密參數是47B,本質是“7B專家的FFN佔比更高”(約77%):

7B×77%≈5.39B/專家 → 8×5.39B≈43.1B(獨立FFN)+(7B-5.39B)≈3.61B(共享層)≈46.7B,四捨五入為47B。

- 關鍵結論:MoE的“總參數”不是“專家數×單專家參數”的簡單乘積,而是“獨立專家層參數 + 共享層參數”,因此Mixtral 8x7B是47B而非56B。

二、推理速度:為什麼等效12B稠密模型,而非14B?

MoE推理速度快的核心是“每個令牌只激活部分專家”,Mixtral的規則是“每個令牌激活2個專家”,但需注意“共享層不重複計算”:

- 稠密模型的計算邏輯:推理時,所有層(注意力、FFN、歸一化)都要對每個令牌計算,比如12B稠密模型,每個令牌要完成12B參數對應的所有FLOPs(浮點運算次數)。

- MoE的計算邏輯:

- 共享層:注意力、歸一化等共享層,對每個令牌只計算1次(和7B稠密模型的共享層計算量一致,因為共享層參數是7B的非FFN部分);

- 專家層(FFN):每個令牌只激活2個專家的FFN層,即計算“2個專家的FFN參數”(而非8個)——2×(7B中的FFN參數≈5.39B)≈10.78B;

- 總計算量等效:共享層(≈3.61B)+ 激活的FFN層(≈10.78B)≈14.39B?——但實際等效12B,原因是“FFN層的計算佔比更高,且共享層的計算量可被優化抵消”:

稠密模型中FFN層是計算密集型核心(佔總FLOPs的70%以上),MoE的計算量主要由“激活的FFN”決定:2個專家的FFN計算量≈2×(7B稠密模型的FFN FLOPs),而7B稠密模型的FFN FLOPs≈7B×0.7(佔比)≈4.9B,2×4.9B≈9.8B;再加上共享層的少量計算(≈7B×0.3≈2.1B),總FLOPs≈11.9B,接近12B,因此説“推理速度類似12B稠密模型”。

- 關鍵結論:MoE推理速度由“激活的專家數×單專家FFN計算量 + 共享層計算量”決定,而非總參數;Mixtral因“激活2個專家+共享層優化”,計算量等效12B稠密模型,比47B總參數的稠密模型快得多。

三、內存需求:為什麼需要容納47B參數的VRAM?

這是MoE推理的核心挑戰——“參數全加載,不管用不用”:

- 內存的作用:推理時,模型的所有參數必須先加載到VRAM(顯存)中,才能進行計算(CPU內存速度太慢,無法支撐大模型實時推理);

- MoE的參數加載邏輯:雖然推理時只激活2個專家,但8個專家的所有FFN參數(≈43.1B)+ 共享層參數(≈3.61B)= 47B參數,必須全部加載到VRAM中——因為模型需要“隨時選擇激活哪2個專家”,無法提前預判並只加載部分專家參數(否則會因“參數缺失”導致推理錯誤);

- 對比稠密模型:如果是47B的稠密模型,推理時也需要加載47B參數到VRAM;但MoE的優勢是“加載47B參數,卻只做12B的計算量”,而稠密模型“加載47B參數,要做47B的計算量”——因此MoE在“相同內存佔用下,速度更快”,但代價是“內存佔用必須達到總參數規模(47B)”。

- 關鍵結論:MoE的“內存需求”由“總參數(共享層+所有專家層)”決定,而非“激活的參數”,因此Mixtral 8x7B需要能容納47B參數的VRAM(約需100GB+ VRAM,因參數需存儲為FP16/FP8格式,1個FP16參數佔2字節,47B×2≈94GB)。

四、總結:MoE推理的“矛盾與平衡”

|

維度

|

MoE(Mixtral 8x7B)

|

同參數稠密模型(47B)

|

同計算量稠密模型(12B)

|

|

參數總量 |

47B(共享層+8個專家FFN)

|

47B(全層稠密)

|

12B(全層稠密)

|

|

推理內存需求 |

高(需加載47B參數)

|

高(需加載47B參數)

|

低(僅需加載12B參數)

|

|

推理計算量(FLOPs) |

低(等效12B)

|

高(等效47B)

|

低(等效12B)

|

|

推理速度 |

快(計算量低)

|

慢(計算量高)

|

快(計算量低)

|

核心結論:MoE通過“參數全加載(高內存)換計算量減少(快速度) ”,解決了“大參數模型推理慢”的問題,但代價是“對VRAM的需求極高”——這也是當前MoE落地的主要瓶頸(需高顯存GPU或分佈式顯存技術)。

moe gate

一、MoE門控的核心邏輯:用“加權選擇”減少專家計算

MoE模型的輸出是門控網絡(G)對多個專家(E)的輸出做加權求和,公式是:

- 門控網絡(G)的作用:決定“哪些專家參與計算”——如果G(x)的某一項為0,對應的專家就不用計算,從而節省資源。

二、典型門控機制:Softmax+Top-K+噪聲

門控網絡不是簡單的“選專家”,而是通過3步實現“稀疏激活+負載均衡”:

- 基礎門控:Softmax網絡

門控網絡是一個帶Softmax的簡單網絡,學習給不同專家分配權重:

��(�)=Softmax(�⋅��) - 優化門控:帶噪聲的Top-K門控(Noisy Top-K Gating)

為了更高效地稀疏激活、同時避免專家“忙閒不均”,引入了3步操作:

- 加噪聲:給門控輸出加隨機噪聲,避免少數專家被過度選擇(負載均衡):

�(�)�=(�⋅��)�+StandardNormal()⋅Softplus((�⋅�noise)�) - 選Top-K:只保留權重前K個的專家(其他設為-∞,後續Softmax後權重接近0),實現“只激活少數專家”:

是的前個元素否則是的前個元素否則KeepTopK(�,�)�={��if ��是�的前�個元素−∞否則 - 再Softmax:對Top-K後的結果做Softmax,得到最終專家權重:

�(�)=Softmax(KeepTopK(�(�),�))

三、關鍵特性與作用

- 省計算:選小K值(比如1-2),只激活少數專家,訓練/推理速度比激活所有專家快很多;

- 負載均衡:加噪聲避免“少數專家被頻繁調用、多數閒置”;

- 路由有效性:至少選2個專家,讓門控網絡學會更合理的“輸入-專家”匹配(Switch Transformers驗證了這一點)。

簡單説:MoE用“門控+Top-K+噪聲”,既實現了“少算專家省資源”,又解決了“專家忙閒不均”的問題,是大模型提升性能同時控制成本的核心思路之一。

我把GShard中“輔助損失+負載均衡+推理邏輯”的核心概念整理成了清晰的邏輯清單,方便你快速串聯所有要點:

GShard-MoE 中的負載均衡機制

一、負載均衡:“軟約束+硬限制+隨機化”的組合拳

|

方法

|

核心邏輯

|

作用

|

與輔助損失的關係

|

|

輔助損失

|

給門控網絡加損失項,強制門控給所有專家分配的權重更平均

|

軟約束:讓門控“傾向”公平分配樣本

|

基礎約束,避免門控天然偏好少數專家

|

|

隨機路由

|

第1專家選Top1,第2專家按權重比例隨機選(非固定Top2)

|

強化公平:用隨機性打破“固定Top2”的傾斜

|

補充輔助損失的“軟約束”,增加分配的隨機性

|

|

專家容量

|

給每個專家設“最大令牌數閾值”,超容量的令牌溢出/丟棄

|

硬限制:適配靜態計算+限制單專家負載

|

從資源上限角度,配合輔助損失實現“軟硬均衡”

|

二、推理效率:“共享層+部分激活”實現“大參數低資源運行”

- 共享計算:自注意力層是所有專家共用的(參數只加載+計算一次);

- 專家計算:Top-2門控僅激活2個專家的FFN層(47B模型中,2個專家的FFN參數≈10B);

- 最終效果:47B總參數的MoE模型,推理時實際計算量僅等效12B稠密模型(共享層≈2B + 激活專家FFN≈10B)。

三、關鍵結論

GShard通過“輔助損失(軟約束)+ 隨機路由(隨機化)+ 專家容量(硬限制)”解決了MoE的負載不均問題,同時用“共享層+部分激活”實現了“大參數模型用小資源高效推理”,是MoE落地的核心工程方案之一。

Switch Transformers:解決MoE“穩定性+效率”的升級版方案

它是MoE模型的工程化優化版本,核心是用“單專家路由+混合精度+動態容量”,既提升訓練效率,又解決MoE的訓練不穩定問題。

一、核心創新:“單專家路由”替代Top-2,大幅降本提效

- 對比GShard的Top-2路由:GShard選2個專家,而Switch Transformers只選1個專家(“Switch”即“二選一”的開關邏輯)。

- 帶來的優勢:

- 降計算負擔:門控網絡只需選1個專家,計算量比Top-2少一半;

- 減通信成本:激活的專家數從2個變1個,多設備間傳輸的張量數據量減少;

- 提批量效率:每個專家的令牌批量至少能翻倍(因為1個專家承接更多樣本),計算硬件的利用率更高。

- 關鍵前提:單專家路由沒有降低模型質量——這是Switch Transformers最核心的突破(之前普遍認為“至少選2個專家才能保證性能”)。

二、負載均衡:簡化輔助損失+動態專家容量

- 簡化輔助損失:

不再用複雜的約束項,而是給每個Switch層加一個“輕量輔助損失”,直接鼓勵門控把樣本均勻分配給所有專家(超參數可調權重),既實現負載均衡,又避免損失函數過於複雜導致訓練不穩定。 - 動態專家容量:

容量公式為專家容量 = (每批次令牌數/專家數) × 容量因子,且容量因子可以動態調整(根據訓練/推理的計算資源靈活變):

- 低容量因子(1~1.25):減少設備間通信成本,適配小資源場景;

- 動態調整:訓練時根據計算負載調大/調小,平衡效率與穩定性。

三、混合精度訓練:平衡“速度”與“穩定性”

- 矛盾點:用低精度(如bfloat16)能減內存/通信成本,但門控的Softmax等操作對精度敏感,容易訓練崩潰。

- 解決方案:“專家用低精度,路由用全精度”:

- 專家的FFN層用bfloat16訓練(降成本);

- 門控的路由計算用全精度(保證Softmax等操作的穩定性)。

- 效果:既實現了訓練加速,又避免了低精度導致的不穩定,且模型質量沒有下降。

四、價值總結

Switch Transformers是MoE落地的關鍵里程碑:

- 用“單專家路由”打破了“多專家才能保性能”的認知,大幅降低MoE的訓練/推理成本;

- 用“簡化輔助損失+混合精度”解決了MoE的訓練不穩定問題;

- 最終實現“1.6萬億參數模型用更低資源訓練/運行”,推動大模型向“大參數+高效能”方向發展。

專家的數量對預訓練有何影響?

增加更多專家可以提升處理樣本的效率和加速模型的運算速度,但這些優勢隨着專家數量的增加而遞減 (尤其是當專家數量達到 256 或 512 之後更為明顯)。同時,這也意味着在推理過程中,需要更多的顯存來加載整個模型。值得注意的是,Switch Transformers 的研究表明,其在大規模模型中的特性在小規模模型下也同樣適用,即便是每層僅包含 2、4 或 8 個專家。

MoE模型微調

一、核心結論:MoE微調的“特殊性”(對比稠密模型)

1. 過擬合:稀疏模型更“嬌氣”,正則化要更狠

- 稠密模型過擬合可通過常規dropout、權重衰減解決;

- MoE模型因“專家層稀疏激活”,數據分佈更集中(少數專家承接大量樣本),更容易過擬合→需針對性優化:

✅ 給稀疏層(專家FFN層)設更高的dropout率(稠密層用低dropout);

✅ 令牌丟棄(訓練中主動丟部分令牌)也是一種正則化,即使丟11%令牌,模型性能也不會明顯下降。

2. 輔助損失:不是“可有可無”,而是“場景化使用”

- ST-MoE作者發現:預訓練/簡單微調時關輔助損失影響小(令牌丟棄可替代其正則化作用);

- 指令微調時:開輔助損失能有效防止過擬合,且MoE從輔助損失中獲益比稠密模型更多。

3. 任務適配:MoE“挑任務、挑數據量”

- 小任務/小數據集:MoE過擬合嚴重,驗證集表現遠差於稠密模型;

- 大任務/大數據集:MoE優勢拉滿(尤其是知識密集型任務如TriviaQA);

- 任務類型:重理解任務(如SuperGLUE)稠密模型更穩,知識型任務MoE更優。

二、實操策略:MoE微調的“避坑指南”

1. 參數凍結:別凍非專家層,凍MoE層更划算

- 錯誤做法:凍結非專家層(注意力/嵌入層)→MoE層佔模型參數90%以上,僅訓專家層會導致性能暴跌;

- 正確做法:凍結MoE層(專家FFN層),只訓非專家層→效果幾乎和全參數微調一致,且:

✅ 顯存需求降一半(不用更新海量專家參數);

✅ 訓練速度大幅提升(計算量僅集中在共享層)。

2. 超參數:和稠密模型“反着來”

|

維度

|

稠密模型

|

MoE模型

|

|

批量大小

|

偏大(如64/128)

|

偏小(如16/32)

|

|

學習率

|

偏低(如1e-5)

|

偏高(如5e-5)

|

|

→ 核心邏輯:MoE專家層激活稀疏,小批量+高學習率能讓梯度更新更“聚焦”,避免專家層參數更新過慢/過穩。

|

3. 指令微調:MoE的“性能放大器”(關鍵突破)

- 普通微調:MoE性能不如同量級稠密模型(如T5);

- 指令微調(尤其是多任務指令微調):

✅ Flan-MoE(MoE的指令微調版本)性能遠超原始MoE;

✅ MoE從指令微調中獲益的幅度,比Flan-T5(稠密指令微調)遠超原始T5的幅度更大→指令微調是MoE發揮優勢的關鍵。

三、場景選擇:稀疏VS稠密,怎麼選?

|

維度

|

MoE模型(稀疏)

|

稠密模型

|

|

硬件條件

|

多機器、高顯存、高吞吐量需求

|

單卡/低顯存、低吞吐量

|

|

計算資源

|

固定預訓練算力下,效果更優

|

微調算力有限時更易落地

|

|

任務規模

|

大任務、大數據集、知識密集型

|

小任務、小數據集、重理解

|

|

參數量對比

|

無意義(計算邏輯不同)

|

參數量可直接對標性能

|

四、總結:MoE微調的核心邏輯

MoE不是“稠密模型的簡單擴容版”,而是“針對性適配的稀疏架構”:

- 微調時要抓住「強正則化+凍專家層+小批量高學習率+指令微調」四個關鍵點;

- 輔助損失要“按需開關”(小任務關、指令微調開);

- 場景上“揚長避短”:大算力、大任務、知識型場景用MoE,小算力、小任務、理解型場景用稠密模型。

moe 高效落地

一、核心痛點:MoE為啥“先天低效”?

原始MoE的分支結構(多專家獨立計算)和GPU架構不匹配:

- 硬件適配差:GPU擅長規整的批量計算,但MoE令牌分配不均(專家間令牌數差異大),導致算力利用率低;

- 通信瓶頸:令牌需跨節點傳輸到對應專家,網絡帶寬成為性能天花板;

- 顯存浪費:所有專家參數都要加載,且激活值存儲需求隨容量因子升高而暴漲。

二、第一步:並行計算——選對“專家並行”,打牢效率基礎

MoE的效率提升,核心是“把專家和數據放到合適的節點上”,先理清四種並行的差異:

|

並行類型

|

核心邏輯

|

適配場景

|

MoE關鍵價值

|

|

數據並行

|

權重全複製,數據拆分成批次

|

小模型/單專家

|

無(MoE用數據並行會浪費顯存)

|

|

模型並行

|

模型拆層,數據全複製

|

超大單模型(如千億稠密)

|

無(MoE層內專家拆分不適用)

|

|

模型+數據並行

|

層拆到節點,數據拆批次

|

超大規模稠密模型

|

適配性差(專家層無法拆層)

|

|

專家並行

|

專家分節點,數據拆批次

|

MoE專屬(核心!)

|

1. 每個節點只存部分專家參數;

2. 令牌只傳給對應專家節點,減少通信

|

✅ MoE最優並行策略:專家並行+數據並行結合

- 非MoE層(注意力/嵌入):用數據並行(和稠密模型一致);

- MoE層(專家FFN):用專家並行(每個節點放1個專家,數據拆批次分給節點);

- 效果:既避免專家參數重複存儲,又減少跨節點令牌傳輸量。

三、第二步:成本平衡——容量因子(CF)是“效率調節閥”

容量因子(專家能處理的最大令牌數/理論平均令牌數)是MoE性能與成本的核心權衡點:

- 容量因子越高:

✅ 優點:令牌丟棄少,模型性能好(ST-MoE驗證丟11%令牌不影響,但更高丟棄會降效);

❌ 缺點:顯存佔用暴增(要存更多激活值)、跨節點通信量上升(更多令牌需傳輸); - 容量因子越低:

✅ 優點:通信/顯存成本低,適配帶寬有限的硬件;

❌ 缺點:令牌丟棄多,性能可能下降; - 實操初始配置:Top-2路由 + CF=1.25 + 單節點1個專家

- 先按這個基線跑,再根據“通信延遲/顯存佔用/模型性能”三角平衡調整:

- 帶寬夠、顯存足→調升CF(如1.5);

- 帶寬窄、顯存緊→調降CF(如1.0)。

四、第三步:部署提速——把大MoE“變小”,適配落地場景

針對MoE參數規模大、部署難的問題,三種核心技術直接降低落地成本:

|

部署技術

|

核心邏輯

|

效果

|

適用場景

|

|

預先蒸餾

|

把MoE知識蒸餾到同架構稠密模型

|

保留30-40%稀疏性增益,模型體積大幅縮小

|

本地部署/低顯存場景

|

|

任務級別路由

|

路由器直接把整句/任務分給1個專家

|

提取“子網絡”(僅保留任務相關專家),簡化結構

|

單任務推理(如專屬問答)

|

|

專家網絡聚合

|

合併多個專家的權重

|

推理參數量減少,無需加載所有專家

|

通用推理/吞吐量要求高的場景

|

✅ 實操優先級:預先蒸餾 > 專家聚合 > 任務路由(蒸餾性價比最高,適配絕大多數場景)。

五、第四步:訓練加速——從“硬件適配”到“算法重構”

兩大核心方案解決MoE訓練的“動態性”和“低效計算”問題:

1. FasterMoE(系統級優化):榨乾硬件性能

- 核心創新:

① 細粒度通信調度:讓令牌傳輸和計算重疊(邊算邊傳,不浪費時間);

② 拓撲感知門控:根據節點間網絡延遲選專家(優先選延遲低的節點的專家); - 效果:訓練速度提升17倍(從“硬件等數據”變成“數據追硬件”)。

2. Megablocks(算法級重構):適配GPU的稀疏計算

- 核心痛點:傳統MoE用批量矩陣乘法,要求所有專家處理的令牌數相同,令牌分配不均時算力浪費嚴重;

- 解決方案:把MoE層重構為“塊稀疏矩陣乘”:

✅ 不丟棄任何令牌,按令牌實際分佈拆成“塊”,每個塊分配給對應專家;

✅ 適配GPU的塊稀疏計算架構,即使專家間令牌數差異大,也能高效計算; - 效果:徹底解決令牌分配不均的低效問題,稀疏預訓練效率大幅提升。

六、總結:讓MoE“起飛”的核心邏輯

MoE的效率提升不是“單點優化”,而是“並行架構打底 + 容量因子平衡成本 + 部署技術降規模 + 訓練技術適配硬件”的組合拳:

- 基礎層:用專家並行+數據並行,解決通信和顯存的先天瓶頸;

- 平衡層:調優容量因子,在性能和成本間找最優解;

- 落地層:用蒸餾/聚合縮小模型,適配實際部署場景;

- 加速層:用FasterMoE/Megablocks解決訓練的硬件適配問題。