操作指南

操作指導

AI平台 國內直接訪問地址:https://sass.xiaoxuzhu.cn/**點擊【新系統登錄】**註冊後登錄即可。

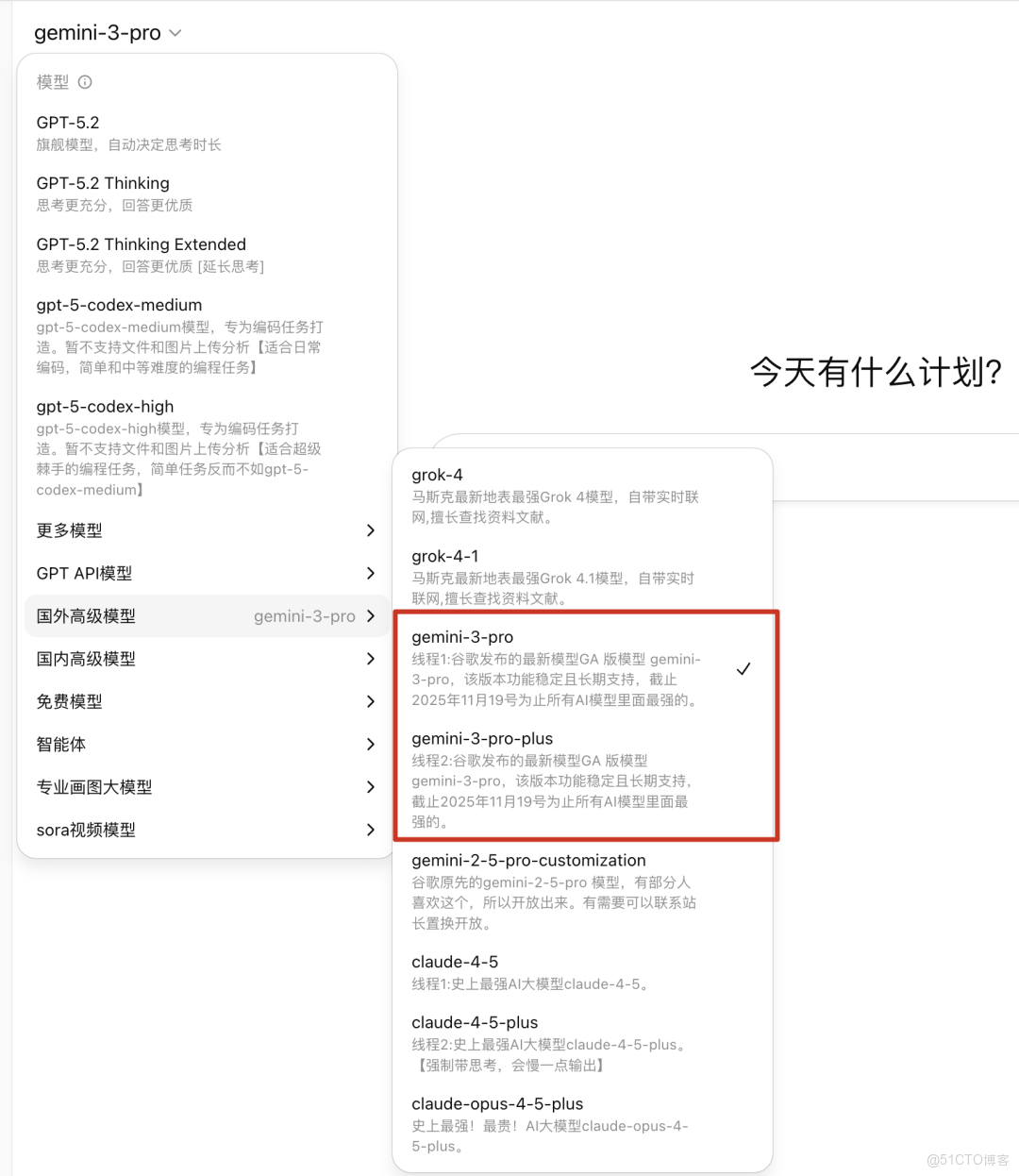

選擇gemini-3-pro大模型

現在的科研越來越“卷”,不僅要看得多,還得處理得快。最近 Google DeepMind 推出的 Gemini 3.0 pro,在海量文獻處理和原生多模態數據理解上確實亮眼👍。它的優勢,主要在下面這 三個典型科研場景裏體現得最明顯:

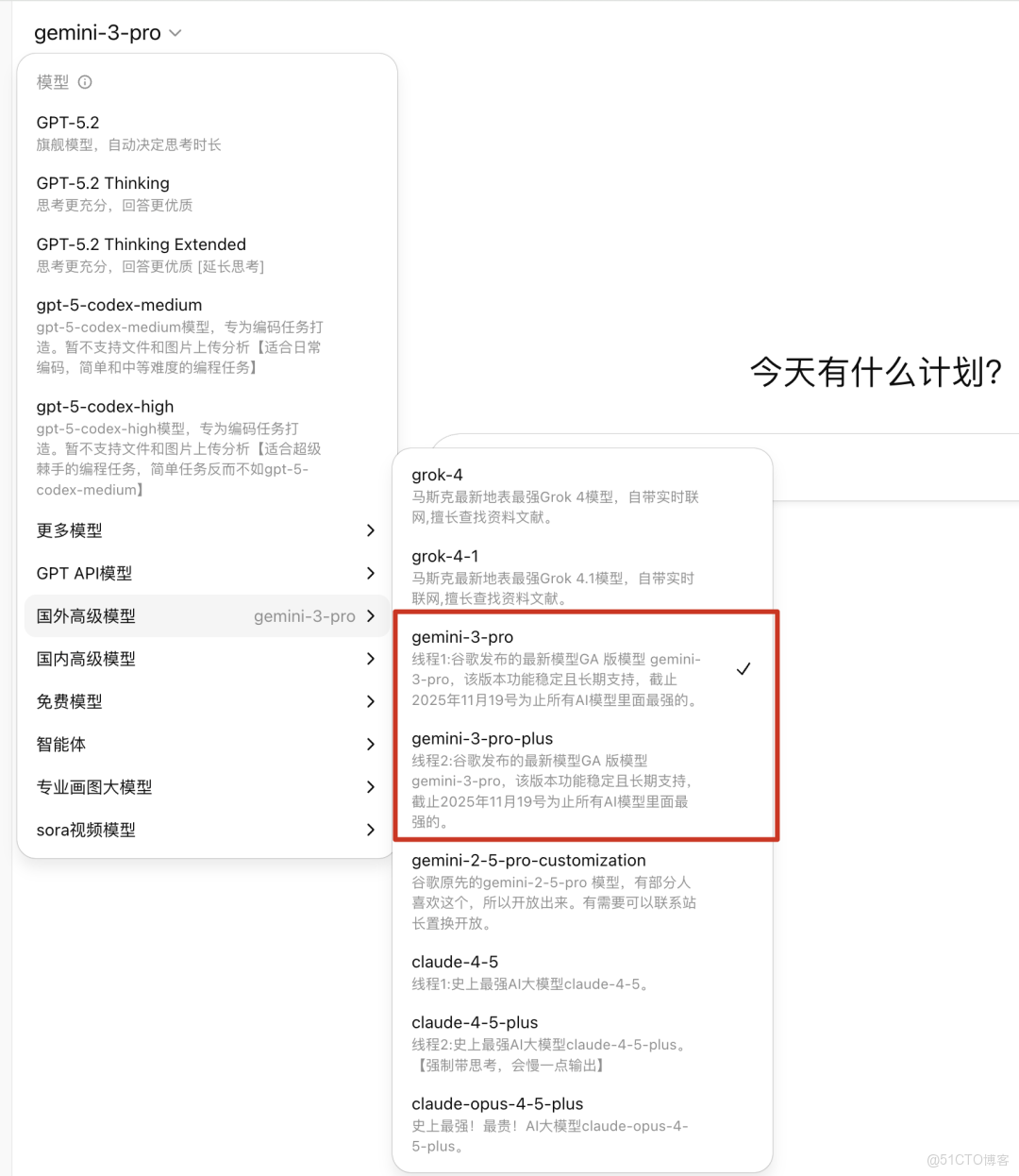

1. 海量文獻的並行分析與跨文檔關聯

以前做元分析或者寫大型綜述,最頭疼的就是文獻量📚——動不動幾百篇,全靠人工梳理,真的是體力+耐心雙重消耗。現在情況不一樣了。Gemini 3.0 的 2M+ Token 超大上下文,直接把玩法改了。它可以把幾百篇論文一次性“裝進腦子裏”,在同一個上下文裏做並行分析。(小提醒一下:對話框一次最多傳 10 個文件,但可以分批傳,模型會記住整個對話裏的內容 👍)我們做過一次實測:

把近五年 300 多篇關於「ESG 評級對企業財務績效影響」的 PDF 文獻,分批餵給 Gemini 3.0 pro。結果是——模型很快就把全量內容消化完了。關鍵不在“讀得快”,而在讀得懂、還能對比。

和傳統只會做關鍵詞檢索不同,它能跨文檔做深度比對,直接揪出論文之間的分歧點。比如模型就發現了一個很有意思的衝突👇

- 多數針對歐美市場的研究(比如 Smith et al., 2023)認為:ESG 評級和 ROE 是正相關的

- 但在第 15 批上傳的、新興市場相關文獻裏(Zhang et al., 2024),卻明確指出二者存在負相關,原因是合規成本過高反而拖累了績效

這種全局視角的關聯分析,真的很強。

它能幫你迅速跳出“只看單篇論文”的侷限,直接鎖定研究爭議點和空白區🎯,對提升綜述深度和研究效率,幫助非常大。如果你平時也被文獻綜述折磨過,這一套真的值得關注 👀✨

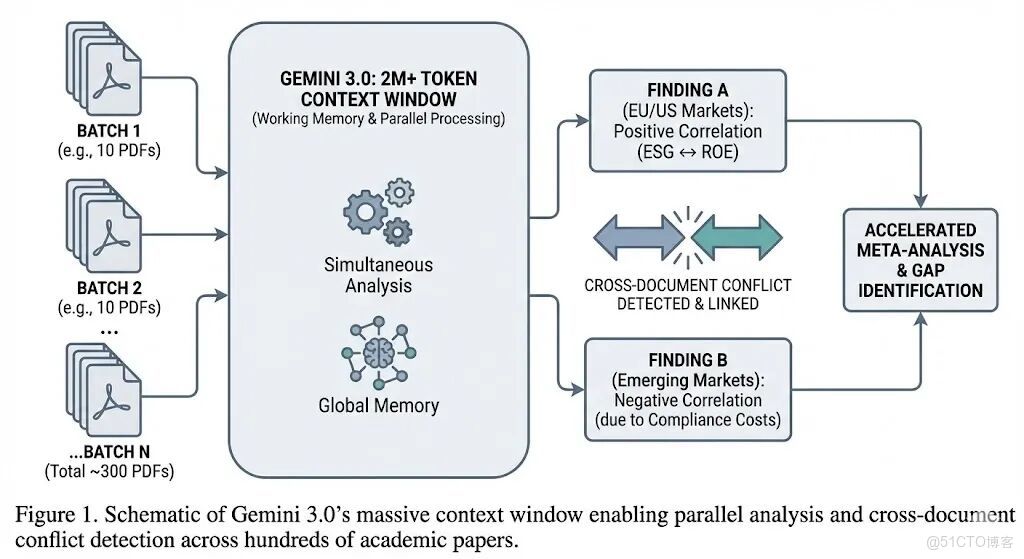

2. 原生多模態數據的直接理解(視頻與圖像)

Gemini 3.0 真正拉開差距的地方,其實就一個詞:原生多模態。

説白了,它終於不再“拐彎抹角”了。以前你要讓模型分析視頻,得先拆幀;看圖表,得先 OCR 成文字;流程又長又碎。而 Gemini 3.0 是直接對着原始音視頻和圖片本體開幹,就像一個真正坐在你旁邊一起看資料的研究員 👀。

1️⃣ 視頻分析:連“肢體語言”都不放過

在管理學、社會學這種定性研究裏,焦點小組訪談視頻一直是體力活。

30 分鐘視頻,光是反覆看、做編碼就能把人耗空 😵💫。我們實測上傳了一段未剪輯的 30 分鐘消費者新品體驗訪談。結果 Gemini 3.0 看完之後,直接幫我們把“編碼(Coding)”這一步做了,還給的是結構化日誌。比如它會明確指出:

- 12:15 討論定價策略時,受訪者 A 雖然嘴上説能接受,但雙臂交叉、身體後仰,是典型的防禦姿態,真實接受度可能並不高

- 18:40 受訪者 B 頻繁點頭、身體前傾,參與感明顯更強(High Engagement)

這種分析,已經不只是“聽懂你説了什麼”,而是開始判斷你到底信不信自己説的話了 🤯。

2️⃣ 圖像分析:不只是識字,而是真正“看懂圖”

再看圖像這塊,尤其是金融場景,差距更明顯。我們上傳了一張包含 K 線、均線、MACD 的技術分析圖。

Gemini 3.0 不只是把圖上的數字讀出來,而是直接按技術分析的邏輯來解讀:

股價觸及布林帶上軌後出現明顯的量價背離,同時底部 MACD 即將形成死叉,這通常是短期趨勢反轉的信號,需要警惕回調風險。

注意這裏的重點👇

它不是“圖上有什麼”,而是**“這張圖意味着什麼”**。

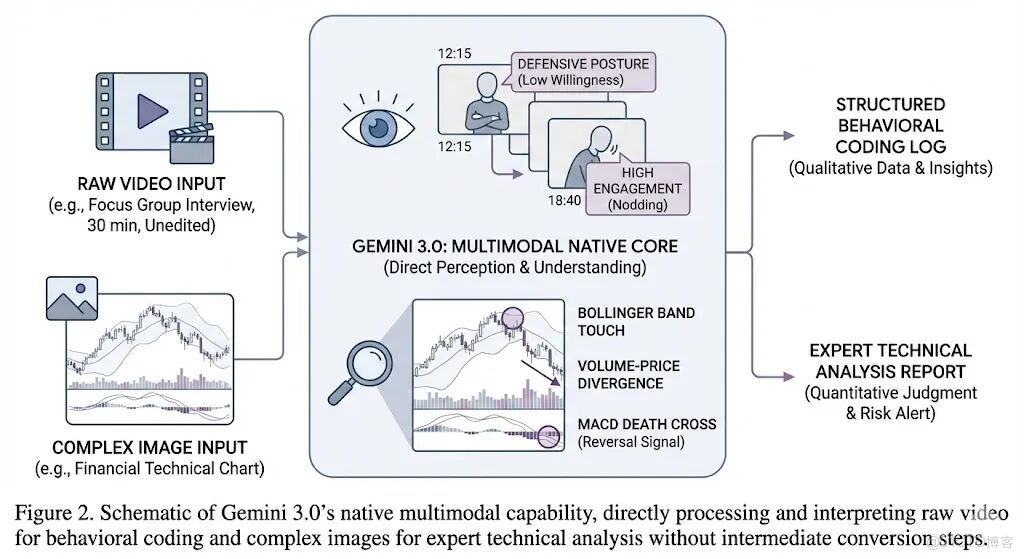

3. 與 Google Scholar 的實時整合與事實核查

説實話,大模型最要命的問題,其實就一個:看起來很專業,結果在胡編 🤦♂️——比如張口就來一篇根本不存在的論文,這就是大家常説的“幻覺”。在這點上,Gemini 3.0算是目前做得最穩的之一。背後靠的是 Google 超大的學術索引。它不是隻憑訓練數據“腦補答案”,而是可以實時去 Google Scholar 裏核對,把生成內容和真實文獻對上號。👉 舉個真實場景:

寫一份關於**“量化寬鬆(QE)是否加劇收入不平等”**的政策簡報。如果用傳統模型,很可能會給你編一個看着特別真的引用,比如 “Smith et al., 2015” 📄——但你一查,根本不存在。而 Gemini 3.0 的做法是:

每一個論點,直接掛原始文獻鏈接。

比如它提到:

Piketty(2014)認為,資本回報率長期高於經濟增長率,是不平等加劇的核心原因

你可以當場點進去,直達 Google Scholar 頁面,甚至 PDF 原文。有沒有這本書、是不是他説的,一眼就能驗證。這一步,其實非常關鍵:

👉 AI 不再只是“寫東西的”,而是變成了“幫你查證的”

從內容生成器,升級成了事實核查員(Fact-checker)✅所以總結一句話👇

如果你是做科研的,需要快速掃文獻、分析圖像/視頻實驗數據,或者短時間搭建一個新領域的知識框架,那 Gemini 3.0 現在確實是一個效率非常高、踩坑概率很低的選擇 🚀

附:可直接使用的 Prompt 示例

請注意,使用以下提示詞時,需要利用 Gemini 3.0 的長文本和多模態文件上傳功能。場景一:跨文檔衝突檢測與綜述(需上傳多篇 PDF)

Prompt:"我已上傳了 10 篇關於[特定研究領域,例如:鋰離子電池固態電解質界面]的文獻。請閲讀所有文檔,並執行以下任務:

- 總結這 10 篇文獻中主流的 3 種實驗方法。

- 重點找出這些文獻在結論上存在的矛盾點或不一致之處,並指明是哪幾篇文獻之間存在衝突(例如:文獻 A 的數據不支持文獻 B 的假設)。

- 基於這些文獻,生成一個包含關鍵進展的時間軸綜述草稿。"

場景二:實驗視頻行為學分析(需上傳視頻文件)

Prompt:"請觀看這段 15 分鐘的[實驗對象,例如:斑馬魚]觀察視頻。請充當專業的行為學研究員,幫我統計以下數據並輸出為表格:

- 記錄對象進入[特定區域,例如:頂部對角線區域]的所有時間點及每次停留的時長。

- 識別並記錄所有[特定行為,例如:急速擺尾]發生的起始時間戳。

- 總結該對象在視頻後半段的整體活躍度變化趨勢。"

場景三:科學圖表深度解讀(需上傳圖像文件)

Prompt:"附件是一張[特定數據類型,例如:拉曼光譜]的實驗結果圖。請作為該領域的專家進行分析:

- 識別圖中所有的特徵峯位,並列出它們可能對應的化學鍵或官能團振動模式。

- 對比圖中樣品 A 和樣品 B 的譜圖差異,並解釋這種差異在材料結構上可能意味着什麼變化。

- 指出圖中數據是否存在明顯的異常或噪聲干擾。"

三、感受

好用的功能太多太多,我就不在這個一一列舉了,有興趣的可以自行嘗試。

有提供免費的授權碼可體驗~

有提供免費的授權碼可體驗~

有提供免費的授權碼可體驗~

私信虛竹哥,獲取體驗碼~ 國內可直接使用~

我是虛竹哥,目標是帶十萬人玩轉AI。