最近,國產大模型領域迎來兩個值得關注的新版本:智譜的 GLM-4.7 與 MiniMax 的 M2.1。它們不再以“生成一段流暢文字”為目標,而是聚焦於真實工程場景中的穩定輸出與持續協作能力。為了驗證這一點,我在本地開發環境中進行了完整測試——使用 VS Code 配合開源插件,通過AI Ping平台可限免調用這兩款模型,分別完成兩類典型任務。

本文將按操作流程記錄全過程:從平台接入、插件配置,到兩個模型的實際表現與能力邊界分析。所有步驟均可復現,代碼和指令均來自真實測試。

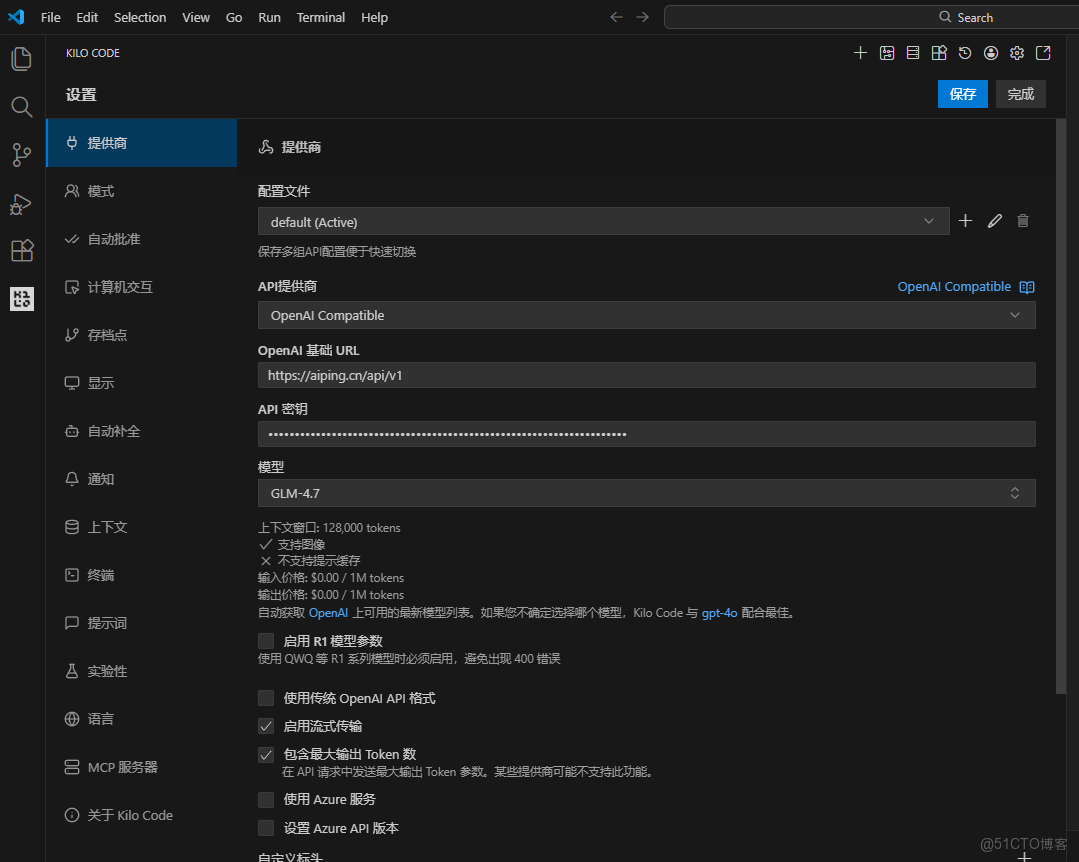

一、平台接入:獲取 API 地址與密鑰

AI Ping 是一個提供多模型統一調用接口的開放平台,支持包括 GLM、MiniMax、通義、百川等在內的多個國產模型。其最大優勢在於兼容 OpenAI 協議,這意味着開發者無需學習新 API,即可直接使用現有工具鏈。

註冊賬號後(目前無需實名),在控制枱可獲取兩項關鍵信息:

- Base URL:

https://api.aiping.cn/v1 - API Key:形如 "QC-***********" 的密鑰

這兩項配置適用於任何支持 OpenAI 格式的客户端。為安全起見,建議通過 .env 文件管理密鑰,避免提交到版本庫。

整個接入過程不到兩分鐘,且當前所有模型調用均為限免,降低了試錯成本。

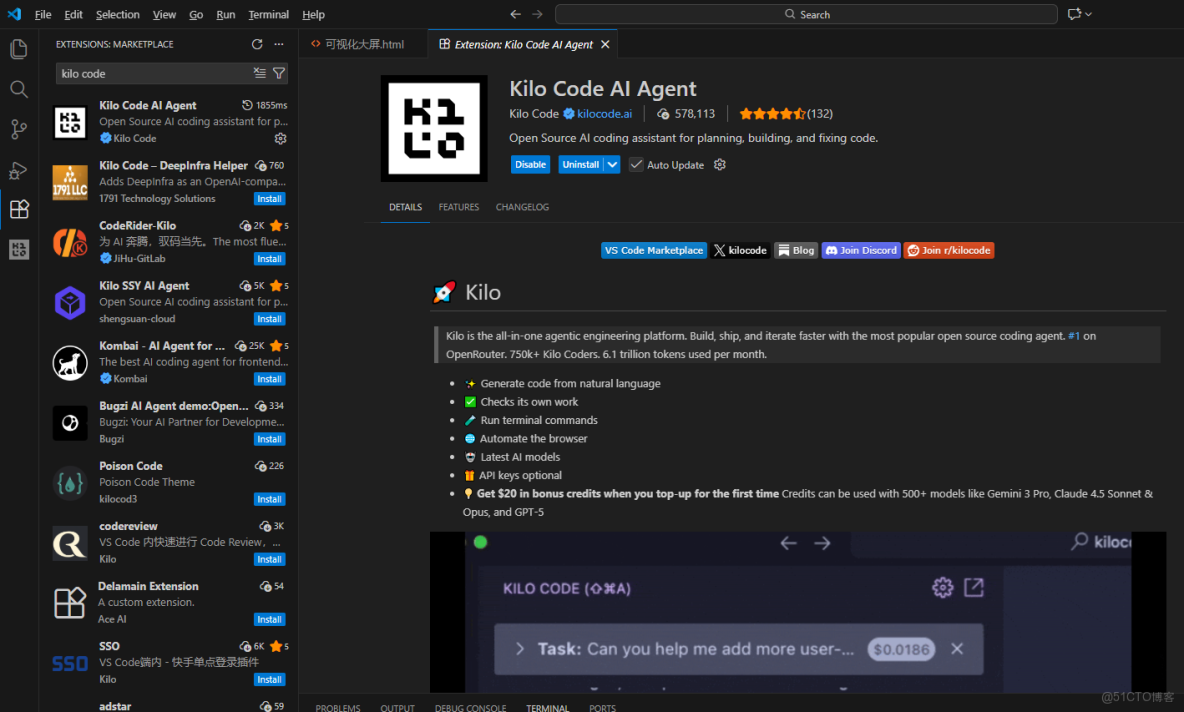

二、開發環境配置:安裝 Kilo Code 插件

為了更貼近日常開發流,我選擇使用 Kilo Code —— 一款開源的 VS Code AI Agent 插件(GitHub 可查)。它支持多步任務規劃、自動文件創建、模型切換等功能,適合測試模型在複雜任務中的協同能力。

安裝方式:

- 在 VS Code 擴展商店搜索 “Kilo Code”;

- 安裝後,在插件設置中添加自定義提供商;

- 填入上述 Base URL 與 API Key;

- 保存並重啓插件。

至此,本地環境已具備調用雲端大模型的能力,後續只需在插件界面選擇模型並輸入任務描述即可。

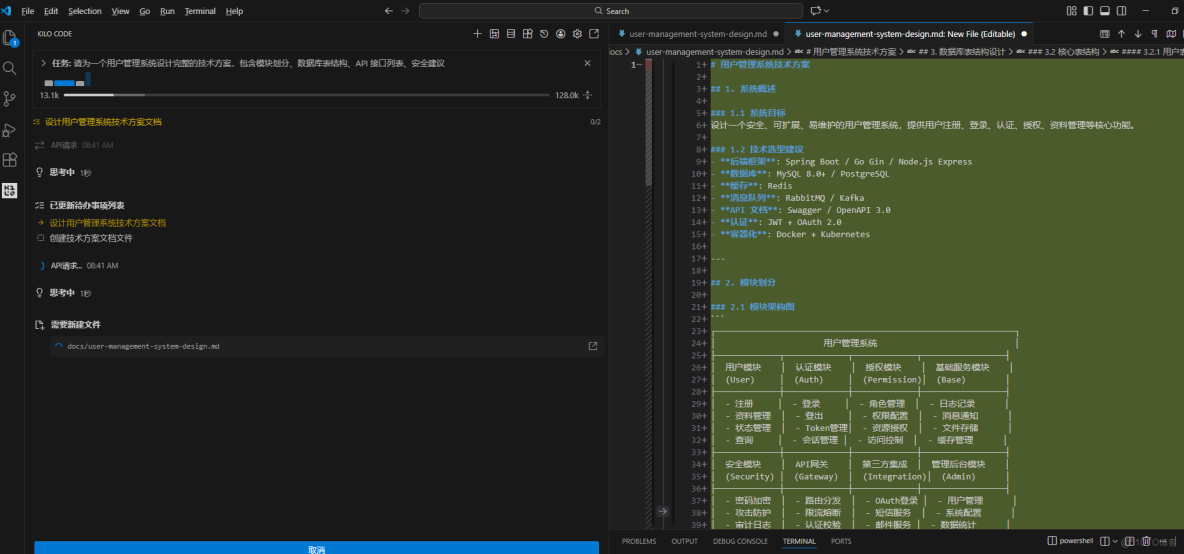

三、GLM-4.7 測評:面向複雜任務的一次性交付

測試目標

評估模型在系統設計類任務中的結構化輸出能力,以下為GLM-4.7 模型配置。

指令輸入

“請為一個用户管理系統設計完整的技術方案,包含模塊劃分、數據庫表結構、API 接口列表、安全建議。”

執行結果

選擇 glm-4.7 模型後,Kilo Code 自動創建 docs/ 目錄,並生成多個文件,包括系統概述、API 設計、數據庫腳本等。

輸出內容節選如下:

## 模塊劃分

- **Auth Module**:處理註冊、登錄、第三方綁定

- **Profile Module**:管理頭像、暱稱、個人資料

- **Security Module**:密碼策略、風控、審計日誌

## 數據庫表(users)

CREATE TABLE users (

id BIGINT PRIMARY KEY,

phone VARCHAR(16) UNIQUE,

email VARCHAR(255),

password_hash CHAR(60),

created_at TIMESTAMP,

updated_at TIMESTAMP

);

## API 列表

| 路徑 | 方法 | 功能 |

|------|------|------|

| /v1/auth/register | POST | 用户註冊 |

| /v1/auth/login | POST | 密碼登錄 |

## 安全建議

- 密碼使用 bcrypt 加密(cost=12)

- 登錄失敗 5 次後啓用圖形驗證碼

- 敏感操作記錄 IP 與設備信息能力分析

GLM-4.7 展現出較強的任務拆解與邏輯組織能力。它沒有停留在泛泛而談,而是輸出了可直接用於開發評審的結構化文檔。尤其在安全建議部分,提到了具體算法參數和風控閾值,體現出對工程細節的理解。

這類任務通常需要人工查閲資料、反覆修改,而模型一次性完成,顯著提升了前期設計效率。

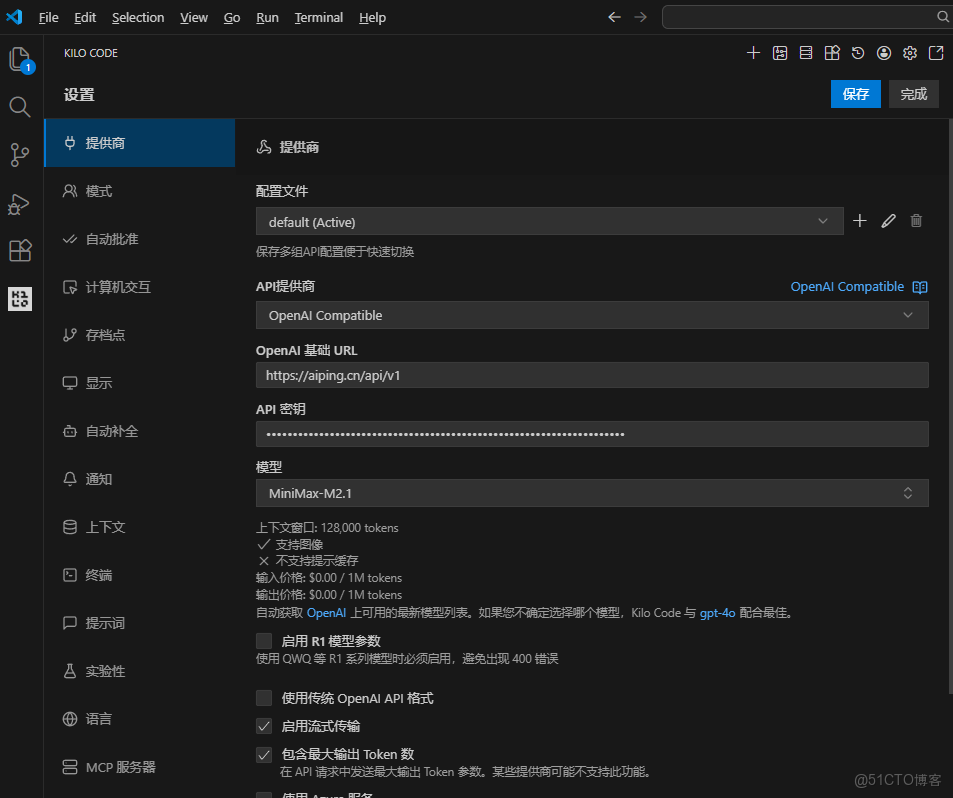

四、MiniMax M2.1 測評:多語言生產級代碼生成

測試目標

驗證模型在系統編程**語言**(如 Go)中的代碼生成質量,以下為MiniMax M2.1 模型配置。

指令輸入

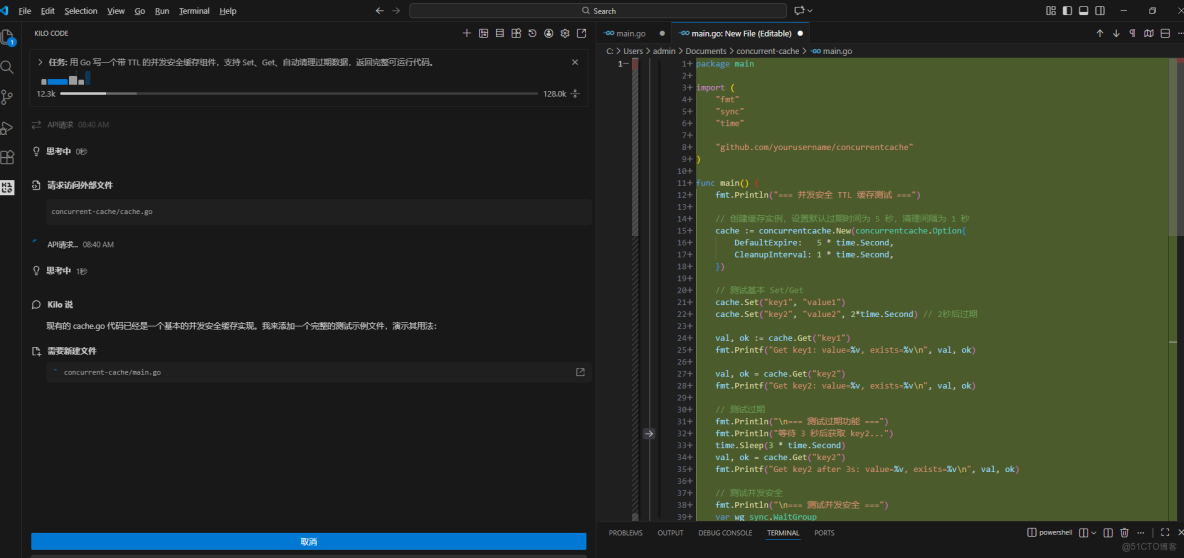

“用 Go 寫一個帶 TTL 的併發安全緩存組件,支持 Set、Get、自動清理過期數據,返回完整可運行代碼。”

執行結果

切換至 minimax-m2.1 模型後,Kilo Code 生成 concurrent-cache/cache.go 和對應的單元測試文件。

核心實現如下:

type Item struct {

value interface{}

expiration int64 // Unix nanoseconds

}

type Cache struct {

items map[string]Item

mutex sync.RWMutex

}

func (c *Cache) Set(key string, value interface{}, ttl time.Duration) {

c.mutex.Lock()

defer c.mutex.Unlock()

c.items[key] = Item{

value: value,

expiration: time.Now().Add(ttl).UnixNano(),

}

}

func (c *Cache) Get(key string) (interface{}, bool) {

c.mutex.RLock()

item, found := c.items[key]

c.mutex.RUnlock()

if !found {

return nil, false

}

if time.Now().UnixNano() > item.expiration {

// 惰性刪除:不主動清理,僅在訪問時判斷

return nil, false

}

return item.value, true

}能力分析

這段代碼有幾個值得注意的細節:

- 使用

sync.RWMutex實現讀寫鎖,保障併發安全; - 採用 Unix 納秒時間戳進行過期判斷,精度高;

- 採用“惰性刪除”策略,避免後台 goroutine 帶來的複雜性;

- 返回

(value, ok)模式,符合 Go 語言慣用法。

整體來看,代碼不僅語法正確,還遵循了 Go 社區的工程實踐,可直接集成進微服務項目,無需大幅重構。

這反映出 MiniMax M2.1 在系統級語言上的深度優化,尤其適合需要長期維護的 Agent 或自動化腳本場景。

五、模型對比:不同路徑,各自擅長

|

維度

|

GLM-4.7

|

MiniMax M2.1

|

|

核心優勢

|

複雜任務的結構化輸出

|

多語言生產代碼生成

|

|

適用角色

|

架構師、技術負責人

|

工程師、DevOps、Agent 開發者

|

|

推理特點

|

強邏輯、分步驟、重一致性

|

快速收斂、低冗餘、高吞吐

|

|

典型輸出

|

技術方案、設計文檔、流程説明

|

可編譯、可測試、可部署的代碼

|

|

上下文利用

|

擅長整合多維度需求

|

擅長保持代碼上下文連貫

|

兩者並非競爭關係,而是互補:

- 當你需要從模糊需求走向清晰方案,GLM-4.7 更可靠;

- 當你需要從設計走向實現,MiniMax M2.1 更高效。

六、總結:國產模型正在進入“可用”階段

通過本次測試,我確認了一個趨勢:國產大模型正從“演示型 AI”轉向“工程型助手”。GLM-4.7 和 MiniMax M2.1 分別在一次性交付與持續編碼兩個維度上展現出實用價值。

而像 AI Ping這樣的平台,則讓這種能力變得觸手可及——無需部署、無需付費、接口標準,普通開發者也能快速驗證模型是否適配自身業務。

如果你也在做系統設計、自動化開發或 Agent 構建,不妨親自試試。只需十幾分鍾配置,或許就能節省數小時重複勞動。