Reasoning 大模型

基本概述

Reasoning大模型特指 ”推理大模型“(Reasoning Large Language Model)是專門設計用於處理需要複雜推理任務的大型語言模型。

- 推理能力的定義:推理是指根據已知的信息和知識,通過邏輯推導得出新的結論或答案的過程。對於大模型而言,推理能力使其能夠處理不僅僅是簡單的事實查詢,還包括解決複雜的問題、進行邏輯推斷、數學計算、理解代碼等需要多步思考和分析的任務。

- 與常規大模型的區別:常規的大模型主要側重於對大量文本數據的學習和理解,以便生成流暢、自然的文本回應,但它們通常直接輸出最終的答案,而不展示中間的推理過程。而推理大模型在回答問題前,會先將問題拆解為更小的步驟,即推理步驟或思維鏈(Chain of Thought, CoT),然後將這些推理過程和最終答案一起輸出,使人們能夠看到模型的思考過程和邏輯推導路徑。

技術實現

要使得模型具備強大的推理能力,可以從如下3點(架構基礎、訓練方法和提示工程)進行技術實現:

- 架構基礎

- 推理大模型通常基於Transformer架構構建,這種架構能夠有效地處理長序列數據,並且在自注意力機制的幫助下,可以捕捉到輸入數據中的複雜依賴關係,為推理提供了良好的基礎。

自注意力機制(Self-Attention Mechanism)是Transformer架構中的一個核心部分。簡單來説,自注意力機制就像是給模型裝上了一雙“慧眼”,讓它能夠同時關注輸入數據中的所有部分,並自動判斷哪些部分更加重要。這樣,模型就能更好地理解數據的整體結構和內在聯繫。

就好比在閲讀一篇文章,當你讀到文章中的一個詞時,你的大腦會不自覺地回憶起與這個詞相關的其他詞或句子,幫助你更好地理解當前的內容。這就是一種注意力機制。 在推理大模型中,自注意力機制的工作方式與此類似。當模型處理一個句子時,它會檢查句子中的每個詞,並通過比較這些詞之間的關係來確定它們的重要性。例如,在處理句子“我喜歡在公園裏散步”時,模型會發現“我”和“喜歡”之間有很強的關聯,因為“我”是動作的執行者;同樣,“散步”和“公園”之間也有緊密的聯繫,因為“散步”通常發生在“公園”裏。通過這種方式,模型能夠捕捉到句子中的複雜依賴關係,從而更準確地理解其含義。 因此,自注意力機制使得推理大模型能夠更有效地處理長序列數據,並在自然語言處理、語音識別等領域展現出強大的性能。

- 訓練方法

推理模型的訓練需要基於(預訓練、微調和強化學習)來進行,以確保模型具備強大的推理能力

- 預訓練:模型首先在大規模的無標註文本數據上進行預訓練,學習語言的基本結構和模式,獲得廣泛的語言知識和世界知識。這一階段的數據量通常非常大,以涵蓋儘可能多的語言現象和信息。

- 微調:在預訓練的基礎上,使用特定領域或有標註的數據對模型進行微調,以優化其在特定任務上的性能和輸出風格。例如,對於推理任務,可能會使用包含推理鏈的數據集進行微調,讓模型學習如何生成合理的推理步驟。

- 強化學習:部分推理大模型還會採用強化學習技術,通過獎勵模型來評估模型輸出的質量和準確性,並根據獎勵信號不斷調整模型的參數,以提高模型的推理能力。

想象一下,一個孩子(模型)剛開始學習解決問題時,他可能會嘗試不同的方法(動作),而每次嘗試後,他會根據結果得到一些反饋(獎勵信號)。如果某種方法得到了好結果(比如解決了問題或者得到了表揚),那麼孩子就更有可能在下次遇到類似問題時再次使用這種方法。這就是強化學習的基本思想:通過“試錯”和“延遲迴報”來不斷學習和改進。

- 提示工程

- 提示工程是提高推理大模型性能的重要手段之一。通過精心設計輸入提示,引導模型按照預期的方式生成推理步驟和答案。例如,在提示中明確要求模型“一步步思考”“詳細解釋推理過程”等,可以幫助模型生成更符合要求的回答。

應用場景

- 學術研究:幫助研究人員解決複雜的學術問題,如數學證明、科學理論推導等,提供新的研究思路和方法。

- 教育領域:輔助學生學習,解答學科相關的問題,提供詳細的解題步驟和解釋,培養學生的邏輯思維和解決問題的能力。

- 商業決策:為企業提供數據分析、市場預測、風險評估等方面的支持,幫助企業做出更明智的決策。

- 智能客服:更準確地回答用户的問題,提供更詳細、專業的解決方案,提高客户服務的質量和效率。

總的來説,推理大模型通過獨特的技術實現和廣泛的應用場景,展現出了強大的能力和潛力。隨着技術的不斷進步和應用需求的不斷提高,推理大模型將在未來發揮更加重要的作用。

Deepseek概念

基本概述

深度求索(DeepSeek)是一家專注於通用人工智能(AGI)研發的中國科技公司,其推出的DeepSeek大模型是公司核心技術成果之一。目前deepseek支持智能對話、文本生成、語義理解與計算推理、代碼生成補全等多種複雜任務,還支持圖像、音頻等多模態輸入。

在技術架構上deepseek採用了混合專家(MoE)架構,通過動態路由機制,僅激活部分參數進行計算,有效降低計算能耗,提高特定任務的處理精度(英偉達市值蒸發)。並且,deepseek擁有龐大的參數量,如DeepSeek-V3的6710億(671B)參數,能夠理解和生成更復雜的語言,處理更多的上下文和細節信息。

一、混合專家(MoE)架構:智慧分工,高效協作

簡單來講,一個複雜的任務被分解成多個小任務,每個小任務都由最擅長它的“專家”來處理,這樣不僅能提高效率,還能確保每個細節都得到精準的處理。DeepSeek大模型採用的正是這樣一種高效的策略——混合專家(MoE)架構。

在MoE架構中,有多個“專家”模型,它們各自擅長處理不同類型的信息或特徵。當輸入數據進入模型時,一個名為“路由器”或“門控網絡”的部分會智能地決定將哪些數據分配給哪些專家去處理。這樣一來,每個專家都能專注於自己最擅長的領域,從而整體提高了處理效率和精度。

比如,在處理一個包含圖像和文本的多模態任務時,MoE架構可以自動將圖像部分交給擅長圖像處理的專家,將文本部分交給擅長文本處理的專家,兩者並行處理,最後再將結果合併,大大提升了處理速度和準確性。

二、動態路由機制:靈活調度,優化資源

在MoE架構中,動態路由機制起着至關重要的作用。它就像是一個智能調度員,根據輸入數據的特性和當前專家的負載情況,動態地決定數據的去向。

這種動態調度不僅提高了模型的靈活性,還使得計算資源得到了更有效的利用。因為並非所有數據都需要經過所有專家的處理,只有最相關的專家才會被激活,從而大大降低了計算成本

因此,deepseek訓練成本相對較低,且支持本地部署,對比同類型的大模型如GPT其硬件要求可降低60%以上

與傳統的大模型相比,DeepSeek大模型在訓練成本上具有顯著的優勢。這得益於其MoE架構和一系列優化措施,使得模型能夠在較低的硬件要求下進行高效的訓練。

DeepSeek大模型支持本地部署,這意味着用户無需購買昂貴的雲服務或高性能硬件設備,就能在普通的計算設備上運行和訓練模型。這對於中小企業和個人開發者來説,無疑是一個巨大的福音。他們可以用更低的成本享受到先進的AI技術帶來的便利和效益。

版本分支

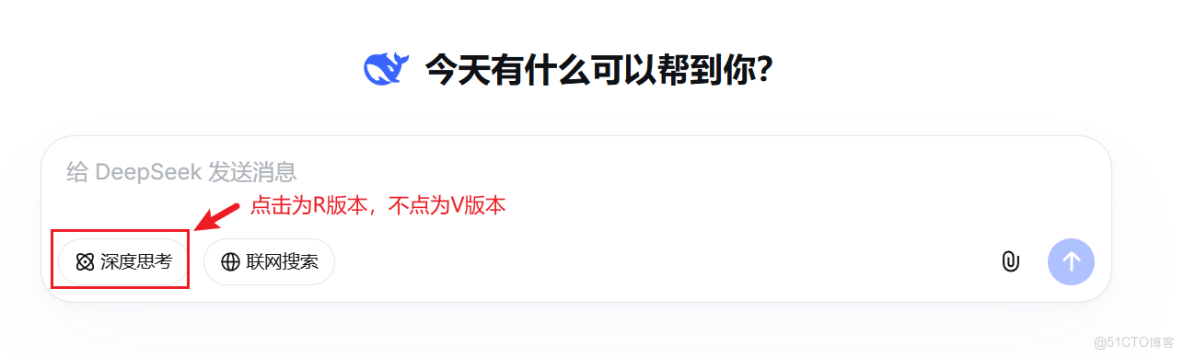

DeepSeek的R系列和V系列是該模型體系中的兩個不同分支,它們各自具有獨特的特點和應用場景。以下是對這兩個系列的詳細對比:

技術架構與模型特性

1、DeepSeek-R系列

- 架構特點:R系列模型採用了先進的混合專家(MoE)架構,這種架構通過動態路由機制,僅激活部分參數進行計算,有效降低了計算能耗,提高了特定任務的處理精度。同時,R系列還引入了強化學習等先進技術,進一步提升了模型的推理能力。

對於DeepSeek R系列這樣的大模型來説,強化學習就像是給模型賦予了一種“自我進化”的能力。模型在面對各種複雜任務時,會嘗試不同的解決方案,並根據任務的完成情況來調整自己的策略。隨着時間的推移,模型會逐漸學會如何更有效地解決這些問題,從而提升其推理能力。

簡單來説,強化學習就是讓模型在不斷的“嘗試-反饋-調整”循環中變得更加聰明和高效。它幫助模型在複雜任務中找到最佳解決方案,就像那個孩子逐漸學會了如何更好地解決問題一樣。所以,當DeepSeek R系列引入強化學習技術時,就意味着這個大模型擁有了更強的“智慧成長”能力,能夠更好地應對各種複雜的推理任務。

- 模型性能:R系列模型在數學、代碼和自然語言推理等複雜任務上表現出色,其性能可與OpenAI的o1模型相媲美。這得益於其大規模強化學習技術,使得模型能夠快速掌握新知識、新技能,並適應不同的任務和場景。

2、DeepSeek-V系列

- 架構特點:V系列模型則更側重於通用性和多模態處理能力。它基於標準的Transformer架構,並通過 “優化算法和增加訓練數據”,逐步提升了模型的性能和適用性。V系列模型支持中英文雙語處理,並能夠處理包括圖像、音頻在內的多種模態數據。

優化算法和增加訓練數據的理解:

優化算法可以讓模型這個“超級大腦”運轉得更高效。例如,在處理自然語言文本時,優化後的算法能夠更快地理解文字之間的關係。就像原本模型需要花費較多時間和精力去理解一個複雜句子中每個詞的聯繫,優化算法後,它能夠更快地捕捉到關鍵詞,更好地理解句子的含義,從而提升模型的性能。

而增加訓練數據意味着讓模型見識更多的場景和情況。以圖像識別為例,如果模型原來只訓練過少量幾種動物的圖片,它可能只能識別這幾種動物。但是當增加了大量不同動物在各種環境下的圖片作為訓練數據後,模型就能識別更多種類的動物,而且在這些動物處於不同姿態、不同背景等情況下也能準確識別,這就提升了模型的適用性。

- 模型性能:V系列模型在各項評測中均表現出色,尤其在知識類任務、長文本理解、編程和數學運算等領域接近甚至超越了國際頂尖閉源模型。這使得V系列模型在實際應用中具有廣泛的適用性。

應用場景

1、DeepSeek-R系列

- 科學研究:R系列模型憑藉其在複雜任務上的卓越性能,特別適用於前沿科學研究領域。例如,在數學推理、代碼生成等方面,R系列模型能夠提供強大的支持,幫助科研人員解決複雜的問題。

- 商業決策:對於需要高精度和複雜推理的商業決策場景,如金融分析、市場預測等,R系列模型也能夠提供有力的支持。其強大的邏輯分析和決策能力能夠幫助企業做出更加明智的決策。

2、DeepSeek-V系列

- 內容創作:V系列模型在文本生成、圖像識別等方面具有出色的表現,因此非常適用於內容創作領域。無論是撰寫文章、設計圖像還是生成音頻內容,V系列模型都能夠提供豐富的創意和靈感。

- 智能客服:在智能客服領域,V系列模型能夠準確理解用户的問題並提供準確的回答。其多模態處理能力還能夠支持語音、圖像等多種交互方式,提升用户體驗。

綜上所述,DeepSeek的R系列和V系列各有千秋,分別在不同的應用場景中展現出了卓越的性能。R系列以其強大的推理能力和複雜任務處理能力著稱,適用於科學研究和商業決策等高端場景;而V系列則以其通用性和多模態處理能力見長,更適用於內容創作和智能客服等廣泛應用領域。

蒸餾模型

基本概述

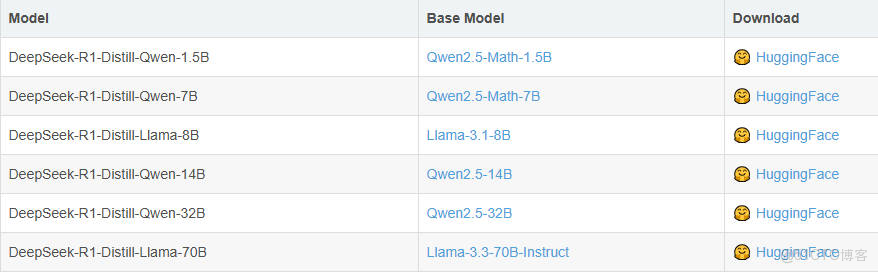

在deepseek的R系列模型中還提供了6種基於Qwen和Llama的蒸餾版本,顯著提升小模型性能。這六個蒸餾小模型是DeepSeek-R1-Distill-Qwen系列(包括1.5B、7B、14B、32B)和DeepSeek-R1-Distill-Llama系列(包括8B、70B)。

蒸餾模型是一種通過將複雜、大型模型(稱為教師模型)的知識遷移到一個更小、更簡單的模型(稱為學生模型)中,以實現模型壓縮和加速推理的技術。在DeepSeek系列中,就是將R1系列大模型作為教師模型,通過特定的蒸餾方法,把知識傳遞給基於Qwen和Llama系列構建的學生模型。其原理是:通過模仿教師模型的輸出,訓練一個較小的學生模型,從而實現知識的傳遞。在訓練過程中,首先利用訓練數據集讓教師模型生成針對輸入數據的響應,這些輸出結果構成了後續學生模型訓練的重要參考數據。然後,學生模型以此為基礎進行微調,通過優化自身的參數,使其儘可能地學習和模仿教師模型的行為模式和決策邏輯,從而實現知識從教師模型到學生模型的遷移。在此過程中,學生模型不斷調整自身的內部結構和參數值,以適應從教師模型傳遞過來的知識和經驗,逐步提升自身的性能表現。

做一個形象的比喻,即為:

想象一下,在一個學校裏,有一個非常聰明的學霸(我們稱他為“教師模型”),他在各個學科上都有出色的表現。然後,還有一個普通的學生(我們稱他為“學生模型”),他想要提高自己的成績,但不知道從何下手。可以基於如下2步實現:

第一步:教師模型的指導 教師模型(學霸)先做了一遍模擬考試題(這相當於利用訓練數據集生成響應)。 他把答案和解題思路詳細地寫了下來,這些答案和解題思路就像是“黃金參考資料”。 現在,普通學生(學生模型)拿到了這些“黃金參考資料”,他開始以此為基礎進行學習。

第二步:學生模型的微調

- 模仿與學習: 學生模型(普通學生)開始根據教師模型(學霸)提供的“黃金參考資料”來調整自己的學習方法和策略。 他會仔細對比自己的答案和學霸的答案,找出差距,並努力縮小這個差距。

- 優化自身參數: 學生模型不斷調整自己的學習計劃、記憶技巧等,就像是在優化自己的內部結構和參數值一樣。 他嘗試不同的方法,直到找到最適合自己的學習方式。

- 逐步提升性能: 隨着時間的推移,普通學生逐漸掌握了更多的知識和技巧,他的成績也開始穩步提升。 最終,他能夠獨立完成考試題,並且取得了不錯的成績。

通過這個過程,我們可以看到,普通學生(學生模型)通過模仿和學習教師模型(學霸)的行為模式和決策邏輯,實現了知識的遷移和自身性能的提升。這就像是蒸餾模型中的知識傳遞過程一樣,學生模型不斷地調整自己,以適應從教師模型那裏傳遞過來的知識和經驗,從而變得越來越優秀。

具體來説,DeepSeek的蒸餾過程是通過使用R1生成的80w個推理數據樣本,對較小的基礎模型(例如Qwen和Llama系列)進行微調而創建的。儘管規模變小,但這些蒸餾版本仍保留了較強的推理能力。因為它們繼承了R1大模型的知識和推理模式,所以在一些推理任務上能夠取得不錯的成績。

意義和作用

- 降低部署門檻:蒸餾後的輕量級模型能夠在資源受限的設備上運行,如移動設備、邊緣計算設備等,大大擴展了AI技術的應用範圍。

- 提升運行效率:小型模型具有更快的推理速度和更低的能耗,這對於需要實時響應的應用場景尤為重要。

- 個性化定製:蒸餾技術使得模型能夠針對特定場景進行優化,滿足不同應用的具體需求。

Deepseek-R1所需硬件配置概覽

伴隨着DeepSeek R1模型使用需求不斷深化,如何才能部署更高性能的滿血版DeepSeek R1模型,就成了很多應用場景下的當務之急。受限於DeepSeek R1 671B(6710億參數)的模型規模,通常情況下部署DeepSeek R1滿血版模型需要1200G-1400G左右顯存(考慮百人內併發情況),也就是需要60塊4090或者18塊A100的顯卡才能夠順利運行(總成本約在260萬-320萬左右)。哪怕是在半精度的情況下,實際測試下來也需要佔用490G的顯存,也就是需要24塊4090或者7塊A100才能夠順利運行(總成本約在120萬至240萬左右)。

在此情況下,如何以更少的成本獲得儘可能好的模型性能——也就是如果進行DeepSeek R1的高性能部署,就成了重中之重。基本來説,目前的解決方案有以下2種:

第一種:採用“強推理、弱訓練”的硬件配置

如選擇國產芯片、或者採購DeepSeek一體機、甚至是選擇MacMini集羣等,都是不錯的選擇。這些硬件模型訓練性能較弱,但推理能力強悍,對於一些不需要進行模型訓練和微調、只需要推理(也就是對話)的場景來説,是個非常不錯的選擇。

例如,45萬左右成本,就能購買能運行DeepSeek R1滿血版模型的Mac Mini集羣,相比購買英偉達顯卡,能夠節省很大一部分成本。但劣勢在於Mac M系列芯片並不適合進行模型訓練和微調。

第二種:採用DeepSeek R1 Distill蒸餾模型

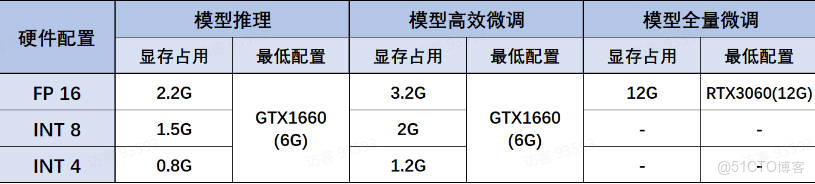

DeepSeek R蒸餾模型組同樣推理性能不俗,且蒸餾模型尺寸在1.5B到70B之間,可以適配於任何硬件環境和各類不同的使用需求。其中各蒸餾模型、各量化版本、各不同使用場景(如模型推理、模型高效微調和全量微調)下模型所需最低配置如下:

FP16、INT8和INT4是指大模型硬件配置中三種不同的數值精度表示方式。

- 如果對模型精度要求極高,如醫療影像分析、高精度自然語言處理任務等,應首先考慮FP16或INT8。

- 如果需要高推理速度,如實時語音識別、視頻處理等任務,可以考慮使用INT8或INT4。

- 如果存儲資源是首要考慮因素,如在移動設備或嵌入式系統中部署模型,INT8和INT4可能是更好的選擇。

- Deepseek-R1-Distill-Qwen-1.5B:

- 性能指數:2顆星,推理能力達到GPT-4o級別(int4 32位 int8 64)

- 適用場景:移動端應用或者個人助理

- Deepseek-R1-Distill-Qwen-7B

- 性能指數:3顆星,推理能力達到o1-mini的70%左右

- 適用場景:高校實驗室或者小型團隊適用

- Deepseek-R1-Distill-Qwen-14B

- 性能指數:4顆星,推理能力達到o1-mini的80%左右

- 適用場景:適用於一般商業場景

- Deepseek-R1-Distill-Qwen-32B

- 性能指數:5顆星,推理能力達到o1-mini性能級別

- 適用場景:適用於高性能要求的商業場景

- Deepseek-R1-Distill-Llama-8B

- 性能指數:3顆星,推理能力達到o1-mini的70%左右

- 適用場景:高校實驗室或者小型團隊適用

- Deepseek-R1-Distill-Llama-70B

- 性能指數:5顆星,推理能力達到o1-mini的性能級別

- 適用場景:適用於高性能要求的商業場景